-

PROHARDVER!

A legtöbb kérdésre (igen, talán arra is amit éppen feltenni készülsz) már jó eséllyel megtalálható a válasz valahol a topikban. Mielőtt írnál, lapozz vagy tekerj kicsit visszább, és/vagy használd bátran a keresőt a kérdésed kulcsszavaival!

Új hozzászólás Aktív témák

-

-

Laja333

őstag

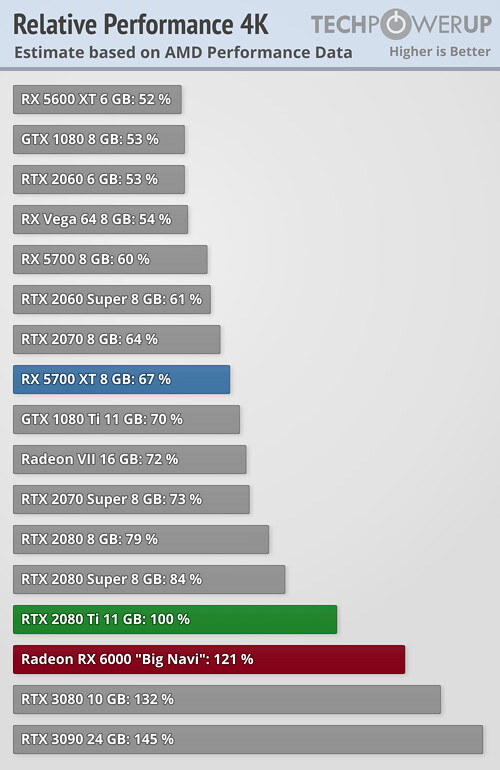

Digital Foundry az 52 CU-s változatot 2080-as teljesítményre tippeli.Az 52-es fölött még a 60/72/80-as variáns tippelték itt a fórumban. Valaki legyen szíves számolja ki, akkor ez alapján melyik kártyát mutathatták AMD-ék. Nekem már késő van.

Semmi, tényleg késő van. Nem nagy dolog 2080-ra tippelni, ha a 40 CU-s 5700XT a 2070/S körül van.

Ez inkább ilyen pesszimista tippelés volt tőlük, csak a CU növekedést vették figyelembe kb.

Ez inkább ilyen pesszimista tippelés volt tőlük, csak a CU növekedést vették figyelembe kb. -

Mumee

őstag

válasz

Petykemano

#49695

üzenetére

Petykemano

#49695

üzenetére

-

Petykemano

veterán

Jó, de a Samsung soha nem gyártott még ekkora lapkákat, nem? Nem tudom, hogy a lapkaméret számít-e azon kívül, hogy általában mennyi a defect density és hogy ha kellően nagy, akkor nagy lapkából túl sok hibás. De van valami maximum reticle size is, amit szoktak emlegetni.

A GA103 amúgy miért jön? Ha a TSMC-re jött volna, azt gondolnám, hogy annyival jobb(an sikerült), hogy egy kisebb (értsd kevesebb tranzisztor) lapkával is tudják hozni a GA102 teljesítményét. De ha az is Samsung, akkor hasonlóan jó lehet, mint a GA102 - feltéve persze ,hogy a GA103 és GA104 nem tekinthető már egy második generációnak abban az értelemben, hogy mennyire ismerik a samsung node-ját.

Persze értem, hogy nagy a gap a 3070 és a 3080 között, de a 103-as elnevezés azért szokatlan.

Egyébként miért kéne az nvidiának most elkezdeni áttervezni a lapkát a TSMC-hez? miért ne kezdhettek volna bele ebbe a munkába 1 évvel ezelőtt, amikor már biztosan látták, hogy a SS 8N gatya?De valószínűleg igazad van, mert ha az lenne, hogy a GA103 a megmentő a TSMC gyártósorairól és már csak hetek-hónapok kérdése és megérkezik, akkor megint felesleges lett volna húzni a kártyákat. Tehát a GA102-re épülő termékeket ki lehetett volna pakolni -50-100W fogyasztással szoksásos hűtővel -4-5% teljesítménnnyel. Ha jön közben a navi, ami amiatt pár százalékkal beelőz? Semmi gond, már húzzuk is rá a GA103-at, ami visszaveszi az elsőséget.

Tehát: a GA103 valószínűleg nem megmentő

-

Abu85

HÁZIGAZDA

válasz

#32839680

#49690

üzenetére

#32839680

#49690

üzenetére

A túltermeléstől mindig lemegy a memória ára. Csak ki kell várni, ez pár hónap.

(#49693) Petykemano: A 8 nm-es Samsung eleve egy half-node. Egy olyan gyártástechnológia, aminek a full-node-ja 2017 vége óta működik. Ha volna vele valami gond, akkor már rég feltűnt volna nemcsak a Samsungnak, hanem mindenki másnak, aki ezen gyártat.

Egyébként a GA103 is Samsungra jön. A TSMC-re csak az Ampere AI dizájnja van meg, az meg nem jó gamingre. Szóval ha az NV elkezdi áttervezni a gaming dizájnt a TSMC node-jára, az nagyjából egy évet vesz igénybe, és onnan még fél év a gyártás beindítása. -

Petykemano

veterán

Sokan úgy vélik, hogy azért nincs ellátás 3080 és 3090 kártyákból, mert a SS8N csak átmeneti megoldás az nvidiánál és a már készülőben levő GA103-mal fogja majd kiszolgálni tömegesen az igényeket.

Akkor azt mondod , hogy ezzel nincs összefüggésben, hanem a GDDR6X kínálat kicsi és/vagy drága és azt várjuk, hogy legyen több/olcsóbb?

-

Petykemano

veterán

azt gondolnám, hogy a sony és a MS érdeke is, hogy legyen valami. Hiszen nekik is érdekük, hogy adott felbontáson nőjön az fps vagy hogy magasabb felbontást tudjanak célozni amúgy gyengébb és olcsóbb hardverrel. Nem is beszélve streamingről, amellyel kapcsolatban épp most mutatta be az nvidia ezt a videohívásos megoldást, ami lényegében arról szól, hogy egy low-quality streamet generál és egy nagyfelbontású minta alapján skálázza fel.

És mivel kvázi egy hardvert használnak, így akár közös érdekük is lehetne, hogy szabványos legyen. AMD hardver-only megoldást nem tartok valószínűnek.

-

Abu85

HÁZIGAZDA

válasz

Petykemano

#49674

üzenetére

Petykemano

#49674

üzenetére

Kérdéses. Nagyon fontos, hogy a GDDR6X bevezetés szintjén van. A GDDR6 is drága volt az első megjelenés pillanatában igaz csak ~20 dollár volt a memóriastack, de 3 hónapon belül lement 10 dollárra. Valószínűleg itt is hasonló fog történni, ahogy a gyártás felfut. Egyre nagyobb lesz a túltermelés, és ez az árat is leviszi. A kezdeti árak a memóriapiacon mindig extrém magasak, még tart a gyártás felfuttatása, és versenyhelyzet sem alakul ki. A DDR5 is azért kezd a szerverpiacon, mert extrém drága lesz egy modul, de egy éven belül már asztali szinten is megfizethető lehet, mert a kezdeti ár a harmadára, vagy jó esetben a negyedére eshet. Most is erre várnak a GDDR6X-nél, hogy felfusson a gyártás, és az ára lemenjen 10-15 dollárra, ami nem sokkal van a GDDR6 fölött.

-

válasz

Televan74

#49667

üzenetére

Televan74

#49667

üzenetére

nem kell ezt bizonyítani. Nvidia nem igen adja 40 % haszonkulcs alá. 50-60 % amit szeretnek. A Moreslawisdead teljesen jól írta le mi történik valójában. ha az AIB partnerek átlagos hűtővel ( értsd Asus TUF, MSI Armor, stb) hozzávetőleg 40 % árréssel dolgoznak, azaz kb egy RTx 3080 átlagos hűtéssel nekik 350-420 dollárba kerül függően a hűtéstől, VRM stb. tehát egy 800 dolláros TUF már közel 40- 50 % árrést biztosít.

Mivel nvidia saját magának nem értékesít GPu-t így kézenfekvő hogy akár egy 150-200 dolláros hűtés is kb hasonló ,de legkevesebb 30 % árrést biztosít.

érdemes elolvasni még egyszer a cikket ha nem tetted volna meg, még ha nem is mindennel értek egyet benne és nem feltétlenüll van minden ebből az okból. : [link] -

Mumee

őstag

válasz

#09256960

#49680

üzenetére

#09256960

#49680

üzenetére

Korábban linkeltem itt vagy AMD CPU találgatósban egy másik AMD szabadalmat is.

Így mindent összevetve az összkép arra mutat, hogy a GPU MCM design felé fejlesztenek és annak egyik állomása ez.

CPU-nál is ugye most már a 2 chiplet közösen éri el ugyanazt az L3-at.

Twitteren is volt erről eszmefuttatás az okosabbak közt. -

Malibutomi

nagyúr

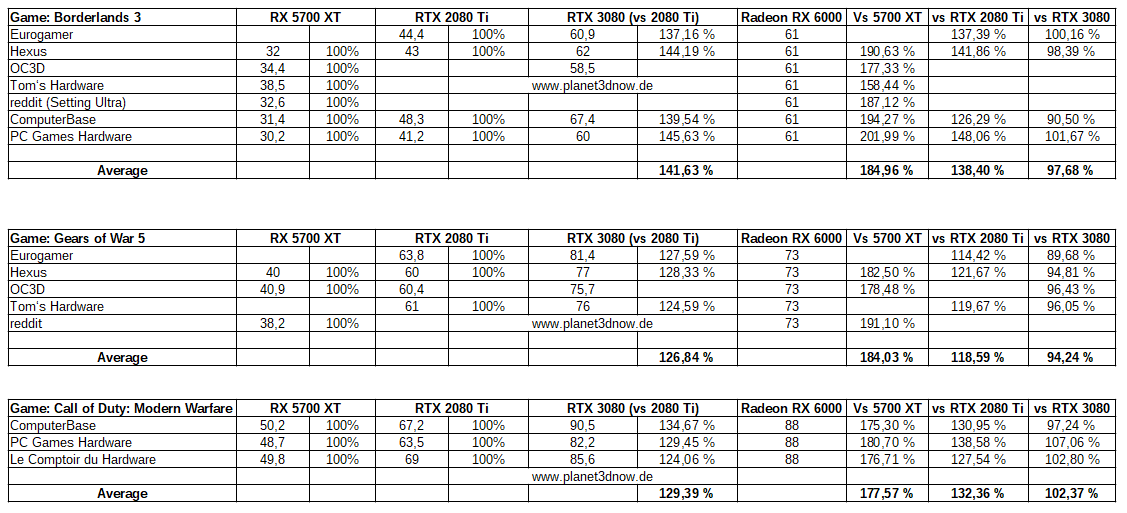

Technikai reszletektol eltekintve ha sikerul a 3080 kore bejonniuk az hatalmas lepes lenne szvsz.

Ha kaphato is lesz az meg aztan az aduasz

-

#09256960

törölt tag

Szerintem nem az NV-t kellene itt számolgatni.

Kellene egy táblázat mennyi lenne a Gddr6Xel 10 GB és ehhez képest mennyi GDDR6al 16GB+ a szilikon ára a kessen

és ha ügyes lennék mellé tenném kiegészítő információnak hogy HBMel mennyi lenne persze + interposer.

Amiről itt még kellene beszélgetni a technológiai harcban hogy ez a Kess most mennyire szolgálta azt hogy tudták hogy nem lesz GDDR6X-ük vagy valóban olcsóbb így.

ESETLEG a KESS az már a SEMI Custom felé tekintők kérése volt és ezzel készültek fel a SSD Heavy terhelésekre.???!!! -

Simid

senior tag

válasz

#32839680

#49678

üzenetére

#32839680

#49678

üzenetére

Szerintem arra gondolt, hogy ha valóban ennyibe kerülne mint amit Abu mondd ($300+), akkor HBM is olcsóbb lett volna. Ezt pedig biztosan tudjuk, hogy így van, hiszen volt egy Radeon VII 700 dollárért (meg még olcsóbban is) úgy, hogy 4 stack volt rajta, gondolom volt rajta 30 dollárnál több nyereségük... A GA102 mem sávszéle ma már elérhető lenne 2-3 stackkel is, szóval olcsóbban mint a R7 4 stackje.

-

válasz

Malibutomi

#49672

üzenetére

Malibutomi

#49672

üzenetére

Megjelenés előtt az Ultimate Play állításban arról volt szó, hogy az NV nem szeret 60% marzs alatt értékesíteni, a $700 MSRP pedig ez alatt van. Ezért nem akarnak a beetetési áron terméket forgalmazni. Nem veszteséges, de nincs is annyi haszon rajta. Én tisztelem Abut a tudása miatt, de ez a $670 önköltségi ár igen valószínűtlen.

-

menpee

aktív tag

válasz

GeryFlash

#49671

üzenetére

GeryFlash

#49671

üzenetére

Félre ne érts, nem személyed elleni szidásnak szántam.

Jelenleg az egyik oldalon azt látom, hogy rengeteg prototípus fejlesztés, amiért annyit kérnek el a gyártói, amennyit nem szégyenlenek, egy adatközpontos felépítésű GPU az adatközpontos extra súlyos prémium árazás nélkül versus a másik oldal, akik azt mondják, hogy ezen még bizony sok profit is van. A rengeteg marketingről és hírverésről már ne is beszéljünk, de azért adjuk hozzá. Eleve is kiemelkedően jónak számít 20%-nyi nyereség manapság, vegyük le átlagos nyereségre és felezzük meg a sok prototípus technológia extra sarca miatt, ami egy bejáratott gyártástechnológiával és felfutott volumennel nem lenne ott.

Győzz meg, hogy nem tűnik logikusnak. -

PitLee

őstag

? Bár még nem tudjuk, hogy melyik Navi mit tud, de a másik oldalon ott lesz a 3070 ami NV szerint gyorsabb, mint a 2080Ti és 60%-al gyorsabb, mint a 2070 és a sima gddr6 miatt még az árazása is jó lehet.

Én az NV helyében most erre gyúrnák, hogy legalább ezt lehessen kapni a AMD 10.28 után, mert még ha ezzel sem tudnak előállni akkor NV részvények lekonyulnak. -

Malibutomi

nagyúr

válasz

GeryFlash

#49671

üzenetére

GeryFlash

#49671

üzenetére

Igen de ha csak elvetve kaphato, es akkor is 1.5-2X aron es mar a megjelenes elott ilyen pletykak voltak hogy direkt nem lesz mennyiseg a FE kartyakbol mert buko van rajta es hogy az AIB-ok adhassak majd msrp-hez kepest magasabb aron akkor azert nem annyira tiszta a kep lassuk be

-

GeryFlash

veterán

válasz

Alogonomus

#49669

üzenetére

Alogonomus

#49669

üzenetére

Főleg hogy AMD-s VGA-m van és a következő gépem is AMD CPU + VGA kombó lesz, fölé-mellé sebaj

Televan, menpee: Nem tudok számokat, ha neked azt mondják a Tesla model 3 17 millióba kerül és 16,9 millió az előállítási költsége amiből akku 8,5 millió Ft akkor erről az állításról anélkül el tudod dönteni hogy f*szság hogy tudnád a pontos adatokat. Nem, nem tudok adatok de nem is dobálózok ,,xy titkos partner kontaktom mondta" kijelentésekkel.

-

Mumee

őstag

16Gbps GDDR6 ~$12/GB

Ha feltételezzük, hogy a GDDR6X mondjuk a duplája árban (bár az talán túlzásnak tűnik), akkor vagyunk 10GB GDDR6X-el $240-en.

$300 tényleg elrugaszkodottnak tűnik, de $200 körül reális lehet.

Cooler Igor szerint $150, ez így már $350."Let’s have a look at the economics of this all. As per IC retailer Digi-Key, doubling the memory of the graphics cards costs around $12 per GB. Therefore, for a 20GB GPU that comes up to roughly $120. This is 16Gbps GDDR6 memory that we’re talking about here. If the new cards indeed feature the faster GDDR6X memory, prices may be slightly higher. "

[link] -

menpee

aktív tag

válasz

GeryFlash

#49666

üzenetére

GeryFlash

#49666

üzenetére

Két tapsikolás között egy számokban kifejezett árat ha tudnál közölni lebontva részegységekre, azt mindenki megköszönné. Okosabbak csak a következő negyedéves nVidia pénzügyi összefoglaló után leszünk. Ha ki merik emelni a 3xxx széria eladásait az összestől, akkor direkt számok lesznek, egyébként meg lehet viszonyítani a várt Ampere megjelenéshez képest, amit ki is emeltek az előzőben is.

Mondjuk off-ba raknám a 3080-as hozzászólásokat, de ez csak az én véleményem. -

GeryFlash

veterán

Hogy mi van?

Abu te ezt most komolyan be akarod nekünk adni? Hogy az anyagköltseg fele a memória?

Abu te ezt most komolyan be akarod nekünk adni? Hogy az anyagköltseg fele a memória?  Hogy a kártya előállítási költsége az msrp 95%-a? Jézusom hagyjuk már ezt, semmilyen belsős infó nem kell ahhoz hogy tudjad hogy ez óriási kamu. Igen valószínűleg 10GB VRAMért 300 dodót fizetnek

Hogy a kártya előállítási költsége az msrp 95%-a? Jézusom hagyjuk már ezt, semmilyen belsős infó nem kell ahhoz hogy tudjad hogy ez óriási kamu. Igen valószínűleg 10GB VRAMért 300 dodót fizetnek

-

#09256960

törölt tag

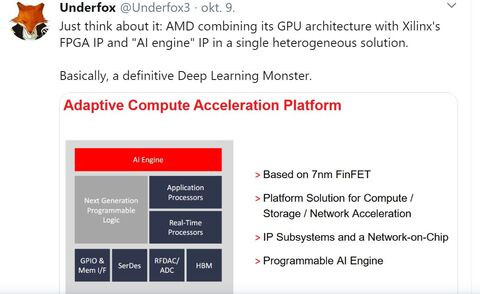

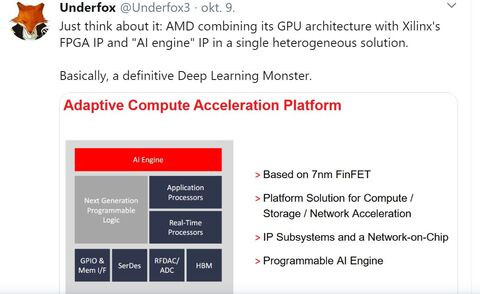

Úgy fog tűnni ez a komment mint egy Monster Hunter DLC

Ugyanis jön az új Deep Learning Monster !!! Harr harr

Platina fokozatú hírbringereknek ajánlott forrás: Underfox -

And01

aktív tag

válasz

Raymond

#49642

üzenetére

Raymond

#49642

üzenetére

Nem biztos az annyira.

Nem tudjuk mennyiért gyárt a samsung a 8nm-en, de figyelembe véve a tsmc 9-10000$

wafer árát a 7nm-re, szerintem a samsung számlázhat kb 6500-8000$ waferenként.

Figyelembe véve a gpu nagy méretét, selejtarányt, egy lapka (gyártási) önköltsége önmagában

is simán lehet 80$ + fejlesztési költség, maszkok ára stb +haszon a lapkán.

Lapkánként az Nvidia simán elkérhet 300$.

És ez mégcsak egy gpu...

Az Nvidia aligha bukik rajt, de szinte biztos nem keres sokat.

Ha partnerek Msrp áron adnák, akkor ingyen dolgoznának, az meg nem kifizetődő.

Jobban járnak hanem adnak el egy darabot sem... -

sutyi^

senior tag

A DLSS akkor válik igazán ütőképes fegyverré ha minden címben akár control panelből kapcsolhatóvá válik.

Jelenleg viszont bármilyen jó a 2.1 még mindig kell hozzá a játékfejlesztőktől az integráció, illetve még mindig az NV szerverein készül a játék specifikus neuron háló ami annyira nem univerzális hogy nem hogy egyik nem jó a másik címhez, hanem a feltanitott hálózat sem minden esetben jó egy játékon belül.

-

Yany

addikt

válasz

stratova

#49651

üzenetére

stratova

#49651

üzenetére

A VS (szigorúan kúltúrált keretek között) elkerülhetetlen. NVIDIA most odatette a lécet, amit az AMD-nek meg kell ugrania. Ezalatt nem tisztán teljesítményt kell érteni, hanem piacképes terméket. Azt meg az enyémhez hasonló feltételrendszereket felsorakoztató leendő vásárlók döntik el, hogy sikerült-e. Mindenkinek megvan ez a listája, csak mások rajta a szempontok és/vagy mértékek. NVIDIÁnál eddig csak az előző generációhoz tudtad mérni a döntést, legyen az akár NVIDIA, akár AMD termék, most már itt a 30x0 széria...

-

Yany

addikt

válasz

gabika1972

#49648

üzenetére

gabika1972

#49648

üzenetére

Melyik része elrugaszkodott?

Hőbörgés helyett egy konstruktív vitára vevő vagyok, de a fenti gondolatoddal, meg egy esetleges "hát az egész" jellegű válaszokkal nem tudok mit kezdeni.

Ahogy a Zen 2 sem minden értelemben volt jobb az Intel termékeknél, ugyanígy itt sem várok abszolút győzelmet, csak észszerű alternatívát. Ahogy Raggie is lereagálta, teljesen okés volt és még egyet is értek vele. De persze jogod van háborogni, csak azt kár velünk megosztani, mert minek?

-

paprobert

őstag

Földig lealkudott Samsung node + formavezérelt dizájnú PCB (pár 10 dollár extra) és hűtő (pár 10 dollár extra) nem lesz végül 670 dollár. Soha, sehol.

A forrásod vagy sz*pat téged, vagy csak tüzet old az általános MSRP vs. valódi ár miatt felháborodás okán egy ilyen indokkal.

-

stratova

veterán

válasz

gabika1972

#49648

üzenetére

gabika1972

#49648

üzenetére

A technológiai boncolgatást én speciel érdekesnek találom, csak annyi várakozás előzi most meg RX 6000-et hogy lassan a találgatós átmegy vs-be. Bár a Radeon Pro kártyák szűk fél évvel később jelentek meg, mint RX 5700 kíváncsi vagyok, vajon ekkora GPU-nál AMD teljes értékű lapkával indít-e a konzumer piacon, vagy itt is megmaradnak a teljesek Apple és a Pro vonalnak.

-

válasz

KillerKollar

#49635

üzenetére

KillerKollar

#49635

üzenetére

ajánlott? a 60Hz monitorodhoz a 2080tid is bőven sok lett volna.

-

Yany

addikt

Igen, a DLSS-sel nagyon nehéz objektívan számolni (ezért gondolom fernek, ha nem azzal tesztelnek, mégha quality-ről is beszélünk, legfeljebb mellé teszik), mert előnyére és hátrányára is vannak olyan jelenségei, amiket csak mozgás közben látsz. Előny pl. a moiré és zizegő élek/minták eltűnése vagy csökkenése bizonyos térfrekvenciák esetén, míg hátrány pl. be-bevillanó elemek rosszul kalkulált részeken. De összességében egy quality 2.0 simán hozza egy 4k összhatását bizonyos címek alatt, amiből nagyon nincs sok.

Viszont, azt mondanám, hogy mivel nem egyértelmű, akkor hanyagolnám, de a lényeg még csak ezután jön: fps-ekben annyival jobb a natívnál, hogy egyszerűen nem lehet figyelmen kívül hagyni. Simán jönnek majd a jövőben a még dúsabb tartalmú gémek, amik már el fogják gondolkodtatni a 3080-as kategóriájú termékeket is egy-egy képkockánál, és ha 3080-nál van DLSS, RX6000-nél meg nincs, akkor lehet sejteni, hogy kik fogják jobban élvezni a felsőkategóriás játékokat. 10GB-os VRAM ide vagy oda.

Viszont, azt mondanám, hogy mivel nem egyértelmű, akkor hanyagolnám, de a lényeg még csak ezután jön: fps-ekben annyival jobb a natívnál, hogy egyszerűen nem lehet figyelmen kívül hagyni. Simán jönnek majd a jövőben a még dúsabb tartalmú gémek, amik már el fogják gondolkodtatni a 3080-as kategóriájú termékeket is egy-egy képkockánál, és ha 3080-nál van DLSS, RX6000-nél meg nincs, akkor lehet sejteni, hogy kik fogják jobban élvezni a felsőkategóriás játékokat. 10GB-os VRAM ide vagy oda.tldr: RX6000-nél nekem dealbreaker lehet, ha még híre sem lesz valami deep learning-es, vagy akármilyen más okosabb SS megoldásnak. Persze egy újabb MLAA kamu nem hogy nem fog meggyőzni, de kvázi rohanni fogok a másik irányba. (konkrétan traumát okozott nekem az a sz*r és hogy mindenki be is kajálta, csak rontott a helyzeten)

-

Mumee

őstag

Igen, bár nyilván nem lesz mindenben ugyanolyan vagy jobb. Már önmagában az valószínűbb, hogy a teljesítmény jobb lesz, mint hogy egyből azonos tudású DLSS/RT.

Persze lehetnek meglepetések, hisz ha alacsonyabb felbontásban a skálázás miatt jobb lehet a Navi, akkor a "DLSS" skálázást is pozitívan befolyásolja hogy alacsonyabb felbontást számol a VGA.Ezt a DLSS mizériát is jó lenne tisztába tenni.

DLSS quality, balanced, performance, ultra performance.

Ugye ahol jobb képet adhat, mint a natív az csak a quality jelenleg, mert ott még nem túl alacsony felbontásról skáláz.

Mondjuk elég relatív ez a jobb képet ad(hat), hisz ki hogy érzékeli, meg melyik játékban mennyire jó az "AI háló". -

Yany

addikt

Szerintem nem az én hozzászólásomra reagálsz.

Nem írok mindenben jobbat.

Nem írok mindenben jobbat.

- Teljesítmény: akár rosszabb is picit

- Ár: -$50 (picit jobb)

- Hűtés: ugyanaz.

- Kompatibilitás: ugyanaz

- DLSS: ugyanaz

- Fogyasztás: max. 300W (ez inkább egy reális outcome, semmint támasztott igény a részemről)

- Elérhetőség: jobb (mondjuk alap)Vagyis: nagy vonalakban valójában egy AMD által gyártott 3080-asra fáj a fogam hasonló áron, de hasonló tudással. És itt nekem nagyon fontos a hasonló tudás is, mert persze, hogy olcsóbb valami, ha szarabb. De itt egyrészt gyártási kapacitással elvileg nincs gond, másrészt a bekerülési költség is alacsonyabb. A fogyasztás is technológiából adódóan egy potenciál, nem csak egy random vágy. A DLSS viszont a grafikonokon is, de a gyakorlatban is(!) egy aduász képesség, ha arra nem kínál semmit az AMD. Az más kérdés, hogy valahol okkal persze, de sok reviewer nem fogja a DLSS számokat a natív felbontás mellé tenni, hiába hoz a 2.0 a natív 4K-nál adott esetekben akár jobb(!) végeredményt is.

-

Raggie

őstag

Én csatlakoznék ehhez minimális módosítással:

-ár/értékben nekem elég ha pontosan ugyan azt hozza, mint az nVidia. Nem kell hogy jobb legyen, elvégre nem fogok több örömet kapni semelyik játéktól csak azért mert zöld kártyán megy a piros helyett csak a konkrét teljesítmény számít szerintem.

-az kell hogy kapható legyen és tényleg annyiért

-kell a jó minőségű (és halk) hűtés

-nem árt a 300 W alatti fogyasztás sem, de ha az egyel fentebbi pont teljesül én igazából ezt a pontot lesz@rom

-kell a kapásból jó driver

-egyelőre lesz@rom a dlss és hasonló feljavító technikákat (igen a 2.0-t is)

Szóval szerintem ezekkel már jók vagyunk. Hozzáteszem, hogy nem biztos, hogy a csúcs kártyájukat fogom megvenni, mert valszeg nem lesz rá pénzem, de egyel a csúcs alattira benevezek az biztos. -

Raymond

titán

válasz

Malibutomi

#49631

üzenetére

Malibutomi

#49631

üzenetére

Ha meg igen akkor meg beleszolok. Egyebkent Pug is megmondhatna neked hogy amit Abu irt az...hmm...a valosagtol elrugaszkodott, csak ez valoszinutlen a hozzaszolasai alltalanos szine alapjan

-

Yany

addikt

-

PitLee

őstag

Az FE hűtő az nem valami "présöntvény" , legalább is úgy néz ki, a AIB kártyákon a rézcsőre huzigált lemezek lehet, hogy olcsóbbak .

-

ez a 670$ honnan van mer Igor pont azt mondta hogy Nvidia a 50-60% körüli marzst szeretné az Fe-n kb 40 % körül van. egy YT videóban azt mondtákhogy 352 $ körül van a haszna Nvidiának egy FE 3080 karin. ha csak 40 % akkor ez magyarázná a 3090 1500 dolláros árazását, ami ellensúlyozná valamelyest a kiesést az extrém magas árával.

-

Devid_81

félisten

A prof piac nem reg vette at a vezetest anyagiakban, a gamer oldal masodlagos.

Viszont ha elkezdenek veszteseget termelni akkor nem tudom ez mennyire jo vagy sem befektetoi szemmel.

Oke itt a termek nem veszteseges, eppen egy kis aproval a felett van, szoval lehet nekik ez igy jo lesz amig nem rendezodik a dolog. -

Abu85

HÁZIGAZDA

válasz

Devid_81

#49627

üzenetére

Devid_81

#49627

üzenetére

Az NVIDIA-nak ez alapvetően a mennyiség miatt lényeges. Ők GPU-kat adnak el, arra rakhatnak maguknak haszont. A gyártással és a komponensekből keletkező költésproblémákkal kapcsolatban a partnerek szopnak. Valószínűleg ezért volt fontos, hogy azonnal legyenek custom modellek.

Szerencsére a 3070-nel nem lesz ilyen gond, az GDDR6 memóriát használ, és az olcsó. Ennél a terméknél már most tudni, hogy kellemes készlet is lesz, tehát nem csak a kereskedelmi megrendelések töredékét szállítják le a gyártók. Bár valószínűleg azért a megrendelés így is több lesz, mint amennyit tudnak szállítani, de mondjuk a megrendelések 60-70%-át teljesíthetik, nem csak a 3-5%-át, mint a 3080-3090 esetében, ami azért nem mindegy.Azt kellene tudni, hogy a Micron mikorra tud jóval több GDDR6X-et gyártani, mert akkor annak az ára elkezd durván megindulni lefelé, és úgy már a 3080-3090 költségei is értékelhetők lesznek. Ha a bőrkabátosnak hihetünk, akkor erre valószínűleg a következő év elején van esély.

-

Jack@l

veterán

válasz

Malibutomi

#49622

üzenetére

Malibutomi

#49622

üzenetére

Ki mondta egy szóval, hogy mi tudjuk? Kb az ujjaimon meg tudnám számolni, akinek erről lenne konkrét információja. De azok is jókora pénzbüntit kapnának ha elárulnák. Ellenben van fogalmam arról, mennyiért szokták gyártani ezeket.

-

válasz

KillerKollar

#49599

üzenetére

KillerKollar

#49599

üzenetére

no offense, de az azért megvan, hogy a cp2077 ajánlott gépigénye high beállítási szint és fhd felbontás mellett egy 1060?

-

Yany

addikt

Erre hadd reagáljak én is. Én akkor lennék elégedett az AMD termékek debütjével, ha lenne egy kártya (gpu)

- 3080 teljesítménye körül (legrosszabb esetben -5%, de bárhol fölötte) de ray trace-szel is(!)

- Árban -50 USD.

- Ténylegesen kapható és ténylegesen annyiért.

- Asus TUF minőségű hűtéssel is kapható

- 300W alatt eszik.

- Minden játék, ami jelenleg RTX kártyán szalad, az kapásból megy Radeonokon a fent említett teljesítménnyel)

- Van egy DLSS alternatívájuk, ami legalább annyi címben működik, mint az NV megoldása.Az, hogy van-e alatta / fölötte még további termék, letojom. Ha van a fentiekre passzoló megoldásuk, van egy vevőjük. Ha nincs, beszerzek egy TUF 3080-ast, amint normalizálódtak az árak, vagy kintről hozzájutok egy szerencsés pillanatban egy normális árúhoz.

A DLSS-t amúgy letojtam az 1.0-es verzióig, de amit a 2.0 művel, az szenzációs.

-

Malibutomi

nagyúr

Na legalabb vannak itt akik tudjak a tenyleges arakat megbizhato forrasbol.

Raymond, Jack@l ne titkolozzatok, tessek megosztani valojaban mennyibe kerul.

-

Abu85

HÁZIGAZDA

válasz

Raymond

#49618

üzenetére

Raymond

#49618

üzenetére

A PC partnertől jött. Ott van egy kontakt.

(#49620) Pug: Azon én is meglepődtem. Az brutális ár egy hűtőre. Szerintem amúgy, ha a memória árát le tudnák vinni nem sokkal a GDDR6 fölé, akkor jóval kedvezőbb lenne. Elvileg csak a memória teszi ki a költségek felét. Nem csoda, hogy 10 GB-ra spóroltak vele 20 GB helyett.

-

KillerKollar

őstag

válasz

Jack@l

#49614

üzenetére

Jack@l

#49614

üzenetére

Egy 700$-os aktuális flagship kártyánál elvárható a max grafika szerintem. Nem azért vettem, hogy mediumon játszogassak.

(#49615)EXA

2080 Ti-m volt, minden generációban cserélem a kártyámat, ezért mondtam, hogy addig, amíg nem jön a következő generáció, addig a 10GB tuti elég lesz, aki hosszabb időre veszi, annak már nem biztos.

Én eddig mindig Ti class kártyát vettem, de a 3090 dupla áron 10-15% extra teljesítményért pofátlan volt nekem, a 24GB memória meg fölösleges, mire kelleni fog már le is cseréltem a kártyát, azért meg nem fizetek érte dupla árat, amikor úgyis elbuknám ha eladom. -

Abu85

HÁZIGAZDA

Kivételesen nem ez a gond. Tegnap óta van némi adat az előállítási költségről. Az RTX 3080 átlagosan 670 dollárból készül. Nincs hova csökkenteni az árat, mert már most is előállítási költségen megy a termék. Az FE konkrétan az előállítási költség alá van árazva, ezért sem lehet megvenni.

A GA103 valószínűleg nem véletlenül céloz olcsóbb gyárthatóságot.

A fő árzabáló egyébként a komplex NYÁK, a hűtés, illetve a GDDR6X. Utóbbi extrém drága, a Micronnal alig tudnak megegyezni a gyártók, mert nincs alternatíva, nincs árverseny, igény viszont van, tehát egymásra licitálnak azért a kevés memóriáért is.

Úgy néz ki, hogy nem a Samsung a hunyó. Egyszerűen mindenkinek van egy számolt veszteség, amit havonta be tudnak vállalni a 3000-es sorozattal, és annál többet nem szállítanak.

Ilyen helyzetben egyébként az NV-nek kellene lépnie, és átvállalni a veszteséget, mert a gyártók ezt a problémát maguk nem fogják megoldani. Pár hónapon belül azért rendeződhet a helyzet, tehát nem kell ezt örökké veszteséggel, vagy annak környékén adni. Egyszerűen csak túltermelésbe kell kényszeríteni a Micront, és rögtön sokkal olcsóbb lesz a GDDR6X. -

EXA

aktív tag

válasz

KillerKollar

#49613

üzenetére

KillerKollar

#49613

üzenetére

De ez eddig nem így volt

Ha minden évben az ember mindent csutkán akart/akar tolni, akkor bizony elég gyakran kellett/kell kártyát cserélni a gépben. Nem egy ember van, aki azért cserélgeti gyakran a kártyát, hogy még véletlenül se kelljen valamelyik grafikai opciót ultrá-ról very high-ra lekapcsolni. Neked milyen kártyád volt a 3080 előtt? Gondolom te is azért vetted ezt a kártyát, hogy majd a Cyberpunk-ot kompromisszum mentesen tud élvezni. -

Jack@l

veterán

válasz

KillerKollar

#49613

üzenetére

KillerKollar

#49613

üzenetére

Nem kötelező max grafikán játszani, GTA V is figyelmeztetett settingsben, hogy kevés a vramod.

-

KillerKollar

őstag

válasz

Jack@l

#49601

üzenetére

Jack@l

#49601

üzenetére

De nem mindenki fogja megvenni a legújabb kártyákat. Rengeteg ember fog még 1-2 évig 2070/2080-asokat használni 8GB memóriával, az alap 3070 is csak 8GB-os és ha a 20GB-os 3080 200-300$-al drágább lesz akkor lehet, hogy az sem lesz olyan népszerű mint a 10GB-os.

Addig amíg ez a generáció a legfrissebb addig nem hinném, hogy a fejlesztők hagynák, hogy elfogyjon a 10GB memória, főleg tripla A-s címeknél, ahol azért van egy komoly fejlesztőcsapat, 1-2 összetákolt optimalizálatlan indie címnél lehet, hogy nincs arra kapacitás, hogy erre odafigyeljenek de túlnyomó részt kétlem, hogy a közeljövőben ez probléma lenne.

Ha igen, akkor mindenki veheti meg az 1000$-os csúcskártyát, akinek meg "csak" egy 3060/3070 8GB kártyára tellik az mehet a búsba...

-

Jack@l

veterán

Majd ha nem csak cherry picked játékok lesznek dx12 alatt, ez kicsit átrendeződik.

-

átvitt értelemben de ide kapcsolódik.

Úgy néz ki Nv törölte a 3070 Ti-t mert nincs GPU( ugyan arra épült volna mint a 3080) kb ez lett volna szerintem tegnap leakelt kártya ellenfele.Úgy látszik még is csak problémás kihozatal.

Innentől nincs a navira álasz NV-nél. -

A Xilinx esélyes akkor lehet, ha komolyan gondolja a két cég az Intel szétzihálását. Én már írtam régebben is, hogy erre megy ki a móka és ezért van eza hatalmas befektetés Nvidiánál is. 90 % szerver piacrész. Ha csak az 40 % ami lehullik és azt felosztják is megtérül mind az ARM mind -talán- a Xilinx.

-

atok666

őstag

válasz

KillerKollar

#49599

üzenetére

KillerKollar

#49599

üzenetére

Az lesz a szivas, mikor ekkora hype utan kijon vegre a CP2077 es egy nagy csalodas lesz... (ne ugy legyen)

Atok

-

válasz

szmörlock007

#49605

üzenetére

szmörlock007

#49605

üzenetére

30 MRD-ert? Sztem szinte biztos, hogy kacsa...

-

Abu85

HÁZIGAZDA

válasz

Jack@l

#49601

üzenetére

Jack@l

#49601

üzenetére

Az új generációs konzolokon eleve finomszemcsés adatmenedzsment van, míg PC-n egyelőre szabványosan csak durva szemcsézettségű érhető el. Ez azért nagy hátrány, mert ha egy játéknak mondjuk kell egy textúrából 4 kB-nyi adat, akkor azt a konzol 4 kB-os lap szintjén be tudja tölteni, míg PC-n be kell tölteni az egész textúrát, ami több megabájt is lehet. Hiába kell neked belőle csak 4 kB-nyi adat, nem tudod csak azt beolvastatni. Ezek azért elég nagy különbségek. Emiatt nem is érdemes a memóriákat összehasonlítani, mert konzolon a memóriahasználat nem pazarló, míg PC-n erősen pazarló sajnos.

-

Robi BALBOA

őstag

A normális ár nem csak rajtuk múlik, ha a kereskedők elkezdenek kavarni, akkor cseszhetjük mi azt, hogy mondjuk az AMD $600-700 MSRP-t adott meg.

Szerintem ha lesz is hiány közel sem lesz akkora mint Nv-nél, erre a nyakamat tenném rá.

Bejáratott gyártósoron vannak, elvileg nem hatalmas 600+mm2 a lapka, a memória sem szívatja őket, mert sima gddr6-ot használnak.(#49599) KillerKollar: Azért a 360k az mégsem 440. A 360-at még el lehet fogadni hype árnak.

-

Jack@l

veterán

válasz

KillerKollar

#49599

üzenetére

KillerKollar

#49599

üzenetére

De ha kijonnek a 16-20 gb-os kártyák, akkor már a közép-felső kategóriában se a 8-10 gb lesz a korlát. Max a játékot nem fogod futtatni max grafikán. A konzolokon viszont kb 8 lesz grafikára, ez az ami vissza fog fogni csomó konzolszökevény játékot minőségben.

Új hozzászólás Aktív témák

Hirdetés

A topikban az OFF és minden egyéb, nem a témához kapcsolódó hozzászólás gyártása TILOS!

MIELŐTT LINKELNÉL VAGY KÉRDEZNÉL, MINDIG OLVASS KICSIT VISSZA!!

A topik témája:

Az AMD éppen érkező, vagy jövőbeni új grafikus processzorainak kivesézése, lehetőleg minél inkább szakmai keretek között maradva. Architektúra, esélylatolgatás, érdekességek, spekulációk, stb.

- Autóhifi

- Sony MILC fényképezőgépcsalád

- Egy szenzor, két zoomkamera: újraírta a Huawei a mobilfotózás történetét

- PlayStation 5

- Mibe tegyem a megtakarításaimat?

- exHWSW - Értünk mindenhez IS

- HiFi műszaki szemmel - sztereó hangrendszerek

- Nintendo Switch 2

- OLED monitor topik

- Milyen légkondit a lakásba?

- További aktív témák...

- Bomba ár! Lenovo ThinkPad Yoga 260 - i5-G6 I 8GB I 256SSD I 12,5" Touch I W10 I Cam I Gari!

- Telefon felváráslás!! Xiaomi 13T, Xiaomi 13T Pro, Xiaomi 14T, Xiaomi 14T Pro

- Apple iPhone 11 64GB, Kártyafüggetlen, 1 Év Garanciával

- Telefon felvásárlás!! Apple iPhone SE (2016), Apple iPhone SE2 (2020), Apple iPhone SE3 (2022)

- Samsung Galaxy S23 / 8/128 GB / Gyárifüggetlen / 12hó Garancia

Állásajánlatok

Cég: PCMENTOR SZERVIZ KFT.

Város: Budapest

Cég: Liszt Ferenc Zeneművészeti Egyetem

Város: Budapest

Hogy a kártya előállítási költsége az msrp 95%-a? Jézusom hagyjuk már ezt, semmilyen belsős infó nem kell ahhoz hogy tudjad hogy ez óriási kamu. Igen valószínűleg 10GB VRAMért 300 dodót fizetnek

Hogy a kártya előállítási költsége az msrp 95%-a? Jézusom hagyjuk már ezt, semmilyen belsős infó nem kell ahhoz hogy tudjad hogy ez óriási kamu. Igen valószínűleg 10GB VRAMért 300 dodót fizetnek

De lehet még ezer más oka is, amiről nem tudunk. Viszont a fenti listámat (hogy mikor lennék elégedett az új Radeonokkal) újra elő fogom kaparni és vitázhatunk majd rajta, hogy a gyakorlatban mit sikerül(t) teljesíteni belőle. Tanulságos lesz szerintem.

De lehet még ezer más oka is, amiről nem tudunk. Viszont a fenti listámat (hogy mikor lennék elégedett az új Radeonokkal) újra elő fogom kaparni és vitázhatunk majd rajta, hogy a gyakorlatban mit sikerül(t) teljesíteni belőle. Tanulságos lesz szerintem.

![;]](http://cdn.rios.hu/dl/s/v1.gif)