Hirdetés

- Szénszál és réz találkozik az Inno3D egyslotos RTX VGA-in

- Vezetékmentes és kompakt gaming klaviatúra a Cherry Xtrfy védjegyével

- Cserélhető filtereket biztosít az Elgato legfrissebb, 4K-s webkamerája

- A YouTube-ot is betiltják a gyereknél az ausztrálok

- Gyilkosságban és öncsonkításban akart segíteni a ChatGPT

- Milyen processzort vegyek?

- Haladó fájlrendszerek, de mire jók? Ext4 vs Btrfs vs ZFS vs APFS

- Milyen notebookot vegyek?

- Házimozi haladó szinten

- AMD K6-III, és minden ami RETRO - Oldschool tuning

- Azonnali VGA-s kérdések órája

- Kormányok / autós szimulátorok topikja

- Nem indul és mi a baja a gépemnek topik

- Egér probléma

- Fejhallgató erősítő és DAC topik

Hirdetés

Talpon vagyunk, köszönjük a sok biztatást! Ha segíteni szeretnél, boldogan ajánljuk Előfizetéseinket!

-

PROHARDVER!

A legtöbb kérdésre (igen, talán arra is amit éppen feltenni készülsz) már jó eséllyel megtalálható a válasz valahol a topikban. Mielőtt írnál, lapozz vagy tekerj kicsit visszább, és/vagy használd bátran a keresőt a kérdésed kulcsszavaival!

Új hozzászólás Aktív témák

-

b.

félisten

válasz

S_x96x_S

#68294

üzenetére

S_x96x_S

#68294

üzenetére

2 év múlva a 16 nak valóban alapnak kell lennie, egyetértek, akár az XX60 és azzal egyszintű kártyákon is a konkurenciánál.

Én most is minimum 12 GB ra számítottam az 5060 kártyáknál, illetve annyi jó lenne rajt. Bízok abban hogy a sok negatív Vram miatti elmarasztalás a 3 Gigás GDDR7 verziók felé tereli a zöldeket.

16 GB -tal azért sok gond nem lesz szerintem. -

-

Busterftw

nagyúr

válasz

hahakocka

#68293

üzenetére

hahakocka

#68293

üzenetére

Nem arról van szó, hogy ne adott volna több vramot "olcsóbban" , arról van szó, hogy nem vált előnyére.

Ezt mutatják a tesztek. Erősebb gpu-val többre mentek volna."Meg Sponsor vagy optimalizálás támogatás lefizetés függő????"

Nem tudom, az AMD milyen fejlesztéssel csökkenti +vram igényt?

"Te terelsz mert én a lényeget mondtam"

Csakhogy nem ez történt, a lényeget a fenti tesztek mutatták meg amit Alogonomus linkelt, aztán te hoztad a minimum FPS mantrát, amit szintén nem támasztanak alá a fenti tesztek, mert arra sem voltál képes, hogy megnézd.

Azért nem, mert ezeket a mantrákat már évek óta autopilot módjára csak beírod. Ezerszer meg lettél cáfolva, de egyik füleden be, a másikon ki."Nem az átlag és MAX ról beszélek"

Tudom, minimum FPS-t írtál , az van a tesztben, ahogy írtam.

Elég lett volna megnyitni a linket és rászánni 2 percet . -

Jacek

veterán

válasz

hahakocka

#68293

üzenetére

hahakocka

#68293

üzenetére

Mint emlitettem a zold anyaszentegyhaz elvakult tagjaival olyan beszelgetni mint sajtreszelovel onkielegiteni, erdekes de felettebb fajdalmas.

Merthetetlen monotonitas turessel rendelkeznek, addig ismetelnek teljesen fals baromsagokat mig a anyaszetegyhaz tagjai elhiszik teljes mertekben, semminemu bizonyitek nem gyozi meg oket, azokon azonnal valasz nelkul atsiklanak.

Akar ugy is hogy ok ideztek be oket es kiderul hogy telhesen hamis, ha valtozik a szeljaras a hatranyokbol azonnal elonyok lesznek, teljesen mindegy hogy mi az.

Hasonlosag fedezheto fel kormanyunk tamogatoival, a valosag nem erdekli oket csak az anyaszetegyhaz ukaza.

Heti pelda a jo es a rossz szankciok

Felesleges veluk barminemu kommunikacio, a premium tagsag ajanlott es ignore azonnal.

UI: pont lejart a premium es az egyik peldanyuknak lattam megint az amokfutasat(igaz ez nem a termeszetes elohelye mert AMD tipic), mar veszem is a premet.

-

S_x96x_S

addikt

válasz

Busterftw

#68289

üzenetére

Busterftw

#68289

üzenetére

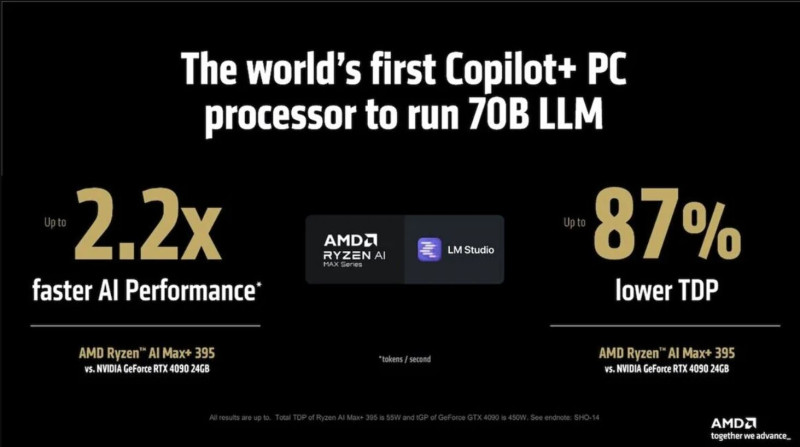

> Milyen LLM gaming benchmark alapjan jar jobban a Radeon a +vram miatt?

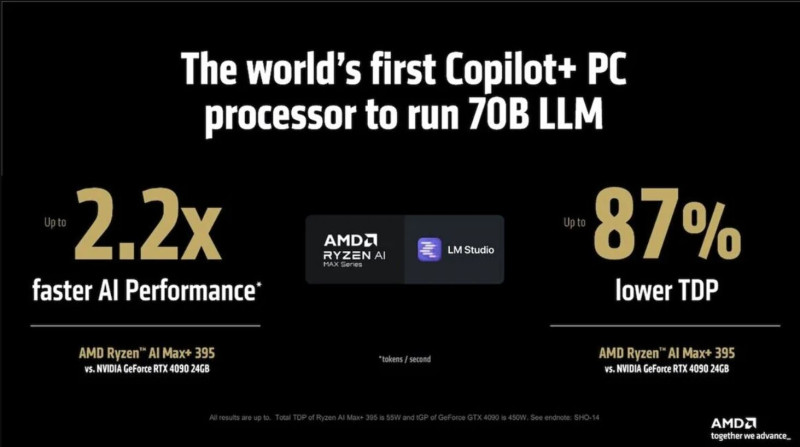

Amúgy nem csak a gaming, hanem a többi téma is fontos.

( "accelerate your gaming, creating, productivity, and development." )És a radeon is rosszul jár a VRAM hiányra,

úgyhogy én nem az AMD vs. NV -ra élezném ki.

mert ugyanez a kérdés, az nvidiánál is.

"RTX 4060 Ti 8GB vs 4060 Ti 16GB"

2023 -as teszt:

RTX 4060 Ti 16GB Roughly 40% Faster Than 8GB at Higher Resolutions

és azóta még rosszabb a helyzet, sokkal több modern játék van8GB és 12GB VRAM például a következő esetekben lehet problémás:

- ~neural network chess engine ( sakk ) nagyobb háló - jobb játék.

- szöveges játékok

- Virtuális karakterek

- ...Neurális hálók - szinte mindenhova jönnek - nem csak a játékokba.

és minél nagyobb ( és jobb ) a modell, annál több a VRAM igény.

VRAM Requirements for Different Neural Network Architectures

- Small feedforward networks (e.g., 2-3 layers, 100-1000 neurons per layer):

1-4 GB - VRAM

- Medium feedforward networks (e.g., 4-6 layers, 1000-5000 neurons per layer):

4-16 - GB VRAM

- Large feedforward networks (e.g., 6-10 layers, 5000-20,000 neurons per layer):

16-64 GB VRAM

( innen )A VRAM probléma főleg mobil GPU-nál jelentkezik - ami az eladások jelentős része.

És a modern játékokban 8GB VRAM már kevés.

- mobil RTX 4070 , 8GB VRAM - 256.0 GB/s

- A 128GB -os Strix Halo -ban 12x annyi VRAM.

AMD: Strix Halo can beat the RTX 4070 laptop GPU by up to 68% in modern gamesVárhatóan az év végén kijön az NVidia is az ARM-es APU/PC -jével,

és ott is meg fog szaladni a VRAM mennyiség. ( 32 - 64 - ... )Valamint jön az Intel is a saját HALO-APU-s termékével, rengeteg VRAM-al.

És a trendet az Apple indította el, mindenki őt követi.

( Macbook Pro, Mac Studio , M2 Ultra, .. )A fentiek alapján

a két év múlva megjelenő modern játékokban én már

min. 16GB VRAM követeleményt is normálisnak tartom.Persze a Sony PS6 VRAM Spec - fog sok mindent meghatározni.

Vagyis a Sony a fejlesztők kéréseit - hogyan értelmezi

és mennyi VRAM-ot rak a következő konzolba. -

hahakocka

őstag

Na most már fontos lett a sok vram hogy végre a 1.3 milliós karira legalább rakott több vramot az NV?

Eddig az AMD adott minden szegmensben kivétel legalsó kateg több vramot vagy egált sokkal olcsóbb kategben. S most elvileg a 9060 is 12-16 gb ot fog adni sokkal olcsóbban. Mint annó az Intel csak ott meg ugye a régebbi procikkal van most gond hogy nem igazán működik jól együtt az amúgy nem rossz Intel VGA. Ott is 12 gb van alsó kategben.

Eddig az AMD adott minden szegmensben kivétel legalsó kateg több vramot vagy egált sokkal olcsóbb kategben. S most elvileg a 9060 is 12-16 gb ot fog adni sokkal olcsóbban. Mint annó az Intel csak ott meg ugye a régebbi procikkal van most gond hogy nem igazán működik jól együtt az amúgy nem rossz Intel VGA. Ott is 12 gb van alsó kategben.Ja 400 mb al hatalmas

s vajon majd minden gamenl vagy gamefüggő lesz? Meg Sponsor vagy optimalizálás támogatás lefizetés függő????

s vajon majd minden gamenl vagy gamefüggő lesz? Meg Sponsor vagy optimalizálás támogatás lefizetés függő????Te terelsz mert én a lényeget mondtam hogy mi az ami érezhetően rossz gamingelés alatt.. Stuterring, előtted rajzolja ki a textúrákat (ez nálam is volt már a 2GB os karimnál annó amikor 4 kellett volna már neki s ez ma is megvan 8-12 es kártyákkal az új gameknél), a hirtelen beesées 12-15 fps es gameplayek nagyon jó élmények! Tele a youtube és a google vele szerinted lehet kamu de nem az. Nem az átlag és MAX ról beszélek meg egy szimpla benchmark tesztről. S mint mondottam az NV által fizetett sponsorált gameknél ha a hátukon lávát folyatnak is megoldják majd hogy menjen

-

Busterftw

nagyúr

válasz

hahakocka

#68291

üzenetére

hahakocka

#68291

üzenetére

Aham, előbb a fentiekre kellene valamit válaszolni, most hogy megint nem jött ki a matek, persze a terelés egyszerűbb, hozzászoktunk .

Most majd jön valami YouTube teszt KarcsiTechRadeonForeva-től aki kimérte."De a DLSS és FSR meg az RT bekapcs is + vramot kér."

Nvidianal épp kevesebbet vramot kér. Ezen is átsiklottál . -

hahakocka

őstag

válasz

Busterftw

#68276

üzenetére

Busterftw

#68276

üzenetére

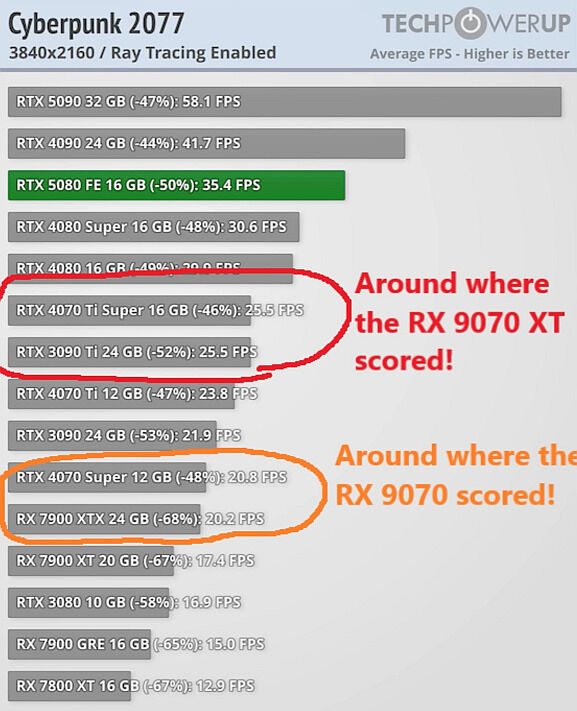

Te megnézted a sok videós tesztet vagy gameplay cideót ahol stuttering van előtted rajzolva a textúrákjat a game vagy beesik 10-20 fps re néha game mert épp elfogy a vram? Az hogy max fps vagy átlagra mit hoz a vram bajt nem annyira jellemzi, kivétel ha már annyira kevés a vram hogy az átlagot is érinti. S az NV sponsor gameken még jó hogy megy NV n a vram hiánya ellenére is.

Azért fizetnek érte meg hogy arra optimalizálják.

Azért fizetnek érte meg hogy arra optimalizálják.

A vram amúgy ahogy írták mások is előny AI nál s munkára és ott érdekes most AMD hozza a 4090 et a kevesebb mint féláras kártyájával! Deepseek ugye. De a DLSS és FSR meg az RT bekapcs is + vramot kér. S ez kihat a gamingre is majd. Mint mondottam NV sponsor gameknél persze hogy megy NV n. D

Deepseek ugye. De a DLSS és FSR meg az RT bekapcs is + vramot kér. S ez kihat a gamingre is majd. Mint mondottam NV sponsor gameknél persze hogy megy NV n. D -

S_x96x_S

addikt

válasz

Busterftw

#68287

üzenetére

Busterftw

#68287

üzenetére

> a diszkurzus, gamingről volt szó.

A gaming-be is jön az LLM.

És az nvidia is promózza az AI PC elgondolását.

"Upgrade to advanced AI with NVIDIA GeForce RTX™ GPUs and accelerate your gaming, creating, productivity, and development."

vagy

NVIDIA Launches AI Foundation Models for RTX AI PCs

"NVIDIA NIM Microservices and AI Blueprints Help Developers and Enthusiasts Build AI Agents and Creative Workflows on PC" -

Busterftw

nagyúr

válasz

S_x96x_S

#68284

üzenetére

S_x96x_S

#68284

üzenetére

Csak ha visszaolvastad volna miről ment a diszkurzus, gamingről volt szó.

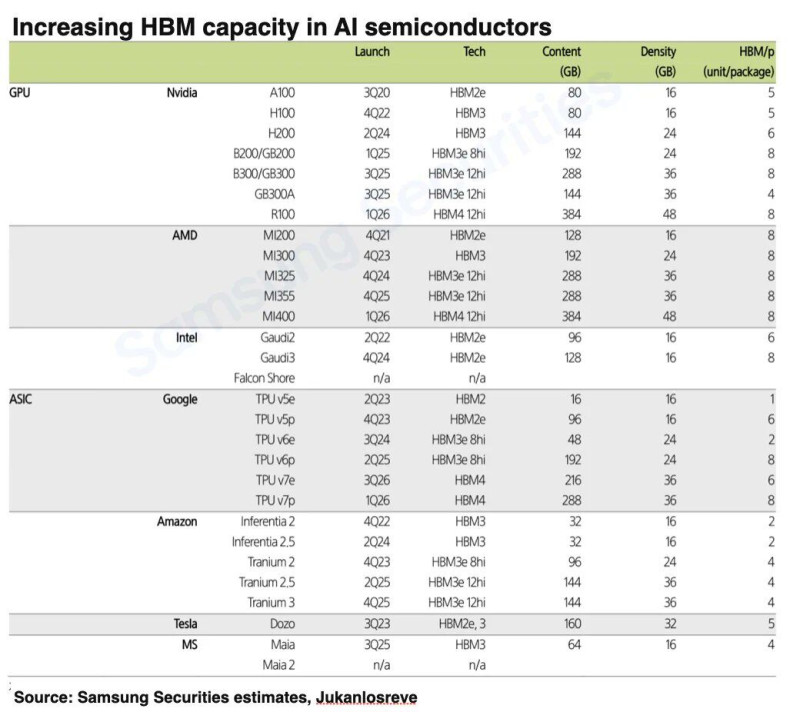

Az Nvidia meg köszöni szépen jól van az AI gyorsítókkal, a vram helyett inkább az AMD foglalkozzon a szoftverrel, ha már az egész iparág szerint egy hatalmas bottleneck.Az Nvidia 32GB-ig ad lehetőséget Vram-ra , az AMD meg 24GB, ami egy last genes megoldás.

Szóval erről ennyit. -

-

S_x96x_S

addikt

"AMD Instinct MI400 chiplet design to feature new Multimedia IO Dies"

https://videocardz.com/newz/amd-instinct-mi400-chiplet-design-to-feature-new-multimedia-io-dies -

S_x96x_S

addikt

válasz

Busterftw

#68271

üzenetére

Busterftw

#68271

üzenetére

> Ezt nem látni a számokból, illetve nem magyarázza meg ,

> hogy miért előny ott a 16GB Radeonon.

> Vagy a 20GB vs 16GB. Vagy a 24GB vs 16GB.pl. Deepseek és más LLM-ek futtatásánál előny a sok VRAM

és ez hamarosan jön a játékokba is.A sok VRAM hatását az AMD is kidomborítja

pl. StrixHalo-s PR anyagokban,

> Vagy a 20GB vs 16GB.az nVidia tudatosan kihagyja az RTX 4080, RTX 5080 -at az LLM-es tesztekből.

és csak 4090 (24GB) , 5090 (32GB) -ot tesz a tesztekbe. --> #48778

(persze egy marketinges feladata, hogy az előnyöket kidomborítsa és a hátrányokat elrejtse - úgyhogy ebben semmi furcsa sincs. )A DeepSeek hatás - megnöveli a VRAM igényt;

és ami eddig "elég"-nek tűnt , az hirtelen már kevés lesz.A fenti gondolatok lényege - hogy a jövőben jobban kelleni fog a VRAM

És persze emiatt az RX 9070 - 16GB se annyira ideális,

és csak a 8GB, 12GB -hoz képest látszik jobbnak.Vagyis ha valaki Pro/Con * nVidia/AMD - ba szeretne bekategóriázálni,

akkor jelzem, hogy én inkább a PRO VRAM -táborba sorolom magamat,

és az AMD-től is elvárom a több VRAM-ot - nemcsak az NVidiától.

Amúgy majd az idő eldönti.

-

válasz

Hellwhatever

#68281

üzenetére

Hellwhatever

#68281

üzenetére

Már AMD volt akkor a tulaj, a márkanevet nem azonnal cserélték, csak később.

Mód: jól elkéstem.

-

Quadgame94

őstag

válasz

Hellwhatever

#68281

üzenetére

Hellwhatever

#68281

üzenetére

Már nem. AMD 2006-ban vásárolta fel őket.

-

fatal`

titán

válasz

deathcrow42

#68254

üzenetére

deathcrow42

#68254

üzenetére

AMD sosem hozott ki kártyát, ami 25%-nél több árelőnyt jelentett volna nagyjából

HD4850 Bár nem ma volt.

Bár nem ma volt.Annak az ellenfele nagyjából az 512MB-os 8800GT volt ($199 vs $349).

-

Jacek

veterán

válasz

hahakocka

#68275

üzenetére

hahakocka

#68275

üzenetére

Felesleges vramrol targyalni az utakkal, bebizonyitod hogy igenis elfogy, hab6 -an nem tudnal elnyomni a bullshittel akkor 1 honap pihi utan ujra kezdik.

Pl Alan Wake 40x belinkeled hogy ossze fossa magat a dicso 12Gb, linkelnek egy tesztet ahol le van irva hogy a fejleszto csokkentette a vram hasznalatot plusz kikapcsoltak dolgokat hogy a 12Gb kartyak ne hugyozzaknossze magukat, de nekik ez bizonyitek

Outlaws.. az is bizonyitek ... ja ahol ha elkezd elfogyni a vram elkezdi butitani a texturakat az engine automatice.

Hagyjad mar ezeket az embereket, ha mond valamit Zuzu Petaz.. -

hokuszpk

nagyúr

"Egyáltalán nem lehetetlen, én nem ebből a szempontból kérdeztem, hogy lehetséges e, hanem hogy ez szerinted megvalósulhat e ez, hogy ugyan azon a gyártáson jobbak mint a zöldek?"

azt nemmondom, hogy jobbak lesznek, mint a Zöldek, de hogy ésszel nagyot lehet előrelépni ugyanazon a technológián, azt az AMD 7nm -en már bebizonyította a Ryzen 3xxx vs 5xxx procikkal. Mondjuk nekem már a 3800XT is sokkal jobbnak tűnt, mint a sima 3800X, mert magasabbra boostolt, és jobban kitartota a boost órajeleket -- lehet, hogy abból is csak szimplán megnyertem a sziliciumlottót -- aztán az 5700G még annál is jobb volt ~10% -al, pedig azon felezett cache van. Az 5800X meg még erre is pakolt ; bár igazából csak benchekben meg esetleg játékokkal jön ki, de utóbbit nemtudom megerősíteni, mert nem játszom.

-

-

hahakocka

őstag

válasz

Busterftw

#68273

üzenetére

Busterftw

#68273

üzenetére

Nem az átlag vagy max FPS a minden. A textúra betöltési anomáliák kevés VRAM miatt, a hirtelen leesés 12-15fps re az 1%-0.1% low ok stb. Nem minden az FPS átlag vagy max FPS ami egy pillanatra van csak.

Sok gamenél van ez amikor kifogy épp a 12 gb ramból akkor akkora lag van kb mint a franc. Vagy a pályarészek textúráit látod hogy tölti be épp vagy a részleteit élesíti, erősíti épp előtted Vagy lejjebb kell venned csak a vram miatt a felbontást vagy a textúra minőséget s most nem az ULTRA a lényeg annak egyébként szerintem se sok értelme van. Alig ad hozzá sokat elvesz az ULTRA

Vagy lejjebb kell venned csak a vram miatt a felbontást vagy a textúra minőséget s most nem az ULTRA a lényeg annak egyébként szerintem se sok értelme van. Alig ad hozzá sokat elvesz az ULTRA -

hahakocka

őstag

válasz

Alogonomus

#68249

üzenetére

Alogonomus

#68249

üzenetére

Persze nincs rossz kártya, csak rossz ár tartja a mondás

A gond az ár hogy 12 gb ost kapsz annyiért amennyiért 5070 esetén 320-340e ért talán kb majd egy AIB kártyán.

-

Busterftw

nagyúr

válasz

Alogonomus

#68268

üzenetére

Alogonomus

#68268

üzenetére

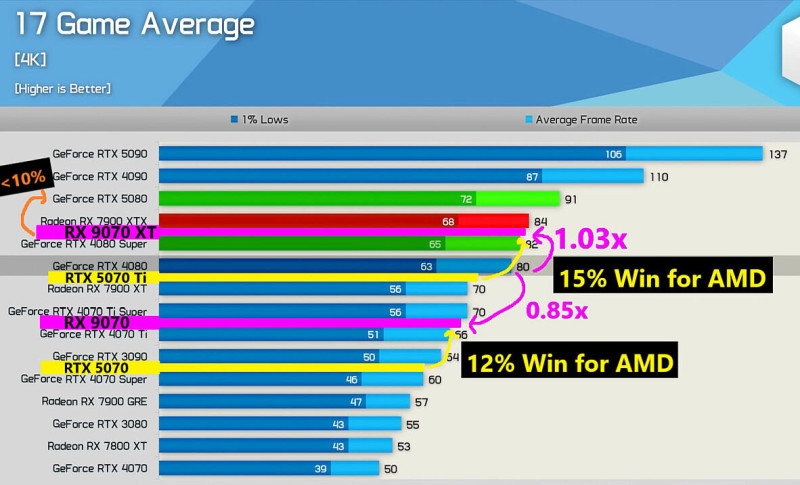

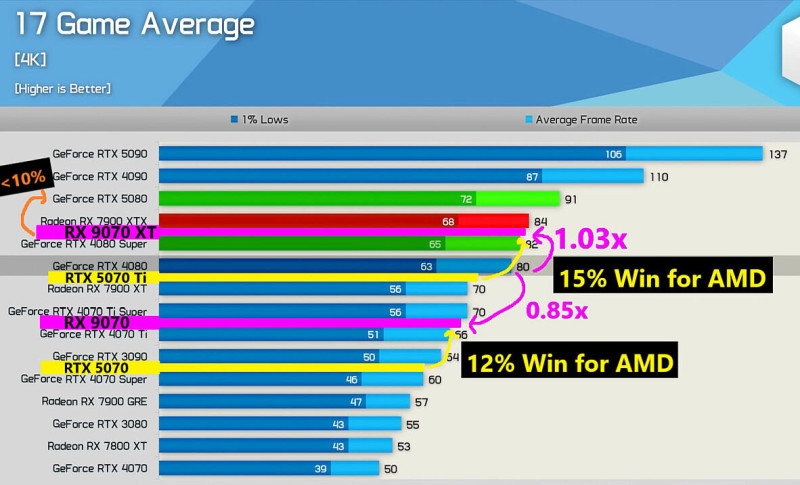

Megnéztem a 4K-t, a 16GB-os GeForce előbbre van mint a 24GB Radeon. Ahogy a 12GB és 16GB is előbbre van mint a 20GB Radeon.

A framegen/dlss megint marhaság, amikor épp ebben a genben csökkent ennek a vram fogyasztása .

Igaz csak 1 játékot demoztak és 400mb mínusz, de az is valami. -

b.

félisten

válasz

Quadgame94

#68267

üzenetére

Quadgame94

#68267

üzenetére

Én ezt a naív feltételezésnek gondolom, józan paraszti ésszel gondold végig.

Hónapokkal ezelött bekerült a a 9070 és 9070 XT elnevezés és milyen érdekes hogy elméletileg 5070 Ti és 5070 körüli teljesítményt fognak hozni.

Ha valóban azt gondolták volna, hogy az Nvidia 40 % ot lép előre, akkor ezeket a kártyákat most 9060-nak hívnák, ezért nem áll meg ez a konteó az én szememben. -

Quadgame94

őstag

Eléggé hülyeség lenne kiindulni ezekből mert a 7800 XT is jól fogyott a legeslegelején aztán már nagyon nem. Az évnek lesz második fele is.

Abből amit eddig láttunk pont az ellenkezője látszik. Az AMD eléggé elmerte magát... akkor hogy egyeztek volna meg bármiről is? Ha így lett volna szépen bejelentettek volna a kártyákat kicait aláárazva úgy jogy az FSR majd caak később jön. Ez lett vna a tpukus AMD move

-

Alogonomus

őstag

válasz

Busterftw

#68259

üzenetére

Busterftw

#68259

üzenetére

Akkor nem értetted meg a hozzászólás lényegét. A 600 dolláros 12 GB-os kártya és az 1000 dolláros 24 GB-os kártya összehasonlításáról szólt.

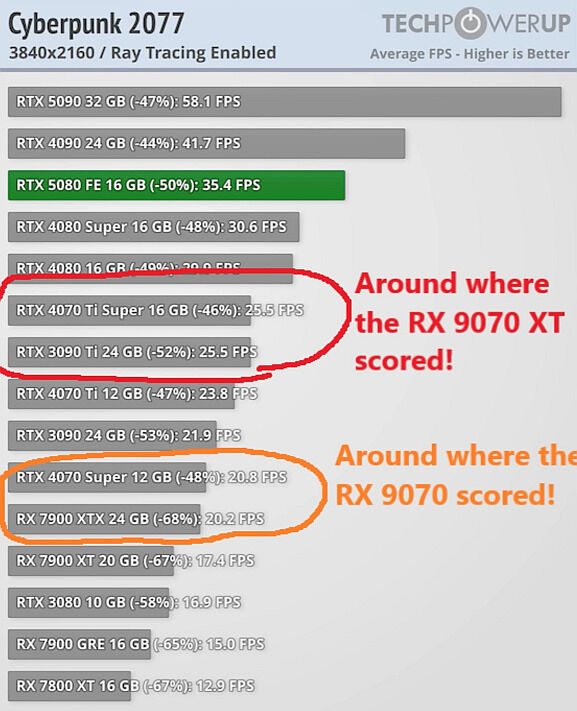

Egyébként bár 1440p-ban még tartja magát a 12 GB Nvidia, de nézd meg 4K-ban az eredményeket, és meglátod a 16 GB értékét. Egy ideig segít a textúra "butítása", a "texture swapping", meg egyéb "mágiák", de 4K-ban már kiütközik az elégtelen memória következménye.

Ráadásul az Nvidia egyre inkább a framegen fokozásában látja a teljesítményproblémákból kivezető utat, viszont a framegen maga is további memóriahasználattal jár. -

Terek

tag

válasz

Quadgame94

#68252

üzenetére

Quadgame94

#68252

üzenetére

Az amd most megnézi,hogy nyelik be a népek a +2-300$-os árakat nv oldalon aztán ahhoz áraz.Több mint valószínű ez egy lezsírozott dolog kettejük között.

Igazából a "papíron" 549$-os 5070 nemtétel(elképesztően hurka,konkrétan egy 4070 ddr7-es memóriával semmi több mivel spec alapján szinte ugyanaz).Szóval ez alá nemnagyon kell várni az új amd kártyákat.

Az amd akkor mehetne nagyot ha mindent bedobna 500$ alá,még aib-ok sem mennének e fölé.Megtörténhet? Biztosan nem

-

X2N

őstag

válasz

deathcrow42

#68263

üzenetére

deathcrow42

#68263

üzenetére

Láttam videót róla. Ha engem kérdeztek legyen vram, még ha nincs is kihasználva, minimum fps meg ilyennek miatt, nálam alap a maximális minőségű textúra évek óta, ez az első amit beállítok settings-ben.

-

Quadgame94

őstag

válasz

deathcrow42

#68256

üzenetére

deathcrow42

#68256

üzenetére

Ez még RDNA4. IPC növekedés is lesz ezt már megerősítették. Ha logikusan átgondolja bárki rajöhet hogy a helyenként 450 dolláros 7800 XT-t akart levaltani az AMD. Azzal számoltak hogy a 7900 XT ami 30% gyorsabb lesz kb az a teljesitmény amit be kell lőniük 500-550 dollárért. Namost ennél több is összejött az NV meg alig hiz pár szazalék előrelépést

Fogyasztás: Ők lépnek előre node tekinreteben, plusz arch. tekinteteben is. Dobják az MCm-et is. A 250W a 7800 XT esetébn eleve rosszul nézett ki. Innen előre lépni nem nagy dolog. Kötelező.

-

-

gejala

őstag

válasz

Alogonomus

#68257

üzenetére

Alogonomus

#68257

üzenetére

Remélem nem onnan szeded ezeket a dolgokat, hogy megnézed mennyire írja tele a VRAM-ot egy játék. A linkelt TPU tesztek ugye ezt mutatják és mint tudjuk, a mai játékok addig töltik a VRAM-ot, amíg van. És mivel ők 24 gigás kártyán tesztelnek, így persze, hogy sok giga lesz a memóriában. De azt lehetetlen megmondani, hogy adott jelenethez mennyit használ a játék, csak a beszaggatásból lehet sejteni, ha kevés a VRAM.

-

b.

félisten

válasz

Quadgame94

#68255

üzenetére

Quadgame94

#68255

üzenetére

Egyáltalán nem lehetetlen, én nem ebből a szempontból kérdeztem, hogy lehetséges e, hanem hogy ez szerinted megvalósulhat e ez, hogy ugyan azon a gyártáson jobbak mint a zöldek?

Mert az Nvidia 4N-t hazsnál az Ada-nál a 4080 nál és 320 W TGP-t alkalmaznak ,de Supernél többet.tehát 25 % körül jobbnak kellene lenniük azonos fogyasztáson HA 4080 supert feltételezünk, azonos gyártáson.

Tehát tulajdonképpen egy RTX 4080 at kell hozniuk, ami nem lehetetlen.

Ami kérdés, hogy ha szerinted ez áll a probléma hátterében, hogy ezt meg tudják valósítani és ezen ledöbbentek, hogy meg tudják valósítani amit az AMD vezér nem rég nyilatkozott az árazásról az ár / értékről akkor most mi a probléma?

Alogonomus: Induljunk ki abból hogy sokkal jobb lenne amúgy szerintem is ha a 5070 18 Gigás lenne vagy 16. és 8 Gigás kártyát nem adnék ki már 2025 ben.

Amit írtam már memória mizzériára hogy engem sokkal de sokkal jobban zavarna annál az hogy van 2-3 játék ahol az ultra textúra felbontást vissza kell vennem Highre kártyán

( ha kell egyáltalán ez DLSS és 1440P mellett,12 GB ról beszélünk nem 8 ról) mint ha egy Metroban vagy egy CP ben vagy bármilyen játékban ami hardveres RT-t használ a csúcs 1000 dolláros kártyám, RT -t aktiválva a középmezőnyben kotorna vagy hogy az FSR olyan anomáliákat okoz a játékokban a DLSS -sel szemben amitől számomra használhatatlan kategória lesz ugyan ezen a szép drága kártyán...és ezzel nem én gondolkodok így hanem a piac jó része, ezért csökkent a radeon részleg..Erre az AMD is szépen rájött, neked is rá kellene, mert az RDNA 4 nél az RT-t és az FSR-t fejlesztették és nem 24 Gigát tettek egy középkategóriás kártyára, ami egy jó irány, ez kell a piacszerzéshez.

-

Busterftw

nagyúr

válasz

Alogonomus

#68257

üzenetére

Alogonomus

#68257

üzenetére

Hol látszik a 12GB probléma az Outlawsban ?

Mert én azt látom 1440p-ben a 12GB Nvidiak előbbre vannak mint 16GB-al az AMD. -

Quadgame94

őstag

válasz

deathcrow42

#68254

üzenetére

deathcrow42

#68254

üzenetére

Ha csak 10-15% hoznak ki akkor semmire sem mennek vele.

-

Alogonomus

őstag

A gondolatmenetedet továbbvezetve, a 600 dolláros Nvidiás kártya és 1000 dolláros konkurens kártya azonosnak érzékelhető RT teljesítménye addig valósul meg, amíg az adott szoftver fejlesztője kiemelt figyelmet fordított arra, hogy az alkalmazott grafikai megoldások memóriaigénye a 600 dolláros Nvidiás kártyának nehogy problémát okozzanak. A Silent Hill például jó példa az "elég memóriás" helyzetre. Az új Spider-Man esetén már látszik némi probléma. Az Avatar már határozottabban jelzi a problémát, míg a Star Wars Outlaws kapcsán már egyértelműen látszik a kevés memória hatása.

Az idő előrehaladtával pedig csak még egyre nehezebb lesz, egyre több kompromisszumot igényel majd egy program memóriaigényét a 12 GB-os határ alá szorítani, így egyre kevesebb játékban érhet majd el a 600 dolláros kártya olyan teljesítményt, mint az 1000 dolláros kártya, vagy akár egy újabb mondjuk 500 dolláros kártya, amin viszont van 16 GB memória. -

válasz

Quadgame94

#68255

üzenetére

Quadgame94

#68255

üzenetére

AMD 6xxx-nél ami nagy előrelépés volt az 5xxx-hez képest az a nagy 64MB+ cache, mint kb. a prociknál az X3D.

Itt gondolom ami nagy előrelépés lehet, hogy átmennek a 5/6nm processből valami 4/5 nm csíkszélességre. Memória cache megmarad természetesen, és némi arch. előrelépés.

Ez már az UDNA lenne, vagy az utolsó RDNA? Ennyire azért nem követtem az AMD utolsó dolgait gpu terén, 6900XT-m volt, ott még utánanéztem a dolgoknak

-

válasz

Quadgame94

#68252

üzenetére

Quadgame94

#68252

üzenetére

AMD sosem hozott ki kártyát, ami 25%-nél több árelőnyt jelentett volna nagyjából ugyanolyan teljesítmény mellett. Szerinted mennyire esélyes, hogy most nemhogy egy, de 2-3 kártyánál lesz ilyen?

Szerintem semennyire.

És akkor nem számoltam a DLSS vs. FSR különbséget, ami sokat számít, de hátha az FSR4 eléri a CNN modell minőségét, és az már sokkal jobb, mint a régi fsr vs. régi dlss.

Amíg nem jön legalább némi AMD hivatalos graph (ami nem szokott túlzó lenni), addig ez mind csak kőkemény találgatás.

Én csak örülnék, ha ilyen árazás és előrelépés lenne: ez azzal is jár, hogy Nvidia árat csökkent majd, ami nekünk játékosoknak jó.

-

b.

félisten

válasz

Quadgame94

#68252

üzenetére

Quadgame94

#68252

üzenetére

Szerinted 260W fogyasztásból hozni fogja a 4080 Supert és 7900XTX et?

És az a gond most, hogy az AMD megvalósíthatná szerinted amit ígért az ár/értékkel,de ez problémát okoz nekik és ezért 9080-nak kellene elnevezniük az OC-t és többet kérni érte ? Milyen logika ez?

Irreális elvárások vannak ezzel a kártyával kapcsolatban már. -

Quadgame94

őstag

Sokat gondolkodtam azon hogyan is szegmentálhatná az AMD a kártyát az újonnan kialakult helyzetben. A középkategóriát az NV az 5070-el akarják megnyerni, ami lényegében egy 4070 Super. Az AMD árazásban ide akart lőni, de azt hitték az NV ennél többet fog adni és úgye nem így lett. Most biztos azon gondolkodnak, hogy mit csináljanak. Ha feltételezzük, hogy az RX 9070 XT 260W fogyasztás mellett tényleg hozza a 4080 Supert akkor ezt kéne tenniük:

RX 9080 - 699 USD

- 4096 SP

- 330W TDP - vagyis ameddig még értelmezhető OC van benne

= RTX 5080 (1440p)

= RTX 4080 Super +5% (4K)

= RTX 5070 Ti +15-18% (4K/1440p)RX 9070 XT - 549 USD

- 4096 SP

- 250W TDP - Hogy elérje pont az 5070 Ti-t

= RTX 5070 Ti (4K/1440p)RX 9070 - 479 USD

- 3584 SP

- 210W TDP - Annyi hogy az 5070-től gyorsabb legyen

= RTX 5070 +8-10% (1440p) vagy egy 4070 TiÖsszesítve: 4K

RTX 5080 117% 999 USD

RX 9080 113% 699 USD

RTX 4080 Super 107%

RX 9070 XT 100% 549 USD

RTX 5070 Ti 99% 749 USD

RX 9070 85% 479 USD

RTX 4070 Ti 83%

RTX 5070 78% 549 USDA szegmentálás szinte a legfontosabb dolog. Az NV is kijöhetett volna egy RTX 5070-el ami a GB203-ra épül stb. De nem tették. A fenti árakban a 9080 a kakuk tojás... Ha tényleg hozná ezt a teljesítményt kizárt hogy ennyivel olcsóbb legyen...de aztán kitudja?

-

b.

félisten

válasz

Alogonomus

#68249

üzenetére

Alogonomus

#68249

üzenetére

A gondolatmeneteden maradva, mint ahogy sok Nvidiásnak szempont hogy 600 dollárért egy 1000 dolláros konkurens kártya RT teljesítményét kapja meg egy jobb felskálázással és ezt piac el is döntötte.. Ha ez mellémegfelelő mennyiségű Vram lenne mindegyik esetben akkor lenne még jobb.

8 gigás RTX és RX kártyát én sem adnék már ki 2025 ben ez jogos és ezt adom.800 dolláros kártya szerencsére ki lett vezetve anno 12 GB vramal és most sem lesz elérhető ilyen .A 5070 Ti 16 Gigás.

549 dolláros áron lesz az 5070 12 Gigával ami figyelmbe véve a BW előrelépését, igazából ugyan azt adja amit a 4070 super de a BW memóriája és memórakezelése valamivel jobb. ami egy megfelelő kompromisszum lesz sok embernek, népszerű lesz szerintem.A 16 Giga pedig nem lesz kevés egyik gyártónál sem az Nvidiánál gyors vram van nagy L2 vel, jobb tömörítéssel, az az AMD nél lasabb de nagy L3 mal.

Jelenleg az új generációban egyetlen kártya fog adni 16 GB nál többet , (ha csak Nvidia nem kezdi el használni a 3 Gigás modulokat) az pedig 5090-2000-2500 dolláros áron. A PC játék készítőknek erre az anyagra kell dolgozniuk. -

Alogonomus

őstag

válasz

hahakocka

#68246

üzenetére

hahakocka

#68246

üzenetére

Nagyon fontos szempont, hogy milyen árszintre érkezik egy adott kártya. A felskálázás óta technikailag a legtöbb új kártya használható 4K kártyaként, miközben nem 4K kártyának szánták.

A 12 és 16 GB, de még a 8 GB sem önmagában jelent problémát, hanem az adott kártya árának a fényében. Ha egy kártyát az ára és/vagy teljesítménye egyébként is belépő szintre predesztinálja, akkor a 8 GB elfogadható lehet mondjuk 250 dollárért. A problémát az jelenti, amikor a 800 dolláros kártya is csak 12 GB-ot kap, vagy az 1200 dolláros kártya 16 GB-ot, mert egy 800 dolláros kártyával jogos elvárás legalább az élvezhető 1440p, ahogy az 1200 dolláros kártyával is a tisztességes 4K.

Az AMD 'csak' 16 GB-ja az előzetes tippek alapján nagyjából 400-450 és 500-600 dollárért érkező kártyákon nem lesz kevés, hiszen az áruk alapján az alsóközép- és felsőközép-kategóriába érkeznek majd. Az pedig szerencse, hogy az új Geforce kártyák nagyon gyenge előrelépést produkáltak, ezért a teljesítménykategóriák érdemben nem tolódtak el az előző generációhoz képest, így míg a korábbi 800 dolláros kártyán a 12 GB kevésnek számított, addig ugyanaz a 12 GB egy már mondjuk 450 dolláros kártyán elfogadható mennyiség, a 16 GB pedig bőven kielégítő. Ugyanígy a 16 GB az előző generáció 1200 dolláros kártyáján kevés volt, de az előző generáció és jelenlegi generáció 600 dolláros kártyáján rendben levő kapacitás. -

Yutani

nagyúr

300-350 dollár között vajon mit fogunk kapni bármelyik gyártótól? A "semmit" jó válasz?

-

hahakocka

őstag

válasz

Alogonomus

#68245

üzenetére

Alogonomus

#68245

üzenetére

Igen ezért mondtam már 1.5-2 éve is a ram problémákat s igazam lett azóta is. Persze sokan lehurrogtak annó, de azóta sok teszt és játék bizonyította hogy a 8-12gb se elég már. Sokszor 1080p-1440p re se főleg ha RT-DLSS is be van kapcsolva. 4K ra már eleve 20-24gb nak kéne lennie alapból erre most az AMD is 'csak' 16 al jön pedig 4K képesek is lesznek ha kb hozzák a 4080-7900xtx et

-

Alogonomus

őstag

válasz

hahakocka

#68244

üzenetére

hahakocka

#68244

üzenetére

Nagyon kellemetlen volt szembenézniük a Geforce kártyát választóknak azzal a ténnyel, hogy a középkategóriás 8 GB-os és felsőkategóriás 10-12 GB-os kártyáik "ekézése" igazolást nyert.

A 8 GB elégtelensége nagyjából 2022 végén, a 12 GB szűkössége pedig legkésőbb 2024 vége felé vált nyilvánvalóvá. A 8 GB főleg a 400-450 ezerért vett 3070-esek tulajdonosai esetén volt keserű pirula, a 12 GB pedig lényegében a 4070 Ti Super szintjénél kisebb zöldkártyások esetén, miközben a kártyájuk számítási teljesítménye alapján még jó lett volna a kártyájuk, de a kevés memória miatt vagy szaggatott náluk a játék, vagy alacsony minőségű elmosódott textúrákkal kényszerültek játszani. -

hahakocka

őstag

Ezért se értem miért AMD bérencezik sokan le ma már az HWU-t. Lehet 10 éve még érezteték néha akár de már rég nem ez a helyzet és a legrészletesebb tesztjeik s a legátláthatóbbak nekik vannak! Raszter, DLSS ON, OFF, RT, RT OFF, fogyasztás, hőmérséklet, ár érték, FPS/WATT, FPS/Dollár, 1080-1440p-4K mérések, s azok átlaga is, OC nem OC, MSRP árak és a jelenlegi árak összehasonlítása stb s mellé 15-50 game ez változó azért.

-

PuMbA

titán

Érdekes volt a mostani Hardware Unboxed Podcast AMD-s része. Steve mondta, ha most nem tud az AMD egy olyan kártyát kiadni olyan árazással, ami pozitív tesztek garmadát fogja hozni, akkor végük van. Ugye az RTX5080 is negatív hírű lett az RTX5090 után. Tim erre mondta, hogy az RDNA3 esetén is amikor az AMD-t ekézte, az nem tetszett nagyon az AMD-nek, úgyhogy valószínűleg nem akarják ezt újra megpróbálni

-

S_x96x_S

addikt

TechPowerUp Interviews David McAfee, GM of Client Channel Business, On the State of AMD Ryzen and Radeon

https://www.techpowerup.com/331780/techpowerup-interviews-david-mcafee-gm-of-client-channel-business-on-the-state-of-amd-ryzen-and-radeon

"""

TechPowerUp: How about AI on desktops?

David McAfee: We've advanced AI PCs significantly. There are many applications now running on the NPU, and we've expanded AI coverage across different product ranges. Desktops have more unbounded compute needs to be compared to NPUs. We focus on combining CPUs and GPUs for diverse workloads. I know there's anticipation for RDNA 4. We didn't cover it in-depth at CES to avoid disappointing people. We will do a full deep dive soon.

....

TechPowerUp: Do you see a space for "Strix Point" on AM5—is there a need for stronger iGPU with NPU?

David McAfee: That's an interesting question. Strix is in a unique space. Maybe this is a good conversation about "Strix Halo" versus "Strix Point". In my opinion, there are levels of 3D performance that create different experience or capability levels on a desktop PC. What we need to prove to ourselves, or the market, is whether Strix as an AM5 desktop part provides a unique experience compared to a more basic graphics system. The next step is very playable 1080p gaming at 30+ frames per second. "Strix Halo" steps up to a different class of gaming. Just for the record, it does not fit the AM5 socket. It's about delivering a valuable experience to consumers given other market choices for CPU and GPU combinations, considering power, noise, and other factors. "Strix Point" is in a gray zone for me in terms of performance versus desktop user expectations.

""

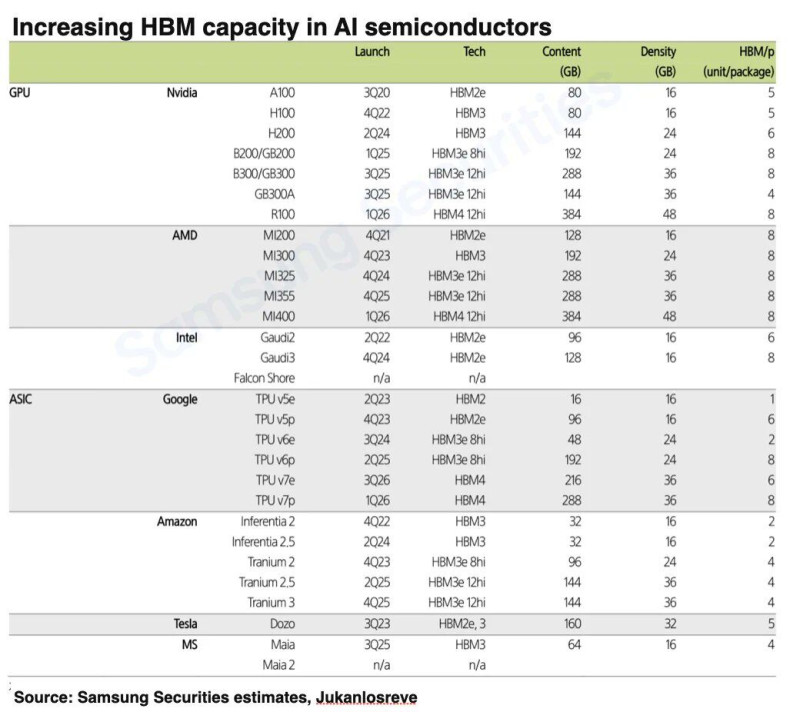

--------------és egy AI CHiP roadmap : a VRAM duplázódik.

https://x.com/Jukanlosreve/status/1885280737425055834

https://x.com/Jukanlosreve/status/1885280737425055834 -

TESCO-Zsömle

titán

válasz

parandroid

#68240

üzenetére

parandroid

#68240

üzenetére

Ray Tracing

-

villamos

őstag

Ezeket most csak úgy itt hagyom...

Kíváncsi vagyok hogyan fognak öregedni...

-

S_x96x_S

addikt

válasz

Chiller

#68236

üzenetére

Chiller

#68236

üzenetére

> a Deepseek ... sem (például) programozás nem megy neki

több Deepseek verzió is létezik

( amelyeket még sokszor tovább butítanak is, hogy kisebb legyen a mérete. )de nekem a teljes "Deepseek R1" elég jónak tűnik

(a programozási benchmarkok szerint - főleg ahhoz képest, hogy nyílt modell. )

- https://aider.chat/docs/leaderboards/

- https://livecodebench.github.io/leaderboard.htmlÉs mindenki ezzel foglalkozik.

"DeepSeek-R1 Now Live With NVIDIA NIM"

https://blogs.nvidia.com/blog/deepseek-r1-nim-microservice/"Best practices for competitive inference optimization on AMD Instinct™ MI300X GPUs"

https://rocm.blogs.amd.com/artificial-intelligence/LLM_Inference/README.html

( ~ "With its high memory capacity, the MI300X can accommodate larger models such as Llama-3.1 405B and DeepSeek v3/R1 while also delivering efficiency for smaller models (≤30B) in TP1 mode, minimizing GPU scaling overhead" ) -

Chiller

őstag

válasz

Devid_81

#68218

üzenetére

Devid_81

#68218

üzenetére

Nem kell bizonyítani, a Deepseek bár nem rossz, mint kérdésekre/keresésekre válaszadó, ha jól tudom sem a komoly képgenerálás, sem (például) programozás nem megy neki. És akkor a videó meg egyebekről nem is szólva, ahol elvileg már tart a nyugati AI.

Meg még ki tudja mi nem (persze ezeket ki kell tesztelni először is, és a megvalósítás lehet csak fejlesztés/idő kérdése).

-

Woodcutt3R

tag

-

Abu85

HÁZIGAZDA

válasz

A.Winston

#68221

üzenetére

A.Winston

#68221

üzenetére

Ez a wakeup call azért fontos, mert az AI ipart újra pezsgővé teheti. Ilyen költségek mellett ott van az a tényező, hogy lehet újra innoválni, mert nem 100 milliókról beszélünk, hanem kb. 10 millión belül egy kisebb összegről, és ez alapvetően a hardvergyártóknak is jó, hiszen így sokkal inkább tud a piac bővülni. Sokkal több szereplő jöhet, ami sokkal alacsonyabb árakat eredményezhet. Ez annak nem jó, aki a brute force modellre tette fel az üzleti modelljét. Ők rábasztak nagyon.

-

Abu85

HÁZIGAZDA

válasz

Alogonomus

#68223

üzenetére

Alogonomus

#68223

üzenetére

A NIS igazából előbb jelent meg. És a működése miatt volt sokkal limitáltabb, mint a RIS, hiszen nem adaptív megoldás, és a minták is szuboptimálisak, amikkel dolgozik. De az NV a hardveréhez igazodott, míg az AMD inkább a problémához igazította a mintákat. Természetes, hogy az utóbbi megoldás jobb eredményt tud adni, mert sokkal több adattal tud dolgozni azzal, hogy nem téglalap, hanem elipszis alapban veszi a mintákat. Ezért nem erőlteti már az NV a DLSS-ben a NIS-t. Inkább leválasztották ezt a komponenst, hogy a fejlesztők az AMD élesítőjét is rá tudják rakni a DLSS-re. Nem is nagyon akarták ezt utána megreformálni, mert nagyon sok munka lett volna, és az AMD megoldása sokkal-sokkal jobban működött. Az egyetlen hátrány, hogy a driverben maradt a NIS, de azt úgy néz ki, hogy leszarják.

Az RSR egy másik technika. Az nem RIS-t használ, hanem RCIS-t. Ha az RSR-t hasonlítjuk a NIS-hez, akkor nyilván nem tud a NIS semmit sem tenni, mert nagyon-nagyon limitált ez a technika. Tényleg, az NV azért nem fejlesztette tovább, mert évekre voltak a konkurens CIS-től, ami az alapja a RIS-nek, és az RCIS-nek.

-

FLATRONW

őstag

válasz

Alogonomus

#68227

üzenetére

Alogonomus

#68227

üzenetére

Ha valami tényleg felesleges volt mindkét cég részéről, akkor az a NIS és az RSR. Szerintem senkinek sem hiányoztak az FSR-nál is rosszabb eljárások.

Arról nem is beszélve, hogy NV reagálásról szó sem volt, AMD reagálásról van szó.

Tény, hogy egy picit jobb volt a RSR, de azon a minőség szinten kb. nem sokat ért.

-

b.

félisten

válasz

Alogonomus

#68227

üzenetére

Alogonomus

#68227

üzenetére

A általad linkelt teszben sincs az hogy látványosan gyengébb lenne, pedig az még az első verziója. Folyamatosan fejlesztették, már a DLSS 2 ről 3-ra való frissitésekor a NIS kapott jelentősebb updatet.

Felesleges a szóforgatás a lényegen nem változtat. -

Alogonomus

őstag

Az Nvidia Image Scaling első bevetését illetően tényleg igazad van, mert az Nvidia tényleg előbb tette be a lehetőséget a driverébe, mint hogy az AMD betette volna a saját beígért képességét. A gyors reagálás attól viszont még nem volt sikeres az Nvidia oldalán, hiszen látványosan gyengébb képminőséget produkált a NIS, bár tényleg hamarabb vált elérhetővé.

Mint a viccben:

– Mennyi 2x2?

– 5!

– Nem jó a válasz!

– De legalább gyors voltam! -

b.

félisten

válasz

Alogonomus

#68225

üzenetére

Alogonomus

#68225

üzenetére

-

b.

félisten

válasz

Alogonomus

#68223

üzenetére

Alogonomus

#68223

üzenetére

Mi nem sikerült benne? Már csak azért is érdekel mert a NIS elöbb jelent meg mint az RSR...

-

Alogonomus

őstag

Hát az RSR vs. NIS esetében ez a gyors reagálás nem igazán sikerült, pedig igazán próbálkozott az Nvidia.

-

PuMbA

titán

NVIDIA Adds Smooth Motion, a Driver-Based Frame Generation AI Model for RTX 50 GPUs

AFMF2 vs. Smooth Motion. Fight!

Ahogy múltkor mondtam, az NVIDIA gyorsan reagál az AMD jó dolgaira.

Ahogy múltkor mondtam, az NVIDIA gyorsan reagál az AMD jó dolgaira. -

A.Winston

tag

Egyet ertek azzal mit itt irsz, de pont lenyeget nem magyarazza az egesz esetnek.

Azt mindenki tudja, hogy pionirnak lenni nem olcso mulatsag. Meg azt is hogy ha valami egyszer kijott optimizalni is lehet. Az hogy deepseek 5-6M dollar “csak” egy wakeup call a nyugati AI iparnak, de nem a hardvergyartoknak! Az angolnak van közmondása is erre (magyart nem tudok): “Early bird gets the worm, but second maus gets the cheese”. Kvazi deepseek is “sajtolt” (ha erti valaki a szo szlengesitett reszet orulok).

Ha nem H800-on kellett (direkt emeltem ki, hogy ertse mindenki akarmennyit sporoltak ez meg mindig az NV hardvereknek koszonheto fejlodes!) hanem legujabb elerhetokon akkot lehet fele vagy toredek ido alatt elvegzik a traininget. Maga az ipar meg nagyon nincs a fejlodesi szakasza csucsanak a kozelebe se.

Tehat, van hardver meghova fejlodni.Mi a baj akkor most tulajdonkeppen? Kerdezhetne valaki teljesen jogosan.

Nagyjabol az hogy a nyugati joletben es bekeben kitermelodott tarsadalom valahol elkezdte evidensnek venni, hogy nekik minden alanyi jogon jar, nem kell neheznek lennie semminek. Belegondolsz nem is annyira meglepo, hogy az utobbi evtized legnagyobb sikertortenet ceget egy tajvani disszidens vezenyli..Igazabol nincs, business as usual van. Csak a medianak kell vinnyogni konstans valami miatt..

Ami latszik szepen, export korlatozasokkal teljesen felesleges operalni. Ez nem fogja a fejlodes utemet megallitani (szerencsenkre).Egyebkent elnezest, nem szeretnem szetoffolni a topicot. Reszemrol lezartam a temat.

-

Abu85

HÁZIGAZDA

válasz

Busterftw

#68216

üzenetére

Busterftw

#68216

üzenetére

Ki tudod számolni, ott a modell, nyílt az egész. Ezért sem vitatják ezt a tényezőt, mert utána lehet számolni ennek, és tényleg kb. ennyire jön ki. Tény, hogy másképp csinálják a kínaiak, de az a helyzet, hogy ők csinálják jól. És ezt nyilván át fogja venni a nyugat is.

-

Busterftw

nagyúr

Igen, allitjak a kinaiak.

Hany es hany ilyen allitas volt mar, aztan kesobb kiderult, hogy korantsem ilyen fekete feher a dolog.A masik meg az, hogy ezt az utolso V3-nal allitjak, nagyban mellozve az egesz cucc teljes koltseget. Szoval ez minimum eros szkepticizmussal illik kezelni.

Lasd a fenti A100 szamok. -

Abu85

HÁZIGAZDA

Azt nézzétek amúgy itt, hogy ezt a modellt 6 milliárd dollárból csinálták. Csak a Microsoft 80 milliárdot tervez költeni erre ebben az évben, vagyis a kínaiak előálltak egy jobb megoldással, ami egyetlen nyugati cég éves AI költésének a töredékéből meglett. Ez világos üzenet, hogy a nyugat rosszul csinálja. Ez persze még nem tragédia a nyugatnak, átvehetik majd ezt a modellt, és át is fogják venni, mert jóval hatékonyabb. Csak ez azt is jelenti, hogy amit eddig számoltam TAM-ot a piacra, az eléggé rossz módszerrel lett számolva. Történt már ilyen régen. Például az űrversenynél, amikor az oroszok előhozakodtak a Szputnyikkal. Az is hidegzuhany volt, de a nyugat ahhoz is alkalmazkodott. Ehhez is fognak, és alapvetően a piacra ennek jó hatása lesz, mert tényleg sokkal kevesebbet kell majd erre költeni. Több lehet benne az innováció. A hardvergyártóknak viszont át kell értékelni az előrejelzéseiket.

-

Abu85

HÁZIGAZDA

Ők nem VGA-kban gondolkodnak, hanem speciálisan ide tervezett gyorsítókban. Csak nem a legjobbakban már, mert elég a kisebb is.

#68213 Busterftw : Mivel nyílt a modell, így utána lehet számolni, és eléggé helytállónak tűnik, amit írnak róla. Tényleg nem véletlenül döntötte be a brute force-ra ráállt tőzsdét. Csak bemondásra ilyen nem történik, simán utánaszámoltak, hogy a kínaiak ezt tényleg ennyiből megcsinálták. És nyilván ettől erősen befostak.

-

Abu85

HÁZIGAZDA

válasz

Alogonomus

#68208

üzenetére

Alogonomus

#68208

üzenetére

Az más. Az a következtetés szakasz. Azt futtathatják bármin, és általában nem NV hardveren fogják, mert következtetés szakaszra már most vannak elképesztően jó alternatívák. Az az előny, amit a DeepSeek R1-nél az okos optimalizálással összehoztak nemcsak a befektetési költségeket tartotta extrém alacsonyan, hanem azt is lehetővé tette, hogy kifejezetten jó legyen a sebessége kevesebb hardverrel is. Ez önmagában a szektornak nagyon jót fog tenni, a hardvergyártóknak nem tesz jót az eladási mennyiséget tekintve, meg eléggé diverzifikálja majd a piacot, mert innentől kezdve 20-30 szereplő közül is lehet válogatni, nyilván Kína már nem NV-t fog rendelni, mert házon belül is van alternatíva.

-

Abu85

HÁZIGAZDA

válasz

A.Winston

#68204

üzenetére

A.Winston

#68204

üzenetére

Semmit sem tippel ez. A DeepSeek R1 működése ellenőrizhető. Hiszen nyílt az egész. Látszik rajta, hogy töredékéből összehozták annak a pénznek, amit a nyugat éget el a papíron rosszabb modellekre. Ergo a nyugati brute force mentalítás nem kifizetődő. Sokkal kevesebb hardver vásárlásával, és hatékonyabb fejlesztéssel jobb modellek hozhatók össze. Erre a DeepSeek bizonyíték. Nem véletlen, hogy ennyire bepánikolt tőle a tőzsde.

-

Devid_81

félisten

válasz

SzilardToth

#68205

üzenetére

SzilardToth

#68205

üzenetére

Belehallgattam de fajt a fuleimnek

![;]](//cdn.rios.hu/dl/s/v1.gif)

-

Alogonomus

őstag

válasz

A.Winston

#68199

üzenetére

A.Winston

#68199

üzenetére

A PTX, mint használt programozási nyelv bizonyított, de hogy milyen "vason" fejlesztették és futtatták, az csak spekuláció és szóbeszéd szintjén kering a neten. Egyes szóbeszéd szerint jelenleg például a Huawei Ascend "vasán" fut a DeepSeek.

Lényeg a lényeg, ezek szerint nem kizárólag Nvidia "vas" nyújthat optimális teljesítményt az AI szektor számára. -

És kiadták a Janus Pro képgenerálásra készült modellt is.

-

SzilardToth

csendes tag

Szerintem, most itt az idő, az nvdia bohóc szériáját van esély lenyomni!

https://youtu.be/keUbF-y6a2k?si=cgCSmuTIysaIRAb3 -

A.Winston

tag

válasz

S_x96x_S

#68202

üzenetére

S_x96x_S

#68202

üzenetére

Olvastam, koszi. Meg magam is kerestem.

Tovabbra is ugy tunik, hogy A: Negativ kampanyhoz nv vallalta a balhet, mert amugy ot erinti legkevesbe, a parasztok meg majd rajonnek, vagy B: A globalis penzpiaci befekteteseket mozgato botok/AI-ok tavolrol sem tokeletesek, es rossz konkluziot levonva adtak fel az nv-s pozicioikat.

Ezek a tech cikkek erdekesek, de ne felejtsd el, hogy mindig epp az aktualis esemenyek allasat probaljak magyarazni. Vagyis reszben ugyan informativ, de inkabb so-so, mert barmit meg az ellenkezojet is levezeti masnap.Ez az egesz a model fejlesztoknek egy arcul csapas inkabb, de erdekes modon az o reszvenyeik nem estek akkorat, vagy mar korrigalva is lettek.

Mindegy nem akarok gyozkodni senkit, aki figyeli ezt a szalat esetleg egy emlekeztetot beallithat 3 honappal kesobbre kinek lett igaza. Az en tippem hogy nv koszonni fogja szepen jol lesz, Meta/Google/OpenAI meg jo esetben jott valami szinten erdemi ujitassal. -

Abu85

HÁZIGAZDA

válasz

A.Winston

#68199

üzenetére

A.Winston

#68199

üzenetére

Nem az a lényeg, hogy min készült. A piac attól pánikolt be, hogy ha a DeepSeek ennyire olcsón tudja azt, amit a többi, akkor felmerül az a kérdés a többiekben, hogy ha ez működik ilyen olcsón is, akkor mi a fenéért vesznek ennyi hardvert? És nyilván, ha felmerül ez a kérdés, akkor ugye előbb-utóbb nem is vesznek annyi hardvert, ami nem jó a hardvergyártóknak. És ha változik az AI modellek fejlesztése úgy, hogy a DeepSeek lesz a minta, akkor csak tizedannyi gyorsítót kell rendelni, aminek az NV lesz a legnagyobb vesztese, mert ők adják el a legtöbb gyorsítót ide. Na ezért fosta össze magát a tőzsde.

Új hozzászólás Aktív témák

A topikban az OFF és minden egyéb, nem a témához kapcsolódó hozzászólás gyártása TILOS!

MIELŐTT LINKELNÉL VAGY KÉRDEZNÉL, MINDIG OLVASS KICSIT VISSZA!!

A topik témája:

Az AMD éppen érkező, vagy jövőbeni új grafikus processzorainak kivesézése, lehetőleg minél inkább szakmai keretek között maradva. Architektúra, esélylatolgatás, érdekességek, spekulációk, stb.

- Kezünkben a Honor Magic V5

- Milyen processzort vegyek?

- Miért álltak az oldalak egy hétig, mi történt?

- Haladó fájlrendszerek, de mire jók? Ext4 vs Btrfs vs ZFS vs APFS

- Milyen notebookot vegyek?

- Házimozi haladó szinten

- Kínai és egyéb olcsó órák topikja

- Star Trek

- Folyószámla, bankszámla, bankváltás, külföldi kártyahasználat

- Borotva, szakállnyíró, szakállvágó topic

- További aktív témák...

- Apple iPhone 7 128GB Yettel Függő 1Év Garanciával

- Azonnali készpénzes Apple Macbook Air felvásárlás személyesen / csomagküldéssel korrekt áron

- Konzol felvásárlás!! Playstation 5, Playstation 5 Pro

- BESZÁMÍTÁS! ASROCK B550M R9 5900X 32GB DDR4 1TB SSD RTX 3080TI 12GB ZALMAN I3 NEO GIGABYTE 850W

- Telefon felvásárlás!! Honor 400 Lite, Honor 400, Honor 400 Pro

Eddig az AMD adott minden szegmensben kivétel legalsó kateg több vramot vagy egált sokkal olcsóbb kategben. S most elvileg a 9060 is 12-16 gb ot fog adni sokkal olcsóbban. Mint annó az Intel csak ott meg ugye a régebbi procikkal van most gond hogy nem igazán működik jól együtt az amúgy nem rossz Intel VGA. Ott is 12 gb van alsó kategben.

Eddig az AMD adott minden szegmensben kivétel legalsó kateg több vramot vagy egált sokkal olcsóbb kategben. S most elvileg a 9060 is 12-16 gb ot fog adni sokkal olcsóbban. Mint annó az Intel csak ott meg ugye a régebbi procikkal van most gond hogy nem igazán működik jól együtt az amúgy nem rossz Intel VGA. Ott is 12 gb van alsó kategben. s vajon majd minden gamenl vagy gamefüggő lesz? Meg Sponsor vagy optimalizálás támogatás lefizetés függő????

s vajon majd minden gamenl vagy gamefüggő lesz? Meg Sponsor vagy optimalizálás támogatás lefizetés függő????

![;]](http://cdn.rios.hu/dl/s/v1.gif)