- Vegyes társaság jött a szombati hardverbuliba

- Százmilliárd dolláros AI-fegyverkezésbe kezdett az Amazon és a Google

- Így tüzelt el százbillió forintot az AI a héten

- Kétféle módon harcol a forró helyzetekkel szemben az ASUS új, M.2-es SSD háza

- Mérföldkő a szilárdtest akkuknál: fontos lépést tett a QuantumScape

- Megárthattak az Intel VGA-terveinek az emelkedő árak

- Elképesztő lemaradásban van az aktuális Loongson CPU-család

- Home server / házi szerver építése

- AMD K6-III, és minden ami RETRO - Oldschool tuning

- Táp ventilátor csere

- NVIDIA GeForce RTX 5080 / 5090 (GB203 / 202)

- Egér probléma

- Nvidia GPU-k jövője - amit tudni vélünk

- Intel Core i5 / i7 / i9 "Alder Lake-Raptor Lake/Refresh" (LGA1700)

- Miért tűntek el a buta tévék?

Új hozzászólás Aktív témák

-

Komolyan, néha az az érzésem, hogy alternatív valóságban éltek. Az nVidiára is megvolt az anyázás a ventillátor-probléma miatt (kihegyezve arra, hogy egy 260e FT-os kártya hogy lehet ilyen gané - jogosan), csak sokkal kevesebb ideig tartott. Felmerülhet a költői kérdés, hogy miért tartott kevesebb ideig - ezt mindenkinek a fantáziájára bízom.

-

-

-

#45185024

törölt tag

Javitották az 1080 venti összevisszajárást megkérjuk mind a 4 1080 tulajunkat vakmero bátorsággal hajtsa végre a frissitéseket

Mondtam már hogy 4 el tobb 1080 tulaj van MO on mint Vega tulaj

-

Abu85

HÁZIGAZDA

válasz

#45185024

#17784

üzenetére

#45185024

#17784

üzenetére

Semennyit. Az effektek számításához szükséges idő ugyanaz DX11 és DX12 alatt. Az aszinkron compute átfedése jelenthet előnyt, mert úgy pár compute effekt ingyenesség válik. A DX11 azért lassabb sokkal, mert nem arra optimalizálták a játékot. Túl költséges és időigényes lenne ennek a módnak a teljesítményét a DX12 közelébe vinni.

Ez egy stratégiai játék. Fölösleges a 60 fps. Nem igényli a játékmenet.(#17783) gbors: Majdnem 100%-os hatékonysággal lehet aszinkron compute-ot futtatni. Az MLAA esetében biztos, mert olyan fázisba van berakva, ahol az ALU-k eleve csak malmoznának. A GPU particles esetében pedig majd meglátjuk.

-

actival63

aktív tag

-

-

Abu85

HÁZIGAZDA

Van róla egy részletesebb leírás, hogy milyen effekt mennyi időbe kerül 4K-ban. Persze ez az aktuális verzióra igaz.

A Warhammer implementációja az éppen aktuális AMD MLAA verzió másolata. Az nem eszik annyit, mint a Jimenez-féle konstrukciók, amelyeket például a Crysis is használ.

Nem különbözik a DX11 és DX12 alatt az effekt elvégzéséhez szükséges idő, mert ugyanaz a shader. DX12 annyiban jobb, hogy átlapolja a számítást a következő képkocka kezdeti számításaival, ahol ugye ez lehetséges. Emiatt pár hardveren még -1-2 fps sem lesz belőle. -

Ezt pontosan hol mérted ki? A Warhammerben? Azért kérdem, mert a legtöbb MLAA implementáció valóban csak 1-2 FPS-t eszik, viszont pl. a Crysis 3 SMMA 4x-e jóval többet. Meg kéne ezt nézni DX11-ben és DX12-ben is MLAA on és MLAA off mellett, abból derülne ki, mi a valós helyzet.

-

Abu85

HÁZIGAZDA

válasz

TTomax

#17768

üzenetére

TTomax

#17768

üzenetére

Természetesen nem reprezentálja. Ebben a tesztverzióban még nem fut aszinkron compute-ban a GPU particles, illetve még nincs kész az a speciális MSAA, amit beleraknak a végleges DX12 kódba. Ettől függetlenül az bullshit, amit Hilbert az MLAA-ról összehord, hogy az akkora "performance hog". Maximum 1 fps-t képes levenni a végső sebességből, és ez nagyon maximum.

-

Abu85

HÁZIGAZDA

válasz

Valdez

#17765

üzenetére

Valdez

#17765

üzenetére

Ezt nem igazán lehet így leírni, mert számos MLAA algoritmus létezik. Az AMD algoritmusa az egyetlen, amely compute shaderben számol. Ebből van kevés a játékoknál, míg más MLAA konstrukció elterjedt, például az SMAA is egy MLAA algoritmus, de nagyon sok játékban az AA csak AA-nak van jelölve és zömében MLAA-k azok is.

Ami miatt az AMD MLAA-ja kedvezőbb DX12-re az az asszinkron compute, mert az AMD konstrukcióját szinte változtatás nélkül be lehet főzni dedikált compute parancslistára, míg más MLAA/FXAA/CMAA konstrukciók esetében át kell írni az egészet előtte. -

Abu85

HÁZIGAZDA

válasz

TTomax

#17758

üzenetére

TTomax

#17758

üzenetére

Megnéztem az MLAA-t mennyit eszik. A kapott adatok alapján 4K-ben a 980 Ti-nek 0,61 ms, míg a Fury X-nek 0,94 ms. Tehát a GeForce-on fut jobban úgy ~30%-kal (ez kb. reális, egyébként nagyjából ennyivel fog jobban az FXAA a Radeonokon.). Ugyanakkor a Radeon aszinkron compute-ban futtatja, így náluk ez ingyenessé válik. Mindenesetre annyira kevés erőforrást igényel maga az effekt, hogy maximum -1 fps jöhet belőle hardvertől függően. Nem értem, hogy a Guru3D miről beszél, gondolom ezt is benézték, mint az FCAT-ot az AotS-ben.

-

#45185024

törölt tag

válasz

rocket

#17770

üzenetére

rocket

#17770

üzenetére

Ha Ti tudnátok távol keleten mennyi okostelefont adtak már el azzal hogy rózsaszínre festik és ilyen helló kitti és társai cuccos témát tesznek rá OMG

Én már rég várom hogy megjelenjenek ilyenek videókártyákon is.

PL Pokemon 480 Edisön , és jobban meg lehet indokolni a 2 kártyás rendszert máris.

-Neked milyen 480 asod van ?

-"Pikacsu" meg "Csarizár "

SZEREZD MEG HÁT MIND !!!

-Apa vehetek még 480 ast?

-De kisfiam csak 4 slot van a gépedbe

-De apaaaa lécíííííí![;]](//cdn.rios.hu/dl/s/v1.gif)

-

Ijk

nagyúr

válasz

ericdrawen74

#17771

üzenetére

ericdrawen74

#17771

üzenetére

Akkor vegyél helyette majd r480-at.

-

TTomax

félisten

válasz

Kolbi_30

#17764

üzenetére

Kolbi_30

#17764

üzenetére

És ez neked is szól (#17765) Valdez

Jó lenne ha végre megértenéd amit írok,harmadjára is leirom ugyanazt.A teszt végeredménye nem reprezentálja az amd vgak dx12es elönyét. A flamewartól kímélj meg,hogy ki mikor és hol tartott be a másiknak,mert nem ez volt a téma,ne is tereld arra.(#17766) gollo91

Majd javítják,de őszintén szólva a játék látványvilága szempontjából nem oszt nem szoroz szerintem. -

Ijk

nagyúr

válasz

ericdrawen74

#17755

üzenetére

ericdrawen74

#17755

üzenetére

Nem elég az r390 teljesítménye?

-

MiklosSaS

nagyúr

Egy kis lazulas....

-

Dyingsoul

veterán

Állítólag az 1080 nem renderel kellő mennyiségű havat AoTS-ban.

-

TTomax

félisten

válasz

Valdez

#17749

üzenetére

Valdez

#17749

üzenetére

Nem az a gond hogy van!Hanem az a gond hogy bencmarkban két opció van on/off,és semmiféle más opció!Mindenki ONnal tesztel ami extrém fekszik amdnek,naná,hiszen ök szállították,így a benchmark ferde képet mutat,mert nem azt mutatja hogy DX12ben milyen erösek a radonok,hanem azt,hogy az MLAA mennyire jól fut radeonon...

(#17750) Ghoula

Ez neked is ugyanúgy szól.olvassátok el amit írok ne csak szavakba kössetek bele,köszönöm!(#17751) Abu85

Te is olvasd el a cikket,mennyire olcsó (csak nem itt),és még csak véletlen sem fut nV gyorsabban...ott a Guru3Ds oldal ök tesztelték,ha ök hazudnak akkor én is... -

-

stratova

veterán

válasz

TTomax

#17746

üzenetére

TTomax

#17746

üzenetére

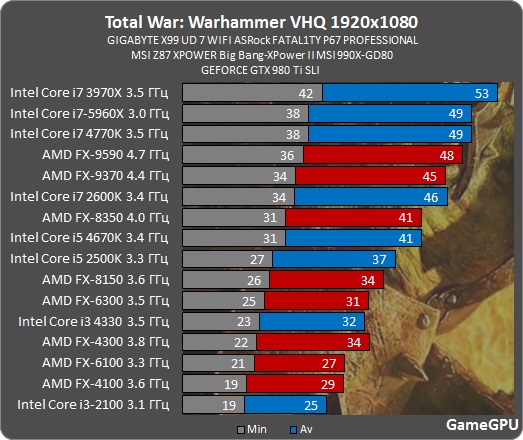

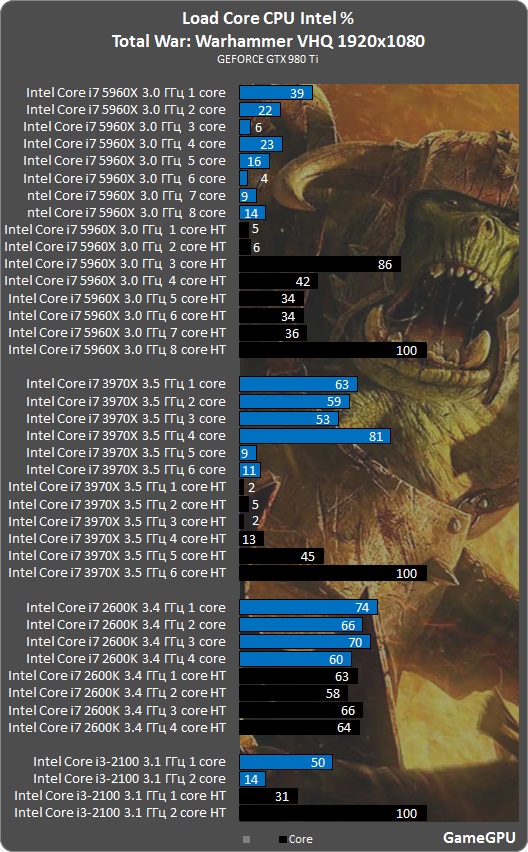

A CPU igényt illetve erre írtam, a másik topikban, hogy pl. GTX 1080 - még ha alapvetően szerintem erre a felbontásra messze túlzás egy ilyen kártya - 1080p-n CPU limites, ennyit hoz, ha 3,0/3,5-ről 4,4-re húzzák "alatta" az i7-5960X-et.

Viszont, szvsz a játék jellegéből és a mai technológa adta lehetőségből adódik, hogy DX12 ide vagy oda, ha egy igazán erős proci mellett nagyon nagy mennyiségű egységet jeleníthetnek meg, akkor azt ki is használják a fejlesztők. S itt most mindegy, hogy ez most egy befutottabb cím, mint a Total War sorozat, vagy egy AotS. -

schawo

titán

válasz

ericdrawen74

#17752

üzenetére

ericdrawen74

#17752

üzenetére

Érdemes várni egy-másfél hónapot és 130-ért venni egy 1070-ez. Nehogy most ilyet vegyél.

-

Ijk

nagyúr

válasz

ericdrawen74

#17752

üzenetére

ericdrawen74

#17752

üzenetére

Most 120k-s árat láttam újonnan (én 107-ért vettem februárban), ha nem veszi meg valaki ennyiért, akkor jobb vétel az 1070. Viszont ha el kell használtan adnod jó esetben sem kapsz érte 90-95k-nál többet, tehát jó 70-80k-t rá kell fizetni a 40% gyorsulásért.

Azt vedd figyelembe mennyire hangos, mennyire szellőzik a házad mert a 390 sokkal jobban melegszik, illetve hogy a játékaidnál mennyivel gyorsabb az 1070 és milyen felbontásra, fps-re van szükséged.

Valamihez nem elég most a 390? -

ericdrawen74

senior tag

Érdemes egy R9 390 nitrot GTX 1070-re cserélni?

-

Abu85

HÁZIGAZDA

-

Ghoula

senior tag

válasz

TTomax

#17746

üzenetére

TTomax

#17746

üzenetére

Az mlaa dolog nagyon is rendben van,szerintem lesz is meg hasonlo a jovoben. Physx remlik? Aki nem nv-n van az tolhatja 1 szalon, cpu-n, x87el? Sot, szivatjak azokat is akik nv hardvert vettek radeon melle fizikara. Pedig ott vettel egy nv termeket ami gyakorlatilag hasznalhatatlan arra.

-

válasz

Malibutomi

#17745

üzenetére

Malibutomi

#17745

üzenetére

Nem olyan jelentős az ... eddig is volt szitu amiben jobbak voltak.. ez csak plusz egy, DX12 ide vagy oda.

(#17746) TTomax

Mondjuk egy nem SLI proci tesztet is csinálhattak volna... ott lehet nem számít ennyire.

Jah mondjuk közbe találtam...

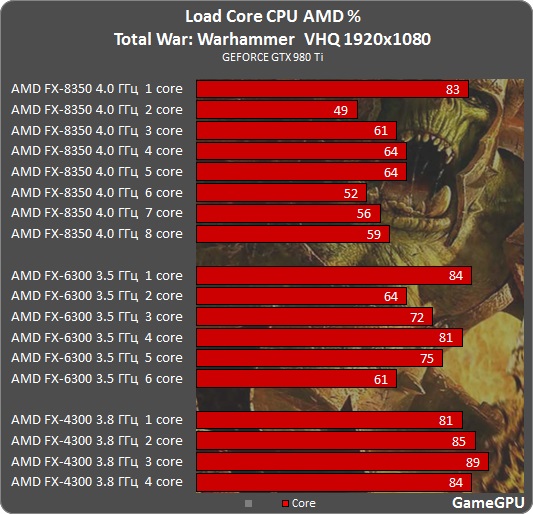

No igen úgy néz ki szépen skálázódik a multicore és az egyszálú IPC szerint is. -

TTomax

félisten

A warhammerel a következő a gond...

"The Benchmark version of the game was provided to us by AMD, the game is an Gaming Evolved title. I found it to be surprising that in the Anti-aliasing options of the benchmark, MSAA is nowhere to be found (disabled). Either you disable AA or use MLAA, these are the only options. MLAA for AMD is what if FXAA for Nvidia. MLAA is way more optimized for AMD opposed to Nvidia and that works out really well for them, especially for the mainstream cards. You could state that this is a somewhat 'favored' option that the game-title is forcing us to use. So again, AMD will yield better results from MLAA but in retrospect, over the years Nvidia cold have optimized this technology a bit more in their advantage. "

Tehát az előny abból adódik,hogy mindenki MLAAval tud csak mérni,amire ugye az AMD elég régóta gyúr,így sajnos itt sem azt látjuk,hogy a DX12re "készített" GCN arch. előnyeiből fakad a jobb teljesítmény...

A másik gond,hogy dx12 ide vagy oda nagyon keményen cpu intenzív....

-

Malibutomi

nagyúr

válasz

FollowTheORI

#17744

üzenetére

FollowTheORI

#17744

üzenetére

A 970 jol lemaradt, ami altalaban a 390 ellenfele, de azt itt meg a 980 sem eri be ami meg a 390x elott szokott lenni kicsivel.

-

válasz

Malibutomi

#17741

üzenetére

Malibutomi

#17741

üzenetére

Na jó de 4K?

Jóhogy... FullHD meg 72 egy 980-on is... szal nem kell itt temetni semmit.

Egyelőre az van hogy vagy mindegyiken jól fut a DX12 vagy mindegyiken rossz/alig játszható... ergo semmi jelentős előnye nincs AMD-nek igazán.

Persze más kérdés hogy az NV előnye sem jön ki, mert nem lehet drivert optimalizálni rá... a fejlesztőknek meg nem lesz ideje igazán rá.Egyedül a 960 roskadt be érdekesen, ha a 285/380-hoz nézem.

-

daveoff

veterán

Ebben igazad van, de amit mondtam akkor is igaz, ha visszaveszel a grafikából akkor is mjdnem mindegy melyik kártyát választod. Mondjuk engem egyáltalán nem érdekel sem a 4k, sem a stratégia.

FHD-n meg azért nagyobb különbségek vannak, oda nekem bőven jó még a 980Ti hosszú ideig, akár beállítások variálása nélkül.

FHD-n meg azért nagyobb különbségek vannak, oda nekem bőven jó még a 980Ti hosszú ideig, akár beállítások variálása nélkül. -

Milka 78

nagyúr

Szolmizációs perceinket halhatták

-

#45185024

törölt tag

válasz

daveoff

#17734

üzenetére

daveoff

#17734

üzenetére

Igazándiból rátapintottál mert 4K tv vásárlás előtt állok és nem tudom hogy belevágjak e.

Lehet várni kellene e Vega Pascalra az megnyugtatóbb lenne... ez van sajna két felbontás között állunk a szakadék tetején lebegve.

Erről akár egy cikk is születhetne milyen kompromisszumokkal lenne meg a 60 FPS az egyes kártyákon , és az mennyire fájna -

#45185024

törölt tag

Total War Warhammer Bench

★★★★★★★★★★★★★★★★★★★★★★★★★

4K eredmények:

46 FPS 1080

39 FPS Fury X

38 FPS TITÁN X

37 FPS 1070

36 FPS 980TI

35 FPS FURY (unlock nélküli )

)

★★★★★★★★★★★★★★★★★★★★★★★★★

Lala la la la la Na ja Direct X 12 -

HSM

félisten

válasz

#Morcosmedve

#17715

üzenetére

#Morcosmedve

#17715

üzenetére

Nem mindegy, mert a csatlakozó olvad durván 10A magasságában, márpedig az nem vidám esemény, ez 2 pin esetén 20A-nél, vagy 3 pin esetén 30A-nél következik be. Persze, jó minőségű és kitűnő állapotú terminálokkal. Ezért van nagy tartalék az ATX szabványban.

-

Valdez

őstag

válasz

he7edik.

#17711

üzenetére

he7edik.

#17711

üzenetére

"Nem bírja a core az XT órajelet ezért nem jön 480x."

Erre reagáltam. Az hogy ki, milyen és mennyi tápcsatit rak a kártyára, teljesen más kérdés.

És ez csak a sima 480-as ami a 4 lényeges kártya közül felételezhetően a legkisebb (480, 480x, 490, 490x).

Én még mindig nem tartom kizártnak az 1400-1450 mhz-es custom kártyákat. -

Fehi85

tag

Hali

Szeretném lecserélni a videokarim, és elsőre a Radeon R7 370 4GB tetszett meg. Olvasgattam a tesztjét, meg a kommenteket, és annak ellenére, hogy egy HD7450es 1gb-os karit cserélnék le, kicsit visszatart amit írtak róla (valójában egy felújított, több éves kártya).

Tovább keresgélve egy GeForce GTX 950 WF is jó lenne, annak ellenére, hogy "csak 128 bites, mert azt írták, hogy nincs ez miatt hátrányban a 256os kártyákkal szemben. Ez menyire valós?

A lényeg, amiért ide írtam, hogy AMD-s procim van, és régebben úgy tudom, nem volt jó páros az nVidia-s videokarikkal. Lenne bármilyen hátrányom az AMD-s proci, és az nVidiás vidkari párosból?

Ha esetleg árban tudtok jobb választást játékra, örömmel utána néznék a dolognak.

Egyelőre egy AMD FX6300 mellé lenne a kari.Előre is köszönöm!

-

válasz

#45185024

#17718

üzenetére

#45185024

#17718

üzenetére

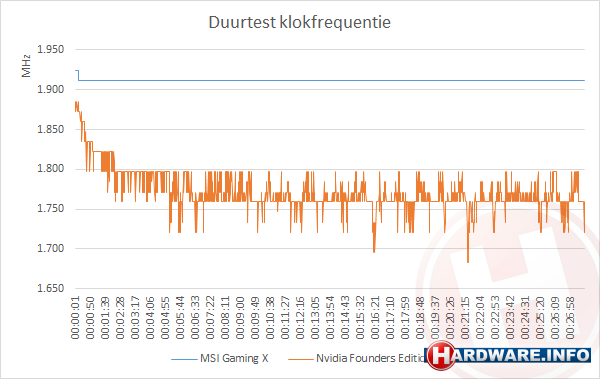

Azért nagyon vicces ez a grafikon, mert a tesztoldal a saját tesztelési módszertanát kérdőjelezi meg vele. A tesztjeikben pár % differencia van az MSI és az FE kártya teljesítménye között, miközben a beállt órajelek között 10% körüli a gap. Ezek szerint a tesztek az első 1.5 percben, a heatup közben készültek

-

#45997568

törölt tag

válasz

daveoff

#17720

üzenetére

daveoff

#17720

üzenetére

Ezek valahol a 980Ti arsavjaban fognak beallni, jelenleg ugy nez ki, aztan majd kesobb kiderul merre mosdulnak tovabb. 220k+ FT-ositva

-

#45185024

törölt tag

Ugy tunik hogy 1080 nál a customtol megszunik az UGRA Bugra

Igaz ez gondolom drágább kártya lesz 280

De legalább stabilan tartja a Mhzet

-

mlinus

őstag

válasz

Bratilla95

#17704

üzenetére

Bratilla95

#17704

üzenetére

ez a 80% milyen statisztika?

csak nem frissen a popsiból lett előhúzva?

csak nem frissen a popsiból lett előhúzva?

-

#85552128

törölt tag

válasz

#85552128

#17714

üzenetére

#85552128

#17714

üzenetére

Na itt van: [link]

A tápon múlik, hogy a harmadik 12V be van e kötve.

"The 6 pin to 8 pin PCI Express adapter will only work if the 6 pin PCI Express connector has a +12 volt wire at pin 2; although most good power supplies have this, the ATX standard is for it not to be there."Anno a 260X-ből is kilehetett sajtolni többet csak a Power limitet kellett megemelni

![;]](//cdn.rios.hu/dl/s/v1.gif)

-

#Morcosmedve

veterán

válasz

#85552128

#17714

üzenetére

#85552128

#17714

üzenetére

Nem mélyültem el ebben, de mivel a táp felőli 6-pin szerintem nem limitált, azaz ha ráraksz párhuzamosan még egy ágat, aka megduplázod W-ot, nem változtat semmit, hogy a másik végén hány +12V-ra osztod le.

Ha érthető, amit mondok. Szerintem is mindegy a PIN-ek száma.

-

#85552128

törölt tag

Ugyanannyi 12V-os pinje van, a not connected rész vagy tápfüggő vagy nem tudom, de szinte minden normális táp 6 pines csatiján megvan és be van kötve.

Ha nem így lenne, a 6->8 pines átalakítók sem működnének.

A 75 és 150W pedig továbbra is egy elméleti limit vagy inkább mondjuk úgy ennyi a szabvány. Egyébként pedig van 2x8 pines 500W-os kártya ami 125W-tal több mint amit elméletileg felvehetne: [link] -

#85552128

törölt tag

válasz

he7edik.

#17711

üzenetére

he7edik.

#17711

üzenetére

Olyat kell venni amin 8 van... Btw. tekintve, hogy a 8 pin is csak +2 GND a 6-oshoz képest és létezik 6 pin -> 8 pin átalakító a 6 pinen is elméletileg up to 150W mehet. Szóval ha a kártya VRM része bírja akár 200W-ig gond nélkül ellehet menni, nem a 6 pin lesz a meghatározó hanem a GPU...

-

-

he7edik.

addikt

válasz

Bratilla95

#17704

üzenetére

Bratilla95

#17704

üzenetére

Ember. Nézd már meg az általad összehasonlított kártyák megjelenési dátumát, specifikációit, fogyasztását, tuningolhatóságát. Mindjárt rájössz hogy az AMD csak sokkal drágább hardver összetevökkel, sokkal magasabb sávszélel képes a zöld kártyák teljesítményét hogy azt is jóval késöbb. A higfosh AMD supportról nem is beszélve. Ezért is tart ott az ájemdé gazdaságilag ahol...

-

Bratilla95

tag

válasz

he7edik.

#17700

üzenetére

he7edik.

#17700

üzenetére

Ezt inkább fordítva írd, úgy helyes.

Egyébként akit nem érdekel a marketing, hanem tesztek alapján választ. Azoknak általában ~80% ban amd kártyája van, nézd meg a perf/$ értéket és ott a nvidia mindig lemarad, Pl.: 390x>980; 390>970; 380x>960(4gb mert ezzel van kb egy árban esetleg kicsit olcsóbb a 960) 380>960. -

válasz

#45185024

#17699

üzenetére

#45185024

#17699

üzenetére

Ezt sosem fogod megtudni... igazából az NV hasznát a pénzügyi jelentések gross marginjából tudod kb kikövetkeztetni... igaz abban bennevan minden termék, hacsak nem bontják ki GPU részre külön.

Utána kéne nézni.

Amugy a legtöbb IT cég 50% körülre törekszik vagy a felett... az alacsony hasznot termelő tömeges termékeknél meg jó ha van 20-30% és ez a közvetlen tőlük vásárlók felé értelmezendő (thát globál/régiós disztribútor, OEM).

A másik amiért nem tudhatod, hogy mire hozzád kerül a termék, abban benne van az NV haszna, a globális/regionális disztribútor (EU pl) haszna+költségei, benne van a magyar disztributor/forgalmazó haszna+költségei és a kisker haszna+költségei is.

Tipikusan azt mondanám hogy mondjuk az MSRP $599 ebból kb 20-30% lehet a "forgalmazás haszna", tehát amit az NV kap az mondjuk ~$420, ezen pedig kb 50% haszna lehet, tehát kb $210 a haszon, $210 dollár az összes rárakódó költség. Ha a 20-30%-os hasznot veszed, akkor meg $85-$125 a haszon és $335-$295 a teljes költség amit "rátesznek".

Persze ez csak az én tippem, mivel IT szektorban dolgozok és kb ezek szoktak lenni az arányok.

Új hozzászólás Aktív témák

Hirdetés

A topikban az OFF és minden egyéb, nem a témához kapcsolódó hozzászólás gyártása TILOS!

Megbízhatatlan oldalakat ahol nem mérnek (pl gamegpu) ne linkeljetek.

- NFL és amerikai futball topik - Spoiler veszély!

- Óra topik

- Iqos cigaretta

- Sub-ZeRo: Euro Truck Simulator 2 & American Truck Simulator 1 (esetleg 2 majd, ha lesz) :)

- Eredeti játékok OFF topik

- World of Tanks - OFF topic

- Megárthattak az Intel VGA-terveinek az emelkedő árak

- Forza sorozat (Horizon/Motorsport)

- Mr Dini: Mindent a StreamSharkról!

- A fociról könnyedén, egy baráti társaságban

- További aktív témák...

- iKing.Hu - Apple iPhone 15 Pro Max Black Titanium 100% Akku

- Lenovo ThinkPad X13 Gen 2 i5-1145G7 16GB 512GB FHD+ HunVillBill- 1 év garancia

- 214 - Lenovo LOQ (15ARP9) - AMD Ryzen 7 7435HS, RTX 4050

- Bomba ár! HP ProBook 440 G5 - i5-7GEN I 8GB I 500GB I HDMI I 14" HD I Cam I W11 I Garancia!

- HP EliteBook 640 G10 - 14" FullHD IPS - i5-1335U - 8GB - 512GB - Win11 - 1 év garancia - MAGYAR

Állásajánlatok

Cég: Laptopműhely Bt.

Város: Budapest

Cég: Central PC számítógép és laptop szerviz - Pécs

Város: Pécs

![;]](http://cdn.rios.hu/dl/s/v1.gif)