-

PROHARDVER!

A legtöbb kérdésre (igen, talán arra is amit éppen feltenni készülsz) már jó eséllyel megtalálható a válasz valahol a topikban. Mielőtt írnál, lapozz vagy tekerj kicsit visszább, és/vagy használd bátran a keresőt a kérdésed kulcsszavaival!

Új hozzászólás Aktív témák

-

paprobert

őstag

A videót még nem volt időm megnézni, úgy írom:

Ez az idővel, és címenként változik. Ha jól emlékszem a DF eleinte 2060S-re taksálta a konzolokat a konzol quality és sebesség megtalálásakor, mostanában már inkább a 2070S-hez hasonlítják.

Szóval ez nem teljesen kőbe vésett.Hasonlóan a PS4 eleinte 750Ti-hoz volt párosítva, de később elmászott a gépigény.

-

PuMbA

titán

válasz

paprobert

#63396

üzenetére

paprobert

#63396

üzenetére

Cyberpunk 2077: PC Benchmarks Running on PS5 and Xbox Series X - So What Do They Do?

A konzolok teljesítményét tökéletesen lehet replikálni egy kicsit alulfrekvenciált 6700 10GB-tal, ami a legközelebb van specifikációkban

PC-n PS5 grafikai beállításokkal pontosan megkapod vele a PS5 teljesítményét.

PC-n PS5 grafikai beállításokkal pontosan megkapod vele a PS5 teljesítményét. -

jimpo

senior tag

válasz

paprobert

#63396

üzenetére

paprobert

#63396

üzenetére

" Műszakilag a népkártya minimuma a 6700XT-nél kezdődik és a 7800XT-vel záródik. Egy ilyen kártya elviszi nagyon hasonló, vagy kicsivel magasabb szinten a modern címeket, mint a minőségnek az alsó határát jelentő konzolok. "

Ja csak konzolra a fejlesztők dolga egyszerűbb, PC fronton sok a változó. Már ha csak a CPU - GPU párost is nézzük, de még a memória is fontos. Az optimalizációt meg hagyjuk... Azt szintén hogy konzolok esetében sem minden natív felbontáson fut, vagy inkább semmi nem. Tehát, népkártya esetén a felbontás legalább annyira fontos "mint a minőségnek az alsó határát jelentő konzolok." felbontása. Amik címenként és gameplay közben is nagyon eltérőek, illetve folyton változhatnak.

Tehát akkor most milyen "magasabb szinten" is futnak a konzolokon a játékok

Azt leszámítva hogy kevésbé, vagy egyáltalán nem röccen ha jól van optimalizálva rá. Megnéznék pár címet hogy futna konzolon fix natív felbontással, ja ez nem így működik...

Bár engem pont nem érdekel, mert nem játszok minden friss címmel.

Népkártya ide, vagy oda, 1080p 144Hz 7800XT, bár inkább multizom.

Népkártya ide, vagy oda, 1080p 144Hz 7800XT, bár inkább multizom.  Nincs annyi időm hogy elmerüljek egy-egy Single-player címben.

Nincs annyi időm hogy elmerüljek egy-egy Single-player címben.

Még a kártya mellé kapott Starfield sem kapott játékidőt, konkrétan a menüig merészkedtem a kártya/játék megjelenése óta. De legalább ha minden igaz fényévekkel jobban futna, hála a patcheknek.![;]](//cdn.rios.hu/dl/s/v1.gif)

-

paprobert

őstag

Amit nem láttam megemlítve lehetséges okként, az a driver-only és a full Radeon Software telepítés közötti különbség.

1-2 éve teszteltem, és akkor az jött ki, hogy majdnem 0.5 GB-tal több VRAM maradt a játékoknak ha a Radeon Software nem volt telepítve a gépen.

Ennyi már bőven elég ahhoz, hogy egy kártya kifusson a VRAM-ból, és átessen a határon.Gondolom a QT alapú csillogó felhasználói felület, a webböngésző, overlay, teljesítménymetrika stb. összeadódik.

-

paprobert

őstag

válasz

Alogonomus

#63388

üzenetére

Alogonomus

#63388

üzenetére

A 6600 nem népkártya.

1, A konzolok teljesítményét se tudja.

2. PS4-re jött címek futtatására kiváló, PS5 címekre nem jó.

3. Ráadásul mivel 3-4szeresre fújt MSRP-vel érkezett, még ennyi leárazás után sem ott van az ára, ahova való.Műszakilag a népkártya minimuma a 6700XT-nél kezdődik és a 7800XT-vel záródik. Egy ilyen kártya elviszi nagyon hasonló, vagy kicsivel magasabb szinten a modern címeket, mint a minőségnek az alsó határát jelentő konzolok.

Népkártya áron csak last-gen minőséget kapsz, valódi népkártyát csak kétszeres áron.

-

válasz

Devid_81

#63394

üzenetére

Devid_81

#63394

üzenetére

Az a véleményem hogy az RDNA2 ( rész) sikere( RT ben azért nem volt túl jó) egyben az Nvidia hibája is volt. A Samsung gyártás legalább 20 % teljesítményt bent hagyott a csúcs Ampere kártyákba.

Ha mindegyik akkori gen azonos gyártáson készült volna szerintem nem lett volna eltérő forgatókönyv az eddigiektől. -

válasz

Petykemano

#63392

üzenetére

Petykemano

#63392

üzenetére

Szerintem nem létezett ilyen hiba, igazat adok Abunak.

Ez egy nagyon jó tapasztalat szerzés és majd felhasználják ezeket a refresh vagy 8000 szériánál, mert alapjában véve jó a 7000 sorozat , nem látom a " hibás" részéta miről mindenki beszél.

Nem tudom mióta elvárt hogy az AMD csúcs kártya lenyomja az Nvidia csúcskártyát, mert szerintem nem igen volt ilyen az utóbbi 10 évben.

Az nem feltétlenül hiba, ha a mási cég valamiben jobb. Mindenki elvan így.

A hibája az árazása, sajnos az Nvida mellett nem lényegesen olcsóbb, azon meg tudna mindkét cég újra tervezés nélkül is javítani,de nem fognak. -

Petykemano

veterán

Jhaaj, szerintem Te is tudod, idézőjel nélkül is tudod, hogy az "50%" csupán egy placeholder: a szép nagy és kerek szám csupán azt a célt szolgálja, hogy illusztrálni lehessen vele, hogy a szóbanforgó állítólagosan vélelmezett "hiba", amit a megkérdőjelezhető eredetű szóbeszédek néhány hónap alatt javíthatónak tételeztek fel azért kellően nagy teljesítménybeli hiányosságot eredményez ahhoz, hogy elvileg érdemes legyen vele foglalkozni.

-

válasz

Petykemano

#63389

üzenetére

Petykemano

#63389

üzenetére

vagy plusz 150 % teljesítménnyel.

Az örök optimizmus. -

Petykemano

veterán

válasz

DudeHUN

#63362

üzenetére

DudeHUN

#63362

üzenetére

Gondolkodtam azon, amit mondtál.

Ha a teljes szériát nézem, akkor amennyiben a "hibás" lapkák már le vannak gyártva, akkor van logika a javított változat visszatartásában. Amennyiben a hibás lapkák már le vannak gyártva, úgy vélem a "javított" változat hamar történő piacra vitelével nehezen eladhatóvá tette volna azokat és ez a kár szerintem legalábbis összevethető lehetne azzal a haszonnal, amit az elvárt teljesítményű kártyák piacra vitelével el lehetett volna érni.

Persze sok a ha, de az általam felvázolt logikát végig arra alapoztam, hogy "ha a >>hibás<< lapkák már le voltak gyártva, amikor a hiba kiderült". Nyilván nincs információm arról, hogy ez a helyzet valóban fennállt-e.Viszont abban igazad van, hogy ha valóban létezett volna ilyen "hiba", amit valóban képesek lettek volna egy negyedévnyi munkát igénylő respinnel korrigálni, akkor a 7900XTX fölé mindenképpen érdemes lett volna kiadni a "javított" változatot +50% teljesítménnyel (600W TDP nélkül), csak hogy lenyomják a 4090-et.

-

Alogonomus

őstag

válasz

meteoreső

#63387

üzenetére

meteoreső

#63387

üzenetére

MLiD táblázata többé-kevésbé jól belövi a különböző kategóriákat.

A "népkártya", amit nála a "mainstream" kategória képvisel az nem 220 ezerért szerezhető be. Egy aktuális "népkártya" állandó és alapvető tulajdonsága, hogy az aktuális játékokban és a népszerű felbontás esetén maximálishoz közeli beállításokkal már jellemzően csak 60 fps körüli értékre képes, illetve a kisebb igényű játékok esetén 90 fps az elvárható vele. Az idő megszépíti az emlékeket, de az utolsó csupa nagybetűvel emlegetett "népkártya", a 1060 esetén is ez volt a helyzet.Az persze igaz, hogy a sok beragadt előző generációs kártya miatt a mostani generációban nem érkezett valóban "népkártyának" tekinthető termék, habár a 7600 és 4060 valamannyire tekinthetőek annak, de a valódi "népkártya" az előző generációs 6600 és 3060, amik meg is kaphatóak 90 és 110 ezer között. 120 ezerért pedig már nem csak a 6700, de a 7600 és a 4060 is beszerezhető.

A 7700 XT - ahogy a táblázatban is látszik - egy felső középkategóriás kártya, nem "népkártya", ahogy a vele többé-kevésbé egyenrangú 3070-ek és a 2080 Ti is messze vannak még a "népkártya" kategóriától, hiszen ha átnézed a 2023-as játékok teszteredményeit, akkor még maximális beállítás mellett is elfogadható teljesítményre képesek. Némileg lecsökkentett grafika esetén pedig bőven elfogadható szintet képesek biztosítani Full HD felbontáson.

-

meteoreső

újonc

válasz

Alogonomus

#63353

üzenetére

Alogonomus

#63353

üzenetére

És gondolod hogy nem lesz még "Olyan időszak" ?

Amikor bejön majd a méregdrága Vafer 2 nanométerre

akkor mennyi lesz szerinted egy FULL HD kártya AMDnél ami mindent visz ? Lesz gondolod 100 forintért ?

Egyszerűen mindig "úgy alakul" hogy nincs népkártya.

7700-nak kellene most annak lenni de 220 ezerért ez is vicc. -

Abu85

HÁZIGAZDA

De van magyarázat.

Először is fontos, hogy az AMD és az NV logikai memóriakezelése eltér.

Az AMD-nek ez az implementációja:

Memóriahalmaz 0 (eszközlokális) -> Memóriatípus 0 (eszközlokális, host által látható, hostkoherens)

Memóriahalmaz 1 -> Memóriatípus 1 (host által látható, hostkoherens)

Memóriahalmaz 1 -> Memóriatípus 2 (host által látható, host által cache-selhető, hostkoherens)Az NV-nek ez az implementációja:

Memóriahalmaz 0 (eszközlokális)-> Memóriatípus 7 (eszközlokális, host által látható, hostkoherens)

Memóriahalmaz 0 (eszközlokális)-> Memóriatípus 8 (eszközlokális)

Memóriahalmaz 1 -> Memóriatípus 9 (host által látható, hostkoherens)

Memóriahalmaz 1 -> Memóriatípus 10 (host által látható, host által cache-selhető, hostkoherens)

Memóriahalmaz 1 (NULL) -> Memóriatípus 0 (NULL)

Memóriahalmaz 1 (NULL) -> Memóriatípus 1 (NULL)

Memóriahalmaz 1 (NULL) -> Memóriatípus 2 (NULL)

Memóriahalmaz 1 (NULL) -> Memóriatípus 3 (NULL)

Memóriahalmaz 1 (NULL) -> Memóriatípus 4 (NULL)

Memóriahalmaz 1 (NULL) -> Memóriatípus 5 (NULL)

Memóriahalmaz 1 (NULL) -> Memóriatípus 6 (NULL)Látható, hogy mennyi az eltérés, és ebből tud olvasni az OS. De nem minden memóriatípust. És itt a fő kérdés az, hogy maga a program hogyan használja a logikai implementációt. Például az UE5 tipikusan támaszkodik a host által látható flagre a működése miatt, így az NV-n eléggé intenzíven kell használni a NULL flages erőforrásokat, mert ugye szart sem ér az adatot olyan eszközlokális helyen tárolni, ami nem látható a host által. És minden olyan adat, ami NULL flages erőforrásban van nem számolt adat, mert csak az alkalmazás tudja nyomon követni a flagelés jellege miatt. Tehát az adat ettől még ott van a VRAM-ban, vagyis a gyakorlatban nem rosszabb az NV memóriakihasználásának hatékonysága, csak ez egy külső szoftver számára nem látható. De ettől az NV GPU-k is tudják használni a VRAM adottságait, mennyiségét, nem kényszerülnek a más logikai menedzsment miatt kevesebb VRAM-ra, csak tényleg nem látod, hogy konkrétan mennyit használ a VRAM-ból.

És abból se induljatok ki, hogy ennyire eltér a logikai menedzsment a gyártók között. Ugye a DirectX 12-nek is van egy elvárt működési módja, és a gyártók hardvereinek is. A logikai menedzsment a különbségeket próbálja áthidalni. A lényeg itt az, hogy kialakítható legyen egy olyan működés, amivel az adott alkalmazás képes teljes egészében kihasználni a rendelkezésre álló erőforrásokat, vagyis ha 8 GB VRAM-van egy VGA-n, akkor szépen menjen el a foglalás 8 GB közelébe. És azért vannak eltérő menedzsmentek logikailag, mert a gyártók ezt a célt más struktúrával érik el, de az API szempontjából mindegy a hogyan, a lényeg a cél elérése. És attól még az NV eléri ugyanezt a célt, hogy egy 3rd party alkalmazás képtelen látni a NULL flages részeket. Tehát a hatékony működés megvan, csak nem látható számodra.

-

Na jó de Daniel videójából világosan látszik, hogy más magyarázat nem lehet erre a UE5 engine alatt, mint a Vram felhazsnálási módja a két gyártónál.Elég logikus videó logikus következtetésekkel, mint mindíg tőle. Ráadásul Nvidia is ezt állítja amit ő most alátámasztott,[link]

hogy lehet éppen a nagyobb L2 miatt is ez. -

Abu85

HÁZIGAZDA

Semmi köze hozzá. Eleve a kiírás egy fals adat, mert a memóriahalamzok-típusok jó része nincs is beleszámolva. Értsétek meg, hogy a DirectX 12 úgy van felépítve, hogy ezt csak az alkalmazás tudhatja. Se az OS, se a driver, se egy külsőleg megírt program nem kaphat képet arról, hogy mi van a VRAM-ban. Fel lehet venni fejlesztőeszközzel, de nem ezt csinálta a videós. Ha ezt csinálta volna, akkor az reális adat lenne. Kiválaszt egy frame-et, és felveszi az egészet, majd elemzi külön. A gond az, hogy ilyen memóriavizualizálója csak az AMD-nek van. Tehát NV-n ez nem megvalósítható. Nem tudni, hogy ilyen tool mikor lesz a GeForce-okhoz. Igazából nem kritikus komponens, mert a legtöbb kapcsolódó bug univerzális, tehát az NV meg tudja várni, amíg ezeket javítják a fejlesztők Radeonokon, és ugyanúgy megjavul a hiba náluk is. Félelmetesen ritka, amikor valami gyártóspecifikus alkalmazásbeli bug okoz olyan hibát, ami szívást okoz a VRAM-on belül. Ha ilyen előfordul, akkor az NV meg tudja mondani, hogy miért, és könnyű javítani memóriavizualizáló nélkül is.

Az a baj, hogy minél közelebb viszed a hardverhez a programozást, annál kevesebb adatot tudsz az OS-sel vagy külön programokkal ellenőrizni. Régen ezek azért működtek, mert volt egy kernel driver, onnan azért a gyártók látták, hogy a program mit hova helyez, de ma a kernel driver nem létezik. Ki lett dobva, mert nagy többletterhelést csinált.

Az OS tud némi adatot ellenőrizni, de nem mindet, mert koncepcióból elvágta a Microsoft az ellenőrizhetőséget.

Még az AMD és az NV is képtelen erre driverből. Bár azt megjegyzem, hogy valamivel pontosabb a gyártói mérés a 3rd party programokhoz viszonyítva, de a NULL-flages foglalásokat senki se látja, és ez az AMD és az NV számára is megkerülhetetlen korlátozás. Koncepcióból ilyen a rendszer, tipikus nem bug, hanem fícsőr dolog.A kérdésedre válaszolva pedig olyan megtörténhet, hogy az alkalmazás memóriamenedzsmentje időnként defragmentál. Ez a DirectX 12 alatt lehetséges, és ilyenkor hirtelen növekszik a sebesség. Ez minden hardveren megtörténik, de más időközönként. A célja a defragmentálásnak az, hogy legyenek nagyobb összefüggő szabad memóriaterületek, vagyis ne kelljen valós időben kidobálni a last used lapokat.

-

Abu85

HÁZIGAZDA

Ez ezerszer át volt beszélve. A VRAM az olyan programok számára nem látható, mint a 3rd party tuningprogramok. Ennek az az oka, hogy a D3D12 és a Vulkan API-k esetében már nem létezik kernel driver. Tehát magáért a memóriamenedzsmentért az alkalmazás felel, de annak ezek az adatai annyira védettek, hogy még maga a grafikus meghajtó sem tudja már pontosan meghatározni, hogy mi hol van a VRAM-ban, és mennyi helyet használ.

Ezért vannak erre a problémára külön segédprogramok, mint például az RMV. [link] - De ez a program konkrétan felveszi az adott frame-re vonatkozó adatokat, tehát visszakereshető, hogy mi, hol, mennyi helyet foglal. Ez azért is lényeges, mert a VRAM az még egy operációs rendszer elől is elrejtett memória.

A DirectX 12 API-val a grafikus alrendszer úgy működik, hogy úgynevezett memóriahalmazok vannak logikai szinten kezelve az operációs rendszer, illetve annak kapcsolódó komponensei által. Ezekhez a logikai memóriahalmazokhoz tartoznak memóriatípusok. Ráadásul ezek mind, vagyis a halmazok és típusok is különböző flagekkel bírnak, vagyis lehetnek eszközlokálisak, host koherensek, host által láthatók, valamint host által cache-elhetők, esetleg egyik sem. Amikor például a Windows meghatározza a memóriahasználatot a feladatkezelő vonatkozó fülén belül, akkor ezeket a memóriahalmazokat látja, de azért nem tud még így sem pontos képet adni, mert egy memóriatípus lehet úgynevezett NULL-flages, és ilyenkor az operációs rendszer sem tudja megállapítani, hogy az adat, ami abban van, konkrétan hol található a fizikai memóriákon belül, a VRAM-ban vagy a rendszermemóriában. Ezt kizárólag az alkalmazás tudja, és pont emiatt vannak olyan memóriavizualizáló fejlesztői eszközök, amikkel ezt a fejlesztők láthatják.

Az ilyen 3rd party programok nagyrészt csak tippelnek, mert annyi adatjuk sincs, mint a Windows feladatkezelőjének, tehát megpróbálják kiolvasni az OS-ből az eszközlokális halmazok adatait, és kidobnak az alapján egy számot. Egy biztos, hogy annak köze nem lesz a valósághoz, mert nem foglalkoznak az összes memóriahalmazzal és memóriatípussal, főleg nem a NULL-flagesekkel. Márpedig ez fontos, mert az AMD-nél két memóriahalmaz és két memóriatípus van megkülönböztetve. Az NV-nél két memóriahalmazra 11! különböző memóriatípus létezik. És ezek közül egyik gyártónál sem mind eszközlokális. Ráadásul mint írtam a NULL-flagest semmi sem látja, márpedig abból az NV-nél van hét darab. Tehát minden adat, ami NULL-flages memóriatípusba kerül, az még az operációs rendszernek is láthatatlan információ. Nem tudnak vele számolni, mert el van rejtve, hogy ne zavarja a rendszer logikai működését.

Lehet nézni egy alkalmazásban az eltérő hardverek memóriahasználatát, de ahhoz memóriavizualizáló kell, mert a tippelőprogramok erre nem alkalmasak.

-

jimpo

senior tag

Ennél a példánál még több is a spórolás, 1+ GB VRAM használat különbség GeForce RTX 4060 Ti 8GB vs 16GB Hát magáért beszélnek a képek. Igaz mindkettőn fut!

-

PuMbA

titán

válasz

huskydog17

#63378

üzenetére

huskydog17

#63378

üzenetére

Azt hittem, hogy ez csak egy mende-monda

Akkor tényleg igaz. 0,5-1GB VRAM használatot spórol ezzel az NVIDIA. Okos.

Akkor tényleg igaz. 0,5-1GB VRAM használatot spórol ezzel az NVIDIA. Okos. -

FLATRONW

őstag

válasz

huskydog17

#63378

üzenetére

huskydog17

#63378

üzenetére

Ezt én is észrevettem most Pascal - Ada váltás során, hogy ugyanaz a játék (Rise of the tomb raider) jelentősen kevesebbet kér max beállítások mellett.

-

huskydog17

addikt

Ebben nincs semmi meglepő, az NV már hosszú generációk óta hatékonyabb memóriatömörítést alkalmaz, emiatt azonos terhelésnél alacsonyabb a VRAM használat, mint a pirosoknál. Az általad linkelt videó ezt újra megerősíti.

A Turing 2018-ban tovább növelte a memóriatömörítés (DCC) hatékonyságát elég masszívan. -

PuMbA

titán

Does AMD need more VRAM to do the same thing?

Érdekes videó, ami tovább viszi a 2-3 évvel ezelőtt már felmerült témát. A 4060 30%-kal veri a 7600-at ugyanazokkal a beállításokkal bizonyos esetekben, ha a 7600-on kifogy a 8GB, de NVIDIA-n még nem, ugyanazokkal a beállításokkal. Mintha az NVIDIA 500MB-tal beljebb lenne.

-

PuMbA

titán

AMD Radeon RX 7900 XTX card drops to $799 in the US

Hamarosan jön az előző évhez hasonló tavaszi RDNA3 áreső, de már a 7700XT és a 7800XT is benne lesz

Karácsonykor sosem viszik le az árakat, mikor pont meglódulnak az eladások.

Karácsonykor sosem viszik le az árakat, mikor pont meglódulnak az eladások. -

S_x96x_S

addikt

(extrém vad találgatás)

Az AMD megnyitotta az "Infinity Fabric XGMI" -t

úgyhogy valamilyen komoly NVIDIA NVLink - alternativa is kezd kialakulni, vagyis a GPU-kat simán hálózatba lehet majd kötni ..Bár > 2-6 év, mire lecsorog a consumer szintre ,

azért eléggé kitágítja majd a lehetőségeket ..

pl. 2 Threadripperben lévő 2x4 GPU-t egynek kezeli az operációs rendszer, amivel el lehet érni akár a 10 millió fps feletti értéket is .. -

Callisto

őstag

A bug amiről beszéltek az mind csak hit kérdése. Semmi tény nem szerepel sehol. Anno pletykák voltak, hogy milyen teljesítménye lesz az RDNA3-nak, de azok is pletykák. Aztán kijött és nem lett és jött egy pletyka, hogy bugos. De csak pletyka.

Innentől kezdve az, hogy ki mit hisz az az egyén döntése és nem tény. Ismétlem: csak HIT, melyet páran tényként kezelnek és úgy beszélnek róla. -

-

Alogonomus

őstag

Viszont ugyanúgy felvázolható egy olyan logikai okfejtés is, ami a "hibás" RDNA3-as forgatókönyvet igazolja, és hogy miért nem javította utólag az AMD.

A Navi 31-es és Navi 32-es kártyák iránt hatalmas a kereslet, a hatalmas keresletre válaszként a 7800 XT egyenesen a hivatalos árát is meghaladó árcédulával kerülhet a polcokra, amit rajta kívül csak a 4090 tud felmutatni ebben a generációban, de annak egyértelműen a szankciók és a kínai állami felvásárlás az oka.

Abszolút hihető magyarázat lehet, hogy az AMD az "hibás" RDNA3 kimondottan kedvező eladásait látva úgy döntött, hogy a mérnökei munkaidejét nem az egyébként is sikeres RDNA3 kijavítására osztja be, hanem vagy az RDNA4 és még későbbi generációk fejlesztésére, vagy akár más termékkategória (CPU, APU, stb) fejlesztésére, miközben az Nvidia még rá is kényszerül a Super kártyák piacra dobására, amiket kisebb-nagyobb árengedményekkel is meg kell még támogatniuk.

Az AMD akkor sem tudta volna eladni mondjuk $1300-ért a javított 7900 XTX-et, ha a javítást követően teljes mértékig ott lenne a 4090 szintjén. Ugyanígy a javított 7900 XT-ért sem adtak volna $1000-t, hiába hozta volna a 4080 teljesítményét. Ugyanez igaz a Navi 32-es kártyák kapcsán a 4070 Ti és 4070 ellenében. A Radeon márkaértéke még lényegesen elmarad a Geforce mögött, és még az Nvidia is kénytelennek látszik a lélektani $1000 alá csökkenteni a 4080 Super hivatalos árát, hogy elfogadható alternatíva legyen a 7900 XTX ellenében, és visszabillenjen az arány a mostani 2,5:1-ről legalább 1:1 szintre. -

Abu85

HÁZIGAZDA

válasz

Hellwhatever

#63366

üzenetére

Hellwhatever

#63366

üzenetére

A chiplet lényege az, hogy a lapka egyes részeit ne kelljen újratervezni. Ezért vezették be. Olcsóbb gyártást és olcsóbb fejlesztést jelent. Az olcsóbb gyártás abból ered, hogy a chipletbe nagyrészt I/O kerül, ami nem jól skálázódik, tehát lehet olcsóbb node-on gyártatni, az olcsóbb fejlesztés pedig onnan jön, hogy megvan az MCD, így a következő generációhoz már nem kell kifejleszteni. Spórolnak vele 200-300 millió dolláros egyszeri költséget.

A chiplet dizájn teljes egészében úgy egymilliárd dolláros, összköltségben mért spórolásra jön ki egy teljes generációra. Nyilván a jövőben is alkalmazni fogják, mert ennek a pénznek van jobb helye máshol. Persze manapság egy generáció három évre van tervezve, és akkor negyedévekre lebontva az egymilliárd dollár egy AMD szintű cégnek még nem is sok, de menedzsment szempontjából van jobb helye.

-

Abu85

HÁZIGAZDA

válasz

Petykemano

#63361

üzenetére

Petykemano

#63361

üzenetére

Az RDNA 2 készletek nem befolyásolnak semmit, hiszen eladják így is mindet.

Mi a valószínűbb... az AMD a saját maga ellensége, és azért nem javítanak egy +50%-os tempóval kecsegtető hibát, mert három hónapnyi melót túl soknak tartanak egy két és fél évig gyártandó generációnál, vagy eleve nem létezik a hiba, és valamelyik twitteres jószág kitalálta? Csak egy picit gondolkozzatok logikusan, és rájöttök, hogy a twitteres pletykák 99%-a megdől az elemi logikán.

-

S_x96x_S

addikt

válasz

Hellwhatever

#63366

üzenetére

Hellwhatever

#63366

üzenetére

> Arról van valami infó hogy

> az RDNA 4 alapú GPU-k tényleg dobják a chipletes felépítést?csak pletyka ...

de állítólag ennek az az oka,

hogy hamarabb ki tudják hozni az RDNA4 -et

a "nép" piacra, vagyis a high-end kivételével mindenhova.

pl. Kézi konzol, mobil apu, mobil gpu,

És az is lehet, hogy RDNA4 azért is sürgős, mert ez kerül a következő PS devkitjébe ideiglenesen ..

A chipletes tesztelés - elég sok idő .. és ha valami kiderül, akkor újabb 2-3 hónap extra fejlesztési idő kell - mig a chipeteken átvezetik a javításokat .. újabb teszt .. és újabb javítandók ..

az RDNA5 már chipletes lesz ..

és szerintem sok ötlet az MI300-ból ( CDNA ) - adaptálva lesz .. -

S_x96x_S

addikt

válasz

Petykemano

#63361

üzenetére

Petykemano

#63361

üzenetére

> ha létezik, akkor az AMDnek érdeke eltitkolni.

sajnos nem ismerünk minden információt,

emiatt bármit bele lehet látni az egészbe ..DE: ha feltételezzük,

hogy az AMD-t racionális döntések alapján vezetik,

ÉS: a vezetők olyan döntést hoznak,

ami a döntéskor elérhető információk alapján, az AMD hosszú távú érdeke.

AKKOR: csak egy dologban dönthetünk ..

Megbízunk -e a jelenlegi AMD menedzsmentben vagy sem ?

vagyis ez egy "TRUST issue" -

Hellwhatever

aktív tag

Arról van valami infó hogy az RDNA 4 alapú GPU-k tényleg dobják a chipletes felépítést?

Mert szvsz ez a bug eredhet ennek a felépítésnek valami hozományából is vagy akár abból is hogy a GPU egyes részei eltérő órajelen futnak és nem minden részegység (vagy munkafolyamat) kedveli ezt.

Ha valahol itt van a kutya elésva annak a javítása már lehet több mint egy respin.

-

PuMbA

titán

válasz

Petykemano

#63361

üzenetére

Petykemano

#63361

üzenetére

RDNA3 főleg a chiplet miatt fontos az AMD-nek, amúgy csak egy inkrementális lépés az alsó és középkategóriában. Semmi állleejtőt nem mutat ezekben a kategóriákban az RDNA2-höz képest ár / sebesség / fogyasztásban. Az biztos, hogy az RDNA2 nagyon jól sikerült, sok játékos gépébe fognak szolgálni még évekig, mint anno a GCN4. RDNA3 kevésbé lesz egy játékos kedvenc architektúra.

-

jimpo

senior tag

-

DudeHUN

senior tag

válasz

Petykemano

#63361

üzenetére

Petykemano

#63361

üzenetére

Szerintem meg üzletileg az a logikus, ha tényleg ennyi és kapsz kb. +50%-ot, akkor már kint lenne egy új széria és kapott volna az architektúra egy új marketing nevet.

Nem hinném, hogy ne akarnának több kártyát eladni. Főleg, ha ennyi lenne az egész. -

Petykemano

veterán

Értem. De nem tudom, mit higgyek, mi a teljes igazság.

Hiszen a teljes igazsághoz hozzátartozik az is, hogy egy rakás RDNA2 készleten ültek, amit most így azért mégiscsak eladtak, ki tudja milyen áron kelt volna el, ha az RDNA3 jól sikerül, vagy ha kap egy respint. Ki tudja, az RDNA2 készletek miatt mennyi már legyártott - "hibás" - RDNA3 lapkán ültek, mikor váratlanul kiderült a "hiba"? Szóval ha egy ilyen hiba létezett, amit negyed év alatt tudhattak volna frissített termékkel korrigálni, akkor se 100%, hogy üzletileg ez a helyes lépés.

Arra is lehet gondolni, hogy ha kiadnak egy frissített terméket, akkor be kell ismerni a hibát, a hibás terméket vásárlók csalódottak lesznek, pénzvisszatérítést kérhetnek, még ha nincs is igazuk, botrány lehet belőle. Egy kijavított hibáért nehéz felárat kérni utólag.

Eközben ha tényleg létezik a "hiba", akkor ez a low hanging +~50% simán elmegy legalább fél generációváltásnak. Korábban is volt ilyen, gondoljunk csak a "GHz edition"-re.

Vagy ha a megoldást az RNDA4-ben viszik piacra, akkor ott az összeadódó előnyök miatt lehet árat emelni.Ezen megfontolások mentén én nem merném egyértelműen kijelenteni, hogy ha létezne a könnyen javítható hiba, akkor azt biztos hamar javítanák és mivel ez nem történt meg, ezért biztosan nem létezik ilyen hiba. De ez persze nem bizonyíték arra se, hogy biztosan létezik. Az viszont szerintem biztos, hogy ha létezik, akkor az AMDnek érdeke eltitkolni.

-

Abu85

HÁZIGAZDA

válasz

Petykemano

#63355

üzenetére

Petykemano

#63355

üzenetére

Erre rákérdeztem a múltkor, face-to-face az egyik vezető szerepkört betöltő személynél, és azt mondta, hogy ha lenne egy ilyen bug, amiről irkáltak, már rég javították volna, mert csak új steppinget kellett volna csinálni, amit negyed év alatt megoldanak, és akkor +50% teljesítmény. Az, hogy ezt nem tették meg, bizonyítja, hogy nem létezik a bug, mert +50%-ért megérné egy respin, de nincs mit javítani, mert úgy működik a hardver, ahogy tervezték.

Ami a valóságban van, hogy az RDNA 3 egyes részei eltérő órajelen futnak, és van olyan szituáció, amikor az egyes lapkák 3 GHz fölött működtetik a front-end részt. Ez szintén normális, így tervezték a hardvert. Arra nem tud mit mondani, hogy miért gondolják páran azt, hogy ha a front-endet 3,5 GHz-re tervezik, akkor a shadereknek is feltétlenül annyin kell működniük.

-

Raymond

titán

válasz

Petykemano

#63358

üzenetére

Petykemano

#63358

üzenetére

Az RDNA4-ben biztos javitva lesz, ott mar a varhato orajelek lesznek.

-

paprobert

őstag

válasz

Petykemano

#63352

üzenetére

Petykemano

#63352

üzenetére

Igen. Így, hogy az RDNA3 nem szólt akkorát mint ahogy eredetileg várni lehetett, egy RDNA3 feature levelre felpumpált középnagy 6nm-es chip költséghatékonyabb lett volna valószínűleg.

De nem gondolom hogy álmatlanul éjszakáznak az AMD-nél a packaging költsége miatt, jó a profit így is. Emellett így már rendelkeznek egy olyan know-how-val, ami értékes a jövőre nézve.

-

Raymond

titán

válasz

Petykemano

#63355

üzenetére

Petykemano

#63355

üzenetére

Javitani biztos lehet vagy lehetett volna, csak persze ott mennek a honapok/felevek es siman lehet hogy miutan osztottak/szoroztak a dolgokat az jott ki, hogy marad ahogy van es nem lesz re-spin vagy frissites, majd lesz a kovetkezo generacio. Mert ha lenne akkor valamikor most kene megjelennie 7x50 termekek formajaban, de latjuk hogy sehol semmi. Raadasul meg mindig a 6-os sorozatot aruljak az alsohazban, most fognak majd valamikor elfogyni a hetekben.

-

Petykemano

veterán

válasz

Raymond

#63354

üzenetére

Raymond

#63354

üzenetére

Igen, valóban nem az N5 hibája, de összességében a gyártástechnológiai előrelépés sem hozott kézzelfogható eredményt az asztalra. Ilyesmire utal az, hogy valamilyen tisztán compute feladatban elérte a 3.5Ghz-et.

Mit gondolsz, lehet arra számítani, hogy ezt a bug-ot, amit akár javíthattak is volna egy frissített RDNA3-ban, végülis sikerült korrigálni, csak külön termékvonalat már nem hoztak rá, viszont az RDNA4 architekturális fejlesztései mellett az RDNA4-ben ez is megérkezik majd?

-

Raymond

titán

válasz

Petykemano

#63352

üzenetére

Petykemano

#63352

üzenetére

"Önmagában az, hogy a compute részt N5-ön gyártották, ez pedig nem eredményezett komoly órajel emelkedést."

Ennek viszont nem az N5 az oka hanem a hardware bug ami az alacsony orajeleket okozza. Az eredeti terv egyertelmuen a 3Ghz kornyeket celozta meg de ez nem jott ossze. Ugy dontottek marad ahogy van mert nem volt ido/penz/akarat javitani.

-

Alogonomus

őstag

-

Petykemano

veterán

Nem sikerült, mert valószínűleg nem a jelenlegi, hanem még a kripto által húzott gazdasági környezetbe szánták.

az RDNA3 két nagy dobása közül az egyik a chiplet, ami akkor lett volna hasznos, ha a kereslet őrült magasságba veri a N5 wafer árait. Skálázódásra nem használták.

A másik pedig a V-cache le(hete)tt volna, amit végül szintén nem vetettek be.

Önmagában az, hogy a compute részt N5-ön gyártották, ez pedig nem eredményezett komoly órajel emelkedést. Valamivel persze nyilván kisebb helyet igényel és bizonyára a fogyasztás is alacsonyabb működés közben.Szerintem összességében jobban jártak volna, ha a Navi22-t is portolják N6-ra, esetleg icipicit mókolnak vele, gyorsabb ramot raknak rá. A 7700XT-t talán nem érte volna el, de megközelítette volna és egy ilyen monolitikus ~290mm2-es N6-on készülő lapka valószínűleg alacsonyabb költséget is jelentett volna, miközben még mindig nem olyan nagy, hogy a kihozatali arány rossz legyen.

Az a kérdés merült volna csak fel, hogy a 7800XT-ért érdemes-e megtartani a Navi32-t.

Azt helyettesíteni egy N6-ra portolt Navi21-gyel lehetett volna, ami mondjuk 450mm2. Ez kicsit talán nagy is, meg ehhez képest a Navi32 már összességében észrevehetően kisebb lapkaméret.Persze utólag könnyű okoskodni. De nekem így, ahogy alakult, az RDNA3 még mindig picit elvesztegetett generációnak tűnik.

De nyilván az AMD sok tapasztalatot szerzett arra nézve, hogy hogy működőképes a skálázódás és hogy hasznot hajt-e a V-cache.

-

meteoreső

újonc

Semelyik nem is csinálnak 7500-at. Pedig pont a 7550 12 GB lehetne a népkártya. Csak ha eltünteted a látásmódodból a VSt akkor megérted hogy AMD nem is akarta soha átvenni az első videókártyagyártó díjat.

Az én mostani 6600 Xtmet 58 ért vettem amit 240 ezerért árultak 2 éve. Abban a kategóriában akar mindenki árulni !

A GAMER KÁRTYA ma EGY MELLÉKTERMÉK. -

PuMbA

titán

AMD Radeon RX 7600 XT’s China release date uncertain amid RX 6750 GRE series popularity

Úgy látszik, hogy az RDNA2-t nehéz lesz kirobbantani, mert még a 6nm / chiplettel sem igazán sikerült elég olcsón gyártani a 7700XT-t. Nagyon érdekes lesz figyelni, hogy az AMD vagy az NVIDIA tud majd több alsó kategóriás kártyát teríteni a játékosokhoz a jelenlegi generációból.

-

DudeHUN

senior tag

1440p maximum beállítások a videóból:

4060 TI 8GB - 4060 Ti 16GB - 7700XT

Talos: 100% - 117% - 124%

LothF: 100% - 100% - 103%

Jusant: 100% - 102% - 114%

Robocop: 100% - 102% - 111%

IoA: 100% - 105% - 126%

Remnant 2: 100% - 100% - 122%A zöldek fogyasztásban sokkal jobbak azt tegyük hozzá. Perf/watt is érezhetően jobb.

-

válasz

Alogonomus

#63343

üzenetére

Alogonomus

#63343

üzenetére

Szokásos bugyuta következtetés tőled ,általánosítva.

Ne egy játékból vonj el oltári nagy, epikus, jövőbe mutató következtetéseket főleg hogy két hónapja a z RX 4080 nal sem bírt RT alatt Forniteben a 7900XTX ugyan ezen teszten.[link]

Gondolom van rá magyarázatod.

A 7700XT 15-20 % kal gyorsabb alapból a 4060 Ti nél míg UE5 alatt semmiféle extra előnyt nem tud felmutatni , sőt vannak UE5 játékok ahol lasabb.

Nézd meg ezt a videót, friss ropogós.[link] -

Devid_81

félisten

válasz

Alogonomus

#63343

üzenetére

Alogonomus

#63343

üzenetére

Az biztos, hogy a 4K alatti +21% teljesitmeny nem er annyit, hogy kozel 2x olyan draga legyen az Nvidia.

Legalabbis nekem nem erne meg annyit, egyszeru jatekos szemmel nezve.

Munkara biztosan mas a ketto, de az nem az en asztalom.

UK Scan-nel nezve (nem is a legolcsobb minden esetben) a legolcsobb beloluk:

RTX 4090 £1749

RX 7900 XTX £939Abbol a £810 kulonbsegbol majdnem meglehet venni minden alkatreszt a PC-hez ha nullarol indul az ember.

-

Alogonomus

őstag

Végre kijött a régóta várt 4090 - XTX összemérés, és bár persze a 4090 jött ki belőle győztesen, de az a Fortnite UE5 RT eredmény komoly trófea az XTX oldalán, és újabb bizonyíték arra, hogy az RDNA3 nagyon passzol az UE5 igényeihez, valamint az eredmény azt is igazolja, hogy a 2023-as UE5-ös játékok RDNA3 felé hajló eredményeit csak egy "unoptimized" indokkal az asztalról lesöpörni próbálóknak nem volt igazuk, valamint az idei és későbbi UE5-ös címek elé is komoly reményekkel nézhetnek az RDNA3-as kártyák tulajdonosai.

-

Petykemano

veterán

válasz

szmörlock007

#63341

üzenetére

szmörlock007

#63341

üzenetére

Nem tudom, mi milyen költségtételt jelent.

De tudomásom szerint az RX 7600 jelenleg 4db 16Gb-es (2GB) modullal készül.

A 32Gb-os modul lehetne az az "elvileg" olcsó megoldás, amire Abu szokta mondani, hogy kapacitástól alig függ az ára. De a Samsung weboldalán a 16Gb-es sűrűség a legmagasabb kiválasztható. Még a GDDR7 esetén is csak 16 vagy 24Gb-os modulokról beszélnek.Az eddig ismert megoldások pedig a PCB áttervezése lehet úgy, hogy elférjen 8db modul a lapka körül, vagy az, hogy a PCB hátoldalára is kerül 1-1 modul.

Az eddig ismert megoldásokon kívül még szóba jöhet az a GDDR6WHogy melyik mennyire nagy költség-növekedést jelent azt persze nem tudom.

Ha tippelnem kéne, akkor azt tippelném, hogy megfognak egy Navi32-es PCB-t és arra teszik rá a Navi33-at és kész. Ezzel meg van oldva a VRAM helyének és a magasabb frekvenciához szükséges tápellátás, valamint a hűtő méretének kérdése is. De látva azt, hogy gyakran mennyire minimális árkülönbség van pl a 6400, 6500 és 6600 kártyák között, ezt se nevezném - a fogyasztó szempontjából - költségtakarékos megoldásnak. -

szmörlock007

aktív tag

válasz

Petykemano

#63340

üzenetére

Petykemano

#63340

üzenetére

Amúgy ha nem lesz nagy felára akkor azért nem felesleges termék. Már Full Hd-ban is van amikor kevés a 8Gb, ha Ultra felbontású textúrákkal és modellekkel akarsz játszani. Például a last of Us-nál 9 giga felett van ha ultrára teszem ezeket. Ha 350 dollárért fogják árulni az tényleg necces lenne, de ha megoldják 300-320-ért, akkor szerintem nem rossz azért azoknak akiknek ez fontosabb szempont.

-

Petykemano

veterán

válasz

hokuszpk

#63339

üzenetére

hokuszpk

#63339

üzenetére

Biztos emeltek 3-4%-ot a GPU frekvencián és mondjuk rá lehet tenni 20gbps-os ram modulokat is és akkor biztos kijön 5% különbség, amiért már el lehet kérni - a 16GB időállóságára hivatkozva - 30-40%-kal több dodót. Ahogy a kolléga fentebb kifejtette, valószínűleg úgyse a gamer a célpont, hanem valamiféle belépőszintű AI munkaeszköznek szánják.

-

hokuszpk

nagyúr

válasz

Petykemano

#63338

üzenetére

Petykemano

#63338

üzenetére

karácsony előtt volt nálam 7600 ; simán ment 3Ghz -t ; az más kérdés, hogy úgytünt semmi pluszt nem adott az emelt órajel ; ha ez a kevés vram miatt volt, akkor van értelme ; ha a szűkös ram sávszél miatt, akkor talán kevésbé.

-

Petykemano

veterán

Na, Abu lecsapta a kérdést: az RX 7600XT Navi 33 alapon készül.

"Az AMD inkább kiegészíti a meglévő sorozatát, hiszen a Radeon RX 7600 és 7700 XT között van egy nagyobb űr. Ezt fogja betölteni a Radeon RX 7600 XT, ami a Navi 33-as GPU-t használja. Az XT jelzés nélküli társához viszonyítva a fő különbség a magasabb órajel, illetve a 8 helyett 16 GB-nyi VRAM lesz."

[link] -

Petykemano

veterán

Úgy volt, hogy nem lesz több ASIC.

De talán ez a Cuarzo/Quartz lehet a válasz arra a kérdésre, hogy miből lesz a refresh.

[link]Ezzel együtt nekem azért még nem áll össze, miképp kap majd helyet a piacon az RDNA3 (refresh) és az RDNA4 megmaradt alsóháza.

Ha igazak a pletyók arról, hogy a navi31 marad a legerősebb darab, annak a frissítésével(/javításával?) érdemes lehet kínlódni. A navi33 elvileg olcsó N6-on készül, ha ott tudnak valamit reszelni, azt is megérheti megtartani belépő szintre. Viszont a navi32 és az RDNA4 picit sztem üti egymást. Én Azokat a monolitikus lapkákat pont oda várnám, ahol a navi32 is szerepet kap. -

meteoreső

újonc

válasz

S_x96x_S

#63335

üzenetére

S_x96x_S

#63335

üzenetére

6600XT 6700XT 7600XT a legjobb ajánlatok a piacon jelenleg. 6650 XT csak azért nem pörög mert azt a 10-est már kiadod a 8 és 12 GBos különbségre.

A7600 is ezért nem ANNYIRA pörög Olcsó 7600 12 GB kártya kellene Full HDre TVre tökéletes lenne.

De ez is megteszi csakhát az ára... ??? -

S_x96x_S

addikt

válasz

Raymond

#63334

üzenetére

Raymond

#63334

üzenetére

> Mindenki VRAM parti,

akkor ezzel[1] se lesz gond .. mert lesznek rá vevők ..[1] Gigabyte leak lists unreleased AMD Radeon RX 7600 XT with 16GB of memory

-

Raymond

titán

válasz

S_x96x_S

#63333

üzenetére

S_x96x_S

#63333

üzenetére

"most vizsgásztattsz ?"

Egy kerdes volt mert volt egy allitasod. Valsz nem jott most se.

"én jobban VRAM párti vagyok mint te "

Mindenki VRAM parti, de nem kellene magyarazni az alapokat hogy miert nem az egyetlen ami a valosagban szamit. Mondom, foglalkozz picit a temaval es akkor mashogy olvasod a hireket es a cikkeket is amiket belinkeltel. Mert egy csomot nem linkeltel volna olyan kommentarokkal mint amit irtal. Mint pl. most is. Ahogy mar irtam, nem kell hozza ma mar semmi kulonos configuracio es kulon environment setup. Mindharom emlitett eszkozhoz csak letoltesz egy zip-et, kicsomagolod es lefuttatod az ott levo bat vagy sh file-t ami mindent telepit ami kell.

Na jo, megyek tomom meg magam kajaval, BUEK!

-

S_x96x_S

addikt

válasz

Raymond

#63332

üzenetére

Raymond

#63332

üzenetére

>> "én kifejezetten a VRAM igényes feladatokról beszélek"

>Es melyikek ezek szerinted?most vizsgásztattsz ?

vagy szerinted tényleg nem léteznek ilyen feladatok ?![;]](//cdn.rios.hu/dl/s/v1.gif)

de amúgy amitre pl. NVIDIA RTX 4000 SFF való

körülbelül hasonló TFLOPS -uk ...

szerintem a 4060 Ti 16GB fejlesztői gépbe olcsó és tökéletes alternativa ( CUDA -ra )

leszámítva, hogy pár extra feature nincs engedélyezve benne.

Persze a NVIDIA RTX 4000 SFF azért még jobb ...

De majd jönnek a 40 SUPER - ek , és akkor les még több 16GB-os alternativa.zárjuk rövidre, mert szerintem úgyse fogunk sose egyetérteni.

én jobban VRAM párti vagyok mint te ..

(pont)

BUÉK ... -

Raymond

titán

válasz

S_x96x_S

#63331

üzenetére

S_x96x_S

#63331

üzenetére

"én kifejezetten a VRAM igényes feladatokról beszélek"

Es melyikek ezek szerinted? Mert nekem inkabb ugy tunik mar egy ideje hogy nem igazan van (sok?) fogalmad a temarol.

"A sok VRAM nem árt ... jövőállóbbá teszi a konfigot"

De nem mindegy hogy mikor es hogyan. Mert ha oda jutunk hogy a generalashoz mindenkepp kell 16GB VRAM addigra lesznek sokkal gyorsabb kartyak. Per pillanat meg mindig jobb egy gyorsabb 10-11-12GB kartya mint a 4060Ti.

"minél nagyobb a generálandó kép, annál inkább kell a vram"

Igen, de ez nem vegtelen. Lasd tovabb.

"és ki akarna alacsony felbontású képeket ? Nem sokan"

Per pillanat a legjobb modell max 1024x1024 felbontasban van training-elve, tehat ennyi pixel a max amit problemamentesen generalsz (lasd [link]), ergo nincsenek random marhasagok hogy ket fej, ket szemely egymas mellett, negy szem, coneheads, stb.

Lehet kombinalni az X es Y erteket, de a max pixelszam legyen 1048576 alatt es 64-es lepesekben erdemes novelni az ertekeket. Az alltalanosan hasznalt felbontasok ezek:

640 x 1536

768 x 1344

832 x 1216

896 x 1152

1024 x 1024

1152 x 896

1216 x 832

1344 x 768

1536 x 640Lehet persze ezeken kivul mas kombinacio is, de ezek amik az SA alltal is tesztelve voltak.

A magasabb felbontast es reszletesseget nem ugy ered el hogy eleve akkoraban renderelsz hanem a fent latott felbontasu kep upscale, refine, hiresfix alltali felskalazasaval.

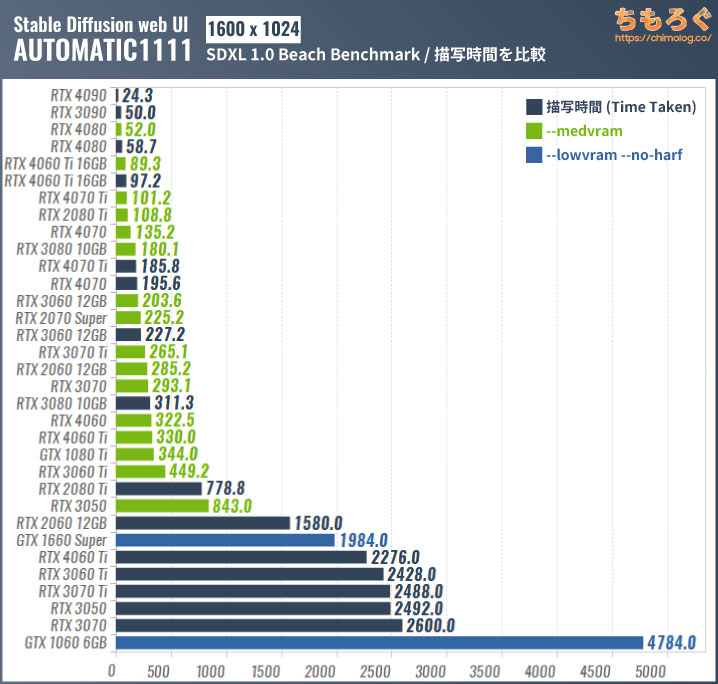

"1600x1024 felett minden átfordul - VRAM igénnyé .."

Senki nem renderel ilyen felbontason, lasd feljebb. Az ilyen anime stilusnal pedig vegkepp felesleges mert nincs reszlet. Ezt megcsinalod normalis felbontason es jobb reszletekkel is. Egyebkent pedig belefutsz a fentebb emlitett artifact problemakba eleg gyakran es erre senki nem vagyik. Csak az idodet (otthon) vagy az idoded es penzed (cloud service) pazarolod.

Eleg melyre kellett turnod hogy azt a cikket/blogot talad, de megintcsak ket dolog jon le az eredmenyekbol:

1) nalam a 2080 a linkelt kepen levo tesztet 254mp alatt vegzi el, tehat ul azzal hogy valamivel 1 perc felett csinal egy kepet ezen a felbontason. Viszont ha megnezed az eredmenyeket tobb problema is feltunik az egyes kartyak eredmenyenel

2) ez meg mindgi A1111 problema ahogy mar irtam. Mas UI nem csinalja ezt, peldaul a ComfyUI ugyanezt 22mp alatt generalja egy 2080-al.Miert nem probalod ki magad? Sokkal tobbet er mint random blog post-okat keresgelni a neten. Minden ami emlitve volt telepitheto macera nelkul otthon is. Az A1111, a Fooocus es a ComfyUI is.

-

S_x96x_S

addikt

válasz

Raymond

#63330

üzenetére

Raymond

#63330

üzenetére

én kifejezetten a VRAM igényes feladatokról beszélek ..

és a jövőben ezekből még több lesz ..Biztos nem optimális mindenkinek ..

de van olyan réteg, akiknek ez az optimális ...A sok VRAM nem árt ... jövőállóbbá teszi a konfigot.

és ez igaz az AMD-re és az nVidiára is ...> a 12GB VRAM-al megy az SDXL alapu modellekkel a 1024x1024

minél nagyobb a generálandó kép, annál inkább kell a vram,

és ki akarna alacsony felbontású képeket ? Nem sokan ..

1600x1024 felett minden átfordul - VRAM igénnyé ..

És ekkor a 4060 Ti 16GB teljesítményben az RTX4080 és a 4070 Ti közé kerül

és ezzel igen jó ár/értéke lesz.

( persze csak olyan tesztekben, amelyeknél a VRAM a szűk keresztmetszet )https://chimolog.co/bto-gpu-stable-diffusion-specs/#16002151024SDXL_10

-

Raymond

titán

válasz

S_x96x_S

#63329

üzenetére

S_x96x_S

#63329

üzenetére

Ez egy eleg kemeny marketing video ami megprobalja a silany ar/ertek aranyal biro 4060Ti 16GB kartyat jobb fenyben beallitani.

Nem tudom mit csinaltak ott igazabol, de egy sima 2080 8GB is jobb eredmenyeket er el mint amit ott a 3080 10GB-nal mutatnak. Peldaul:

Generate - 34.9

1024x1024 + LoRA - 34.3

Upscale 2x - 8.2

Upscale 4x - 14.5Ugyanazokkal a beallitasokkal amiket hasznaltak (a videoban latni amit a szoveges blog-ba nem raktak be).

A generalas maga egyebkent 10-15mp attol fuggoen hogy a 20 Step auto vagy a 30 Step hajo peldarol van szo, a tobbi 20mp a housekeeping. Az utobbi az ami csak 1-3mp ha van boven VRAM, ami normalis beallitasokkal meg az A1111-ben sem igazan problema egy 3080 10GB-nal (

--medvram-sdxl --xformers). Ha nem a memoriazabalo A1111-et hasznalod akkor pedig vegkepp semmi gond mert boven a 10GB alatt vagy, nem veletlen hogy feltort a ComfyUI az utobbi honapokban, eleve kevesebb a VRAM igenye es raadasul mivel az egyik SA alkalmazott fejleszti igy elsonek jonnek ra az ujitasok. Plusz az a management ami olyan sokaig tart az A1111-nel a 8GB kartyan is sokkal kevesebb idot igenyel.Vagy ott van a Fooocus, ami a 30 Step hajos peldat szinten kikopi magabol 23mp alatt amibol a generalas ugyanugy 15mp mert az fix, de a housekeeping viszont csak 8mp es nem 25 mint az A1111-nel.

A 4060Ti pedig meg mindig nem igazan jo az ara miatt mert azert a 455-460 kezdoarral eleg draga. Otthonra jobb lehet egy 3060 12GB ami boltbol most 280-300EUR hasznaltan pedig 200-220EUR es a 12GB VRAM-al megy az SDXL alapu modellekkel a 1024x1024 generalas. Ha csak erre kell egy kartya akkor ott tud az ember sporolni (sot, 2 darab hasznalt meg olcsobb mint egy darab uj 4060Ti 16GB es gyorsabban generalja a kepeket a vegen

). Ha pedig masra is kell a kartya (jatekok pl. mert ez az egyetlen) akkor pedig inkabb a 4070 egy 100assal dragabban. Ami szinten nem rossz meg azok a 2080Ti kartyak amik most 250-280EUR kozott mennek. Az igazi viszont a 3090 amik voltak mar 450-500 kozott is, de alltalaban inkabb 500-600 kozott vannak. De ott van VRAM, savszel es compute is, meg 600-ert is a legjobb ar/teljesitmenyu kartya.

). Ha pedig masra is kell a kartya (jatekok pl. mert ez az egyetlen) akkor pedig inkabb a 4070 egy 100assal dragabban. Ami szinten nem rossz meg azok a 2080Ti kartyak amik most 250-280EUR kozott mennek. Az igazi viszont a 3090 amik voltak mar 450-500 kozott is, de alltalaban inkabb 500-600 kozott vannak. De ott van VRAM, savszel es compute is, meg 600-ert is a legjobb ar/teljesitmenyu kartya.Training-et elfelejtheted egyebkent is ezekkel, mindegy hogy 16GB vagy 12GB a kartya, ott tobb ertelme van a felhoben berelni kapacitast arra a par orara vagy napra, otthon ugyanaz hetekig futna.

-

S_x96x_S

addikt

válasz

Petykemano

#63328

üzenetére

Petykemano

#63328

üzenetére

> 16 GB ... hogy annak lenne-e a vásárlónak gyakorlati haszna?

16 GB inkább

- a felhasználóknak ( kreativ, renderelés, mérnöki szimuláció )

- és az AI/ML/Data fejlesztőknek

lehet vonzóJelenleg sokszor a VRAM hiánya a legnagyobb probléma,

és ez néha sokkal fontosabb minthogy lassabban fut pár dolog.Mert ha az AMD tényleg komolyan veszi az AI-t ( és kénytelen .. )

akkor kell olcsó fejlesztői ( vagy játszó ) platform.Vagyis az RTX 4060 TI 16 GB - alternatívája lesz.

"GeForce RTX 4060 Ti 16G - The Best Value Graphics Card for Stable Diffusion XL"

https://www.msi.com/blog/stable-diffusion-xl-best-value-rtx-graphics-card

-

Petykemano

veterán

válasz

Komplikato

#63327

üzenetére

Komplikato

#63327

üzenetére

Több lehetőség is kínálkozik, hogy ne a szokásos lehangoló eredményt kapjuk, amit várunk :

a) navi33 N6 refresh

b) navi32 2MCD-vel.

c) navi33 N5/N4 portVajon Érdemes reménykedni?

Persze nem zárom ki, hogy tényleg csak annyi, higy rátesznek 16GB-ot a navi33-ra, de továbbra is kérdésként lebeg előttem, hogy annak lenne-e a vásárlónak gyakorlati haszna?

-

Komplikato

veterán

válasz

Petykemano

#63325

üzenetére

Petykemano

#63325

üzenetére

Csak becsúszott egy infó bizonyos Gigabyte féle 7600XT 16GB kártyákról.

-

Alogonomus

őstag

válasz

Petykemano

#63325

üzenetére

Petykemano

#63325

üzenetére

A 3 és 4 MCD-s Navi 32-es kártyák iránt jelentős a kereslet, ráadásul az igazán drága elemük az az 5 nm-es GCD, amiből ugyanúgy egy darabot igényelne a mondjuk $300-os Navi 32-es 7600 XT, mint az $450-os 7700 XT, vagy $520-os 7800 XT. Ráadásul a hírek szerint az 5 nm kihozatali aránya nagyon jó, így maximum a 7700 XT szintjéig kellhet visszavágni a Navi 32-es GCD-t.

Amennyiben tényleg nem 16 GB-os Navi 33 lesz, akkor valóban a 12 GB-os Navi 32-es verzió lenne a logikus 192 bites busszal a 4060 Ti teljesítményszintjére, de a 1080p-hez sokkal jobban passzoló 12 GB-os kapacitással. Persze továbbra is kétlem, hogy lenne érdemi mennyiségű 7700 XT szintjét sem elérő Navi 32-es GCD, ahogy a Navi 31-ből is alig volt olyan, ami "csak" a GRE szintjéhez volt jó. Arányaiban a többi nagyobb 7900-ashoz képest nem is találunk sok 7900 GRE-t.

-

Petykemano

veterán

Én is úgy látom, hogy a kártya értékét érdemben nem növelné, mert ahová a 8GB nem elég, ott a lapka maga is elvérezne. Ezért mondtam, hogy porhintés. De attól még meg lehet lépni. Nem tudom, hogy most ilyen helyzet van-e, de Abu szokott olyan eseteket említeni, amikor kapacitás-váltás megy végbe a memóriapiacon és a kisebb kapacitású memórialapka szinte semmivel nem olcsóbb, mint a nagyobb kapacitású, így érdemesebb utóbbit alkalmazni.

A magam részéről valószínűbbnek tartok egy 2MCD-vel szerelt Navi32-t 7600XT-ként, ami a Navi32 lapkákkal kissé pazarlónak tűnik, de az utóbbi időben kiadott GRE elnevezésű kártyák arra utalnak, hogy ezt az AMD elfogadhatónak tartja. Mivel a Navi32 lapkák elég későn kerültek forgalomba és most már elvileg csak néhány negyedév választ el minket az RDNA4 lapkáktól, így nem tartom elképzelhetetlennek, hogy az AMD igyekszik kiszórni a "felesleget".

-

válasz

Petykemano

#63323

üzenetére

Petykemano

#63323

üzenetére

Minek tennének rá 16 GB vramot? szinte kizártnak tartom.

-

Petykemano

veterán

válasz

Alogonomus

#63322

üzenetére

Alogonomus

#63322

üzenetére

Igaz, a válogatott lapkákhoz illesztett 16GB még egy lehetséges megfejtés. Bár eléggé porhintés...

-

Alogonomus

őstag

válasz

Petykemano

#63321

üzenetére

Petykemano

#63321

üzenetére

Hihetőnek tűnik az a spekuláció, hogy a 7600 XT ugyanúgy csak egy "duplázott" 16 GB-os modell lesz, ahogy az történt a 4060 Ti esetén. Vagyis akár pont ugyanazt a Navi 33-as chipet tartalmazhatja, csak már 16 GB kerül a kártyára. Esetleg "felsőpolcos" Navi 33 kerül rá, ami pár százalékkal jobb teljesítményre képes, hogy a teszteken pár fps plusz is jelentkezzen a 7600-hoz képest.

-

Petykemano

veterán

válasz

Komplikato

#63318

üzenetére

Komplikato

#63318

üzenetére

Fura pletykák.

A 7600X-et és a 7700-at el tudnám helyezni az árlétrán. De a 7700X és a 7800X között jelenleg is annyira kicsi az árkülönbözet, hogy a 7800-at szerintem nehéz lenne a kettő közé beilleszteni. Legalábbis anélkül, hogy árban ne a 7700X helyére kerüljön lefelé tolva azt.Ha ez így történne, akkor a 7700-nak viszont nagyjából árban és teljesítményben oda - utóbbioban picivel előbbre - kellene érkeznie, ahol és 6750XT tartózkodik, csak kedvezőbb fogyasztással. Mondjuk 200W TDP, amit mondjuk kiemelkedően jónak még nem lehetne nevezni.

Ami technikai kérdés még maradt az az, hogy vajon a 7600XT-et miből állítják elő? Nem hiszem, hogy a Navi33-ban lenne még kraft. Ami nem hagy más lehetőséget, mint hogy Navi32 lapkákból készülhet 2 esetleg 3 MCD-vel.

-

válasz

Komplikato

#63318

üzenetére

Komplikato

#63318

üzenetére

7700 és 7800 több elentétes állítás szerint nem lesz már az RDNA4 elött. Ez a 7600XT lesz állítólag az utolsó kiadott RDNA3 kártya.

Jövő őszig ez a portfólió várható a pletykák szerint.

DE közben vannak ellenkező hírek is. Én azt,akitől olvastam, -hogy nem lesz más SKU- elég megbízható forásnak tartom. -

PuMbA

titán

Ahogy gondoltam, a RIS nem hozza vissza a TAA által már legyalult részleteket. RIP éles és részletes képminőségű játékok 1958 - ~2020. A poén az, hogy még konzolokon is panaszkodtak, hogy az előző WRC képe simán élesebb volt. Végleg beléptünk egy új korba, ahol a grafika sokat fejlődött, de beáldozták érte az éles és hibamentes képet.

Lacccca87: Textúrákkal semmi baj sincs, nagyon éles textúrák vannak a játékokban, csak elmossák a jelenleg használt grafikai megoldások.

-

Lacccca87

addikt

Én ezt már anno mondtam még amikor az UT 3 kijött és akkor még hírből se voltak ilyen felskálázók meg stb... Rengeteg maszatoló efektet tettek a játékokba ami gyors mozgásnál még jól is mutatott de amikor álló képről beszéltünk vagy csak közelebbről megnéztem egy texturát...hát maradjunk annyiba hogy elszomorító volt az eredmény (1080p-ről beszélünk, és egyes esetekbe max textura részletesség).

Anno sokan próbálták ezt magyarázni hogy ez így jó, meg pl ahogy abu is nyomja a félmegoldásokat. De ez így semmi, komolyan 2023-ban gondot okoz éles jó minőségű textúrákat használni. Régebben még érthető volt mert nem fért bele a VRam-ba és voltak is trükkök (pont UT ban CPU által számolt texturák, ugye a hátránya az volt ha kevés a proci akkor látványos volt amikor később tudta csak bedolgozni.) de most simán mehetne, de helyette kapjuk a minden szeméttel megkent postprocesselt képet, ami mellett meg csodálkozik a paraszt hogy mekkora a késleltetés mert még át kel küldeni vagy 47 filteren mire megkapod a végleges képet. Szánalom. Ahogy a mostani felskálázssal is megy az is. Nem más az egész cska költség megtakarítás a fejlesztők részéről. -

PuMbA

titán

Ok, megnézem. Nekem a baljós dolog az az, hogy például 1080p TAA-n a 100m-re lévő kerítés egyáltalán nem látszik, míg a 720p-s FSR-es képen simán kivehető. Na most a RIS hogy fogja az egyáltalán nem látszó részleteket, tehát például a kerítést rárakni a képre utólag, miközben a TAA-nak "hála" az már egy nem létező dolog.

Legvégső esetben azt teszem, amit az RDR2-nél csináltam, hogy virtuális szuperfelbontás és 1440p-n már hagy annyi részletet a TAA, hogy 1080p-n élesen néz ki. Ebben csak az a sajnálatos, hogy 1080p-re 1440p VGA-t kell venni ezen csodálatos megoldások miatt

-

Abu85

HÁZIGAZDA

A DLSS és az FSR is ugyanúgy elmos, csak azért nem érzékelhető, mert van rájuk beépítve élesítő post process. Már, ha a fejlesztők beépítik, de általában igen. Ha a TAA-ra nincs, akkor irány a Radeon vezérlőpult, és erre van a Radeon Image Sharpening. Ez ráadásul az egyetlen driverből injektálható renszer, ami konkrétan kontraszt adaptív, tehát nem fogja elrontani a kontrasztot az aktiválása.

A másik lehetőség a ReShade-féle CAS, de annál jobb az AMD-féle RIS, mert gyorsabban csinálja meg ugyanazt. Viszont, ha nincs Radeonod, akkor a ReShade-féle CAS nagyjából ugyanazt tudja, mint a RIS, csak némileg lassabban. Ha esetleg lenne a játékba beépítve CAS, akkor azt célszerű használni.

Az élesítőnél igazából az a lényeg, hogy kontraszt adaptív legyen, illetve elliptikus mintával dolgozzon, legalább 12-tap kernellel. Ha ez a két kritérium megvan, akkor általában jó az eredmény. A négyszöges mintájú rendszereket kerüld, mert ott nem lesz elég minta a jó eredményhez. -

PuMbA

titán

Tegnap játszottam az EA Sports WRC-vel megint és ez vetette velem észre, hogy micsoda nagy gond manapság már az az alap dolog, hogy egy játékban éles és hibamentes képet kapj.

Ebben a játékban ugye az Unreal Engine 4 beépített TAA-ja van, ami 1080p-ben nagyon mossa a képet vagy mivel AMD-m van FSR, ami viszont nagyon szellemképesedik. Az autóban a belső nézetben az ablaktörlő után 3 darab szellem kontúr marad, ami borzasztóan zavaró és nem lehet így vezetni. Ha nem használok AA-t, akkor pedig az egész kép zizeg.

Jó lenne egy értelmezhető megoldás is...

-

S_x96x_S

addikt

AMD’s CDNA 3 Compute Architecture

https://chipsandcheese.com/2023/12/17/amds-cdna-3-compute-architecture/

"CDNA 3’s whitepaper says that “the greatest generational changes in the AMD CDNA 3 architecture lie in the memory hierarchy” and I would have to agree. While AMD improved the Compute Unit’s low precision math capabilities compared to CDNA 2, the real improvement was the addition of the Infinity Cache." -

Devid_81

félisten

válasz

Alogonomus

#63306

üzenetére

Alogonomus

#63306

üzenetére

Azt, hogy nem lesz hivatalos MSRP aruk siman elkepzelhetonek tartom

-

Alogonomus

őstag

válasz

Devid_81

#63305

üzenetére

Devid_81

#63305

üzenetére

Na azt mondjuk én sem hiszem, hogy a jelenlegi már csökkentett bolti árakhoz képest is még alacsonyabb hivatalos áron küldenék csatába a Super kártyákat.

Az persze elképzelhető, hogy nem lesz deklarált hivatalos áruk. Arra láttunk már többször is példát a közelmúltból. -

Devid_81

félisten

válasz

Alogonomus

#63304

üzenetére

Alogonomus

#63304

üzenetére

Hogy a Super olcsobb lesz arra nem mernek sok penzt felrakni.

Viszont tok jo lenne ha igazad lenne

-

Alogonomus

őstag

válasz

Hellwhatever

#63300

üzenetére

Hellwhatever

#63300

üzenetére

Szerintem ne számíts egy asztali RDNA3-as refresh-re. Az RDNA3.5 a laptop piacra érkezik.

Az RDNA4 kártyák jövő ősszel már érkeznek, jelenleg pedig az RDNA2-es és RDNA3-as eladások annyira kedvezőek, hogy nem csak a pénzügyi jelentésében mutatott rá az AMD a kártyaeladások felfutására, de a JPR grafikon és a sokszor idézett német DIY kereskedés számai is azt mutatják, hogy abszolút az AMD van lendületben az asztali kártyák piacán. Ezért is kényszerül az Nvidia kiadni a 3 Super kártyát január 17 és 31 között az eredeti non-Super kártyákénál alacsonyabb MSRP mellett, de erősebb paraméterekkel.

Amennyiben a Super kártyák megfordítanák a piaci viszonyokat, akkor is inkább fog az AMD árat csökkenteni a jelenlegi kártyáira vonatkozóan, minthogy februártól az RDNA4 érkezéséig hátralevő mondjuk 7 hónapra bevezessen egy úgy fél-generációt, miközben az AMD egyébként is deklaráltan a mobil szegmensre akar fókuszálni az elkövetkező hónapokban. -

S_x96x_S

addikt

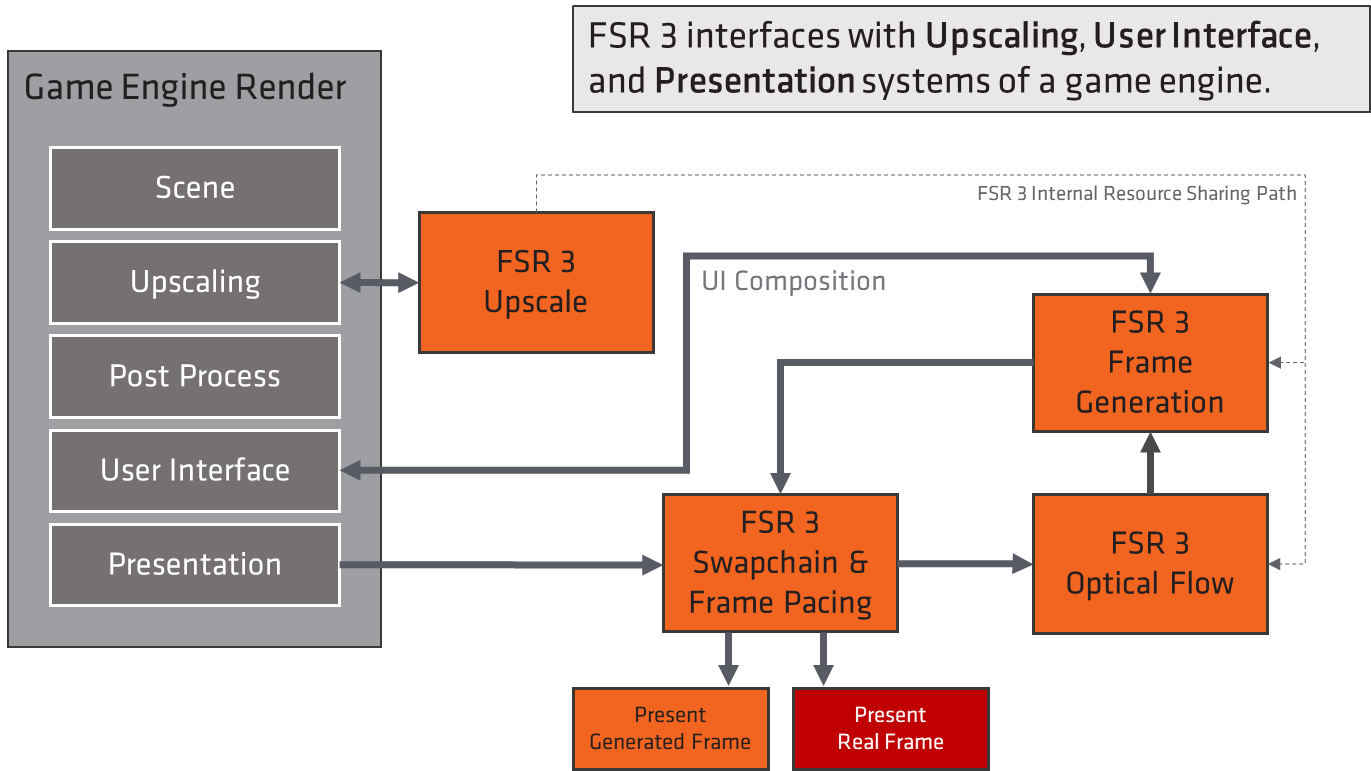

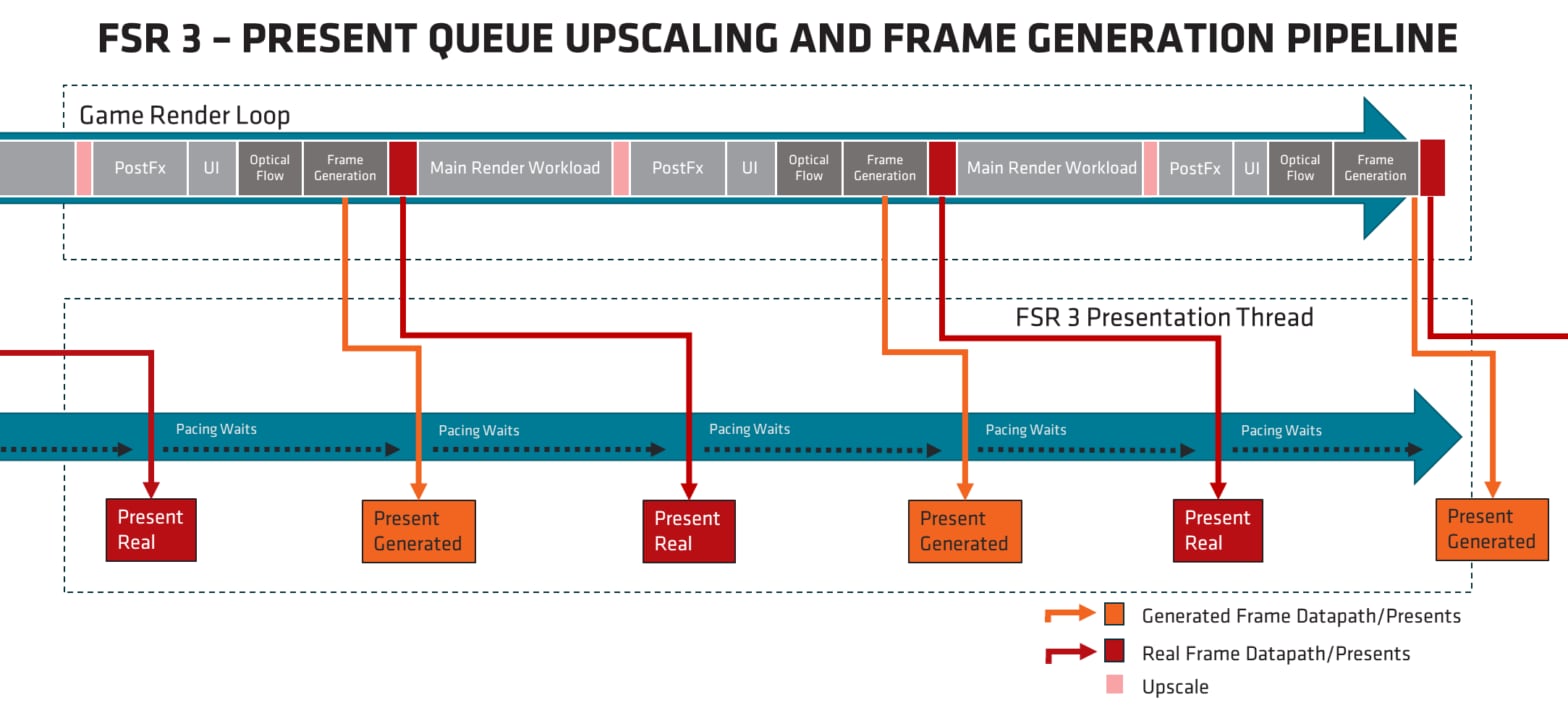

FSR

https://gpuopen.com/fidelityfx-super-resolution-3/

https://github.com/GPUOpen-LibrariesAndSDKs/FidelityFX-SDK/releases/tag/fsr3-v3.0.3Download the latest version – v3.0.3

AMD FSR 3 API for integration.

Currently released as a special branch of AMD FidelityFX SDK 1.0.

- Detailed information about this release in our FSR 3 release blog.

API documentation including quick start checklist.

- We strongly recommend you consult this checklist to ensure the best upscaling quality!

Full C++ and HLSL source provided via a library.

FSR 3 DirectX 12 sample.

This package includes source of all FidelityFX SDK 1.0 samples, but only the FSR 3 executable is pre-built.

-

PuMbA

titán

Megkaptuk az újonnan az AMD driverbe belerakott hardveres GPU ütemezés (HAGS) okát: az AMD a hivatalosan kiadott FSR3-hoz ajánlja a bekapcsolását

Ez a kiváltság ugye csak az RDNA3 tulajdonosoké.

Ez a kiváltság ugye csak az RDNA3 tulajdonosoké.

Új hozzászólás Aktív témák

A topikban az OFF és minden egyéb, nem a témához kapcsolódó hozzászólás gyártása TILOS!

MIELŐTT LINKELNÉL VAGY KÉRDEZNÉL, MINDIG OLVASS KICSIT VISSZA!!

A topik témája:

Az AMD éppen érkező, vagy jövőbeni új grafikus processzorainak kivesézése, lehetőleg minél inkább szakmai keretek között maradva. Architektúra, esélylatolgatás, érdekességek, spekulációk, stb.

- Azonnali VGA-s kérdések órája

- Kazy Computers - Fehérvár - Megbízható?

- Elektromos autók - motorok

- RAM topik

- Autós topik

- Mibe tegyem a megtakarításaimat?

- Milyen TV-t vegyek?

- OFF TOPIC 44 - Te mondd, hogy offtopic, a te hangod mélyebb!

- Milyen légkondit a lakásba?

- 5.1, 7.1 és gamer fejhallgatók

- További aktív témák...

- Targus Universal USB 3.0 DV1K-2K Compact docking station (DisplayLink)

- Bomba ár! Lenovo ThinkPad X270 - i5-6G I 8GB I 256GB SSD I 12,5" FHD I HDMI I Cam I W10 I Garancia!

- Samsung Galaxy Watch 5 /12 Hó Garanciával

- Bomba ár! HP ProBook 430 G8 - i5-1135G7 I 16GB I 256GB SSD I HDMI I 13,3" FHD I Cam I W11 I Gari!

- BESZÁMÍTÁS! ASUS TURBO RTX 3090 24GB GDDR6X videokártya garanciával hibátlan működéssel

Állásajánlatok

Cég: Liszt Ferenc Zeneművészeti Egyetem

Város: Budapest

Cég: PCMENTOR SZERVIZ KFT.

Város: Budapest

PC-n PS5 grafikai beállításokkal pontosan megkapod vele a PS5 teljesítményét.

PC-n PS5 grafikai beállításokkal pontosan megkapod vele a PS5 teljesítményét.

Népkártya ide, vagy oda,

Népkártya ide, vagy oda,  Nincs annyi időm hogy elmerüljek egy-egy Single-player címben.

Nincs annyi időm hogy elmerüljek egy-egy Single-player címben.

![;]](http://cdn.rios.hu/dl/s/v1.gif)