Hirdetés

- Hogy is néznek ki a gépeink?

- Házi barkács, gányolás, tákolás, megdöbbentő gépek!

- AMD Ryzen 9 / 7 / 5 / 3 5***(X) "Zen 3" (AM4)

- Kompakt vízhűtés

- AMD Navi Radeon™ RX 9xxx sorozat

- Apple MacBook

- Milyen asztali (teljes vagy fél-) gépet vegyek?

- Házimozi haladó szinten

- Bluetooth hangszórók

- Intel Core i5 / i7 / i9 "Alder Lake-Raptor Lake/Refresh" (LGA1700)

-

PROHARDVER!

A legtöbb kérdésre (igen, talán arra is amit éppen feltenni készülsz) már jó eséllyel megtalálható a válasz valahol a topikban. Mielőtt írnál, lapozz vagy tekerj kicsit visszább, és/vagy használd bátran a keresőt a kérdésed kulcsszavaival!

Új hozzászólás Aktív témák

-

Abu85

HÁZIGAZDA

Mindenkinek van. A Synopsys régóta kínál. Egy éve elég modern megoldást is a DSO.ai opcióval, ami kompatibilis a legtöbb EDA eszközzel. Ez egyáltalán nem újdonság, nem értem, hogy miért beszélünk úgy róla, hogy még nem volt ilyen soha. Ezt már egy ideje alkalmazza kb. mindenki, aki top lapkákat tervez.

Ahogy nézem a Cadence is kínál ilyen platformot.A Synopsys és a Cadence eszközei azok, amiket használnak chiptervezésre. Még az NVIDIA sem használ mást, sosem utaztak ilyen területen, így megveszik azoktól a rendszert, akik értenek hozzá.

-

b.

félisten

Ironizáltam főni.

Valószínűleg piacvezető DGPU gyártókánt és a legnagyobb ML GPU gyártóként van erre megoldásuk és nincsenek elmaradva ezen a téren.

Bill Dally ha azt mondja hogy elég úttörő és egyedülálló az eszközük a gyártás átevezéshez az AI segítségével és pár hónapra lerövidíthető akkor ez így is van. -

Abu85

HÁZIGAZDA

Kétlem, hogy az NVIDIA ennyire le lenne maradva, inkább csak most beszélnek róla publikusan. De lassan 15 éve általános a gépi tervezés, nagyjából 10 éve a GPGPU-s, és ezen belül pedig már három éve általánosan beszivárgott az gépi tanulással történő tervezés is.

A piacon lévő legújabb hardvereket már bőven így tervezték. De sok haszna amúgy nincs, mert a kritikus áramkörök tekintetében még mindig sokkal rosszabb a gép, mint az ember. Viszont egy csomó áramkörre meg megéri használni, mert tranzisztorban ugyan szarabb lesz, de időben spórolsz, és nem veszítesz sokat fogyasztásban.

-

b.

félisten

az Nvcellről [link]2021 Decemberében ben jelent meg erről az első hivatalos tanulmány és 5 napja beszélt erről Bill Dally. [link]

Az hogy elötte voltak már erről infók (hát a PH-n biztos nem) tájékoztatások a technológia fejlesztéséről az nem ugyan az, hogy hivatalosan egy érkező gamer GPU dizájnál használjak már.

Az Ai-t úgy általában persze biztos régebb óta használják tervezésre. -

Abu85

HÁZIGAZDA

Egy ilyen szintű újságnak tisztában kellene lennie azzal, hogy melyik pletyka a hülyeség.

Nem akarlak lelombozni téged, de már lassan három éve AI segítséggel terveznek a cégek. Ebben semmi újdonság nincs. A kritikus részeket pedig mindig manuálisan tervezik, mert a gép ezekben szar.

#37688 Petykemano : Nincs sok értelme a monolitikus dizájnnak, ha van chiplet konstrukciód rá.

#37687 Isobutane : Nem, mert itt erősen más irányba történnek a fejlesztések. Az NV specifikus áramköröket rak a lapkába, mint a Tensor feldolgozó, és ezeket nagyon erősíti. Ezzel szemben az AMD sokkal inkább arra költi a tranzisztorokat, hogy fogyasztást spóroljon meg a cache-dizájnnal.

-

b.

félisten

Úgy néz ki mégis igazak voltak a szivárgások anno. [link]

-

#94257664

törölt tag

válasz

#94257664

#37690

üzenetére

#94257664

#37690

üzenetére

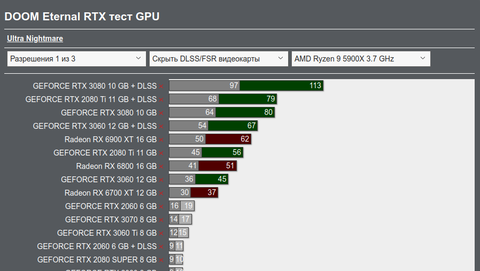

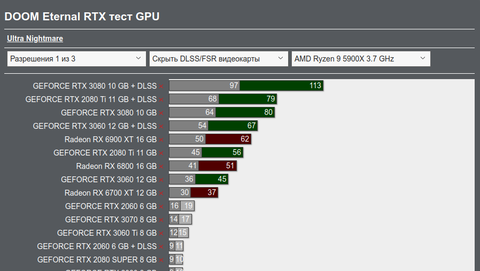

ui: hasonló "anomália" nekem is kijött Doom Eternal-ban., gyakorlatilag 1440p felett muszáj a 10-12GB VRAM, viszont ha levszi az ember a textúra részletességet picit, hogy beleférjen a VRAM-ba akkor már egy 3070 szintű cuccal is tök jól futnak a dolgok még magas felbontásban is, szóval nekem pl. nettó felesleges lenne még a 4K OLED-hez is egy 3070-nél durvább kari, remélem a next-genben nem spórolják le a VRAM-ot a 3070 tier kártyáról.

-

#94257664

törölt tag

Remélem kihoznak egy olyan kártyát ami jó lesz egy "4K budget" cuccnak. Jelenleg nekem az RTX 3070 is bőven elég lenne, de olyan szituációkban, ahol 4K-ban telemegy a VRAM, eléggé lemarad a 6700 XT-hez képest és akadni is kezd. Viszont a Raytracing/DLSS oldala meg sokkal jobb bizonyos játékokban. Remélem az RTX 4050 / TI / RTX 4060 vonal hozza ezt a szintet - legalább 12GB VRAM és 3070 szintű raszter / RT teljesítmény.

-

b.

félisten

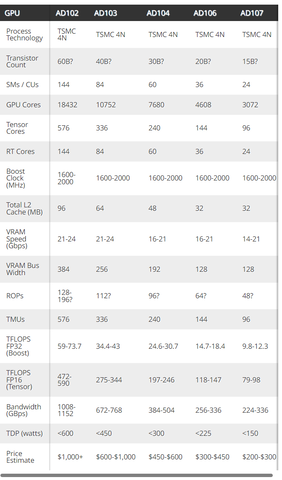

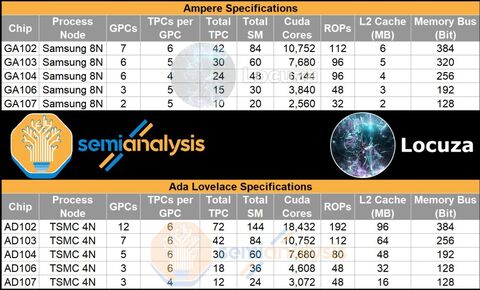

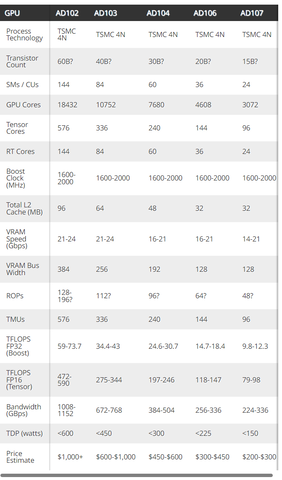

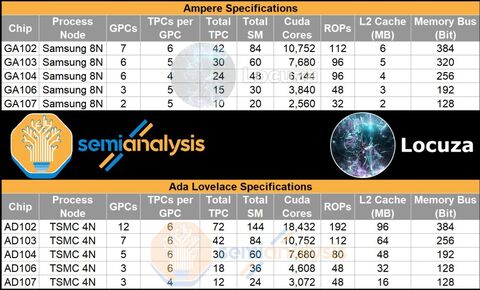

A Tom's táblázata nem bullshit hisz nem azt mondják, hogy ez lesz az Ada , hanem hogy összeszedték táblázatban az eddigi pletykákat és azt összefoglalva kiközölték.

Én valószínűnek tartom, hogy 5 nm-n jön és jön majd egy refresh/ Super majd később kisebb nm-n említve a tegnapi AI tervezést amivel egyszerűbb a folyamat. -

Abu85

HÁZIGAZDA

válasz

GeryFlash

#37681

üzenetére

GeryFlash

#37681

üzenetére

Itt a gyártási költség a nagy probléma. Úgy számolj, hogy 5 nm-en kétszer drágább ugyanaz a lapka, mintha kihoznád 6 nm-en. Ez nagyon komoly probléma, és emiatt csinálja az AMD az egyes chipleteket 6 nm-en. Ugyanez az oka annak, hogy a Navi 33-nál a compute chiplet is 6 nm-en jön. Ez lesz egy 200 watt körüli fogyasztású fejlesztés.

A Tom's Hardware táblázata egy vaskalapos bullshit. Eleve a 4 nm az 5 nm-nél is drágább, és kapacitásban kb. az 5 nm-es kapacitás 5%-át, ha kiteszi. Ezen belül a 4 nm-ből a P vagy az X verzió az, amire normális GPU-kat lehet tervezni. A P-n még idén megkezdődik a kísérleti gyártás, és ezt használja Hopper, de ugye itt számításba kell venni, hogy a tömeggyártás csak a következő évben kezdődik meg. Az X esetében még a kísérleti gyártás is 2023-ban kezdődik, és a tömeggyártás leghamarabb a jövő év végén esedékes.

Mindemellett senki se számítson 500 dollár alatti 4 vagy 5 nm-en készülő új kártyákra. Egyszerűen a waferköltség annyira, de annyira magas, hogy nem fér bele. A Navi 33 pont azért marad 6 nm-en, hogy meg tudja támadni az 500 dollár alatti árszintet, ha erre szükség van. Ha 5 nm-en készülne legalább a compute mag, akkor erre a Navi 33 se lenne képes, pedig az a fejlesztés dizájnban egy 128 bites motyó, tehát a rendszer komplexitása valahol a 6600 XT és 6700 XT között van, a teljesítménye pedig 6800 XT és 6900 XT környéki. Egyszerűen még egy ilyen picire tervezett dizájnnál is olyan nagy költség lenne az 5 nm-es waferár, hogy nem fér bele a normális árcédula. Ez meglátszik a fogyasztáson is. A Navi 33 200 watt környéki fogyasztást kínál, mert az a fő célja, hogy a teljesítményt tegye elérhetővé. Az NV-nek a legkisebb 5 nm-es fejlesztése is 300 watt fölött fogyaszt, mert ott az új node ára annyira extrém, hogy muszáj mögé rakni egy komoly teljesítményt, hogy legitimáld vele a 700-800 dolláros árat, amit egy 256 bites dizájnnal reálisan lehet hozni.

Ezt a problémát most nagyon sok pletykagyáros nem érti meg, és még mindig azt hiszik, hogy itt lesznek olcsó új generációs VGA-k.#37682 Petykemano : Nincs elérhető 4 nm-es eljárás, ami nem kísérleti lenne. Ezért is kicsi most a kapacitás. Mint írtam, egy GPU-nál N4P-re van szükség minimum. Ez csak jövőre kerül tömeggyártásba. Az N4X leghamarabb jövő év végén, de inkább 2024-ben. Amíg egy node nem kerül tömeggyártásba, addig csak kis kapacitással érhető el.

Jelenleg a 4 nm, nem teszi ki az 5 nm-es kapacitás 5%-át sem. Ki az a hülye, akik kihoz rá egy nagy mennyiségben készülő fejlesztést? A Hopper az azért 4 nm-es, mert kb. pite mennyiségben készül, annak reális, ha kiadják kísérleti gyártás szintjén, mert annyit úgy sem rendel belőle a piac, hogy kifogyjon. Eleve csak a szerverpiac egy picike, kb. fél százalékát tudja célozni a specifikus interfész miatt. Aztán majd jön a szabványos interfésszel, amikor beindul a tömeggyártás 4 nm-en. A Zen 4 chiplet a Hopperhez viszonyítva egy masszív tömegtermék, aminek milliószor nagyobb a piaca, így jóval több lapkát is kell gyártani belőle. -

GeryFlash

veterán

Ne is mondd... A 8454. processzorhuto, RGB-s RAM, gamer router es egyeb full erdektelen dolog, lassan heti 2-3 olyan hir van amire kattintok, az erdemi informacio meg az AMD, NVIDIA GPU es AMD/INTEL/NVIDIA 3 forumbol jon kommentekbe

Ertem hogy nem lehet mindenfele spekualciot es hasonlot lehozni, de a technikai cikkek es mindenfele termekbeutatok aranya most mar rohejes aranyban van/

Ertem hogy nem lehet mindenfele spekualciot es hasonlot lehozni, de a technikai cikkek es mindenfele termekbeutatok aranya most mar rohejes aranyban van/ -

b.

félisten

válasz

GeryFlash

#37679

üzenetére

GeryFlash

#37679

üzenetére

Érdemes azért ezt óvatosan kezelni még. Volt a napokban hír hogy az Nvidia már AI val fejleszt és tesztel GPU kat a mérnökök munkájának megsegítésére. Állítólag ez az AI képes 92 % ban önállóan áttervezni egy kész tervezett vagy gyártott GPU dizájnt egy másik csíkszélre vagy gyártásra baromi gyorsan. Ezzel igazából elég mobilis tud enni Nvidia akár csíkszélek között ha gond lenne, gondlom azért fejlesztették ki. Elég durva dolog ha igaz.

[link]Mondjuk ilyen hírek és IT tartalmú cikkek helyett olyan f@szságok jönnek Nvidia hírnek a PH-n hogy milyen jó a MH / s rátája a 3090 Ti-nekmeg hogy újra bejelentették a z elérhetőséget a 3000 szériának. mert Blikket tolunk és ezeket vesszük át a komoly oldalaktól . és kincs a heti 3-4 nvidia fika hír, ilyenek meg mennek a levesbe.

-

Petykemano

veterán

-

GeryFlash

veterán

Tudom, ezert irtam hogy midrangeknek lesz problemajuk. De akkor ezek szerint a felso kategoriaban is lesz node lemaradas, 4 vs 5nm, bar az kevesbe jelentos. Mindenesetre nem all ossze az tortenet, hogy milyen rohadt draga a waffer, ugy tunik most fordul a kor es az Nvidia lesz nagyvonalu es az AMD szarrago.

Mindenesetre ha valoban N4-en jon az AD107 akkor vagy nagyon draga lesz a 4060TI vagy nem igaz hogy nem lehet midrange VGA-t leading edge nodeon gyartani korrekt arral es haszonnal. -

Abu85

HÁZIGAZDA

-

-

b.

félisten

Egy kis összefoglaló Tom's ról az RTX 4000 pletykákról. [link]

-

b.

félisten

[Nvidia Ada Lovelace Leaked Specifications, Die Sizes, Architecture, Cost, And Performance Analysis]

TSMC 4N

Nvidia ügyesen korrigálja a TSMC drágább gyártását e szerint és jobb ár érték arány várható. -

FLATRONW

őstag

válasz

GeryFlash

#37665

üzenetére

GeryFlash

#37665

üzenetére

Az AMD-nek is van egy 375 W-ig eleresztett vizes kártyája, ami nem gyorsabb, mint a sima 3090. Az RDN 2 esetén már felesleges ennél nagyobb fogyasztást engedni, mert már nem hoz teljesítményt.

Ne felejtsük el, hogy az RDN 2 már egy eleve csiszolt 3.generaciós 7nm-re épül, ebből kb. kihozták a maximumot.

Ilyen szempontból nagyon szép, amit az NV kihozott a 8 nm-ből.

Az meg majd kiderül, hogy azonos gyártás mellett mire képesek. Ezek alapján szerintem is az NV lesz a jobb. -

Abu85

HÁZIGAZDA

válasz

huskydog17

#37669

üzenetére

huskydog17

#37669

üzenetére

Ugyanúgy tudsz kérni a Radeonra is -50%-os a Power limitet. És nem esik 50%-kal a teljesítmény, hanem inkább 10-15%-kal.

Minél inkább kicentizel egy hardvert, annál rosszabb lesz az energiahatékonysága. Ez így van évek óta minden gyártónál. Amiért nem élnek ezzel az az, hogy a userek többre értékelik a teljesítményt, mint a teljesítmény/wattot. Ettől függetlenül a user dönthet otthon a működésről. Az AMD-nél erre van gyárilag támogatott funkció (Power limit +/-50%), az NV-nél pedig el lehet érni hasonló hatást 3rd party programokon keresztül bizonyos tuningbeállításokkal.

Ha valaki nagyon teljesítmény/watt párti, akkor lehet kérni még Radeon Chillt is. Azzal konkrétan kilő az energiahatékonyság.

Az NV-nél is elérhető a HiAlgo Chill DirectX 9-re. Ezt az AMD még nem vette le. -

nubreed

veterán

válasz

Raymond

#37671

üzenetére

Raymond

#37671

üzenetére

Csak mindez a magyar webshopokban egyáltalán nem érződik, direkt figyeltem néhányat az elmúlt 2-3 hétben, miközben elvileg tényleg ez a nemzetközi trend, hogy haladunk az MSRP felé, szépen esnek a VGA árak, itthon a legtöbb videokártya (engem csak az nvidia érdekel, így azt néztem) drágább lett most, mint mondjuk 2-3 hete. És olyan szinten drágább, hogy ez nem magyarázható csak az euró erősödésével. Több 10ezer forint drágulásról beszélek akár 2-3 nap alatt is. Tehát a magyar realitás merőben más mint a nemzetközi trendek. Ezt mivel magyarázzuk? Én nem látok bele a hazai nagykerek és webshopok árképzési gyakorlatába, nem tudom mi van a háttérben, maximum csak rosszmájúan feltételezek dolgokat.

-

Raymond

titán

válasz

Komplikato

#37670

üzenetére

Komplikato

#37670

üzenetére

Nem az Arc az ami levinne vagy viszi le az arakat. Honapok ota mennek lefele. Pelda:

MSI GeForce RTX 3060 Ventus 2X 12G OC

Az utolso 6 honap fejlemenye. A december elejei 1000eur csucsrol 4 honap alatt lement az aktualis 449eur szintre es meg mindig mennek lefele az arak.

Vagy a 3070Ti ez ido alatt 1399eur -> 768eur es a tobbi is hasonlo. Igen, ezek meg mindig nem MSRP arak, de messze nem az van ami par honapja vagy hogy ne lenne megfizetheto kartya. A 3050/2060 es 6600 ami az ertelmes teljesitmenyszinten van 350eur korul all most ami nem ugyanaz mint a hosidokben amikor 200-250eur kozott voltak, de nem is az a vilag vege kategoria mint az utobbi honapokban.

-

Komplikato

veterán

Off: Mai Videocardz bejegyzés szerint a teljes Intel Arc desktop széria negyed évvel csúszik. Sokára lesz itt megfizethető gaming kártya.

-

huskydog17

addikt

válasz

GeryFlash

#37665

üzenetére

GeryFlash

#37665

üzenetére

"De, le van maradva."

Hol? Én a cikkben leírtakról beszélek."Ha most az AMD is kihozna ennyi tapasztalatszerzes + node csiszolgatas utan egy 450 wattos szart es leszabalyoznad 300-ra akkor meg az lenne a csucs energiahatekony."

Feltételezés. Ilyen nem történt meg és valószínűleg nem is fog már, de ha mégis jönne egy ilyen az RDNA 3 előtt és lesz arról is független teszt, akkor erre térjünk vissza, addig ennek a feltételezésnek semmi értelme."Ossze kell vetni a 3070TI perfomance es TDP-jet a 6800-zzal, van lemaradas."

De miért azokat vessem össze, amikor a linkelt cikk nem arról szól? Amúgy nem csoda, hiszen a 3070Ti agyon van hajtva, de a többletfogyasztás nagy része a GDDR6X-re váltás miatt történt. A 3070Ti-t amúgy én nem sorolnám a csúcskategóriába, főleg mert itt még a GA104-es GPU van jelen, nem pedig a GA102."De az biztos, hogy ha ugyanolyan nodeon keszulnenek akkor az Nvidia elverne az AMD-t."

Megint csak feltételezés, ez sem biztos. Node kérdésben annyit tudunk, hogy az Ampere generáció a Samsung első generációs 8nm-os node-ján készült, míg az RDNA2-es széria a TSMC optimalizált N7P node-ján, ami tekinthető a 3. generációs 7nm-es TSMC node-nak. Többek között ezért is lesz nagyon érdekes az új generáció mindkét oldalon, hiszen a jelenlegi információk szerint az új RTX gen is TSMC node-on fog készülni.E mellett érdemes figyelembe venni azt a szintén nem elhanyagolható tényt, hogy a két csúcs termék (Radeon RX 6900 vs. Geforce RTX 3090Ti) közül a 300 Wattos 3090Ti-on ugye a GDDR6X VRAM miatt jóval kevesebb fogyasztási keretet kap a GA102, mint a Navi21 az RX6900-on és ugye mindkét kártyán a két GPU teljes kiépítésű, egyik sincs vágva (GA102, Navi21).

A teszt arra mutat rá, hogy a két csúcs termék, illetve csúcs-GPU közül az Ampere nyújtja a jobb energiahatékonyságot, hiszen a teljes kiépítésű GA102 úgy gyorsabb és takarékosabb 300W környékén, mint a teljes értékű Navi21, hogy közben a VRAM miatt kisebb a GPU fogyasztási kerete is, aztán ugye a Navi elvileg jóval fejlettebb node-on készül.

Mindezeket figyelembe véve szerintem a legkisebb mértékben sem túlzás azt mondani, hogy az Ampere semmivel nincs lemaradva energiahatékonyság terén a felső és csúcskategóriában (GA102 vs Navi21).

-

b.

félisten

válasz

GeryFlash

#37665

üzenetére

GeryFlash

#37665

üzenetére

A 3070 Ti egy utólag kihozott SKU... GA104 GPU párja a Navi 22 az eredeti 3070 hez nézve Átlagosan a 3070 5-11 %- kal gyorsabb felbontás függően és szögre annyit vagy kevesebbet eszik mint a 6700 XT. [link]

A 3070 Kb úgy van túlhúzva és mint ha egy 6700XT versenyezné egy 3080 nal... példának jó a 3070Ti és a 3090Ti de nem általános eset és az egész Ampere generációra igaz....

-

Televan74

nagyúr

Lehet itt okosnak lenni, de ha a 3090Ti nem lenne túltolva, nem lenne a leggyorsabb NV kártya és a cég nem kérhetne annyit amennyit kér.

-

válasz

GeryFlash

#37665

üzenetére

GeryFlash

#37665

üzenetére

A 3070 Ti ugyanúgy túl van hajtva, mint az összes többi Ampere kártya. Ahhoz, hogy kiderüljön, melyik architektúra van előnyben, kellene egy méréssorozat mondjuk 25W-os lépésekben. Valószínűleg az AMD kártyák sem a sweet spotjukon üzemelnek, de az NVIDIA-k biztosan alaposan túl vannak tekerve.

-

GeryFlash

veterán

válasz

huskydog17

#37664

üzenetére

huskydog17

#37664

üzenetére

De, le van maradva. Ha most az AMD is kihozna ennyi tapasztalatszerzes + node csiszolgatas utan egy 450 wattos szart es leszabalyoznad 300-ra akkor meg az lenne a csucs energiahatekony. Ossze kell vetni a 3070TI perfomance es TDP-jet a 6800-zzal, van lemaradas. De az biztos, hogy ha ugyanolyan nodeon keszulnenek akkor az Nvidia elverne az AMD-t.

-

huskydog17

addikt

Lenyűgöző, hogy ha az RTX 3090Ti 450 helyett 300 Watton üzemel, teljesen felborul az erősorrend energiahatékonyság téren. Bizony a felső és csúcskategóriában messze a legenergiahatékonyabb kártya a 300 Wattos 3090Ti.

Ebből is nagyon jól látszik, hogy az NVIDIA mennyire brutálisan sz*rrá hajtotta ezt a GPU-t néhány százaléknyi plusz tempóért cserébe. Ha viszont észszerű keretek között (sweet-spot) üzemel, akkor nagyon szép eredményeket hoz.

Nekem ebből az látszik, hogy a Samsung 8nm+Ampere kombináció semmivel sincs lemaradva a TSMC 7nm+RDNA2 kombinációtól energiahatékonyság terén.

A 450 Watthoz készített hűtő pedig a sokkal alacsonyabb hőtermelés miatt még teljesen terhelés esetén is csendben marad. Na ilyen lenne az észszerű out of the box termék. -

b.

félisten

Durva tranzisztorszám várható az AD102 ben. [link]

" Thank everyone. Truth is often in the hands of a few people, but this time the truth should be in the hands of the majority."

teljesen a Vega jut eszembe ..a két cég egymás " útjára" lépett.

ha ez igaz és a másik infó is, ami 600mm2 méretet akkor az remek kihasználása a TSMC által megadott 5 nm ben kihozható maximális tranzisztorsűrűségnek.

-

b.

félisten

[NVidia is making a DESKTOP CPU]

Coreteks, csak csipetnyi sóval

-

b.

félisten

válasz

FragMaster

#37658

üzenetére

FragMaster

#37658

üzenetére

-

b.

félisten

AD102 is NOT a simple "GA112". When GH202 is cancelled, AD102 has integrated Hopper's new technology. Never underrate your Jensen.

[link]Hoppá.

GH202 ből vajon milyen technológiát integráltak?

jah utolsó mondat ment aláírásba .

-

b.

félisten

válasz

T.Peter

#37653

üzenetére

T.Peter

#37653

üzenetére

Nincs ezzel baj. nem rossz az UE5 kinézetre és jönnek vele jó játékok. DE egyéni véleményem az róla a kinézete alapján, hogy ÉN speciel nem látom benne azt a nagy méretű előrelépést amivel 5-8 évig ki tudja szolgálni a nextgen pc. játékokatés ezzel hardvereladást generáljon, ahonnan tekintettem rá elsősorban. Még a techdemókban sem.

Például az összes érkező UE5 játékban, pl Hellblade, Black Myth , Redfall, az a jellegzetes plasztikusság ,a csillogó fényes textúrák. életre kelt műanyagbábu effektusa mozgásban is. AZ mellett persze szép a grafika meg van egy két úgy mond látványos effekt de nincs a részemről semmi extra hogy ez mennyire valósághű vagy extra nagy előrelépés pl a Hellblade 1 hez vagy az öreg God of War ps4 pro verzióhoz.

Amúgy például az ( GOW)nem volt plasztikus és annál éreztem jó párszor azt a wow effektet. amiért mondjuk 2018 ban vettem volna új generációs kártyát

A hangzásról ne is beszéljünk, mert azt mondom hogy az utóbbi pár évben 2-3 játék volt méltó arra, hogy a belépőnek azért nem nevezhető házimozi rendszeremre rá merjem kötni. Az a GOW és a GOW volt God of War és a Gears of War( Gears 5) volt

God of War és a Gears of War( Gears 5) volt

-

T.Peter

őstag

válasz

GeryFlash

#37654

üzenetére

GeryFlash

#37654

üzenetére

Nem hiszem, hogy elvarhato az, hogy egy masik csapat megugorja az epic szintjet. Plusz teljesen mas cellal keszulo tesztekrol van szo. UE 4-gyel a kozeleben sem voltak ennek a szintnek.

Objektiven nezve az order szintjet mar megugrottuk az elozo generacioban is.

Egyebkent jo lenne inkabb azonos studio hasonlo jatekait osszehasonlitani. Pl a Supermassive games jatekait, amikor mar lesz UE 5 alapu jateka is. -

GeryFlash

veterán

-

-

paprobert

őstag

válasz

Petykemano

#37644

üzenetére

Petykemano

#37644

üzenetére

Nagyon jó meglátások.

Az N5 feltételezhetően jó kihozatalára azonban volt példa korábban, a 7nm is rekordot döntött kihozatalt tekintve.

Nem igazán volt a termékek árára hatással, mindössze szűkebb termékbeli szórást, kevesebb selejtet, ezáltal nagyobb termékkontrollt és profitot hozott az AMD-nek.A vásárlók nem igazán látják ennek a pozitívumát, sőt van egy inverz hatása is a jó kihozatalnak.

Tegyük fel, a gyártósorról kevés alacsony frekvenciát bíró CPU jön le, mert kicsi a szórás. Így jóval kisebb eséllyel alakul ki felhalmozás, túlkínálat az alacsonyabb minőségű szilíciumból, nehezen válik dömpingárassá egy alsó-középkategóriás termék. CPU-k esetében az R5 2600 és társai voltak utoljára nagy mennyiségben elérhetőek, a GF-nál gyártva.

7nm-en végletekig kitapasztalva, a Zen3-ból, csak most, másfél évvel később kaptunk valódi mennyiséget a hulladék chipekből.Ha megnő a cég kontrollja a portfólió felett, akkor pont csak annyi lesz kínálva belépőből, hogy ne sok vizet zavarjon a termékskála jobban fizető részén.

Ha viszont rossz a kihozatal, akkor tüzet kell oltania dömping árral, hogy mentse a menthetőt.#37645 b.

Hát igen, a megéri-e kérdést elég sokan feltettük magunknak, vagy az asszonynak, vagy csak a pénztárcánknak. Egyelőre az álláspont az, hogy a grafika nem is annyira fontos.

Ilyen elmebeteg TDP-s VGA-kal pedig egyelőre nem édesgetnek közelebb magukhoz a cégek, még az árak helyreállása után sem. -

T.Peter

őstag

Mit ereznel, gondolnal jelentos elorelepesnek? (ne vedd tamadasnak, szimplan csak erdekel)

A matrix demo melyik resze?

Nem gondolom hogy barmilyet is kene venned csak egy (vagy tobb) jatek miatt, de az a resz a mondat masik fele volt es nekem ugy tunt hogy nem attol teszed fuggove az unreal-rol valo velemenyedet. -

válasz

GeryFlash

#37642

üzenetére

GeryFlash

#37642

üzenetére

Az hogy paprobert kollega a prohardver forumon azt erzi hogy se az Nvidia se az AMD nem erdemli meg ezt a profit ratat mint az elmult 2 evben, es csak ne sporoljanak a gyartaskoltsegen, kulonben se fejlesztettek semmit es az felsokategoriaban ugyanott van a perf/watt mint 6 eve, es ennek az erzesenek hangot is ad attol meg – kapaszkodj meg – senkit nem erdekel.

Legfeljebb pár fórumozót. Annyiért meg már érdemes leírni, hátha lesz belőle értelmes párbeszéd.

-

GeryFlash

veterán

válasz

paprobert

#37643

üzenetére

paprobert

#37643

üzenetére

Ja hat azt elfogadom hogy, tartalek lehet es ,,mehetnenek az olcso kartyak is 5nm-en" akkor is gazdasagos tudna lenni. Csak miert tegye, a 7-->6nm es az ilyen olyan szoftveres optimalizalasok is sokat tudnak hozni, a tobb profit meg jobb.

R&D meg igy is lesz egy szinten, nem kell novelni ahhoz hogy meglevo K+F es half-node jelentette bonuszok hozzak azt hogy 6600XT fogyasztason 3070TI-t kapjunk.Anyagkoltsegben meg valszeg jobbra jon ki a rosszabb de olcsobb node.

Amugy arrol nem beszelve, hogy szerintem alapbol nincs annyi waffer hogy itt mindket ceg 5nm-en gyartson. Jon ugye a Zen4, az iPhoneok meg iden valszeg mind 5nm-n erkeznek szoval az Apple feloli demand is kis mertekben fog csokkenni, ehhez az a 20%os kapacitas noveles lofutty. Ja es meg a Qualcomm is jon N5-re.

Ilyen node demand es erdemi konkurencia mellett azert joesellyel a TSMC szemtelen penzeket kerhet el, lehet igaz is hogy kozel nullszaldos lenne az olcso kartyaknal. -

b.

félisten

válasz

paprobert

#37643

üzenetére

paprobert

#37643

üzenetére

Kíváncsi vagyok mi sül ki ebből a generációból. Eléggé két esélyes lesz ez a szitu.

A magas árhoz magas kereslet is kell ami most szerintem kisebb mértékű lesz.

Ezt főleg a TDP keret emelésre értem és az árazásra, hogy meddig lehet csinálni.

Annyiban téved az Nvidia és az AMD hogy rohadt sok emberhez nem jutott el az Ampere akik már váltottak volna és még mindig Pascalon vagy Turingon vannak, mint én is és eddig nagyjából xx70 vagy xx80 kártyákat vásárolnak.

ha most ráviszik az Amperet kisebb csíkszélre, mondjuk TSMC 7 nm vagy 6 ra vagy Samu 5 re,akkor mi a fenének váltsak egy RTX 2070 ről én egy RTX 4070 re vagy 80 ra mikor egy RTx 3080 majd a használt piacot elöntők közül vagy az új genben mondjuk RTX 4060 néven ott lesz.

Nem fogok venni 4- 600 W fogyasztású szörnyetegeket mikor kisebb fogyasztással is jelentőset léphetek előre, ráadásul a 3080 10-12 GB használtan egy értelmes alternatíva lesz . Engem nem győzött meg az Unreal sem hogy jelentős előrelépés lesz sőt eddig egyetlen olyan új generációs játékot sem láttam PC-n beharangozva amitől én rohannék venni RTX 4080 vagy radeon 7900 kártyát vagy amire nem lenne elég egy 3080 vagy 70....

Szerintem erősen le fog csökkenni most a kereslet a kiadás utáni második évben és így a profit, bármit is akarnak.... -

Petykemano

veterán

válasz

paprobert

#37641

üzenetére

paprobert

#37641

üzenetére

Igen, én is úgy emlékszem, hogy ez a beszélgetés 2-3 évvel ezelőtt pontosan így lezajlott.

Nemrégiben még cikkek is jelentek meg arról, hogy óóó, hát sajna úgy tűnik, hogy a chipleten alapuló CPU designok árának alja $300.

Aztán pár hónappal később magától is lecsökkent $250-re. Ma meg már hivatalosan is $200.Nyilván sok összetevős, de úgy tűnik, hogy az árat leginkább mégiscsak az adott termék kereslet-kínálat viszonyai határozzák meg. Amíg kellett a chipletek nagy része a Milanhoz és/vagy szűkös volt az AMD-nek rendelkezésre álló gyártókapacitás, addig drágán mérte a desktop ryzent, mert az eladható darabszám figyelembevételével így volt maximális a profit.

Az eladható darabszám figyelembevételével profitmaximalizálás - mindig ez a cél. És az eladható darabszámra hatással van az, hogy adott áron mennyire viszik vagy hogy van-e a

kínálatnak kemény korlátja, vagy olyan puha, hogy a termelés mennyiségének csökkenésével vagy növelésével nőnek a költségek.

(csökkentés miatt: az egy példányra eső tervezési költség, növelés miatt pedig az alapanyagköltségek)MLiD-nek volt egy videója arról, hogy miért lehet majd árban elérhető az RDNA3.

Egyrészt azt Te is említetted, hogy az N5 nem új gyártástechnológia, másrészt nagyon remek a selejtarány is. Harmadrészt pedig a chiplet tervezés miatt relatív kicsi, tehát kezelhető méretű és összességében sem nagy lapkák készülnek majd N5-ön. Most csak hasraütök: 2db 200-250mm2-es lapka N5-ön + 1db 250mm-es lapka N6-on. Feltehetnénk a kérdést, hogy nem létezik, hogy összességében ilyen pici lapkákkal dolgozzon az AMD, de valójában összköterjedésben ez így is közel másfélszer nagyobb lenne, mint a Navi21!Az AMD-nek nem csak arra kell gondolni, hogy a $10000-os N7 helyett már $17000-os N5-on kell gyártani (már ha még valóban ilyen költségtételt jelent egy wafer), hanem arra is, hogy mondjuk N5-re tervezni már $0.5-1mrd, amit leghatékonyabban úgy lehet csökkenteni, ha minél több eladott termékre lehet teríteni. Tehát itt is van egy egy optimum függvény, hogy hol adott áron mennyi termék kel el és az a mennyiség akkor mekkora részt tud lefedni a tervezési költségekből.

Sokan érveltek azzal az áremelésekre, hogy a cégek a homlokukhoz csaptak, hogy ja hát ha ennyiért is elkel, akkor adhatjuk drágábban is. Azt azonban ne felejtsük el, hogy ez az RDNA előtt az élen egy kvázi-monopol, rögtön azt követően pedig egy felfokozott bányász-időszakban volt. Könnyen lehet, hogy aki hajlandó volt kifizetni a 2x-es felárat az nem saját szórakozására tekintettel értékelte még így is megérősnek a vásárlást, hanem tervezetett bányászati tevékenységgel gondolta ledolgozni a különbözetet. Ha a bányászat kikerül a képből, akkor a felár megfizetésére való hajlandóság is elpárologhat.

Az persze valószínű, hogy a 2x gyorsabb kártyákért az AMD és az Nvidia is többet fog elkérni, mint a jelen generáció. De a mostani generációváltás során én egy a korábbiakban megszokott tier lecsúszást és ezzel árcsökkenést várok.

-

paprobert

őstag

válasz

GeryFlash

#37642

üzenetére

GeryFlash

#37642

üzenetére

Megfogalmazom neked nem morális, hanem pénzügyi szempontból.

Ha az R&D növelésnél olcsóbb a node váltás, hogy valamilyen jellegű fejlődés kicsikarható legyen, akkor az fog megtörténni. Persze ezeknél is olcsóbb a TDP emelése, így most ez van soron. De ez is el fog fogyni egyszer.

Visszatérve, Abu az új node használatának lehetőségét tagadta, én pedig kijavítottam, hogy az akarat nincs meg, mert a számokban bőven van tartalék.

-

GeryFlash

veterán

válasz

paprobert

#37641

üzenetére

paprobert

#37641

üzenetére

,,Ahhoz fejleszteni is kéne. "

Az hogy paprobert kollega a prohardver forumon azt erzi hogy se az Nvidia se az AMD nem erdemli meg ezt a profit ratat mint az elmult 2 evben, es csak ne sporoljanak a gyartaskoltsegen, kulonben se fejlesztettek semmit es az felsokategoriaban ugyanott van a perf/watt mint 6 eve, es ennek az erzesenek hangot is ad attol meg – kapaszkodj meg – senkit nem erdekel. Alternativakent lehet majd venni Intelt, ahol a csucs lesz az mint itt a masik kettonel a belepo, biztos majd melyen alavag az Intel arban.

Ne erts felre, nekem se senkinek se tetszik ez a szitu, de nem lehet mit tenni, az hogy ki mit erdemel meg irrelevans. Oruljunk neki hogy legalabb kapunk vegre belepo kategoriaban 3070TI teljesitmenyt 6600XT fogyasztassal. Leszarom ha ez 6nm es nem 5nm-en fog keszulni.

-

paprobert

őstag

Ahhoz fejleszteni is kéne. Úgy beszélsz, mintha a VGA-piac csak egy kifizetőhely lenne, ahol alanyi jogon jár a jelenlegi profit, és te a cégek képviselője vagy.

"Nullszaldóért nem éri meg dolgozniuk."

A két véglet között azért akad még jó néhány lépcsőfok. Ezért kérdeztelek, hogy tisztában vagy-e, hogy szükség esetén mennyiből tudnak még engedni.

Rengetegből. -

GeryFlash

veterán

válasz

gejala

#37634

üzenetére

gejala

#37634

üzenetére

RDR2 a konzol ciklus legvegen jott ki nem az elejen.

FLATRONW: De miert tennek? A cegek nem ugy gondolkoznak ahogy ti, hogy igen msot 2 ev alatt jol megszedtuk magunkat, van boven tartalek most egy kicsit belefer kevesebb profit is. Minden ev az elozohoz van merve, ha esik a profit esik/eshet a tozsdei arfolyam is.

-

Jacek

veterán

válasz

huskydog17

#37636

üzenetére

huskydog17

#37636

üzenetére

-

gejala

őstag

válasz

GeryFlash

#37620

üzenetére

GeryFlash

#37620

üzenetére

"De nem lesz olyan jatek, amihez ez kell. Mert a konzolok mar most visszafognak"

Konzolok a min grafikát határozzák meg PC-n, nem a maxot. PC-n eddig is sokkal jobban néztek ki a konzolos játékok és sokkal több fps mellett lehetett játszani őket. Pl. RDR 2 is 25-30 fps PS4-en PC-s low grafika mellett. Ugyanez lesz PS5-ön is. -

paprobert

őstag

A TSMC részéről durván a duplázás duplázásának a duplázása is beleférne (8x) a két gyártónak, annyi a profit.

Vagyis a közelében nem vagyunk a nullszaldónak, amit te állítasz.Ez a beszélgetést lefolytattuk már 2-3 éve, csak a 7nm-rel. Későre jár, én inkább elengedem a dolgot.

-

paprobert

őstag

"Nyilván a 6 nm egy koncepció is, mert az 5 nm iszonyat drága, még a legkisebb VGA-k esetében is művészet lesz vele 600 dollár alá vinni az árat. Emiatt maradnak a régi VGA-k meg, mert igazából a 300-500 dolláros szintre nem nagyon lehet 5 nm-es dizájnt fejleszteni. Nem tudod összerakni haszonnal."

Minden porcikám azt mondatja velem, hogy bullshit ez a bekezdés.

TSMC 5nm

Apple A14 - September 15, 2020, 17 months agoKísértetiesen hasonlít ez a felvezetés a Zen2 valamint a konzolok megjelenése környéki klisékhez, csak akkor a 7nm volt aktuálisan megfizethetetlennek kikiáltva.

Szerintem, látva az elmúlt másfél évet, nincs szükségük a cégeknek ilyen mosdatásra. Köszönik szépen, rekord profitot halmoznak ebben a pillanatban is, sok negyedéves sorozatban, nem kell félteni őket az 5nm-től.

-

Jacek

veterán

válasz

huskydog17

#37626

üzenetére

huskydog17

#37626

üzenetére

Irónia csak átment?

-

Abu85

HÁZIGAZDA

Részben igen. Na jó, relatíve nagy részben.

De a teljesítmény/watt az biztos javulni fog, mert a Navi 33 az még 6 nm-en van, tehát nem az új 5 nm-t használja. És annak a teljesítménye nagyjából 6800 XT-6900 XT közötti, miközben a fogyasztása 6700 XT alatti, a kialakítása pedig fizikailag a 6600 XT-re hasonlít, tehát 128 bites busz, relatíve kicsi NYÁK, stb.

A többiről még nem nagyon van pontos adat, mert a többi next-gen mindkét oldalon 5 nm-es. Nyilván a 6 nm egy koncepció is, mert az 5 nm iszonyat drága, még a legkisebb VGA-k esetében is művészet lesz vele 600 dollár alá vinni az árat. Emiatt maradnak a régi VGA-k meg, mert igazából a 300-500 dolláros szintre nem nagyon lehet 5 nm-es dizájnt fejleszteni. Nem tudod összerakni haszonnal.

#37623 GeryFlash : Marad egy csomó in-house motor. Az Unreal Engine 5 sokaknak nem felel meg. A Square Enixnek is ott van a Luminous Engine házon belül, de nem minden stúdiójuk használja. Az meg, hogy a kisebb fejlesztők váltanak igazából logikus. A CD Projekt RED motorja egyáltalán nem erős.

-

Cifu

félisten

válasz

GeryFlash

#37623

üzenetére

GeryFlash

#37623

üzenetére

A HFW sehol sincsen összetettség szinten a CP2077-hez, az előbbi egy főleg szabad téri játékterület, az utóbbi egy zsúfolt metropolisz, szóval almát körtével sikerült összehasonlítani (vannak bajai a CP2077-nek, de especiel ahhoz képest mit nyújt látványban, nem rossz egyáltalán a teljesítmény)...

Erőforrás zabálóbnak se igazán nevezném, ha i5-2400 + GTX 960 2GB-os VGA-val is 30 FPS körül fut a játék 720p-ben...Én 50 körüli FPS-el játszom @FHD + RT High + DLSS quality, egy ~i7-4770 szintű Xeonnal és egy RTX 2070 Superrel, szénné modolva...

-

GeryFlash

veterán

Jo, de a CP2077 szerintem egy eroforras zabalo szar (mondjuk egy Horizon Forbidden Westhez kepest) es nagyon rosszul skalazodott. Nem csoda hogy dobtak is es vegul UE5-tel keszul a Witcher 4.

Egyebkent Abu, errol mi a velemenyed? Abba az iranyba fogunk menni hogy mindenki ugyanazt a motort (mondjuk UE5) fogja hasznalni? Eddig soha nem volt tiszta, hogy a kozepes jatekfejleszto studioknak melyik a rentabilisabb, es sokan inkabb licenceles helyett in-houset hasznaltak (pl Metro jatekok 4A Engine, Remedy jatekok - Northlight stb).

En szemely szerint kicsit sajnalom, hogy minden jatek ,,ugyanugy fog" kinezni, ami igy nyilvan nem igaz, de azert az egyedi featureok es az innovacio szerintem hatterbe tud szorulni.

Kerdes hogy a nagyok (EA, Ubisoft, Sony) a kesobbiekben, mondjuk 5-10 eves tavlatban hogyan dont? Tenyleg le fog szukulni 1-2 enginere a piac, mert annyival koltseghatekonyabb lesz UE5-tel fejleszteni? Vagy a nagyoknak meg fogja erni lemasolni az UE5 koltseg hatekony featurejeit, es ok megmaradnak in-hosuenal, mindenki mas meg UE5 (esetleg Unity)? -

Cifu

félisten

válasz

GeryFlash

#37620

üzenetére

GeryFlash

#37620

üzenetére

Azt ertem, de ha a legkisebb tag lesz 200-225watt (Nvidinal meg 250 wattol) akkor az nagyjabol a 3070TI-3080 szintjet kene hogy hozza.

Pont ez a szép. A 3070Ti ezt a teljesítményt 290W-al hozza. Amiben az gyönyörű, hogy a 2080Ti kb. 15%-al kisebb teljesítményt tudott 250W-al. Tehát a teljesítmény / fogyasztás arány tyúklépésekkel totyog tovább.

AMD oldalon is ugyanez van...

De nem lesz olyan jatek, amihez ez kell.

Furcsa kettőséget érzek ezzel kapcsolatban.

Egyfelől mindig megy, hogy "de mi fogja ezt a teljesítményt kihasználni", másfelől pedig megy, hogy brü-hü-hü, az új XYZ játék még az egy millió forintos kártyámmal sem tud stabilan Ultra részletességgel natív 4K @ 144 FPS-t, milyen optimalizálatlan hulladékot adtak ki megint...Ez utóbbi miatt jutott oda a CP2077 is, hogy az 1.5-ös patch-ben kivették a Psycho és Ultra grafikai szintet, és lett csak High szint, amit kb. a korábbi Ultra és High közé lőttek be.

Custom MOD-okkal fel lehet emelni a LOD-ot, lehet 4K-s textúrákat használni, emelni a reklámok felbontását, amelyek jelentősen javítják a grafikai minőséget, cserébe az FPS beleál pillanatok alatt a földbe...Szóval nem lesz olyan játék, amihez ez kell? De, van, illetve lehetne akár most is. Persze, DLSS meg hasonló trükkök alkalmazásának mellőzése esetén...

-

GeryFlash

veterán

Azt ertem, de ha a legkisebb tag lesz 200-225watt (Nvidinal meg 250 wattol) akkor az nagyjabol a 3070TI-3080 szintjet kene hogy hozza. Ez a PC playerek nagyon nagy reszenek (80%) boven eleg lesz. En azert ezt a kijelentese Abu-nak elegge nem tudom hova tenni. Altalaban nem erdeke ennyire a legkisebb tag fele terelni a nepet a VGA gyartoknak.

,,Ebben a régióban a hatékonyság nem tényező. Az tényező, hogy Cinebench-ben meg 3DMark-ban mennyit tolsz"

De nem lesz olyan jatek, amihez ez kell. Mert a konzolok mar most visszafognak, mar most megy a szopas hogy 4k/30FPS legyen vagy 1080/1440p 60FPS. Most jonnek ketszer erosebb hardverek, de hova. Vagy innentol 1440p 30FPS lesz majd konzolon a quality mode?

-

Cifu

félisten

válasz

GeryFlash

#37618

üzenetére

GeryFlash

#37618

üzenetére

Az RDNA mögül a 2-est felejtettem el. Az RX 5700 esetén a TDP 180W volt. Az még jobb példa lett volna, igazad van...

De hogy minek azt nem ertem, mert mar most kb bottleneck a jelenlegi konzolgeneracio, tehat hova kell ketszer nagyobb teljesitmeny?

Anno a Titan szériával az nVidia bebizonyította, hogy van egy réteg, akinek semmi sem drága, a téma pörög tovább. Van vevője az Intel i9 és a Ryzen 9 szériának is.

Ebben a régióban a hatékonyság nem tényező. Az tényező, hogy Cinebench-ben meg 3DMark-ban mennyit tolsz.A DLSS anno a Ray-Tracing miatt kellett, és az AMD-nek is első sorban amiatt fontos az FSR 2.0 szerintem.

-

GeryFlash

veterán

Nem az 5700XT-re gondoltal (225W-tal)? Marmint RDNA eleje az volt.

Egyebkent igen, hihetetlen szanalmas az egesz szituacio. Tudom hogy a mostani harvderekkel nem tudnal pontosan akkora teljesitmenyt ekkora wattal, de ezek a high-high end kartyak perf/wattja rohejes, de igazabol a tobbi is. Erdekes hogy amig a vilag minden szegmense a zold es fenntarthatosag iranyaba halad addig a VGA-knal duplazzuk a kategorian beluli fogyasztast... De hogy minek azt nem ertem, mert mar most kb bottleneck a jelenlegi konzolgeneracio, tehat hova kell ketszer nagyobb teljesitmeny? Mikozben a ket gyarto izommal tolja az DLSS-t es az FSR-t, azokkal meg mar a mostani hardverekkel sem lehetetlen a 4K/144FPS.

-

Cifu

félisten

-

Abu85

HÁZIGAZDA

Egyrészt nem a 80%-át hozza, hanem inkább az 55%-át. Legalábbis erre utalnak a szimulációk. Attól, hogy nem annyival kevesebb a mag, még a PCIe verzió gyakorlatban elérhető órajele sokkal kisebb. Másrészt az N4X egy elképesztően drága node, még a 3 nm-nél is drágább, tehát consumer termékben szinte kizárt, hogy bevetik, mert nem hoz annyit, hogy megérje +500 dollárt rakni a végfelhasználói árra. HPC termékeknél who cares, az a +500 dollár zsebpénz a tipikusan 10000 dollár fölötti árakon.

A 600 watt pedig igaz. Sőt, a legnagyobb OC-s modellek 750 wattig elmennek. Az AMD is emelni fog a tipikusan 300-350 wattos határon. A csúcs-Radeon 450 wattot céloz, és az OC-s modellek mennek 550 wattig is.

Viszont az NVIDIA oldalán lesz 250-300 watt közötti GeForce. Tehát ez nem fog eltűnni, csak ez lesz a sorozat belépője. Az AMD-nél is 200-225 watt között fogyaszt a legkisebb új Radeon.

Ezek alatt a mostani termékskála újra kiadott maradéka lesz. -

b.

félisten

[NVIDIA Jetson AGX Orin Full Review ]

pöpec cucc lett. -

b.

félisten

Ugye ez Kopite írta. nem feltétlenül Április 1.

April Fools' Day,

**90 PG139-SKU310, AD102-300, 24G 24Gbps, 600W;

**80 PG139-SKU330, AD102-200, 20G 24Gbps, 500W;

**70 PG141-SKU310, AD104-400, 12G 24Gbps, 400W.

[link] -

b.

félisten

válasz

Alogonomus

#37610

üzenetére

Alogonomus

#37610

üzenetére

Nem tudom, nem vágom a gyártási árakat.

De ez szerintem több dologtól függ.. A GDDR6 megy a 3060 ra és a 3050re most, nem az X, valószínűleg ott olcsóbb az 1 GB modul még mindig.

De elméletileg kompatibilis a GDDR6X és a sima GDDR6, ott nem tudom mi mennyibe kerül, egyáltalán kell e GDDR6X vagy a sima GDDR6 gyorsított kiadásban elég. Ha nem kell nekik áttervezni nagyon semmit az Amperehez képest annál olcsóbb semmi nincs, ugyan az a PCB ugyan a a nyák ugyan szinte minden. Meglátjuk. -

b.

félisten

válasz

Hellwhatever

#37608

üzenetére

Hellwhatever

#37608

üzenetére

Szerintem a memóriabusz nem feltétlenül fog változni.

Ha igaz amit Igor ír feljebb- belinkeltem-, hogy a 3090Ti és 4090 GPU egyszerűen pin kompatibilis úgy ahogy van, akkor nem tartom kizártnak hogy a nyesett verziók is így lesznek..Ha így lenne, akkor igazából partnereknek nem kellene sok mindent tervezniük, marad minden így , gondolom a memória buszt is egyszerűbb így hagyni. BIOS frissítés + Ada GPU az Ampere helyett.

Szerintem a mostani memóriák 1-2 GB verzióival számolhatunk ugyan ezen a buszon.4050 8x1, 4060 és Ti 12x 1, 4070 és Ti 8x2, 4080 10x2, 4080 TI 12x2 vagy 10x2, 4090 12x2 -

Hellwhatever

aktív tag

válasz

Alogonomus

#37604

üzenetére

Alogonomus

#37604

üzenetére

A matekot értem mögötte, lélektanilag furcsa a 192 bit. Nálam fejben ez még mindig a xx60 szint kiváltsága. Jóideje ez az első szembetűnő vágás a xx70-es szérián.

-

b.

félisten

válasz

huskydog17

#37602

üzenetére

huskydog17

#37602

üzenetére

engem inkább az zavar attól függetlenül, mi igaz ebből mi nem, hogy behozták a köztudatba a xx90 kártyát.

Létrehoztak egy új SKU szintet.tehát azt kapod a csúcson ( a 90 ben )amit amúgy a 80 ban hoztak régen teljesen összesűrítve az egész közé téve még a Ti variánsokat... -

Alogonomus

őstag

válasz

Hellwhatever

#37600

üzenetére

Hellwhatever

#37600

üzenetére

A 12 GB azzal jön ki. 256 bites memóriabusszal 16 GB lenne, 16 GB esetén viszont a jóval drágább 4080-on (különösen a Ti-on) szúrná sokak szemét a (csak) 16 GB.

Memóriakapacitásban ez a jó sorminta. Ráadásul állítólag a Lovelace GPU-n sokkal méretesebb cache lesz, így a memóriabusz jelentősége sokat csökken, mert sokkal ritkábban kell a VRAM-mal kommunikálnia. -

b.

félisten

Hát nem tudom. Igor kielemezte az Ada RTX 4090 nyákját. [link]

Én ez alapján nem tartom elborultnak ezt kivéve a 128 bites megközelítést, a 4060 kártyáknál ,az biztos hülyeség.

A memóriával nem érdemes foglalkozni ezeknél az infóknál még, mert a 2 GB modulok szóba jöhetnek már mellékes mit írnak oda. plusz ugye a rebesgetett nagy L2...

Ez alapján 12 darab memória hely van ami 2 GB modulokkal is 24 GB csúcs kártyán...Az Ada egy Ampere továbbfejlesztés egy fajta átmenet lesz az érkező MCM és a monolitikus dizájn lezárása között, előkészíti az előbbit.

Ez a Pascal- Maxwell szintű ugrás így is , ha ez igaz lenne, tehát az utóbbi 10 év legnagyobb ugrása. Én nem élném bele magam nagyon hogy itt 2-3x teljesítményt fogunk kapni raszterben...

Ez alapján amúgy kb 230-250 wattból lesz kb a 3080 szint, ami megint reálisnak tűnik... -

huskydog17

addikt

Április 1. ennyire lehet komolyan venni, de április 1-et leszámítva is tömény bullshitnek tűnik.

Én is belenézek a jósgömbömbe és tippelnék egyet már most:

Szerintem az RTX 4060 kb. RTX 3070Ti max 3080 tempót fog hozni 200-220 Wattból 380, max. 400 dolcsiért és 12 GB VRAM-mal.

Kizártnak tartom, hogy a 4060-as 128 bitet fog kapni, amikor már 6 éve 192 bites, továbbá ha az RTX 3060 12 GB VRAM-ot kapott, akkor a 4060-as biztosan nem fog 8 GB-ot kapni.

Új hozzászólás Aktív témák

A topikban az OFF és minden egyéb, nem a témához kapcsolódó hozzászólás gyártása TILOS!

MIELŐTT LINKELNÉL VAGY KÉRDEZNÉL, MINDIG OLVASS KICSIT VISSZA!!

A topik témája:

Az NVIDIA éppen érkező, vagy jövőbeni új grafikus processzorainak kivesézése, lehetőleg minél inkább szakmai keretek között maradva. Architektúra, esélylatolgatás, érdekességek, spekulációk, stb.

- Lakáshitel, lakásvásárlás

- Fűnyíró topik

- Azonnali mobilos kérdések órája

- Miért álltak az oldalak egy hétig, mi történt?

- Genshin Impact (PC, PS4, Android, iOS)

- Hogy is néznek ki a gépeink?

- Házi barkács, gányolás, tákolás, megdöbbentő gépek!

- Interactive Brokers társalgó

- Samsung Galaxy S21 és S21+ - húszra akartak lapot húzni

- PROHARDVER! feedback: bugok, problémák, ötletek

- További aktív témák...

- EVGA GeForce FTW3 ULTRA GAMING RTX 3070 Ti 8GB GDDR6X 256bit Videokártya

- ASRock Radeon Challenger Pro RX 6700 XT 12GB OC

- !!Újszerű!! AsRock RX 7700XT 12GB /Jótállással!/Szép állapotban!/Beszámítás! Posta ok!

- !!ÚJSZERŰ!! Gigabye Aero RTX 4070 Super 12GB /Jótállással!/Beszámítás!/Posta ok!

- Videokártyák

- Gamer PC-Számítógép! Csere-Beszámítás! R5 1600X / GTX 1080 8GB / 32GB DDR4 / 256SSD + 2TB HDD

- AKCIÓ! Gigabyte Z370M i5 9400F 16GB DDR4 512GB SSD RX 5700XT 8GB ZALMAN S2 TG Corsair S650W

- Honor Pad X8 64GB, Wi-Fi, 1 Év Garanciával

- Bomba ár! Dell Latitude 7320 - i5-11GEN I 8GB I 256SSD I HDMI I 13,3" FHD I Cam I W11 I Garancia!

- Azonnali készpénzes Microsoft XBOX Series S és Series X felvásárlás személyesen/csomagküldéssel

![;]](http://cdn.rios.hu/dl/s/v1.gif)

Ertem hogy nem lehet mindenfele spekualciot es hasonlot lehozni, de a technikai cikkek es mindenfele termekbeutatok aranya most mar rohejes aranyban van/

Ertem hogy nem lehet mindenfele spekualciot es hasonlot lehozni, de a technikai cikkek es mindenfele termekbeutatok aranya most mar rohejes aranyban van/