- Alsó-középkategóriás, PlayStation 5-be is helyezhető M.2 SSD-t virított a Klevv

- Antec kirakatház Lian Li zöngével és egy csavarral

- Újabb inteles VGA került elő a Biostar hátizsákjából

- Belépőszintű játékos headsetekkel bővült a Corsair kínálata

- Kétféle tájolással munkára fogható, ITX-es ház jött a Sharkoontól

- Apple notebookok

- Steam Deck

- Vezeték nélküli fülhallgatók

- NVIDIA GeForce RTX 4060 / 4070 S/Ti/TiS (AD104/103)

- AMD K6-III, és minden ami RETRO - Oldschool tuning

- Google Chromecast topic

- AMD Ryzen 9 / 7 / 5 / 3 3***(X) "Zen 2" (AM4)

- Soundbar, soundplate, hangprojektor

- Intel Core i3 / i5 / i7 8xxx "Coffee Lake" és i5 / i7 / i9 9xxx “Coffee Lake Refresh” (LGA1151)

- Milyen billentyűzetet vegyek?

Hirdetés

-

Toyota Corolla Touring Sport 2.0 teszt és az autóipar

lo Némi autóipari kitekintés után egy középkategóriás autót mutatok be, ami az észszerűség műhelyében készül.

-

Van, ahol már törvényben védik az agyhullámainkat

it Az USA-ban még nem volt rá példa, hogy törvényben védenék az agyhullámokat és a mentális adatokon való nyerészkedés miatt aggódnának. Colorado azonban most lépett, mert túl gyorsan fejlődik a neurotechnológia.

-

Homeworld 3 - Befutott a gépigény és a roadmap

gp A készítők felfedték, hogy milyen hardverek kellenek a játék futtatásához, valamint azt hogy mi vár ránk a későbbiekben.

-

PROHARDVER!

A legtöbb kérdésre (igen, talán arra is amit éppen feltenni készülsz) már jó eséllyel megtalálható a válasz valahol a topikban. Mielőtt írnál, lapozz vagy tekerj kicsit visszább, és/vagy használd bátran a keresőt a kérdésed kulcsszavaival!

Új hozzászólás Aktív témák

-

Abu85

HÁZIGAZDA

válasz

Beowulf_78

#2

üzenetére

Beowulf_78

#2

üzenetére

Mivel a TSMC 2009 januártól teljesen fel lesz készülve a 40nm-re, meg lehet csinálni a chipet ezzel a technológiával. Nyilván van benne kockázat, mert nagyon kevés az idő a gyártástechnológia kidolgozására, ha egy pici hiba is becsúszik és nem lesz hatékony a gyártás akkor nagyon drága lesz az előállítás és gyártási fázis közben kell módosítani a technológiát ami nagyon nehéz. Nyilván ha ez az esett előáll, akkor lehet, hogy jobban jártak volna az 55nm-rel, még anyagilag is.

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

Az egy olyan kialakítású rendszer ami a gyártási és fejlesztési költségekre nézve sokkal olcsóbban kihozható.

Az egész lényege a Crossfire Sideport ami a Rambus Flex I/O rendszerére épül. Ez 8GHz-en maximum 76,8 GB/sec-es sebességre képes 12 csatornán (5 be-, és 7 kimeneti).A Master Chip Design-al két chipet kell tervezni, egy mastert ami a főchip lesz és egy slave szolga chipet ami a master chiphez kapcsolódik. A master chip annyi slave chipet tud kezelni ahány Crossfire Sideport-ja van. A master chip egy teljesen általános felépítésű GPU, míg a slave chip csak a számításért felelős shader core-t tartalmazza a hozzá kapcsolódó textúrázóval.

Az előnyök egyértelműek két pici és olcsón gyártható chipet kell majd kifejleszteni, és a különböző kategóriákban induló kártyákra küönböző konfigurációkban kell majd felszerelni. Például a legkisebb versenyző csak a Master chipet fogja tartalmazni alacsony teljesítménnyel, míg a legerősebb modell, a master chip mellett annyi slave chipet is tatalmazhat ahány Crossfire Sideportja van.Példának okáért legyen a master chip 800 shader procis ugyanazzal a felépítéssel, mint az RV770 4 darab CF sideprottal. A Slave chip szintén 800 shader procit tartalmazzon a szükséges felépítéssel. Mindkét chipet 40nm-en gyártva (mert a méret miatt ez reálisan kivitelezhető) a következő termékskála alakulna ki. A memória minden esetben a Master chiphez kapcsolódik, mert csak azoknak van ROP blokkjuk.

HD 54xx -> 800 SP, 40 Gather4 TMU (1 master chip)

HD 56xx -> 1600 SP, 80 Gather4 TMU (1 master chip + 1 slave chip)

HD 56xx+ -> 2400 SP, 120 Gather4 TMU (1 master chip + 2 slave chip)

HD 58xx -> 3200 SP, 160 Gather4 TMU (1 master chip + 3 slave chip)

HD 58xx+ -> 4000 SP, 200 Gather4 TMU (1 master chip + 4 slave chip)Természetesen az egyes chipek a gyártási selejtekre nézve butíthatók.

Persze azt senki sem tudja, hogy milyen felépítés lesz alkalmazva a chipekben, de a design mutatja, hogy maximálisan testre szabható a rendszer és rendkívül olcsón kivitelezhető.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

Hivatalosan nem tudni semmit, de utánaszámolva az eddigi fejlesztési költségek 30-40%-át emésztené fel a teljes generáció megtervezése, illetve a gyártás úgy 40-50%-al lenne olcsóbb az eddigi viszonyokhoz képest. A chipeknek nagyon piciknek kell lennie ... a master chipet max 200mm^2, míg a slave chipet 150mm^2 alatt kell kihozni.

Valszeg a Rambus FLEX IO 70 GB/sec feletti sávszélessége megoldja a kommunikációt.Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

-

Abu85

HÁZIGAZDA

Huha a GT300 az elég sokára jön

... én nyárra vártam volna. Így viszont 2009 Q4-ig le van futva a dolog.

... én nyárra vártam volna. Így viszont 2009 Q4-ig le van futva a dolog.

Kíváncsi vagyok az AMD mikor kezd el izmozni az árakkal ... jövőre már valszeg lesznek akkora előnyben, hogy többet kérjenek a cuccokért.

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

-

Abu85

HÁZIGAZDA

Ki támogatja a CUDA-t - NVIDIA

Ki támogatja az OpenCL-t - mindenki

Mi a kérdés? ... Hogy elterjed-e a CUDA? Támogatás hiányában nem.

Ilyet már egy csomószor láttunk a történelemben. 3dfx Glide tipli, NVIDIA cg tipli. Mind a támogatás hiányában kapituláltak.

Remény ... a remény meg az emberi elme kvintesszenciája, ami egyszerre a legerősebb és a leggyengébb oldalunk.

... a remény meg az emberi elme kvintesszenciája, ami egyszerre a legerősebb és a leggyengébb oldalunk. ![;]](//cdn.rios.hu/dl/s/v1.gif)

Az NV mindent a CUDA-ra tett fel, amelyik piacon bukik a platform, ott bukik az NVIDIA is.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

A Glide-ot és a cg-t is szerették, és mind a kettő kihalt. Ez nem ezen múlik. Ha a CUDA-t csak az NVIDIA támogatja, akkor a rá írt program csak az NVIDIA kártyákon fog futni. Ergo a többi gyártónál is kell találni valami megoldást a program futtatására. Az AMD-re ott az Ati Stream a Larrabeenek meg ott van a saját platformja. Gyakorlatilag három rendszernél háromszor kell megírni ugyanazt. Ezzel szemben az OpenCL-re, vagy Compute Shaderre megírod egyszer a programot, és fut mind a három rendszeren.

Ha ezek a dolgok a szereteten múlnának, akkor már az x86 is ki lenne dobva az ablakon.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

schwartz

#184

üzenetére

schwartz

#184

üzenetére

A Glide tette őket tönkre ... nem foglalkozott a DirectX fejlődésével. A chipjeit egyszerűen nem készítette fel az aktuális DX támogatására.

Amíg egyedül vagy egy piacon nyomhatód a saját megoldásod, amint belép egy konkurens a független szabványok kerülnek előtérbe. Ez íratlan törvény ... ez mindenkinek az érdeke.

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

Firestormhun

#186

üzenetére

Firestormhun

#186

üzenetére

Mit ér a könnyű programozhatóság, ha még egyszer ... netán kétszer el kell készíteni ugyanazt a többi vállalat rendszerére?

Ezek előre lefutott körök. Eddig minden olyan platform behalt, amit nem támogattak globálisan a legnagyobb vállalatok. Egyedül az NV édeskevés, az AMD-vel, vagy az Intellel lenne esélyük, de mindkét vállalat tudja, hogy ha a CUDA-t nem támogatják, akkor az NV-vel nem kell számolni hosszútávon.

Többiek hol vannak? Szerinted min futott a Havok bemutató a GDC-n? Csak nem Radeonon? Bezony a Radeon már képes futtatni az OpenCL kódot december óta. Lebecsülöd őket. Az AMD-nek már kettő WHQL drivere is van Win 7-re ... az NV-nek van? Az, hogy az AMD nem jelenti be, nem azt jelenti, hogy nekik még nincs kész a meghajtójuk. Az NV azért jelent be minden jelentéktelen, vagy házi feladat fejlesztést, mert mindenki arról beszél, hogy a Radeonok elpicsázzák a GeForce-okat. Kell néha olyan téma, ahol nem kell fikázni a GeForce-ot.

Az NV bizony mindent feltett a CUDA-ra, azért vannak most ilyen ramaty helyzetben, mert a platform nem terjedt el. Az eredeti tervek szerint már CUDA-ra kellene írni a játékokat, ehelyett mindenki bontja fel a TWIMTBP szerződést. Ha annyira érdekli őket a VGA piac, miért az AMD publikálja a fejlett DX10 eljárásokat? Ellentmondások és ellentmondások. Az NV eltaktikázta magát, és most fut a pénze után.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

schwartz

#188

üzenetére

schwartz

#188

üzenetére

Nem akarok, egy olyan chipről véleményt alkotni, ami még nincs kint, de ha igazak a pletykák, akkor grafikára nem lesz ideális a GT300. Baromi nehéz lesz tökéletesen ütemezni, majdnem képtelenség kategória. Ami nagyobb baj, hogy méretes lesz. Ha az AMD-nél is igaz az az 1,9 TFLOPS, akkor az RV870 egy 160-170 mm^2-es lapka, amiből bizony nem csak X2, de X4 verzió is lesz a méretből kifolyólag.

Persze lehet, hogy a pletyikből semmi sem igaz.

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

Mert a Microsoft már teszteli a drivereket és építi be a Win 7 telepítőjébe. Beta drivert azonban nem lehet beépíteni, mert az MS nem írja alá, addig amíg nem ütik meg a minimális elvárásokat. A Win 7-nél ezek sokkal szigorúbbak lesznek, mint a Vistanal, így jobban kell majd figyelni erre. Az NV drivereit egyelőre képminőségproblémákkal dobták vissza, de a sebességben is sokat kell majd javítani, mert a Vistahoz viszonyítva a programok futása lassabb. Az AMD 9.3 például átlag 3-4%-kal gyorsabban futtat egy alkalmazást Win 7 alatt, a Vistához viszonyítva. Nyilván nem kell ekkora sebességet elérni, de az NV jelenlegi átlag 20% mínuszán még javítani kell.

Nyilván ezek a különbségek abból adódnak, hogy a két vállalat mást tart fontosnak, így a rendszerprogramozókat aszerint csoportosítja. Az AMD a driverekre, az MS rendszereire és az OpenCL-re koncentrál, ezután jön csak a Havok és az Ati Stream. Az NV-t elsősorban a CUDA és a Physx érdekli, valamint a driverek a kiadott oprendszerekre ... a többi pedig kevésbé fontos. Nyilván mire kint lesz a Win 7 addigra lesz az NV-nek is WHQL drivere csak problémás az OEM-eknél, ha nincs a meghajtó integrálva a friss operációs rendszerekben.Az a post 2007-es. Azóta legalább egy tucat GPGPU-val foglalkozó írást olvastam. Bár ez a része annyira nem érdekel, inkább a grafikára koncentrálok már. Ez érdekli az olvasók többségét. A G80 legnagyobb előnye, hogy stream rendszer, így nincsenek függőségek, az R600-nál vannak, egyszerű számításoknál ez nagyon visszaüt. Lásd Folding képességek. A G80 az egyszerű számításokra tervezték, és a bonyolultaknál, valamint a sok ideiglenes adatta dolgozó grafikai számításoknál megfekszik. Ez R600 kvázi a rendszer ellentéte. Ha sok függőség van a kódban, akkor nem egy erőgép, kevés függőséggel már sokkal jobb a helyzet. A bonyolult feladatokat meg imádja.

A cikkeimben minden fontosat leírok. Mi miért van satöbbi.

schwartz:

Keldor papa: egyelőre ezek előrejelzések. Én számítok arra, hogy az NV észen tér.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

Jól látod, de az igazsághoz az is hozzátartozik, hogy a Microsoft brutálisan az AMD puszipajtásává vált (főleg az elmúlt egy évben). Ettől persze a szükséges dokumentumokat mindenki megkapja.

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

Az Euphoria az nem fizikai motor. Az a rendszer a karakterek élethű mozgásáért felel.

Az említett címek (GTA4, Ghostbusters, SW: The Force Unleashed) a Havok motort használják fizikára.Gyusz: Ha jól tudom, akkor a Win 7 következő verziója RC, azaz már az NV lekéste az integrálást. Nem katasztrófa a dolog, de mindenképp negatívum az OEM gyártók körében. Emellett ugye semelyik NV-s gép nem kaphat Win 7 prémium matricát (DX10.1 nuku miatt). A "hülye azért nem vagyok boltok" erre hajtanak ... baromság a matrica, de kétségtelen, hogy vevőcsalogató.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

VinoRosso

#204

üzenetére

VinoRosso

#204

üzenetére

Miért lenne feltétlenül bonyolult az amiben sok függőség van? Ha az egyszerű utasítások függnek folyamatosan egymástól, akkor már rossz a helyzet az R600 esetében. Ezért ilyen gyenge a chip Folding teljesítménye. Erre mondta a Folding egyik programozója, hogy ezen nem lehet javítani, mert az R600-at az AMD a DX10-re tervezte, azaz a legjobb chipet akarta a grafikai számításokra. Ha a rendszer csak olyan utasításokat kap amik függnek egymástól, akkor a shader processzorok 80%-a pihen, mert egyszerűen nem tud a lehetséges 1+1+1+1+1 co-issue módban működni.

A G80-nál olyan, hogy függőség nincs, mert ez az architektúra stream rendszer. Komponens folyamokon dolgozik, azaz az utasításokat az egymás után következő komponenseken végzi el. Gyakorlatilag a G80 mindig 100%-os kihasználtságot garantál. Ami nagyszerű a programkódnak. A probléma az, hogy a belső cache rendszer irgalmatlanul gyengén bánik az ideiglenes adatokkal. A stream processzorok regisztereinek mérete is kevés. Az ütemező elemzi a feladatokat, és ha túl bonyolult a párhuzamos végrehajtásra, akkor a 8 utas Streaming shader processzorból annyi utat lekapcsol, ahány szükséges a működéshez. Ez persze azt is magával vonhatja, hogy egy ilyen blokkban a 8 stream egységből csak egy fog működni, és az felhasználja a többi egység regiszterét. Előfordulhat persze az is, hogy még így is kevés lesz a regiszterterület, így a hely hiányában az adatok a TPC cache-be lesznek kiírva. Gondolom nem kell ecsetelni, hogy ez mekkora probléma a sebességre nézve. A rendszer aktív processzorai ilyenkor kvázi 10-15 órajelenként dolgoznak (most nem tom pontosan mekkora a TPC cache késleltetése). A G200-nál például a stream processzorok regiszterméretét megduplázták és a belső gyorstárak összmérete is a hatszorosára nőt. Ez nagyon látszik a DX10-es példaprogramokban. Főleg a Geometry Shadert, vagy Cube Map tömböt használó alkalmazások esetén ... utóbbi esetében szó szerint megfekszenek a GeForce-ok, még a GT200 is az R600 alatt van, túl bonyolult nekik a feladat. Persze a GT200 még így is tízszer gyorsabba a G80-nál, csak az R600-hoz még ez is kevés.Az NV-nek ezért lenne fontos legyűrni a DX-et, mert a CUDA-ban jó eséllyel nem használnak majd, olyan baromságokat, mint Geometry Shader és Cube Map tömb. Amikkel egyébként Globális Illuminációt és dinamikus környezeti tükröződést lehet csinálni, ergo egy újabb grafikai ugrás lenne. A DX10.1-ben már az MS azt is megoldotta, hogy a Cube Map tömbök számítása párhuzamosan történjen. Hmm ... vajon miért is nem támogatják a GeForce-ok a DX10.1-et, ha annyira a grafikára pályáznak? Vagy lehet, hogy mégsem a modern eljárásokra épülő grafikai számításokért rajonganak?

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

Sajna az Euphoria lényegéről tényleg sok a félreértés. Pedig a hivatalos oldalon minden infó megvan. A fizikáért nem felel, de együttműködik a PhysX-el és a Havokkal is.

hmm ... tényleg május 5 az RC. Akkor még van pár napja az NV-nek. Mindenesetre szoros lesz, mert ha visszadobják megint aláírás nélkül, akkor már időhiány van.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

schwartz

#210

üzenetére

schwartz

#210

üzenetére

Valóban ... a Ghostbuster az saját fejlesztésű. Most olvastam, hogy a motor 8 szálat kezel, így a nyolcmagos procikat is kihasználják. VELOCITY physics engine a neve. Majd meglátjuk mit tud. Bár a videók meggyőzőek.

Kösz, hogy felhívtad rá a figyelmem.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

biggamer

#214

üzenetére

biggamer

#214

üzenetére

Miért vesznek az emberek grafikus kártyát? Csak nem játékra? ... Melyik játék van CUDA-ra írva? Ez itt a probléma, ezért esik az NV részesedése. Nagyszerű ez a Nero féle támogatás, meg a CUDA alkalmazások ... de most komolyan. Fincsi extrák ... de a Radeon játékra jelenleg jobb. Innentől kezdve, meg az egész verseny el van döntve.

Annyira érdekli az embereket a CUDA, hogy egy - azaz 1 darab - GeForce GTX 275-re 30 darab Radeon HD 4890 eladás jut még mindig. Pedig most már az NV sem mondhatja, hogy nincs elég készlet a piacon.Most az NV marketinggel ilyen havi konferenciákat. Ma is lesz egy (majd megyek is rá). Miről fog szólni? CUDA, PhysX ... de könyörgöm miért? Tisztán látszik, hogy nincs beleszólása ezeknek a technikáknak az eladásokba. Jó és olcsó grafikus kártyát kell csinálni, ahogy az AMD is tette, és jönni fognak az eladások. Addig meg megy a marketing bullshit.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

biggamer

#216

üzenetére

biggamer

#216

üzenetére

Mi lesz a végén? Van OpenCL és lesz ingyenes Compute Shader. Ezek minden rendszeren futnak. Mi értelme van ezek mellett az NVIDIA CUDA-janak, vagy mondjuk az AMD Ati Stream rendszerének. Ha te fejlesztő lennél, akkor neked az lenne az érdeked, hogy ne csak a GeForce tulaj Pisti, hanem a Radeon tulaj Marika is használja a programod. Mi több vegye meg!

De ha csak Pisti tudja futtatni, akkor már eleve nem tudsz szert tenni Marika pénzére. Potenciális vásárlóbázist vesztesz aminek egyenes következménye a kevesebb bevétel. Szerinted egy fejlesztőnek ez a célja?

De ha csak Pisti tudja futtatni, akkor már eleve nem tudsz szert tenni Marika pénzére. Potenciális vásárlóbázist vesztesz aminek egyenes következménye a kevesebb bevétel. Szerinted egy fejlesztőnek ez a célja?Ezt mind az NV is tudja. Ezért vették meg a Physx-et, hogy az AMD-t rákényszerítsék a CUDA támogatásra, csak ők még így sem mentek bele. Több esetben is megkeresték őket a zöldek, de mindig az volt a válasz, hogy a Physx az oké, de a CUDA-t nem akarják támogatni. Ennyi ... ha nem akarják, akkor nem. Ebbe bele kell törődni. Most, hogy itt vannak a független API-k minden kör le van futva.

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

Szerinted, ha az NV tud DX10.1-et, akkor használnák a CUDA-t a Stormrise alatt a Z adatok kinyerésére? Hát persze, hogy nem. Miért is végeznénk plusz munkát, amikor a szabvány ott van, amit mindenki támogat. Illetve hát támogatni kellene, csak hát az NVIDIA-nak nem ez az érdeke.

Valóban bullshit a DX10.1 - [link] Csak átlag 20-25% plusz sebesség van benne. Baromira nem érdeke a felhasználónak, hogy gyorsabban fusson a program a számítógépén.

A DirectX-nél meg lehet jobbat csinálni, senki sem akadályoz meg benne. Persze előre szólok, hogy nehéz lesz.

Az AMD előadásokon azért nagyságrendekkel kevesebb bullshit van. Ennek egy oka van ... az ipari szabványok támogatására is törekszenek. Persze megemlítik, hogy van Ati Stream-jük, meg mitudomén még mijük, de ezek kapnak kb egy vagy két oldalt. Az NV-nél a GeForce GTX 275 50 oldalas bemutatóból 30-40 arról szólt, hogy milyen jó a CUDA meg a PhysX, és hogy ezt az AMD kártyák nem tudják. Nuku teljesítményteszt a Radeonokról, mert már nem találnak olyan beállítást ahol egy átlagos játékban az ár szerinti konkurens GeForce nyerne. Ez a rideg valóság.

Az NV és az AMD kártyák is tuják már futtatni az OpenCL kódot.

biggamer: Nagyon kevés olyan ember van, aki nem a játék miatt vesz ilyen izmos grafikuskártyát. Szerintem az NV nem belőlük akar megélni ... sőt biztos, hogy nem, mert tönkremennének.

Balika911: Nem a DX marad csak a fix futószalag tűnik el, de a compute shader az fejlődik tovább. Persze ha az OpenCL jobban ízlik a fejlesztőknek, akkor futni fog a játék minden operációs rendszeren.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

Beowulf_78

#223

üzenetére

Beowulf_78

#223

üzenetére

Régen azért baromi jó volt a fejlesztőknek, mert kopogtatott az NV és adott programozókat akik jól optimalizáltak. Annyira elenyésző volt az ATI tulajok száma, hogy sokan felvállalták. Ezért volt egy csomó játékban TWIMTBP logo. Most, hogy a Radeonok a kereskedelemben kicsinálták a GeForce-okat, a célcsoport többségében Radeont alkalmaz, ezért a fejlesztők az elmúlt egy évben felbontották a TWIMTBP szerződéseket ... vagy a lejártakor egyszerűen nem újították meg őket.

Az is fontos tényező volt, hogy a fejlesztők is az NV-től tanultak ... rengeteg DX9 doksi volt a zöldeknél, most megfordult a világ. Az AMD dokumentálja az új eljárásokat. A fejlesztők is ebbe az irányba kacsingatnak.Ha annyira nem érdek a közös platform, akkor minek a DirectX, OpenGL és a többi. Miért támogatják a gyártók? Hát persze, hisz ez az ipar érdeke. Hogy mindent egyszer kelljen megírni és az több rendszeren fusson. Ez a szabvány lényege. Szabvány nélkül a PC-s játékipar a jelenlegi komoly szinten nem létezne.

Keldor papa: hát akkor elment a hajó.

![;]](//cdn.rios.hu/dl/s/v1.gif)

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

Beowulf_78

#227

üzenetére

Beowulf_78

#227

üzenetére

Remélem ezt most nem mondtad komolyan.

![;]](//cdn.rios.hu/dl/s/v1.gif)

Egyébként ne nézzük a DX10.1-et. ... De ettől még a Radeon birtokolja minden szegmensben a legjobb ár/teljesítmény mutatót. Ezzel nem lehet küzdeni, mert a jelenlegi GeForce architektúra alkalmatlan erre.

Az NV hidegvéréről meg annyit, hogy órás szintű a marketing. Azt is bejelentik, ha valamelyik oldalon egy játékban elveri a GeForce a konkurens Radeont. Szóval nekem inkább kapkodásnak tűnik, ami megy a zöldeknél, de ez ilyen viszonyok között világos, hisz az eladások gyengék, a partnerek pedig elégedetlenek.[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

VinoRosso

#231

üzenetére

VinoRosso

#231

üzenetére

Én nem fikáztam a GT300-at, csak írtam, hogy az előzetes infó szerint nem biztató. Nem grafikára lesz, ahogy a G80 és a GT200 sem arra van. Ennyi ... már leírtam, hogy miért. Bár ez nem újdonság. Majd meglátod az év végére, hogy mi lesz a helyzet.

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

VinoRosso

#233

üzenetére

VinoRosso

#233

üzenetére

Néztem teszteket pontosan tudom mennyire gyenge az ideiglenes adat kezelése a rendszernek. De ez már megint lefutott dolog. Az RV770 pedig azért érte be az NV-t, mert G80 architektúra akkor volt jó, amikor megjelent, az R600 pedig akkor lett működőképes, amikor az RV770 jött. A GT200 előnye pedig már nem egyértelmű az RV770-RV790-nel szemben. Az új játékok már az AMD rendszerének feküdnek és fognak feküdni. Ez már tényként kezelhető. (mi is leváltjuk a régi versenyzőket és jönnek az új DX10-es tesztjátékok ... jobban reprezentálják a jövőbeli teljesítményt)

De nem vitázom tovább. Anno megmondtam, hogy az FX5900-at kicsinálja majd DX9-ben a középkategóriás Radeon 9600 is, elég sokan röhögtek, aztán a HL2 után már belátták, hogy igazam volt. Meglátjuk, hogy alakul a dolog a DX10-ben. Amire ugye a jelenlegi architektúrák készültek.

Amire ugye a jelenlegi architektúrák készültek.[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

De azokat azért nem írták meg, mert az OpenGL csak egy a sok dolog közül ami nem az MS fennhatósága alatt van. Ott van még az MS Live, vagy a .net ... ésatöbbi. Ezek is kizárják a Linux-ot.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

Ezt a kérdést már kitárgyaltuk, az NV döntött így, hogy nem támogatja a DX10.1-et. Az egyedül az NV mérnökei tehetnek arról, hogy ilyen ramaty helyzetben vannak. Az ipari szabványokat támogatni kell, ez mindenki érdeke, még az NVIDIA-é is. Senki nem akarja, hogy úgy járjanak, mint a 3dfx, pedig jelenleg ilyen irányba haladnak.

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

VinoRosso

#253

üzenetére

VinoRosso

#253

üzenetére

A Stormrise-ban igaz, hogy a DX10-ben is gyorsabb a Radeon a konkurens GeForce-nál, de a DX10.1 még +25%-ot tesz rá a négymintás SSAO és árnyék szűrés miatt - Gather4 előnyök, negyedannyi munka ugyanazzal a végeredménnyel. Erről a GDC-n beszéltek a játékfejlesztők (Techland, DICE, Creative Assembly, Ubisoft Montreal és EA Phenomic) ... itt a közös anyaguk ... [link]

A Far Cry 2-őt az picit aranyos, azt ugyanis azért írták meg DX10.1-re, hogy az AMD egy fázissal többet számoljon, mint a GeForce ezzel lassítva a Radeon kártyákat. Ezért nincs például DX10 mód engedélyezve a Radeonoknak, mert akkor ugyanannyit számolnának a kártyák, az az egy fázis az kb. 10-15% mínusz az AA teljesítményen a Radeonoknak. Persze előny, hogy az alpha teszt objektumoknál is van AA, de ezekből az objektumokból nincs sok a játékban. Az Ubisoft például a Far Cry 2-nél sokallt be az NVIDIA-ra ... ezek után az NV a szerződésre hivatkozva még a PhysX-et is erőltetni akarta, így az Ubisoft inkább kivásárolta magát TWIMTBP kötelezettséges alól.

A S.T.A.L.K.E.R. Clear Sky az AA nélkül gyorsabb DX10.1 módban és sokkal szebb ... össze van hasonlítva. AA-val meg lassabb a DX10.1 mód, de az Alpha test miatt több a számítás is, tehát összességében ott vagyunk, hogy az AMD a konkurens GeForce rendszerekkel hasonló sebességet ér el látványosan jobb képminőség mellett.(ezt meg is írtuk) Extra GDC anyag a GSC-től - [link]

A PhysX-et akkor hozzuk fel példának, ha ipari platformba lesz építve, addig csak cukor nélküli cukormáz, ami borítékolható, hogy ki fog halni. Az Anandtech már megírta róla a nem túl rózsás véleményét. Mi újságírók - minő meglepetés - újságírók vagyunk.![;]](//cdn.rios.hu/dl/s/v1.gif) Minden szempontot a felhasználó érdekéhez kell viszonyítanunk. A gyártók érdekét kb. leszarjuk, nem érdekel minket.

Minden szempontot a felhasználó érdekéhez kell viszonyítanunk. A gyártók érdekét kb. leszarjuk, nem érdekel minket.  Elmegyünk a sajtótájékoztatókra, bratyizunk velük, de a marketingmaszlagot nem adjuk át a világnak, mert az nem érdekel senkit, max a fanokat. Innentől kezdve van egy szoros határvonal a dolgokban, amelyik technika nem épül ipari szabványra, az elgondolás szinten halott, tehát nem veszünk róla tudomást, mert az elmúlt 10-14 év tapasztalata alapján minden ilyen (nem szabványos) megoldás kihalt. És ezek bizony tények, ha már egy megoldás át ment volna a szitán, akkor más lenne a nézőpont, de az összes gyártói technológia a kukában végezte, mert jött rá egy általános független megoldás (ide is megérkezett az OpenCL és év végére már lesz Compute Shader, tehát baromira nem nehéz kitalálni, hogy a CUDA és az Ati Stream az bukó a PC-s VGA piacon). Nem véletlen, hogy az NV felvetette a Physx OpenCL-be való pártolását, mert az Intel és az AMD a Havok-ot beteszi a szabványos platformokba. Itt látszanak egyelőre az érdekkülönbségek. Az Intelnek és az AMD-nek az számít, hogy a Havok elterjedjen, az NVIDIA-at nem érdekli a PhysX, ennek a technikának csak az a célja, hogy az AMD-t és utána az Intelt rávegye a CUDA támogatásra, hogy az NV saját rendszere legyen a szabvány teljesen GeForce-ra optimalizálva. Innentől kezdve az AMD jöhet az kis chipekkel és a "kivégzős" Sweet Spot politikájával, a Multi GPU-s skálázást megölik a CUDA-n és éljen, az NV nyert. Ez az egész lényege. Csak a CUDA valamiért nem akar terjedni a játékfejlesztők körében. Még mindig a DX a fő platform és az OpenCL, Compute Shader felé kacsingatnak a jövőre nézve (ahogy ez a GDC-n ki is derült ... mindenki a Havok-ot figyelte a PhysX Apex bemutató pedig nem éppen telt ház mellett volt lezavarva). És nem azért érdekelte a fejlesztőket a Havok, mert nekik ez új, hanem azért, mert orrba-szájba hangoztatták, hogy a Havok rendszer platformfüggetlen. Nyilván ha az NV akar a PhysX-el kezdeni valamit, akkor ki kell szakítania a CUDA-ból.

Elmegyünk a sajtótájékoztatókra, bratyizunk velük, de a marketingmaszlagot nem adjuk át a világnak, mert az nem érdekel senkit, max a fanokat. Innentől kezdve van egy szoros határvonal a dolgokban, amelyik technika nem épül ipari szabványra, az elgondolás szinten halott, tehát nem veszünk róla tudomást, mert az elmúlt 10-14 év tapasztalata alapján minden ilyen (nem szabványos) megoldás kihalt. És ezek bizony tények, ha már egy megoldás át ment volna a szitán, akkor más lenne a nézőpont, de az összes gyártói technológia a kukában végezte, mert jött rá egy általános független megoldás (ide is megérkezett az OpenCL és év végére már lesz Compute Shader, tehát baromira nem nehéz kitalálni, hogy a CUDA és az Ati Stream az bukó a PC-s VGA piacon). Nem véletlen, hogy az NV felvetette a Physx OpenCL-be való pártolását, mert az Intel és az AMD a Havok-ot beteszi a szabványos platformokba. Itt látszanak egyelőre az érdekkülönbségek. Az Intelnek és az AMD-nek az számít, hogy a Havok elterjedjen, az NVIDIA-at nem érdekli a PhysX, ennek a technikának csak az a célja, hogy az AMD-t és utána az Intelt rávegye a CUDA támogatásra, hogy az NV saját rendszere legyen a szabvány teljesen GeForce-ra optimalizálva. Innentől kezdve az AMD jöhet az kis chipekkel és a "kivégzős" Sweet Spot politikájával, a Multi GPU-s skálázást megölik a CUDA-n és éljen, az NV nyert. Ez az egész lényege. Csak a CUDA valamiért nem akar terjedni a játékfejlesztők körében. Még mindig a DX a fő platform és az OpenCL, Compute Shader felé kacsingatnak a jövőre nézve (ahogy ez a GDC-n ki is derült ... mindenki a Havok-ot figyelte a PhysX Apex bemutató pedig nem éppen telt ház mellett volt lezavarva). És nem azért érdekelte a fejlesztőket a Havok, mert nekik ez új, hanem azért, mert orrba-szájba hangoztatták, hogy a Havok rendszer platformfüggetlen. Nyilván ha az NV akar a PhysX-el kezdeni valamit, akkor ki kell szakítania a CUDA-ból.

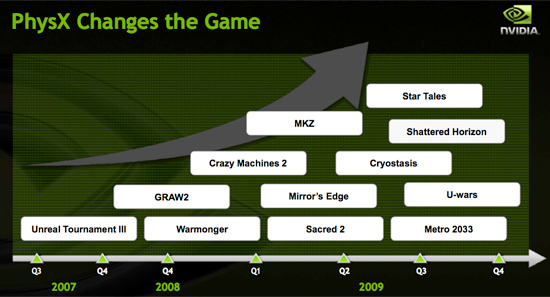

Rosszul értelmezed a PhysX támogatását is. Az, hogy egy játék a PhysX API-re épül nem jelenti automatikusan a hardveres támogatást, ugyanis az platform, tartalmaz egy szoftveres és egy hardveres kódolást. Ergo a fejlesztő eldöntheti, hogy használni akarja-e a hardveres fizikát vagy nem. Speciel UE3-as játékból ami használja a fizikai gyorsítást az az UT3, a Mirror's Edge és majd a Star Tales (valamikor kijön idén). Ezenkívül támogatja a GeForce gyorsított fizikát: Ghosh Recon Advanced Warfighter 2, Warmonger, Sacred 2, Cryostasis. Emellett PhysX lesz még idén: Shattered Horizon, Metal Knight Zero, Metro 2033, U-wars. Van még több hardveres PhysX játék is, de az kompatibilítási problémák miatt csak a PhysX kártyán tud működni. Természetesen a PhysX kártyát az új GeForce PhysX játékok is támogatják, bár itt meg kell jegyezni, hogy normális kód csak az Unreal Engine 3-ban van a gyorsítóhoz írva. Ez gyakorlatilag azt jelenti, hogy helyenként szart sem ér a rendszer (pl.: Cryostasis, Sacred 2). - na jó a szarnál azért többet ér, de csodát ne várjatok.

Ezenkívül még jön még pár Physx játék idén, de ezekről az NDA miatt nem nyilatkozhatom ... és a DX10.1-et, valamint a tesszellátort támogató játékok is titkosak. Sry srácok, de megkötötték a kezemet ... még a számukat sem mondhatom el ... és ezt komolyan veszik (priviben sincs infó ), majd ha lejárnak az NDA-k, akkor elárulom.

), majd ha lejárnak az NDA-k, akkor elárulom.

Az RV870 - GT300-ról még korai beszélni. Eleve semmi hivatalos anyag nincs, hogy gyakorlatilag milyen chipek lesznek. Ha a nem hivatalos infókat vesszük alapul, akkor gázban van az NV, mert az RV870 az 1200 SP-jével kb. 160-170 mm^2 lesz. Amiből egy X2 baromi olcsó, és kurva gyors. A GT300-at az 512 SP-vel és megváltozott ütemezővel 430 mm^2 főlé érdemes tenni, de inkább 450-460-at mondanék, mert a textúrázócsatornáknak mostantól egy helyett négy szűrő kell a DX11 miatt, ami szintén tranyózábálás. Plusz ugye ott van a cache szervezés, ami az infók szerint továbbra is blokkszintű. Mellesleg, ha az AMD MCM modult csinál az RV870-ből, akkor egy RV870 X4-re is lehetőség van, amire a múlt évi infók szerint idén ősszel lenne támogatás a 8 utas CrossFireX személyében. Továbbá nem említettük, hogy az októberi rajthoz már a Juniusi tape out-nál kvázi hibátlan chip kell, így 6-7 revíziót lehet készíteni amiben javítani kell a felmerült hibákat. Általában 10-12 revízió készül egy chipből a végleges forma előtt. Mérnöki csoda, ha ezt az NV megcsinálja. Az AMD RV770 startja előtti hirtelen órajelemelés gyerekjáték volt anno ehhez képest.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

VinoRosso

#261

üzenetére

VinoRosso

#261

üzenetére

Tisztázzunk pár dolgot. Egy DX11-es játék szebben néz majd ki és gyorsabban fog futni a DX10.1-es Radeonon, mint a DX10-es GeForce-on. Másrészt ... szerencsére a DX11-ről lehet beszélni, mert nincs róla NDA. Két stúdió dolgozik DX11-es motoron (illetve egy DX10-ből fejlesztett változaton ... ez nem jelent majd problémát, mert a DX11 a DX10 kiterjesztése - tehát nem ilyen kamu DX10 lesz, mint a DX9-nél volt szokás), ahogy az a GDC-n kiderült, ők a DICE (Frostbite Engine) és a Techland (Chorme Engine). Az DX11 váltás egyelőre azért kell, mert az AMD Tesselation SDK nem működik a GeForce-on (világos, hisz AMD SDK

![;]](//cdn.rios.hu/dl/s/v1.gif) ), így a DX11-gyel, kell majd életre kelteni a GT300 tesszellátorát. Ez nem sok munka, a Tessellation SDK-ből könnyű DX11 kompatibilis kódot csinálni. Legalábbis a DICE szerint a DX11 portolás három óra volt. Egyelőre több dologban nem gondolkodnak a DX11-nél, mert a Compute Shaderen kívül, minden szükséges dolgot tud a DX10.1 (illetve a Compute Shadert is támogatja, csak némi megkötéssel). Gyakorlatilag az új textúratömörítési eljárások szintén emulálhatók a DX10/10.1-es karikon ... persze némileg lassabban. A Gather4 mint legfontosabb dolog, ott van a DX10.1-ben.

), így a DX11-gyel, kell majd életre kelteni a GT300 tesszellátorát. Ez nem sok munka, a Tessellation SDK-ből könnyű DX11 kompatibilis kódot csinálni. Legalábbis a DICE szerint a DX11 portolás három óra volt. Egyelőre több dologban nem gondolkodnak a DX11-nél, mert a Compute Shaderen kívül, minden szükséges dolgot tud a DX10.1 (illetve a Compute Shadert is támogatja, csak némi megkötéssel). Gyakorlatilag az új textúratömörítési eljárások szintén emulálhatók a DX10/10.1-es karikon ... persze némileg lassabban. A Gather4 mint legfontosabb dolog, ott van a DX10.1-ben.Sajnos az NV az elmúlt hetek alapján nagyon ramaty helyzetben van. Voltam a héten konferencián. Most már nem az átlagos teljesítménnyel, hanem egy-egy megvett játékkal támadnak a zöldek.

Az NV GF GTX 275 PR doksija egyszerűen teljesen más elvre épült, mint a régiek. Még a GTX 295 megjelenésénél fel voltak sorolva a top játékok és le volt mérve a a HD 4870 X2 teljesítménye. (Természetesen itt bevett szokás, hogy szándékosan olyan beállításokat keresnek, ahol a saját kari nyer. Ez nyilván PR doksi, az AMD is ezt csinálja. Eredményt ugye egyikük sem tud hamisítani, mert ellenőrizve vannak, de nyilván olyan beállításon tesztelnek amit jónak látnak, csak ugyanazok legyenek a körülmények, mindkét rendszernél.)

A GTX 275-nél már ilyenről nem találtunk infót a PR anyagban, mert az NV alig talált olyan beállítást, ahol a HD 4890 verve volt. Két játékért meg kb. felesleges grafikont csinálni, mert még a végén rákérdeztek volna, hogy miért hiányzik a Crysis Warhead, Enemy Territory Quake Wars ... stb.

Ettől függetlenül sírva röhögtek az anyagon az újságírók, mert le volt tesztelve az UT 3 Physx-es pályákkal, a Mirror's Edge Physx móddal, meg a Physx-es techdemók. És képzeld nyertek a GeForce-ok a procival számoló Radeonok ellen.![;]](//cdn.rios.hu/dl/s/v1.gif)

Ha lehet úgy fogalmazni jelenleg az NVIDIA játékokat vesz ... kb. havi egyet, és az összes többi programban el lesznek verve. Nem tudnak jönni a PR anyagokban az ár/teljesítménnyel, mert a konkurens Radeonok gyorsabbak és olcsóbbak. Árcsökkentésről meg szó sem lehet. kb ... ez a mai siralmas helyzet. A jövőbeli PhysX-ről meg azért nem beszélnek, mert kérdéses a jövő. Miért támogasson egy fejlesztő egy olyan technikát, ami a többségnek nem áll rendelkezésre.

A Crytek sosem fog Physx-et használni. Maga a Boss mondta, hogy nem akarnak külsős technikát alkalmazni, továbbra is saját rendszert csinálnak mindenre.

A PhysX-nek amúgy van menekülő útvonala. Ki kell szedni a CUDA-ból és életben marad. Ellenkező esetben meg tényleg nem nehéz belátni mi lesz vele. Nem tudok olyan technológiáról, amit nem végzett volna ki egy független platformra épülő.

Mellesleg az NV-nek sokkal jobb GeForce eladási mutatók kellenének a CUDA-s Physxre. A jelenlegi HD 4890:GTX 275 féle 30:1 az baromi kevés. A többség gépe a lényeg a fejlesztőknek.

Mellesleg az NV-nek sokkal jobb GeForce eladási mutatók kellenének a CUDA-s Physxre. A jelenlegi HD 4890:GTX 275 féle 30:1 az baromi kevés. A többség gépe a lényeg a fejlesztőknek.Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

VinoRosso

#264

üzenetére

VinoRosso

#264

üzenetére

De a DX10.1-es kártya kvázi ugyanazt a teljesítményt és képminőséget hozza a DX11-ben, mint egy natív DX11-es. Ezzel szemben a DX10-es kártya lassabb lesz és gyengébb képminőséget állít elő.

Ráadásul a Tesselation SDK-vel az első játékok alatt egyetlen HD Radeon nem szenved hátrányt, mert a legelső DX11-es címek a tesszellátor használatára törekednek. Márpedig a tesszellált felületnek az xBox 360-on is kell működni, így az eljárás megfelelő lesz az összes tesszellátorral rendelkező kártya számára.Tévedés a gyártók nem vesznek játékokat. Kapcsolatokat teremtenek, de a játékért még soha senki nem fizetett. Olyan eset volt, amikor az NV némi anyagi juttatás fejében megkérte a fejlesztőt, hogy küldjék el az AMD csapatát, ha bejelentkeznek (Hellgate: London) ... de ennyi volt. A PhysX támogatását viszont meg kell venni. A Mirror's Edgebe is 5 milláért rakták bele. Világos, hogy megkérik az árát a fejlesztők, mert kvázi kizárják az elterjedtebb rendszer felhasználóit a max. grafikából (ugye teljesen világos, hogy a PhysX az nem fizikaként, hanem grafikaként van jelen - de ez lényegtelen). Az NV-nek konkrétan venni kell mostantól a játékokat, ha eladást akar generálni, mert ezek nélkül nincs az az ember, aki drágábban vesz GeForce-ot a gyorsabb Radeon mellett (fanokra ugye nem lehet építeni ... általában az emberek nagy többsége a saját érdekét nézi).

A Crytek TWIMTBP szerződése már a múlt évben lejárt és nem újították meg. Ellenben beálltak az AMD-hez, mivel a CryEngine 3 főleg az Xbox 360-hoz készül, és a Xenos az AMD fejlesztés. Nyilván nem kérdés, hogy az AMD ismeri a legjobban a rendszert. A Crytek a saját érdekét nézi, az NV-t kb. leszarja. Jelenleg az AMD tud nekik segíteni.

A fizikáról a GDC-n nyilatkozott Yerli, amikor megkérdezték, hogy vesznek-e PhysX-et/Havok-ot ... arra rögtön rávágta, hogy nem ... válasz röviden: teljesítményben sokkal jobban járnak egy saját rendszerrel, mert azt a motor igényei szerint fejlesztik. Bár azt megjegyezte, hogy a Havok bemutató nagyon tetszett neki, de nem lát benne olyan dolgot, amit a jelenlegi saját fejlesztésű rendszerük ne tudna megcsinálni.Az őszi GT300 starthoz mondom, hogy kvázi hibátlan type out kell. Ilyen a történelemben sohasem fordult elő. Nem mondom, hogy nem lehetséges, de a realitás talaján maradva 40 nm-en a január a reális időpont. Persze ettől most vonatkoztassunk el. Jön a GT300 és kész. Mit fog adni a DX11 az elején. Tesszellátor támogatást ... a többi újításhoz idő kell, mint a DX10 esetében. Persze nem sok, de minimum egy év. Eleve a fejlesztők a gyártók dokumentumai alapján dolgoznak, jelenleg a Techland és a DICE aki hozzáfogott a DX11 portolásba, de messze nem viszik túlzásba. Mellesleg ez a két stúdió DX10 motort csinált, tehát AMD partnerek. Ugye csak az AMD-nek vannak fejlett DX10 dokumentációi, így a stúdiók azoktól a cégektől kérnek segítséget, akik segíthetnek nekik. DX10-ben pedig az AMD a top, így máshoz nem tudnak menni. Az NV a CUDA-val volt elfoglalva, így az ő rendszerprogramozói nem annyira képzettek, mint az AMD-sek.

A userek tömkelege nem fog venni DX11-es karit. Pláne nem méregdrága NV-t, mert a GT300 nem az olcsóbb szegmensbe nevez (gazdasági válság stb.). A középkategóriás DX11 chip pedig az NV-től nem az év végén jön. Persze konkrét infót megint nem mondhatok, de általában 3-4 hónap szokott lenni az átfutás. Talán most sem lesz több.

Mellesleg ott egy kellemetlenség is, az RV870 személyében, ami várhatóan előbb jön a GT300-nál. Elméletben az AMD a GT300 startra időzítheti az X2 verziót. Mi a garancia arra, hogy a GT300-at választják. A PhysX annyira nem érdekli az embereket, nézd meg a felméréseket. Mindenki a teljesítményre hajt elenyésző tömeg választ a DX10.1+tesszellátor miatt kártyát, és még elenyészőbb a PhysX miatt. A vásárlók többsége szerintem azt sem tudja mi az a DirectX, de hallotta, hogy valami jó dolog, és nézi a minél nagyobb számot. A PhysX-ről meg kb. fogalma sincs ... azt sem tudja, hogy létezik.

A G80 az eleve az Ati csődjére ment. Csak azért nem mentek a vörösök a csődbe, mert az AMD-nek elég tartaléka volt. Ha a felvásárlás nem történik meg, akkor már rég az NVIDIA az egyeduralkodó a CUDA-jával.

És a DX az melyik grafikus processzorgyártóhoz kapcsolható? Azt az MS fejlesztette, ahogy leírod, aki nem gyárt grafikus processzort ... ergo a cég totálisan gyártófüggetlen (bár durván AMD puszipajtás, de ezt most hagyjuk

![;]](//cdn.rios.hu/dl/s/v1.gif) ) a PC-s játékpiac életben tartása a célja.

) a PC-s játékpiac életben tartása a célja.tlac: A HD Radeon tesszellátort a Tesselation SDK-n keresztül lehet támogatni. Ha van a játéknak Xbox 360 verziója, akkor copy-paste, ha nincs, akkor meg kell írni a kódot. Nyilván DX11 hiányában mindenki a Tesselation SDK-n nyomul, így a jelenleg fejlesztett projektek tesselation kódja meg lesz írva a Radeonokra, és a DX11 kód lesz az extra meló. De ez a DICE szerint 3 óra pluszmunka (konkrét tapasztalat birtokának hiányában én elhiszem nekik

)

)

A DX11 tesszellátor egyébként maximum 64x-es tesszellálásra képes, míg a Xenos 15x-ös.[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

Hát nem lesz jól látható, mert a 15x-ös is durván jó minősége ad, csak úgy mondtam, hogy az egység különbözik. Alapvetően ez az eltérés jelen van.

schwartz: Ha ez nem így lenne, akkor nem 30:1 lenne a HD 4890:GTX275 eladási mutató.

(és ezt már nem szabad az gyenge beszerezhetőségre fogni, mert még a múlt héten is ilyen eredményeket küldtek a kereskedők) Ennek a csatának az NVIDIA részéről már nincs értelme ... logikátlan az árverseny is hiszen az AMD sokkal olcsóbban gyárt. Az egyetlen kiút a GT300. A Q2-től persze annyiban egyszerűbb lesz az NVIDIA-nak, hogy a TSMC-nél már csak feleannyi chipet gyártat, mint a Q1-ben, bár még így is sok marad majd raktáron.[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

Sweet Lou 6

#279

üzenetére

Sweet Lou 6

#279

üzenetére

Addig meg elleszünk az aknakeresőn mi?

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

Sweet Lou 6

#282

üzenetére

Sweet Lou 6

#282

üzenetére

Persze ... a Q4-gyel megcsapta őket a probléma szele. Ők is tudják, hogy nem megy jól. Meg a vezetőség úgyis megpróbálja kiegyensúlyozni a negyedéveket. Pénztartalék az van, nem bőséges be egy időre elég.

Igazából az Intel is csak szívatja az NV-t, csődbe tuti nem fogja vinni, mert okosabbak a zöldek annál. Csak finoman sugallják nekik, hogy már nem szívesen látott vendég a PC-s piacon ... "Maradhatsz, de szopni fogsz."![;]](//cdn.rios.hu/dl/s/v1.gif)

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

VinoRosso

#288

üzenetére

VinoRosso

#288

üzenetére

Az, hogy wikipédia.

A HL2 baromira nem így zajlott. Tudom, mert elmondták nekem (egyszerű reklámszerződést kötöttek, amiben az volt benne, hogy a Valve játékok beállítómenüjében be kellett rakni egy "legjobban ATI-val fut" feliratot). A Valve azért ment az AMD-hez (ATI-hoz ... lényegében mindegy), mert a DirectX 9-es Source motor alatt tudták, hogy bolhafing az FX teljesítménye, így az NVIDIA semmilyen segítséget nem tudott volna nyújtani, mert szar volt az architektúra az erős shader terhelésre.

A HL2 baromira nem így zajlott. Tudom, mert elmondták nekem (egyszerű reklámszerződést kötöttek, amiben az volt benne, hogy a Valve játékok beállítómenüjében be kellett rakni egy "legjobban ATI-val fut" feliratot). A Valve azért ment az AMD-hez (ATI-hoz ... lényegében mindegy), mert a DirectX 9-es Source motor alatt tudták, hogy bolhafing az FX teljesítménye, így az NVIDIA semmilyen segítséget nem tudott volna nyújtani, mert szar volt az architektúra az erős shader terhelésre.

A Doom 3 is baromság, olyannyira, hogy John Carmackről nyíltan lehet tudni, hogy nem egyezik meg senkivel sem reklámszerződésben, sem más támogatásban. Egyszerű munkakapcsolatról lehet szó nála maximum, ami nem hozza hátrányos helyzetbe a konkurens vállalatok termékeit. Carmack külön render rutinokat írt anno a piacon lévő kártyákhoz. Volt az alap ARB a régi termékekhez (GF3, GF4 stb), az NV30 (GF FX), az R200 (Radeon 8500/9000), és az ARB2 a többi Radeonora illetve a jövő grafikus kártyáira.Hát rosszul tudod, mert a Crytek a CryEngine 3-on dolgozik, és jelenleg folyamatosan az AMD segítsége kell, mert azt a poligontömeget, valahogy mozgásba kell hozni az XBox 360-on. Ebben hogy tudna segíteni az NVIDIA? Azt sem tudják, hogy a Xenost, hogy kell megfelelően programozni. Ellenben ezt a legjobban az AMD tudja, hiszen ők tervezték a lapkát, tehát tőlük kell segítséget kérni.

Akkor nevezzük a DirectX-et gyártófüggetlennek (nem Intel, nem AMD, nem NVIDIA, nem VIA).

Remélem, így már világos, miért lehetetlen a CUDA elterjedése. Mondj egy olyan rendszert a piacon, ami valamelyik gyártóhoz kapcsolódik, és komoly mértékben elterjedt a fejlesztők körében.

Remélem, így már világos, miért lehetetlen a CUDA elterjedése. Mondj egy olyan rendszert a piacon, ami valamelyik gyártóhoz kapcsolódik, és komoly mértékben elterjedt a fejlesztők körében.  Akár évekre is visszamehetünk.

Akár évekre is visszamehetünk.

Egyébként kb. helytálló, hogy az MS az nem valami találékony, mert általában lop, de a DX-et figyelembe véve. Mond mi gátolta meg abban, a Khronos Group-ot, hogy jobbat csináljon az aktuális DX verziónál? ... mert az MS biztos nem

Jó dolog mindent rákenni az MS-re, de alapvetően, nem mindig erről van szó.[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

schwartz

#293

üzenetére

schwartz

#293

üzenetére

És hol a glide? Amint jött a DX kihalt. A 3dfx abba halt bele, hogy nem volt képes felfogni, a glide vesztét.

Crytek: A Techland azt mondta, hogy a motorba most építették be a tesszellátort, de még nem döntötték el, hogy használni fogják-e. Először az új Call Of Juarezt kell befejezni, mert az ubi nyárra kéri.

Ellenben a Tesselation SDK kód aránylag könnyen portolható DX11-be, így előfordulhat, hogy ezek a játékok DX11-esek lesznek.

Úgy tom, hogy a DX11-gyel a a DICE és a Techland foglalkozik jelenleg, a többiek még nem merültek bele. Most alapvetően itt az is része a dolognak, hogy a Frostbite és a Chrome Engine 4 az normális DX10 motor, tehát nem nehéz alakítgatni.[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

Megjöttem.

- itt az eredeti koncepció. Kb. a megjelenést ki lehet nézni az alsó tengelyből. - persze ne vegyétek készpénznek.

- itt az eredeti koncepció. Kb. a megjelenést ki lehet nézni az alsó tengelyből. - persze ne vegyétek készpénznek.

Ezek egészültek ki még három címmel amivel az idei paletta be is zárult. Ezek a címek:

a Terminator Salvation, a Dark Void és a Darkest of Days.

A megjelenések még nem tutik, de ebben az évben jönnek az biztos.A Physx kártya támogatás az lesz, de kérdéses, hogy milyen mértékben. Ugye már a Cryostasisnál is kb. nudli volt a rendszer. Ezeket a játékokat az NV szó szerint megvette, azt pletyizik, hogy pár cuccért még tíz millát is fizetett. Azt szeretnék, ha GeForce-ot vennétek ... ami teljesen világos.

A Physx kártyával nekik nem dagad a bankszámlájuk. Nem mintha a GeForce kártyák hoznának bevételt, de legalább az részesedés gyanánt megjelenik a kimutatásokban.

A Physx kártyával nekik nem dagad a bankszámlájuk. Nem mintha a GeForce kártyák hoznának bevételt, de legalább az részesedés gyanánt megjelenik a kimutatásokban.

A gépigényről nem sokat mondanak, de nagy átlagban egy GF GTS 250 kell majd a gyorsított Physx-hez (persze itt érdemes alacsonyabb felbontásokban gondolkodni). Helyenként még a GTX 260 is kevés lesz (a Cryostasis-nál úgy néztem már az, oda még társkártyát is ajánlanak a VGA mellé).

Tehát összefoglalva:

Ha valaki 1680x1050-ben játszik, az Physx-re minimum egy GeForce GTX 260-at vegyen (216 SP ajánlott, mert számolásról van szó ... a 192 SP-s akár 20%-kal is lassabb lehet ebben). Nagyon minimum a GF GTS 250, de ezzel már több játéknál is grafikai kompromisszumok kellenek.

Magasabb felbontásra GeForce GTX 275-285 a megfelelő. Az AA-s és AF-es álmokat pedig GTX 295-nél, vagy GeForce társkártyával lehet dédelgetni.schwartz: A 3dfx sokkal versenyképesebb lett volna, ha a Voodoo 2 után mindig támogatják az aktuális DX verziót ... összedolgoznak az MS-sel, akkor nem csak az NV adott volna tippeket az API képességeire. De a Voodoo 5-höz még új Glide rendszert fejlesztettek. Így jön ide a Glide. Az lett e vesztük, hogy reménykedtek az API-jukban, amikor az már 1995-ben ... kb. halott volt.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

Beowulf_78

#307

üzenetére

Beowulf_78

#307

üzenetére

Biztos, hogy ment az SLI. Megvették a játékot, kaptak volna a fejlesztők, ha nem megy.

De amúgy tudtuk, hogy a Cryostasis az ilyen játék. Ez van.

Ez van.Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

schwartz

#311

üzenetére

schwartz

#311

üzenetére

Need For Speed (3-tól kezdve mind - jó is volt benne az akkori Voodoo 2-m szoftver renderre

... jött is a TnT a gépbe a csalódások után). Star Wars: Racer vagy Rogue Squadron (ezek sajna el sem indultak

... jött is a TnT a gépbe a csalódások után). Star Wars: Racer vagy Rogue Squadron (ezek sajna el sem indultak  - asszem öt hónap után lett driver, de én akkorra már kihajítottam a Voodoo-t, és osztottam a TnT-vel

- asszem öt hónap után lett driver, de én akkorra már kihajítottam a Voodoo-t, és osztottam a TnT-vel  ). 2001-ig most nem akarok elmenni, de nem lenne nehéz még egy jó adag játékot találni.

). 2001-ig most nem akarok elmenni, de nem lenne nehéz még egy jó adag játékot találni.Nem mondtam, hogy az API hibás, a 3dfx volt a hülye, hogy elhitte, hogy a Glide a gyártófüggetlen API-kkal labdába rúghat.

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

schwartz

#317

üzenetére

schwartz

#317

üzenetére

A teljesítménybeli elsőséget azzal vesztette el, hogy nem szólt bele a DX fejlesztésébe ... hagyta, hogy az NV és a többiek a saját megoldásaikra formálják a rendszert.

Az NV is ugyanezt csinálja éjjel-nappal a CUDA-jával foglalkozik a DX pedig kicsúszik a keze alól. A DX11-be egyetlen egy technológiát nem jegyeztek be az NV oldaláról. Még az A-buffer is az AMD kidolgozása alapján implementálták, pedig azt az NV már 3 éve kidolgozta.

Még az A-buffer is az AMD kidolgozása alapján implementálták, pedig azt az NV már 3 éve kidolgozta.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

schwartz

#319

üzenetére

schwartz

#319

üzenetére

A D3D7 támogatásának része a hardwareT&L. A 3dfx-nek együtt kellett volna dolgozni az MS-sel, mert senki sem akadályozta volna a partnerkapcsolatot. A pénzeket nem a megvalósíthatatlan elképzelésekre, és főleg nem a glide fejlesztésére kellett volna költeni.

rocket: A THQ-nak is van, a Take 2-nak is, sőt az Ubisoftnak is meg az EA-nak is. Miért ne legyen a SEGA-nak? ... ingyen lehet licenszelni a PhysX technológiát.

Még az APEX-et is.

Még az APEX-et is. ![;]](//cdn.rios.hu/dl/s/v1.gif) Másrészt ... a PhysX használata nem egyenlő a GeForce gyorsított fizikával. Több mint száz játék használja a PhysX-et, elenyésző mennyiségben alkalmaznak hardveres támogatást, és ebből még kevesebb használ GeForce gyorsított fizikát. Jelenleg majdnem 50 PhysX technológiát használó játék van fejlesztés alatt, töredékükben lesz GeForce PhysX gyorsítás. A nagy címeket nem lehet megvenni, mert túl drágák. Nem ér meg egy játék 10 milliónál többet, sőt szerintem még 1 millát sem ér meg, mert ettől nem lesznek jobbak az eladások, nem fog haszonnal gyártani az NVIDIA és nem lesz versenyképes a technológiájuk. Ezért adják ingyen a PhysX-et és az APEX-et, mert pénzért már nem kell a fejlesztőnek. Ha költ rá, akkor vagy csinál egy sajátot, vagy megveszi a Havok-ot a megfelelő CPU skálázhatóság véget.

Másrészt ... a PhysX használata nem egyenlő a GeForce gyorsított fizikával. Több mint száz játék használja a PhysX-et, elenyésző mennyiségben alkalmaznak hardveres támogatást, és ebből még kevesebb használ GeForce gyorsított fizikát. Jelenleg majdnem 50 PhysX technológiát használó játék van fejlesztés alatt, töredékükben lesz GeForce PhysX gyorsítás. A nagy címeket nem lehet megvenni, mert túl drágák. Nem ér meg egy játék 10 milliónál többet, sőt szerintem még 1 millát sem ér meg, mert ettől nem lesznek jobbak az eladások, nem fog haszonnal gyártani az NVIDIA és nem lesz versenyképes a technológiájuk. Ezért adják ingyen a PhysX-et és az APEX-et, mert pénzért már nem kell a fejlesztőnek. Ha költ rá, akkor vagy csinál egy sajátot, vagy megveszi a Havok-ot a megfelelő CPU skálázhatóság véget.

Az NV most nem tehet mást, nyomnia kell a PhysX-et. Minden héten többször hírbe kerülni, akár negatív lefolyásúba is. A prezentációkon is csak a saját GeForce PhysX játékokkal tud tesztelni, mert a többi népszerű játékban már kikapnak az árbéli konkurens Radeontól.

A tegnapi sajtóanyag volt az eddigi csúcs. A drágább GeForce GTS 250-et jelölték meg a Radeon HD 4770 ellenfelének (mindenféle teszteredmény közzététele nélkül írta az NV, hogy a két termék teljesítménye azonos - az Anandtech volt olyan kedves és tesztelt GTS 250-et a cikkében

- az Anandtech volt olyan kedves és tesztelt GTS 250-et a cikkében  ). Persze árcsökkentés lett volna, ha a partnerek egyhangúan nem vétózzák meg a javaslatot, ugyanis nem hajlandóak a veszteségeket benyelni.

). Persze árcsökkentés lett volna, ha a partnerek egyhangúan nem vétózzák meg a javaslatot, ugyanis nem hajlandóak a veszteségeket benyelni.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

A jelenlegi formában a PhysX az tényleg nudli, de a fejlesztők véleménye pozitív a technológiáról és a GeForce gyorsított fizikai számításról is. Egyedül az nem tetszik nekik, hogy ugyanezt egy másik megoldással meg kell majd csinálni a Radeonra is. Ergo ha a Physx-et kiszakítják a CUDA-ból (OpenCL támogatás jó lesz), akkor már a fejlesztők is komolyan használni fogják és komoly jövője lehet. Simán lehet versenyezni a Havokkal. Csak procifronton van előnye az Intel rendszerének (persze az erőforrásigénye is alacsonyabb, de ezeken lehet javítani).

Persze kérdéses, hogy ez a megoldás mennyire jó az NV-nek ... a CUDA-t kell elterjeszteni, minden más mellékes.Az Ati-nál nincs értelme teszteket venni. Egyrészt úgyis kiderül, hogy ki hazudik, másrészt ezzel a saját felhasználóbázisát csapná be. Az NV-nek kvázi minden mindegy már. Ha elterjed a CUDA, akkor ők lesznek a császárok, ha meg nem, akkor kb. nem érdekli őket az átvágott felhasználók véleménye, mert két-három év is tipliznek.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

Azért itt nem olyan egyszerű ez. Az NV-nek már nagyon rossz hírneve van. A szaksajtó zsigerből utálja már őket, mert folyamatosan zaklatnak, hogy ezt meg azt adjuk le hírül, aminek nincs semmi valóságalapja. Folyamatosan jön az Intel fika, de néha befut egy AMD is, amikor már nagyon reménytelennek látják a helyzetet. Nyilván a Radeonokon nagyon nehéz fogást találni. De ha már egy kóbor pistike beír valamilyen fórumba, hogy nincs megelégedve a Radeonnal, akkor az anyag bejárja a világot.

Most is jött a 2009 Q1 piaci eredmény, amin írták, hogy az AMD részesedése esett, míg az NV-é nőt. Jött a szokásos anyag. Ez valóban így van, de a Best Buy áruházlánc kimutatása szerint az NV az 50 dollár körüli kategóriában közel százszor több grafikus kártyát ad el, mint az AMD ... 80 dolcsi fölött viszont már AMD fölény van (160 dodó fölött nagyon). Nyilván az OEM gépeknél és a retail piacon is az olcsó termékből adják el a legtöbbet, így nem nehéz növelni a részesedést, de a fejlesztőkhöz ezzel nehéz odamenni, mert az 50 dodós VGA-val rendelkező gépek nem teljesen a célközönséget jelölik.

Az AMd atermékkínálatából most a játékosokra koncentrál, ha őket megnyerik (márpedig az eladások alapján erre brutálisan jó esély van), akkor a kevésbé tájékozott nép, nem az 1 GB-os 9400 GT-t veszi, majd hanem az 1 GB-os HD 4350-et.

Egyik se jobb a másiknál persze, de ez így működik. A gigabájt az alap, és még a GeForce név él az emlékezetben.

Egyik se jobb a másiknál persze, de ez így működik. A gigabájt az alap, és még a GeForce név él az emlékezetben.Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

schwartz

#328

üzenetére

schwartz

#328

üzenetére

A Tesselation SDK 2008 év végén lett elérhető a fejlesztőknek a végleges változat asszem idén márciusban készült el. A múlt évben egyedül az NHN Games tartott igényt a korai verzióra, a többiek inkább megvárták az SDK-t. Én is ezt tettem volna. Az xBox360-hoz csak most érdemes használni, a PC-re meg nem éri meg a dolog, ha a konzolra nincs használva. Egyik fejlesztőt sem érdekli az ATI szép mosolya, még egy combos csekk sem. Ha nincs SDK.

![;]](//cdn.rios.hu/dl/s/v1.gif) Most, hogy itt van lehet tanulmányozni, a Techland és a DICE már építi is be a motorjukba ... sőt ha jól tudom a DICE már be is építette.

Most, hogy itt van lehet tanulmányozni, a Techland és a DICE már építi is be a motorjukba ... sőt ha jól tudom a DICE már be is építette.rocket: A Best Buy-tól azért kérek kimutatást, mert ők az USA legnagyobb áruházlánca. Náluk reprezentatív csak az lehet, ha mindenkinek az eredményét elemzik és összegzik. Erre nincs kapacitás. Nekem meg pláne nincs ilyenre időm. A HD 4830 meg nem generált annyi eladást, mint a HD 4850, de ezt sejteni lehetett. Inkább mennek a drágábbra, de jobbra. A középárú karik közül a HD 4870 az eddigi legnagyobb eladást generáló termék a kereskedők, és a partnerek szerint is.

A játékok szempontjából mi a baj? Az azonos árkategóriában Radeon jobban futtat szinte mindent, mint a GeForce. Ennél miért kell több?

Új családnév nem biztos, hogy jó. Egyrészt baromi sok HD 4800 van még raktáron, így a tájékozatlanabb vevők azt veszik, a többiek meg a HD 4770-et. Így is fosnak a partnerek, hogy probléma lesz az új kariból, mert túl olcsó és túl gyors.

Emellett nyáron már kiadható lesz az RV870, amit picit majd csúsztatni is kell, a régi cuccok miatt.[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

Hát ami tervezett, arról annyit lehet tudni, hogy a játék megjelenése előtt egy héttel. De lehetnek olyanok is, amikről nem tud az AMD (pl.: a H.A.W.X. is csak úgy jött a semmiből).

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

Beowulf_78

#333

üzenetére

Beowulf_78

#333

üzenetére

Ezt már kitárgyaltuk nemrég. Ez a részesedés a teljes piacot jelenti. Az IGP-től kezdve a professzionális piacig. A Best Buy amerikai áruházlánc kimutatása szerint teljesen érthető az eredmény hiszen az 50 dollár körüli kártyák esetén százszor annyi NV kártya talál gazdára, mint AMD. Ennek megfelelően az 2009 Q1 legnépszerűbb terméke a 9400 GT 1 GB, a második legnépszerűbb a 9500 GT 1 GB, harmadik pedig az 512 MB-os HD 4870 (bár utóbbiból már közel feleannyi fogyott, mint az elsőből).

Az emberek 60%-a vásárol az alsóházból. Az AMD hiába ad el többször annyit a 100 dodó fölötti kategóriában, ha kikap a belépőszinten és a notipiacon. Az AMD GPU piaci részesedése leghamarabb szeptemberben fog nőni, amikor kijön a Windows 7, mert csak az AMD termékek kaphatnak Win 7 premium matricát.[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

Új hozzászólás Aktív témák

A topikban az OFF és minden egyéb, nem a témához kapcsolódó hozzászólás gyártása TILOS!

MIELŐTT LINKELNÉL VAGY KÉRDEZNÉL, MINDIG OLVASS KICSIT VISSZA!!

A topik témája:

Az NVIDIA éppen érkező, vagy jövőbeni új grafikus processzorainak kivesézése, lehetőleg minél inkább szakmai keretek között maradva. Architektúra, esélylatolgatás, érdekességek, spekulációk, stb.

... én nyárra vártam volna. Így viszont 2009 Q4-ig le van futva a dolog.

... én nyárra vártam volna. Így viszont 2009 Q4-ig le van futva a dolog.

Persze, hogy nincs. Attól, hogy egy kártya az egész ugyanúgy SLI-be működik ... Az AMD x2-se is Crossfirex, csak egy kariban.

Persze, hogy nincs. Attól, hogy egy kártya az egész ugyanúgy SLI-be működik ... Az AMD x2-se is Crossfirex, csak egy kariban.![;]](http://cdn.rios.hu/dl/s/v1.gif)

... a remény meg az emberi elme kvintesszenciája, ami egyszerre a legerősebb és a leggyengébb oldalunk.

... a remény meg az emberi elme kvintesszenciája, ami egyszerre a legerősebb és a leggyengébb oldalunk.

Amire ugye a jelenlegi architektúrák készültek.

Amire ugye a jelenlegi architektúrák készültek.

), majd ha lejárnak az NDA-k, akkor elárulom.

), majd ha lejárnak az NDA-k, akkor elárulom.