Hirdetés

- Kompakt vízhűtés

- Milyen notebookot vegyek?

- Milyen TV-t vegyek?

- Elkészült az SMIC 5 nm-es node-ja, de a kínaiaknak haszna nincs rajta

- AMD Navi Radeon™ RX 9xxx sorozat

- Tizenkét tányérra térne át a Toshiba a HDD-piacon

- Projektor topic

- Mesébe illő csodakábelt tervezett a GeForce-ok leégése ellen a Segotep?

- Bluetooth hangszórók

- És akkor a memóriapánik után beköszöntött a HDD-pánik

-

PROHARDVER!

Új hozzászólás Aktív témák

-

inf3rno

nagyúr

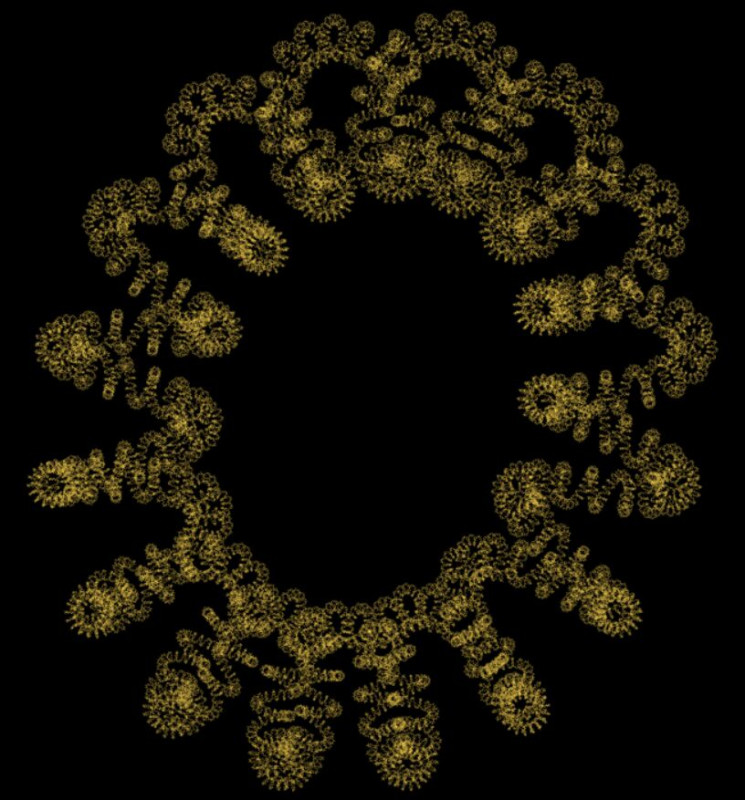

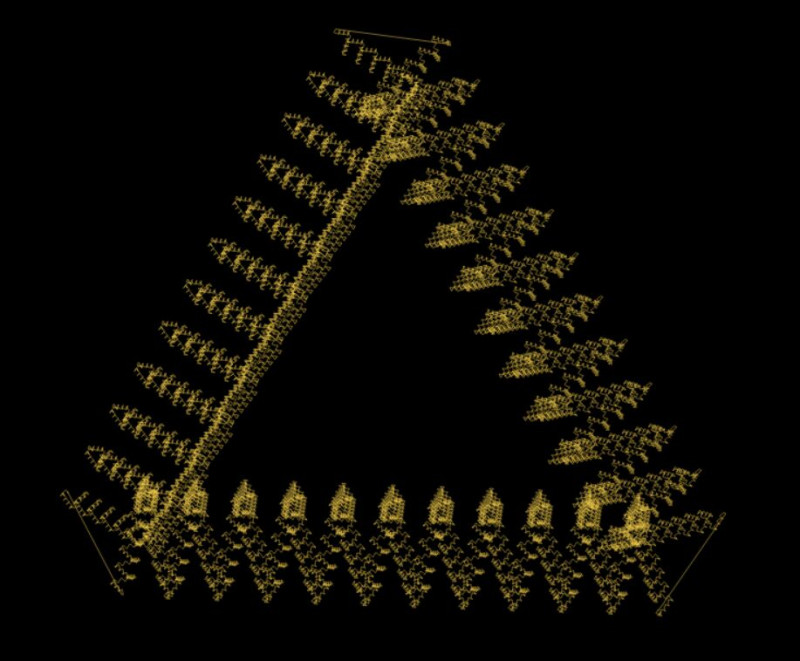

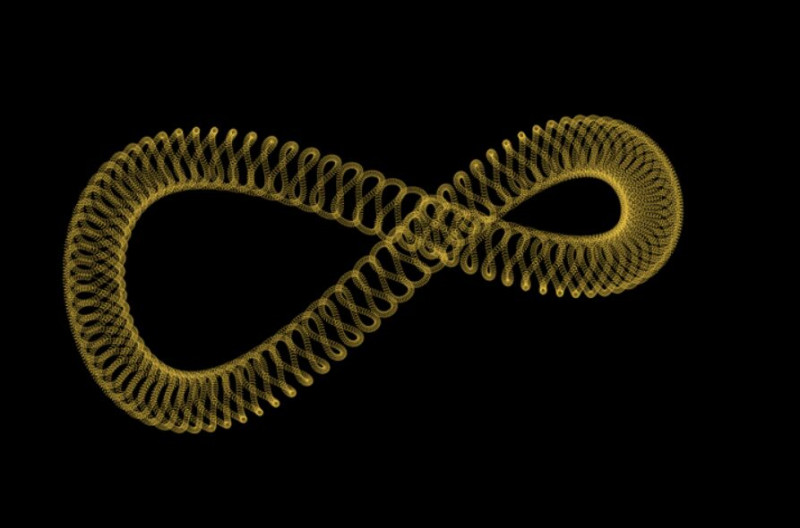

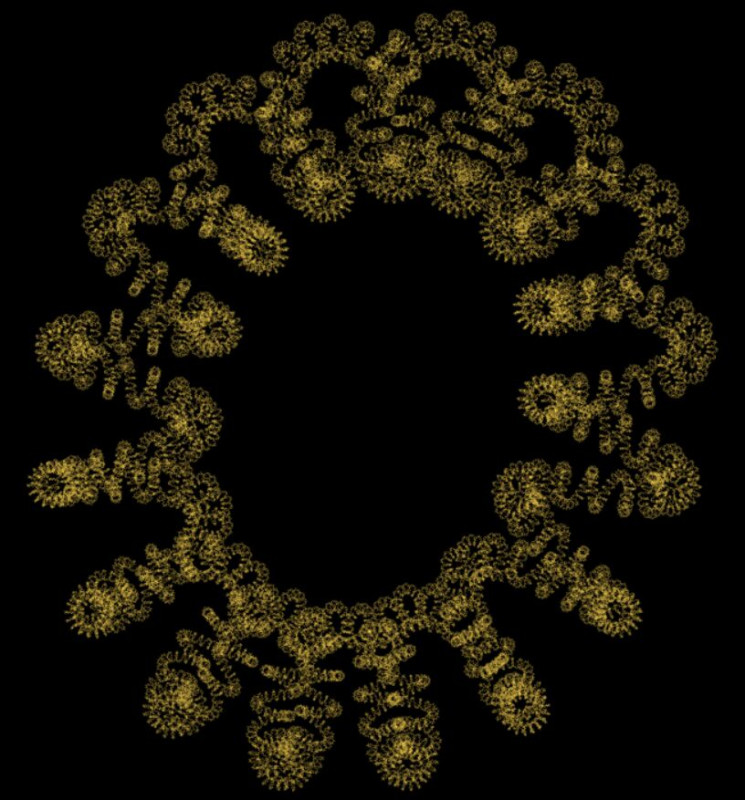

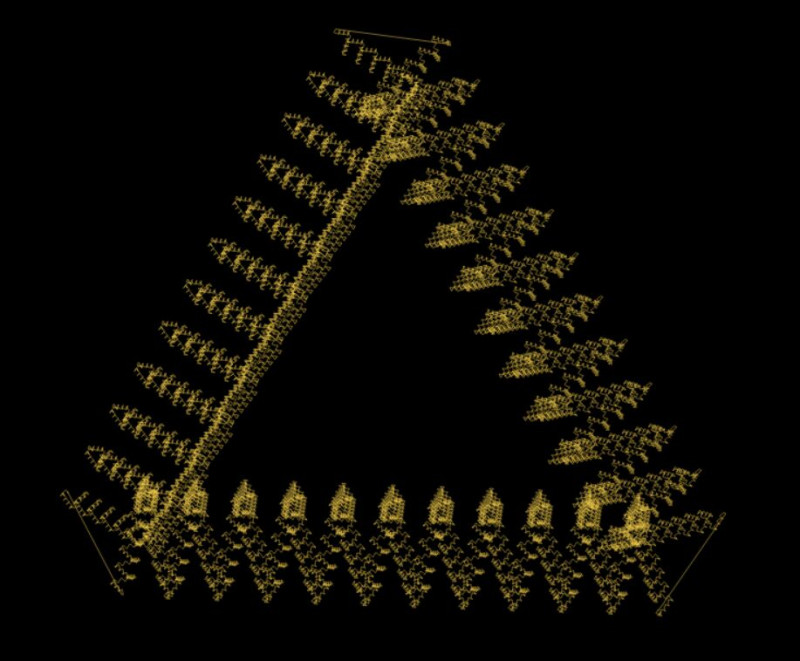

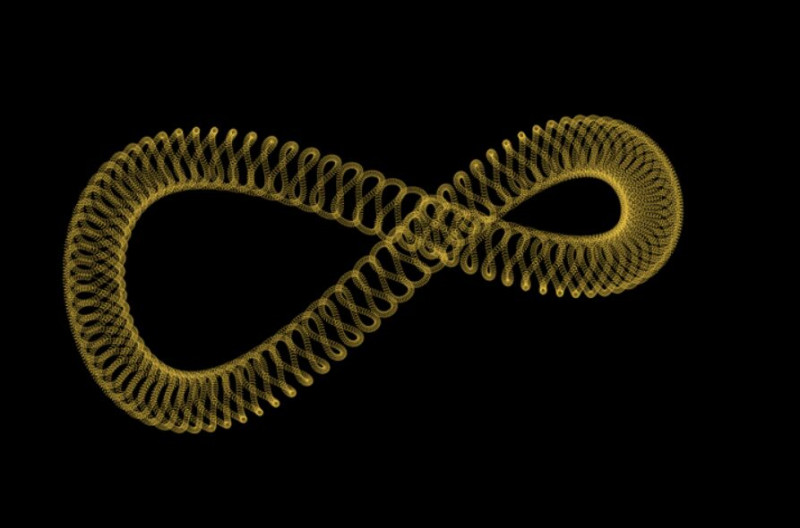

Nekem készen vannak a fraktáljaim:

A fizetési rendszerrel is haladtam sokat, meg elképzelhető, hogy még idén meglesz, mert egy időigényes feature-t kivettünk belőle és a v2-re átraktuk.

-

gergo5991

őstag

ma egy random app ötlet jutott eszembe, és geminivel rákérdeztem van-e ilyen a piacon stb, azt mondta kva jó ötlet, sok benne a fantázia, ilyen a piacon konkrétan nincs.

Nyilván minden igaz amit gemini mondott. Kérdésem az lenne, van itt valaki, akinek sikerült már ötletet pénzé tenni? de olyan szinten, hogy még egy file se lett létre hozva, magát az ötletet eladta. -

inf3rno

nagyúr

Én most spirális fraktál rajzolással küzdök. Nem vagyok annyira toppon a 3d geometriában, de haladok chatgpt segítségével. Néha úgy vagyok vele, hogy jobb lenne utána olvasni, mert túl okos akar lenni a chatgpt, és mindenféle hülyeséget összehord ahelyett, hogy a kérdésre válaszolna.

Fizetési rendszert hegesztek még, az eléggé lefáraszt. Még 2-3 hét van vissza abból a projektből. Remélem azért januárban végzek vele, mert már nagyon unom.

-

martonx

veterán

válasz

VikMorroHun

#20938

üzenetére

VikMorroHun

#20938

üzenetére

Ez tök jó, csak éppen továbbra sem írtál éppen semmi kontextust, hogy vajon milyen programnyelv, milyen keretrendszeréről beszélsz

Azért örülünk, hogy sikerült megoldanod valamit, valamiben, mutatókkal! -

VikMorroHun

őstag

válasz

inf3rno

#20930

üzenetére

inf3rno

#20930

üzenetére

Fun fact: miután leírtam a múltkoriakat, úgy döntöttem, elhagyom a mutatókat. Összesen 5 objektumról van szó, az kézzel is kezelhető. Szépen átírtam a függvényt switch/case szerkezetre (idejét sem tudom, mikor használtam ilyet utoljára); a 20-30 sorból lett 50+ sor, de működött. Miután

ezzel megvoltam, megértettem, mit is olvastam az egyik fórumon, amikor valakinek ilyen jellegű gondja támadt. A megoldás: mutatót kell használni. Igen, azt használtam, és nem működött. Ja, hogy az egész UI-t azzal kellene kezelni...

ezzel megvoltam, megértettem, mit is olvastam az egyik fórumon, amikor valakinek ilyen jellegű gondja támadt. A megoldás: mutatót kell használni. Igen, azt használtam, és nem működött. Ja, hogy az egész UI-t azzal kellene kezelni...

Ma este lettem készen vele. (De nem baj, hogy előtte annyit küzdöttem ezzel, mert a félig jó változat rávilágított néhány programhibára (amit ki tudja, mikor vettem volna észre nélküle), amik kijavítása meglehetősen fontos volt). -

válasz

cattus

#20936

üzenetére

cattus

#20936

üzenetére

Oké, az Angular is csak, csak nem az a useState/setState-es hülyeség, mint amilyen a React (és amilyen a Flutter). Egyszer írtam Flutterben egy egyszerű appot, két hétig volt fenn Play Store-ban, annyira megutáltam, hogy nem volt kedvem tovább fejleszteni. Már a forráskódja sincs meg.

Angular hagyományosan inkább a two way bindinget használja, mint pl. a JavaFX. Bár az igaz, hogy mióta vannak signalok, azóta ugyanott vagyunk, mint Reacttel.

-

cattus

addikt

válasz

urandom0

#20935

üzenetére

urandom0

#20935

üzenetére

Az Angular is egy reactive framework.

Mostanra amúgy eljutottunk oda hogy a legtöbb frontent framework kb. ugyanazt a paradigmát implementálja minimális eltéréssel, pl. a Vue ref(), a React useState, az Angular signal() meg a Svelte $state() kb ugyanúgy működik / néz ki.

-

válasz

martonx

#20934

üzenetére

martonx

#20934

üzenetére

Azt gondolom, hogy ezeknél az ismertebb frameworkoknél (beleértve a React-et, Vue-t, Svelte-t, Angulart, stb.) tudsz valami jobbat.

A Vue szerintem egyértelműen programozó barátabb, mint a React, mondjuk nem nehéz annak lennie, mert a React a JSX-el együtt egy gány tákolmány (bugos is, lassú is). A Svelte-t nem ismerem, de jókat hallottam róla.

Én, ha most kezdenék frontendes projektbe, az összes ilyen reactive frameworköt kerülnék, és szerintem Angularral állnék neki. -

martonx

veterán

válasz

urandom0

#20932

üzenetére

urandom0

#20932

üzenetére

Előre bocsátom, hogy böngészős és .Net vonalat ismerem. És ez azért erősen szubjektív tud lenni, pláne weben, ahol kismillió megoldás van ugyanarra.

Svelte és Vuejs ha böngészőről beszélünk (tudom, tudom ott a hype a React, előtte - mellette pedig az Angular, amik nem is rosszak, csak épp szerintem vannak náluk sokkal jobb megoldások).

.Net vonalon pedig a .Net Maui lett meglepően jó. -

-

inf3rno

nagyúr

válasz

VikMorroHun

#20929

üzenetére

VikMorroHun

#20929

üzenetére

A frontendet (fullstacket) az ilyenek miatt hagytam ott. Programozni nagyon szeretek, UI-t tákolni viszont nagyon utálok.

-

VikMorroHun

őstag

A programozás szépségei...

Van egy UI "ablak", ahol visszajelzést kap a felhasználó.

Ki akartam bővíteni, hogy belerakok néhány objektum mutatót, azokat meg egy tömbben kezelem.A következő változatokat sikerült összehozni:

- a tömb elemszáma folyamatosan nő (érdekes módon az indexek is, szóval a tényleges elemszám konstans, ahogy lennie kell, persze a ciklus 0-tól indul)

- jó a tömb elemszáma, de ha valami megváltozik, újrarajzolásnál szétesik a UI

- ha kihagyok egy utasítást az objektum mutatók létrehozásakor, amivel hozzáadnám őket a tömbhöz (mert látszólag kicsivel korábban már megtörtént), akkor minden remekül

működik, csak a tömb üres lesz, vagyis nem fogom tudni használni az objektum mutatókat (mert nincsenek). Bár a UI mutatja őket.

- látszólag minden remekül működik, nem esik szét a UI sem, csak ha leáll a program, memóriaszivárgás van.Olyan verziót még nem sikerült készíteni, hogy a fentiek közül egyik hiba se jöjjön elő.

-

axioma

veterán

Ujra itt van: [AoC]

Sajnos csak 12 nap lesz. -

-

coco2

őstag

És majd amikor a dap szerverei leállnak, mert "a kellemetlenségekért szíves elnézésüket kérjük" és társai, akkor a szolgáltatás határozatlan ideig elérhetetlen lesz, mert senki sem fog tudni bejelentkezni.

A közelmúltban volt valami kormányzati rendszerek leállásáról, amiről annyit hallottam nyilvánosan, hogy valami szerverben tönkrement egy alkatrész, és nagyon sajnálják. Csak kicsit kiröhögni való szakmai szemmel, hogy kormányzati szinten nem képesek 100.0% üzemstabilitást garantálni.

-

válasz

VikMorroHun

#20916

üzenetére

VikMorroHun

#20916

üzenetére

Szerintem az ötleted jó, de az már nem a te scope-od, hogy a user megfelelően kezelje az e-mail fiókját. Egy fiók/user, 2FA, ... ezeknek azért elég alapvető dolgoknak kellene lennie manapság.

-

coco2

őstag

válasz

VikMorroHun

#20916

üzenetére

VikMorroHun

#20916

üzenetére

Szerintem nem kellene túl szakbarbárnak lenned.

Azokat a problémákat nem informatikailag, hanem jogilag kezelik. Ha a cég rááll email ellenőrzésre, általában belerakja a felhasználási feltételekbe, hogy a felhasználó elfogadja a teljes jogi és erkölcsi felelősséget annak az email címnek a biztonságban tartásáért, amit a titkos funkciókhoz használ, és ha azt a fiókot feltörik, akkor azért ugyan úgy felel, mintha ő maga szándékosan követte volna el mindazokat a cselekményeket, amiket idegen személy követett el. És ott a pont.

A te gondolkodásodban ott a hiba, hogy a dáp is csak jelszavas. Egy jelszó helyett kettőt kell elkapni, esetleg hármat, esetleg még egy mobil számot is lenyúlni, igen, még több védelem, de végső soron egy patchwork, aminek sehol sincsen vége. Nincsen lezárva a kérdés. Kérdőjel van a sor végén ("mi van ha még azt is.. ?"), és nem pont ("lenyeled."), ami egy cég tevékenységét kiszámíthatatlanabbá teszi a jogi kockázatok miatt (beperelik, hogy a cég volt trehány, mert szoftver hiba és a többi).

Szóval nem. Nincsen igazad

Amit mégis ellenőrizhetsz, hogy a felhasználási feltételek és a jogi felelősség összhangban van-e kezelve az informatikai szerelékkel. Ha az nincsen meg, na azért viszont nyafoghatsz a főnöknek, hogy mégis mi az a trehányság?

-

VikMorroHun

őstag

Kiberbiztonság Magyarországon 2025-ben:

Cég: létrehoztunk egy portált, ahol az ügyfelek hozzáférhetnek (érzékeny) ügyféladatokhoz, és néhány dolgot meg is változtathatnak. Fontos, hogy megerősített e-mail címük legyen az adatbázisban, mert oda megy az értesítés, a jelszógenerálási utasításokkal együtt.

Én: Mi lenne, ha integrálnánk a DÁP-ot, mint erős ügyfél hitelesítő alkalmazást a rendszerbe?

Cég: Nem, az e-mail cím a tuti.

Az nem derült ki, hogy mi van, ha

- többen használnak egy e-mail postafiókot

- valaki bekap egy adathalász e-mailt, esetleg keyloggert is

- egy szakértőnek kedve szottyan jelszótörést gyakorolni (mindenkinél más, de mégis ismert a kiindulási adat és a jelszógenerálási módszer) -

Lien

aktív tag

Sziasztok, az itteni fórumozók véleményére lennék kíváncsi, akik jártasak a manuális szoftvertesztelésben. Mit láttok, vajon érdemes ebbe tanfolyamok nélkül, videókat, adatokat halászva belemélyednj, esetleg ebbe az irányba átképeznie magát az embernek? Milyen lesz a jövőbeli kilátása ennek a szakmának? Volt lehetôségem egy nagyon kedves ismerősöm napi munkájába belenézni, hogy milyen és még ha monoton is tetszene. Azért egy automata tesztelés nulla programozói tudással nem menne max sokkal később.

-

inf3rno

nagyúr

válasz

inf3rno

#20908

üzenetére

inf3rno

#20908

üzenetére

Mértem még közben egy bulk insertet. Az talán 5%-al gyorsabb, mint a JSON-os megoldás, viszont közel sem annyira kényelmes ér rugalmas, mint az INSERT SELECT a JSON-al, úgyhogy komplexebb helyzetekben nincs is igazán értelme foglalkozni vele.

Ami még érdekes itt, hogy egyes dátumokra mentek értékeket. Aztán bizonyos tábláknál összefüggő dátum tartományok alakulhatnak ki, amiknél azonos az érték. Azt találtam, hogyha 5+ dátumot átfog egy átlagos tartomány, akkor már megéri from-to tárolni, mert jóval gyorsabb az írása és az olvasása is. Batchben frissíteni úgy, hogy ne fragmentálódjon közepesen bonyolult, de azért megoldható.

Így bizonyos tábláknál a sima 100-as tranzakciós megoldáshoz képest 50x-es írási sebesség is elérhető. Ez kb. olyan, mintha 1 perc alatt bemenne, ami most 1 órába telik. Azért az nem semmi. A problémásabb tábláknál is 5-10 perc, ami várható 1 óra helyett.

-

inf3rno

nagyúr

válasz

dabadab

#20901

üzenetére

dabadab

#20901

üzenetére

Na benchmarkoltam, egyelőre csak annyit, hogy 10.000 rekord van, és másik 10.000-el írjuk felül INSERT ON DUPLICATE KEY UPDATE-el. A sebességek ilyenek voltak:

- egyesével beküldve: 6.000 record/sec

- tranzakcióban beküldve 100-as kötegekben: 10.000 record/sec

- tranzakcióban beküldve 250-es kötegekben: 10.000 record/sec

- JSON-ban beküldve CTE-vel 100-as kötegekben: 80.000 record/sec

- JSON-ban beküldve CTE-vel 250-es kötegekben: 95.000 record/sec

- JSON-ban beküldve CTE-vel 10.000-es kötegekben: 110.000 record/secNekem ebből az jött le, hogy JSON-ban fogom beküldeni CTE-vel ahelyett, hogy tranzakcióval szarakodnék. A 250-es köteg tűnik optimálisnak. Annyi talán még elveszhet, ha valami nagyon félrecsúszik, nem zabál annyi memóriát és sebességben elég közel van a 10.000-es köteghez.

Még csinálok majd egy 4. változatot, aminél először SELECT FOR UPDATE-el lekérem, hogy mi változott, aztán csak utána tolom rá az INSERT ON DUPLICATE KEY UPDATE-et. Így le tudom naplózni a tényleges változásokat is. De ezt csak akkor lépem meg, ha nem annyira lassú, mondjuk hozza legalább az egyszerűbb JSON-os változat 80%-át sebességben.

-

Sonja

nagyúr

Érdekes programozási nyelvet találtam.

"The only compiled language that lets you code with "sus", "slay", and "vibez" while achieving near-c performance."

-

inf3rno

nagyúr

válasz

dabadab

#20901

üzenetére

dabadab

#20901

üzenetére

Hát benchmarknál arra gondoltam, hogy beviszek 10 millió rekordot, aztán beküldök újabb 10 milliót úgy, hogy abból 50k ami tényleges változtatás. Nagyjából valami ilyesmire lehet készülni, max 25 millióra. Igazából a 100 az ilyen hasraütésre született vagy nem tudom mi volt a megfontolás mögötte, simán lehet, hogy 1000 vagy 10000 lesz helyette, most tervezzük újra a rendszert.

-

inf3rno

nagyúr

Nem akarok itt komplett SQL-t írni. Nagyjából úgy néz ki, hogy a SELECT-be rakok egy JSON-t a 100 értékről, azt beparsolja, aztán INNER JOIN-al illesztem a meglévő táblára az értékeket az ON részében meg lesznek a kulcsok meg az, hogyha az érték eltérő, akkor kerüljön csak kiválasztásra. Az INSERT ON DUPLICATE KEY UPDATE meg erre a kiválasztott halmazra íródik.

A 3-as jó lenne, de tudok nélküle élni.

Igazából csak kíváncsi voltam kinek mi a véleménye, megérzése. Így is úgy is le fogom benchmarkolni legalább az első kettőt.

-

JoinR

őstag

válasz

VikMorroHun

#20902

üzenetére

VikMorroHun

#20902

üzenetére

Van benne egy kis programminghorror vibe.

![;]](//cdn.rios.hu/dl/s/v1.gif)

-

VikMorroHun

őstag

Ha már log:

A programom 8-10 példányban fut egyszerre, de néha egyik-másik meghibásodik valamiért (nem jöttem rá, mitől). Nincs hibaüzenet, nincs összeomlás, egyszerűen csak megáll, és nem csinál semmit. Eléggé véletlenszerű a dolog; tesztelésnél nem jelentkezik, csak élesben, viszont sok pénzbe kerülhet, ha előfordul, úgyhogy csináltam egy kis log filet, amibe folyamatosan irkálják a dolgaikat, és mindegyik tudja ellenőrizni az összes többit. Ha valamelyik azt látja, hogy leállt az egyik, akkor újraindítja. Tök jó, működik (és így az is kiderült, hogy naponta többször is előfordul ez a hiba). Az egyiket én magam állítottam le, mert nincs rá szükség. A naplóban viszont benne maradt, és buzgón "indították is újra" a nem létező programot. Ok, írtam hozzá egy ellenőrző függvényt, hogy ha valami nem létezik, akkor ne akarják újraindítani, akkor se, ha a naplóban van róla adat. Eredmény: csak fél óránként próbálják újraindítani. Néha egy óráig semmi, aztán valamelyiknek megint feltűnik, hogy nini, hiszen ez leállt, akkor újraindítjuk! Ma írtam hozzá egy másik függvényt, ami kiüti a nem létező programhoz tartozó azonosítót a naplóból, hátha így már nem akarják újraindítani. Kíváncsi vagyok, mi lesz a jövő héten.

Néha egy óráig semmi, aztán valamelyiknek megint feltűnik, hogy nini, hiszen ez leállt, akkor újraindítjuk! Ma írtam hozzá egy másik függvényt, ami kiüti a nem létező programhoz tartozó azonosítót a naplóból, hátha így már nem akarják újraindítani. Kíváncsi vagyok, mi lesz a jövő héten.

Nyilván, ha törlöm a naplót, akkor nincs adat, ami alapján újraindítanák a nem létező programpéldányt, de azért kíváncsi vagyok, sikerül-e végre rendesen megcsinálni...

-

válasz

inf3rno

#20898

üzenetére

inf3rno

#20898

üzenetére

Teljesen tippre az első tűnik a gyorsabbnak, de 100 értéknél tulajdonképpen mindegy is.

Ha viszont tényleg le akarod mérni, hogy a te konkrét adatbázisodnál, a te adataiddal melyik a gyorsabb, akkor meg kapcsold be a slowlogot (egy long_query_time=0 után minden query slow querynek fog számítani) és nézd meg.

-

coco2

őstag

válasz

inf3rno

#20898

üzenetére

inf3rno

#20898

üzenetére

A use case-edet nem igazán sikerült leírni.

Ha adatok vizsgálata nélkül kiírhatnál, akkor csak kiírnál. Viszont ott van a (3), ami miatt azt feltételezem, vizsgálnod kell előbb. És azt viszont kihagytad a számítás egészéből. Így egy kicsit nehézkes tippet adni.

Az (1) esetében konkrétan hogyan gondoltad kiválasztani, hogy melyik értékek változtak ? Pláne hogy teljesítményen filozol, bizonyos környezetekben egyáltalán nem kicsike probléma az.

A (2) esete legalább érthető, felülvágnál valamit kérdés nélkül, és ha fix értékek vannak, én is azt csinálnám. Egybe írni a halom insert/update-et, aztán had szóljon. Viszont van egy tippem, hogy nem egészen úgy van az.

A (3) esetében gondjaid lehenek egy write-heavy környezetben. Az adatok már akkor mások lehetnek, mire hozzád megérkeztek, ha meg nem fogod tranzakcióval. Ha meg megfogod, azzal blokkolsz minden mást, ami ugyan ahhoz akarna hozzáférni. Teljesítmény szempontjából nem igazán előnyös.

És persze az a teljesítményoptimalizálás használni kell, vagy csak kirakatba tenni díszelegni?

-

inf3rno

nagyúr

Szerintetek melyik az optimálisabb MariaDB-nél sebesség, memória, cpu szempontjából? Van batchenként mondjuk 100 értékem, amiről nem tudom, hogy változott e, benne van e egyáltalán a táblában, stb. 1.) Küldök be egy 100-as INSERT SELECT ON DUPLICATE KEY UPDATE-et, ahol kiválasztom, hogy melyik értékek változtak, és csak azokat frissítem be egy kérésben. Itt a CTE-be mondjuk JSON-ként teszem be az értékeket, vagy SELECT UNION-al, édesmindegy nekem. 2.) Tranzakcióba teszek egyesével 100 INSERT ON DUPLICATE KEY UPDATE-et. 3.) Csinálok egy SELECT-et, hogy mi változott, aztán tranzakcióban beküldöm a 2-eshez hasonlóan csak azt. Ez jobb hibakezelés szempontjából, ha valamilyen SQL elszáll, de kevésbé gyors lehet, mint az INSERT SELECT.

-

lanszelot

addikt

Hello,

Milyen program nyelvvel lehet Windows 11 desktop widgetet irni?

Olyanra gondolok mint pl a stardock fences. -

coco2

őstag

válasz

VikMorroHun

#20894

üzenetére

VikMorroHun

#20894

üzenetére

A sztori szerint 3 kell hozzá. Egy feláll a létrára, és tartja az égőt, kettő meg felemeli a létrás, és körbeforgatják

-

VikMorroHun

őstag

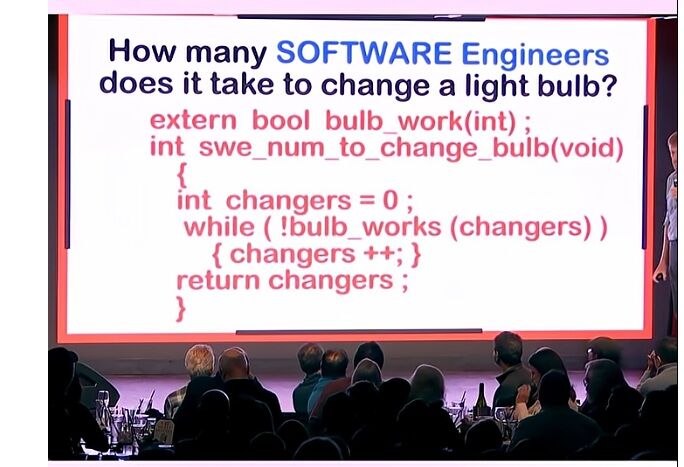

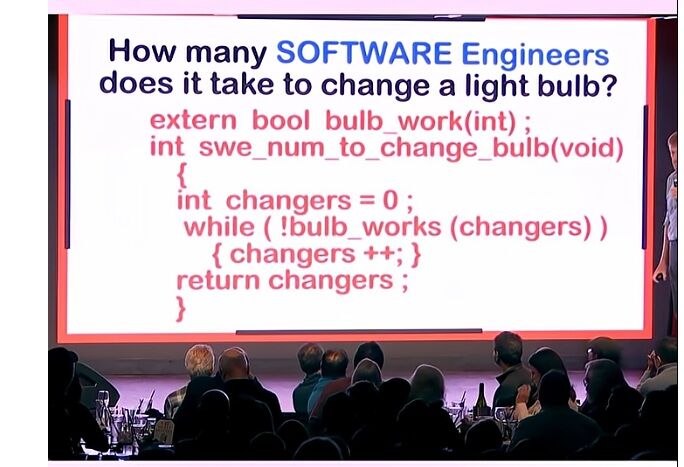

Ha valakit érdekel, itt van az összes.

-

coco2

őstag

válasz

VikMorroHun

#20892

üzenetére

VikMorroHun

#20892

üzenetére

>Azért itt hagyom, hátha másnak is hasznos lesz.

Tévedés gyanánt?![;]](//cdn.rios.hu/dl/s/v1.gif)

2 space, nem tab

-

VikMorroHun

őstag

Visual Studio 2022 kérdés:

Be akartam állítani, hogy szóköz helyett tabokat használjon. A dokumentáció szerint Tools-Options-Text Editor-All Languages-Tabs részen kell, de nem működik. Ok, megvan a válasz. Text Editor-Advanced-Use adaptive formatting kikapcs, és máris azt fogja használni, amit beállítok neki.

Azért itt hagyom, hátha másnak is hasznos lesz.

-

Azokból a játékokból a lore-t talán érdemes lenne megnézni az ifjú titánoknak.

Azok a játékok a lore-t kb. kompletten átvették Tolkientől (elég csak ránézni a címekre) meg asztali RPG-kből, akkoriban nem nagyon foglalkoztak azzal, hogy saját lore-t találjanak ki (aztán amikor igen, az akkor is egy nagyon vékony réteg volt az előzőekben említetteken).

-

btraven

őstag

Nagyon aranyos ahogy a játékot átnevezték valami informatikai névre hogy a rendszergazdik ne találják meg. Bár szerintem a név inkább editorra utal p-edit-5 [link]

-

inf3rno

nagyúr

válasz

martonx

#20886

üzenetére

martonx

#20886

üzenetére

Egyáltalán nem ragaszkodom az SQL-hez. Teljesen jó nekem a Neptune erre a projektre. A cyper lekérdezőnyelvvel már játszottam régebben neo4j-vel, úgy nézem, hogy ez is támogatja. Ami kérdéses inkább a fejlesztői környezet, de elvileg localstack-el vagy serverless-el megoldható lambda fejlesztés, adatbázisnak meg tök jó a neo4j. Fellövöm valamelyik héten ezt az egyveleget AWS-en, aztán rákötöm valamelyik domainemre. Kíváncsi vagyok rá.

-

coco2

őstag

válasz

inf3rno

#20884

üzenetére

inf3rno

#20884

üzenetére

Az ilyen típusú adathalmazokból statikus weblapokat szokás gyártani, amikben linkek vannak más weblapokra. Amíg rendesen felépíted a gyűjteményt, a weblap gyártás vezérléséhez és a linkek nyilvántartásához bizony kelleni fog valami adathalmaz kezelő. Nem kell sql, ha nem akarod, elég egy json, elvégre nem lesz szükség adathozzáférési konfliktusok lekezelésére, ha csak egyetlen munkaprocess fér hozzá az adatokhoz. Ha elkészült, nem fog már hozzá kelleni semmi más, mint egy statikus weblap hosting szolgáltatás. Gyakorló projektnek jó ötlet lehet, ha a főzőcske érdekel.

-

-

inf3rno

nagyúr

Mondok egy példát. Van egy pizza recept, amihez paradicsomszósz kell. A paradicsomszósz megvehető, de elő is állítható paradicsom sűrítményből vagy egész paradicsomból receptek alapján. Szóval igazából amikor egy receptet kérdezel le összetevőkkel, akkor valójában egy teljes gráf szeletet kérdezel le egy csomó alapanyagok előállításához való recepttel együtt. Ha versenyezni akarsz mondjuk egy nosaltyval, akkor kellenek az ilyen többlet szolgáltatások, hogy mondjuk ha van 2kg paradicsom otthon, akkor felajánlja, hogy főzzél belőle szószt ahelyett, hogy elküld a boltba kész szószért. Mondjuk nem biztos, hogy erre mindenkinek van igénye, én csak magamból indulok ki, hogy nem mindig van minden itthon és fogalmam sincs, hogy mit főzzek.

-

inf3rno

nagyúr

Ahogy nézem with recursive lekérdezéssel megoldható még abban is. Igazából én nem szeretném SQL adatbázisban megoldani, mert azok nem erre valóak meg leginkább azért, mert gyakorolni akarom a felhő alapú technológiákat. Akarok egy itthoni AWS és talán egy Azure accountot is gyakorolni.

-

inf3rno

nagyúr

válasz

martonx

#20878

üzenetére

martonx

#20878

üzenetére

Én most gondolkodok egy hobbi receptgyűjteményes projekten, hogy megnézzem melyik környezetben mik a lehetőségek. Az egész kb. 10-15 SQL tábla lenne. A neheze, hogy gráfban kell lekérdezni kb. 5-10 kapcsolat mélységig, hogy bármi hasznosat megtudjak. Szóval erre talán gráf adatbázis lenne jobb. Úgy nézem, hogy Azure környezetben van a Cosmos, AWS-ben meg a Neptune, ami ilyet tud, és mindkettő egész olcsó, ha valami nagyon minimumra veszem a használatot.

-

martonx

veterán

válasz

inf3rno

#20875

üzenetére

inf3rno

#20875

üzenetére

Azure Function kb. az AWS Lambda megfelelője. Az AWS Lambda egy komplett serverless futtató környezet. Az Azure Function nem komplett futtató környezet, inkább ahogy a neve is mondja egy saját SDK-n belül megvalósított funkciókra szolgál (a funkciók pont ugyanazok lehetnek mint AWS Lambdánál, azaz HTTP requesttől a storage eventeken keresztül mindenféle lehet), azaz kötöttebb, mint az AWS Lambda, cserébe egészen olcsó (elég nagy határon belül ingyenes). Ugyanolyan az árazása, mint AWS Lambdának, azaz futásidő közben elhasznált erőforrásért kell fizetni.

Ha a kötöttség nem jön be, akkor az Azure App Service az, ami az AWS Lambdához közel áll, viszont ez már inkább egy komplett webszerver. Ennek megfelelő árazással (nem a használt CPU + ram után fizetsz, hanem havi fixen szerver paraméterekért pl. 1 mag 2 Gb ram fixen havi 11 EUR). Szvsz ez a kettő Azure feature áll közel az AWS Lambdához, ami valahol e kettő között helyezkedik el.

S3 megfelelője az Azure Storage, amiben létezik Table Storage, ami egy filléres végtelenül buta NoSQL szerűség, inkább csak egy JSON tároló, ami tud minimális SQL szintakszissal keresni is magán belül. Filléres, rohadt gyors, cserébe egészen buta.

Szóval Azure-ön belül én egy Azure Function + Azure Table Storage-al állnék neki. Ezzel a párossal vélhetően kb. ingyen lenne az egész móka.De azon is gondolkoztam platformtól függetlenül, ha tényleg csak ennyi kell neki, hogy 10-15 másodpercenként valami adatot elérhetővé tenni HTTP-n keresztül, akkor miért nem generálja ezt ki a mostani szervere, és dobja ki egy static hostingba a json file-t (AWS, vagy Azure vagy bármi). Ettől kezdve azt bárki, bármilyen mennyiségben kb. ingyen le tudja kérdezni, akár DDoS-olni is tudja persze, csak nem fog számítani.

Mondjuk én kitenném ingyenes Vercel-be / Netlify-ba, ami ad CDN-t is, és máris probléma megoldva és nulla költsége van.

és nulla költsége van. -

inf3rno

nagyúr

válasz

martonx

#20874

üzenetére

martonx

#20874

üzenetére

Ja most nézem, tényleg el van szállva az ára a Redisnek és az RDS-nek is minimum 100 USD. AWS környezetben olcsósítva akkor maradhat az, hogy Lambda + S3(JSON/CSV) + Athena. Amennyire értem, hogy mit akar, gyakorlatilag elég neki annyi, hogy előállítja az adatot, bizonyos időközönként a játék szerver adatai alapján, aztán kiolvassa a legrégebbit, esetleg Athena-val még keresni is tud benne. Azure-al tisztában van valaki, hogy ott mik elérhetőek olcsón? Szeretnék abban is valamennyi tapasztalatot szerezni.

-

inf3rno

nagyúr

válasz

MasterDeeJay

#20872

üzenetére

MasterDeeJay

#20872

üzenetére

AWS Lambda kell, és ElastiCache-be betenni egy időzített folyamattal mondjuk percenként az adatot, aztán onnan kiszívhatja a lambda, és nem zavarja a játékszerveredet sem, ha szétDDOSolják a Lambdát. Már ha AWS a környezet. Amúgy ahogy írták DDoS-ra meg jó a CloudFlare.

-

-

válasz

MasterDeeJay

#20870

üzenetére

MasterDeeJay

#20870

üzenetére

> cloudflare mögé maga a weboldalt beraktam és minden szerver dns-ét. Bár a már feloldott ip-ket tudják támadni.

proxied modban nem kene, hogy lassak az a feloldott IP-t

-

Köszi a válaszokat!

Úgy épül fel hogy van egy fixip-s hely ahol fut az egyik játékszerver, van egy nemnatolt otthoni netes ahol fut a másik játékszerver és az mikrotik cloud dns-ével van összehozva saját domainel.

A webszerver ahw.hu-ról van totál ingyenes csomag. Domain meg tarhely.eu-s.coco2

Api token ezt szerintem meg tudom csinálni. Tanusítványt nem tud szerintem a httplistener.dabdab

A webszerver igyenes awh.hu tárhelyről van. Megnézem hogy annak milyen ip-i vannak viszont szerintem az ingyenesben nem teljesen fix.emvy

cloudflare mögé maga a weboldalt beraktam és minden szerver dns-ét. Bár a már feloldott ip-ket tudják támadni.Annyit megcsináltam hogy van egy cache a webszervernél hogy ne kérdezzék le a látogatók egyenként a szervereket hanem egy lekérdezés 10 másodpercig él azaz ha lenne 100 látogató akkor is csak pár lekérés megy 10-15 másodpercenként a szerverek felé. Ez a része védett jelenleg azaz a játékszervereket a weboldalról nem tudják ddosolni. Azaz magát a szolgáltatót igen de elvileg a játékszervereket onnan nem csak ha direktbe az játékszerver ipjeiket találják meg.

Tervben lenne az hogy ha a mod készen van akkor több szerver keresője lenne nem csak megjelenítő. -

válasz

MasterDeeJay

#20866

üzenetére

MasterDeeJay

#20866

üzenetére

Tegyed be Cloudflare mögé. Az ingyenes verzió is ad DoS védelmet, bár a WAF az havi 200 dollár (az már tud egy csomó szofisztikált dolgot).

-

válasz

MasterDeeJay

#20866

üzenetére

MasterDeeJay

#20866

üzenetére

Ha fixen egy szerver kérdezi le az adatokat, akkor tudsz IP címre szűrni, akár firewall szinten is (ha ahhoz hozzáférsz) - ez nem bombabiztos, mert nyilván a forrás IP-t is lehet hamisítani, de pár dolog ellen véd. Aztán meg ott a rate limiting, hogy nem engeded, hogy akárhány aktív lekérdezés legyen, hanem egy idő után nekiállsz nem válaszolni. Nyilván ezzel megát a denial of service-t nem tudod elkerülni (szóval lehet, hogy átmenetileg a webszerver se kapja meg az adatokat), de legalább nem fogja elzabálni a modod az erőforrásokat a játék elől.

-

coco2

őstag

válasz

MasterDeeJay

#20866

üzenetére

MasterDeeJay

#20866

üzenetére

DDOS ellen effektíve nem tudsz védekezni. Legyen szerver craft, legyen teljesítmény-hatékony a tech stack, és ne legyenek haragosaid

WebAPI-hoz illik tokent rakni a csomagba, amit login szervertől kell kérni, és amíg az nincs, gyorsított eljárással csak ignorálni a kérést.

Ha csak saját maganak kell, használj zárt tanusítványt, és akkor senki más nem tud a szerveredhez csatlakozni.

-

véleményt, ötletet szeretnék:

Van egy játék amelyben írtam egy modot. Annyit csinál hogy egy httplistenerrel kirak mindenféle infót, azaz szervernevet, maxplayer, onlineplayer és azoknak életét, hőmérsékletet időjárást a helyzetüknél stb. [link] Aztán ezt egy PHP összeszedi és weben megjeleníti. [link]

Namármost ez valahogy biztonságossá kellene tennem. A gond ugye az hogy a httplistener eléggé egyszerű szerkezet és a játék sem igazán arra van kitalálva hogy én egy moddal nyissak belőle egy webszervert. Milyen módon tehetném biztonságossá azaz ddos védelem meg a többi. Nem tárol atomtitkot és igazán sem jelszót sem semmi olyat mit a játékhoz való csatlakozásnál ne lehetne kiírtani. Elsősorban azt szeretném elkerülni hogy a szerver túlterhelődjön. A PHP résznél tudok cache-elni ha szükséges így nem kell lekérni újra a dolgokat minden egyes látogatónak bár ezt a részt még nem írtam meg. -

Amennyiben vannak kapcsolataid megfelelo helyen (CIO, CTO, COO, CISO - vagy az kozeli tanacsadojuk), es hozzafersz olyan szoftverekhez beszerzesi ar alatt, ami most keresett, akkor van eselyed.

Alternativakent el kell tudnod hitetni, hogy ezt a szoftvert el tudod kesziteni (megfelelo hataridon belul). -

coco2

őstag

Vajon van közöttünk, aki rálát a szoftver piac sales oldalára? Akár ismerősön keresztül? Nem az elmélet érdekel, hanem a jelenkori belföldi gyakorlat, és a nagy értékű szoftverek eladása a kérdésem célpontja, amihez ügyfél management tartozik, és jelentős a folyamatos jutalék.

-

aprokaroka87

nagyúr

Amit a chatgpt kapcsán tapasztalatok hogy sok esetben egy ideig jól megy a dolog aztán mint ha történne valami minden elkezd " elromlani "

Hozok egy egyszerű projektetet

A szövegrészt ne figyelje senki, ugyanis már az agyrém volt hogy elmagyarázni hogy mi és hogyan van 😁

Aki akarja próbálja ki.

Amire érdemes figyelni hogy a szélesség meg a hosszúság össze van cserélve.

Egy példa.

Szélesség 2000

hosszúság 1000

sáv 370vagy darab hosszúsága 370

Amit észre vettem hogy a Canvas rajzon kb 160 x 160 mm darabok esetén még épp látható a kijelzett méret, az alatt viszont már elkezdi levágni a végét.

Erre több megoldást is javasoltam.

1. Legyen kisebb a betűméret.

2. alkalmazzon sortörést.

3. alapból ne legyen minden darabon ott a méret, hanem csak akkor történjen meg ha az egér kurzor felette van, vagy az érintő képernyővel oda van tapizva akkor jelenlen meg.Igazából a 3. tűnt a legjobb opciónak.

Na de szerintetek bármelyiket is jól megcsinálta?Pedig előtte meg le írta hogy mit csinált meg 😁

Persze tudom bonyolulttá teszi a dolgot hogy ezt magyarul írom neki.

Aki akarja nyugodtan probálja ki.

Természetesen azt is tudom hogy az egész kód egyben van és ugye tudomásom szerint ilyet sem szabadna.

nincs külön szedve a javascript, css, html rész.

De alapból egybe írta 🤷Nos a tanulság az az számomra is ha nem tudsz programozni az AI nem fog helyetted " programozni "

-

-

proci985

MODERÁTOR

olyan matematika levezetéseket is meg tud csinálni, amit sose látott.

Ja, zero shot learningre képes ami jó, mert mi emberek is így működünk. Probléma, hogy az a matematikai levezetés nem feltétlenül lesz jó.Még ScopusAItól is láttam eléggé meredek hibákat.

coco2

Most esetleg megkérdezném, honnét tudod, hogy mit kapott információ betápnak?

promptokból nagyon specifikus esetekben (szűk terület) vissza lehet fejteni.googlenél nekem tavaly pythonnal volt az a tapasztalatom, hogy az első 20 találat kb a petal dataset alapján írt guideból generált -> crawlolt -> generált -> crawlolt -> generált content volt.

de olyan szinten, hogy konkrétan azt már semelyik guide nem írta, hogy mi van, ha eltérő adattípus vagy eltérően formázott inputod lenne.

---

egyébként nagyon úgy néz ki, hogy vibe coding egy pontig pl BSc computer science programoknál működik. aztán utána gyanúsan eljön az a pont, hogy aki magától nem tud kódot olvasni és írni, az kb belefut egy betonfalba.

mondjuk globális publikációkat erről a területen még nem láttam, de pl a Microsoft pár héttel ezelőtti tanulmánya is ezzel egybevág. senioroknak nagyon jó (és ha senior vagy, akkor stimmel amit írsz, hogy genAI a te szinteden gyorsít), kezdőknél viszont akadályozza bizonyos kritikus kézségek kialakulását.

-

coco2

őstag

válasz

inf3rno

#20825

üzenetére

inf3rno

#20825

üzenetére

Azt természetesen értem. És az igazat megvallva fogalmam sincs, mi a tényleges információ forrása. De azt én is tapasztaltam, hogy megbízhatóbb adatkereső, mint a mostanra már csak fizetett hirdetéseket kereső google (

![;]](//cdn.rios.hu/dl/s/v1.gif) ).

).Napi humor gyanánt meg itt egy YT videó chatgpt-ről

-

inf3rno

nagyúr

Amit adott válaszokat a kérdéseimre azokkal én teljesen jól meg vagyok, sokkal többet segített, mint bármelyik keresőmotor vagy ember, akivel eddig találkoztam, és elég speciális a témakör. Nem hiszem, hogy sokszor publikálták ezeket az információkat, fogalmam sincs honnan szedi őket, de kb. kincsestár ebben a témakörben, a többi kereső, wikipedia meg teljesen használhatatlan.

-

coco2

őstag

válasz

inf3rno

#20821

üzenetére

inf3rno

#20821

üzenetére

A "sikerül valamit kihúzni belőle", és az "egyben működő program, ami részleteiben is mind pont olyan, amilyet szeretnél" vagy ugyan az lesz, vagy lesz közöttük a "távolság". Amit én állítottam, hogy a "távolság" akkora lesz, hogy a másodikhoz képest az első maximum kétbalkezezésnek fog érződni. Esetleg az unalomig lerágott csont eseteiben az nem lesz úgy, de mindegyik másikban igen. Arra az állításomra értetted, hogy vitatkoznál vele?

-

inf3rno

nagyúr

Ezzel vitatkoznék, nekem olyan ritka témakörben is sikerült adatot kihúzni belőle, amire a google, duckduckgo semmi találatot nem adott, a bing is csak mérsékelten hasznosat. Pont az volt a várakozásom, hogy kevesebbet tud a kereső motoroknál, mert nem létezik, hogy ennyi adatot normálisan beindexelnek, de mégis.

-

coco2

őstag

válasz

aprokaroka87

#20817

üzenetére

aprokaroka87

#20817

üzenetére

A chatgpt csak olyasmire jó, amit már ezerszer publikáltak, dokumentáltak, szájbarágtak. A többiben felesleges számítani rá, csak nevetséges kétbalkezeskedések várhatóak, semmi egyéb.

Elolvasni a "24 óra alatt html" és abból a sorozatból a css meg javascript könyveket még nem a világ vége időben. Időben hatékonyan és sokat tud segíteni, ha részegységeken túl egyebet nem kell kérned a chatgpt-től, és utána össze tudod legózni az eredményt saját magad.

-

inf3rno

nagyúr

válasz

aprokaroka87

#20815

üzenetére

aprokaroka87

#20815

üzenetére

Attól függ, hogy minek a kódját.

-

válasz

aprokaroka87

#20815

üzenetére

aprokaroka87

#20815

üzenetére

Ezt hívják vibe codingnak .

Tulajdonképpen pont olyan, mintha házat építenél bármiféle statikai meg egyéb ismeretek nélkül: az elején úgy tűnik, hogy jól haladsz vele, de egy idő után simán a fejedre omlik az egész

-

aprokaroka87

nagyúr

válasz

axioma

#20816

üzenetére

axioma

#20816

üzenetére

Van már egy viszonylag egyszerű projekt amibe bele kezdtem, az tény hogy bőven van olyan amikor nem igazán tudja mi van.

Kedvencem amikor már jól működő dolgokat kezd ell átirni 😁

De mostmár mondjuk úgy kezd összeállni.

Vannak még bakik persze.Ettől tuti nem leszek programozó, bár közben azért tanulni kell dolgokat.

Eleinte pl a " rajzolás " svg-ben volt, viszont mivel dimanikus számolás is része a feladatnak ezért voltak néha komolyabb megadások az " oldalon "

Aztán lett Canvas.

Az már sokkal jobb.Amit elrontottam hogy nem kértem külön a html, css, js kódokat, így egybe rakta, gondolom ez is árthat a " lelkének "

kedvencem amikor felkínál + funkciókat, erre az egész kód kb felét elhagyja 😁

-

axioma

veterán

válasz

aprokaroka87

#20815

üzenetére

aprokaroka87

#20815

üzenetére

Attol fugg, mi a cel.

Hazit ne adj be igy (nem csak azert mert nem tanulsz belole, hanem mert az oktatok altalaban ezeket siman kiszurik).

Ha sajat celra kell, akkor en is irtam mar olyan kodot llm segitsegevel, amihez nem konyitok. De sajna ritkan sikerul egybol hasznalhatora amit ezek letrehoznak, es altalanos programozoi rutin nelkul ha hibat kell keresni (nem is hibauzenet javitasa, bar abba is sokszor beletorik a bicskajuk), hanem logikai hiba (=nem azt csinalja amit akartal) es nem ertesz hozza, akkor igen nehez lesz vegleges allapotura hozni. Szoval csak akkor ha ez neked hobbi, es nem idegeskedesi forras lesz (utobbi esetben csak az elso iteraciot probald meg, hatha mazlid lesz).

Az LLM ugye egy papagaj. Amit sokat latott, az bedrotozodott neki, azt visszaadja, de amint nem standard amit kersz, mar egyre kisebb esellyel jo.

Amugy nem feltetlen a ChatGPT a legjobb kodirasra, probald meg amiket elersz, me'g az is lehet hogy kis logikazassal ket mashogy rosszbol is tudsz jot csinalni

-

aprokaroka87

nagyúr

Ha valaki nem igazán kónyit a programozáshoz mennyire szentségtörés chatgpt-vel megírni a kódot? 😁

Html, javascript, CSS. -

coco2

őstag

Foglalkozott itt valaki video stream-ek lelkivilágával? Jelenetekre akarnék darabolni nagyobb videót automatikusan. Darabolásra tudok ffmpeg-et használni, de kellenek nagyon pontos időbélyegek.

Azon gondolkodok, hogy a jelenetek között hogyan vannak a határok? Léteznek például stream-be pakolt képek egészben a jelenet határon gyorsabban adni tiszta képet? Ha igen, hogyan tudom felkeresni őket, és időbélyeget gyártani a pozíciójukból? Vagy ha van bármi jó módszer, igazán minden ötletre nyitott vagyok. Leírások / blogok lennének jók, ha valaki találkozott ilyesmiről fejtágítóval, ami nem fényév távolságból kezdi el leírni, hogy mi hogyan van. Leprogramozni akarnám könnyen újrahasznosítható formában.

-

smallmer

őstag

Sziasztok!

Szeretnék elmenni egy automata tesztelő képzésre. Van valami ötletetek, hogy melyik hasznos? Tényleg olyat szeretnék, ahol tanítanak is valamit gyakorlati példákon keresztül.

-

válasz

husztiimi

#20810

üzenetére

husztiimi

#20810

üzenetére

> Ha meg át lesznek téve, akkor majd megmérjük, hogy mi legideálisabb inputtól függő választás? openMP + GPU? MPI + GPU? MPI + openMP + GPU

Ezeket szerintem ki lehet számolni, következik a feladat struktúrájából. Például belefér-e a mátrix a GPU memóriájába? Ha igen, mennyi idő megcsinálni vs mennyi idő 1) feltölteni 2) odavinni a node-ra? Ha jól láttam, 200 gbps interkonnekt van, azért az nem nagyon gyors (késleltetést nem tudom). Szóval én először biztos csinálnék papíron egy esztimaciot.

-

proci985

MODERÁTOR

válasz

husztiimi

#20810

üzenetére

husztiimi

#20810

üzenetére

Ezért mondtam, hogy én ránéznék az authorlistákra. Nekem is volt, hogy egy PhD thesisből vagy egy régi repoból kellett visszafejteni mit csináltak, de még mindig egyszerűbb, mint ilyen szinten belemászni az optimizációba.

Egyébként adott esetben megpróbálni felvenni a kapcsolatot az authorokkal is működhet.

-

husztiimi

csendes tag

válasz

proci985

#20809

üzenetére

proci985

#20809

üzenetére

Sok-sok cikket elolvasgattunk, de jellemzően nem írják le a cikkekben (PRC, J. Phys. G), hogy a konkrét kód CPU-n futott-e, vagy sem?! Meg azt sem, hogy CPU-n milyen módon (openMP, vagy MPI)? Meg azt sem, hogy a kód milyen nyelven íródott?! Úgyhogy azt gondolom, hogy előbb-utóbb majdcsak megoldjuk valamilyen úton-módon a GPU-ra való átrakását a mátrixdiagonalizációknak. Ha meg át lesznek téve, akkor majd megmérjük, hogy mi legideálisabb inputtól függő választás? openMP + GPU? MPI + GPU? MPI + openMP + GPU? Ha meg esetleg GPU-val valami nem várt csoda folytán mégis lassulás lesz a „hozadék” például az adatmozgatások miatt, akkor meg úgy fogjuk fel, hogy milyen jó ujjgyakorlat volt a GPU-ra való kódrész implementációja...

-

proci985

MODERÁTOR

válasz

husztiimi

#20805

üzenetére

husztiimi

#20805

üzenetére

(nem mozgok HPC területen)

leírás alapján tippre lehet bele kéne nyúlni a pipelinebe, hogy nyerjetek is valamit.

GPUn mátrix transzformációnak gyorsabbnak kéne lennie, de a kérdés, hogy mennyi idő megy el az adatmozgatással.

ha kutatási terület, én ránéznék a környezeti publikációkra, hogy ki futtat hasonló HPC környezetben. cikkeknél nem mindig írják le, hogy mit hogy oldottak meg tartalmi okok miatt, de pl egy master vagy phd thesis esetén van esély, hogy lesz egy github repo és egy rendes leírás is.

-

husztiimi

csendes tag

MPI-hoz a Komondor gépet használjuk: https://hpc.kifu.hu/hu/komondor

Ha a "probléma" nem indokolja az MPI használatot (ez néha-néha azért előfordul), és elegendő hozzá az openMP is, akkor arra pedig van két darab számítási nódusunk: az egyik AMD EPYC 9554 64-Core procikkal és 2.5TB memóriával, a másik pedig Intel(R) Xeon(R) CPU E7-8880 v2 procikkal és 3TB memóriával.

-

husztiimi

csendes tag

Ja igen, "szuperszámítógépen futtatjuk" - az a napi nagyot mondás gyakorlatod volt?

Nagyon szomorúan látom, hogy bejegyzésed nem segítő szándékkal, csupán csúfolódási szándékkal született. Így a tisztánlátás érdekében kifejtem inkább egy kicsit: Képzeld el, hogy nemcsak olyan programok léteznek, amelyek asztali platformra vannak "megálmodva", hanem vannak olyan progik is, amik sokkal nagyobb erőforrásokat igényelnek. Pl. a saját fejlesztésű programunk, amit a kollégáimmal együtt évek óta fejlesztgetünk-csiszolgatunk pont ilyen. (Dokumentációt is írtunk hozzá, amelyet igyekszünk frissíteni, amikor új részek/rutinok kerülnek a kódba.)

A programot arra használjuk, hogy kiszámolunk vele ezt-azt, azután pedig ha szerencsénk van, akkor évente 1-2 cikket publikálunk azokból az eredmény(ek)ből, ami a programnak az eredményeiből levont konklúzió. A program képes openMP és MPI módokon futni. (Remélem ezekről már hallottál.) Viszont bemenő inputtól függően (bemenő input = probléma paraméterei) a futási idő rettenetesen sok lenne egy asztali számítógépen. (Asztali gépen csak az openMP-nek lenne amúgy is értelme, az MPI-nak nem.) Így a programot olyan esetben, ahol az input úgy kívánja, szuperszámítógépen futtatjuk hibrid módon (hibrid = MPI + openMP). A futási idő tetemes részét a hatalmas méretű mátrixdiagonalizációk viszik el. Ezért jött az ötlet, -ha már eleve HPC környezetben futtatjuk a kódot (amennyiben az input ezt kívánja), akkor miért nem fejlesztjük fel eme kódot úgy, hogy a futási idő redukálásában a GPU is segítsen? (Azaz a sok-sok dsyev mátrixdiagonalizáció szubrutin-hívásokat a GPU végezze.) Eredeti bejegyzésem ezért született… (Sőt, a bejegyzésben lévő egy darab 100x100-as méretű eset csak egy "állatorvosi ló". -Nem igazi eset... Ilyen kicsi mátrix élő esetben nincs... )Nem gondoltam, hogy az általam felvetett "problémához” ennyi magyarázat szükséges lett volna. Egyszerűen csak bíztam benne, hogy hátha olvassa ezt a topikat olyan HPC user is, aki pont nvfortrant használ a saját kutatásához/szimulációihoz mint mi és már találkozott ilyesmi problémával. Benne volt a pakliban, hogy esetleg nem találok a fórumban segítséget; -ezzel nincs is gond. De véleményem szerint a kicsúfolásod felesleges volt... A fórumbeli bejegyzéseidben sem HPC használatra utaló nyomokat, sem (openMP, vagy MPI) parallelizációt nem látok. Nem tudom, hogy te miket fejlesztesz, meg hol és minek, de tuti, hogy ha leírnád, akkor többen is bele tudnának kötni.

-

coco2

őstag

válasz

husztiimi

#20802

üzenetére

husztiimi

#20802

üzenetére

A chatgpt google skill-t helyettesíteni jó, azon túl teljesen megbízhatatlan. Olyan esetekben használható, amikor semmi sem múlik azon, hogy működni fog-e, vagy sem.

Chat gpt vicc:

eval(await OpenAI("fix this:"+ErrorMessage))

Kicsit komolyabban a 10k sor önmagában úgy hangzik, mint 2 emberhónapnyi munka. Ha azon egy szoftver cég kiakad, húzza le a rolót. Ami konkrétan azt a 10k sort illeti, a kérdés inkább az, létezik-e még elő ember, dokumentáció, szájhagyomány útján terjedő akármi, amiből meg lehet érteni a bemeneti adatot, és a feldolgozásának a miértjét? Ha már nem létezik, akkor az a probléma nem arra van tervezve, hogy azt bárki megoldja. Aki mégis azzal foglalkozik, fordítva ül a lovon.

Ja igen, "szuperszámítógépen futtatjuk" - az a napi nagyot mondás gyakorlatod volt?

![;]](//cdn.rios.hu/dl/s/v1.gif)

-

husztiimi

csendes tag

Sajnos pont ettől tartottam... A chatgpt egyik válasza a sok közül nekem is az volt, hogy felajánlotta, hogy ír egy olyat, ami a C-s modult használja... De amit írt nekem az nem fordítható le. Sajnos a neked írt kód sem fordul le. (Írtam eredeti posztomban, hogy: "Sajnos az AI (chatgpt) ebben nem tud segíteni.")

Félreértés ne essék, én is használom sokmindenre a chatgpt-t, pl. keresse meg a hibát egy adott kódrészletben, vagy írjon egy-egy kisebb részt. Néha ezeket jól megcsinálja. De sajna néha kurvára nem. Sajna a te "megoldásod" az utóbbiak táborát erősíti.

Új hozzászólás Aktív témák

● olvasd el a téma összefoglalót!

- Garmin Venu 3 fehér (homokkő)

- ÚJ bontatlan S9 41mm Midnight / éjfekete Cellular Azonnal átvehető Deák térnél

- ÚJ BONTATLAN Apple Watch Series S9 41mm Pink és Mid Azonnal Átvehető DEÁK TÉRNÉL 1 Év Apple Garancia

- BONTATLAN Új iPhone 17 PRO Kozmosznarancs 256-512GGB Független 1év Apple Gar. Azonnal átvehető.Deák

- BONTATLAN Új Ipad 9th 10th 11 gen. Air 6 7 , Ipad Pro Mini 7 IPADEK Azonnal DEÁK Térnél Átvehető.

- BESZÁMÍTÁS! Gigabyte B550M R7 3700X 32GB DDR4 512GB SSD RTX 3060Ti 8GB Zalman Z1 PLUS CM 700W

- Apple iPhone 13 Mini 128GB,Újszerű,Adatkabel,12 hónap garanciával

- Tablet felvásárlás!! Apple iPad, iPad Mini, iPad Air, iPad Pro

- iKing - Xiaomi 14T Pro Titan Gray Vékony, prémium kivitel, nagy kijelző 12/512

- ÁRGARANCIA!Épített KomPhone Ryzen 5 5600X 16/32/64GB RAM RX 7600 8GB GAMER PC termékbeszámítással

Állásajánlatok

Cég: PCMENTOR SZERVIZ KFT.

Város: Budapest

Cég: ATW Internet Kft.

Város: Budapest

ezzel megvoltam, megértettem, mit is olvastam az egyik fórumon, amikor valakinek ilyen jellegű gondja támadt. A megoldás: mutatót kell használni. Igen, azt használtam, és nem működött. Ja, hogy az egész UI-t azzal kellene kezelni...

ezzel megvoltam, megértettem, mit is olvastam az egyik fórumon, amikor valakinek ilyen jellegű gondja támadt. A megoldás: mutatót kell használni. Igen, azt használtam, és nem működött. Ja, hogy az egész UI-t azzal kellene kezelni...

![;]](http://cdn.rios.hu/dl/s/v1.gif)