Hirdetés

- Milyen billentyűzetet vegyek?

- AMD K6-III, és minden ami RETRO - Oldschool tuning

- Kormányok / autós szimulátorok topikja

- Szünetmentes tápegységek (UPS)

- Milyen házat vegyek?

- Milyen monitort vegyek?

- AMD Navi Radeon™ RX 9xxx sorozat

- 5.1, 7.1 és gamer fejhallgatók

- Épített vízhűtés (nem kompakt) topic

- Milyen egeret válasszak?

Új hozzászólás Aktív témák

-

válasz

DudeHUN

#47198

üzenetére

DudeHUN

#47198

üzenetére

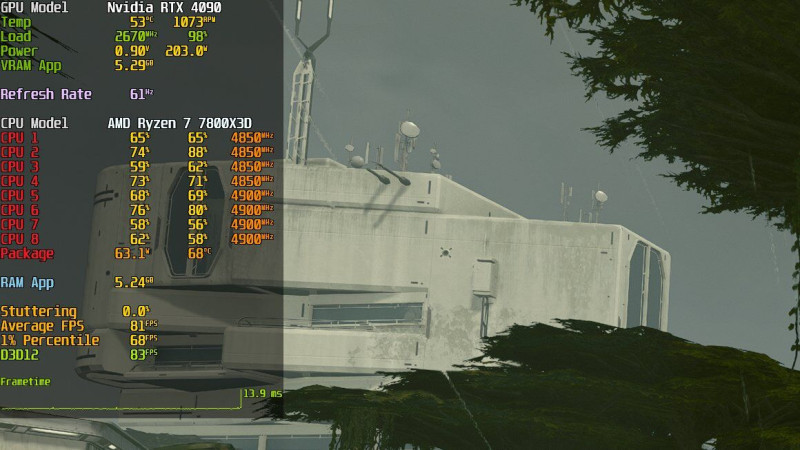

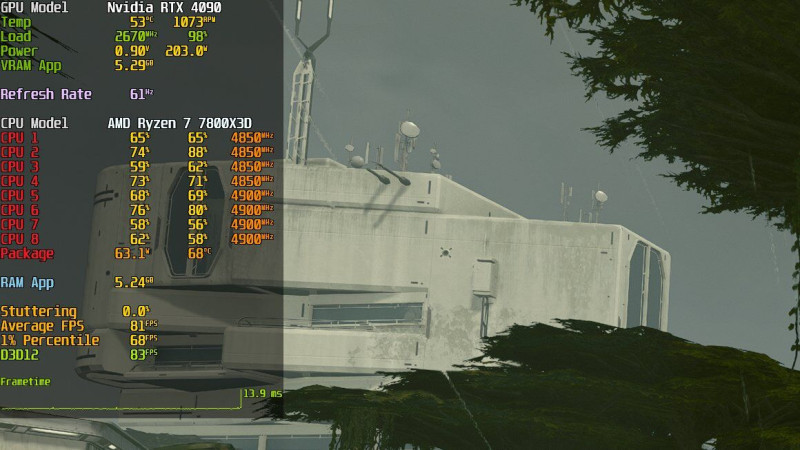

Nem cpu limit. érdemes megnézni a teszteket. FHD-n az Nvidia kártyák gyorsabbak arányaiban nézve. [link] és a limit az AMD kártyákat érinti.

Nem tudják a tesztelők sem mi áll jelenleg az Nvidia kártyák alacsony energiafogyasztásának a hátterében, teljesen szokatlanuk viselkedik mindegyik a játék alatt. Mint ha vissza lennének fojtva.

-

DudeHUN

őstag

válasz

Petykemano

#47197

üzenetére

Petykemano

#47197

üzenetére

Szerintem sem kell ebbe többet bele látni. Nyilván mivel az AMD és az XBOX csapat is segített a Bethesdának és nincs RT az RDNA-nek jobban fekszik a dolog.

De simán lehet bug is.

Az is lehet, hogy itt többet számít az Nvidia driver overhead. Mert elég furcsa a CPU kezelés a játékban. Ugye eddig úgy fest központi RAM sávszél limites is.

13900K valami 6000+-res RAM esetében valszeg jobban pörgette volna a kártyákat, mert itt lehet az IF limitál.

Biztos kap még optimalizációt. Minden létező irányba. Mondjuk csodát nem várnék. Részemről így is örülök, hogy stabilan fut és nem microlaggos. -

Petykemano

veterán

Szerintem nem az.

És attól, hogy időről időre van egy-egy játék, ami különböző körülmények miatt esetleg jobban fekszik az AMD-nek, attól még nem lesz az. Még ha annak szánták is. Egy fecske nem csinál nyarat.

Persze jó lenne, ha ez az összehasonlítás trendszerűvé válna, (Persze lehetőleg nem amiatt, mert az nvidia elhanyagolja drivert.) de nem tartunk ott.Tudjuk hogy a kártyák látható teljesítményét nem kizárólag a hardver és a driver (most az egyéb szoftvertől tekintsünk is el) adja. Annak része a játékok optimalizációja is. Ezt volt hivatott szolgálni a TWIMTBP, a gameworks. És nyilván ugyanerre apellál az AMD a konzol irányból megközelítve. Ebben az nvidia nagyon jó. (Ebben is)

-

hokuszpk

nagyúr

válasz

huskydog17

#47182

üzenetére

huskydog17

#47182

üzenetére

"Az AMD mérnökei viszont itt megveregethetik saját vállukat, ugyanis sikerült elérniük, hogy az RX7900XTX gyorsabb, mint az RTX 4090. "

lehet, hogy az NV kartyaval szamoltatnak egy tengert a valami alatt !

![;]](//cdn.rios.hu/dl/s/v1.gif)

-

válasz

keIdor

#47187

üzenetére

keIdor

#47187

üzenetére

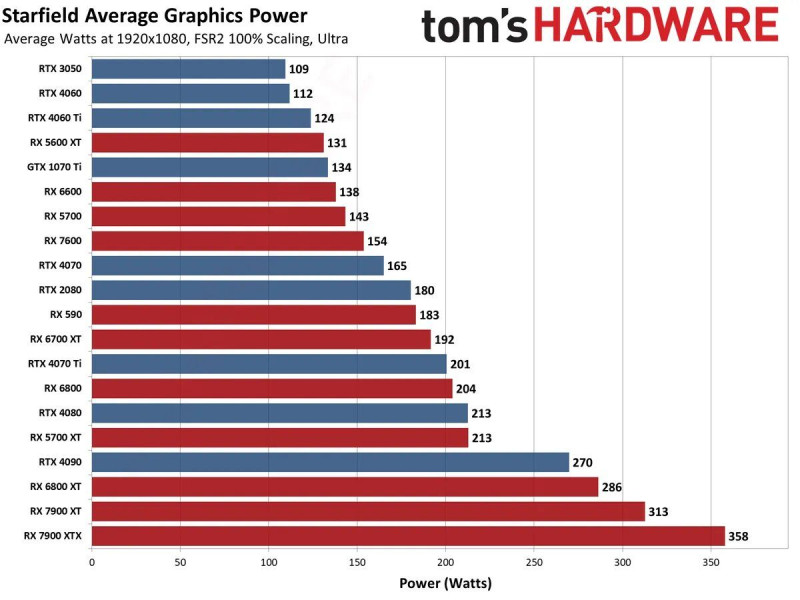

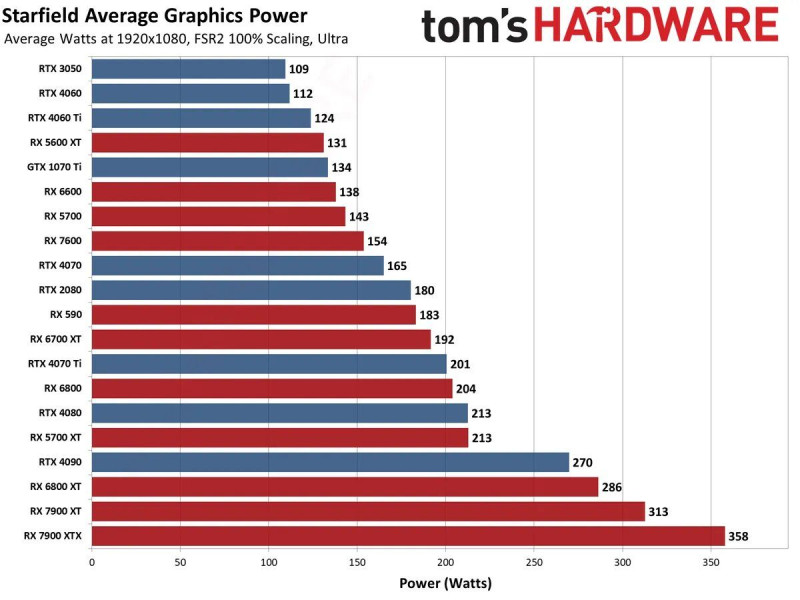

Úgy néz ki valamiért az Nvidia kártyák nem normál módon működnek játék alatt és nem CPU bottleneck. A 4090 pl 200 W fogyasztással megy.

[link]

"

Looking at these GPU power consumption figures in Starfield courtesy of

@tomshardware

, it's quite clear to me that NVIDIA GPUs are underutilized compared to their AMD counterparts. I would really like to know what's happening here.2Tudom én az AMD jó fej, a véletlenek összejátéka ez is mint annyi más furcsa dolog a támogatott játékaik során.

-

huskydog17

addikt

válasz

Petykemano

#47188

üzenetére

Petykemano

#47188

üzenetére

Mi köze hozzá az AMD-nek? Nem tudom eldönteni, hogy ez a kérdés részedről trollkodás vagy tényleg komolyan gondolod. Jóhiszeműen feltételezem, hogy elsiklott a figyelmed felett a júniusi bejelentés, ami kb. milliószor volt említve a különböző világsajtókban. Bár rendkívül erősen kétlem, hogy nem olvastál/hallottál az exkluzív partnerségről, de elméletben még lehetséges.

"Nvidia vezet - Nvidia király

AMD vezet - AMD szabotázs!!444!"Ke? Hol írtam ilyet? Csak egy újabb álom a részedről. Majd ha kijózanodtál, esetleg beszélhetünk. Tőled már megszoktam, hogy mindig behaluzol valamit a hozzászólásokba.

Mi lenne, ha egyszer kizárólag arról beszélnénk, ami valóban le lett írva és nem általad kitalált mesékről?

"Ráadásul az Nvidia már elismerte, hogy nem volt elegendő erőforrásuk a day0 driver megfelelő elkészítéséhez."

Én eddig csak az AMD-nél olvastam problémákról. Az NV-nál mi volt a gond? Hol ismerte el? Lemaradtam erről.

-

válasz

Petykemano

#47188

üzenetére

Petykemano

#47188

üzenetére

Azt elismerheted hogy a 7900XTX nem 4090 teljesítményű kártya..

-

Kolbi_30

őstag

válasz

Petykemano

#47188

üzenetére

Petykemano

#47188

üzenetére

Es akkor most, kettehugyozza, megalazza, lefossa...ahogy a zold oldal szokott nyilatkozni...

-

Petykemano

veterán

válasz

huskydog17

#47182

üzenetére

huskydog17

#47182

üzenetére

Nvidia vezet - Nvidia király

AMD vezet - AMD szabotázs!!444!Aham...

Mindazonáltal tényleg értem a kritikát a játék teljesítményével kapcsolatban. De ehhez mégis mi köze van az AMD-nek?

Ráadásul az Nvidia már elismerte, hogy nem volt elegendő erőforrásuk a day0 driver megfelelő elkészítéséhez.

-

paprobert

őstag

Nem lenne túl nagy gond ezzel a sebességgel, ha a kártyák annyiba kerülnének, mint korábban.

A jelenlegi árakon viszont kijelenthejük, hogy 2023-ban a 1080p gaming már a pirosaknál is vérlázító $600, a zöldeknél pedig "mindössze" $1100.

Tudom, csúsztatok, de azért na...

Ideje lenne a kártyák értékének és az áraknak arányba jönnie, mert a semmiért megy a pénzkérés.

-

válasz

gejala

#47183

üzenetére

gejala

#47183

üzenetére

Maga a játék is sajnos elég átlagos 4,6 ponton áll jelenleg a 10 ből. A textúrák évekkel ezelőtti szintet ütnek meg.

A játék nagyobb gépigénnyel megy mint a CP 2077 high RT vel.

HU is csinált egy elég jó tesztet: [Starfield: 32 GPU Benchmark, 1080p, 1440p, 4K / Ultra, High, Medium]

Legnagyobb poén, hogy nem lehet fényerőt állítani a játékban.

Komolyan?

Az FSR megvalósítása jó, a DLSS valamivel jobb. Szegény Intelesek meg szívnak mert nem megy a játék , várják a javítást.

Azt gondolom a gyártóknak lassan át kellene gondolniuk ezeket a szponzorációkat mindkét oldalon. -

gejala

őstag

válasz

huskydog17

#47182

üzenetére

huskydog17

#47182

üzenetére

Kár érte. Eddigi Bethesda játékok rondák és technikailag elmaradottak voltak, de legalább normálisan futottak, max egy kis procilimit volt városban. Ez most úgy fut szarul, hogy még nem is túl szép. De legalább kicsit kevesebb a bug.

![;]](//cdn.rios.hu/dl/s/v1.gif)

-

huskydog17

addikt

Starfield Benchmark - ComputerBase

PCGHNa ezt nevezem igazi hulladék, pocsék optimalizálásnak, pontosabban ez igazi optimalizálatlanság, az új mélypont. Az AMD mérnökei viszont itt megveregethetik saját vállukat, ugyanis sikerült elérniük, hogy az RX7900XTX gyorsabb, mint az RTX 4090. Igaz, az általános sebessége a játéknak annyira pocsék, hogy még viccnek is rossz. Legalább majd az AMD marketingesei megveregethetik a mellüket, hogy "a mi kártyáink gyorsabbak Starfield-ben, mint a konkurencia".

Egy RTX 4080-as még FullHD-ban (!) sem tudja mindig stabilan tartani a 60 fps-t maximális grafikán! Az új RTX 4060Ti pedig még a Full HD 30 FPS-hez is kevés! Ez az új mélypont. Ne feledjük, hogy a játék semmilyen RT-t nem támogat, kizárólag raszteres technikát használ.

Mindössze két pozitívumot lehet felhozni a PC portnál: nincs shader compilation miatti és traversal akadás, a másik, hogy a VRAM igény is baráti. 1440p-ig bezárólag 8 GB VRAM elegendő. 4K-hoz 10 GB kell.

FullHD-ban az AMD kártyák olyan CPU limitbe ütköznek, amibe az NV kártyák nem. 1080p-n olyan masszívan fékezi az AMD kártyákat a CPU limit, hogy a többi felbontásban látott sebességelőny teljesen eltűnik és egálba kerülnek a zöldekkel.

Hm...ez érdekes. Nem úgy volt, hogy az AMD DX12 drivere alacsonyabb CPU terheléssel jár? Most akkor mi van?FSR 2 pedig szokás szerint felemás képet ad.

Mondjuk Bethesdától nem vártam példa értékű PC portot, ez még az alacsony elvárásomat is messze alulmúlja. A baráti VRAM igény viszont számomra is kellemes meglepetés, itt sokkal rosszabbra számítottam az AMD-től.

-

-

Raggie

őstag

válasz

Raggie

#47177

üzenetére

Raggie

#47177

üzenetére

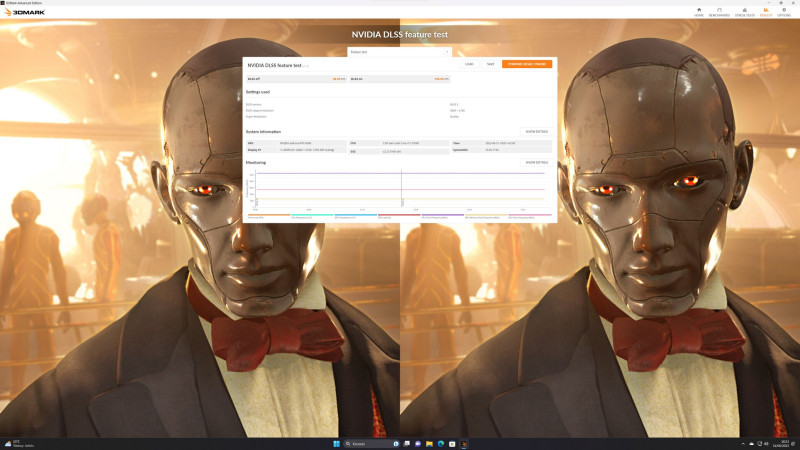

És ez nem önmaga tényéért probléma. Nem az a gond, hogy itt kiváló lesz a képminőség. Hanem az, hogy ez egy benchmark, azaz ezt nagyon sokan azért futtatják, hogy ne kelljen sok tucat más játékon tesztelni, hanem inkább csak ezt és ebből az általános, a többi játékokban tapasztalható teljesítmény és minőségre vonjanak le előre következtetéseket.

És ez együttesen az előzőekben leírtakkal, na AZ a problémám.

#47176b. : bele szerkesztetted a "lenne" kifejezést. Igen ez így korrekt volna, ha a teszt címe az volna, hogy "What if DLSS implementation would be perfect in games feature test"

De nem az.

A címe simán "DLSS feature test"...

EDIT:Ja és ha jól emlékszem van már FSR feature teszt is, és arról is pontosan ez a véleményem. -

Raggie

őstag

Értem. Ezt el is fogadom. Még simán lehet, hogy így is van.

Csak sajnos a vállalatokban nem bízom(egyikben sem). És ahogy már láthattuk mindkét oldalon, hogy tisztességtelenül kivételezéssel ráoptimalizálnak a benchmarkokra úgy sajnos azt kell feltételezni szerintem, hogy ha van rá módjuk, akkor erre is ráoptimalizálnak. És mivel itt nagyon sok és számukra tökéletes mód és lehetőség kínálkozik így a legnagyobb valószínűség szerint élnek is vele. -

válasz

Raggie

#47175

üzenetére

Raggie

#47175

üzenetére

Értem és igaz amit írsz. Referencia célt szolgál szerintem .

Tehát a teszt azt mutatja meg milyen lenne tökéletes megvalósításban ehhez képest a játékokban a beépítés minősége szerintem inkább jó, mint rossz.

Gyakorlati tapasztalat, mindennapi használat, nem teszt alapján írom amit írok. -

Raggie

őstag

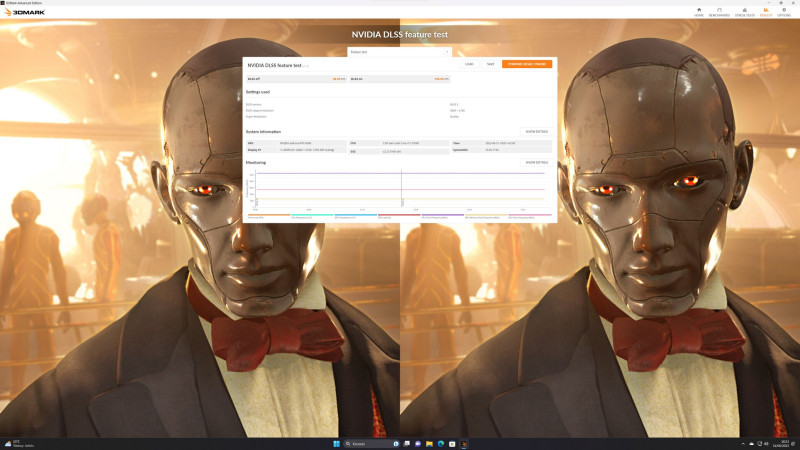

Pont nem. Ez egy feature teszt. Azt teszteli, hogy működik-e és ha igen mennyi FPS-t kapsz pluszba.

De pont a grafikai megvalósításban fals képet ad, mivel egyáltalán nem interaktív. Kvázi a mozgásvektorok fixek és minden egyes alkalommal pontosan ugyanolyanok lesznek. Ezt előre megtanulja a felskálázó és -bumm- máris kész a tökéletes szellemkép és egyéb grafikai anomáliák nélküli kép. De a játéknál ez persze nem megy, mert ott a user rángathatja a képet bármerre. Így ott rosszabb lesz a képi minőség.

Erre próbáltam csak utalni. -

keIdor

titán

Na ezért jó a DLSS és FrameGen.

Képminőségben nem vettem észre változást, viszont a gyorsulás több, mint 2x.

-

Busterftw

nagyúr

"Ha az Nv szabványosan oldja meg a kapcsolatot "

Akkor az AMD-nek nem kellett volna 2 evet varni a FreeSynccel.

A konkurencia segitese az Nvidia szamara versenyhelyzetben miert is kivanatos?

A G-Sync forraskodjat ne adjak at nekik egy az egyben?

Az AMD is versenyezhetett volna jobban, innovalhatott volna egy sajat scalerrrel.

Latod mar az osszefuggest? -

HSM

félisten

válasz

Busterftw

#47163

üzenetére

Busterftw

#47163

üzenetére

Az Nv implementációja ugyan miért késett volna? Az AMD ennyit vacakolt vele, de nem azért, mert szabványosan csinálták, hanem elsősorban ott úszott el a dolog, hogy megvárták a szabványt követő sorozatgyártott scalereket. Ha az Nv szabványosan oldja meg a kapcsolatot a saját 300 dolláros scalerével akkor nem hinném, hogy bármi jelentősebb csúszást okozott volna. Alapvetően teljesen ugyanazt a működési elvet csinálják, csak nem szabványosan. Ez így minimális igazítás a szoftveren, se több, se kevesebb.

-

Busterftw

nagyúr

Hogy hogy miert ne lett volna, ott a pelda az AMD-tol aki szabvanyosan jott ki a sajat megoldasaval.

Epp errol szol a vita, hogy a szabvanyositas miatt erre nem lett volna lehetoseg, mert az eredmeny Freesync lett volna, ami eves lemaradasba hozta oket.

Az AMD miert nem akarta jobban? Miert nem hoztak ki egy szabvanyos scalert (jelentsen ez barmit) es dobta piacra?Ezert nem jo a szabvanyositas es az innovacio/verseny egyvelege.

-

HSM

félisten

válasz

Busterftw

#47161

üzenetére

Busterftw

#47161

üzenetére

"Nincs fix, jobb minoseg, nincs a monitor teljes tartomanyaban mukodo VRR, nincs 144Hz support. Ezeket az AMD meg +2 evvel kesobb hozta, ami mar 4 ev."

Miért ne lett volna? Ugyanúgy működhetett volna a scaler szabványos módon, az összes jósággal együtt, kb ugyanabban az időben. Akarat kérdése lett volna az egész.A többire.... Sajnálom, hogy ennyire nem érted.

Én feladom ezen a ponton.

Én feladom ezen a ponton. -

Busterftw

nagyúr

"Nem az AMD-t akadályozta, hanem Pistikét,"

Es Pistikenek mi koze van a piaci versenyhez, kerdezem ujra?

Kevesebb terelessel tobbre mennenk."aki monitort vett, hogy később az AMD kártyájával is használhassa"

Hogy mi? G-Sync 2 evvel a FreeSync elott volt, az Nvidia vilagosan kozolte, hogy csak Nvidia kartyaval megy a buli. Miert vett volna barki"így később Pistike nem vett AMD kártyát"

Ujra, miert vett volna? Teljesen vilagosan le volt kommunikalva, hogy G-Sync csak Nvidiaval mukodik. Es ujra ujra, ez miben korlatozta az AMD-t a sajat megoldasanak piacra dobasaban? Semmiben. Sajat magat korlatozta, a szabvanyositassal."A fix minőségű, G-sync logós scalarral (ez volt valójában az innováció) nyugodtan megjelenhettek volna szabványt is támogató módon"

Ha nyugodtan megjelennek, akkor nincs verseny es egy rosszabb megoldassal leptek volna piacra 2 evvel a Freesynccel egyutt a piacra.

Nincs fix, jobb minoseg, nincs a monitor teljes tartomanyaban mukodo VRR, nincs 144Hz support. Ezeket az AMD meg +2 evvel kesobb hozta, ami mar 4 ev.A Pistike vga/monitor parositasanak semmi koze nincs a versenyhez.

Pistike piacon versenyzo megoldasok/termekek alapjan vasarol, ami a piaci reszesedest folyasolja be max, nem a versenyt. -

HSM

félisten

válasz

Busterftw

#47159

üzenetére

Busterftw

#47159

üzenetére

"nem akadalyozta az AMD-t "

Nem az AMD-t akadályozta, hanem Pistikét, aki monitort vett, hogy később az AMD kártyájával is használhassa, így később Pistike nem vett AMD kártyát. Nem olyan bonyolult ez.

Nem azt mondtam, hogy nem volt innovatív a G-sync modul, azt állítottam, hogy nem az innováció tette szükségessé, hogy a szabványtól (ami már fél évvel korábban végleges formában készen volt, tehát VESA tagként az Nv ennél lényegesen korábban is már tudhatott róla!) eltérő, inkompatibilis módon valósítsák meg. A fix minőségű, G-sync logós scalarral (ez volt valójában az innováció) nyugodtan megjelenhettek volna szabványt is támogató módon, akkor lett volna verseny, mert Pistike döntésén múlt volna, milyen monitort milyen kártyával párosít.

-

Busterftw

nagyúr

Csak hogy az user nem versenyez sem az Nvidiaval, sem az AMD-vel.

Az Nvidia/AMD versenyez a piacon az userekert, illetve azok penzeert.Azert mert Pistike Nvidia kartyat vett, nem akadalyozta az AMD-t a FreeSync piacra dobasaban.

"Aki Nv kártyát vett, az csak hozzá való monitort vehetett."

Ha az user errol tajekoztatva volt, akkor nincs semmi problema. Marpedig volt, mert a G-Sync kijovetelekor egyertelmuve tette az Nvidia, hogy csak Nvidia kartyakkal mukodik.

Ez nem korlatozta semmiben az AMD-t es a sajat megoldasat a piacon."És itt szó nincs innovációról"

Dehogynincs szo, ilyen funkcio nem volt meg szeles korben elerheto a piacon a gamereknek. "a new method, idea, product, etc."A sajat scaler biztositotta azokat a feature-ket es fix minoseget, amit az AMD csak evekkel kesobb hozott a piacra es nem tudott launchkor biztositani, mert 1. technologiailag nem volt ott, 2. a tobb szaz kulonbozo monitorok eltero scalerekkel jottek.

-

HSM

félisten

válasz

Busterftw

#47157

üzenetére

Busterftw

#47157

üzenetére

"Magyarazd meg konkretan, a G-Sync miben korlatozta a versenyt?"

Aki Nv kártyát vett, az csak hozzá való monitort vehetett. És fordítva is, aki már megvette a drága, jó minőségű monitort, utána kénytelen volt Nv kártyán maradni, mert más kártyán egy kulcsfontosságú képességet vesztett volna el.

És itt szó nincs innovációról, meg egyéb marhaságokról, mivel a kis 300 dolláros scaler működését ugyanúgy felprogramozhatták volna szabvány szerint is, főleg hogy a rajta lévő Altera Arria V GX FPGA modul elméletileg DP1.2a támogatású [link] . -

Busterftw

nagyúr

A monopolhelyzet nem illegalis, csak ha visszaelnek vele.

Illetve errol itt szo sincsen. Csak open-source kornyezetben is letrejohet monopolium, ha valamelyik versenyzo megoldasa jobb/kelendobb."Tényleg magyaráznom kellene, miért korlátozza a versenyt a vendor lock-in?"

Igen magyarazd meg, mert zart/proprietary megoldasok a piac reszei es nem torvenybe utkozok. Magyarazd meg konkretan, a G-Sync miben korlatozta a versenyt?

Mert en az latom, hogy a konkurencia megoldasa el es virul.Versenyhatranyba nem a zart megoldas hozta oket, hanem a szabvanyositas miatti teszetoszaskodas. Errol szol a vita, mint egy pelda.

-

HSM

félisten

válasz

Busterftw

#47154

üzenetére

Busterftw

#47154

üzenetére

"szabványosítás és az innováció/verseny nem fér össze"

Pedig összefér, megfelelően koordinálva. Sőt, csakis úgy férnek meg jól egymás mellett. Pl. koordinálás nélkül az innováció monopolhelyzetbe csaphat át, lásd pl. vendor lock-in.Természetesen a szabványosítás lassítja valamennyire az új (jobb?) termékek piacra kerülését, ezt nem is vitattam.

Ugyanakkor számtalan súlyos valós probléma kezd már most is a féktelen innováció jóvoltából kibontakozni, aki nem barlangban él, annak szerintem nem kell magyarázni.

"Ez konkrétan miben nyilvánult meg?"

Tényleg magyaráznom kellene, miért korlátozza a versenyt a vendor lock-in?

-

Busterftw

nagyúr

"Jó dolog az "innovációval" dobálózni,"

Nem dobálózom, beszélgetünk arról a kiindulópontról, hogy a szabványosítás és az innováció/verseny nem fér össze.

Ezt az eddigi példák is alátámasztották, a szabványosítás lassította az új/jobb termékek piacra kerülését." versenykorlátozó gyakorlatokat"

Ez konkrétan miben nyilvánult meg?

Senki nem gátolta az AMD-t, hogy piacra dobja a FreeSyncet, vagy az LFC-t. Versenyhátrányba épp saját magukat hozták azzal, hogy a nagy open-source közepette évekkel később és gyengébb feature settel léptek a piacra. -

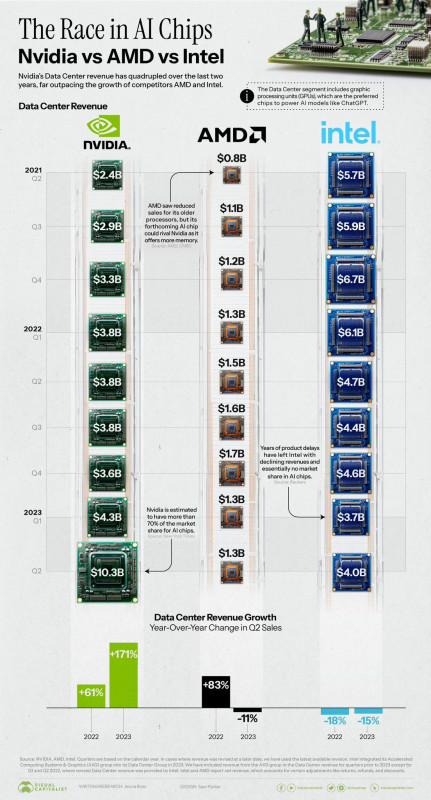

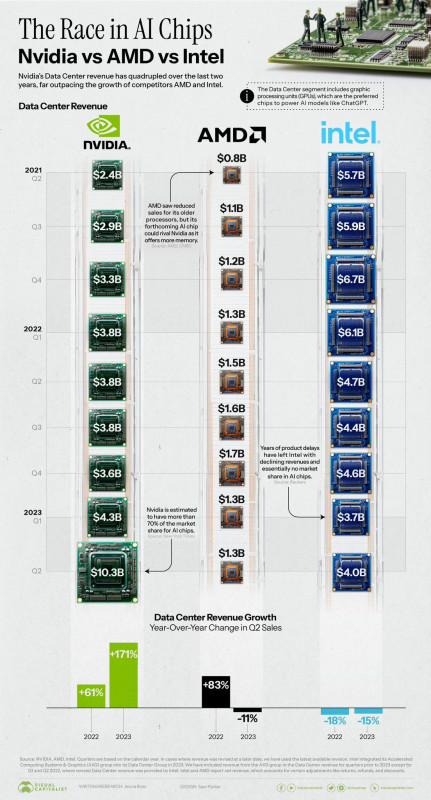

[Google Cloud & NVIDIA Join Forces To Power AI Computing]

Megint nem kell foglalkozniuk egy darabig a gaming szegmenssel

-

Kolbi_30

őstag

válasz

keIdor

#47149

üzenetére

keIdor

#47149

üzenetére

Tehat akkor AzNVnek sincs arra a szintre kartyaja, mivel te irtad le hogy minden hokusz pokusz hasznalataval sincs a 4090 lofasszal 4k@120FPS csak jo esetben a fele..

Bar nekem nincs 7900 XTX kariom csak sima XT viszont van 4k@120 hz oled tvm..

FC6 minden ultra atlag 80 fps nem is megy nagyon alá.

Division 2 75-80

Black Desert remastered(mmo bitang grafikaval remastered beallitassal) Atlag 101 fps

War Thunder ez mindenen jol fut, ebben van RT ha jol tudom ez Vsync on 120 fpsrol el se mozdul.

The hunter Call of the wild ez masszivan NV jatek HAirworks meg minden van itt neha beterdel de itt is 80 fps az atlag..

Mostani "AAA" Baldurs Gate 3 itt hozza azt a 80 fpst mint a tesztekben bar itt nem letfontossag...

Igaz nem CP2077 egyik sem de az nem is erdekel.. -

FLATRONW

őstag

válasz

proci985

#47134

üzenetére

proci985

#47134

üzenetére

A freesync nem volt iparági standard, csak egy megvalósítás az adaptiv sync (VRR - nevezzük akárhogy) szabványra.

Az NV jelenleg G - Sync Compatible minősítést ad ki, amelyeket olyan adaptiv sync monitorok kapnak meg, amelyek korábban már megkapták a Freesync hitelesítést is.

Természetesen nem kapja meg minden ilyen monitor a minősítést, mivel elég sok hulladék képességű példány is piacra került (50-75 Hz tartomány). Ezek a monitorok megkapták a Freesync támogatást, mivel annak minőségbeli követelményei jóval alacsonyabbak voltak, hogy el tudják árasztani a piacot, és hogy az olcsóságot is fevehessék a marketing szöveg közé.

A modulos G-Syncnek volt egy olyan előnye is, hogy több hw-t tudott támogatni. A 650Ti volt a minimum. Freesync oldalon pedig GCN 2, így kimaradt a támogatásból az elég versenyképes 7000-es sorozat és pl. a 280x is. -

HSM

félisten

válasz

keIdor

#47145

üzenetére

keIdor

#47145

üzenetére

"Most már a legtöbb monitor eleve tudja mindkettőt. Ez előnyére változott"

Tévedés. A mostaniak csak az adaptive sync-et tudják, ami a szabvány. Csak erre nagy kegyesen az Nv ráhúzta a G-sync compatible matricát.

(G-sync, FreeSync a gyártók VGA oldali implementációinak a fantázianeve.)#47146 b.: " fogalmad sem volt mikor lesz erre válasz"

A Vesa szabvány előbb volt, mint a G-sync, akkor hogy is van ez? Persze, a szabványos scalerek (amik nem 300 dolláros felárral oldották meg a problémát) miatt valóban sok idő telt el, mire a szabvány is utolérte őket."Nem megy most sem a freesync rajt"

De, mennek a freesync-es monitorok rajta, mivel azok a Vesa adaptive syncjét használják DP-on. Persze, volt pár típus, ami HDMI-n az AMD saját szabadalmát használják, az valóban nem működik Nv-n.#47147 Busterftw : Van más is, pl. kompatibilitás, verseny.

Jó dolog az "innovációval" dobálózni, de veszélyes, ha ezzel csomagolod be a valójában versenykorlátozó gyakorlatokat.#47148 keIdor : Én akkoriban is AMD kártyákat használtam. De olvastam a fórumon is morgolódást, hogy volt, aki szeretett volna AMD kártyát, de a monitorán nem akarta elveszteni a sync képességet.

Az Nv-nek most eléggé bejött, hogy olcsó az 5nm, hogy nem viszik már úgy a csipeket. Ha nem ilyen lenne a gazdaság sokkal nagyobb előnye lenne az RDNA3-nak a chipletezésből.

#47149 keIdor : FrameGenjük fog jönni hamarosan az FSR3-al. Meglátjuk, milyen lesz. Az mindenképp jó pont, hogy menni fog az előző generáción, így remélhetőleg ki fogom tudni próbálni a 6800XT-men.

-

keIdor

titán

Azt továbbra is problémásnak tartom, hogy az AMD-nek nincs 4K@120Hz-re alkalmas kártyája. OLED TV-k ára azért annyira nem is horror, tehát nem egy tömegeknek elérhetetlen kijelzők ezek manapság.

Mert a 7900XTX jóindulattal 60Hz, és ha Ray Tracing is szóba jön, akkor arra sem.

Ott a Cyberpunk 2077 Path Tracing, RTX-4090: 2160p, RT: PT on, DLSS Quality, FrameGen on és 60-70 fps.Most ugyanerre a beállításra nincs AMD kártya. RT-től jobban eleve lehal, FrameGen nincs, FSR meg rosszabb képminőség. Én elismerem az AMD-nek azt a termékét, ami tényleg jól sikerült, de a fenti szerintem problémás. Oké, hogy a userek többsége nem engedheti meg, de ha akarnék se tudnék AMD-re váltani, mert nincs a 4090-el RT-ben is megegyező kártyájuk. FrameGen hiánya is fájó pont, mert jó ha van.

-

keIdor

titán

"Ha pedig megvetted a méregdrága G-sync monitort, utána már csak Nv kártyával működött, mivel nem volt szabványos.

"

"

Ahogy írtam is, övék a market share 80-90%-a egy évtizede, de lehet több is van már. Nem hülyék dolgoznak ott, mert úsznak a pénzben, úgy kalkuláltak a marketingesek, hogy a nagyrészük maradni fog GeForce vonalon. Hiszen akkor nyeregben voltak a 780(Ti)-al, 980(Ti)-al, a Pascalt meg sem említem. Fury X és Vega nem sikerültek jól, késtek is fél évet bőven. Ezért sem volt probléma a zárt rendszer, mivel régóta nagyon dől a pénz az nVidiához. Most is egyébként a 7700XT/7800XT késett fél évet. Valahogy nagyon nem tud talpra állni a Radeon részleg, ami a Ryzennek sikerült, a Radeonnak nem. Pedig az RDNA2-nél azt hittem sikerül tartani a tempót, de nem úgy látszik. Vagy csak az nVidia nyúlt nagyon mellé a Samsunggal, nézőpont kérdése.(?) -

Busterftw

nagyúr

"Egyébként vélhetőleg lényegesen kevesebb elektronikus hulladék keletkezett volna"

Aminek ugye semmi koze a temahoz. De hat oke, ha mas erv nincs."utána már csak Nv kártyával működött"

Ez csak annak volt fejfajas, aki AMD kartyat valasztott anno, az userek kisebb hanyada.

A lenyegen nem valtoztat, az innovaciot nem hatraltatta a "szabvanyositas" amit csak gyengebb termeket eredmenyezett es futast a konkurencia utan. -

Értem amit írsz és elolvastam.

Azok az azonos kategóriák mindig később jöttek. Nem az volt hogy jött a Freesync 2 aztán Nvidia hozta a Gsync ultimatet, hanem fordítva, fogalmad sem volt mikor lesz erre válasz. Évek teltek el közben. A mostani helyzet már szuper Freesync 2 mindenben ok.

De anno volt kettő nem mellékes dolog:

Mire megy az ember a Freesynccel Nvida kártyával? Nem megy most sem a freesync rajt, hanem egyszerűen a szabványos DP Adaptive szinkronizációt engedte Nvidia.

Tehát a Freesync továbbra is AMD, a Gsync meg továbbra is Nvidia maradt. Az egyik hardvert használt a másik nem ennyi a különbség.

Ez szerintem inkább a monitorgyártók érdeme, kényszerítő hatása az Nvidiára. Nekem Asus Gsync monitorom volt azt váltottam le a Samsung freesync kettesre. Nem bántam meg.

Meg hát az is kell ahhoz hogy az ember az AMD VGA-k miatt váltani akarjon rá, ami a Pascal-Vega idején valljuk be, nem volt túl vonzó lehetőség. -

keIdor

titán

Tudom, hogy már van.

Én a régről beszéltem, ami 5-6 év lehetett kb. amikor még minden G-Sync monitor chipes volt.

Most már a legtöbb monitor eleve tudja mindkettőt. Ez előnyére változott.Én amúgy a zárt, de egy garantált minimum minőség híve vagyok. A zárt sem probléma, ha a tiéd a market share 80-90%-a. Mert ez már lassan egy évtizede így van.

-

HSM

félisten

válasz

Busterftw

#47143

üzenetére

Busterftw

#47143

üzenetére

"Ha az Apple is szabvanyozik, akkor nem lenne a piacon az usereknek ez a kenyelmi funkcio elobb."

Gondolom, kellett nekik, mint egy szelet kenyér... Egyébként vélhetőleg lényegesen kevesebb elektronikus hulladék keletkezett volna, ha hamarabb beállnak ők is az USB-C mögé.

Egyébként vélhetőleg lényegesen kevesebb elektronikus hulladék keletkezett volna, ha hamarabb beállnak ők is az USB-C mögé."Nem tudom milyen fejfajasrol beszelsz."

Mondjuk arról, hogy kettévágták a piacot, vagy megvetted a méregdrága G-syncet, vagy nem volt synced. A szabványos adaptive sync monitorokat meg nem kezelték a kártyáik évekig. Ha pedig megvetted a méregdrága G-sync monitort, utána már csak Nv kártyával működött, mivel nem volt szabványos.

A minőség biztosítására normális helyeken tanúsítványokat alkalmaznak, pl. HDR600 a VESA-tól [link] , nem pedig vendor lock-in-t.

-

Busterftw

nagyúr

Azt, hogy az USB-C peldad teged cafol.

Mig az USB-C szabvanyt 2014-ben fogadtak el, a Lightning mar elotte ket evvel tudta a szimmetrikus csatlakozast.Ha az Apple is szabvanyozik, akkor nem lenne a piacon az usereknek ez a kenyelmi funkcio elobb.

"A scaler ugyanúgy működhetett volna szabványos alapokon, sok fejfájást megspórolva az érintetteknek."

Nem tudom milyen fejfajasrol beszelsz. A fix, ellenorzott/tesztelt hardver biztositotta a minoseget."Ez Freesync-nél is ezer éve adott, LFC néven"

De jo hogy felhoztad, ujabb cafolat a szabvanyositasra es az innovaciora.

Az AMD a G-Sync utan csak 3 evvel jelentette be az LFC-t, ami engedte a Freesync mukodeset teljes tartomanyon. Ezt a G-Sync mar tudta releasekor.#47141 b.

"Ettől függetlenül voltak persze nagyon jó monitorok is köztük,csak a Freesync plecsni nem volt garancia semmire."

Pontosan a kulonbozo gyartok/modellekben hasznalt eltero minosegu scalerek miatt. -

HSM

félisten

"például az hogy 2 évvel elöbb mutatták be"

Kb. igen. Ugyanakkor a már-már szokásos szabványtiprás mellett, ugyanis a DP1.2a már 2013 januárban hozzáadta a szabványos megoldást (adaptive sync), de az Nv-nek nagyon fontos volt fél évre rá egy saját, zárt, inkompatibilis megoldással megtrollkodni a piacot. Véletlenül sem a szabványt implementálták a moduljukkal...."már leglább 144 Hz működést, magas HDR fényerőt, minimum válaszidőt, meg hasonló jóságokat írt elő"

Elolvastad, amiket írtam? Azonos kategóriát kéne nézni. Ugyanúgy léteztek prémium Freesync megoldások is. Azok ugyanúgy tudták a HDR-t, fényerőt, 144Hz-et, stb. Az első G-sync monitor is gyakorlatilag úgy készült, hogy szereld ki egy a már létező ASUS VG248QE típusból a gyári scalert [link] ....

Nézhetnénk úgy is, a Freesync lehetővé tette, hogy olcsó monitorok is hasznos plusz szolgáltatással bővüljenek gazdaságosan, lásd az említett olcsó 48-75Hz darabok. Ezek árából a G-sync modul sem jött volna ki, annak pedig magában még csak képe sincs.

-

A Gsyncnnekelőnye volt a Freesync első verziója ellen, például az hogy 2 évvel elöbb mutatták be ha jól emlékszem, valamint a Gsync második verziója már leglább 144 Hz működést, magas HDR fényerőt, minimum válaszidőt, meg hasonló jóságokat írt elő.

Tehát itt is az volt, hogy volt egy olyan megoldás ami zárt volt de garantált egy minimum magas minőséget nyújtott, meg volt a másik oldalon egy idővel később érkező, nyitott de sokszor szinte játékra használhatatlan megoldások amik 40 és 60 hz mögött működtek, lassú válaszidővel stb.

Ettől függetlenül voltak persze nagyon jó monitorok is köztük,csak a Freesync plecsni nem volt garancia semmire.. A Freesync 2 volt az a lépés aminél egyenrangú lett a két cég megoldása ez után lépet is Nvidia vagy rákényszerült a lépésre, ez a jó szó.

Én is egyből lecseréltem a Gsync Asus-t egy Samsungra, miután támogatta már az alap szabványt az NV. -

HSM

félisten

válasz

keIdor

#47137

üzenetére

keIdor

#47137

üzenetére

"Egyetértek, G-Sync ment már 30Hz/30fps felett is, FreeSync sok termék esetén meg csak 48-120Hz/fps tartomány."

Ez Freesync-nél is ezer éve adott, LFC néven, gyakorlatilag akárhány FPS-től működik a szinkron, ha elég nagy tartományt tud a monitor. Ma már külön tier, Freesync Premium néven futnak ezek. (Nem változott semmi, csak lett egy szigorúbb feltételekhez kötött matrica a megfelelő termékekre [link] .) A sajátom is ilyen, 48-144Hz-ig tud a panel, de mivel aktív az LFC, így vajsima 25-30FPS-el is, nyilván amennyire sima tud lenni 25-30FPS.

Nyilván nem a legolcsóbb freesync monitorok tudását érdemes összehasonlítani a G-syncesekkel, hanem hasonló képességű panellel felszerelteket.A G-sync modul előnye szvsz kizárólag az volt, hogy az overdrive-ot tudták vele frekvenciafüggően változtatni, ami sokáig biztosan hiányzott a Freesync megoldásokból. De ez a feature szvsz sehogy sem ér meg egy 300 dolláros modult, főleg szabvány kompatibilitás nélkül.

-

keIdor

titán

Igen a Turing jól sikerült és hiába volt 450 ezer/1200€ az RTX-2080Ti, aki befizetett rá 2018-2019-ben, az nagyon jól járt, mert az egész 2020-2021-es bánya őrületet megúszta vele. Persze utólag okos az ember, senki sem tudhatta, de utólag ezek az emberek szerencsésnek mondhatják magukat.

Most már én is így tettem volna…A 11GB meg a mai napig azért elég. Simán jó az még 1440p-re és egy 3070-nél is tovább fogja bírni.

-

válasz

keIdor

#47137

üzenetére

keIdor

#47137

üzenetére

Így van.

Amúgy az öregedésre vissza térve, Turing meg rommá veri az RX 5700 kártyákat ha a szolgáltatásokat nézzük.

Egy barátom 2080 Ti vel van már évek óta, 1080P-n igaz, de mindennel játszik RT vel , most meg a z FSR3 és DLSS3,5 még jobban kitolja a lehetőségeit.11 GB vrammal elvan vígan. -

keIdor

titán

válasz

Busterftw

#47133

üzenetére

Busterftw

#47133

üzenetére

Egyetértek, G-Sync ment már 30Hz/30fps felett is, FreeSync sok termék esetén meg csak 48-120Hz/fps tartomány.

Mikor GTX-1080Ti-al kellett játsszam az RDR2-t, ott nagyon nem volt ez mindegy…

nVidia sokszor zártabb, de jobb is a minőség. DLSS esetén most ugyanez elmondható. Továbbra is azt mondom, valamit, valamiért.

Ugyanakkor azt is elismerem, hogy az AMD is tud jókat mutatni. Kepler rosszul öregedett a GCN2-höz képest, meg egy HD7970 is sokkal tovább bírta, mint a Fermi.

De ott a DirectX 10.1 esete is, AMD támogatta, az nVidia nem és elég bicskanyitogatóan is kezelték a zöldek.

I give credit where credit is due. -

HSM

félisten

válasz

FLATRONW

#47124

üzenetére

FLATRONW

#47124

üzenetére

Összedugják a fejüket, hogy milyen adatokból, a futószalag melyik pontján kéne egy ilyen technológiának szerepelenie, és milyen kimenetet kell adnia a játéknak. Onnantól kezdve a belső működés már mindenki magánügye lehetne. A DLSS is maradhatna a saját technológiájuk, az FSR is maradhatna nyílt.

A játékfejlesztői wrapperek és a streamline is ezt próbálja, de ez utólag már foltozgatás, ezt előre kellett volna jó alapokra építeni, ami mindegyik érintett igényeinek megfelel."Az a baj, hogy közös szabvány esetén nem igazán tudnának egymással versenyezni."

Miért ne tudnának? Mennyire terheli a hardvert, milyen a képminőség, temporális stabilitás? Bőven van hol versenyezni.#47125 b.: Ezért kéne összeülni, megegyezni.

#47126 FLATRONW : Miért ne lehetne? Régen ilyen volt pl. az anizotróp szűrés. Szabvány volt, de bizonyos VGA-kon jobb minőségben dolgozott. Pl. a HD6800-6900 széria ezen javított az előző generációs Radeonokhoz képest [link] .

#47129 Busterftw : Nem tudom, mit akarsz bizonyítani a listáddal. Talán azt, hogy évek óta van szabvány és innováció is? Miközben ezt tudom írni egy USB-C-s dokkolóról, USB-A-s perifériákkal?

#47133 Busterftw : A scaler ugyanúgy működhetett volna szabványos alapokon, sok fejfájást megspórolva az érintetteknek. De inkább a lock-in-t preferálták.

-

Busterftw

nagyúr

válasz

proci985

#47131

üzenetére

proci985

#47131

üzenetére

Nem volt trollkodas a G-Sync, az extra hardver azert kellett, hogy minden monitorban ugyanugy mukodjon a scaler.

A Freesync ezert tudott elteroen viselkedni (eltero tartomany stb), mert minden monitorban mas scaler volt.Most a G-Sync Compatible-nel pontosan ezert vizsgal az Nvidia, mert ott kicsivel tobb a G-Sync teszt kovetelmeny, mint hogy radobjak a Freesync plecsnit.

A hardver a fix minoseget biztositotta. (es teszi ezt a mai napig az Ultimate tierben)

-

válasz

FLATRONW

#47128

üzenetére

FLATRONW

#47128

üzenetére

Én is ezt gondolom,főleg,hogy van 200 DLSS játék,ami nem szponzorált,függetle n döntés.

proci985:

Ezt a forgatókönyvet már olvastam valahol,hogy azért hozta a Gsyncet ,mert jön a freesync,csak nem igaz szerintem .

AMD a Gsync bejelentése után valami kiállításon egy laptopon mutogatta a freesync korai verzióját ami azt hiszem egy meglévő technologia volt. -

proci985

MODERÁTOR

a DXR nem fut a RDNA1-en, pedig tudna

papiron igen, gyakorlatilag a generacios csucs 5700XTn se birna barmilyen ertelmes FPSt elerni. felesleges lett volna eroforrast pazarolni a szeriara.#47127b. a g-synch pont egy trollkodas volt, avagy free-synchhez kepest kellett az extra HW meg a vendor lock-in az alapfunkciok bizonyosfoku javitasa miatt. plusz korabban kihozva picit amikor tudtak, hogy jon a freesync, hogy erezd a premiumot. egyebkent a kesobbi megoldasok altalaban krosszkompatibilisek

hasonlo trollkodast egyebkent megcsinaltak anno a physXel is, csak altalaban olyan szinten elszurtak az optimizaciot (ld Borderlands2 ahol negyedelte az FPSt ultrawide helyzetben vagy a Crysis2), hogy egy ponton gimmickke valt, pedig lett volna ertelme.

driver szinten ugyanezt jatszak pl *nixen utobbi 1-2 evben, avagy a driver OS, de boszen mozgatjak le BIOS szintre a funkcionalitas egy reszet.

-

gV

őstag

de mindig kizár valamilyen hardvereket a körből

amúgy ezt az AMD is csinálja, a DXR nem fut a RDNA1-en, pedig tudna. ahogy pl. a Turing GTX-eken fut is. értem én, hogy a bőrkabátos a sz_rarc, de abban a kérdésben, hogy az nV saját pénzén fejlesztett technológiáknál megválogatja min engedi futtatni, részemről rendben van. így az FG-ért sem hullajtok könnyet, hogy nem megy Turingon, annak viszont örülök, hogy terjed, mert a vele együtt jövő reflexet én is tudom használni.

-

Busterftw

nagyúr

"Lásd USB-C."

Nem cáfoltad meg, inkább engem igazol.

Typy-A csatlakozó után 18 évet kellett várni a Type-C - re.De nézzük magát az USB-t, amit ugye hasonlóan több nagy cég kezdett, hogy majd ők jól megtolják az innovációt együtt.

USB 1.0 1996

USB 2.0 2000

USB 3.0.2008

USB 3.1 2013

USB 3.2 2017

USB 4.0 2019És ezek specifikáció dátumok, nem kész termékekben lévő megoldások.

-

válasz

FLATRONW

#47126

üzenetére

FLATRONW

#47126

üzenetére

Ilyesmi lenne jó.

AMD és Intel kb úgy gondolkodik, hogy hoznak egy általános megoldást és néha azon felül hoznak egy specifikust, mint mondjuk az AMD féle framegen nem FSR3 változata vagy Intel XeSS nek is van olyan verziója, ami csak Intelen fut és jobb minőséget ad de van egy általános is.

Nvidia hoz egy frankó megoldást, viszonylag jól megvalósítja, de mindig kizár valamilyen hardvereket a körből vagy ahhoz köti őket és az alap általános támogatást nem szorgalmazza.Ez alól az RT a kivétel, mert a Microsoft DXR adja az alapot , egy szabványra épül, azt maximum gyorsítani lehet speckó hardverekkel és megoldásokkal de az alapok adottak.

Ugyanezt meg tudta volna oldani Gsyncnél is, hogy hoz egy alap adaptiv támogatást minden Nvidia kártyára aztán hardverhez köti a jobb minőségű Gsync-et vagy egyes szolgáltatásokat.

DE erre én nem az olyan open megoldásokat látom megfelelőnek, amik egyetlen VGA gyártótól származnak vagy ahhoz köthetőek. -

FLATRONW

őstag

A kérdés inkább az, hogy egy szabványt lehetséges e úgy támogatni, hogy az jobb minőséget hozzon, mint amit a konkurencia képes hozni.

Pl. a szabvány Adapiv Syncre épülő Freesync és G-Sync Compatible azonos minőséget képvisel. Minden más, ami különbséget jelent, azt szabványon kívül hozza mindkét gyártó. -

FLATRONW

őstag

Engem az érdekelne, hogy egy szabványosítás pontosan mit jelentene jelen esetben.

1. Az NV megnyitja és bedobja a közösbe a DLSS-t, és így minden gyártó kártyáján azonos minőségben, és közel azonos teljesítményen lesz elérhető a közös eljárás, ami lényegében a nyílt DLSS-re épülne, mert az FSR jelenleg nem igazán tud mit hozzáadni?

Ezzel az a baj, hogy így az NV nem nyerne vele semmit, csak felhozná a konkurencia termékeit, és elveszítene egy olyan szolgáltatást, ami vásárlói szemszögből adott esetben dönt a két gyártó közötti választásnál.

2. Gondolom az az eset nem lehetséges, hogy az FSR-t szabványra emelik, az így szállított kódot az NV driverből kiegeszíti vagy lecseréli a DLSS azon extra képességeivel, amelyek jelenleg a különbséget jelentik. Így megmaradna a minőségbeli előnye. Ha ez lehetséges lenne, akkor ma is megtehetnék.

Az a baj, hogy közös szabvány esetén nem igazán tudnának egymással versenyezni. Teljesítményben szinte azonosak jelenleg is, az erősebb hardverrel már nem tudnak előrébb lépni.

Az RT az más dolog. A szabvány ellenére az NV ott előnyben tud lenni, mert az még mindig egy megterhelő eljárás, egy jobb és erősebb hardverrel előnybe lehet kerülni.

-

HSM

félisten

válasz

Busterftw

#47117

üzenetére

Busterftw

#47117

üzenetére

"Ha az Nvidia kozos interfacen egyezkedett volna a konkurnciaval, akkor nem lenne most RT-ben es AI felskalazoban elonyben."

Pedig RT-re ott van a közös interfész (DXR/Vulcan), ahogy egyébként Ai-ra is (DirectML), és mindkettőben előnyben vannak."Nem tudom mirol beszelsz"

Arról, hogy az FSR3 FÉK FRÉM generátora működni fog az előző generációs kártyáikon, így majd nyugodtan kipróbálhatom ha majd megjelent az RX 6800XT-men.

Míg, akik a nagy innováció hajtotta gyártó konkurens RTX3080-asát vették, azok vehetnek új kártyát a DLSS3-hoz, mert abban még nincs megfelelően innovatív OPTIKFLÓ AKKELERÁTOR.![;]](//cdn.rios.hu/dl/s/v1.gif)

-

keIdor

titán

válasz

Raggie

#47109

üzenetére

Raggie

#47109

üzenetére

Szerintem nincs baj a felskálázással, ha az olykor szebb képet ad, mint a natív, +10 fps-t még.

A baj akkor van, ami a Remnant 2-nél is, hogy felskálázással számoltak csak a 60 fps-re, csak annyira optimalizálták, ami nonszensz.

Tartok tőle, hogy ez egy új trend kezdete lesz. Natívval kéne számolniuk és ha kell valakinek a plusz, akkor bekapcsolja. -

Busterftw

nagyúr

"Hibás az érvelésed. Ha előre megegyeznek egy jó interfészben"

HIbas az ervelesed, mert a piaci verseny nem igy mukodik es hatraltatta volna az innovaciot ugyanugy.

Ha az Nvidia kozos interfacen egyezkedett volna a konkurnciaval, akkor nem lenne most RT-ben es AI felskalazoban elonyben.

Illetve erre nincs garancia (ha megegyeztek volna)"mert kellett valami duma, miért is vegyenek az emberek TENZOR kóros RTX VGA-t?"

Nem tudom mirol beszelsz, RT nelkul is jo es kompetetiv szeria volt a Turing.

Ugyanez igaz az Ada-ra is. Akinek nem kell az RT/DLSS, igy is jo kartyat kap. -

HSM

félisten

válasz

Busterftw

#47108

üzenetére

Busterftw

#47108

üzenetére

"ha kezdetektől fogva közös szabványon keresztül kellene ennek piacra jutnia, akkor most vastagon szopnának az Ada userek."

Hibás az érvelésed. Ha előre megegyeznek egy jó interfészben, akkor teljesen mindegy, mikor készül el az AMD megvalósítása."Ehelyett az Nvidia üti a vasat, innovál és kijött vele, mert kész volt."

Akarod mondani, mert kellett valami duma, miért is vegyenek az emberek TENZOR kóros RTX VGA-t?![;]](//cdn.rios.hu/dl/s/v1.gif)

Most persze megint vehetnek új RTX4000-et mert abban OPTIKFLÓ AKKELERÁTOR is van FÉK FRÉM generálni.

Most persze megint vehetnek új RTX4000-et mert abban OPTIKFLÓ AKKELERÁTOR is van FÉK FRÉM generálni.  De legalább dübörög az innováció.

De legalább dübörög az innováció.

-

FLATRONW

őstag

válasz

Raggie

#47109

üzenetére

Raggie

#47109

üzenetére

A látottak és leírtak alapján nagyon úgy tűnik, hogy ezzel nem lehet annyi időt nyerni, hogy azt bármi hasznosabbra lehessen elkölteni.

A megjelenés után hónapokat kell várni, hogy rendbe rakják a játékokat. Moderek pedig egy hét alatt képesek beletenni, a fejlesztők valószínűleg még könnyebb helyzetben vannak.

Én azt mondom, hogy megjelenés napján legyen benne felskálázás, hogy legalább csökkenteni lehessen az teljesítmény gondokat. Ezzel is időt nyerve maguknak a további javításra.

Felskálázás nélkül pl. ezt a "csoda" Immortalt sem adhatták volna ki.

XSX és PS5-ön 4k FSR2 Ultra Performance (720p) módban fut a játék.

Series S-en pedig 436p az alap felbontás. -

Raggie

őstag

Ah, értem. Azért ez egyel kevésbé megnyugtató nyilatkozat, mintha AMD azt mondta volna, hogy általánosságban soha nem blokkolja a konkurencia technológiáit.

Mindenesetre azt nem vitatja senki itt, hogy az volna a legjobb ha nem lenne tiltás semmire.

Inkább azon megy a vita, hogy ha nincs tiltás, akkor milyen energiát/időt/pénzt mire fektessen be a stúdió, hogy a lehető legjobb játékot tegyék le az asztalra.Egyébként én azt mondom, hogy mindegyik felskálázási technikát hanyagolni lehetne és a rájuk fordított energiát inkább bugfixelésre és a day0 patch-ek elkerülésére lehetne fordítani. Aztán a felskálázások jöhetnek az első havi petch-el vagy valami.

-

Busterftw

nagyúr

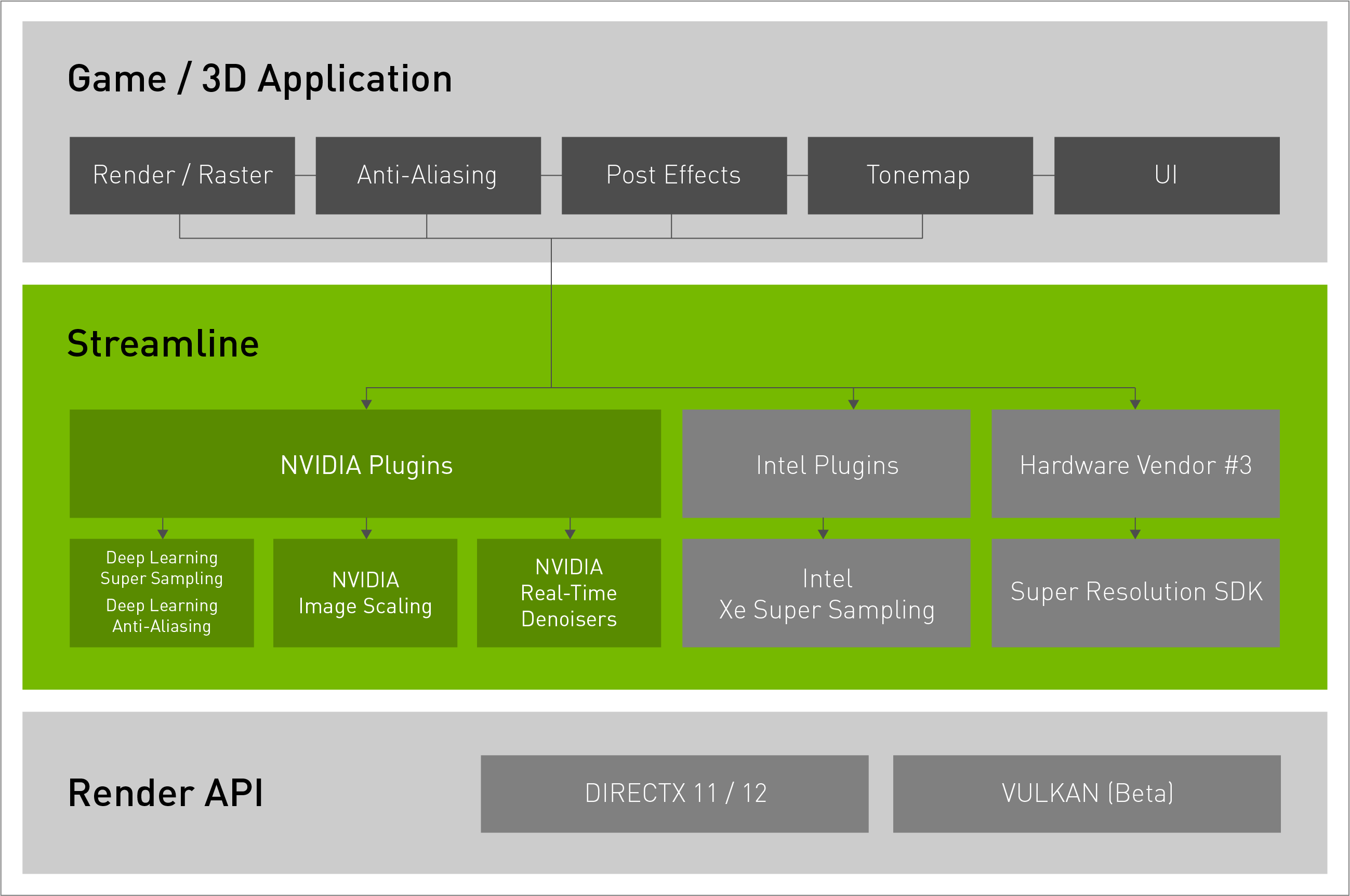

Erre ott van a Streamline SDK, amihez pont az AMD nem csatlakozott.

A DLSS plugin pl UE5-ben rém egyszerűen be kapcsolható és OTA frissül, szóval nem értem továbbra sem ezt a hatalmas fejlesztői erőforrást a beépítésrőleés a karbantartásról amiről beszélsz."Miért ölné meg?"

Mert a piaci szereplőknek össze kell ülni és megegyezni egy köztes megoldáson.

Az AMD lassan 10. hónapot üli az FSR 3.0-on és ezzel együtt a frame genen, ha kezdetektől fogva közös szabványon keresztül kellene ennek piacra jutnia, akkor most vastagon szopnának az Ada userek.

Ehelyett az Nvidia üti a vasat, innovál és kijött vele, mert kész volt.

Zárt vagy nem zárt, az usernek tök mindegy, neki az a lényeg hogy piacon van és jól működik. -

válasz

Raggie

#47105

üzenetére

Raggie

#47105

üzenetére

Azt írta hogy a Starfieldben, ebben a játékban nem blokkolja a készítőket, nem azt hogy eddig nem tették.

Ez így 4 héttel a balhé után a sajtó/ közösségek nyomására érdemi lépés volt.Pug :

Nem hiszek senkinek csak véleményem van.

Ugyan ez lenne ha Nvidia blokkolná az FSR-t és az XeSS-t és vitatkoznék erről bárkivel mert az XeSS csak Intelen futó verziója is baromi jól sikerült a tesztek alapján.

DLSS közeli minőség és amúgy is szorítok Intelnek.

Nvidiát is rühellem azért, hogy a framegent nem teszi elérhetővé Amperen, én meg dönthessem el jó e nekem az a minőség.

Nem én találtam ki a dolgot ami media hírré tett és megfogalmazódott.

Nem tőlem származik a felvetés, ezek a táblázatok sem, az hogy a HU és GN erről videókat csinált és utána járt megkereste mindkét gyártót. AMD vel semmi gondom amúgy.

A témát én is unom és én is sokallom magam, nem akartam ezzel ennyit foglalkozni, szóval elhiszem, hogy te is. Tényleg elengedem.

-

HSM

félisten

válasz

Busterftw

#47102

üzenetére

Busterftw

#47102

üzenetére

"ha valamibe mindenki úgy nyúlhat bele és változathatja ahogy jónak látja, abból hogy akarsz szabványt"

A szabvány az interfésznek kell, hogyan kell pl. etetni adattal egy ilyen technológiát, és annak hogyan kell adott adatokkal működnie. Innentől mindenki szállíthatná a saját megoldását alá, és csak egyszer kellene a fejlesztőnek szívni a beépítéssel, karbantartással.

Ha egy ilyen open source megoldásba a fejlesztő belenyúlna, onnantól az ő felelőssége lenne, hogy továbbra is megfeleljen a szabványos interfésznek a működés.

"Ez pont az innovációt ölné meg, hiszen nem lenne verseny."

Miért ölné meg? A versenyt éppen a zárt technológiák és licenszfeltételek ölik meg.

Lásd USB-C. Bár vannak kifogásaim vele, de be kell lássam, pokoli kényelmes és környezetbarát, hogy egyetlen komolyabb USB-C töltővel/dokkolóval minden USB-C eszközt tudok itthon tölteni. Szemben a korábbi gyakorlattal, hogy ahány kütyü, annyiféle töltő hozzá. A verseny is köszöni szépen, jól van, USB-C-s telefon/tablet/notebook/powerbank és töltő/dokkoló oldalról is. Sőt, notebook téren még javult is a verseny, mivel pl. dokkolóból már nem csak az adott gyártó sokszor típusspecifikus dokkolóját (vagy töltőjét) tudod megvenni, hanem ha vettél egy általános USB-C dokkolót az minden épkézláb dokkolható USB-C-s notebookhoz jó lesz.

-

válasz

Busterftw

#47102

üzenetére

Busterftw

#47102

üzenetére

Nagyjából amúgy közös megoldás.

Nvidia temporális eljárást használni, az FSR 1 még nem , aztán az FSR2 már az lett és az XeSS is az. Épp ezért mondják , az Unrealos fejlesztő fickó is, hogy ha az egyik gyártó eljárására elkészül a temporális tréning onnantól a másik kettő eljárást egyszerű beépíteni. Ezért tudják a modderek akár 1 nap alatt beletenni.

A Resident Evil-be amodder állítása szerint ennyi idő volt beletenni a DLSS-t, és a működése szinte kifogástalan, jobb lett mint az eredeti FSR kivéve a menü és rejtvények ahol enyhén szellemképes,de a 3.1 már ezt is megoldotta benne [link]

A DLSS tweak [link] szuper segítség ehhez. -

Busterftw

nagyúr

Külön külön tiszta sor, éppen ezért vagyok kíváncsi, hogy gondoltad ezt?

Tehát ha valamibe mindenki úgy nyúlhat bele és változathatja ahogy jónak látja, abból hogy akarsz szabványt?A kettő eléggé üti egymást.

"Az véletlenül sem opció, hogy esetleg leüljenek egy asztalhoz a nagy innováció közepette és találjanak egy közös megoldást?"

Ez pont az innovációt ölné meg, hiszen nem lenne verseny.

Ezért is jobb az Nvidia megoldása, mert piac vezetőként nekik presztízskérdés, hogy ebben is jobbak legyenek mint az Intel és az AMD.A felhasználóknak pedig ezért lenne az a legjobb megoldás, ha választhatnak.

-

Brutális.

Új hozzászólás Aktív témák

A topikban az OFF és minden egyéb, nem a témához kapcsolódó hozzászólás gyártása TILOS!

Megbízhatatlan oldalakat ahol nem mérnek (pl gamegpu) ne linkeljetek.

- Építő/felújító topik

- Víz- gáz- és fűtésszerelés

- iPhone topik

- OpenWRT topic

- Futás, futópályák

- Audi, Cupra, Seat, Skoda, Volkswagen topik

- Samsung Galaxy S25 Ultra - titán keret, acélos teljesítmény

- Milyen billentyűzetet vegyek?

- Bittorrent topik

- Brogyi: CTEK akkumulátor töltő és másolatai

- További aktív témák...

- 27% - ÚJ MSI GeForce RTX 5060 Ti VENTUS 2X OC PLUS 8GB GDDR7 Videókártya

- Gigabyte GeForce RTX 4080 Super 16GB Gaming OC eladó SOK-SOK GARIVAL

- Gainward GeForce RTX 4070 Ti SUPER Phoenix

- Gainward RTX 3080 10GB GDDR6X Phoenix

- 27% XFX Radeon RX 9070 Swift OC Triple Fan Gaming Edition 16GB GDDR6 256bit Videokártya

- AKCIÓ! HP EliteBook x360 830 G7 i5-10210U 16GB 512GB 1 év garancia

- HP Victus Gaming Laptop RTX 4070 / i7-13700H 16GB DDR5 1TB SSD Garancia

- Dell Vostro 3425 6magos Ryzen 5 5625U 8GB RAM 256GB SSD

- Azonnali kézbesítés az év bármely pillanatában

- Dobozos Új Dell Xps 9530 i7 13620h 16gb ram 1tb ssd intel uhd graphics+ Intel Arc A370M

Állásajánlatok

Cég: Laptopműhely Bt.

Város: Budapest

Cég: PCMENTOR SZERVIZ KFT.

Város: Budapest

![;]](http://cdn.rios.hu/dl/s/v1.gif)

"

"