Új hozzászólás Aktív témák

-

do3om

addikt

válasz

Petykemano

#37271

üzenetére

Petykemano

#37271

üzenetére

Ha igy megy ahogy elsőre tűnik, amire kijön a navi annyi NV kari lesz a piacon hogy egyszerűen nem lesz hova tenni. Sem árban sem teljesítményben, a megjelenési időt meg nem is említem, már a most is késő nem hogy 19 vége.

Egyszerűen elveszlik majd az NV termékpalettája között.

-

válasz

Petykemano

#37238

üzenetére

Petykemano

#37238

üzenetére

Hát az eddigi trendek alapján (Maxwell-Pascal) 1536 számolósnak kellett volna lennie. De ugye a nagyobb lapka selejtjeiből készül, így nem tiltanak le annyit, így az szokásoshoz képest kb 25% előnye lesz. Kb egy 1070 szintjét fogja ez így hozni, legalábbis ha nem herélik ki.

Én kb úgy nevezném, hogy a GDDR6-os verzió az 2060 Ti, a GDDR5 pedig 2060.

-

HSM

félisten

válasz

Petykemano

#37238

üzenetére

Petykemano

#37238

üzenetére

Azért a 64 helyett 48 ROP és vágott memória interfész szerintem erősen bele fog rondítani azért a képbe a tiltott számolókon felül, főleg RT-el.

A 1060 készleteket nem féltem, szerintem ez nem azokra lesz veszélyes, egy ekkora GPU-val lényegesen drágábban fog nyitni. Az én tippem, hogy a 1060 marad 80-100K környékén, mint olcsó de korrekt sebességű GPU és a GTX1070 150K körüli árán fog nyitni a 2060.

Egyszerűen nincs benne piaci logika, hogy a 1060 árán adjanak egy annál nagyságrendekkel költségesebben gyártható (és vélhetőleg jóval gyorsabb) terméket, főleg nem a megjelenéskor.Lásd: [link]

-

hhenry

őstag

válasz

Petykemano

#37238

üzenetére

Petykemano

#37238

üzenetére

Kiváncsi leszek,hogy ki szórják-e nagy leárazásokban az előző generációt esetleg

-

#45185024

törölt tag

válasz

Petykemano

#37223

üzenetére

Petykemano

#37223

üzenetére

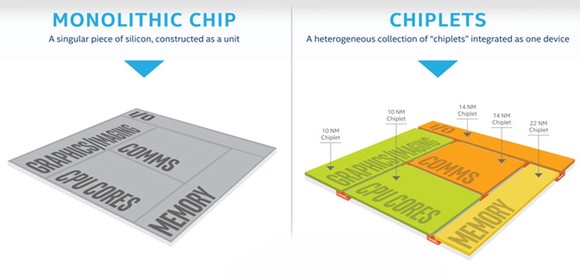

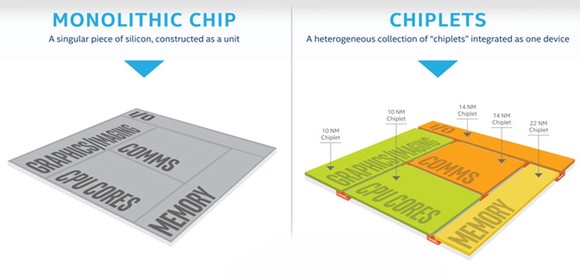

Nem is értem minek még videokártya

Alaplapra chipletesen rárakják ami kell

Intel meg AMD megfelezi a piacot NV meg megszunik ennyi

-

TTomax

félisten

válasz

Petykemano

#37207

üzenetére

Petykemano

#37207

üzenetére

Ahhoz hogy a volumenre tudjanak menni igen vonzó termékkel kell előállni.A legvonzóbb paraméter az ár,az az amit mindenkinek ki kell fiozetnie a pénztárnál,és a cserébe kapott teljesítmény.A külföldi forumokat olvasgatva, az a 3-400euros/font ársáv amit még sokan ki tudnak/akarnak fizetni.Az a baj hogy ebben az ársávban már ott van a 1070/Ti,vega56 söt voltak helyzetek amikor a 1080 is ott volt,bár nem sokat.Arra próbálok kilyukadni hogy egy 1070nél erösebb és kevesebbet fogyasztó vgara lenne szükség 300euro körül...igen azzal lehetne tarolni,de a realitásokat figyelembe véve nem sok esély lesz erre,vagy az ár vagy a teljesítmény nem lesz meg a kettö együtt szerintem nem fog menni.

-

#04430080

törölt tag

válasz

Petykemano

#37179

üzenetére

Petykemano

#37179

üzenetére

Fogalmam sincs. De azt a 3 GB kártyát már elfelejthették volna. Képzelj el egy 1070 -et 3GB VRAM -mal

-

#45185024

törölt tag

válasz

Petykemano

#37142

üzenetére

Petykemano

#37142

üzenetére

Mert árérték arányuk miatt alig veszik.

NVnek nagyon szüksége van az GTX 2070 2080-ra. Mert nem lesz eladása.

Még akkoris ha ezzel le kell nyelnie egy békát és nem lesz idén osztalák.

(Azzal nem értek egyet hogy 50-es részvényen sem lenne semmi baj, de lenne olyan eladási hullámot váltana ki és tele lenne minden az NV elértéktelenedése cikkel. A tőzsde elég pánikérzékeny...)

Milyen terméke lesz NVnek ami a Navival fog megküzdeni fél év múlva ? Az RTX 2070 ?

Az lesz mint eddig NVsek örülnek mert "győztünk"

AMDsek meg örülnek mert majdnem ugyanazt a teljesítményt megkapják féláron...

A tensor magoknak nyilván nincs értelme egy 2060ban, (már egy 2070ben sem sok) és mégsem jöttek ki.

NVnek 100-170 között köv fél évre nincs terméke ha meg navi ki jön csak rosszabb lesz...Válaszolnál a videóban feltett kérdésre ?

Videó

Videó -

válasz

Petykemano

#37113

üzenetére

Petykemano

#37113

üzenetére

Azzal az lehet a baj, hogy ott is húst fogsz majd, ahol a szemüveg szerint nem is kéne lennie...

-

válasz

Petykemano

#37047

üzenetére

Petykemano

#37047

üzenetére

Így van, tökéletesen egyetértek veled. Anno pont veled tárgyaltuk mennyire jó lehetne a 2400G egy NUC ban. na azóta se jött meg a Zotactól, én meg lemondtam róla, pedig nagyon szerettem volna.

-

proci985

MODERÁTOR

válasz

Petykemano

#37039

üzenetére

Petykemano

#37039

üzenetére

meg a hd48x0nal is

-

#45185024

törölt tag

válasz

Petykemano

#37035

üzenetére

Petykemano

#37035

üzenetére

Na én erre mindenképp szeretnék reagálni link

05%ovn van a 470 eladás és 9.35%on a 1050TI miközben egy erősebb GPUról beszéünk.

Én is nagybácsikája vagyok két kisfiúnak aj de szörnyú szó ez a bácsika szerintetek is ??? amiből egyik most ért a "PC-t szeretnék" időszakba és kérdezte tőlem milyen videókártyát vegyek. Hát mondom

-Neked egy 570 az pont jó lesz.

-De a barátomnak 1050TI van én is oyat akarok mondja.

-De mondom az egy lassabb GPU és drágább is...

-Nem baj Full HDre jó lesz az. és ragaszkodik a barátja tervéhez aki látta a youtuben hogy az a jóóóó..

Na amikor a PR ilyen mértékben lemérgezi a tudatot és a youtubberek meg a influencerek így nyomják akkor ne csodálkozzunk....

Adoredtől én ezen a videón nagyon csodálkoztam. Nem csak az árak miatt ha kis 7nm-es GPU lesznek és nem a "12nm-en átviszem a GPUmat kisebb tranzisztor de azonos szilícium méret helyett" akkor a kevesebb szilícium miatt az árak drasztikusan le is eshetnek...

De ebben a videóban pont a lényeg a 3600G APU (20CU)

ami értelmetlenné teszi 1060-ig mindent és ha kiadják egy csapás lesz a 2050Ti- re.

NV azért van csapdában mert végletekig eltolta a kártyaosztályokat a fejekben.

A következő 200 ezres kártyája nem veri meg a 2080Tit...

Az olcsósításnak nem csak az APUkban van helye de az Adored árak GPUra azok elszálltak. -

válasz

Petykemano

#37039

üzenetére

Petykemano

#37039

üzenetére

Nekemis szimpatikusabb, mindenképpen.

-

válasz

Petykemano

#37035

üzenetére

Petykemano

#37035

üzenetére

Akkor ennyi, nyugodtan lehet féknyúzként kezelni az rx 3k-s "híreket". Persze az AMD érdekelt benne, hogy ilyenek keringjenek, ha egyetlen vásárló meglévő AMD-s karit vesz vagy kivár, ahelyett, hogy az eredetileg tervezett rtx 2070-et beújítsa, már nyertek a dolgon.

-

proci985

MODERÁTOR

válasz

Petykemano

#37035

üzenetére

Petykemano

#37035

üzenetére

az 590 meg mehet egy kort az unnepi szezonban, addig is lehet nemi hasznot realizalni rajta

-

válasz

Petykemano

#37032

üzenetére

Petykemano

#37032

üzenetére

A bányászok részéről ugyan megszűnt a nyomás, de ahogy a mobiloknál firmware-optimalizálás és support helyett egymás után adják ki az ilyen kacatokat, aligha lesz jobb a helyzet.

#37033: a pletyka eredete azért édekelne. Bár simán lehet, hogy egy lelkes hívő nem bírta és alkotott

-

válasz

Petykemano

#36986

üzenetére

Petykemano

#36986

üzenetére

A GCN skálázódását SzVSz a fogyasztás állította meg, a Vega64 ha meghajtják, eszik annyit, mint egy 2080Ti, sőt!

Más: a VGA-árakban mikor fogunk látni hasonlót?!?

-

válasz

Petykemano

#36986

üzenetére

Petykemano

#36986

üzenetére

Az ár is kulcsfontosságú, azzal így is opreálht AMD, ha kevesebb is a hardveres teljesítmény.230-250 $ körül egy GTX 1070 vagy 300-350$ körül egy 1080 teljesítményű navi 7 nm gyártásból adódó előnyökkel szerintem siker termék lenne.

-

válasz

Petykemano

#36984

üzenetére

Petykemano

#36984

üzenetére

7nanón - ha már annyira istenítik az új gyártástechnológiát - pedig bizony illenék legalább a 2080-at/KÉTÉVES 1080Ti-t betámadni.

De ahogy mondtam fentebb, ez csak pletyka+klikkvadászat, elképesztően elszabadultak az álhírgyártók. Az RTX-ekről is év elejétől kezdve folyamatosan tolták a féknyúzt, 99%-uk bármiféle forrás nélkül, photoshoppal.

-

HSM

félisten

válasz

Petykemano

#36881

üzenetére

Petykemano

#36881

üzenetére

Azért ne kutyuljuk össze az ISA-t az architektúrával.

Ajánlom ezt az oldalt: [link].

Igen, az ISA nem változott, de kb. a csip minden más részét erősen fejlesztették a GCN3-hoz képest, ezért GFX8-ból GFX8.1, azaz továbbfejlesztett GFX8. Főleg szót érdemel az utasítás előbetöltés, a duplájára növelt L2, és a bővített lehetőségek az ütemezésre, amik lehetővé tették pl. a TrueAudio Next-et is. Ezek nem kis dolgok, nem véletlenül lett ez a legmagasabb IPC-jű GCN.

Főleg szót érdemel az utasítás előbetöltés, a duplájára növelt L2, és a bővített lehetőségek az ütemezésre, amik lehetővé tették pl. a TrueAudio Next-et is. Ezek nem kis dolgok, nem véletlenül lett ez a legmagasabb IPC-jű GCN.Még kis plusz infó, ha valakit érdekel: [link].

(#36883) lezso6:

-

#59036672

törölt tag

válasz

Petykemano

#36810

üzenetére

Petykemano

#36810

üzenetére

Engem nem érdekel a fogyasztás csak megjegyeztem milyen vicces. AMD úgy tudta nyögvenyelősen lenyomni a régi 1060-at, hogy 2x annyit fogyaszt az új 590.

-

válasz

Petykemano

#36776

üzenetére

Petykemano

#36776

üzenetére

Teljesen érthető a 7% bevételcsökkenés, sőt, reálisan nézve simán duplájára is tenném az Nvidia, 3-4x-esére az AMD bevételkiesését a VGA-üzletágból. De igazából annyi karit legyártottak - és szívott fel a bányaipar - hogy a két gyártó akár 6-8hónapra most be is szüntethetné a gyártást, míg a vevők elviszik a bányakészleteket. Teljesítményben a bányászkarikhoz képest egyedül a Turing az újdonság az asztalon, azt viszont 12nanón veszteséges gyártani.

-

imi123

őstag

válasz

Petykemano

#36776

üzenetére

Petykemano

#36776

üzenetére

Azokat az embereket sem értettem akik az AMD bukását várták, és azokat sem akik a Turing bukását várják.

Az AMD-nek kimondottam kedvez hogy piacra dobták a Turingot. Tudjuk mennyire erős a VEGA DX12-ben.Most kapott egy méltó vetélytársat. Ha sikeres a Turing akkor a VEGA el fog húzni a PASCAL-októl.

Nem is kell az NV-nek driveresen butítani a PASCAL-okat, elég az MS ajánlásait követni. -

Egon

nagyúr

válasz

Petykemano

#36776

üzenetére

Petykemano

#36776

üzenetére

Ennyi.

-

syberia

veterán

válasz

Petykemano

#36742

üzenetére

Petykemano

#36742

üzenetére

-

válasz

Petykemano

#36742

üzenetére

Petykemano

#36742

üzenetére

Ezért is húzta-halasztotta az nvidia ennyire a Turingot - AMD meg ki se adott semmit.

-

Abu85

HÁZIGAZDA

válasz

Petykemano

#36724

üzenetére

Petykemano

#36724

üzenetére

Ennek megközelítőleg sincs semmi köze a Chillhez. A Chill az egy scene pacing eljárás, míg az Adaptive Shading-féle megoldások amolyan vizuálisan veszteségmentes trükkök a képszámítás hatékonyabbá tételére. Ettől még ugyanúgy van parancslista, ugyanúgy nincs inputhoz ütemezve a képszámítás, ugyanúgy nem paraméterezhető a célzott képkockaszám, stb. Sokkal inkább a VR-ben alkalmazott Variable Rate Shadinghez van köze, csak nem úgy csökkenti a részletességet, hogy a kép fix részeit számolja kisebb részletességgel, hanem figyelembe veszi a tartalmat is.

-

HSM

félisten

válasz

Petykemano

#36697

üzenetére

Petykemano

#36697

üzenetére

"Combosabb hűtés kell => zaj"

Ajánlom figyelmedbe a TPU Rx590 tesztjét, hogyan lehet olyan halk egy 200W-s kártya, mint a legjobb 120W-os konkurensek. [link]

"With the default BIOS, the card is already very quiet, reaching only 31 dBA. The real kicker is the "quiet" BIOS, which is whisper quiet—as quiet as the best GTX 1060 cards we tested!"Combosabb PSU kell... Minél combosabb?

Egy SFX tápnál ez érdekes lehet, de egy nomrál ATX-es tápnál azért nem kell szélsőséges dolgokra gondolni +60-80W miatt. Én régebben 460W-os passzív tápról OC i5 4690K-t hajtottam R9 290X-el...

Egy SFX tápnál ez érdekes lehet, de egy nomrál ATX-es tápnál azért nem kell szélsőséges dolgokra gondolni +60-80W miatt. Én régebben 460W-os passzív tápról OC i5 4690K-t hajtottam R9 290X-el...

Egy akár 300W-os 290/390-nél még értettem a házhűtés meg táp parát, de egy 150-200W közötti kártyánál ezt már annyira nem gondolom jogos aggodalomnak.Szóval, nekem ezekből semmi előnyöm nincs. Amit a gyártók nyernek, hogy a GTX1060 gagyibban kivitelezett, olcsóbb hűtéssel és VRM-el is halkan működőképes, azt szépen le is nyelik.

-

válasz

Petykemano

#36697

üzenetére

Petykemano

#36697

üzenetére

Mindjárt te leszel kék-zöld ha ilyeneket mondasz.

![;]](//cdn.rios.hu/dl/s/v1.gif)

Szerintem nincs akkora jelentősége. A legtöbbeknek 500 wattos tápja szokott lenni, az meg bármilyen VGA-t elbír, ha nem valami kazán proci van mellette. Egy jó hűtés meg nem drága. Egy jó ATX ház meg simán elszellőztet 400 wattot.

Egyedüli gond akkor van, ha 400 wattos táp mellé akarsz 300 wattos VGA-t. Vagy aprócska házba akarsz izmos VGA-t.

-

Abu85

HÁZIGAZDA

válasz

Petykemano

#36683

üzenetére

Petykemano

#36683

üzenetére

Fogják még egy darabig mindkettőt gyártani. Idővel persze már csak a 12 nm-es verziót, mert az kompatibilis a 14 nm-essel.

(#36684) b. : Az NV még minden aktuális Pascal GPU-t gyárt. Egy év múlva is gyártani fogják őket. Még Fermi GPU-kat is gyártanak.

-

válasz

Petykemano

#36683

üzenetére

Petykemano

#36683

üzenetére

Az a jó, beáll az ára az 1060 alá, az 580 szintjére, csak az a gond, hogy Nv azt már nem gyártja,. Az új középkategóriás cucc( 2019 Q1- esetleg 2, már ha lesz) meg valószínűleg jó lesz árban is meg teljesítményben is, hisz nem lesz benne semmi varázslat.

Valószínűleg ez a fél év a z RX é lesz. Azt mondom joggal, hisz én is jobb vételnek tartom őket a zöld vérem ellenére is, olcsóbban. Mármint az 580 4-8 GB. Ha ennyi lesz az 590, akkor az is jó vétel lesz,de abból nem vennék meg akármilyen példányt gagyi hűtéssel a fogyasztása miatt. -

válasz

Petykemano

#36625

üzenetére

Petykemano

#36625

üzenetére

Ez a részvény árfolyamra alapozott farokméregetés egyre szánalmasabb.

-

válasz

Petykemano

#36520

üzenetére

Petykemano

#36520

üzenetére

AMD-nek ez RTX nélkül is megvan...

![;]](//cdn.rios.hu/dl/s/v1.gif)

-

válasz

Petykemano

#36533

üzenetére

Petykemano

#36533

üzenetére

A Turing SM egyszerre képest INT, FP és Tensor műveleteket végezni. Meg nyilván RT-t is. Ennek nem sok köze van az Async Compute-hoz. Utóbbi lényege az, hogy nincs megkötve a hardverállapot, bármikor adhatsz compute feladatot, illetve ugyanazon a feldolgozón több feladat is futhat egyszerre, prioritásokkal, stb, hasonlóan a multi-taskinghoz.

-

válasz

Petykemano

#36520

üzenetére

Petykemano

#36520

üzenetére

és utána leírta ezt is ugyebár:

"én 30-40 fps-re számítottam max, raytracingel"

-

válasz

Petykemano

#36520

üzenetére

Petykemano

#36520

üzenetére

Hogy ON is legyen:

Majdnem harmadolja a teljesítményt a DirectX Raytracing a Battlefield V-ben

Remélem ezen azért reszelnek vagy ilyesmi. Elég vicces, hogy a low hoz egyedül egy kis gyorsulást, a medium, high, ultra között pedig semmi különbség sincs.

-

válasz

Petykemano

#36520

üzenetére

Petykemano

#36520

üzenetére

A piros csula jobb

?

? -

válasz

Petykemano

#36502

üzenetére

Petykemano

#36502

üzenetére

Szerintem nem gáz, biztos van elég.

Azt viszont nagy hülyeségnek tartom, ha minden marad, csak a 8.8 Gbps GDDR5X lesz új. Legalábbis ha le akarják verni az RX 590-t, akkor 10 helyett 7-8 GPC-t kéne csak letiltani. Vagy ha mégis 10-et tiltanak le, akkor egekbe emelik az órajelet, 1500/1700 helyett 1800/2000 körülire.

-

Televan74

nagyúr

válasz

Petykemano

#36502

üzenetére

Petykemano

#36502

üzenetére

Eddig meg vették drága pénzen a GP104 GPU -val ellátott kártyákat. Birka nép. Ezt nagyon gáz! (poén)

-

Abu85

HÁZIGAZDA

válasz

Petykemano

#36411

üzenetére

Petykemano

#36411

üzenetére

Eleve nem ugyanazt a kódot futtatják. Az AMD-hez mér az SW: BF óta a direkten PS4 PSSL kódokból fordít bizonyos shadereket a DICE. NVIDIA-hoz és Intelhez nyilván ezt nem teszik meg, hiszen ezek ezzel a módszerrel nem is kompatibilisek, szóval itt szimplán az Xbox One HLSL kódjait portolják a shader modell 5.0-hoz. A BF5 annyiban változott, hogy már shader modell 6.0-hoz is portolnak. Utóbbi szükségtelenné tenné a PS4-es shadereket is, hiszen megvannak benne ugyanazok a függvények, csak ugye a DX11 miatt nem szerencsés túlságosan építeni ezekre, mert akkor sok shader nagyon eltérne az 5.0-s és a 6.0-s változat tekintetében. Viszont a PS4 PSSL-re már megvan több címben is jól kitesztelt program, amivel egyszerűen konvertálható AGS-re specifikus shader, ergo ezt megéri alkalmazni.

(#36421) PuMbA: Annak a beállításnak nem csak előnye, hanem hátránya is van. Ha bekapcsolod, akkor nő a késleltetés. Nem mellesleg azért van ez alapértelmezetten kikapcsolva, mert a gyártók szeretik ezt maguk szabályozni a driverek, adott játékhoz tartozó profiljában. Szóval ez valami egyezmény lehet, aztán ott az opció bekapcsolni.

(#36412) b. : Ennek nem sok köze van magához a DX11-hez. Tényleg csak annyi történik, hogy más shadereket futtatnak. Az AMD nagyon sokáig a DICE legfőbb technológiai partnere volt, kidolgoztak az elmúlt években több olyan eszközt is, amivel egyszerűen gyorsabb kódokat lehet írni a Radeonokra. Az NVIDIA ezzel nem törődött, mert jött a shader modell 6, ami úgyis szabvány, csak itt is számolni kell azzal, hogy még ha a BF5 már megy is ebbe az irányba, akkor sem fog azonnal mindent kihasználni a shader modell 6-ból, mert még kompatibilisnek kell lenni a DX11-es shader modell 5-tel is. És azért ennyiféle kódot karbantartani tényleg nem szerencsés ám.

-

válasz

Petykemano

#36413

üzenetére

Petykemano

#36413

üzenetére

valószínűleg egy 3 éves generációt nagyon féltenek és rettegés van a szívükben

( vagy leviszik az árát és szevasz, esetleg az 1070 árárt is hozzá )

( vagy leviszik az árát és szevasz, esetleg az 1070 árárt is hozzá )  Remélem is , hogy jó lesz az 590, hozza a szokásos évente 10 % -t ( lol) mert akkor olcsó lesz a 2060

Remélem is , hogy jó lesz az 590, hozza a szokásos évente 10 % -t ( lol) mert akkor olcsó lesz a 2060De egyébként Arra gondoltam hogy akkor jön a végleges mindenki számára elérhető verzió,de látom, hogy Nov 20 és csak a deluxe jön akkor.

-

válasz

Petykemano

#36411

üzenetére

Petykemano

#36411

üzenetére

dx 12+ 4 K aztán 3 %

Jobban fekszi már a vegának is dx 11. eza furcsa, az szerintem elkönyvelhető volt, hogy Vega végre hozza az 1080 szintjét legalább ebben a játékban,de 4 K alatt és dx 12 ben megzuhan az is. 3 % ra kerül az 1080 Tól.

nem értem, hogy a világ legfejlettebb grafikus motorja, lassabb Dx 12 ben és még mindig nem oldják meg az előjövő hugh spike effektust. Hogy lehetnek ennyire érdektelenek, hihetetlen, mikor már évek óta jelen van és némi optimalizálást igényelne a dolog.

Remélem Nov 15 után jobb lesz. -

Abu85

HÁZIGAZDA

válasz

Petykemano

#36388

üzenetére

Petykemano

#36388

üzenetére

Elviszik az OEM/ODM-ek. Ugyanaz van vele, mint az 1080 Ti-vel. Nem lehet mit csinálni.

-

Raymond

titán

válasz

Petykemano

#36364

üzenetére

Petykemano

#36364

üzenetére

"...hol a mainstream desktop hbm kártya?"

-

Abu85

HÁZIGAZDA

válasz

Petykemano

#36327

üzenetére

Petykemano

#36327

üzenetére

A GPU-architektúrák ott pukkadnak ki, ha a hardveres szálkezelés már nem tudja etetni a multiprocesszorokat. Az NV és az AMD is ennek a határán van az aktuális dizájnnal, de még van benne egy-két generáció. Főleg úgy, hogy a WinML eléggé megváltoztatja az igényeket. Nem igazán az lesz a lényeg, hogy több teljesítményt építs be a hardverbe, hanem az, hogy az AI-ra tervezett részhardver gyors legyen, illetve a DXR-nek gyakorlatilag a sávszélhiánytól szenved. Ergo mindegy, hogy a mostani AMD és NV dizájnoknak közel a határa, a következő API-k igazából nem az ALU-kra hajtanak, hanem a sávszélre, illetve specializált AI hardverre.

-

zovifapp111

senior tag

válasz

Petykemano

#36327

üzenetére

Petykemano

#36327

üzenetére

És mi jön még...

Ez csak egy kis "retró" szösszenet volt a részemről

Ez csak egy kis "retró" szösszenet volt a részemről  Persze a 290 290x akkor is egy legenda marad

Persze a 290 290x akkor is egy legenda marad  Egy újabb 290x vs. 780ti szintű csatára lenne szüksége a népnek.

Egy újabb 290x vs. 780ti szintű csatára lenne szüksége a népnek. -

syberia

veterán

válasz

Petykemano

#36271

üzenetére

Petykemano

#36271

üzenetére

-

Abu85

HÁZIGAZDA

válasz

Petykemano

#36271

üzenetére

Petykemano

#36271

üzenetére

Valósnak valós, csak nem reprezentatív. Kb. olyasmi, mint a Steam. A teljes piachoz képest egy eléggé szűk minta, ami nincs is korrigálva.

-

#45997568

törölt tag

válasz

Petykemano

#36184

üzenetére

Petykemano

#36184

üzenetére

Am evekig fel lehet hozni adu asznak

-

válasz

Petykemano

#36149

üzenetére

Petykemano

#36149

üzenetére

át akkor ezt a 16:1 dolgot el is lehet felejteni, kár volt rá ennyi kommentet pazarolni

-

válasz

Petykemano

#36149

üzenetére

Petykemano

#36149

üzenetére

A Steam az nem reprezentatív, akármennyire azt akarják hinni sokan.

-

#00137984

törölt tag

válasz

Petykemano

#36130

üzenetére

Petykemano

#36130

üzenetére

Nem, mert ilyen GTX 1060 opció egyik párhuzamos dimenzióban sem történhetett volna meg.

RX 470-ig kitartottam AMD vonalon, de ha GTX 1060 3GB-ot veszek, akkor saját magamat hibáztatnám és az Nvidia-t, mert a játékokban a 4GB VRAM kezdett már kevés lenni. GTX 1060 GB szintén cserélve lett volna a GTX 1070 Ti-re.

RX 470-ig kitartottam AMD vonalon, de ha GTX 1060 3GB-ot veszek, akkor saját magamat hibáztatnám és az Nvidia-t, mert a játékokban a 4GB VRAM kezdett már kevés lenni. GTX 1060 GB szintén cserélve lett volna a GTX 1070 Ti-re. -

válasz

Petykemano

#36133

üzenetére

Petykemano

#36133

üzenetére

ezeka számok honnan vannak? ez a 16x több kártya ment el? mert szerintrem ha így is van akkor a bányáaszat miatt történt, elfogyott az AMd és vettek NV-t. Külön logaritmust fejlesztettek nvidiára,, mert nem volt sehol se RX se Vega, míg Nvidia nagyjából mindig elérhető volt.ha nem lett volna bányászláz szerintem nem ezek a számok-már ha valósak- lennének most hanem tippre 10 ből 3 RX kártyát vett volna.

,

Egyébként nagy probléma hogy AMD már 4. generációnál ugyan abban a kategóriában versenyez nagyjából azaz a GTX 970-980 szinten ez alól a Vega kivétel ami előre tudott innen lépni, de hát drága is meg nincs is régóta köztünk. 290- 390- 480-580 saját magának is konkurenciát állít évek óta. és egyben a kínálat csúcsát is jelentették a Vega megjelenéséig. most a gáz Fury-t hagyjuk szerintem. -

Raymond

titán

válasz

Petykemano

#36131

üzenetére

Petykemano

#36131

üzenetére

"De azt mivel magyarázod, hogy az nvidia ugyanerre a szintre ugyanezen az áron be tudott tolni egy terméket, amit 15x akkora eladást produkált egy már telített szegmensben."

Sehogy, mert nem ez tortent.

"Pedig se lényegesen nagyobb teljesítményt, se lényegesen jobb árat nem kínált a korábbi 970-hez képest a korábban Megjelent polaris viszonylatában."

Se a szint se az ar nem stimmel.

Voltak a $329-es 970 es egy $549-es 980 kartyak. Erre jott a $249-es GF1060 6GB ami teljesitmenyben a ketto kozott helyezkedett el ugy hogy az ujabb jatekoknal inkabb a 980 szintet hozta, tobb (+25%) VRAM-al, alacsonyabb fogyasztas (-20%) es alacsonyabb (-25%) ar mellett.

-

válasz

Petykemano

#36133

üzenetére

Petykemano

#36133

üzenetére

Összeszedtem a kérdéses teljesítmény-kategóriát. A soron következő kártya mindig gyorsabb volt valamennyivel, kivéve a 480, az csak simán a 390 szintjét hozta, de ugye jóval olcsóbb volt.

2013, csúcskategória:

február: GTX Titan ($999)

október: 290X ($549)

november: 780 Ti ($699)2014, felsőkategória:

szeptember: 970-980 ($329-549)

2015, felsőkategória:

június: 390(X) ($329-429)

2016, középkategória:

június-augusztus: 470-480 ($199-239)

július-augusztus: 1060 ($199-249)2017, középkategória:

április: 570-580 ($199-229)

Ez alapján az AMD folyton aláígért az NV-nek.

-

válasz

Petykemano

#36131

üzenetére

Petykemano

#36131

üzenetére

Igen, a piac így működik szinte minden területen. Nem tolerálják nagy mértékben az 5-10 % előrelépést vagy az 5-10 % árkülönbséget, vagy éppen a szűkösebb választékot ( belinkelhetünk ide legolcsóbb 580 és 1060 kártyát, de nagyon sok embernek nem az felel meg, vagy mert a boltos nem ajánlja a Gigát, mert sok probléma van vele, vagy éppen a vevő csak Asus MSI-EVGA szentháromságban gondolkodik. nagyon nehéz meghatározni, a pillanatnyi döntés fontosságát valamint azt sem kellene szerintem elfelejteni, ha már marketing és kereskedelem, hogy egy vevőt ki akarunk mozdítani a komfort zónájából..

Ez alatt azt értem, hogy volt egy baromi jó maxwell kártyája a GTX 970-980 személyében , ami rekord eladásokat produkált, tehát rengeteg tulajdonosa volt. Egy jól sikerült sorozat.

Probléma mentesen kiszolgálta a tulajt, mi az evidens? miért kockáztasson egy másik fajta VGA-t mikor ezzel megelégedett? Ugyan ez van a kocsiknál, ha valakinek bizonyított a Toyota akkor nagy valószínűséggel abban gondolkodik, mert jónak találja a gyártót.

Ahhoz hogy ezt a vevőt kimozdítsuk ebből a komfort zónából, sokkal nagyobb inger kell, hogy érje. vagy árban vagy teljesítményben az adott árért, ez történt CPU fronton a ryzennel.

Mint ahogy számomra az érthetetlen, hogy sokan miért is vettek még akkor is 290-290X kártyát, mikor jelen volt a GTX sorozat, vagy miért venne bárki is AMD-t ha NV-t is vehet , hisz ti is ezt kérdezitek, miközben nagyon sokáig se olcsóbb se gyorsabb nem volt.Ezért hoztam példának a Vega kártya ha most 100 K lenne ( nem elvárom csak példaként írtam azt nevezném például erős húzó erőnek )

-

#00137984

törölt tag

válasz

Petykemano

#36107

üzenetére

Petykemano

#36107

üzenetére

Nem vettem volna meg az Nvidia-tól a 3GB VRAM videókártyáját, de akkor sem ha féláron adják. Feljebb akartam váltani és nem visszalépni egyet a gyengusz kis teljesitményben. RX 470 után egy ideig még vártam az RX 470 refresh videókártyát, de az RX 570 és RX 580 érkezett. Mérsékeltebb fogyasztásra számitottam, de teljesitményben sem lépett nagyot előre az AMD, ezért akkor tértem át a zöld oldalra.

Elégedett vagy a válasszal vagy szerinted elsietett döntést hoztam.

Elégedett vagy a válasszal vagy szerinted elsietett döntést hoztam.

-

válasz

Petykemano

#36107

üzenetére

Petykemano

#36107

üzenetére

Ugyan már, tudjuk a választ!

-

#00137984

törölt tag

válasz

Petykemano

#36102

üzenetére

Petykemano

#36102

üzenetére

Másfelől szerintem az AMD a videókártyáin nem jó írányba fejleszt. Játékra a compute képesség nem sokat számit, miközben a GPU mérete és fogyasztása elszalad. Az a 250$ akkor a középkategóriát jelentette számomra, ami a FullHD/60Hz. Most mennyi ez a középkategória, miközben a fejlődés egyre inkább a 4K. Játékosnak jó a FullHD (vagy az 1440P), de ott már nagyobb képfrissitésre törekszenek (144Hz).

-

#00137984

törölt tag

válasz

Petykemano

#36102

üzenetére

Petykemano

#36102

üzenetére

Nem.

Mivel a GTX 1070-re esett a választásom, amit jó áron tudtam eladni és még a legjobb időben sikerült a GTX 1070 Ti-re szert tennem. Igazából a GTX 1060 3GB nálam nem jőhetett volna számitásba, mert az RX 470 után nem volt szükségem egy közel azonos képességű videókártyára. GTX 1060 6GB-ot nézegettem egy ideig, de végül sikerült átlépnem az AMD árnyékát. Kiléptem a fényre.

Mivel a GTX 1070-re esett a választásom, amit jó áron tudtam eladni és még a legjobb időben sikerült a GTX 1070 Ti-re szert tennem. Igazából a GTX 1060 3GB nálam nem jőhetett volna számitásba, mert az RX 470 után nem volt szükségem egy közel azonos képességű videókártyára. GTX 1060 6GB-ot nézegettem egy ideig, de végül sikerült átlépnem az AMD árnyékát. Kiléptem a fényre.  Ki tudja mi jőhet még?

Ki tudja mi jőhet még? -

válasz

Petykemano

#36041

üzenetére

Petykemano

#36041

üzenetére

Persze, ezt is írtam válaszként. Fent az átlagfelhasználó érdekéről van szó. Ugye legyen gyors és olcsó.

-

s.bala31

őstag

válasz

Petykemano

#36008

üzenetére

Petykemano

#36008

üzenetére

RX 480-ról váltottam GTX 1070-re, szerettem volna a polaristól nagyobb teljesítményt, de egyszerűen akkoriban piros oldalon nem volt más alternatíva. Pár hónap után az 1070 megadta magát, gondoltam adok még egy esélyt az AMD-nek és megvárom a Vegákat. Sajnos nagy csalódás volt az árazásuk és a teljesítményük (korábban ugye AMD mellett mindig a jó ár/teljesítmény mutató szólt), és úgy gondoltam nem várok semmilyen csodadriverre és kb 50 ezerrel olcsóbban beszereztem egy GTX 1080-at mint az akkori ref Vegák. Szerintem AMD jelenlegi siralmas VGA helyzetéért nem feltétlenül az Nvidia marketing gépezete felelős, egyszerűen az utóbbi időben képtelenek voltak időben reagálni a piaci igényekre. A helyükben már elengedném ezt a Desktop VGA szegmenst mert így nem sok értelme van.

-

válasz

Petykemano

#36008

üzenetére

Petykemano

#36008

üzenetére

na akkor elmondom a véleményem az RX 580 ról a videóban ezzel példálóznak hibásan.

RX 480 volt amikor az 1060 megjelent és 1060 gyorsabb volt nála . Rá egy évre kijött 580 ami pár százalékkal gyorsabb volt min t az 1060 de nem mindenhol és nem általánosan, néhány játékban.1 évre rá( 10 hnapra ? mindegy mert nem lehetett kapni hónapokig)!!

+ adalék: nvidia mióta kínálja elérhető áron ezt a teljesítményt? a GTX 980 már mióta van piacon? akinek 970 kártyája volt vagy 980 nem 1060 ra váltott mert minek?ugyan azt a teljesítményt kínálni évek óta egyre olcsóbban elégnek kellene lennie bármire?

és ahhoz hogy egy kártyára kijelentsük, hogy gyorsabb mint a konkurencia ahhoz általánosan mindenhol gyorsabbnak kellene lennie de ez egyik kártyára se igaz( Vegára sem, RX re sem) ha már utólag jön ki rá 1-2 évre hogy piacon van a konkurencia és piacot akar tőle hódítani..Ez semmilyen területen nem működne így nem csak a VGA-k terén. -

Venyera7

senior tag

válasz

Petykemano

#35990

üzenetére

Petykemano

#35990

üzenetére

Ez nem hiteles számtalanszor le lett írva, hogy miért...

![;]](//cdn.rios.hu/dl/s/v1.gif)

-

válasz

Petykemano

#35995

üzenetére

Petykemano

#35995

üzenetére

most leírtad kicsit fura módon , (

) hogy kellene objektíven ezt közölni, de a videó a zenével a ránagyításokkal és a szöveggel nem ezt sugallja sok helyen és én ezt rühellem.

) hogy kellene objektíven ezt közölni, de a videó a zenével a ránagyításokkal és a szöveggel nem ezt sugallja sok helyen és én ezt rühellem. -

válasz

Petykemano

#35990

üzenetére

Petykemano

#35990

üzenetére

AMD megint áldozatnak van beállítva , néhol meghatódtam.

-

válasz

Petykemano

#35971

üzenetére

Petykemano

#35971

üzenetére

Régen egyébként pont fordítva volt: a G80-GT200-GF100 inkább compute-ra volt kihegyezve, miközben az AMD TeraScale játékra. Eleinte nem volt túl jó (2900XT), de baromi jól skálázható, így a 4xxx sorozattal kezdve már sokkal jobbak voltak játékra. De általános compute-ra már nem igazán, mert a VLIW nehezen programozható. Ezért jött a GCN.

-

Abu85

HÁZIGAZDA

válasz

Petykemano

#35960

üzenetére

Petykemano

#35960

üzenetére

Rajanak ehhez semmi köze, ő nem igazán a grafikai divíziót vezeti az Intelnél, hanem a peremhálózati rendszerek menedzsere, amellett persze, hogy az alelnöke a "Core and Visual Computing" csoportnak, illetve a vezető mérnök.

Akik mennek (Darren McPhee, Tungler Antal, stb.), Chris Hook után mennek. Gondolom az AMD sem nagyon akarta marasztalni a "Mr. Poor Volta" teamet.Raja Gregory Stonert vitte magával, ő felelt az AMD-nél a ROCm-ért. Eközben viszont probléma volt, hogy le se szarta a SYCL-t, és emiatt az AMD több embere elment más céghez, hogy foglalkozhasson a SYCL-lel. Valószínűleg emiatt őt se nagyon marasztalta a cég, hiszen nem túl célravezető stratégia csak csőlátásban a ROCm-öt tolni.

Hardveres és driveres arcok maradtak az AMD-nél, őket nehéz robbantani onnan.

-

Petykemano

veterán

válasz

Petykemano

#35960

üzenetére

Petykemano

#35960

üzenetére

Jaj, bocs, azt hittem, szakemberről van szó, erre kiderül, hogy csak egy marketinges. Hát azért nem kár. Az amdnek a semmilyen marketing is jobb, mint amilyen az utóbbi években volt. (= mérsékelt elvárásokkal várjuk a polaris 30-at és a Vega20-at a biztos vesztesek nyugalmával. Nem csalódhatunk)

-

válasz

Petykemano

#35500

üzenetére

Petykemano

#35500

üzenetére

Az 1080 Ti vagy 30%-kal több pixel fillrate-et tud, mint az 2080, aztán mégis ugyanott van.

Viszont ami izgalmas, az a Vega M GH. Ebben ugye 64 ROP van. Ha ezt valahogy egy Polarisszal össze lehetne vetni jól, akkor érdekes következtetéseket lehetne levonni. 24 CU + 64 ROP vs 36 CU + 32 ROP.

-

#45997568

törölt tag

válasz

Petykemano

#35182

üzenetére

Petykemano

#35182

üzenetére

Szegeny zold hivok most biztos felszisszentek, kommersz gyartonak tartani a szeretett nv-t...

Abbol indulok ki mint Te is, leven a 20XX sorozat meg erosen kompromisszumos...

-

Kvg

senior tag

válasz

Petykemano

#35180

üzenetére

Petykemano

#35180

üzenetére

És még a "fostalicska" 2080 még mindig nem tudja a 4k 144fps-est. mert igények erre is vannak. 800k monitor kell hozzá arról meg ne is beszéljünk.

Magyar fizetésekhez 1440p bőven jó egy 150k AMD. Az hogy egy-két valószínűleg adócsaló gazdag embernek semmi nem elég és tele sz@rják fórumokat a magas elvárásaikkal nem lehet mit kezdeni. -

Abu85

HÁZIGAZDA

válasz

Petykemano

#35071

üzenetére

Petykemano

#35071

üzenetére

Igen. De mint írtam, a hardveren belül ez egy kis áramkört igényel, plusz egy extra hardverállapotot. Tranzisztor szintjén nem igazán lehet több százezernél, ami elenyésző a mai sokmilliárd tranyós lapkáknál. Ilyenkor többet jelent a tesztelhetőség, mint a tranyóval való spórolás, mert ha először van hardvered rá, akkor először tesztelheted, és elsőként is jössz rá olyan limitekre, amelyek a második generációnál számítani fognak. A DX12 és a Vulkan API-ra sem azért az írja az AMD a leghatékonyabb drivereket, mert náluk okosabbak a programozók, hanem azért, mert nekik volt egy Mantle-jük, és mindenki előtt két évig tesztelhették, hogy mi az ideális stratégia erre. Bizonyos projekteknél fontos az idő, mint tényező, amikor egy újítást teljesítményét nem olyan nehezen befolyásolható tényezők határozzák meg, mint a compute, vagy a memsávszél. Utóbbi két esetben nyilván nem sokat lehet nyerni az idővel, hiszen eleve egy olyan tényező limitál, amivel nehéz mit kezdeni az általános fejlődésen túl. Egy primitive shader olyan dolog, amit nem igazán a compute vagy a sávszél fog limitálni, hanem sokkal inkább a szoftveres háttér, illetve a hardverállapotra vonatkozó optimális paraméterezés. Itt az idő sebességet jelent.

-

válasz

Petykemano

#35071

üzenetére

Petykemano

#35071

üzenetére

Valamelyik új játékban használák a primitive shadert, csak most nem jut eszembe melyikben. De ugye a primitive shader "okoskivágását" szabványosan is meg lehet oldani nagyjából, legalábbis Abu írta, hogy compute shaderrel is megcsinálható (s ezt is használják már valahol), de gondolom nem annyira hatékony, hisz a compute shader az a futószalagon kívül van. Cserébe bármire használható, s a compute shader futhat async compute-ként, a grafikus futószalag mellett párhuzamosan.

-

válasz

Petykemano

#35060

üzenetére

Petykemano

#35060

üzenetére

Write only módban vagy?

Itt megírta: [link]

Itt megírta: [link]Végül megjelenik egy úgynevezett mesh shading is, ami valójában a vertex és a hull shadert váltja le a task shaderrel, míg a mesh shader a domain és a geometry shader lépcsőket helyettesíti. Gyakorlatilag egy új futószalagról van szó. Nem lehet elmenni amellett szó nélkül, hogy eléggé sok a hasonlóság az AMD Vega architektúrában bemutatott primitive shadinggel, ahol ugye a vertex és a hull shader lépcsőket a surface shader váltja, míg a primitive shader a domain és a geometry shader helyére kerül, illetve a leírások alapján is hasonlóra képesek az említett futószalaglépcsők, vagyis próbálják a geometria kivágását, illetve ezek kezelését hatékonyabbá tenni.

-

imi123

őstag

válasz

Petykemano

#35060

üzenetére

Petykemano

#35060

üzenetére

A turing ismertetőben le van írva hogy ugyan azt a célt szolgálja, csak szintén nem automatikusan működik.

Talán a nagyobb részesedésével az NV több programba tudja "befizetni" a használatát. -

#45997568

törölt tag

válasz

Petykemano

#35060

üzenetére

Petykemano

#35060

üzenetére

Legalabb meglatjuk mit is kellett volna kapnunk a Vega-hoz

Kivancsi leszek, mit mond A Mester

-

#45997568

törölt tag

válasz

Petykemano

#34956

üzenetére

Petykemano

#34956

üzenetére

Gondolom jo paran vesznek protest AMD cuccokat, a zoldek uj generacioja most egy olyan lelektani hatart lepett at az arazassal aminel sokan azt mondjak h kapjak be, veszunk inkabb AMD-t.

Jo par forumon olvastam ezt, a Pascal-t ugyanezen okok miatt nem veszik ugyanezen vasarlok.

Ugyanigy persze vannak akik AMD-t nem vesznek, mert csak. Sznobizmus van meg divatmajmolas

(tisztelet a kivetelnek)

(tisztelet a kivetelnek)Ettol meg eleg jelentos a vasarlobazis aki vesz majd zold cuccot, mert uj, meg RTX, meg "mindenki" ezt veszi...

Vtom: egeszen jol hangzik, akkor addig koltok masra

-

VTom

veterán

válasz

Petykemano

#34889

üzenetére

Petykemano

#34889

üzenetére

Ilyen rajzokért nem lehet végelges bant kérni az egész internetről?

-

Hajdi

senior tag

válasz

Petykemano

#34817

üzenetére

Petykemano

#34817

üzenetére

SSd-ről szépen megy, az a lényeg. Bár 1440p-ben játszom, ugyanakkor szerintem szépen teljesít a Vega! Van másik videóm 7600rpm wincseszterről. Ég és föld az ssd béli különbség. Mellesleg a 60 fps lock volt a vidi alatt.

Egy dolgot viszont nem értek. Szeretnék pl: Afterburnerrel monitorozni, de detto nincs hang. Bármilyen monitorozó megy nincs hang...

-

válasz

Petykemano

#34813

üzenetére

Petykemano

#34813

üzenetére

Giga RX 570 Gaming 4GB 65k kéne legyen. Az jelenti a visszaállt árat.

-

válasz

Petykemano

#34813

üzenetére

Petykemano

#34813

üzenetére

Az 580 8-nak kellene 80 körül mennie. Akkor mondhatnánk hogy visszaálltak az árak. De ha egy Giga gaming 100+ akkor még nem vagyunk ott.

Bár idehaza közben a forint beleállt a földbe, így nem is számíthatunk ennél jobb árakra..480 8G-t vettem 82-ért tavaly februárban. Az 580-nak sem szabadna drágábbnak lennie, mivel csak egy refresh és ugyanaz a kategória.

-

namaste

tag

válasz

Petykemano

#34807

üzenetére

Petykemano

#34807

üzenetére

Neked honnan jönnek a számok?

2018 2. negyedévben 11 millió kártyát adtak el, tavaly összesen 52 milliót.

-

GFerr56

aktív tag

válasz

Petykemano

#34776

üzenetére

Petykemano

#34776

üzenetére

Hay!

Ezt a címet nem ismerem, nem is vagyok valami nagy játékos. Amit játszottam, az a FC5, ami tökéletesen futott FHD 65-100 fps-el, 1050 Ti kártyával. Szóval azt akartam mondani még, hogy nem feltétlen elfogult mindegyik, a mérnöki alapszabályt betartva (egy mérés nem mérés), több (minél több) összehasonlítást kell megnézni, és ahol a mérési pontatlanságnál (1-2%) nagyobb eltérés van, ott gyanakodni kell.

Üdv

-

GFerr56

aktív tag

válasz

Petykemano

#34773

üzenetére

Petykemano

#34773

üzenetére

Hay!

Csak egy adalék: azért nem kell bedőlni mindenféle teszt eredményeknek (ez sem teljesen elfogulatlan...vajon miért?!). Szóval, anno a 8700k, amim volt, alapon (ahogy állítólag itt is szerepel) SOHA nem produkált 204 pontnál kevesebbet (SC). Húzva (RYZEN-nél elég koppra volt) még durvább volt az érték (215-220). A 8086k-nál még nagyobb az eltérés (ez későbbi széria, de alapjában véve ua az a proci). Szóval ez a táblázat egy kissé elfogulatlan...![;]](//cdn.rios.hu/dl/s/v1.gif)

Üdv

-

Crytek

nagyúr

válasz

Petykemano

#34773

üzenetére

Petykemano

#34773

üzenetére

CB nem érdekel az nem játék... De elég sok teszt van a neten ahol látni amd még gyenge 1 szálon. Sokkal jobb mint régen, de még kevés. Kiváncsi leszek fordul-e a kocka valaha..

-

válasz

Petykemano

#34768

üzenetére

Petykemano

#34768

üzenetére

Értettem én elsőre is ne aggódj

Azért linkeltem be valós teszteket mert a gyökér felteszik a videót így YT ra és még táblázatba is szedi.GTX 960 lenyomta az RX et szóval viszlát

Azért linkeltem be valós teszteket mert a gyökér felteszik a videót így YT ra és még táblázatba is szedi.GTX 960 lenyomta az RX et szóval viszlát

Én nem látom ott a GPU kihasználtságot , csak a GPU hőfokot.

-

-

cyberkind

félisten

válasz

Petykemano

#34765

üzenetére

Petykemano

#34765

üzenetére

Hát azért nem feltétlenül.

-

válasz

Petykemano

#34705

üzenetére

Petykemano

#34705

üzenetére

Találó

-

válasz

Petykemano

#34703

üzenetére

Petykemano

#34703

üzenetére

Az valami garázscég?

Látod azt a vigyorgó ZÖLD fejet ?

-

Abu85

HÁZIGAZDA

válasz

Petykemano

#34700

üzenetére

Petykemano

#34700

üzenetére

A függetlenített int32 elsődlegesen ahhoz kellett, hogy sugárkövetésben ez egy, ha nem is nagyon sűrűn, de azért picit erőteljesebben használt operáció. Így az fp32-es shading mellett párhuzamosan lefuthat. Persze csak akkor, ha van elég regiszter hozzá, mert ugye ez még mindig probléma lesz, de legalább az elvi lehetőség adott.

Az 50% az L1-ből jön, de csak akkor, ha a futtatott shader kevés warpot tud használni a Pascal multiprocesszorán. Lásd a Vega esetében az LDS pressure, amitől a Polarishoz képest a Vega CU shader teljesítménye a duplájára nőtt. Na most a Pascal->Volta/Turing váltásnál nem volt közel duplázás, de azért az összevont cache az occupancy limites szituációkban simán hoz 50%-ot, ha a meghajtó úgy van beállítva, hogy a maximális warpot direkt limitálja, hogy azzal a cache partíción keresztül csökkentse az LDS/register pressure-t. Persze a legtöbb compute shadert úgy írják, hogy ne legyen occupancy limites a Pascal/Polaris és a még korábbi generációkon sem. De azért van már olyan compute shader, ami már az. Ezekhez az új, occupancy limitre kifejezetten ügyelő Vega/Volta/Turing dizájnok az ideálisak, vagy az Intel IGP-i, azok brute force tolják. A gyakorlatban pedig ezeket azért nem látod igazán, mert rengeteg shadert futtat egy alkalmazás, tehát teszem azt a shaderek 3%-ára az új multiprocesszor hatékonyabb, de az összesített teljesítményt inkább a maradék 97% határozza meg, ahol pedig eleve nincs occupancy limit, vagy nem annyira erős, hogy amellett még ne lehessen elfedni a memória késleltetését. Persze azzal, hogy a hardverek fejlődnek, a fejlesztők egyre komplexebb shadereket írhatnak, így pedig egyre több olyan shader futhat egy játékban, ami a régi dizájnokkal occupancy limites lesz.

A gyakorlatban pedig ezeket azért nem látod igazán, mert rengeteg shadert futtat egy alkalmazás, tehát teszem azt a shaderek 3%-ára az új multiprocesszor hatékonyabb, de az összesített teljesítményt inkább a maradék 97% határozza meg, ahol pedig eleve nincs occupancy limit, vagy nem annyira erős, hogy amellett még ne lehessen elfedni a memória késleltetését. Persze azzal, hogy a hardverek fejlődnek, a fejlesztők egyre komplexebb shadereket írhatnak, így pedig egyre több olyan shader futhat egy játékban, ami a régi dizájnokkal occupancy limites lesz.A DLSS az olyan mint az SS, csak nem mindenhol alkalmazza a rendszer. Igazából azért hoz sebességnövekedést, mert közben mást viszont nem úgy számol, ahogy natív részlegességgel amúgy tenné. Ezért van megjelölve a DLSS külön, mert a DLSS nélküli eredmény jelöli a natív részletességet. Ha natív részletesség mellett lenne alkalmazva a DLSS, akkor az extra számítástól csökkenne a teljesítmény, de pont az a lényege, hogy ne kelljen némelyik számítást elvégezi.

Ha ugyanaz a számítás az AMD és az NV között, akkor igazából a képminőség is 99%-ban ugyanaz. Egyedül a szűrés különbsége okozhat eltérést, de ez felfogásbeli különbség, illetve ebből a szempontból az AMD-nek van egy beállítása a driverben, ami annyit tesz, hogy ha a mintázat szűrésének minőségét a user "teljesítmény"-re állítja, akkor azt a minőséget kapja, amit az NV ad default. De az AMD default minősége még mindig eléggé sokban követi a Microsoft WHQL-es, mára már nem kötelező érvényű előírásait.

A különböző eljárások pedig különböző minőséget adnak. A főbb dolgokat összehasonlítottuk régebbi cikkekben (viszont ezek jó része nem alma-alma összehasonlítás, mert eltér maga az eljárás, tehát természetes némi különbség): [link] és [link] -

válasz

Petykemano

#34687

üzenetére

Petykemano

#34687

üzenetére

A RPM kimaradt. Azaz a 2x FP16/INT16 és 4x INT8.

-

Abu85

HÁZIGAZDA

válasz

Petykemano

#34628

üzenetére

Petykemano

#34628

üzenetére

Azt jelenti, hogy a 2022-ben érkező Sapphire Rapidsban sem lesz gyorsabb p2p interconnect, mint 2019-ben érkező Rome-ban. És ez Krzanich döntése volt, elvégre ő felelt ezekért a tervekért Ruttner helyén. Ez pedig alapvetően meghatározza a skálázhatóságot. Most már ezzel nincs mit tenni, nem lehet csak úgy leállítani a fejlesztéseket. A Sapphire Rapids után lesz esélyük, addig a Rome is nagy falat lesz, hát még a következő Milan.

(#34629) Locutus: A 2070 játéktól függően úgy 15-25%-kal jobb az 1080-nál (legtöbb helyen inkább 15, de ha nagyon sávszéligényes a játék, akkor többel). A 2080 kb. hasonló az 1080 Ti-hez, hol gyorsabb, hol lassabb, attól függ, hogy mennyire terheli a ROP-ot és a memóriát a játék, mert ezekből sokkal kevesebb van a 2080-ban. A 2080 Ti pedig gyorsabb az 1080 Ti-nél úgy nagyjából 10-20%-kal.

-

Abu85

HÁZIGAZDA

válasz

Petykemano

#34623

üzenetére

Petykemano

#34623

üzenetére

Nem időben. Akkor kellett volna, amikor Justin Rattner helyére magát jelölte. Ott rombolta le az Intel következő 5-6 évét.

-

#59036672

törölt tag

válasz

Petykemano

#34617

üzenetére

Petykemano

#34617

üzenetére

Sapphire 5870 Toxic

-

cyberkind

félisten

válasz

Petykemano

#34617

üzenetére

Petykemano

#34617

üzenetére

Ez a grafikon tökéletesen bemutatja mi is történt az 5k széria után, én 6990-ről mentem a jóval gyengébb 580-ra, azóta eszembe se jut az Amd mint videokártya, felém mindenképp rosszul csinálnak valamit jó régóta.

-

Raymond

titán

válasz

Petykemano

#34598

üzenetére

Petykemano

#34598

üzenetére

Vagy ha olyannak "uzen" akivel nem akar uzletet kotni akkor az van a homlokan hogy SEMMI CUSTOM!

-

szmörlock007

aktív tag

válasz

Petykemano

#34580

üzenetére

Petykemano

#34580

üzenetére

Sőt, intelnél még pénz is lesz

-

Abu85

HÁZIGAZDA

válasz

Petykemano

#34573

üzenetére

Petykemano

#34573

üzenetére

Semmit nem tudunk arról, hogy a gyártók hogyan implementálják a DXR-t. Ezt ugyanis lehet fallback layeren futtatni, illetve írni rá egy specifikus implementációt. Annyit tudunk, hogy az NV a Volta-hoz ír meghajtót, míg az AMD a GCN-hez, de itt annyi infó még van, hogy a GCN3-tól más lesz az implementáció, mint a GCN3 alatt. Minden más hardver a fallback layert használja.

A teljesítmény szempontjából két tényező van. Lesz ugye maga a számítás. Mivel a DXR is ugyanazt csinálja, mint más raytracing framework, így hasonló lesz itt a teljesítmény, mint mondjuk a Luxmarkban, persze a raszterizáció miatt itt közrejátszik majd az aszinkron compute hatékonysága, hiszen nem csak a sugárkövetést számolják az ALU-k compute shaderben, hanem más feladatot is. A másik tényező például a denoising speciális végrehajtása. Ehhez lehet használni egy rakás implementációt. A Microsoft gyári implementációja egy SAD-re épülő technika, ami a fallback layeren belül működik. Az NV valószínűleg a tensor magokat használja majd itt, míg az AMD valószínűleg a saját dedikált SAD/QSAD/MQSAD utasításait. A Vega 20-ban valószínűleg valami kevert megoldást alkalmaznak majd, hogy hozzájussanak a 4 bites feldolgozás extrém sebességéhez. Szóval ezek a tényezők összességében határozzák meg a végső sebességet.

Az AMD Vulkan-hoz írt implementációja eléggé speciális. A teljesítménynél az a probléma vele, hogy az Anvilt az AMD saját magára írja, tehát tök oké, hogy elvileg működhet gyártófüggetlenül, de annyira magára tudja szabni az egészet az AMD, hogy nem fog annyira gyártófüggetlenül működni. Értsd ezt úgy, hogy amíg a DXR esetében a gyártó önállóan dönthet úgy, hogy bizonyos dolgokat felgyorsít egy gyártói implementációval, amihez ad egy drivert ki és megy, addig a Vulkan-féle sugárkövetésnél az NV-nek és az Intelnek az AMD-t kell megkérni arra, hogy ugyan gyorsítsák már fel rajtuk a sugárkövetést.

Új hozzászólás Aktív témák

Hirdetés

A topikban az OFF és minden egyéb, nem a témához kapcsolódó hozzászólás gyártása TILOS!

Megbízhatatlan oldalakat ahol nem mérnek (pl gamegpu) ne linkeljetek.

- Samsung Galaxy S22 és S22+ - a kis vagány meg a bátyja

- Samsung Galaxy S23 és S23+ - ami belül van, az számít igazán

- WLAN, WiFi, vezeték nélküli hálózat

- iPhone topik

- BestBuy topik

- One mobilszolgáltatások

- Házimozi haladó szinten

- Házimozi belépő szinten

- OLED TV topic

- Óvodások homokozója

- További aktív témák...

- OLCSÓ MONITOROK

- Csere-Beszámítás! Sapphire Pure RX 7700XT 12GB GDDR6 Videokártya! Bemutató Darab!

- Bomba ár! HP EliteBook Folio 1040 G2 - i5-G5 I 8GB I 256GB SSD I 14" HD+ I Cam I W10 I Garancia!

- LG 27GP95RP - 27" Nano IPS - UHD 4K - 160Hz 1ms - NVIDIA G-Sync - FreeSync Premium PRO - HDR 600

- Telefon felvásárlás!! iPhone 15/iPhone 15 Plus/iPhone 15 Pro/iPhone 15 Pro Max

Állásajánlatok

Cég: Promenade Publishing House Kft.

Város: Budapest

Cég: PCMENTOR SZERVIZ KFT.

Város: Budapest

Főleg szót érdemel az utasítás előbetöltés, a duplájára növelt L2, és a bővített lehetőségek az ütemezésre, amik lehetővé tették pl. a TrueAudio Next-et is. Ezek nem kis dolgok, nem véletlenül lett ez a legmagasabb IPC-jű GCN.

Főleg szót érdemel az utasítás előbetöltés, a duplájára növelt L2, és a bővített lehetőségek az ütemezésre, amik lehetővé tették pl. a TrueAudio Next-et is. Ezek nem kis dolgok, nem véletlenül lett ez a legmagasabb IPC-jű GCN.

![;]](http://cdn.rios.hu/dl/s/v1.gif)

Persze a 290 290x akkor is egy legenda marad

Persze a 290 290x akkor is egy legenda marad