- Melyik tápegységet vegyem?

- VR topik (Oculus Rift, stb.)

- Sugárkövetés nélküli sugárkövetés felé menetel az új PlayStation

- Fejhallgató erősítő és DAC topik

- NVIDIA GeForce RTX 5080 / 5090 (GB203 / 202)

- Androidos fejegységek

- TCL LCD és LED TV-k

- AMD K6-III, és minden ami RETRO - Oldschool tuning

- Samsung Galaxy Tab tablet topik

- Objektívek topikja

Új hozzászólás Aktív témák

-

Cifu

félisten

válasz

S_x96x_S

#2879

üzenetére

S_x96x_S

#2879

üzenetére

Ahogy nézem a legtöbbeknek (nekem is) az Ice Lake-SP szerver CPU sorozat kaszája jutott az eszébe. Elviekben 2020 Q3 volt a tervezett megjelenési dátuma.

Mondjuk ez meglepő annak fényében, hogy a korábban kiszivárgott hírek szerint az Ice Lake-SP 14c/28t szerverprocija meglepően erős volt a SiSoft Sandra tesztben.

Ugyanakkor az Ice Lake-SP a Copper Lake-SP vonal mellett jelent volna meg, kizárólag a két utas szerverekben, tehát valójában egy extra párhuzamos sorozat lett volna, magasabb IPC-vel, feltehetően magasabb áron. Mivel eleve 2020 Q3-ban már a Zen3-as Epyc Milan-al kellene versenyeznie (ha az AMD tényleg kihozza azt nyáron), ez egy teljesen felesleges termékvonal, akár hogy is nézzük.

Ezen a képen (tavaly nyári szivárgás) még 2020 Q2 volt a megjelenés dátuma, ez tavaly év végén egy negyedévet csúszott.

Ha valóban ez következik, ugyanakkor nem akkora világvége, ahogy beharangozzák a SemiAccurate-nál. Ha ugyanis a Sapphire Rapids-SP / Eagle Stream nem csúszik, akkor az Ice Lake-SP amúgy is mindössze három negyedévet élt volna mindössze úgy, hogy 2021 Q1-be már jönne a sokkal fejlettebb Sapphire Rapids-SP.

Ismét ha valóban ez a helyzet, akkor az Intel egy teljesen logikus döntést hozott: nem fog egy újabb termékcsaládot a piacra dobni, mert sose fogja az árát visszahozni, feltehetően a nagy partnerek sem fognak két kézzel kapni utána, és párhuzamosan foglalkozni a Copper Lake-SP-vel és az Ice Lake-SP-vel. Szóval egyszerűsítették a megjelenési terveket, és inkább a Sapphire Rapids-SP-re koncentrálnak, hogy minél hamarabb kijöjjön...

-

-

paprobert

őstag

válasz

S_x96x_S

#2860

üzenetére

S_x96x_S

#2860

üzenetére

Szerintem az AMD a saját proprietary modulációjával akarja megelőzni a valódi szabvány megérkezését. Nagyjából azt teszi, amit az Nvidia a G-sync-kel tett anno.

Mivel nála van a CPU és a BIOS is, olyan szoftvert implementál relatíve gyorsan, amilyet nem szégyell. Így lesz 1-2 év AMD-only előny.

-

Petykemano

veterán

válasz

S_x96x_S

#2858

üzenetére

S_x96x_S

#2858

üzenetére

Csak az árazás nem lesz elég szerintem.

"Neoverse N1 core is almost identical to the Cortex-A76" (A76 => IntroductionMay 31, 2018)

[link]Már a Cortex A77 is lassan 1 éves. Tehát itt még legalább 1 generációt előre lehet lépni. Ha az Amazon együttműködik az Armmal, akkor már előre megkapják az A78/Hercules terveit.

EC2 A1: Nov 26, 2018

Graviton2: Dec 3, 2019Jövő év végén biztos jön valami új.

Persze ha ez a graviton2 7nm, akkor olyan nagyon előretörni már nem lehet. 5nm és drága, vagy 7nm és esetleg EUVInkább az a durva, hogy 80-110W-ra teszik a fogyasztást. Ez azt jelenti, hogy minimum másfélszer, de talán 2x annyi magot is lepakolhatnak egy node-ba, miközben nincs kompromisszum a ST teljesítményben.

Fel kell kötni a gatyát.

-

Petykemano

veterán

válasz

S_x96x_S

#2844

üzenetére

S_x96x_S

#2844

üzenetére

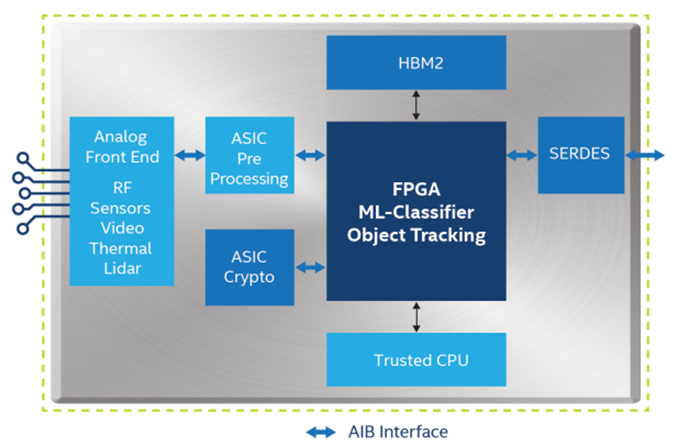

Én meglepődnék, ha első körben hbm-en kívül bármi 3d lenne.

Tegyük hozzá, hogy a(z IF) fogyasztáson már egy interposer is sokat javítana. Azt is látjuk, hogy van példa arra, hogy Mit tesz lehetővé a CPU maguk mellé pakolt HBM2. (A64FX)

A legpraktikusabb az lenne, ha maga az IO lapka az interposer is.

Aztán persze az elképzelhető kompozíciók száma sok.

-

Cathulhu

addikt

válasz

S_x96x_S

#2837

üzenetére

S_x96x_S

#2837

üzenetére

Tudtommal a legtobb intel sebezhetoseg megtalalasat is az intel szponzoralta (marmint fizetett a megtalalonak). Tulajdonkeppen ez nem olyan szornyu dolog, mert a lyuk ott van, akkor is ha nem talaljak meg/publikaljak, igy viszont legalabb van lehetoseg javitani. Mas kerdes, hogy az intel most par generacioig szivni fog veluk, de hosszabb tavon szerintem jobb nekik. Csak azt nem tudom eldonteni ezzel vegul bizalmat nyernek vagy vesztenek

-

joysefke

veterán

válasz

S_x96x_S

#2825

üzenetére

S_x96x_S

#2825

üzenetére

a trend, hogy hosszú távon a nyitottabb rendszerek gyorsabban fejlődnek, és nagyon gyorsan ledolgozzák a hátrányukat.

Mint a nyitott Windows, nyitott AD, nyitott Office, nyitott Google service, nyitott vSphere?kb 5-10 ARM -es szerverproci készül a háttérben ( még ha csak 1 cég olvasná félre a piaci trendeket, de ezekből fél tucat van)

- alacsony a belépési küszöb

- a fejlesztési erőforrások eloszlanak,

...Trendeket olvasgatsz/hangoztatsz, de értelmezed is őket?

Készül pár ARM szerverproci DESIGN a háttérben, nyilván azért mert (a valószínűtlen) siker esetén a potenciális nyereség óriási, a designt elkészíteni meg ehhez képest fillérekbe kerül. Persze, hogy megéri bepróbálkozni. Ez egyelőre csak annyit jelent, hogy van kockáztatható tőke.

Az alacsony belépési küszöb kijelentés meg szerintem nevetséges. A belépési küszöb nagyon magas, de a megugrandó magasság java nem a chipdesign elkészítésében van, hanem az ARM-re létező szerver-workloadot futtatni akaró fizetőképes ügyfelek megtalálásában.

x86-ot is lehet gyártani a TSMC-nél. Akár a legújabb node-on is. Az hogy az AMD éppen nem érzi magát komoly lépéskényszerben és nem tesznek fel mindent a pirosra (legújabb gyártástechnológia) az nem jelenti azt, hogy adott esetben a jövőben ne tudnák a termékeket úgy strukturálni, hogy legyen termékkategória ami az elérhető legújabb technológián van legyártva, akár kísérletezés jelleggel. Az, hogy a ZEN3 egy lépés technológiai lemaradással készül a TSMC legmodernebbhez képest az egy közép távú taktikai döntés volt és nem természeti törvény.

A post többi részében pedig szerintem indokolatlan keveredés van. Szerverprocesszorok kontextussal indítottunk, nem értem, miért kell idekeverni az 5G modemeket, hogy ARM chipek (amelyek nyilván mobil SoC-ok) elöbb jönnek alacsony csíkszélen mint a high perf x86. stb. Ennek köze nincsen a szerverpiachoz.

-

joysefke

veterán

válasz

S_x96x_S

#2821

üzenetére

S_x96x_S

#2821

üzenetére

Én úgy látom, hogy Te elsősorban a technikai újdonságok és termékbejelentések oldaláról közelíted meg a témát, én pedig a tényleges piaci realitás és valós potenciál irányából.

Szóval én

mintaz ARM szerverpiaci betörésének a valószínűségét 0-nál többre tartom.Én is, de szerintem ez a valószínűség nem jelentős. Ahhoz, hogy jelentős vonzerővel rendelkezzen a platform, a jelenleginél sokkal többet kéne az ARM-nek villantania. Kicsit megverni az x86-ot energiahatékonyságban és ár-teljesítményben az nem elég.

de szerintem valós a trend és a nagy Cloud szolgáltatók érzik ezt.

A nagy cloud szolgáltatatók szeretnének olcsó/energiahatékony vason szolgáltatni, meg úgy általában minnél többféle opcióval rendelkezni, de az ügyfeleknek van ARM-es gépekre igénye?

A jelenlegi vállalati ügyfelek által bérelt cloud kapacitás hány százaléka fut ARM-en és hány százaléka x86-on? Nem azt kérdezem, hogy van-e ilyen a kínálatban meg hogy a szolgáltatók jó ötletnek tartják-e. Szóval mennyi 99,9%-0,1%? És ez jelenleg mennyire gyorsan mozdul? Én nem látom, hogy jelenleg nagy igény lenne erre mármint azok részéről akik fizetnének is érte. A szakmai újságírók, cloud providerek no meg a gyártó marketingje szerintem nem releváns.

De valós ügyféligény ...

A valós ügyféligény az amiért az ügyfél fizetni is hajlandó. Amiket itt felsoroltál azok klienseszközök és kliens alkalmazások, illetve az ügyféligény amit linkeltél, az pár user siránkozása, hogy nem fut az app a kütyüjén.Abban a kontextusban ahonnan a vita indult, ott a termék az számítási kapacitás a cloudban, az ügyfelek leginkább cégek, a futtatott applikációk pedig web/sql, AD/exchange/office és custom vállalati cuccok.

20%-ék árelőny ütős érv az AWS részéről, emiatt a többi cloud szolgáltató is követni fogja a példájukat ( mert piaci kényszer is ) .

Mindenkinek a kínálatában lesz, csak hát az ügyfelek...

Egyébként a TSMC-nél gyártott ARM szerverproci hogyan fog egy a szintén a TSMC-nél azonos technológiával gyártott x86 szerverprocival szemben érdemi ár vagy teljesítményelőnyt felmutatni? -

joysefke

veterán

válasz

S_x96x_S

#2813

üzenetére

S_x96x_S

#2813

üzenetére

Semmiféle forradalom nem zajlik főleg nem minicomputer alapokon. A geekek kaptak egy újfajta tamagocsit amivel otthon el tudják az üres óráikat tölteni. Senki sem otthoni/ munkahelyi PC helyett próbálja ezeket használni. Ez egy plusz eszköz a meglévőek mellé, saját funkcióval. Ami tipikusan se nem iroda, se nem játék se nem internetezés.

Tényleges forradalomnak inkább azt nevezném, ha az Apple tényleg megpróbálna átállni ARM-re laptop/desktop fronton. A dolog sikerességében nem nagyon hiszek, de az tényleg hullámokat csapna.

És a következő egy két generáció ezen nő fel.

Facebookon, Viberen és Instagramon nőnek fel, nem linuxos Rasberry Pi-n.

és igazából erre kell az AMD-nek is válaszolni.

Stratégiailag kell egy olcsó APU, ami alapján egy "nép" NUC-ot lehet kiadni.Próbálok nem cinikusan válaszolni. De a lényeg az, hogy az AMD-nek pénzt kell csinálnia, itt és most, nem árnyakra vetődni. Azt szűk 10 évig már csinálták, meg is lett az eredménye. Ha pedig megnézed, hogy miből van most pénzük, akkor azok tipikusan nem a kicsi olcsó szarok, hanem a 200$ + -os árkategória ez CPU-ra és GPU-ra is vonatkozik.

Nem azt mondom, hogy nem kell a kicsi olcsó szarokkal (is) foglalkozni, de az AMD számára jelenleg még ott nem nagyon van pénz.

az ARM-es debian/ubuntu disztribúció már eléggé használható.

én amikor próbáltam nem volt vele semmi gond.

ha van androidos(ARM)-es telefonod, akkor a termux-al tesztelheted .

nem is kell málnapc.Geekek játékszere. Attól, hogy valami elvileg működik (működhetne) még nem lesz sikeres termék. => Desktop Linux, Windows Phone 8-10 stb

-

joysefke

veterán

válasz

S_x96x_S

#2814

üzenetére

S_x96x_S

#2814

üzenetére

Ezeknek pont nem kell. Mégpedig azért nem kell, mert a cloud ügyfeleknek (Azure, AWS, Google Cloud Platform, Digital Ocean ügyfelek) akik fizetnek a VM-ért/infrastruktúráért aligha fog mostanában ARM kelleni.

És itt az, hogy az Amazon miket jelent be kb édesmind1 amíg nem tudnak fizető ügyfeleket keríteni. Sosem a nagy bejelentések a szűk keresztmetszet, hanem, hogy a nagy ötletekért kitől lehet pénzt elkérni.

Akiknek kellhet azok a nagy felhő app szolgáltatók (Google-Facebook-Twitter- CDN szolgáltatók ilyesmi) akik a saját x86 alapú infrastruktúrájukat cserélhetnék valami költséghatékonyabbra vagy olyanra amivel kevésbé vannak az intelnek kiszolgáltatva. A FB / Google használót aligha fogja érdekelni, hogy ARM vagy x86 masináról jön a szolgáltatás.

Az infrastruktúrát bérlő vállalati felhasználót viszont nagyon is fogja érdekelni, hogy milyen platformot bérel. Főleg ha saját pénzért kifejlesztett vállalati szoftverei is vannak (amelyek nyilván x86-hoz kötöttek)

-

Cathulhu

addikt

válasz

S_x96x_S

#2789

üzenetére

S_x96x_S

#2789

üzenetére

Ha 80 magon hoz specialis esetben hasonlo teljesitmenyt es fogyasztast mint a 64 magos Epyc, az nem tul biztato. Az AMD se volt igazan versenykepes, amig magonkent nem tudta hozni az intelt, hiaba volt 2x annyi magja. Sot, lehet meg most sem szamolnak vele igazan, a szerver es HPC piac pont nem a kiserletezo kedverol hires. Na most ha x86-rol x86-ra nem hajlandok valtani, akkor ARMra meg kevesbe fognak.

-

Petykemano

veterán

-

Petykemano

veterán

válasz

S_x96x_S

#2790

üzenetére

S_x96x_S

#2790

üzenetére

Az az érdekes, hogy - eddigi infók szerint - az AMD Milan nem hoz több magot.

Az intellel szemben persze nem is kell, de ilyen kihívókkal szemben igen. Nem gondolnám, hogy az most tényleges versenytársa lenne az intelnek vagy az Epycnek. Ugyanakkor lehetnek, akik meghosszabbítják a trendvonalat és számolnak azzal, hogy 2-3 év múlva mi lesz. Úgy ruháznak be, vagy úgy fejlesztenek. Ebben az értelemben mondom, hogy különös, hogy nem lesz több mag. Pedig a mindshare megtartásához nyilván kell, hogy aki erre felkapja a fejét, az amikor meglátja a Milant, az majd akkor legyintsen erre, ahelyett, hogy elkezdje nyomon követni. -

S_x96x_S

addikt

válasz

S_x96x_S

#2789

üzenetére

S_x96x_S

#2789

üzenetére

A STH jobban pontosítja az Amperes vs. EPYC összehasonlítást ..

ami lényeges, hogy mit hagytak ki az összehasonlításból,

például az FP-t ..

"What is completely missing from all of the performance numbers is floating-point performance. "

------

Ampere Altra Launched with 80 Arm Cores for the Cloud

https://www.servethehome.com/ampere-altra-80-arm-cores-for-cloud/"

Let us be clear, this is a huge step forward from eMAG. It is also an important milestone for the Arm server market. This is a much more competitive part than previous iterations. If Arm is going to take sockets from Intel and AMD as primary server CPUs, this is a step in the right direction.

Looking ahead, AMD says that its next-gen “Milan” architecture is due out later this year. Since AMD has EPYC 7002 “Rome” systems already shipping and greater system diversity, and Ampere Altra is not shipping in the same quantity yet, the real competitor to Altra from AMD will be Milan." -

Petykemano

veterán

válasz

S_x96x_S

#2751

üzenetére

S_x96x_S

#2751

üzenetére

"Igazából az AMD-nek is szüksége lenne ilyen AI/ML-re tunningolt HPC-s APU-kra"

Csak emlékből, de mintha az arcturusnál.megjelenne a bfloat16, ami egy fontos és hasznos fícsör a ML cuccokhoz.

És a navi12-t is úgy emlegetik, hogy DL/ML utasításokkal bővül.Ezek szerintem alkalmasak lehetnek az AMDnek AI/ML lábaknak. Nyilván lehet lefelé skálázni apunak.

Viszont ezt a kifogja a szelet kérdést nem teljesen értem. Mármint abból foghatja ki a szelet, hogy egy komolyabb gpu-t egy komolyabb CPU mellé kelljen tokozni "BIG APU"-ként.

A közös tokozás , közös IO lapka ugye azt tenné lehetővé, hogy a compute lapka a memória sávszélességvel tudjon adatokan kinyerni a memóriából, ne pedig a pcie3 sebességével. A pcie6 ezt a gátat mondhatnók áttöri. Pcie6-on keresztül is megoldható a memória-koherens elérést (CXL) tehát egy ilyen compute lapka HBCC-vel tudna streamelni a saját memóriáját gyorsítótárnak használva. (Nyilván persze a pcie6 az egy plusz lépcső)

A vitorlából kifoghatja a szelet dolgot úgy tudom értelmezni, hogy míg összetokozásos megoldás esetleg csak AMDnek volt, addig bár a cxl és a pcie6 nem gátolja meg az amdt se, hogy úgy kínálja a portékáját, de úgy már jelentős verseny lehet.

Talán csak az az egy kérdés van, hogy vajon energiafelhasználás szempontjából számít-e, hogy csak az IO lapkán keresztül történik-e a memóriaelérés, vagy még a pcie6-on is átmegy. Ugye az epyc esetén is a huzalozáson átáramló adat rengeteg energiát emészt fel.

-

Cifu

félisten

válasz

S_x96x_S

#2750

üzenetére

S_x96x_S

#2750

üzenetére

A fő kérdés, hogy ki merre indul el és mennyire sikerül az adott technológiát elterjeszteni. Tök jó, hogy az Epyc tudja a PCI-Express 4.0-át, de ahhoz hardverek is kellenek. Mondjuk jönnek is, lassan, de jönnek. Csakhogy a CCIX és a Gen-Z pont azért kezdett el formálódni, mert a PCI-Express lemaradt, nem kicsit, nagyon. A felhő alapú számításnál pedig hátrányba került az, akinek nincs saját külső interconnectje (az nVidia itt gurított az nVLinkkel, a 2.0 már kint van két éve, 200Gb/s sebességgel, full duplex).

Az Intel kicsit elaludt, mivel a PCI-Express 3.0 vonallal tökön lőtte magát, mert ott például 8Gb/s per lane van, ami 16x csatinál = 128Gb/s. Közben meg jönnek már a 200Gb/s és készülnek a 400Gb/s hálózati csatik. Igény lenne rá, mert iszonyatos pazarlás, hogy a 16x PCI-Express csatikat hálókártyákkal tömjék meg, csak ugye az Epyc esetében is 256Gb/s az elméleti csúcs, és várják sokan a PCI-Express 5.0-át (elméleti határ: 512Gb/s). Ezért kell a CCIX (25Gb/s * 16 = 400Gb/s) és brutálisan erős opció a Gen-Z (itt még az alap 16Gb/s per lane is elégséges lehet, ha kihasználód a 256 sávot = 4096Gb/s elméleti határ, és a szkenárióban ott van az 56Gb/s per lane...). A

Miután az AMD túl kis szereplő (jelenleg), hogy maga határozza meg a "merre" vonalat, ezért kénytelen minél többet támogatni, hogy legalább a rugalmassága miatt opció legyen az asztalon.

-

Cifu

félisten

válasz

S_x96x_S

#2745

üzenetére

S_x96x_S

#2745

üzenetére

A specifikáció lezárása egy dolog, a piacra kerülés egy másik. 2021-ben örülhetünk, ha a 2019-ben lezárt PCI-Express 5.0 megérkezik. Ugyebár a lezárt specifikációkat még be kell építeni a jelenleg fejlesztés alatt lévő CPU-kba, SKU-kba...

Röviden egyébként a "szokásos" előrelépés, vagyis duplázódik a sávszélesség a PCI-Express 5.0-hoz képest és alacsonyabb válaszidő.

-

HookR

addikt

válasz

S_x96x_S

#2743

üzenetére

S_x96x_S

#2743

üzenetére

A második linkeden van egy érdekes, látókör szélesítő komment, remélem nem gond, ha bemásolom:

olliej: "I still don’t understand what it is about avx2 that results in these kinds of issues - is it really just a matter of increased number of execution units running at once causing weird power and heat issues?"

paulmd: "Not increased number of execution units, but increased number of transistors, yeah.

A normal multiply does 1 number at a time (32 bit for simplicity). AVX2 can do up to 8 multiplications at a time. That's a huge amount more transistors firing all at once and that causes the voltage to start to droop.

AVX-512 takes that even further and now it's 16 multiplications per unit, oh and Intel moved from 1x256-bit unit per core on Haswell/Broadwell to 2x512-bit units on Skylake-X, so it's potentially 32 multiplications at a time.

Basically to prep for that much power being drawn all at once, the chip has to wind everything else down and switch to a higher-voltage mode to account for the voltage droop caused by all those transistors switching at once in one place.

At this level behavior is intensively analog and thermals/voltage both significantly affect transistor current draw and switching time, which feeds back into heat and power consumption.

This gets even more problematic on 7nm/10nm type nodes and especially in GPUs where you are doing a huge amount of vector arithmetic all the time. Essentially it is no longer possible to design processors that are 100% stable under all potential execution conditions, or even under normal operating conditions, so you have to have power watchdog circuitry that realizes when it's getting close to brownout/missing its timing conditions and slows itself down to stay stable. That's why AMD introduced clock stretching in a big way with Zen2 (despite the fact that it's nominally been around since Steamroller). NVIDIA piloted this with Pascal, AMD piloted it with Vega and brought it to CPU with Zen2. You simply cannot design the processor to be 100% stable at competitive clocks anymore. You have to have power management that's smart enough to withstand small transient power conditioning faults.

https://semiengineering.com/managing-voltage-drop-at-107nm/

https://semiengineering.com/power-delivery-affecting-performance-at-7nm/ " -

Petykemano

veterán

válasz

S_x96x_S

#2733

üzenetére

S_x96x_S

#2733

üzenetére

Érdekes, hogy az ibmnél már a L3$ is eDram.

Kár, hogy nem mondanak.többet erről a 96 magos prototípusról. Persze nyilván itt nem a CPU a lényeg, hanem az aktív interposer, az összeköttetés és a skálázódás.

Ja, meg persze a 3d

Bár ez nekem magyarázatra szorul. Itt 6 lapka van. Ezek vannak 3d stackelve? Vagy arról van szó, hogy egy lapka 8 magos, ebből van 2db 3d stackelve.és ilyen 2x8-as toronyböl van 6?Mindenesetre igen, azt korábbi mérésekből tudjuk, hogy interposerrel Lehetne jelentősem csökkenteni az összeköttetés fogyasztását.

Active interposer lehet egyben IO lapka is. Adoredtv csinált videót a lehetséges topológiákról is.

És hát ez azt is bemutatta, hogy miképp Lehetne megduplázni a magok számát úgy, hogy közben az egész package kiterjedése nem nő. -

S_x96x_S

addikt

válasz

S_x96x_S

#2725

üzenetére

S_x96x_S

#2725

üzenetére

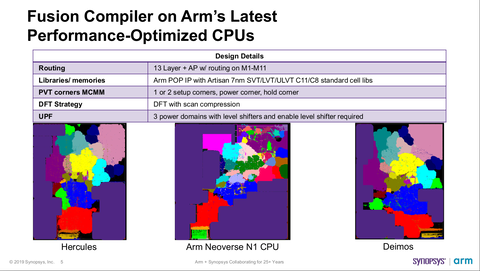

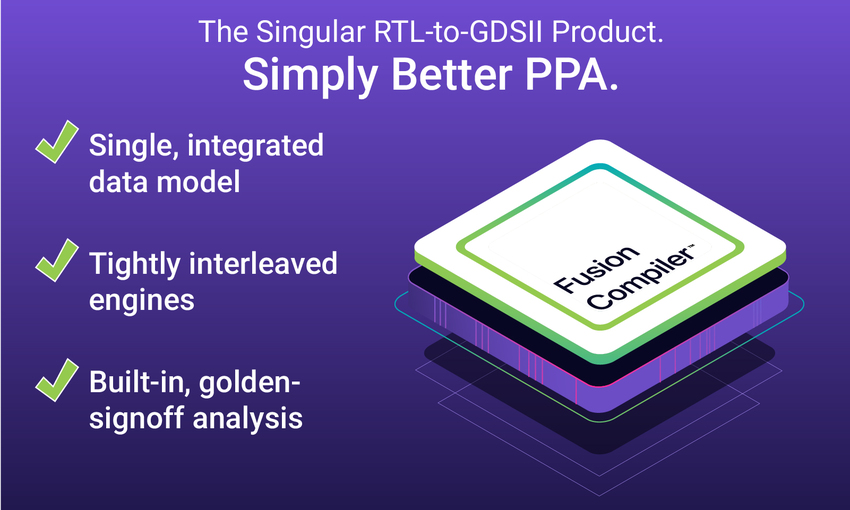

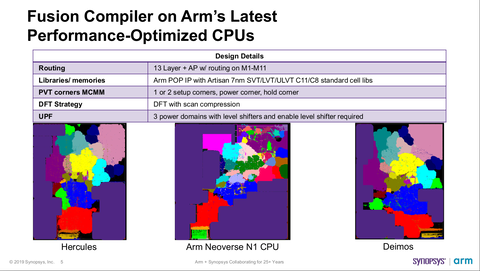

Fusion Compiler ...

The Singular RTL-to-GDSII Digital Implementation Solution

https://www.synopsys.com/implementation-and-signoff/physical-implementation/fusion-compiler.html"Benefits

* Single, integrated data model architecture for unmatched capacity, scalability, and productivity

* Unified RTL-to-GDSII optimization engines unlocks new opportunities for best performance, power, and area results

* Built-in signoff timing, parasitic extraction, and power analysis eliminate design iterations

* Pervasive parallelization with multi-threaded and distributed processing technologies for maximum throughput

* Leading foundry process certified FinFET, gate-all-around, and multi-patterning aware design

"

És az ARM -es új chipek tervezésénél is ezt használták.

( Fusion Compiler on Arm’s Latest Performance-Optimized CPUs )

-

S_x96x_S

addikt

válasz

S_x96x_S

#2722

üzenetére

S_x96x_S

#2722

üzenetére

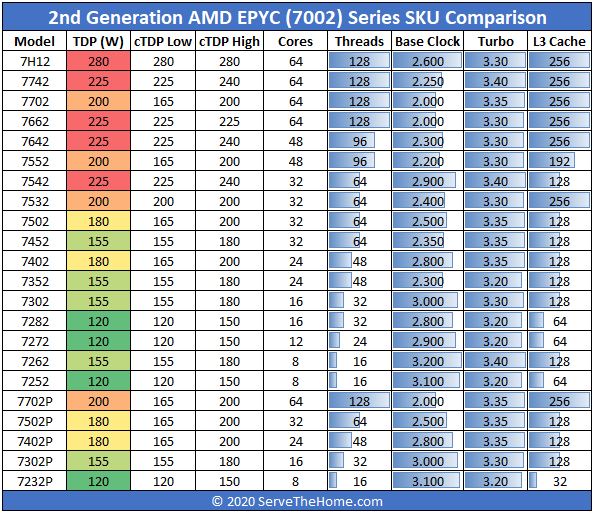

Az új 32c/64t -es CPU-nál (7532) kimaxolták az L3-as cachet - 256Mb-lett, mint a 64c-é. Lehet, hogy ez is valamilyen összefüggésben van a VMware-es licensz módosítással.

Update: We now have list pricing from AMD “In our standard 1Ku pricing, the 7662 is $6,150 and the 7532 is $3,350.” (Source: AMD)

AMD says that Dell and Supermicro will now offer the two new SKUs while HPE and Lenovo will follow. We requested list pricing and will update this piece when we get it.

https://www.servethehome.com/amd-epyc-7662-and-epyc-7532-launched/

-

Cifu

félisten

válasz

S_x96x_S

#2716

üzenetére

S_x96x_S

#2716

üzenetére

Állítólag az "Unreal Engine" - kapott egy kis optimalizációt

...a kódfordító motorhoz (compiling), és nem a játékengine-hez magához.

de ezen kívül tud valaki még valamit, hogy az UE - mennyire támogatott több core -on ?

Úgy tudom 64 szálig skálázódik. *Doppergés* függően attól, milyen jellegű terhelést kap.

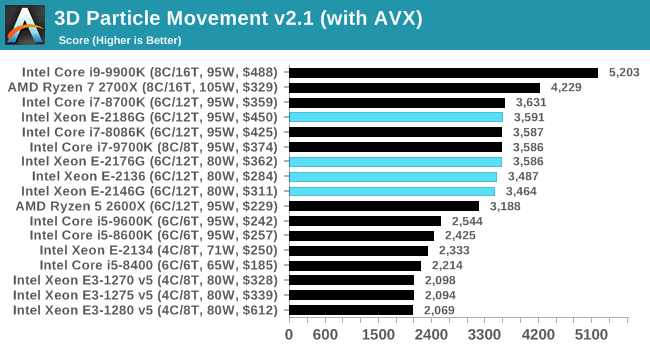

Ez a fő probléma a fejlesztés terén: bizonyos dolgokat tök szépen lekezel az UE, de nagy általánosságban nehéz a párhuzamos multi-thread megfelelő leprogramozása. Szóval az UE motoros játékok többsége jelenleg jobban szereti a magas IPC-t, mint a több szálat.

Nézd meg az SW: Jedi Fallen CPU teszteket, az i3-8100 (4 mag / 4 szál) kb. olyan teljesítményt nyújt, mint a Ryzen 5 3600 (6 mag / 12 szál). Az i5-8400 (6 mag / 6 szál) pedig lelépi az R9 3950X-et is...

-

Petykemano

veterán

válasz

S_x96x_S

#2695

üzenetére

S_x96x_S

#2695

üzenetére

"Lehet, hogy Raja re-inkarnálta a OneAPI -ba a legtöbb HSA ötletet."

Nem volna rossz, de csak hogy lássuk, hogy Abu nem habokra tépte a száját.

Amúgy nyilván mindig felmerül a kérdés: mik azok a műveletek, vagy inkább úgy fogalmazok, hogy jobok, batchek, taszkok, amelyeknél egy finomszemcsés gpu gyorsítás megéri mondjuk főleg a vektoros AVX(512)-szel szemben?

Valamilyen elvont értelemben ugye ugyanarról beszélünk: van egy halom adat, amire a frontend ráenged valamilyen feldolgozó egységet. Csak egy CU nyilván lényegesen messzebb van, lassabb adat-összeköttetéssel és a vezérlés sem megoldott.

-

hokuszpk

nagyúr

válasz

S_x96x_S

#2691

üzenetére

S_x96x_S

#2691

üzenetére

legalabb majd mindenki jol meglepodik, amikor 12 mag / 24 szalas zen3 lesz a konzolban RDNA2 -es gpuval, hbm2e -vel.

** mert anno olvastam a Sony alapitojanak a konyvet, es valami olyasmi volt a vonalvezetes mar az elso termekektol kezdve, hogy "a hardverhez szoftver kell". Ezért szállt be anno a Sony a zene és filmiparba.

most viszont ott tartunk, hogy a "Szoftverhez hardver kell". És a szoftveren sokkal nagyobb a haszon... -

joysefke

veterán

válasz

S_x96x_S

#2679

üzenetére

S_x96x_S

#2679

üzenetére

de pl. a leendő konzolos célhardvernél : PS5 APU-ja ( ahol a pc-s szűk keresztmetszeteket kezelték és minimális szoftveres overhead van ) már elég jó a helyzet - szerintem lesz pár olyan játék, aminél leesik az állunk.

A PS5 vagy Next-Box APU-ja nem azért lesz gyors mert "minimális szoftveres overhead van" vagy mert a PC-s overhead számottevő vagy lényegesen nagyobb lenne (ezt is kötve hiszem) hanem azért mert egy R5 3600-nál erősebb CPU mellé kerül egy bika GPU sok és gyors memóriával ráadásul az első években jó ha nullszaldós lesz a hardware.

Magyarul azért mert relatíve erős hardver kerül az új konzolokba, ennek köze nincsen semmilyen "kisebb overheadhez"

-

TRitON

aktív tag

válasz

S_x96x_S

#2679

üzenetére

S_x96x_S

#2679

üzenetére

Az alapvető akadály az APU-k fejlődésében a memória sávszélesség, illetve annak hiánya, valamint, hogy a GPU tápellátása az alaplapokon jelenleg eléggé karcsú.

A Dual Channel DDR4-3200 elméleti maximális sávszélessége 51.2GB/s, ez egy 4770-es (!) Radeon memória sávszélességével egyenlő és nyilván egy APU-nál figyelembe kell venni azt is, hogy ennek a sávszélességnek csak a töredékét tudja használni. Ennek ellenére egy Vega 11 a 4770 teljesítményének a dupláját produkálja, ami eléggé szép teljesítmény (valahol a HD 6870 (134.4GB/s) és 6950 (160GB/s) között van félúton).

Az APU-k teljesítményének drasztikus növekedését a DDR5 memória, és/vagy a memória csatornák számának növekedése hozhatná el; itt egy kalap alá tenném az esetleges integrált HBM memóriát is, mint egyfajta L4 cache-t.

Például, tegyük fel, az AMD a következő TRX50 foglalatot úgy készíti el, hogy legyen rajta dedikált, sokfázisú táp egy GPU-nak, ami normál CPU esetén annak energiaellátásában vesz részt, APU esetén egy teljesen külön táp a GPU-nak (vagyis pl. a 16 fázisból 8-8-ra osztódik szét), illetve van rajta 4x64bites, DDR5 memória csatorna, na meg persze monitor kimenet. Ez már, ha egy közepes, 5200-as modullal számolunk, 166.4GB/s sávszélesség, a jelenleginek a háromszorosa.

Ez azt jelentené, hogy (elméletben), a klasszikus, AM5-ös APU-k teljesítménye valahol a HD 7870 körül lehetne (+50%), a TRX50-eseké pedig az R9 290 környékén; itt nyilván rendelkezésre állna egy ~120W-os TDP keret is.

De ez persze csak egy elmélet, tudtommal semmi nem mutat abba az irányba, hogy a TR-ek heterogén cuccokká váljanak, pedig az a platform lenne erre tán a legalkalmasabb. -

S_x96x_S

addikt

válasz

S_x96x_S

#2671

üzenetére

S_x96x_S

#2671

üzenetére

> A lényeg: az lehet, hogy azonos áron egyre nagyobb

> teljesítményű apuk jelennek meg (évről évre egyre több tflops),

> de azt a trendet nem látom, hogy azonos áron

> az is kapaszkodna fel, hogy milyen minőséget tudsz elérni

> (évről évre 1080p-ben egyre jobb grafikai beállítás,

> és/vagy egyre több fps - nyilván nem ugyanabban,

> hanem az újabb és újabb játékokban értve)

valószínüleg túl lett marketingelve (mint minden )

.. és a bevezetés is sokkal nehezebb ( értem ezalatt a teljes ökoszisztémát : directx12, játékenginek, játékfejlesztők ) valamint a memóriagyártók se túlságosan remekeltek.de pl. a leendő konzolos célhardvernél : PS5 APU-ja ( ahol a pc-s szűk keresztmetszeteket kezelték és minimális szoftveres overhead van ) már elég jó a helyzet - szerintem lesz pár olyan játék, aminél leesik az állunk.

Ha pár ötlet beválik, akkor az átszivárog a mezi pc-kbe is. ( de ennek is kell pár év )vagyis én látok trendet az APU-knál, csak lassú, nehezen érzékelhető itt a végeken.

és szerintem ~5 éven belül lesz HPC - APU -is ...

és egy friss idézet Mark Papermaster (AMD)-től:

"There are parts of applications that will diverge from the processing strengths of traditional CPUs. GPUs, FPGAs, and purpose-built ASICs are already examples. The industry has been pursuing heterogeneous computing for years. For example, at AMD we merged CPUs and GPUs onto a single die to reduce latency. We call this an Accelerated Processing Unit, or APU." ( link )

Amúgy szerintem a PCIe4.0 bevezetés is lassan megy. -

#82819712

törölt tag

válasz

S_x96x_S

#2671

üzenetére

S_x96x_S

#2671

üzenetére

APU-kkal szerintem az a baj hogy nincs 4900G és ha lehet alaplapra integrálva. A G vonal teljes elhagyása fájó pont a 4000-es sorozatban. (Anélkül hogy tisztában lennék a HBM2E árával...)

Intel előáll most ezzel a TILE-vel, csempe mozaik kinek hogy esik.

A dokumentáció azt mutatja, hogy az Intel Xe GPU-k „csempe” modulokat fog használni.(4) Az Intel nem nevezi ezt „chiplets” -nek a dokumentációban.

"Xe cards would use a multi-die system, packaged together by Foveros 3D stacking"

Ezen nagyon filózok mi lehet ez???

Létezik hogy a HBMhez hasonlóan már egymásra tudják pakolni a chippeket? vagy AMD szerűen elő a GLUE és 4-et egymáshoz tudnak már ragasztani??? -

Petykemano

veterán

válasz

S_x96x_S

#2671

üzenetére

S_x96x_S

#2671

üzenetére

szerintem inkább

- az erős APU-k tesznek be a high-end GPU-knak.

Igen, sokáig így tűnt. Mondjuk 4-5 éve az a várakozás (nem remény, hanem trend értelemben), hogy az apuk felfalják a dGPU-k alsó szegmensét. Természetesen ez csak akkor igaz, ha közben nem nő ezzel egyenesen arányban a játékok teljesítményigénye is.

A dolognak kicsit megálljt parancsolt az, hogy az intelnél leálltak a fejlesztések és az AMD lehetőségeit is korlátozta a nem GDDR/HBM ram által elérhető sávszéleség, amit nem próbáltak áttörni.Ugyanakkor szerintem az apukra is igaz, hogy egyre drágább lesz. Jelenleg egy 3400G-t, amivel ha jól emékszem, 1080p-ben 60fps-sel low-ban lehet játszani, 50eFt-ért (+körítés) kapsz meg. Én sajnos nem hiszem, hogy egy ennlé erősebb IGP.vel rendelkező Renoirt ezért az árért lehet majd megkapni. egy 6 magos szerintem igazodni fog a 6 magos Matisse árához, tehát minimum $200, de lehet, hogy akár $250 (80-90eFt) is lehet.

A lényeg: az lehet, hogy azonos áron egyre nagyobb teljesítményű apuk jelennek meg (évről évre egyre több tflops), de azt a trendet nem látom, hogy azonos áron az is kapaszkodna fel, hogy milyen minőséget tudsz elérni (évről évre 1080p-ben egyre jobb grafikai beállítás, és/vagy egyre több fps - nyilván nem ugyanabban, hanem az újabb és újabb játékokban értve)

- És jönni fognak az Intel oldaláról is a hasonló CPU-k erős integrált grafikával )

- És az új konzolokról se feledkezzünk el.Azzal kapcsolatban nekem is van várakozásom, hogy az intel oldaláról érkező verseny akár a dgpu-kra, akár az apukra nézve lehet jótékony hatású. És sokan várják ugyanezt a konzoltól - hogy ha $600-ért lehet kapni egy remek konzolt, akkor kevesebben fognak $1000-t fizetni egy remek videokártyáért. NYilván a két piac nem teljesen átjárható, de lehet zabolázó hatása a felbukkanó részlegesen helyettesítő termékeknek.

(Én magam is felvetettem, hogy talán megvalósítható lenne és milyen remek lenne egy $500-600-os big apu 8 maggal és 40CU-val 16GB HBM2E-vel.)

A felhasználási szokások persze sokrétűek. Az igazság az, hogy én el szoktam mondani, hogy ma már irodai munkára sem elég egy 2/4-es cpu. De ettől eltekintve ha én döntően játszom, akkor mi motiválna arra, hogy 12-16 magos aput vegyek $400-500-ért (amin elketyeg valami 1080p&60fps high) mondjuk egy $200-os chromebook helyett vagy egy $120-os rpi helyett, amivel $5 ellenében máris tudok játszani IS nagyjából ugyanebben a minőségben. Nyilván renderelni nem fogok.

Ezzel most azt akartam mondani, hogy lehet, hogy az apuk esetleg elhappolják a teret a diszkrét GPUk- elől, de eközben meg úgy tűnik, mintha a cloud gamint meg elhappolná a teret/létjogosultságot az olyan apuk elől, amiknek épp az lenne az érdeme, hogy már rendesen lehet rajtuk diszkrét GPU nélkül is játszani.

Ennek a trendnek, vagyis a felhősödésnek csak az szabhatna gátat, ha

1) olyan workloadok alakulnának ki a többletteljesítmény hátán, ami nehezen felhősíthető

2) a technológiai fejlődés a többletteljesítmény megvásárlását megfizethetővé is teszik. Tehát az egy zsákutca, hogy a szűkülő piac miatt egyre többet kel fizetni a több teljestményért, amit aztán egyre kevesebben vesznek meg és még tovább drágul.Teszem hozzá, szerintem az AMD, az intel és az nvidia - feltéve, hogy nem tudnak profitjukat megtartva teljes mértékben átállni a felhő és más ipari szolgáltatók kiszolgálására - érdekelt abban, hogy konzumer piacon nagy volumenben értékesítsen hardvert.

-

#82819712

törölt tag

válasz

S_x96x_S

#2664

üzenetére

S_x96x_S

#2664

üzenetére

Ettől clickbaitesebb címet nem mutatsz Redditen ma egy 2001es cikkről beszélgetnek:

3...

"Ha a fiad új "processzort" kért egy AMD nevű társaságtól , ez valódi oka a riasztásra."

"AZ AMD egy harmadik világban működő társaság, amely alacsonyabbrendű, "knock-off" másolatokat készít az amerikai proceszorokról." -

Petykemano

veterán

válasz

S_x96x_S

#2667

üzenetére

S_x96x_S

#2667

üzenetére

Csak találgatok :

Lehet-e offloadolni raytracinget, vagy bármilyen grafikai munkát cpura, ami nem kötelező, de hasznos lehetőség a sokmagos cpuk eladásához és amihez jól jöhet a pcie4.

Esetleg nem CPU, hanem egy m.2 foglalatos compute stick?"2-3 év múlva pcie5-ös gpukat akarnak majd ránk sózni"

Itt is felteszem a kérdést. Az a tapasztalat, hogy jó internet kapcsolat mellett kár most is jó a GFN. Ez persze csak 1080p, de csak havi $5. Ez kibírható. Miközben ugye arról beszélünk hogy ma már egy 1080p 60fps ultra grafikával tudó gép azért 200eFt, SFF/noti esetén minimum 300eFt

Persze lehetnek platformfüggő címek, ami miatt mégsem lehet $5-ból megúszni, biztosan nagyobb a lag, mint kliensen futtatva, bizonyos körülmények között kompromisszumokat kell kötni, de tévén, mobilon, jóval olcsóbb, vagy meglevő eszközön is működik.Természetesen az apuk fejlődésével azt várná az ember, hogy lassan elérünk oda, hogy 1080p 60fps ultra meglesz, tehát hogy ezt a teljesítményhez egyre olcsóbban hozzá lehet jutni, ami mind a cloud, mind a kliensoldali minőség igényét egyre magasabbra tolja.

Viszont nem ezt látjuk, hanem azt, hogy bizonyos teljesítményszintek nemhogy egyre olcsóbbak, hanem inkább drágábbak lesznek. A technológiai fejlődés nem lehetővé teszi a magasabb számítási igényű, jobb minőségű grafika előállítását, hanem sokkal inkább arról van szó, hogy a ár/érték arány stabil, de a magasabb, extrém minőség bevezetése (pl az, hogy 16GB RAM kelljen, meg a raytracing is így debütált) igazából csak ösztönző a még drágább hardver megvásárlására. A maximumhoz egyre többet kell fizetni, pont úgy, ahogy az 1080p-hez is.

Eközben abu azzal riogat, hogy valóban egyre drágábbak lesznek a.hardverek.

Tehát ha adott minőséghez egyre drágább hardver szükséges, akkor egyre kevesebben fognak vásárolni, szűkül a piac, emiatt megint áremelkedések várhatók, stb. Közben elindulnak a cloud gaming szolgáltatások.

Így kinek fognak 2-3 év múlva pcie 5 kártyákat eladni?

Mit Lehetne felvillantani, hogy jelenlegi széles tömegek vásároljanak. A volumen nyilván nem mindegy. Persze lehet olyan gyártó, amelyik átáll kliens hardverek helyett cloud hardverek gyártására. (Mondjuk nekem eddig mindig úgy tűnt, hogy a cég, amelyik nem tudja nagy volumenű gyártásra szétkenni a költségeit, annak vége) Pcie5 ott is kelleni fog nyilván.

De bennem most az merült föl, hogy vajon lesz-e még egyáltaln high performance client gpu piac 2-3 év múlva akkor, Amikor $5-ért cloud gaminget? -

válasz

S_x96x_S

#2665

üzenetére

S_x96x_S

#2665

üzenetére

Nem hiszem, hogy lesz lényegében kimérhető különbség a PCIE3 és PCIE4 vga között (kapcsolatban).

Ehhez nem erősebb kártya kéne, hanem más programozási gyakorlat a jelenlegihez képest (pl. nem mindent betölteni előre a grafikuskártya memóriájába, hanem menet közben tölteni be ahogy kell abba tartalom)..

egy nagy különbség lehet még is... rövidebb játékbetöltési idő, ha jelenleg a vga memóriába másolás lenne a szűk keresztmetszet (és időt igénylő feladat). De nem hiszem, hogy utóbbi jelenség annyit számítana, hogy pcie4 platformhoz ragaszkodna emiatt az ember

De lényegében jelenlegi kártyákkal még a pcie3 esetén a 16x és 8x között is marginális különbség van (mondom ezt én, egy olyan platformon aminek csak pcie2 támogatása van).De ez a B550 chipset ... tényleg nem tűnik nekem úgy, mint ha bármit is változott volna a korábbi promontory sorozathoz képest.. szerintem maximum tényleg csak azon hibák javítására került benne sor ami miatt nem volt népszerű (sőt kitiltották) egyes állami körökben az adott chipsettel szerelt gépeket (így kvázi a teljes AMD platformot hivatali körökben).. és eddig elhúzódott a hiba javítása.

-

paprobert

őstag

válasz

S_x96x_S

#2642

üzenetére

S_x96x_S

#2642

üzenetére

Ettől a grafikontól függetlenül, méret és TDP limitált helyzetekben (mobil) azt látjuk, hogy az Apple még tud előre menni, a Qualcomm viszont egy helyben toporog lassan 3 generáció óta, ahogy a Samsung is.

Szerverben egyik limit sem létezik igazán, tehát ha valós lenne hogy a mobil megoldások néha már verik az x86-ot, akkor szerverben már át kellett volna venniük a vezetést a legtöbb tulajdonságot tekintve. De ez egyáltalán nincs így, tehát ebben a cikkben legalább egy nagy csúsztatás van.

-

Petykemano

veterán

válasz

S_x96x_S

#2642

üzenetére

S_x96x_S

#2642

üzenetére

Bár ha jól látom, nem teljesen egyértelmű, hogy mit mutatnak a csíkok. Geekbench Single thread? körülötte IPC-t emlegetnek.

Mindenesetre azt gyaníom, hogy a fekete az Apple A13-mal a végén.

De ez nem lehet IPC. mert az A13 valójában már elég durván magasabb IPC-t hoz - legalábbis Geekbench5-ben.

A13: ~1350 @ 2660MHz

x86: ~1700 @ 5000MHzNem nehéz kiszámolni, hogy közel 50%-kal magasabb az IPC.

Más kérdés, hogy vajon magas frekvenciát is el tudna-e érni.

És más kérdés, hogy vajon az x86 a frekvencia néhány %-os elengedése mellett tudna ilyen 20-30%-os IPC-t hozni.Az biztos, hogy a frekvencia nem megy feljebb. Mindenki tegye meg tétjeit, hogy vajon a x86 tud-e a tranzisztorbüdzsé erre való áldozásával IPC-t növelni és hogy az ARM-nál ez a folyamat meredekebben tarthat-e anélkül, hogy hasonlóan elszállna a fogyasztás.

Ugye sok esetben sok energiát nem is a számítás elvégzése emészt föl, hanem hogy egy nagy lapkán belül az adat utazik. Ezért mondják, hogy a jövő a "Data locality" fejlesztésében rejtőzhet.

Mindenesetre ez valamilyen ST teljesítmény lehet. Abban meg tényleg nem volt jelentős előrelépés az x86 terén.

-

#82819712

törölt tag

válasz

S_x96x_S

#2642

üzenetére

S_x96x_S

#2642

üzenetére

Egy ideje már heggesztgetik az AMRszos windowst, a chiplet szemlélet elterjedése GPUban is jelentősen előnyhöz juttathatja őket, kérdés majd mi üt be előbb az 1nmnél a grafénra való átállás vagy a ARM igazán nagy teljesítményű változatai.

De ha így drágul minden akkor 5- 3 nm-en már alig valamit kapunk a pénzünkért (mm^2). -

joysefke

veterán

válasz

S_x96x_S

#2612

üzenetére

S_x96x_S

#2612

üzenetére

Minden olyan programnál, amit AVX-512 támogatással fordítottak

Feltételezem a gyakorlatban, ez leginkább csak bencsmárkokat jelent.

Az AMD-nek szerintem nem az lesz itt a baja, hogy az intel tud AVX512-t, ők meg csak 256 bites AVX-et, hanem a legtöbb problémás esetben az, hogy az intel procit a dispatcher ráviszi a legjobb AVX kódra, az AMD pedig a skalár kódot futtatja pedig tudna elég komoly órajel (és magszám előny mellett) mellett AVX2-t is. Az hogy az AVX kódot is az aktuális intelre felépítésre optimalizálták és nem AMD-re az már részletkérdés, ha az AMD ráfut a vektor kódra.

Ha ránézel a magszámokra, AVX-órajelekre, cache méretre és a teljes processzor memória sávszélességére, akkor szerintem nem az AMD-nek van szüksége AVX512-re, hogy pariban legyen az intellel, hanem az intelnek van szüksége az AVX512-re hogy egyrészt legyen valami marketingfegyvere illetve ne verje agyon a ZEN2/3, ha az éppen ráfut egy több szálon végrehajtott AVX2 kódra.

Mondom ezt úgy, hogy AVX512-vel még nem volt dolgom, és SSE/AVX-szel is csak pár egyszerűbb kódot írtam (önképzés jelleggel hobbiból), tehát ha valaki jobban rálát a dologra javítson ki

-

-

S_x96x_S

addikt

válasz

S_x96x_S

#2596

üzenetére

S_x96x_S

#2596

üzenetére

Linux -os teszt.

AMD Ryzen Threadripper 3990X Offers Incredible Linux Performance

https://www.phoronix.com/scan.php?page=article&item=3990x-threadripper-linux&num=1

"When taking the geometric mean of the benchmarks for this article today, The Threadripper 3990X came out overall 26% faster than the dual Xeon Platinum 8280, which is a very nice accomplishment since such a configuration currently retails for $20,000 USD worth of processors alone. For those doing serious content creation work like Blender or other CPU-based renderers/modeling, engaging in heavy multi-threaded workloads that aren't memory intensive (where instead you'd be better off with the EPYC 7002 CPUs with eight-channel memory), or code compilation of large software projects, the AMD Ryzen Threadripper 3990X is a mighty impressive competitor" -

S_x96x_S

addikt

válasz

S_x96x_S

#2595

üzenetére

S_x96x_S

#2595

üzenetére

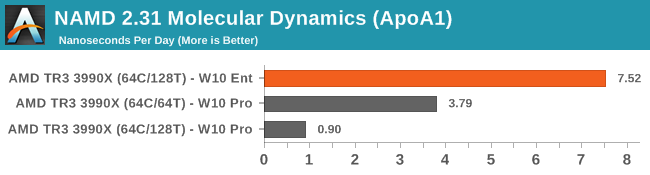

Azért a Microsoft is sarcol a magasabb magszámért.

és a 64 core/128thread-nél kijön az eltérés .. nem mindegy, hogy milyen Windows fut rajta ...A 64magos threadripperhez - W10 Enterprise - kell .. ; egyébként szívás

( Vagy használj Pro-t és kapcsold ki az SMT-t .. lásd 64c/64t - második sor ; de hogy még büntessen is 128T-nél ... )

)

-

Petykemano

veterán

válasz

S_x96x_S

#2575

üzenetére

S_x96x_S

#2575

üzenetére

"úgy kell a teljesítményt növelnie, hogy a tágabb üzleti partnereket (pl. VMware) se haragitsa meg .."

A 64 magos cpu lényegében megduplázta az egy socketből kihozható teljesítményt.

Ez a vmware-re nézve mindenhol bevételkiesést jelenthet,.ahol nem a számítási igény nőtt meg, hanem spórolni akartak: több tflops/kWh, kevesebb gép, kevesebb socket, kevesebb licencdíj.

Mondjuk minden cég, ahol a számítási igény nem nőtt, de kettőnél több socketet használtak. Ha jól tudom, a.vmware virtualizációt valósít meg, tehát elég valószínű, hogy ez elég sok vmware ügyfelet érinthet.Na, de oda akarok kilyukadni, hogy

Világos, hogy a 4 szál nevezetese is hasonló hatást váltana ki a vmwaretől, illetve más cégektől, amik jelenleg socketre, vagy magra vetítve számláznak.De mi az, ami nem?

Tehát ha holnap az AMD kihozna egy olyan procit, ami felépítésében megegyezik a jelenleg piacon levőkkel, de 50-100%-os IPC emelkedést hoz, vagyis egy ilyen 32 magos processzor ellátná egy mai szerver feladatait, amire ma 2x32 magos licenct kell megvásárolni, akkor az is sérti a vmware érdekeit, nem?

Ezek szerint a hardver kapacitás csak olyan mértékben nőhet, amennyire a számítás igény, különben a fejlődés túl diszruptív ami a hardver vásárlónak jó lenne, azt az előnyt - részben - elgáncsolja a licencelő.

Persze nem állítom, hogy nem ezt tenném, csak kérdezem, hogy mi az az előrelépés, a számítási igények stabilitása mellett, Amivel piacot tudsz szerezni, de nem lépsz rá a szoftveresek tyúkszemére?

-

válasz

S_x96x_S

#2572

üzenetére

S_x96x_S

#2572

üzenetére

Ha meglépne egy ilyet az amd, valószínű hamar lekövetnék a licenszekkel is. és más módon menne a licenszköltség onnantól.

Ha majd lesz SMT4 szerintem ott is lehet lépnek rá valamit (lehet átállnak száll alapú licenszre). Vagy valami olyanra, hogy X mag de maximum X*2 száll... Persze csak akkor ha a teljesítményben is kiérződne egy esetleges "előny"... -

Petykemano

veterán

válasz

S_x96x_S

#2566

üzenetére

S_x96x_S

#2566

üzenetére

"szerintem ha az AMD -ha "szemétkedni" akarna,

akkor simán át tudná alakitani a ccx - et úgy, hogy a rendszerből

4c/16thread -nek látszódjék ami amúgy 8c/16t .."Hogy?

Mondjuk egy olyannal trükközhet, hogy 8 ép mag van a lapkán, és az, hogy ebből mi aktív és mi nem, az dinamikusan váltogatható. Így a turbózás ideje maximalizálható.Én elképzelhetőnek tartom, hogy 2 lépcsőben egyesítik a zen magokat - pont úgy, ahogy elvileg a zen is hasonlít két összeolvasztott bulldozer integer magra.

Mindig az jut eszembe, hogy valamit csinálni kell, hogy lépést tartsanak az arm évi 30%-os növekményével. A magasabb frekvencia nem tart ki örökké.Aztán persze mivel a számítási kapacitás növelésének legnagyobb gátja az, hogy egy központi memóriából kell kiemelni a számolandó adatot ws az eredményt visszaírni, ezért valamikor biztosan jön az a fajta elosztott számolás, hogy minden számolóegység saját memóriával rendelkezik.

(Jim Keller) -

Cifu

félisten

válasz

S_x96x_S

#2566

üzenetére

S_x96x_S

#2566

üzenetére

A ciki inkább az, hogy a VMWare eddig jobban megérte a Hyper-V-vel szemben a nagy magszámú procik használatánál. Most igazából mindkét "nagy" szereplő lábon lőtte magát, az M$ féle 8/16 bázisú core-alapú licensz sem igazán értelmezhető megoldás, a VMWare féle is hasonlóan nyakatekert lett.

Amíg nem lépnek tisztán core, de még inkább thread alapú elszámolásra, addig ez mindenesetre elég kellemetlen helyzet.

-

válasz

S_x96x_S

#2530

üzenetére

S_x96x_S

#2530

üzenetére

A DIY piac eléggé "mélyponton" van Intelnél..

Nem az a baj velük, hogy rosszak a cpuik (a bugokat leszámítva), hanem az árazás pocsék, de nagyon.

Ezen az nem segít, hogy amíg az AMD cpui idővel olcsóbbá válnak, az intelnek kiszámíthatatlanul akár felfelé is megindul az ára ahogy a termék "öregszik" :\ ... -

Cathulhu

addikt

válasz

S_x96x_S

#2510

üzenetére

S_x96x_S

#2510

üzenetére

Ha Q4-et nezzuk, a YoY szamok nagyon impresszivek, de ha az egesz evet, akkor viszont "csak" egy stabilan pozitiv merleg, enyhe novekedessel. Ezekszerint vagy a tavalyi Q4 volt gyenge vagy az idei eros, de a tobbi negyed osszessegeben kompenzalta (elobbi esetben a tobbi volt eros, utobbi esetben a tobbi gyenge, most ennek nem neztem utana).

Erdekes mindenesetre.Meg egy erdekesseg:

A tavaly ev vegihez kepest a keszpenzallomany ~350 millioval nott (~1.5 mrd), az adossag pedig ~750 millioval csokkent (~0.5 mrd), azaz az addosag nagy reszet egy ev alatt visszafizettek mikozben "felretenni" is tudtak, es jelenleg 3x annyi kp (vagy kp jellegu) vagyon van mint adossag. A befektetok es hitelezok egy ideje igen nyugodtak lehetnek, 3 eve meg mar kb temettek a penzuket remenykedve a csodaban

-

joysefke

veterán

válasz

S_x96x_S

#2504

üzenetére

S_x96x_S

#2504

üzenetére

Ennek az AMD számára egy olyan pozitív hozadéka lehet, hogy a Cisco a meglehetősen komoly Cisco UCS szerverkínálatába beépít AMD-s gépeket is.

https://www.cisco.com/c/en/us/products/servers-unified-computing/index.html

-

-

S_x96x_S

addikt

válasz

S_x96x_S

#2486

üzenetére

S_x96x_S

#2486

üzenetére

> AMD + Xilinx pletykak

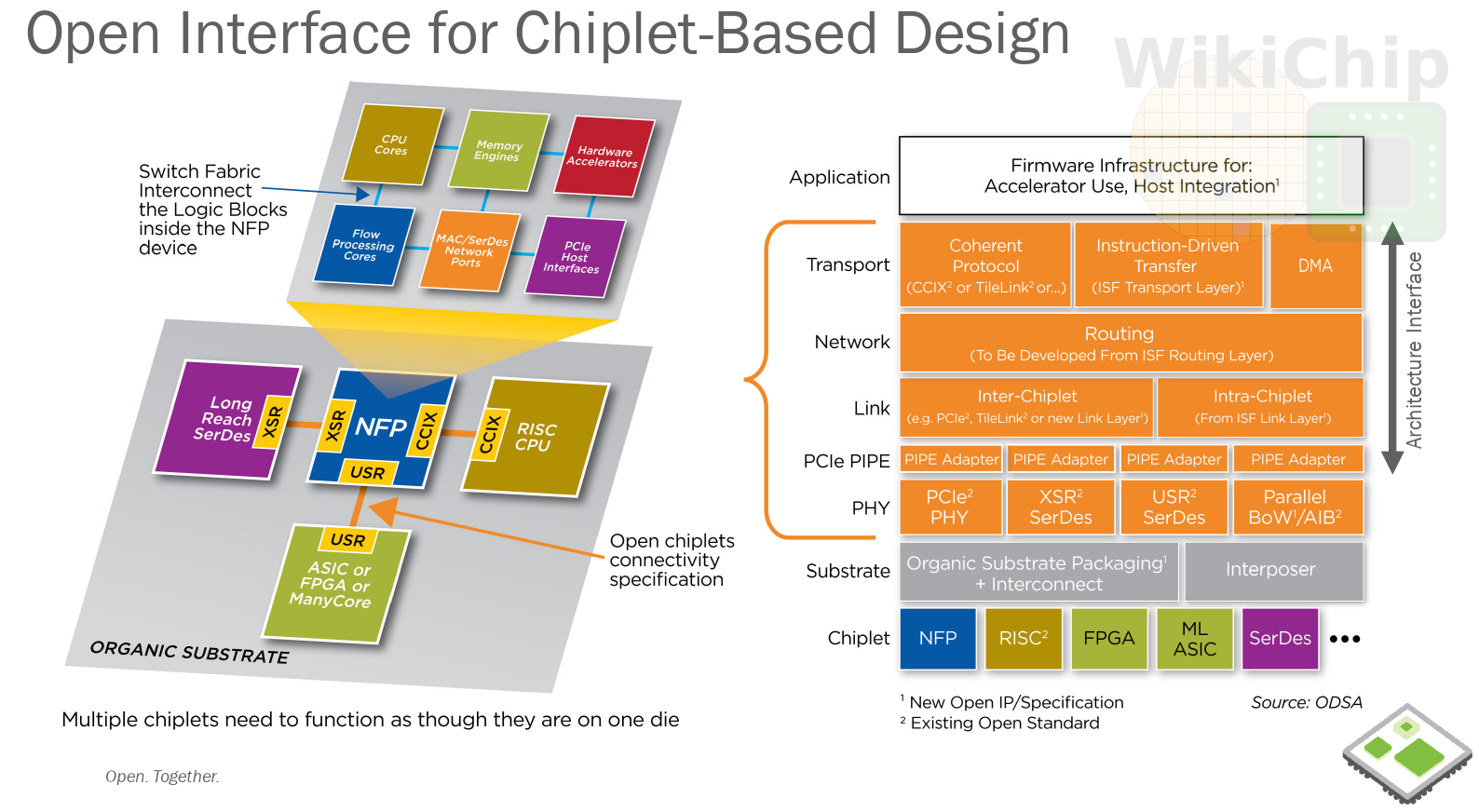

mielőtt az AMD és partnerei definiálnának valami chiplet kapcsolódási szabványt, az Intel gyorsan betolta az AIB-t a közösbe.

Az FPGA-kat biztos érinti. Ha általánosan elterjed a szabvány, akkor a Xilinx-nek is újra kell gondolnia a stratégiáját. Hogyan tud jobban növekedni ....Persze az AMD-nek is újra kell értékelnie. Tud-e egyszerre 2 chiplet-es szabványt támogatni ... vagy át kell terveznie a sajátját, hogy minél közelebb legyen az AIB-hez.

Habár ha én az AMD helyében lennék, akkor csak az I/O -die -t készíteném fel, hogy több chiplet szabványt támogasson, vagyis a Zen4-as chipletek és az AIB-s chipleteket is hozzá lehessen kapcsolni. ( egyszerre)

Valószínüleg az elején nem lesz hatékony az AMD megoldása ..Mindenesetre ez egy okos húzás az Intel részéről .. amivel átvették a kezdeményezést. Ráadásul másoknak kell hozzájuk igazodnia.

( persze az Intel-t is szorította az OCP-s nyílt szabvány ; vagyis ők is kényszerlépésben voltak. )--------------------------------

Intel joins CHIPS Alliance to promote Advanced Interface Bus (AIB) as an open standard

https://chipsalliance.org/announcement/2020/01/22/intel-joins-chips-alliance-to-promote-advanced-interface-bus-aib-as-an-open-standard/"Intel is joining CHIPS Alliance to share the Advanced Interface Bus (AIB) as an open-source, royalty-free PHY-level standard for connecting multiple semiconductor die within the same package. This effort is intended to encourage an industry environment in which silicon IP can be developed using any semiconductor process as a “chiplet,” and easily integrated with other chiplets into a single device to deliver new levels of functionality and optimization. Broader adoption and support for AIB-enabled chiplets will help device developers grow beyond the limits of traditional monolithic semiconductor manufacturing and reduce the cost of development. Working together, Intel and CHIPS Alliance will encourage the growth of an industry ecosystem which engenders more device innovation via heterogeneous integration."

-----------------

https://www.anandtech.com/show/15434/intel-joins-chips-alliance-contributes-advanced-interface-bus

-------------------------

Persze az Intel rá is volt kényszeritve erre a lépésre - mielőtt az OCP meghatározza a szabályokat ...

https://fuse.wikichip.org/news/3184/ocp-makes-a-push-for-an-open-chiplet-marketplace/

-

Cathulhu

addikt

válasz

S_x96x_S

#2486

üzenetére

S_x96x_S

#2486

üzenetére

A vicc az, hogy 5 evvel ezelott, az Altera felvasarlasa korul jottek az elso pletykak, csak akkor az AMD meg epp a beka segge alatt volt, es a Xilinxet tippeltek vevonek, csak ugye ha jol sejtem az x86 liszenszek helyzete miatt nem mukodhetett volna, ott max egyesules johetett volna letre, de ahhoz meg tul nagy volt a kulonbseg a ket vallalat erteke kozott. Most meg pont a forditottja a helyzet. Raadasul ha jol remlik, az ATI hitel is lejart mar, illetve az AMD keszpenz allomanya nagyobb mint a hitelallomanya, azaz most lehetoseg lenne ujabb nagy beruhazast inditani, ami mondjuk kb pont akkora pofon lenne mint az ATI felvasarlasa. De az is vasarlas volt es nem egyesules. Most jol megy az AMD-nek, es meg ugy erzem 5-6 ev biztos van Zen-ben, ha nagyon gyengelkedik az intel, akar meg tobb is, de utana megint uj architektura kell, es nem biztos hogy lesz akkor is egy Jim Keller. Nagyon egy labon all most az AMD, valamerre szerintem bovulniuk kellene.

#2487: azert az intel felvezeto gyartasa a vilag egyik legnagyobb, ha nem a legnagyobb ilyen jellegu vallalkozasa, nem osszemerhetoek a lehetosegeik a GloFo-eval. A versenynek meg kifejezetten jot tenne az ijesztoen ketszereplosre szukult piacra hirtelen egy harmadik belepese. Igeny lenne ra, ezt remekul mutatja, hogy mekkora a TSMC elojegyzese.

Azt meg sose fogjuk megtudni hogy mennyire volt rossz az eredeti 10nm naluk. Az intel fele monolitikus designoknak nagyon nem fekudt, de lehet egyszerubb chipeket, modemeket vagy memoriakat mar tudtak volna joval korabban is piackepesen termelni es nem vesztettek volna el a 2-3 eves elonyuket a tobbi bergyartoval szemben. Persze ez egy nagy HA, egy talalgatas reszemrol, de ami biztosan latszik, hogy mindket uzletag szenved a masikkal valo kapcsolatatol. -

Cathulhu

addikt

válasz

S_x96x_S

#2479

üzenetére

S_x96x_S

#2479

üzenetére

Ezt kb 2-3 eve pedzegetik, amikor eloszor nyilvanvalova valt, hogy a 10 nano bukta, hogy az AMD-hez hasonloan kulon kellene valni. Szvsz mindket uzletagnak elonyere valna, a gyartas szerezhetne kulsos ugyfeleket, uj tapasztalatokat, TSMC-nek lenne egy eros kihivoja, a tervezes meg nem lenne megkotve (az AMD-t azert a GloFo meg evekig kisertette ugye). Aztan az eletkepes megmarad (lehet mindketto, lehet egyikse).

Ha tenyleg igaz, hogy a Xe megy kulsoshoz, akkor az sok mindent elarul a jelenlegi allapotokrol es a valtozo szemleletmodrol.Mas: szerintetek van alapja az AMD + Xilinx pletykaknak? A pozicio most idealis, az erosodo AMD market cap-ja mar a duplaja a Xilinxenek, az meg eleg stabilan hozza a bevetelt es a nyereseget. Raadasul az intel + altera parosnak igy lenne egy eros konkurenciaja.

-

válasz

S_x96x_S

#2479

üzenetére

S_x96x_S

#2479

üzenetére

Szerintem ez függ erősen a 7nm-ük sikerétől és attól, hogy "csúszik-e" ...

Ha a 7nm-ük is olyan szenvedős mint ami a 10nm volt... Akkor az az érzésem hallunk még erről a témáról (nem is olyan soká)..

Még közel 2 év van a 7nm-en tervezett sorozatgyártás beindulásáig. De lassan valami Tape-outnak kellene ott történni pár egyszerűbb chippel (mondjuk tipikusan memóriachipekkel), mert pont a legbonyolultabb gigantikus szerver chipekkel akarnak rajta kezdeni.

Ez utóbbi mondjuk 2 dolgot vetít előre:

1. kétségbeesetten akarnak javítani a szerveren chipeken,

2. magabiztosak a technológiát illetően, vagy ellenkezőleg "nincs más esély" módon pusholják emiatt fejlesztőket a siker érdekében (esetleg idióták... de csak nem utóbbi). -

joysefke

veterán

válasz

S_x96x_S

#2477

üzenetére

S_x96x_S

#2477

üzenetére

vagy csak paper launch lesz ... vagy csak limitált launch lesz ...

Ilyet 2019-ben láttunk már párat az inteltől, az AMD is megcsinálhatja, de attól a paper launch még nem lesz igazi launch...

Egy kiállításon nagyot ígérni 3/4-1 évvel előre sokkal könnyebb, mint azt ténylegesen megvalósítani, de ettől még remélem, hogy neked lesz igazad, és év vége előtt ténylegesen elérhető lesz a ZEN3. Asztalon is.

Kéne egy felmérést csinálni, hogy aszimmetrikus-s az intel és AMD között migráló munkavállalók miatti tudás transzfer...

-

válasz

S_x96x_S

#2470

üzenetére

S_x96x_S

#2470

üzenetére

intel kapacitása akkor fog helyreállni ha a szervereknél áttérnek 10nm-re (és azt terhelik onnantól), vagy hírtelen nem rendelnek annyi szerver chippet.. piszok nagy a szerverchipek DIE-ja (694 mm², de a 18 magos is 485 mm², a 10 magos 325.44 mm²), pluszban emiatt a kihozatala is alacsonyabb mint a normál chipeknek, pontos számokat nem tudni de egy-egy 28magos szerver dieból a tippek szerint akár 10db asztali 8magos chip is kijöhet (174 mm²)...

Addig ott szerintem nem oldódik meg a kapacitásgond amíg nem indul be a 10nm szerverchip gyártás valamikor jövőre... jó esetben (mert hosszú ideje halljuk ezt a "jövőre jön" szöveget.. de talán már lesz belőle valami). -

joysefke

veterán

válasz

S_x96x_S

#2470

üzenetére

S_x96x_S

#2470

üzenetére

Szvsz a legvalószínűbb forgatókönyv, hogy nem jön ki a ZEN3 2021Q1 előtt (erről volt is valami pletyka) és az intel ellátási problémái folyamatosak maradnak egész 2020-ban, ez utóbbit a napokban szerver és notebook gyártó partnerek vezetői is hangoztatták.

Lehet hogy lesz árcsökkentés-kategória eltolás, de én nem hiszem, hogy hirtelen nagy árverseny alakulna ki intel kezdeményezéssel.

-

#82819712

törölt tag

válasz

S_x96x_S

#2465

üzenetére

S_x96x_S

#2465

üzenetére

Ez jobb mert egymás mellett mutatja jobban meg lehet érteni a 3700U Vs 4700U -t

-

válasz

S_x96x_S

#2463

üzenetére

S_x96x_S

#2463

üzenetére

lehet tényleg történik majd valami most már ... mert ez nem rossz.. bár még csak "kicsi APU", és nekem minimum kéne a nagyobbik változat a régi sorozatból ... de ez akkor se rossz...

mondjuk kicsit zavaró a hátlapon az USB színezése, mert a 2db kék és a mellette levő fekete USB-k csak 2.0ák, egyedül a DP és a HDMI közötti USB 3.1 ... illetve az előlapiak is 3.1esek.. de a színeket kicsit megkavarták hátul :\ ...

-

válasz

S_x96x_S

#2455

üzenetére

S_x96x_S

#2455

üzenetére

Washington pressures TSMC to make chips in US (nikkei.com)

https://news.ycombinator.com/item?id=22068544 -

Petykemano

veterán

válasz

S_x96x_S

#2456

üzenetére

S_x96x_S

#2456

üzenetére

Coreteks az utolsó "broken silicone" interjúban azt mondta, hogy

1. Az AMD eredetileg nagyon agresszív tervekkel rendelkezett a zen3-ra nézve.

2. De az utolsó kezébe jutó roadmapek azért szerényebb előrelépésről tanúskodnak, olyan, mintha sok cumót hátra soroltak volna későbbi releasebe.

3. Ugyanakkor az AMD kommunikációja továbbra is mintha a nagy előrelépsre íródna: pushing the envelope.(Tehát hogy a mai zen3 terv nem ugyanaz, mint, aminek 2-3 éve tűnhetett )

Igazából egy szemszögből nem meglepő, hogy lassítanak, hiszen ha alig tudják kiszolgálni az igényeket, akkor lazíthatnak, amíg az Intel előáll valami ütőképessel.

Másrészről meg azért az armos megoldások az intel bénultságától függetlenül jönnek fel, mint a talajvíz. Nincs idő lazítani, mert akkor intelestül amdstül dobják az x86-ot.Coreteks dátumot ugyan nem említett, de azt mondta, nem tartja elképzelhetetlennek, hogy nyomnak egy refresht a zen2-n egy új 7nm-es nodeon.

De az se kizárt szerintem, hogy nem egy zen3 design létezik, vagy inkább úgy mondom, hogy zen3 ipre építő design. Ugye a frontier is zen3 ip. De az semicustom: Megmagyarázná pl az smt4 pletykákat.

Mindenesetre ha a zen3 tényleg oly későn jön (2021Q1-Q2), akkor egy zen2 refresh belefér.

Új hozzászólás Aktív témák

Hirdetés

- Rengeteg pénzt kapott az USA-tól az Intel, de Trump kért cserébe valamit

- Battlefield 6

- Samsung Galaxy Z Fold7 - ezt vártuk, de…

- Melyik tápegységet vegyem?

- D1Rect: Nagy "hülyétkapokazapróktól" topik

- VR topik (Oculus Rift, stb.)

- Linux kezdőknek

- Sugárkövetés nélküli sugárkövetés felé menetel az új PlayStation

- Kerékpárosok, bringások ide!

- Gitáros topic

- További aktív témák...

- GYÖNYÖRŰ iPhone 15 Plus 128GB Black -1 ÉV GARANCIA - Kártyafüggetlen, MS3355, 100% Akkumulátor

- KONZOLOK FELVÁSÁRLÁSA - AZONNAL - AKÁR ORSZÁGOSAN +36307343036

- GYÖNYÖRŰ iPhone 15 Plus 128GB Pink -1 ÉV GARANCIA - Kártyafüggetlen, MS3354

- Sony a6700 + Sigma 30mm 1.4 DC DN - új fotoplus vásárlás

- GYÖNYÖRŰ iPhone 15 Plus 128GB Pink -1 ÉV GARANCIA - Kártyafüggetlen, MS3353

- HIBÁTLAN iPhone 14 128GB Red -1 ÉV GARANCIA - Kártyafüggetlen, MS3159

- GYÖNYÖRŰ iPhone 13 128GB Green -1 ÉV GARANCIA - Kártyafüggetlen, MS3036

- Lenovo IdeaPad 3 17ITL6 - 17.3" HD+ Intel 6305 - 8GB - 256GB SSD - Win11 - MAGYAR

- Lenovo ThinkPad dokkolók: USB-C 40A9/ 40AY/ 40AS/ Thunderbolt 3 40AC/ Hybrid USB-C DisplayLink 40AF

- GYÖNYÖRŰ iPhone 14 Pro 256GB Deep Purple -1 ÉV GARANCIA - Kártyafüggetlen, MS3352

Állásajánlatok

Cég: CAMERA-PRO Hungary Kft.

Város: Budapest

Cég: FOTC

Város: Budapest