-

PROHARDVER!

A legtöbb kérdésre (igen, talán arra is amit éppen feltenni készülsz) már jó eséllyel megtalálható a válasz valahol a topikban. Mielőtt írnál, lapozz vagy tekerj kicsit visszább, és/vagy használd bátran a keresőt a kérdésed kulcsszavaival!

Új hozzászólás Aktív témák

-

T.Peter

őstag

Szerintem fogjak hasznalni, max implementalnak egy fallback modot, hogy tudjak futtatni a jelenlegi shader-ekkel is. Persze ettol meg plusz munka, de ez van. A konzolokon biztosan fogjak hasznalni es mivel lesz multiplatform cim, max bukjak a mesh shader elonyeit, mint pl a culling. Megoldjak erobol.

Mar csak azert is, mert ugyanilyen hozzaallassal akkor a level design sem fog valtozni, amig a hdd ki nem kopik.

Merem remelni, hogy az Unreal Engine-be mar gozerovel irjak a mesh shader implementaciot. -

-

a különbség hogy te az API-t az AMD szempontjából mutattad be, miközben ők még PC-n hardveresen nem képesek a legtöbb újítást támogatni a most kint lévő generációval. legközelebb majd 2020 év végén láthatunk tőlük olyan hardvert ami ezekre képes lesz, miközben nvidia a Turinng-gal addigra 3 éve a piacon lesz és éppen a második generációs fejlesztéseit hozza be.

Amire mindenki utal pl a fenti PC world cikkben is,hogy úgy néz ki az nvidia már 2017 ben előre látta ezeket a változásokat amik jönni fognak és lefektették az alapjait annak ami most képes megváltoztatni a fejlődési irányt és ehhez nekünk felhasználóknak már hardvert adtak és mind hardveresen mind driveresen felkészültek rá... Erre úgy mutatsz be egy Microsoft API-t hogy az AMD mit és hogyan ügyködik benne milyen jó hogy driveresen fordítgatják a kódokat ...persze hogy fordítgatják, hisz nincs hardverük., persze hogy fontos nekik a legacy kód, hisz mindenük ez alapján működik PC-n..Nvidiának is valószínűleg fontos lesz.

Még arra sem lehet hivatkozni amit Cifu írt, hogy nincs infód, mert a fenti fejlesztői modellek és információk évek óta elérhetőek Nvidiánál. egyszerűen nagyon jó lett volna ha rávilágítasz a két gyártó és a PC piac mostani helyzetére, mert a legtöbb szakújságíró világosan látja, hogy mi történik manapság és hogy Nvidia nem hagyta elúszni a konzolokkal a PC-s játékipart és annak a fejlődését, sőt éppen megfordította és a konzolok fejlődnek arra amerre a zöldek szeretnék..

Arról már ne is beszéljünk, hogy nagyon úgy néz ki a Turing nagyon is időtálló fejlesztés lesz azzal szemben amiről szó volt . ami elavulttá teheti az a következő generációs Nvida kártya család... -

igen csak ebben az a gond, hogy az új Konzolos portokat az RDNA 2 re és a Turing / Ampere gpu ra fogják lefordítani a legegyszerűbben és ebből adódoan a sebesség is ezen lesz valószínűleg majd a legjobb. Microsoft már ősszel hozza ki az első multiplatform címeket.

Innentől kezdve a navi 5700 kizárólag driveres fordítóban bízhat ezekben a címekben míg a Turing azon kívül, hogy driveresen támogatni fogja, hardveresen is képes lesz gyorsítani, azokat a címeket amik mesh shadingot alkalmaznak... -

Amúgy beleolvastam a cikkedbe kiakadtam szokás szerint a mes shadingon ahogy behoztad. Miért vagy ennyire elfogult az AMD irányába? nagyon jól tudod hogy AMD kénytelen driveresen megoldani a mesh shadingot miért kellene a többi gyártónak erre ráfeküdnie mikor Nvidia képes megoldani ezt hardveresen lényegesen gyorsabban?Illyetve Nvidia támogatni fogja driveresen is API szinten,de Ilyenkor talán nem AMD-t kellene fényezni hanem leírni, hogy az Nvdia 2 éves architektúrája képes megoldani már ezt a dolgot hardverből...VRS szintén Nvidia hozta be. ezzel szemben írsz egy cikket ahol nem azt emeled ki hogy az Nvidia Turinggal mennyire előrelátóan alkalmazta a technológiákat és hogy alakította ki a hardvert ehhez már lassan 3 éve hanem azt írod hogy jó lenne ha a többi gyártó is driveresn fordítgatná kódot ahogy AMD teszi mert neki nincs ehhez hardvere még... ne viccelj már ez már kicsit (nagyon )sok. Totálisan az látszik, hoyg a zöldek lefektettek egy irányt amit most követ a piac, mind a konzol mind a PC....Kiderült hogy nem hogy elavulnak az RTX kártyák, hanem most fog előjönni az előnyük az új API ban, az történt amiről mindig regélnek a másik oldalon hogy az nvidia korán elavul az AMD meg gyorsul. Hát most vissza nyalt a fagyi....

Itt akik most utat törtek és megvalósítottak valamit amit amúgy valamikor megálmodott az AMD a Mantlevel azok nem az AMD asztalán ülnek. -

Valószínűleg tisztában vannak a konzol működésével, ha az ő RT kódjukat futtatva demózták a játékot.

Örülök neki,de remélem nem kell további 7 évet várni a következő előrelépésig a PS6 ig..remélem nem erre [link] gondolsz, mert ez kifejezetten Béna lett , (na jó nem annyira.

)

) -

lenox

veterán

Itt nem a pixelekből lövöd ki a sugarakat, hanem egy kamera mögötti pontból.

Ez egy szemleltetes. Az a lenyeg, hogy nem parhuzamosok azok. Mikor lattal utoljara olyan 3d-t, ahol a targyak merete a tavolsagtol fuggetlen volt? Akkor lenne parhuzamos ugyanis.

#26309:

Sajnálom magam és Ben Archardot is a Metro Exodus grafikus fejlesztőjét, hogy nem érti a sugárkövetést

O valoszinuleg erti, de attol, hogy magaddal egy mondatba teszed, ettol ez meg rad nem vonatkozik. Persze amugy szerintem alapvetoen erted te is, de ettol ez a parhuzamossag meg elemi hiba.

Tehát ha ő beszél a véletlenszerű adatelérés problémájáról, akkor az jó, ha én, akkor az nem.

Ha csak elismetelned, amit mas mond, azzal nem lenne baj, de sokszor koltesz hozza, pl. ezt a parhuzamossagot, azzal meg szokott gond lenni. -

Jack@l

veterán

Akkor egyszerűsítem a kérdést egy booleanra: A fényforrás(ok)ból, vagy a kamera nézőpontjából indul az elsődleges sugár?

A kettő közül melyik esetben párhuzamosak a sugarak?

Mi történik ha két frame között megmozdul a kamera, vagy valamelyik test? (tudom, ritka dolog ez játékoknál, de mégis)

Alu mióta végez float műveleteket? -

Jack@l

veterán

Hülye kérdések:

Mit értessz primary ray alatt, honnan hova megy a sugár?

Tegyük fel igaz amit mondassz és cacheli az első kört, mekkora cache-re van szüksé hozzá?

Ha nagyságrendileg nagyobb mint ami cache van a magokhoz, akkor nem pont a memóriából cachelés miatt jobb a hbm? Mert a számításhoz biztosan nem memória kell, hanem elspdlegesen számítási teljesítmény.

UI: ha válaszolsz ne valami rizsát nyomj lécci, hanem konkrét válaszokat -

és ezt az AMD/ Bethesda adta ki neked,Abunak a PH -n hogy milyen szerződésük van ami él jelenleg is egy gyártóval?és milyen feltételek vannak benne Nvidiára vonatkozóan?

nekem egyszerű itthoni trafikokra vonatkozó szerződéseim vannak,de ilyen infó kiadása miatt az összes trafikosom ott állna a bíróságon. Ne haragudj, de nehezen hiszem el ezt a sztorit.Bethesda az Nvidia VK ray-t hazsnálta fel,.. itt nyilatkozták [link] : EZt az Nvidia írta. [link]

Az adaptive shading szintén Nvidia kód. nem ők írták ,Nvidia írta. -

-

szerintem ezek a dolgok mind le vannak már zsírozva,hisz egy gyártópartnertől jött az infó, akiket már felkészítenek ilyenkor arra mire hogy készüljenek, gondolom üzleti tervvel is előállnak. Ezek a dolgok csak kész termékkel és megbeszélt gyártással működnek. Nvidia nem kapkodásra hajlamos cég elég jól terveznek évek óta... Már azt sem tartom kizártnak hogy ők év végén a Hopper-t fogják bemutatni a professzionális szegmensben...

-

És ha ezen dolgok esetében esetleg az Nvidia mégis hatalmasat lép előre az Amperevel a sok tapasztalattal rendelkező AMD vel szemben? Olyan dolgokról nyilatkozol, amiket látjuk, mérjük tapasztaljuk hogy működnek. Szenzációsan jó lett a Navi a Turinghoz képest hisz van 7nm tapasztalat.. ja nem....

Szerintem bizonyos GPU kat TSMC nél fog gyártatni bizonyos méretű GPU kat pedig a Samsungnál.( mint a pascal esetében)

Azt sem tartom, kizártnak, hogy az Ampere csak bizonyos szegmensekbe érkezik meg, azaz a kiforrott gyártású Turingot tovább nyomatja kisebb csíkszélen( vagy változatlanul ,de olcsóbban) a Samsungnál ( mondjuk 8nm) az Ampere pedig felső kategóriában a TSMC nél... -

De ami a legfontosabb hogy a fenti dolgok mind megérték a TSMC nek és az Nvidának a "bukásra ítélt" Turing esetében is. Nem de?

valós haszna pedig nem az 4-6 % optimalizáción van hanem hogy VAN gyártókapacitás és elérhető termék a piacon időben.

valamint az AMD is és az összes fő partner már 7 nm EUV gyártat ebben az évben nvidiának ilyen fogyasztási értékekkel simán jó lehet a 7nm non EUV consumer piacra. -

Már a HBM-mel kiépíthető egységnyi sávszél olcsóbb

Hát persze, a HBM már régóta olcsóbb, elméletben. Leginkább a Te elméleteidben. A gyakorlati kivetülését meg továbbra is várjuk. Az 1650S-re miért nem abból megy 1 stack? Vagy a 2080S-re 2? Stb.

A RT-kérdéshez - én most nem jósolgatnék, hogy az NVIDIA miben gondolkodik. Nem tudom, hogy a jóindulattal is lagymatag fogadtatás ellenére is hisznek még benne, vagy a folytatásban csak buzzword lesz. Leginkább ezen múlik, milyen irányt követnek.

-

meg van valami ,hogy a samsung most csinált valami HBM 2 ramot extra gyorsat ha jól olvastam .

lehetséges, hogyegyfajta csábító tényező lesz, hogy náluk nyomassák a zöldek a kártyákat.

Én örülnék a HBM ramnak, csak Nvidát ismerve elég nehezen tudom elképzelni, hogy ezt az egybetokozást jól veszik, mert eladják az összes GPU selejtet szinte alsó TIER szintű kártyának. vagy a GPU még az egybetokozás előtt kiesik ami hibás? Akkor is sérülhet amikor egybetokozzák? -

Az azért megvan , hogy a tesztben szereplő 2070 Super mennyi tranzisztort tartalmaz( 13,6 milliárd miközben az 5700 Xt 10,6 milliárdot) és remélem az is megvan hogy az OC hatására alig nőt az általad említett IPC vagy végrehatjtási műveletek száma vagy mindegy hogy hívjuk, , sőt volt olyan teszt, ahol csökkent a kapott eredmény , azaz hiába képes több műveletre egy ciklus alatt, ez jelenleg sehol nem köszön vissza miközben fogyasztás 50 % ra megnőtt.

Azt látni, hogy a Navi megint ki van hegyezve csúcsra mint ahogy eddig a Vega és az Rx kártyák is kivoltak, miközben Nvidia belövi az optimális tartomány közepébe a kártyát és azzal hozza az eredményeket ami Uv és OC hatására is kb ugyan annyit, 40 wattot változik fel és le.

Igen az leírtad mi az IPC de ettől függetlenül nem látszik semmiféle hatása sehol ennek. A gyakorlati teszt számít amit belinkeltem.

ja és IQ ide vagy oda, ha nem tudsz esetleg németül ajánlom a Google fordítót és olvasd el mit ír Wolfgang Andermahr akit megint megkérdőjelezhetsz ha akarsz,de a világ egyik legjobb ilyen jellegű tesztelője és cikkírója.

példa értékű ez a pártatlanság a részedről amivel egyet tudsz érteni bárkivel aki esetleg nem lát csodát a naviban vagy az AMD ben.![;]](//cdn.rios.hu/dl/s/v1.gif)

-

Petykemano

veterán

"egy munkaelemre levetített magasabb IPC sokkal több tranzisztort igényel."

De mi/hol a haszon, amit már ma tapaszhatunk, és nem csak 1-2 generáció múlva?Vagy fordítsuk meg: az nvidia hol fizeti meg a számlát?

(Azt is mondhatod például, hogy az nvidia azért tud olyan hardvert szállítani, ami specifikus programozást igényel, mert ezt el is tudja hozzá intézni, ellentétben az AMD hiába próbálna olyan egyszerűbb felépítésű hardvert készíteni, ami sokkal hatékonyabb, ha ráprogramoznak, mivel nem tudja elintézni, hogy ráprogramozzák és ezért egy általánosabb képességű hardvert szállítani, ami bármit lekezel, de ennek tranzisztor és energiaköltsége is van.)

-

Egon

nagyúr

Nem tudom, hogy mi köze van a GeForce Now-nak a Stadia-hoz, azt meg pláne nem tudom, hogy miképp jön az nV-s topicba a Stadia. Egy adott szolgáltatásról alkottam véleményt (méghozzá nem első kézből, hanem a videóban látottak alapján), és ez a GeForce Now, nem más.

Haggyállógva légyszi, b.-nek címeztem, hogy ez így nekem szubjektíve használhatatlan, részemről itt pontot is tennék a történet végére.

De ha már trollkodunk, mit látnak szemeim: [link] Ezt az apróságot mintha annyira nem reklámoztad volna (vagy csak én nem emlékszem rá)...![;]](//cdn.rios.hu/dl/s/v1.gif)

-

Azért rakta oda az XT-t mert mint már sokadszor írom le, írta , hogy köti az NDA,de a WCC által közölt cikkre hivatkozva mint forrásra azt elemezte ki. ha a WCC azt írta volna, hogy 5900 lehet nem hozta volna le,de mivel Igorrol van szó, aki nem egy idióta, hanem egy brutál jó hírnevű újságíró és tesztelő, ezért azon az XT-n nem fog aggódni, mint leak infó, mert erről szólnak az ilyen topikok is mint ez itt, amiben éppen beszélgetünk..

-

Most akkor ez volt az a fals infó ami semmiképp sem stimmel, hogy odatett egy XT-t ? ezen voltál kiakadva hogy semmi nem stimmel abból amit leírt? mert én konkrétan azt látom, hogy leírta, hogy egy 5500 ( xt) nevű kártya jön meg majd egy 5600 ( XT) is.

A teljesítményről meg ködös utalásokon kívül egyenlőre semmi nincs.

Ami külön aggasztó, hogy igazam lett, és valóban megvárjátok a GTX Turing tesztekkel a 6-8 hónappal később kijövő radeon kártyákat, hogy azokat tudjátok mellé tenni, ami számomra eldöntötté tette a kérdést amit már régóta tud és sejt egy pár ember, hogy mennyire elfogult az egész rendszer ahogy csináljátok/ csinálod és ezzel tönkre teszitek mind az oldalt még maradt az egykori színvonalából és minőségéből.Ezzel pedig a saját olvasóitokat tiporjátok le akik évek óta hűségessel az oldalhoz,de már inkább csaka fórumhoz, meg persze az a párt fanatik akit sikerült kinevelni agymosással. -

Ez teljesen mindegy abból a szempontból. hogy milyen neveket használ, az a lényeg hogy szerinte jön két kártya amik szerinte ilyen teljesítményűek lesznek.

Ebben nagyjából egyetérthetünk, hogy akkor szerinted is jön két kártya csak más néven. ami a cikkben a lényeg az a teljesítményük,a mire viszont nem reagáltál, hogy az valós e a vagy fals e. ha szerinted nem tud semm és azért dobálózik kamu nevekkel akkor az eredményeknek is rosszaknak kell lennie amiket közölt becsülve.... -

gyakorlatilag ha elolvastad volna a cikket az első bekezdésben leírja a választa felvetésedre.

"Of course, I can’t leak anything that manufacturer A or N may have given me in terms of information. The so-called NDAs help against this. Whereby this is not seen so narrowly in Asia rather."

Mivel megjelöl forrásként oldalakat a cikkéhez, (WCC/ egy ázsiai site ) ezért azokat az elnevezéseket használja, mert ezzel nem szegi meg az NDA-t az eredményekre meg természetesen azt írja, hogy becsült, de ugye elég neves oldalról van szó ezért elég jó eséllyel vehető, hogy hasonló lesz a felállás, mert már képben van. Nem tudom miből gondolod, hogy te több infóval rendelkezel mint az igorslab,vagy fordítva, hogy egy ilyen menő site mint ő ( k) nem kap legalább annyi infót mint te a PH ról...

Toms'hardver újságírója . -

Nagyon jó. Tehát a kettő messze nem ugyanaz, jelen esetben pl. időzítés szempontból sem. Haladunk

Akkor már csak azt kell megugrani, hogy ha a WTFTech lehozza, hogy az AMD megjelenteti az 5500-at, az 5600-at, az 5800-at és az 5999-et, akkor onnantól kezdve senki nem vonható felelősségre ezen típusnevek használatáért.

Akkor már csak azt kell megugrani, hogy ha a WTFTech lehozza, hogy az AMD megjelenteti az 5500-at, az 5600-at, az 5800-at és az 5999-et, akkor onnantól kezdve senki nem vonható felelősségre ezen típusnevek használatáért. -

-

lenox

veterán

Annyi a gond, hogy a ket kartyan (2070 vs 2080) ugyanaz a savszelesseg, 2070-en kisebb az fps, tehat ott a sugarkovetes se hasznal annyi savszelt, tehat nem a savszel a limit a 2070-en. Kiprobaltam a kedvedert a sajat gepemen (rtx 6000), 100 gpu load es 60% mem load van, nem savszel a limit.

-

X2N

őstag

Otthon viszont nem probléma a memória. Én nem fogok milliárd geometriából álló víz/füst/tűz/robbanás effekteket csatajeleneteket stb szimulálni és renderelni. Azt be kell lássa mindenki hogy aki mozgóképet akar renderelni és komolyabb VFX-et renderel arra még a 4 kártyás rendszer is édes kevés. Állóképre a 4 kártya már közel realtime tud raytracinget. A másik dolog meg az hogy ezt a rengeteg effekt nagy részét nem lehet gpu-n szimulálni, így is kell hozzá erős processzor ami leszámolja. Én együtt tudok azzal élni hogy véges a memória a vga-ban, az új gépemben most 32GB ram van, ha esetleg a GPU 8GB-ja kevés lenne akkor majd leszámolja a cpu 10x lassabban, egye fene. Ezeket én rendereltem: LINK A képek 95%-át egy 980Ti-1 óra alatt bővel lerendereli 2K+ felbontásban. Processzorral ezeket 8+óra alatt lehetne lerenderelni. Ami nevetséges a GPU-hoz képest, ráadásul a GPU-val a viewportban is látom a közel végleges képet csak zajosan ami alapján tudok utánaállítani a fényeken. CPU-val erre nincs lehetőség, ott le kellene renderelni az egész képet majd utána állítani.

-

X2N

őstag

Ez is csak programozás kérdése, az octane tudja az out of core geometry-t. Majd a többiek is felzárkóznak. Egy játékban nincs olyan komplex scene mint egy professzionális renderben, nem kell annyira sok memória mint ahogy azt gondolod. Egy mostani Quadro meg röhögve lerenderel bármit. Az már user error ha neked nem elég 96GB Vram se.

-

A hivatalos források magnak hívják és szamszerusitik. 30/36/40/46/48 az RTX kártyákban ráadásul itt azonos felepitesű GPU kat merünk össze azonos multiprocesszor felepitessel.

A lényege a hozzászólásnak ezen egysegek számának az egymáshoz viszonyulása RT használata alatt ahol szamszerusitve kijon, hogy kevesebb RT maggal/mindegy hogy hivjuk/ ugyan az a GPU (RTX 2080 VS RTX 2070 Super) kisebb teljesitmenyre képes aktív RT alatt.

Ezert nem értem miért írod, hogy az RT magok számának nincs köze a teljesítményhez. Ha a memóriával korlátozva lenne ez a dolog, akkor hasonló eredmények lennének mint CPU limites VGA teszteknel.

Meg a tesztprogramokban is kijon az eltérés, legyen az Microsoft vagy bármi. -

ne haragudj meg Abu,de ezek megint azok a dolgok, hogy csak te voltál jelen 9 másik újságíróval az AMD-s konferencián, ezt is csak te kaptad meg vízjelezett PDF ben a Microsofttól ( ettől függetlenül adatokat amiket lenox kér, pl a hitrátióról) bemásolhatnál ide hozzászólásban.

Itt jönnek azok a gondok amikor azt gondolom ezen bizonyítékok hiányában, hogy smafu ebben sok minden amit mondasz és az egészet beállítod tényként, miközben pusztán ez a te véleményed a saját rálátásod szerint. Még jobban azt gondolom, hogy semmit nem látsz bele abba, milyne fejlesztést fog eszközölni Nvidia a következő generációs kártyákon az RT szintemelésére.

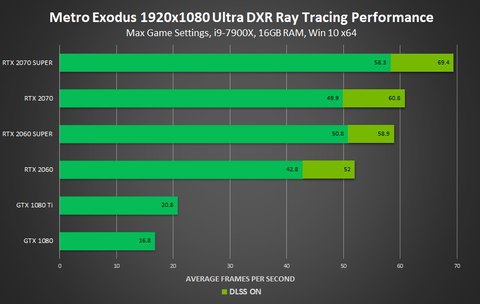

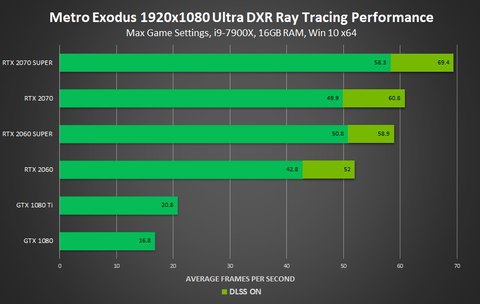

Egyre jobban csalódás minden ami itt zajlik a PH-n.A sávszél biztos probléma egy bizonyos szint fölött ,de jelenleg az van hogy a 2070 és a 2060 Super között 3 % különbség van kb RT magok számában ( a 2070 ben 36 RT mag van a Super 2060 ban 34 ) és pont ez jön ki az RT eredményekben is azonos GPU val. csak úgy mint a 2070 super ( 40 darab RT core ) és a 2080 között ahol (46 darab RT core )van.15 % kb a kölünbség a 2 kártya között bekapcsolt RT alatt, azonos GPU val ebből világosan lejön , hogy az RT gyorsítók száma hatással van az RT On teljesítményre és nem feltétlenül a memória a szűk keresztmetszet.

-

X2N

őstag

Az EEVEE biztos hogy kompromisszum, azt kell csak megérteni hogy a RT nem csak magáért az árnyékokért, a fényekért és a tükröződésekért van. Mondok egy példát talán így érthetőbb lesz. Ha van egy 3d karaktered, és megvilágítod 1-2 spotlámpával szemből akkor látod a bőrön a részleteket, amit a normal map bump map ad. Ha én csak annyit csinálok hogy kicsit megnövelem a fényforrás méretét a bőrön a mikro részletek máris tompábbak simábbak lesznek ahogy a való életben is. RT-vel minden felület "reagál" a fényekre. Egy raszterizált megoldás szerintem ezt nem fogja leszimulálni mert kvázi "1 mintavételes", miközben RT-vel rengeteg sugarat szimulálunk 1 felületre valós időben folyamatosan. Itt nincs olyan hogy befejezte a frame-t a gpu mert folyamatosan változik minden.

-

X2N

őstag

AZ EEVEE az egy vicc bocs. Elég csak megnézni egy tükröződést pl egy üvegpoháron, köze sem lesz a valósághoz nem számol anyagon áthaladó sugarakkal ha EEVEE-vel rendereled. AZ EEVEE-nem használ sugárkövetést és ez látszik is. Persze látványos amikor realtime látod az eyecandy csúcs grafikát, de ennyi. Valakinek ez már tökéletes nincs ezzel semmi gond. De nem egy Octane vagy Redshift, minőség. Jelenleg ezek a leggyorsabbak. Ez a maximum amit meglehet csinálni most. Emberi bőrt, szemet talán a legnehezebb jól renderelni.

-

X2N

őstag

Igen ezt kellene jobban kihangsúlyozni. Ugyanis nagyon nem mindegy hogy van beparaméterezve a sugárkövetés. Lehet rengeteg dolgot állítani sugarak számát, a távolságot, a sugarak ütközését meddig számolja, caustic-ot szimuláljon-e esetleg dispersion-t, a színspektrumot szimulálja-e stb. Ezekben a játékokban kvázi interaktív módban működik csak a sugárkövetés nem photoreal módban. Megkockáztatom photoreal sugárkövetés caustic-al és egyéb effektekkel nem lesznek játékokban még sok sok évig.

-

X2N

őstag

Lehet hogy jobb a Blender viewportban, de a DAZ-ban ott van az Iray ami sokkal jobb mint a Blender Cycles. Persze van Blender alá radeon prorender, Lux de azokkal sokkal körülményesebb dolgozni.... Itt Iray-nél ha jól tudom nincs a sugarak száma lekorlátozva, végtelenségig számolja. A sugarakat 10 eltérítésig legalább visszaköveti. 4 kártya már elég gyors már már realtime a jelenlegi modellekkel. Itt sokkal részletesebb modellek vannak mint egy játékban....

-

lenox

veterán

Mondjuk korabban azt irtad, hogy demoprogramokban lehet, hogy igaz, gyakorlatban nem, de akkor neked ezek szerint a peldaprogramok a gyakorlat.

Nem tudom, ami quake 2 benchmarkot nezem 2070 vs 2080 eseten ha igazad lenne, akkor egyforma teljesitmenyuk lenne, de nekem ugy tunt, hogy inkabb szepen skalazodik. Ez mondjuk a te fenti allitasodat, miszerint 'mindig a memória lesz a szűk keresztmetszet' cafolja. Persze nem jelenti azt, hogy sosem lehet a memoria a szuk keresztmetszet, de a 2070 vs 2080 ertekek jok kiindulasnak mas programokban is. Persze gondolom, hogy falra hanyt borso. -

lenox

veterán

Olvasd végig.

Mit? Szivesen olvasnek/neznek errol infot, ha lenne valahol, hogy melyik jatekban hogy alakul, de nem latom, hogy ilyet hivatkoznal.A jelenlegi kialakítással nincs messze a nullától a legtöbb effektnél. Hardveres koherenciamotor nélkül egyszerűen nincs lehetőség a sugarakat megfelelően csoportosítani.

Tehat akkor pl. Battlefield V, Quake 2 stb. mindnel 0?Én a Microsoft adatai alapján írom, amit írok.

Akkor vegre egy linket dobhatnal.

-

X2N

őstag

Az a baj hogy itt ezt csak te állítod senki más. Nincs forrás sem.

Szerintem meg nem kell nagyob memória sávszélesség. Én most vettem egy RTX2060 Super-t és gyorsabban renderel mint a régi 980Ti, pedig a 980Ti-több cuda core-t tartalmaz. Sokat számítanak azok az RT magok(hívjátok aminek akarjátok). Ha pedig beletennék még egy 2060S-t 2x gyorsab lenne. Hiába nincs összekötve a memória nvlink-el. Iray render és UE4 RT. Egyszerűen számításigényes a RT, 4 kártyával már lehet közel realtime renderelni, kevesebbel nem, akkor kompromisszumos lesz. Az hogy milyen geometriai részletesség van egy mostani játékban lényegtelen. Nálam most a Daz Studioban egy komolyabb haj 12millió négyszögből áll. Már a viewportban akad a kép. Ezt vajon egy gyengébb kártya RT magok nélkül szerinted meddig számolná? Mondjuk ez még csak a beta változat ami már kihasználja az rtx kártyákat.

Szerintem meg nem kell nagyob memória sávszélesség. Én most vettem egy RTX2060 Super-t és gyorsabban renderel mint a régi 980Ti, pedig a 980Ti-több cuda core-t tartalmaz. Sokat számítanak azok az RT magok(hívjátok aminek akarjátok). Ha pedig beletennék még egy 2060S-t 2x gyorsab lenne. Hiába nincs összekötve a memória nvlink-el. Iray render és UE4 RT. Egyszerűen számításigényes a RT, 4 kártyával már lehet közel realtime renderelni, kevesebbel nem, akkor kompromisszumos lesz. Az hogy milyen geometriai részletesség van egy mostani játékban lényegtelen. Nálam most a Daz Studioban egy komolyabb haj 12millió négyszögből áll. Már a viewportban akad a kép. Ezt vajon egy gyengébb kártya RT magok nélkül szerinted meddig számolná? Mondjuk ez még csak a beta változat ami már kihasználja az rtx kártyákat. -

lenox

veterán

Nem én számoltam vs Amit én számoltam

Most akkor el kene donteni, hogy te szamoltal vagy nem. Ha igen, akkor legyszi adjal cache hit ratiot amivel szamoltal, ha nem, akkor linket, hogy ki hol szamolt. Amugy gondolom te kb. 0-val szamolsz egy talalgatas alapjan, illetve meg az is lehet, hogy talaltal egy programot ami alapjan azt hiszed, hogy mindig annyi.A cache-hit arány pedig attól függ, hogy koherensek-e a sugarak. A demoprogramokban lehet, a gyakorlatban nem.

Mi a gyakorlat? Egy jatek es egy demo ugyanugy korlatozott, tehat ezt nem tudom, hogy kene ertelmezni. Van tobb programhoz is adatod, hogy melyikben mennyi a chr, vagy csak egy demo program alapjan talalgatod, hogy mindig annyi? -

De senki nem mondta hogy ez a gyorsító ugyan olyan elven fog működni mint a mostani RT vagy azt sem mondta senki, hogy a képen nem egy dupla GPu-s ( chipletes) megoldás lenne rajta.

Kb semmit nem tudunk az egészről, ez egy olyan terület amiről kb a megjelenése napjáéig nem is látjuk mit és hogyan módosítanak benne. valószínűleg látják Nvidiánál a problémákat nem csak te számolsz itt a pH-n és fedezed fel a limitáló tényezőket,hanem ők is megpróbálnak megoldást találni arra, ha nem HBM2 lesz a fedélzeten vagy bármi egyéb megoldást.

próbáld egyszer feltételezni azt magadban hogy az AMD-n kívül létezik más cég is aki alkalmaz közmunkaprogramon kívüli mérnököket is és használják az eszüket arra , amire kell, és hátha kitalálnak olyan dolgokat is,amire te nem gondolsz.![;]](//cdn.rios.hu/dl/s/v1.gif)

De ha már itt tartunk, kíváncsi lennék, te mit vársz mondjuk a következő generációs Nvidától, mondjuk legyen RTX 3080.

Biztos, hogy a dedikált hardver megmarad RT-re szerintem egyenlőre( és miért nem teszteltek Nvidia kártyákat önállóan ? csak a szokásos, ha már itt vagy....

)

) -

Jack@l

veterán

Akkor befejezem mert látom lepereg rólad a józan logikus gondolkodás.

Maradjunk annyiban hogy ray-, path-tracinghez nincs olyan hogy elég mag...

Majd 8k 120fps-nél 100 millio poligonnal el lehet gondolkozni hogy már elég.

Nem a memória a szűk keresztmetszet perpill, hiába is próbálod ész nélkül nyomni az amd-s hbm2-t.

Új hozzászólás Aktív témák

A topikban az OFF és minden egyéb, nem a témához kapcsolódó hozzászólás gyártása TILOS!

MIELŐTT LINKELNÉL VAGY KÉRDEZNÉL, MINDIG OLVASS KICSIT VISSZA!!

A topik témája:

Az NVIDIA éppen érkező, vagy jövőbeni új grafikus processzorainak kivesézése, lehetőleg minél inkább szakmai keretek között maradva. Architektúra, esélylatolgatás, érdekességek, spekulációk, stb.

- Azonnali informatikai kérdések órája

- Autós topik

- Bittorrent topik

- Gurulunk, WAZE?!

- Folyószámla, bankszámla, bankváltás, külföldi kártyahasználat

- AMD K6-III, és minden ami RETRO - Oldschool tuning

- Apple iPhone 16 Pro - rutinvizsga

- One otthoni szolgáltatások (TV, internet, telefon)

- Kerékpárosok, bringások ide!

- GAI: Poor Volta...

- További aktív témák...

- BESZÁMÍTÁS! GIGABYTE AORUS MASTER RTX 3070 8GB GDDR6 videokártya garanciával hibátlan működéssel

- Asus TUF RTX 3060 TI 8GB GARANCIÁS

- GIGABYTE RX 6600 XT 8GB GDDR6 EAGLE Eladó!

- BESZÁMÍTÁS! ASUS TURBO RTX 3090 24GB GDDR6X videokártya garanciával hibátlan működéssel

- PowerColor Red Devil RX 7900 XTX Csere Kisebbre

- ÁRGARANCIA!Épített KomPhone Ryzen 7 5800X 16/32/64GB RAM RTX 5070 12GB GAMER PC termékbeszámítással

- ÁRGARANCIA!Épített KomPhone i5 12400F 16/32/64GB RAM RTX 3060 12GB GAMER PC termékbeszámítással

- AKCIÓ! Gigabyte H510M i5 10400F 16GB DDR4 512GB SSD GTX 1070 8GB Rampage SHIVA Zalman 600W

- Bomba ár! MacBook AIR 13" 2018 - i5-8210Y I 16GB I 512SSD I OS X Sonoma I Cam I Gari!

- BESZÁMÍTÁS! Asus TUF B365M i7 9700F 16GB DDR4 512GB SSD RTX 3060Ti 8GB Rampage SHIVA Zalman 600W

Állásajánlatok

Cég: PCMENTOR SZERVIZ KFT.

Város: Budapest

Cég: Liszt Ferenc Zeneművészeti Egyetem

Város: Budapest

![;]](http://cdn.rios.hu/dl/s/v1.gif)