- Vizsgálat indult, a Meta chatbot gyerekekkel folytatott romantikus beszélgetést

- Akkor is nehéz dolga lesz az Intelnek, ha részesedést vásárol benne az USA

- Megnyitotta kapuit a hardverpláza

- Megjöttek a Corsair Nautilus RS LCD sorozatú, készre szerelt vízhűtései

- Formabontó analóg klaviatúra a Sunder keze nyomán

Új hozzászólás Aktív témák

-

válasz

DudeHUN

#47198

üzenetére

DudeHUN

#47198

üzenetére

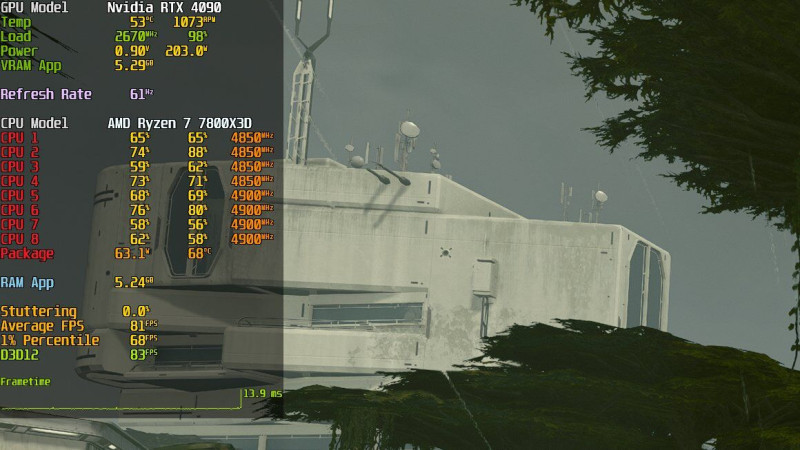

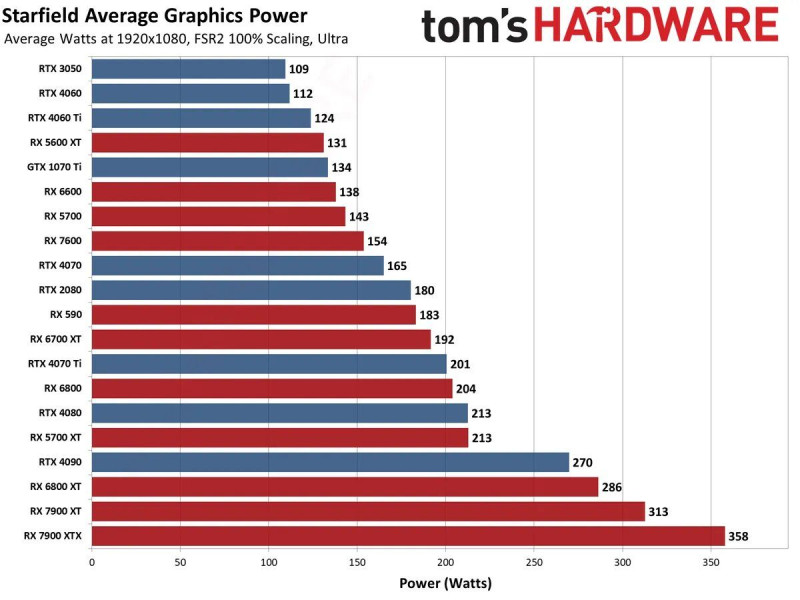

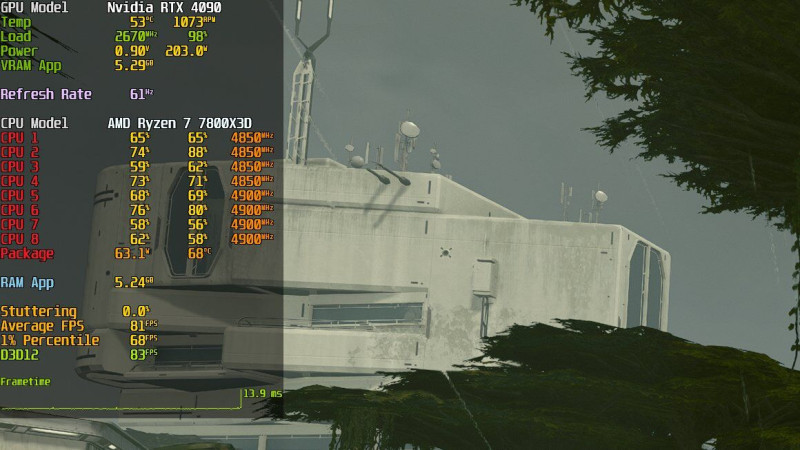

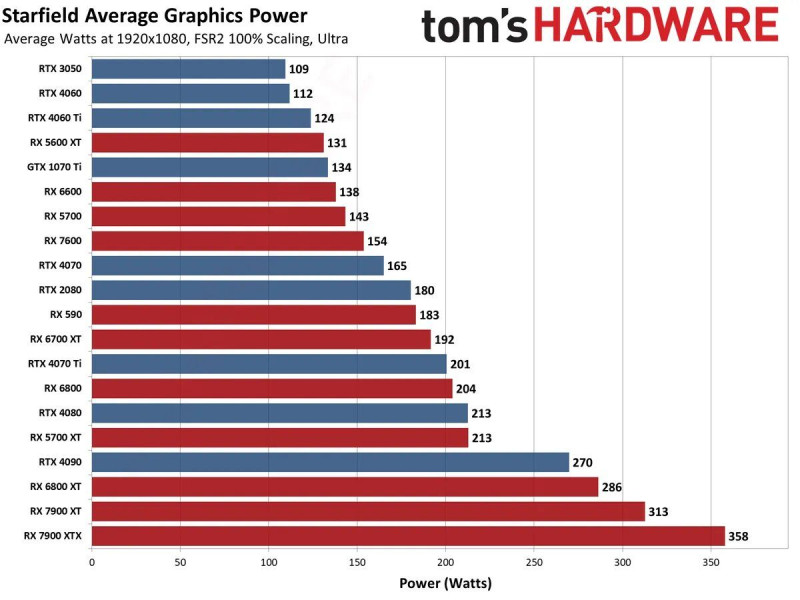

Nem cpu limit. érdemes megnézni a teszteket. FHD-n az Nvidia kártyák gyorsabbak arányaiban nézve. [link] és a limit az AMD kártyákat érinti.

Nem tudják a tesztelők sem mi áll jelenleg az Nvidia kártyák alacsony energiafogyasztásának a hátterében, teljesen szokatlanuk viselkedik mindegyik a játék alatt. Mint ha vissza lennének fojtva.

-

válasz

keIdor

#47187

üzenetére

keIdor

#47187

üzenetére

Úgy néz ki valamiért az Nvidia kártyák nem normál módon működnek játék alatt és nem CPU bottleneck. A 4090 pl 200 W fogyasztással megy.

[link]

"

Looking at these GPU power consumption figures in Starfield courtesy of

@tomshardware

, it's quite clear to me that NVIDIA GPUs are underutilized compared to their AMD counterparts. I would really like to know what's happening here.2Tudom én az AMD jó fej, a véletlenek összejátéka ez is mint annyi más furcsa dolog a támogatott játékaik során.

-

válasz

Petykemano

#47188

üzenetére

Petykemano

#47188

üzenetére

Azt elismerheted hogy a 7900XTX nem 4090 teljesítményű kártya..

-

válasz

gejala

#47183

üzenetére

gejala

#47183

üzenetére

Maga a játék is sajnos elég átlagos 4,6 ponton áll jelenleg a 10 ből. A textúrák évekkel ezelőtti szintet ütnek meg.

A játék nagyobb gépigénnyel megy mint a CP 2077 high RT vel.

HU is csinált egy elég jó tesztet: [Starfield: 32 GPU Benchmark, 1080p, 1440p, 4K / Ultra, High, Medium]

Legnagyobb poén, hogy nem lehet fényerőt állítani a játékban.

Komolyan?

Az FSR megvalósítása jó, a DLSS valamivel jobb. Szegény Intelesek meg szívnak mert nem megy a játék , várják a javítást.

Azt gondolom a gyártóknak lassan át kellene gondolniuk ezeket a szponzorációkat mindkét oldalon. -

-

válasz

Raggie

#47175

üzenetére

Raggie

#47175

üzenetére

Értem és igaz amit írsz. Referencia célt szolgál szerintem .

Tehát a teszt azt mutatja meg milyen lenne tökéletes megvalósításban ehhez képest a játékokban a beépítés minősége szerintem inkább jó, mint rossz.

Gyakorlati tapasztalat, mindennapi használat, nem teszt alapján írom amit írok. -

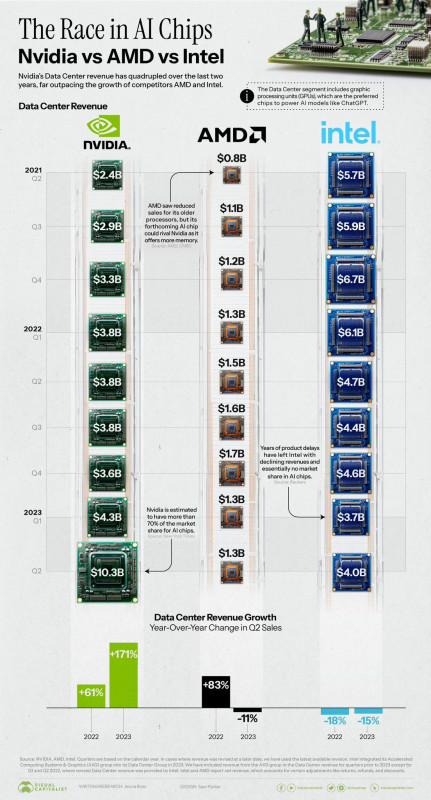

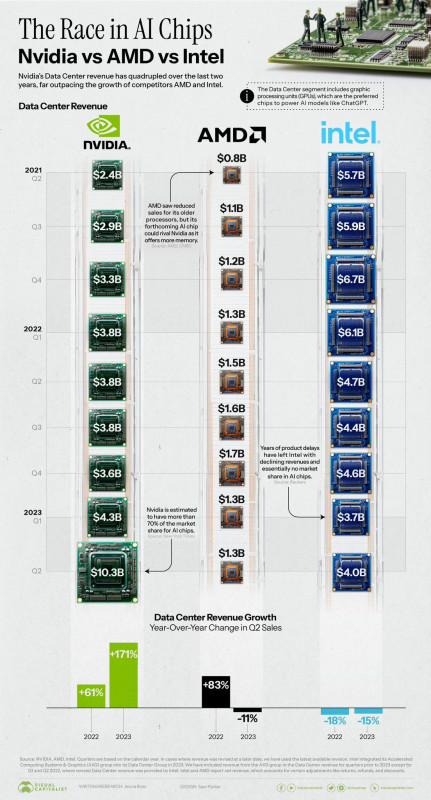

[Google Cloud & NVIDIA Join Forces To Power AI Computing]

Megint nem kell foglalkozniuk egy darabig a gaming szegmenssel

-

Értem amit írsz és elolvastam.

Azok az azonos kategóriák mindig később jöttek. Nem az volt hogy jött a Freesync 2 aztán Nvidia hozta a Gsync ultimatet, hanem fordítva, fogalmad sem volt mikor lesz erre válasz. Évek teltek el közben. A mostani helyzet már szuper Freesync 2 mindenben ok.

De anno volt kettő nem mellékes dolog:

Mire megy az ember a Freesynccel Nvida kártyával? Nem megy most sem a freesync rajt, hanem egyszerűen a szabványos DP Adaptive szinkronizációt engedte Nvidia.

Tehát a Freesync továbbra is AMD, a Gsync meg továbbra is Nvidia maradt. Az egyik hardvert használt a másik nem ennyi a különbség.

Ez szerintem inkább a monitorgyártók érdeme, kényszerítő hatása az Nvidiára. Nekem Asus Gsync monitorom volt azt váltottam le a Samsung freesync kettesre. Nem bántam meg.

Meg hát az is kell ahhoz hogy az ember az AMD VGA-k miatt váltani akarjon rá, ami a Pascal-Vega idején valljuk be, nem volt túl vonzó lehetőség. -

A Gsyncnnekelőnye volt a Freesync első verziója ellen, például az hogy 2 évvel elöbb mutatták be ha jól emlékszem, valamint a Gsync második verziója már leglább 144 Hz működést, magas HDR fényerőt, minimum válaszidőt, meg hasonló jóságokat írt elő.

Tehát itt is az volt, hogy volt egy olyan megoldás ami zárt volt de garantált egy minimum magas minőséget nyújtott, meg volt a másik oldalon egy idővel később érkező, nyitott de sokszor szinte játékra használhatatlan megoldások amik 40 és 60 hz mögött működtek, lassú válaszidővel stb.

Ettől függetlenül voltak persze nagyon jó monitorok is köztük,csak a Freesync plecsni nem volt garancia semmire.. A Freesync 2 volt az a lépés aminél egyenrangú lett a két cég megoldása ez után lépet is Nvidia vagy rákényszerült a lépésre, ez a jó szó.

Én is egyből lecseréltem a Gsync Asus-t egy Samsungra, miután támogatta már az alap szabványt az NV. -

válasz

keIdor

#47137

üzenetére

keIdor

#47137

üzenetére

Így van.

Amúgy az öregedésre vissza térve, Turing meg rommá veri az RX 5700 kártyákat ha a szolgáltatásokat nézzük.

Egy barátom 2080 Ti vel van már évek óta, 1080P-n igaz, de mindennel játszik RT vel , most meg a z FSR3 és DLSS3,5 még jobban kitolja a lehetőségeit.11 GB vrammal elvan vígan. -

válasz

FLATRONW

#47128

üzenetére

FLATRONW

#47128

üzenetére

Én is ezt gondolom,főleg,hogy van 200 DLSS játék,ami nem szponzorált,függetle n döntés.

proci985:

Ezt a forgatókönyvet már olvastam valahol,hogy azért hozta a Gsyncet ,mert jön a freesync,csak nem igaz szerintem .

AMD a Gsync bejelentése után valami kiállításon egy laptopon mutogatta a freesync korai verzióját ami azt hiszem egy meglévő technologia volt. -

válasz

FLATRONW

#47126

üzenetére

FLATRONW

#47126

üzenetére

Ilyesmi lenne jó.

AMD és Intel kb úgy gondolkodik, hogy hoznak egy általános megoldást és néha azon felül hoznak egy specifikust, mint mondjuk az AMD féle framegen nem FSR3 változata vagy Intel XeSS nek is van olyan verziója, ami csak Intelen fut és jobb minőséget ad de van egy általános is.

Nvidia hoz egy frankó megoldást, viszonylag jól megvalósítja, de mindig kizár valamilyen hardvereket a körből vagy ahhoz köti őket és az alap általános támogatást nem szorgalmazza.Ez alól az RT a kivétel, mert a Microsoft DXR adja az alapot , egy szabványra épül, azt maximum gyorsítani lehet speckó hardverekkel és megoldásokkal de az alapok adottak.

Ugyanezt meg tudta volna oldani Gsyncnél is, hogy hoz egy alap adaptiv támogatást minden Nvidia kártyára aztán hardverhez köti a jobb minőségű Gsync-et vagy egyes szolgáltatásokat.

DE erre én nem az olyan open megoldásokat látom megfelelőnek, amik egyetlen VGA gyártótól származnak vagy ahhoz köthetőek. -

válasz

Raggie

#47105

üzenetére

Raggie

#47105

üzenetére

Azt írta hogy a Starfieldben, ebben a játékban nem blokkolja a készítőket, nem azt hogy eddig nem tették.

Ez így 4 héttel a balhé után a sajtó/ közösségek nyomására érdemi lépés volt.Pug :

Nem hiszek senkinek csak véleményem van.

Ugyan ez lenne ha Nvidia blokkolná az FSR-t és az XeSS-t és vitatkoznék erről bárkivel mert az XeSS csak Intelen futó verziója is baromi jól sikerült a tesztek alapján.

DLSS közeli minőség és amúgy is szorítok Intelnek.

Nvidiát is rühellem azért, hogy a framegent nem teszi elérhetővé Amperen, én meg dönthessem el jó e nekem az a minőség.

Nem én találtam ki a dolgot ami media hírré tett és megfogalmazódott.

Nem tőlem származik a felvetés, ezek a táblázatok sem, az hogy a HU és GN erről videókat csinált és utána járt megkereste mindkét gyártót. AMD vel semmi gondom amúgy.

A témát én is unom és én is sokallom magam, nem akartam ezzel ennyit foglalkozni, szóval elhiszem, hogy te is. Tényleg elengedem.

-

válasz

Busterftw

#47102

üzenetére

Busterftw

#47102

üzenetére

Nagyjából amúgy közös megoldás.

Nvidia temporális eljárást használni, az FSR 1 még nem , aztán az FSR2 már az lett és az XeSS is az. Épp ezért mondják , az Unrealos fejlesztő fickó is, hogy ha az egyik gyártó eljárására elkészül a temporális tréning onnantól a másik kettő eljárást egyszerű beépíteni. Ezért tudják a modderek akár 1 nap alatt beletenni.

A Resident Evil-be amodder állítása szerint ennyi idő volt beletenni a DLSS-t, és a működése szinte kifogástalan, jobb lett mint az eredeti FSR kivéve a menü és rejtvények ahol enyhén szellemképes,de a 3.1 már ezt is megoldotta benne [link]

A DLSS tweak [link] szuper segítség ehhez. -

Brutális.

-

Nézd meg a videót, érdemes...

Úgy ahogy egy csomó játékban nincs semmiféle Nvidia márkajelzés és marketing célokra való felhasználás Például Spider-Man játékok, Call of Duty, Last of Us stb Rengeteg van,

Amúgy Starfield megjelenése elött AMD kiadott egy közleményt hogy nem blokkolja a játékban a DLSS ( és XeSS?) bekerülését. -

Mert te only write üzemódban kommentelsz.

Belinkeltünk neked anno egy halom játékot ahol semmiféle Licensz logót nem kell használni ,de van benne DLSS. Ezt elmondják a HU videóban is [link] 15:43 tól például ,hogy az Nvidia rugalmasan kezeli. Ha egy fejlesztő valami oknál fogva nem akarja szerepeltetni a zöld logót akkor nem kell neki.

Erről te miért nem veszel tudomást mint olyan sok egyéb érvről amivel reagáltunk neked? -

Nem állítottam egyáltalán butaságot csak te nem tudtad értelmezni.

ide beteszem neked a nyílt forráskódra vonatkozó törvényi rendelkezés egy részletét :"A GPL nem követeli meg a szerzőtől a módosított munka nyilvánosságra hozatalát, csak a lefedett munka továbbadásakor kerül sor a

szoftver automatikus licencelésére, ezért ebből a szempontból sem jogellenes a szerződés.

A szerző azonban úgy is dönthet, hogy a műve nyilvánosságra hozatalához adott engedélyt visszavonja. Ez természetesen súlyosan érintheti a reciprocitási láncban később következő felhasználókat, ennek ellenére a felhasználási szerződés ezzel ellentétes rendelkezései jogellenesség miatt semmisek.

A szerzőnek joga van arra, hogy nevét, szerzői minőségét a programon feltüntessék. Mivel a nyílt forráskódú szoftverek világában az egyenrangú résztvevők által önkéntesen végzett alkotótevékenység dominál, különösen nagy jelentősége van annak, hogy a forráskód különböző módosított változatait megkülönböztessék egymástólAzt írtam hogy mit csinálsz ha az FSR4 majd részben zárt lesz vagy driverhez lesz kötve egyes szolgáltatásokban, mint most az új szolgáltatások egyes funkciói és nem fut majd Nvidia és Intel kártyákon a jövőbeni AMD FSR fejlesztések?

Ki nem szarja le hogy a fejlesztőnek ez mivel jár ? Miért ő tudja hogy nekem mivel jár lemondania játékuk miatt 30 ezer forintról?[mert abszolút nem ez látszik a félkész termékeik kiadásánál, hogy akár csak egy kicsit is tisztelnék a felhasználókat azzal hogy minőségi munkát adnak ki a kezükből. nekem mindegy hogy ez kiadó vagy fejlesztői döntés amikor otthon a nappaliban játszok.

Tehát engedjük is el valaki azt támogatja hogy valami ne legyen benne egy játékban, ez számomra érhetetlen és értelmezhetetlen. Részemről ez már lerágott csont felesleges egymást győzködnünk tovább a témában mert a szakasz két végén állunk ,és ez így is marad. -

"Óriási tévedés."

Nem az.Az FSR nem gyártófüggetlen.. Az AMD eljárása, szellemi terméke, pont ugyan úgy ki vagy szolgáltatva a döntéseiknek a jövőben és a jelenben és az általuk nyújtott minőségnek és szolgáltatásnak.

Lehet az FSR 4 zárt lesz , aztán akkor meg mi zöldek meg kékek nézelődnénk egy megrekedt felskálázás hiányában.

Ezért lenne jó egy valóban VGA gyártófüggetlen megoldás, mondjuk a Microsoft-tól.Az FSR vagy bármelyik eljárás fejlődése vagy megjelenése is kérdéses ha anno az NVidia nem hoz DLSS-t , ha most nem hoz FG-t ,akkor az FSR 3 is kérdés mikor lett volna, ha lett volna egyáltalán arra erőforrás szánva.

Szerintem Tévedsz, ha azt gondolod verseny és konkurencia nélkül a mai világban bármelyik gyártó is csak úgy az ilyen eljárásokba és azok minél magasabb szintre való fejlesztésére dollármilliókat fektetne, kivéve ha pénzt látsz ebben és ebben jó az Nvidia. Lásd Raytracing..

A kötelező minimumot kapjuk így is, még azt sem.

Nem csak marketing értéke van annak hanem versenyszférát teremt ,kutatásra és fejlesztésre ösztönzi konkurenciát a saját eljárásai jobbá tételében, ami nekünk fogyasztóknak kell. -

Azért vagy annak a híve mert nem szereted magát az eljárást használni és mert te megkapod a kártyádhoz elérhető legjobb minőséget.

Kicsit tovább gondolva létezik a világon párszor több RTX kártya tulaj akik kaphatnának ez mellett a pénzükért egy jobb felskálázást más fejlesztők elmondása alapján minimális munkával növelh etnék a játék felskálázásának a minőségét, a vásárlóbázis elégedettségét.

Attól a nyílt eljárás ugyan úgy ott van és beépíthető nem függ a DLSS től sőt ellenkezőleg megkönnyíti a beépíthetőségét.

Mindhárom eljárásnak ott kellene lennie egy játékban, XeSS is remek minőséget tud, FSR 3 is sok fejlesztést hoz és a DLSS is diktálja azt amit el kell érniük a másik cégeknek. Remélem egyik gyártó sem fog kizárólagosságot erőltetni. -

válasz

proci985

#47036

üzenetére

proci985

#47036

üzenetére

"fele annyiba kerul, mint a 7900XT, es majd harmadaba mint a 4080 amik kb ugyanezt tudjak, csak driveresen kiforrottan."

ugyan ezt tudják?

A 4080 kb 2 x erősebb de vannak játékok ahol 3x FG nélkül. Az ARC 770 kb a 4060 / ti kategóriájában játszik. Amúgy szerintem sem rossz kártya. -

Ezt remélem viccnek szántad. Ez a játék átlagosan néz ki, úgy ahogy.

Egy RTX 4090 kártyán éppen tud 60 FPS-t ez azt jelenti hogy az AMD legerősebb kártyáján tud kb 45 FPS-t natívban. Ilyen közepes grafikával. Fogalmam sincs mit látsz benne de ez a játék szar és optimalizálatlan és nem is néz ki jól.

Mi előnye van így a nanite/ lumken technológiának a RThez nézve?

Black myth meg kap majd megjelenésig 20 downgradet. -

Hát ez ( is) szarul sikerült, főleg UE5 bemutatónak.

[Immortals of Aveum Disappoints as Unreal Engine 5’s True Debut] -

válasz

DudeHUN

#46987

üzenetére

DudeHUN

#46987

üzenetére

Fordítva .

A blokk 3090 és Ti re volt való, erre a srác leemelt a polcról egy 4090 kártyát szétkapta és nem passzolt sehogy, mire rájöttek hogy az nem egy 3090 Ti hanem egy 4090.

A srác azt mondta hogy ő azt hitte az egy 3090 mire Linus mutatta neki a hátlapot amire rá van gravírozva hogy 4090 . Ezek után azért megcsinálták a tesztet mégis, úgy hogy nem passzolt a hűtő, nem tudták rárögzíteni. a szétszerelésnél konkrétan eltörték a nyákot tehát az Kuka, és kijelentették, hogy ez egy szar. Amiután a kommentelők írták, nekik hogy ember nem jól teszteltetek és a startup cég egyik alapítója alákommentelt a videó alá, hogy mennyire fáj neki látni hogy a z egyetlen mérnöki prototípusával így bánnak és rosszul tesztelték.

Ezek után azért megcsinálták a tesztet mégis, úgy hogy nem passzolt a hűtő, nem tudták rárögzíteni. a szétszerelésnél konkrétan eltörték a nyákot tehát az Kuka, és kijelentették, hogy ez egy szar. Amiután a kommentelők írták, nekik hogy ember nem jól teszteltetek és a startup cég egyik alapítója alákommentelt a videó alá, hogy mennyire fáj neki látni hogy a z egyetlen mérnöki prototípusával így bánnak és rosszul tesztelték.

Még úgy is hogy hetekkel ezelőtt és többször megbeszélték, hogyan és mire, írásos tájékoztatót és használatit küldtek hozzá, amire Linus rá sem nézett

A Startup cégnél meg tudták, hogy ezen múlik a cég sikere hogy a nagy Linus tesztel és majd ilyen következtetést vonnak le.

Követelték sokan hogy újra teszteljenek, de Linus azt mondta hogy ha 5-10-20 fokkal alacsonyabb lenne a hőfok ő akkor is nemet mondana a hűtőre, mert szar. Jól néz ki de szar.....

Több cég jelezte, ( GN is) hogy jutassák el nekik a hűtőt majd ők normálisan letesztelik, de Linus baszott visszajuttatni a minta / mérnöki példányt és hetekig nem is adta szándékát erre a cég többszöri megkeresésére sem, majd egy kiállításon árverezés alatt volt a hűtő a standjukon. ( Linuséknál) és ez csak egy dolog amire rávilágított Jesus, pl a Intel ARC 750 amiben szarrá veri az RTx 4060 kártyát ( mint kiderül teljesen más beállításokkal "véletlenül") meg a 4090 ami 3090 Ti -nél 300% kal volt gyorsabb Linuséknál, valamint nem frissítik a tesztjeiket és még rengeteg dolog ami igazából bicskanyitogató ahogy természetesnek veszi ezt a Linus hogy félrevezeti az embereket, ezek után mindenki hibás csak ő nem, és a poén hogy 1-2 napja banolják redditen az embereket.

( Linuséknál) és ez csak egy dolog amire rávilágított Jesus, pl a Intel ARC 750 amiben szarrá veri az RTx 4060 kártyát ( mint kiderül teljesen más beállításokkal "véletlenül") meg a 4090 ami 3090 Ti -nél 300% kal volt gyorsabb Linuséknál, valamint nem frissítik a tesztjeiket és még rengeteg dolog ami igazából bicskanyitogató ahogy természetesnek veszi ezt a Linus hogy félrevezeti az embereket, ezek után mindenki hibás csak ő nem, és a poén hogy 1-2 napja banolják redditen az embereket.

Eddig olyan 500 embert már kibanoltak, mert szóvátették, hogy vegyen vissza és változtasson .Demokrácia rulez.. -

GN Linuséról közzé tett videója , amiből egyre jobban dagad a botrány.

Szerintem érdemes megnézni, főleg a hűtős részt, hogy vezethet félre egy elfogult és / vagy hozzá nem értő sajtó/cikkíró/ inluenszer tömegeket és hogy ronthatja egy cég piaci stabilitását.

[The Problem with Linus Tech Tips: Accuracy, Ethics, & Responsibility] -

nem tudom volt e már:

Kínai nyelvről fordítva Goggle segítségével innen :[link]"Az Intel 8-án nyilvánosan elismerte, hogy biztonsági rés van az ARC A750 / A770 grafikus kártyán, amely DoS támadásokhoz használható, és érzékeny információkat szivároghat ki. / CVE-2022-41984 , az a furcsa, hogy a hatás a 2022 októbere és decembere között kiadott első köteg grafikus kártyákra korlátozódik, és a 2023-ban leszállított grafikus kártyákat kijavították. A külvilág gyanítja, hogy az Intel tudhatta a sérülékenység hosszú ideig, és ez az ARC A750 / Az A770 késésének valódi oka.

Az Intel SA-00812 dokumentumleírása szerint a CVE-2022-38973 lehetővé teszi a privilegizált felhasználók számára, hogy szolgáltatásmegtagadási támadásokat indítsanak, a CVE-2022-38973 pedig lehetővé teszi a hitelesített felhasználók számára, hogy szolgáltatásmegtagadási támadásokat indítsanak, és lehetővé teszi az illegális hozzáférést a szivárgáshoz. érzékeny információ.

Az Intel kijelentette, hogy az érintett grafikus kártyák főként 2022 októberétől decemberéig terjednek, vagyis az ARC A750 / A770 grafikus kártyák első kötegét, és a 2023-ban szállított többi termékcsomagot nem érinti.

A külvilág azt gyanítja, hogy az Intel tudhatta a sérülékenység létezését, ezért az első köteg grafikus kártyákkal gondok voltak, de a 2023-ban leszállított ARC A750 / A770 varázslatosan nem érintette. Valójában 2022-ben az Intel többször is késleltette a piacra lépés idejét, és nyomás nehezedik rá. Ha várni kell a javított chipre, akkor azt 2023-ig el kell halasztani. 2022 októberében adják ki.

Az Intel ezúttal csak a szivárgás részleteit közölte, de nem közölt firmware-frissítéseket vagy javításokat.Ha 2022 októbere és decembere között vásárolta az Intel ARC A750 / A770 grafikus kártyát, az Intel azt javasolja, hogy vegye fel a kapcsolatot a régiójában található Intel termékeivel."

-

[Special driver for Ratchet and Clank from AMD]

Ratchet & Clank Rift Apart update enables ray tracing on Radeon RX GPUs

-

-

válasz

Raymond

#46956

üzenetére

Raymond

#46956

üzenetére

Miért tartod valószerűtlennek? Nincs vagy nem lesz Zen 4 alapú 8 magos CPu vagy RDNA 3 alapon nem tudnak bele tenni erősebb egyedi GPU-t ?

persze lehet hogy csak wishlist, nem tudom én sem természetesen de ezek lennének azok a speckók ( Tflops alapján) amit elvárnék egy pro géptől,( most az lényegtelen milyen CPU vagy hogy 16 vagy 20 GB GDDR6X vagy GDDR6) .

főleg hogy a PSVR2 elég jó lett és a PS5 nem méltó hozzá, döglődik alatta. -

válasz

Petykemano

#46947

üzenetére

Petykemano

#46947

üzenetére

A kép pletyka, csak akitől van egy elég jó leaker .

A zen 4 teljesen jó döntés. mi értelme lenne a zen 5 nek költséghatékonyságot nézve."Különös az is, hogy a nem kifejezetten jól sikerült RDNA3-at nevezik meg, mint grafikus egység"

ilyenkor elgondolkodok azon hogy miért írjátok ezt le sokszor? szerintem az RDNA3 jó lett.

Az árazással van baj de ha a konkurenciát nézem még azzal sincs.

Szépet lépett előre RT ben, erős raszterben. ha 7800 és 7800XT nak hívnák a megjelent variánsokat és 550$ és mondjuk 700 dollár körül lenne az ára elégedetten csettintenénk.

Ps5-be pedig a majd érkező új verziók átdolgozása megfelelőek lesznek. A mostani Ps5 kb RX6700 és mégis mit hoznak ki belőle. -

-

Na jó de nem tudom elolvastad e lényeget , twitteren már írják -Ez pont az a dolog amit elég sok tulaj akarni fog.

Kb 25 ezer dollár feletti értékű extrát tudsz feloldani az autóban ezzel.+ a mentési funkciók full selfdriving, mert az aztán kell ...hányan fognak megpusztulni ettől.

Ami a rosszabb hogy ki lehet törölni belőle az előzményeket( baleset ,javítások stb.)

Itt pont a fizikai hozzáférés egy alapvetően elérhető funkció a kereskedésekben és szervízekben, Óravisszatekerés magasabb szinten... -

-

válasz

Raymond

#46931

üzenetére

Raymond

#46931

üzenetére

Jó ez itt szerintem

pedig arról volt szó 2022 Novemberben, hogy :[link]"Miért lenne pánik? A raktárkészlet ürül, és csak +2 hónapra számolják most a Navi 21 és 22 kivezetését a tervezetthez viszonyítva, ami például egész jó, mert tavaszra le lehet cserélni mindkét lapkát. Ez teljesen jó az AMD-nek. Állhatnának úgy is, ahogy az NVIDIA áll, hogy van kb. 60 millió eladatlan vagy lekötött GPU-d az előző generációból, és nem tudod hozni a next-gent a tömegpiacnak, mert tök lassan veszi meg a piac az előző generációt. Az Navi 33 ellen szánt AD106 például most 2023Q3 végén jönne. Nem azért, mert nem készül el gyorsan, hanem mert ha kihozzák, akkor le kellene írni úgy 4 milliárd dollárnyi eladhatatlan készletet. Az AMD felhalmozott GPU készlete nincs 50 millió dollár, tehát ha nagyon szorít az idő, akkor ennyit még le is tudnak írni, de nyilván nem szorít, ráérnek azt eladni februárig.

Ha a piac valamilyen okkal beomlik, az mindig annak fáj, akinek nagy tartalékja van."

és utána :

[link]

"Ez a tendencia folytatódni fog, mert az NVIDIA jelenleg 4,5 milliárd dollárnyi eladatlan GPU-n ül, és mellé még van 4 milliárd dollárnyi előre lekötött tétel, ezek nagy része még mindig a Samsungtól jön, tehát prev-gen. Ergo az NV rá lesz kényszerítve arra, hogy ezeket szórja ki gyorsan, mert ennyi tételt normál esetében, tehát nem bányászláznál másfél év eladni, de kellene majd hozni az amúgy már kész AD106-ot a tömegpiacra, miközben szeptemberben még tavaszra volt időzítve a start, októberben már nyárra, most pedig jövő őszre. De nem azért, mert bármi baj lenne a hardverrel, úgy működik, ahogy a nagyobb modellek, csak ugye van hozzávetőleg 9 milliárd dollárnyi olyan már kifizetett termék, amelyeket ki kellene dobni, ha tavasszal jönne. És érthető módon az NVIDIA nem akar úgy 7 milliárd dollárnyi tételt csak úgy leírni. Tehát a jövőben ezek eladása lesz a fontos, és emiatt a piaci részesedésük biztosan nőni fog, mert belemennek majd a veszteséggel történő értékesítésbe is. Utóbbi miatt viszont a Gaming szegmens szzonális eredménye még pár negyedévig romlani fog. Persze az egész attól is függ, hogy az AMD hogyan árazza majd a Navi 33-at. Ha nagyon ki akarnak baszni az NV-vel, akkor benyomják 400 dollárra, és akkor az NV-nek is le kell vinnie a GA102-ket erre a szintre. Szóval olyan nagyon ennek a helyzetnek az NV nem örül, az AMD annál inkább, mert a Gaming részlegük már most növekszik a bányászláz után, és még nincs is itt a next-genjük."

És Petyke jól látta és jósolta meg a helyzetet( én is amúgy ) : [link]

-

ha valaki lemaradt róla , elég jó kis videó DF-től:

[Unreal Engine 5.2 - Next-Gen Evolves - New Features + Tech Tested - And A 'Cure' For Stutter?] -

válasz

Valdez

#46916

üzenetére

Valdez

#46916

üzenetére

Úgy hogy felturbózták és kibővítették a RT effekteket.

" Both ray-traced shadows and ray-traced ambient occlusion are new additions to the PC version of the game and require additional processing power."

De AMD-n nem az RT vel van gond, hanem az RT+ felskálázástól omlik össze a játék de ezt leírták már több helyen...

" game with ray tracing and Dynamic Resolution Scaling enabled on some AMD GPUs like the Radeon RX 7900 XTX" -

válasz

proci985

#46903

üzenetére

proci985

#46903

üzenetére

4060 nem rég jött ki , pár hete még.

A 3060 Tu meg annyira bezuhant árazásban mindenhol hogy az egyik legnépszerűbb kártya letr NV fronton. Kb ugyan olyan népszerű, mint a 6700 XT AMD oldalán, közel is vannak teljesítményben.

Engem az lepett meg, hogy a 3080 és az fölötti kártyák nincsenek sehol. -

[EXCLUSIVE FULL REVIEW of the SNEAKER X PC]

érdekes cucc az bizti

Nada megint remek munkát végzett. -

[link]

ÚJ műfaj virágzik.

"Ez a derékvédő és vállvédő! A kínai vámhatóság jelentése szerint egy fekete ruhás férfi Makaóból Zhuhaiba utazott a Gongbei vámon keresztül, akit a vámtiszt a rendellenes testtartásban sétáló utast találta és elfogta. További ellenőrzést követően a vámosok 306, műanyag fóliával és szalaggal becsomagolt Intel CPU-t találtak az utas lábán és hátán, becsült értékük körülbelül 459 000 RMB.

A kínai törvények és rendelkezések értelmében a kínai vámhatóság nyilvános árveréseket fog lebonyolítani az elkobzott árukról, az „árverési törvény” vonatkozó rendelkezéseivel összhangban.

-

válasz

Yutani

#46893

üzenetére

Yutani

#46893

üzenetére

Mondjuk nem volt az annyira alacsony azon a kripto árszinten.

Lassabb volt a megtérülési idő, csak ennyi.de nagyon profitábilis volt az RDNA 2 is az alacsonyabb fogyasztás miatt. Ezért nem lehetett azt sem venni, nem azért mert a gamereknek az jutott.

Például a mai árfolyamon :RTX 3090 : Profit per day: 0.67 USD

RX6800: Profit per day: 0.53 USD -

válasz

keIdor

#46890

üzenetére

keIdor

#46890

üzenetére

ha megnézed amit írtam, feljebb:

"A 7900XTX amúgy 4070 szintjén lenne, ha nem lenne eltolva a szint.

Vissza köszönne a Turing korszak amikor az 5700XT volt a porondon a 2070 ellen.

Nem jó ez se az Nvidiának se az AMD nek mert hogy nézne ki ha a 7900XTX = 4070 esetleg 4070 Ti lenne max 600 dolláros áron.

Nvidia ezzel a szint eltolással kompetensé tette az RDNA3-at és ( mindkét cég) több pénzt keres. Sima kartell."Nem vagyok benne biztos, hogy gyártásilag is fel voltak készülve a fenti forgatókönyvre.

Ha a csúcs SKu-t, a 7900XTX -et ugye mondjuk valahol a 4070 környékére lehetett volna max pozícionálni, akkor Nvidia 3 kártyával lefedte volna az egész RDNA 3 porfóliót. kb annyit tudott volna AMD is hozni. nem lett volna hely,alulról meg ott a régi gen teljes választékban.

Nagy gondban lett volna AMD, lehet belekalkulálták ezt a forgatókönyvet is a rendeléseikbe, így meg legalább fogyb a régi gen. Szinte minden promociójukban az RDNA2-t nyomatják most is, 6600XT-t vagy mit adnak egy játékhoz.

Valószínűleg az lett volna mint az RDNA 1 nél. Két új SKU mondjuk 7800 XT meg 7700 XT , és alatta az RDNA 2.Szerintem most az lesz hogy valamelyik szinten, mondjuk a 7800 nál egyetlen versenyző lesz, nem lesz XT meg XTX vagy sima és XT,meg lehet a 7700 is így jár.

-

válasz

keIdor

#46888

üzenetére

keIdor

#46888

üzenetére

igen ez a probléma, még inkább a használt piacra terelik azt, aki nem fél ettől ( nekem a 3080 karim is bányászott annál akitől vettem, el is mondta korrekten, tudtam milyen körülmények között volt ( klímatizált, tiszta rendezett környezet, dobozában bent a számla) tökéletesen működik 1 éve.nem mindegy honnan veszi az ember.)

De már többször leírtam én is itt, épp a héten is itt : [link]

hogy ezzel az AMD is nagyon jól járt hogy elcsúsztatta Nvidia a számozást . Két cég ezzel "megoldotta" a helyzetet.

-

válasz

Busterftw

#46884

üzenetére

Busterftw

#46884

üzenetére

Mondjuk naív elképzelés volt, hogy ezt lehet korlátozni, legyünk őszinték. A csúcson pár hónap alatt nullán voltál egy kártyával ha bányásztál, már akkor kerestél egy vagyont.

még azokon az árakon is.

Inkább a saját piacuk összeomlása, a hatalmas mennyiségű használt kártya és a gamer piac "megnyugtatása" hogy mi próbálkozunk,de..." felkiáltással volt a cél.Valójában bekövetkezett, amitől tartottak.

Most olyan árakon vannak a használt és Garis Ampere kártyák a piacon, hogy az van most Nvidia fronton, mint volt anno a Vega-RX korszakos bányászláz végén. 80 ezer körül garis 3060 Ti,100ezer forint fölött kicsivel garis 3070 meg egy 4060 Ti árán garis 3080 kártyákat tudsz venni. 210 ezerért ment múlt héten 3090 kártya itt. egyszerűen elöntötte a piacot 1-2 hónapja a kártyaáradat. Ebayen most licitálok egy 3090 EVGA-ra garis-dobozos, 4 hónapot bányászott,400 uroval eddig én vagyok a befutó. és mindjárt lejár a licit.( Elötte 435 euroval ment el egy ugyan ilyen)

Szóval ez van.Már nem is érdekel mennyiért megy a mostani gen bármelyik oldalon,

még Táp cserével is jobban járok most ,mint hogy Ada-t vagy 7000 RX -et vegyek. -

válasz

Thrawn

#46877

üzenetére

Thrawn

#46877

üzenetére

"A pletyka szerint az EVGA tajvani irodájának munkatársai, köztük a legendás overclocker Vince "K|NGP|N" Lucido, lemondtak, és a bezárás küszöbön állt. Megkerestük Lucidót, de sajnos azt mondta, jelenleg nem tud nyilatkozni. Megkerestük az EVGA-t is nyilatkozatért."

Annyi bizonyos hogy még a csapat tagja,de ilyen pletykák nem röppennek fel csak úgy. Valószínűleg kényszerhelyzetbe került EVGA. Lucido választás elé állította aztán most vagy megegyeznek vagy nem.

Az biztos, hogy a márkanevet megtartják, mivel az övék, szóval ebből a nyilatkozatból, sokkra nem lehet következtetni, hogy a Kingpin továbbra is az EVGA része.

"Our Taiwan office is still operating and Kingpin is still with EVGA" -

válasz

Gyuri27

#46871

üzenetére

Gyuri27

#46871

üzenetére

Az EVGA egy jó cég volt de szűk portfólióval és kicsi piaccal. Az mellé nem fért bele ez a szolgáltatás amit nyújtottak.

Egyedi nyákokkal dolgoztak, áttervezték a hűtést és a PCB-t nem igen volt náluk referencia megoldás .Rengeteg pénz ez és költség.

AZ mellé a magas szintű RMA szolgáltatás az EU ban ez horror pénz volt az USA-ban jobban ment a dolog, de az is volt a fő piacuk neki.

A bányászszezon utolsó évében 79 millió dollárt kerestek míg egy átlagos évben kb ennek a felét. A csúcson szálltak ki.

A idei bevételük 27 millió dollár lett és ennek nagy része az Ampere Geforce eladások tették ki még mindig.

Kingpin azért áll fel, mert ők nem egy alaplaptervező meg Tápgyártó csapat nem erre tették fel a nevüket és a tudásukat.

Sajnálom az EVGA-t, de megértem a zöldek álláspontját, hogy nem kivételeznek, az EVGA--ét kevésbé. Jól kerestek ők ahhoz képest, hogy egy Asus mondjuk kiegészítők, laptopok ,alaplapok, házak stb tömegét árulja és mindegyik földrészen azonos portfólióval és hasonló eladással és ehhez csapódik a szerverek és a komolyabb munkaállomások bevétele az nvidiával.

Halkan hozzáteszem hogy ezt megoldhatta volna valami fű alatti módon Nvidia amúgy , hogy bent tartja őket a piacon, ebben mindenképpen igazat adok,de sajnos nem igen mérlegelik ők a Játékosok valós igényeit.

Még reménykedek, hogy azért most lépnek valamit a zöldek de nem sok esélyt látok rá. -

[NVIDIA unhappy board partners may work with Intel on the Battlemage Series]

Nagyon ráférne mindkét cégre hogy Intel odapirítson nekik.

-

válasz

Yutani

#46859

üzenetére

Yutani

#46859

üzenetére

Nem fértem hozzá sajnos a 12 GB verzióhoz.

Ázsiai beszállítás volt a hiány alatt csak ,aztán hozzánk így nem jutott igazán németből. Amúgy jellemző a cégre, mivel feliratkozás volt náluk a skalperek miatt, hogy pár hónap után küldtek egy emailt hogy felajánlanak egy 10 Gigás verziót vásárlásra a 12 GB helyett és mivel 10 éve regisztráltam hozzájuk több vásárlással, így kapok rá 10 % kedvezményt is, de vissza utasítottam mert 12 GB verzió volt a cél.( + nem tudtam hogy vége lesz náluk)

Ezért lett aztán MSI. -

válasz

-FreaK-

#46852

üzenetére

-FreaK-

#46852

üzenetére

Még nekik sem válaszoltak és jók a következtetések. Nagyjából minden értelmes ember így gondolkodik ahogy GN.

A legrosszabb hogy szerintük most végigrohan az AMD a stúdiókon és próbálja finomítani a dolgot. Sonynál nem tudták átütni a dolgot úgy néz ki ,mert az ő játékaiban van DLSS.

Ez gáz.

Amúgy azokra a stúdiókra nézve is , akik ezt elfogadták. -

válasz

Raggie

#46841

üzenetére

Raggie

#46841

üzenetére

Inkább egy vélemény elég óvatos és jó nagy körítéssel és megfogalmazással. Nagyjából ők sem tudnak egyértelműen kijelenteni semmit, egy elképzelésük van róla. AZ hogy ez pénz vagy technikai segítség mindegy.

Nvidia szponzorált címeknél valahogy eljutnak oda a fejlesztők, hogy beépítik a konkurens megoldást .

hát izé...bírom a srácokat de hogy gyakorlatilag ott mi történik és miért nem merül fel ez egy AAA kategóriás támogatásnál bekerüljön XeSS és DLSS az továbbra is szerintem egyértelmű és ők is mondják, hogy igazából ők sem tudják ott mi hangzik el mi nem.. -

Linkeltem neked többet is, egy github oldalt, ahol azt gondoltam megy az hogy átnézd a többi bejegyzést is egy vissza gombnyomással.ahol értelmezheted magad is a Licensz feltételeket.

A Steramline Plugin tartalmazza a DLSS-t is.

"Semmi nem akadályozza meg a kiadót, hogy megpróbáljon magának az általánostól kedvezőbb licenszfeltételeket kialkudni a jogtulajdonostól, és hogy akár kapjon is, ha a zöldeknek is megfelel az ajánlat. Így ennek bizonyító ereje nincs arra nézve, általánosan kötelező-e avagy sem. "

cool magyarázat.

cool magyarázat.

Úgy kötelező, szerinted hogy még sem az .

Ez egy partatlan vita kitaláltál egy okot miért is teszi jól AMD a DLSS tiltását és mikor az ember mondja hogy nincs semmilyen nyitó oldali logó a játékokban akkor meg nyomsz egy ilyen magyarázatot, ami szerint még sem kell megjeleníteni azta logót... Van ennek így értelme? -

A DLSS új verzió amiket te is linkelsz és és idézel az a meglévő DLSS módosításához és frissítéséhez van.

Egy független szoftverbe való beépítéshez a Streamline [link] van ami teljesen ingyenes és nyílt és elérhető benne minden Streamline funkció ideértve a DLSS-t [link] és nincs semmilyen trademark kötelezettség.[link]

És pontosan hasonló a célja mint amit te is felvázoltál egy egységes keretrendszer. -

válasz

Yutani

#46814

üzenetére

Yutani

#46814

üzenetére

csak épp egy kicsit kellene tovább olvasni :

" NVIDIA Trademark Placement in Applications with a licensed SDK, other than

the DLSS SDK or NGX SDK. For applications that incorporates and/or makes use of

a licensed SDK, other than the DLSS SDK or NGX SDK, you must attribute the use

of the applicable SDK and include the NVIDIA Marks on the credit screen for

applications that have such credit screen, or where a credit screen is not

present prominently in end user documentation for the application. -

-

Szerintem épp ez a hozzáállás vérfan.

"Bezzeg az olyan eseteknel, amikor csak DLSS only a jatek, ami valoban kizar az nV usereken kivul mindenki mast.... aaaaz rendben van

Szponzorált címekről van szó.

Nvidia szponzorált címben 2 daraban nincs FSR a többibe vagy van vagy belerakhatja a készitő. Amiben csak DLSS van az nem Nvidia szponzorált hanem független vagy pedig az FSR elött jelent meg.Akkor ez így rendben van mert az FSR még ha szarabb minőségű is de megy mindenen és jobb megoldást korlátozzák, mert a DLSS - 3 generációnyi Nvidián, 7-8 éves kártyákon is frankó minőségben megy, és a piac 80 % án futna jobb minőségben. Nektek meg ugyan úgy ott lenne az FSR ahogy most is.

Ki veszít ezzel? Nem ti, nektek mindegy. Cserébe aki szeretné hogy a készítőt ne korlátozza AMD az vérfan titulust kap AMD meg megértést tőletek, "pártatlanoktól"

Amúgy az XeSS SDK XMX verziója ami szinte ugyan olyan minőségű, mint a DLSS, szintén nem fut minden hardveren. -

-

mindegyik érved amit kiemeltél egytől egyik félremagyarázás, inkább úgy írom süket duma.

"Úgy látom, még mindig nem esett le, hogy úgy tűnik, jobban ismerem a területet, mint te..."

Semmiből nem látszik ez meg , hogy azona területen szakember lennél vagy értenél hozzá .

Szoftverfejlesztő vagy ? Elhiszem. Ebben a témában dolgozol amiről szó van? Kizárt.(I)Úgy látom, az sem ment át, hogy nem elég csak beépíteni.(/I)

Lásd fentebb, komolyan vehető ez így ebben a formában?

"A lelkes rajongók utána supportálják is, ha gond lenne vele? Költői kérdés volt...

A black box nem azért rossz, mert nehéz beépíteni, hanem mert nehéz karbantartani, mivel nem látsz bele a működésébe, és nem tudsz módosítani rajta, ha szükséges lenne."Most komolyan mit nem értettél meg abból amit Husky leírt? Az SDK szabadon hozzáférhető ,a legújabb is Githubon.[link]

Február óta a 3. verziónál jár a DLSS 3.0 és hozzáférhet bárki, nem korlátozza Nvidia a használatát.[link]

Ha benne van a DLSS onnantól te magad otthon a legfrissebb SDK-t használhatod a játékban .

Just work ,nincs szükség a fejlesztő közbenjárására és arra hogy hajlandó legyen számodra frissíteni bármit is ezzel kapcsolatban a játékban.

Ezt írta le neked Husky hosszú kommentben.

Amúgy szerinted tehát sokkal jobb ha nincs abszolút, mint hogy beletegyék az AMD-s játékba a modderek és felhasználó frissítse néha ha akarja vagy egyáltalán szükséges..."Nekem, mint aktív Radeon Rx 6800XT, és nem olyan rég még RTX 3060 12GB tulaj is az volt a jó, amikor egyik felskálázást sem kapcsoltam be, mert látványosan romlott a képminőség egy minőségi natívhoz képest. "

Nyilván ez ebben a vitában abszolút nem kompetens, ,hogy neked mi tetszik mi nem .Arról van szó, hogy a felskálázást aki használja annak mi a jobb.

-

Miért miből kellene nem ezt gondolnom?

milyen világhírű stúdiónál vagy és építesz be felskálázásokat "A" kategóriás címekbe?

milyen világhírű stúdiónál vagy és építesz be felskálázásokat "A" kategóriás címekbe?

A szoftverfejlesztés hatalmas terület ne húzz már rá mindent egy kaptafára.

Ha a három közül egyetlen megoldás be van építve onnantól minimális munkával beépíthető bármelyik eljárás a játékba. Azaz ha van FSR 2.0 semeddig nem tart beépíteni a DLSS-t hisz erről szól a Resident Evil belehekkelt DLSS támogatása lelkes rajongók által ami végül jobb minőséget adott, mint a gyári FSR... Blackbox eljárástól nem rossz nem?

Felhasználóknak az a jó, ha választhatnak egy játékban melyik felskálázást akarják használni és a saját kártyájukhoz mérten a lehető legjobb eljárást kapják.

Pont az segíti elő a versenyt ha az AMD szembesül azzal hogy a felskálázási megoldásuk jelenleg a harmadik helyen van a minőségben és ezen változtassanak, hogy nektek, radeon kártya tulajdonsoknak jobb legyen.

Annak, akinek lehetősége van rá, azaz RTX kártya tulajdonos, ne kellejen beérnie az FSR 2 vel mikor a DLSS 3.0 többet ad neki minőségben. A verseny az nem ennek az ellehetetlenítése.

Amúgy meg alvó oroszlán bajszának a huzogatása ,mert Nvidia szerintem már nagy ívben leszarja a Pascal támogatását az FSR -rel és a DLSS egyforma minőséggel megy minden RTX kártyán, azaz az lesz a vége ennek, hogy pénztárca kinyit, aztán jönnek az only DLSS játékok, full RT terheléssel, és széthúz a piac. -

Nem értem a végeredmény türkében mire reflektász? Miért, az FSR 2 jobb végeredményt ad? A végeredmény tükrében az látszik hogy a felhasználóknak minőség szempontjából jobb a DLSS,a fejlesztőknek konzolportoknál valószínűleg az egyszerű átültethetőség és kevesebb munka miatt jobb az FSR de a felhasználóknak ez jobb szerinted?

Ne a fejlesztők szempontjából érveljünk már mert azt nem látjuk, te sem , nekik ez valójában mivel jár, mit kapnak érte, mennyi munka, mennyire elégedettek valójában ők,a készítők maguk az eredménnyel vagy csak úgy vannak vele hogy mindegy ezt így le tudják,de biztos látják , hoyg aDLSS jobb minőséget ad a felhasználók szempontjából aki az amúgy is szar minőségű játékokért pénzt ad , amiben a felskálázó eljárások végzik el az optimalizációt a fejlesztő helyett.

Épp ezért nagyon nem mndegy milyen minőségben kapod azt meg. Amúgy az Nvidia fejlesztők a SDK cserét a TPU oldalán heti szinten hagyják jóvá... -

válasz

Petykemano

#46723

üzenetére

Petykemano

#46723

üzenetére

Már a követelmények is érdekesek.Nvidia oldalról eggyel régebbi generációt adnak meg mindkét esetben.

RX5700 és 1070 Ti.

6800XT és RTX 2080.

majd jól pofára esnek,mert beleheggesztik a modderek DLSS-t ami jobb lesz,mint az eredeti,mint volt rá példa legutóbb. -

[Cyberpunk 2077 Phantom Liberty First Look: PS5, Xbox Series X, PC RT Overdrive]

Elképesztően néz ki szerintem konzolon is.

Új hozzászólás Aktív témák

Hirdetés

A topikban az OFF és minden egyéb, nem a témához kapcsolódó hozzászólás gyártása TILOS!

Megbízhatatlan oldalakat ahol nem mérnek (pl gamegpu) ne linkeljetek.

- Autós topik

- Samsung Galaxy S23 és S23+ - ami belül van, az számít igazán

- Milyen autót vegyek?

- Sorozatok

- Synology NAS

- Telekom mobilszolgáltatások

- Kínai és egyéb olcsó órák topikja

- Házimozi és Hifi kábelezés!

- Apple Watch Sport - ez is csak egy okosóra

- Pécs és környéke adok-veszek-beszélgetek

- További aktív témák...

- Akció! Hordozható GAMER Monitor! MSI MAG162V ! 15.6 1920x1080 FULLHD! Bolti ár fele!

- Lenovo ThinkPad T14 Gen1 Ryzen5

- Apple iPhone Xs Max 64GB, Kártyafüggetlen, 1 Év Garanciával

- Frederick Forsythe: Isten ökle (nem olvasott)

- ÁRGARANCIA!Épített KomPhone Ryzen 9 5900X 16/32/64GB RAM RTX 5070 12GB GAMER PC termékbeszámítással

Állásajánlatok

Cég: FOTC

Város: Budapest

![;]](http://cdn.rios.hu/dl/s/v1.gif)

Ezek után azért megcsinálták a tesztet mégis, úgy hogy nem passzolt a hűtő, nem tudták rárögzíteni. a szétszerelésnél konkrétan eltörték a nyákot tehát az Kuka, és kijelentették, hogy ez egy szar. Amiután a kommentelők írták, nekik hogy ember nem jól teszteltetek és a startup cég egyik alapítója alákommentelt a videó alá, hogy mennyire fáj neki látni hogy a z egyetlen mérnöki prototípusával így bánnak és rosszul tesztelték.

Ezek után azért megcsinálták a tesztet mégis, úgy hogy nem passzolt a hűtő, nem tudták rárögzíteni. a szétszerelésnél konkrétan eltörték a nyákot tehát az Kuka, és kijelentették, hogy ez egy szar. Amiután a kommentelők írták, nekik hogy ember nem jól teszteltetek és a startup cég egyik alapítója alákommentelt a videó alá, hogy mennyire fáj neki látni hogy a z egyetlen mérnöki prototípusával így bánnak és rosszul tesztelték. ( Linuséknál) és ez csak egy dolog amire rávilágított Jesus, pl a Intel ARC 750 amiben szarrá veri az RTx 4060 kártyát ( mint kiderül teljesen más beállításokkal "véletlenül") meg a 4090 ami 3090 Ti -nél 300% kal volt gyorsabb Linuséknál, valamint nem frissítik a tesztjeiket és még rengeteg dolog ami igazából bicskanyitogató ahogy természetesnek veszi ezt a Linus hogy félrevezeti az embereket, ezek után mindenki hibás csak ő nem, és a poén hogy 1-2 napja banolják redditen az embereket.

( Linuséknál) és ez csak egy dolog amire rávilágított Jesus, pl a Intel ARC 750 amiben szarrá veri az RTx 4060 kártyát ( mint kiderül teljesen más beállításokkal "véletlenül") meg a 4090 ami 3090 Ti -nél 300% kal volt gyorsabb Linuséknál, valamint nem frissítik a tesztjeiket és még rengeteg dolog ami igazából bicskanyitogató ahogy természetesnek veszi ezt a Linus hogy félrevezeti az embereket, ezek után mindenki hibás csak ő nem, és a poén hogy 1-2 napja banolják redditen az embereket.