- A Solidigm elhagyja a végfelhasználókat célzó SSD-k piacát

- Kvantumpontos OLED monitorokkal bővült az ASUS ROG-os portfóliója

- A GravaStar egyedi megjelenésű fémegerei is beléptek az ultrakönnyű szegmensbe

- 520 Hz-es monitorok duója az ASRock védjegyével

- CL 30 alá mennek a G.Skill hamarosan debütáló RAM-jai

- Google Home/Nest

- Házimozi belépő szinten

- 3D nyomtatás

- Milyen asztali (teljes vagy fél-) gépet vegyek?

- Intel Core i5 / i7 / i9 "Alder Lake-Raptor Lake/Refresh" (LGA1700)

- Milyen belső merevlemezt vegyek?

- Fejhallgató erősítő és DAC topik

- Milyen RAM-ot vegyek?

- AMD Ryzen 9 / 7 / 5 / 3 5***(X) "Zen 3" (AM4)

- Milyen videókártyát?

Új hozzászólás Aktív témák

-

HSM

félisten

Még nem lehet kapni. Ugyanakkor semmi olyan nem kell bele, amitől drágább lenne a monitor, mint egy mai akármilyen, ellentétbe a G-sync-el.

Nv VGA-val, ha dinamikus képfrissítés-szinkront szeretnél, akkor csak a G-sync monitor jó, mivel az A-synceseket valamiért nem támogatják.

És nem azt mondom, hogy mindenképpen hozzá kell adni, de ha ilyen monitorban gondolkozik az ember, mint pl. én, akkor ez egy igencsak létező plusszköltség.

(#998) xRagna: Elfogadom.

Ennek ellenére vitathatatlan előnyei vannak. Nekem nagyon bejön.

Ennek ellenére vitathatatlan előnyei vannak. Nekem nagyon bejön.

(#999) Jack@l: A 290-es Radeon egyéves konstrukció, akkoriban az NV sem tett rá HDMI2-t. Ugyanakkor már egy éve rákerült a DP1.2a. Tehát az NV a friss cuccára nyugodtan rátehette volna. Azt is feltételezhetjük, hogy a 2015Q1-es A-sync monitorokig nem fog új csip lépni a GM204-ek helyére.

Ráadásul azt is feltételezhetjük, hogy akik ma ilyen VGA-t vesznek, nem lesznek boldogabbak, ha az övék nem tud valamit, de a friss cucc drágán meg igen, és cserélhetnek megint.

Abba pedig ne menjünk bele, mennyire valós alternatíva játszani a 4K, szerintem nem igazán, kevesek hozzá még ezek a kártyák. Ezzel ellentétben ezek a sync megoldások nagyon is kézzelfogható, azonnal kihasználható előnyöket hoznak.

Ezzel ellentétben ezek a sync megoldások nagyon is kézzelfogható, azonnal kihasználható előnyöket hoznak.

[ Szerkesztve ]

-

Jack@l

veterán

válasz

Zsmester89

#995

üzenetére

Zsmester89

#995

üzenetére

Ennyi...

@HSM: Megértetttük, mit szeretnél mondani az utóbbi 20 hsz-edből, de térjünk már majd vissza akkor, ha alig lesz drágább egy a-sync-es monitor a simáknál ÉS akkor még mindig nem lesz az nv kártyákon DP 1.3. Úgy érzem addig csak szájkarate amiről beszélsz. Kb ugyanaz, mintha azt mondanám szar az ati, mert nem rakott hdmi2-t a kártyájára. (hidd el az nagyobb szívás lesz karácsony környékén, mikor minden jobb bőrben lévő ember 4k-s tévét vesz)

[ Szerkesztve ]

A hozzászólási jogosultságodat 2 hónap időtartamra korlátoztuk (1 hsz / 10 nap) a következő ok miatt: Az ÁSZF III 10/8. pontjának megsértése - trollkodás - miatt. Többször és többen is kértek már, hogy hozzászólás írásakor használd a linkelés funkciót, mert ennek elmaradása sokak számára zavaró.

-

Loha

veterán

Ha téged, mint halandó felhasználót nem érdekel, hogy 50K-val drágábban kapod meg az azonos tudású monitort

Milyen azonos tudásról beszélsz? Lehet már kapni A-Synces monitort 50k-val olcsóbban a G-Syncesnél?

NV VGA-val csak G-Synces monitort lehet használni?Nem folytatsz keresztes hadjáratot, csak egy nem létező 50k-s költséget hozzáadsz a GTX 970 árához, hogy leronts ár/érték arányát...

#996: Szerintem teljesen lényegtelen, hogy licenszre, vagy +kütyüre fizeted a +200dodót.

Szerintem is teljesen lényegtelen a vásárló szempontjából, viszont ha a G-Sync jövőbeni árát akarod megsaccolni, akkor már nem mind1, hogy most azért van 200$-os felára a G-Syncnek, mert drága bele az FPGA vagy az NV kapzsi.[ Szerkesztve ]

-

HSM

félisten

Szerintem teljesen lényegtelen, hogy licenszre, vagy +kütyüre fizeted a +200dodót.

OKé, elfogadom, hogy mikor kijött a G-sync, jó ötlet volt ezzel az FPGA-s cuccal megoldani a kompatibilitást a régi NV kariknak, de az gáz, hogy a vatta új GM204-be sem rakták bele az ehhez szükséges tudást, hogy a fél éven belül megjelenő monitorokkal a 200 dodós G-sync cuccok nélkül is működhessen.... Sehogy nem lesz ez jó a piacnak szvsz.

(#995) Zsmester89: Örülj neki, ha mindenféle szinkron mentes 40FPS boldoggá tesz, mert akkor jóval olcsóbban fogsz tudni játszani PC-n, mint én.

-

Zsmester89

őstag

Jöttök itt A meg G syncel

engem nem érdekel, muzsikáljanak még egy év múlva is 40fps fölött a játékok az 55" full hd-s lcd-men és kész

engem nem érdekel, muzsikáljanak még egy év múlva is 40fps fölött a játékok az 55" full hd-s lcd-men és kész

[ Szerkesztve ]

A "Hogyan lehetsz milliomos?" c. könyvet egy csomagban árusítják a BTK-val.

-

Loha

veterán

Arra válaszoljál, hogy hogyan jön ki a 200$-os licencdíj, amit itt sokan szeretnek emlegetni, amikor maga a cucc önköltsége simán lehet 200$.

Nem volt idő, vagy fel akarták mérni a piaci igényeket és béta tesztelni a cuccot, mielőtt ASIC-ot gyártanak belőle, ahogy más cégek is csinálják, persze ez nem jelenti azt, hogy nem lehet belőle 5$-os ASIC később.

Persze hogy egyszerűbb lett volna 2013-ban beépíteni egy nem létező DP-ot, aztán várni 2015 Q1 -ig amíg csinál hozzá vki monitort is.

Aki Adaptive-Synces monitort fog venni az fogja megfizetni a fejlesztés költségét, mert többieknek jók lesznek a meglévő chippel szerelt monitorok is.

-

HSM

félisten

válasz

#52815360

#992

üzenetére

#52815360

#992

üzenetére

Ha téged, mint halandó felhasználót nem érdekel, hogy 50K-val drágábban kapod meg az azonos tudású monitort, akkor szerencsés vagy.

Én inkább más dolgokra költöm.

Én inkább más dolgokra költöm.Nem folytatok keresztes hadjáratot, csak mint írtam, árnyalom a remek ár/érték arányról szóló nyálban gazdag GTX970 hozzászólásokat, amit kb. minden topikban lehet mostanság olvasni, néha privátban is.

-

#52815360

törölt tag

Nem vagyok Ati-fan, de csak a vak nem látja, hogy itt egy szabványosítás alatt álló technológiát sajátítottak ki. Gondolom, sejted, hogy nem véletlen FPGA a megvalósítás ASIC helyett. Egészségükre, de nem volt ez egy korrekt üzleti húzás, se a többi VESA taggal, se a vásárlóbázisukkal. Aki ezt nem látja, vagy nem lát a szemétől, vagy Nv fanboy.

Engem, mint halandó felhasználót, miért kellene hogy érdekeljen, mit sajátit ki? Felőlem az egész világegyetemet a nevére veheti. Sőt az sem érdekel, ha ugyan azt adja el 20e helyett 30e -ért. 4 év alatt ez kb napi 3 csepp viz ára. Többet is elpazaroltam már. Ami érdekel : fusson rajta ami kell, driver ne keseredjen meg, legyen halk és ne fűtse a szobát, mert az nem az ő dolga. Akinek amd kell amd -t vesz, akinek nv az nv -t vesz. Nem kell itt keresztes hadjáratot vivni mindegy egyes cikk fórumában.

-

HSM

félisten

Minden monitorba kell ez az FPGA a G-synchez. De gondolom sejted, hogy azért FPGA egy ilyen bonyolult cucc, mert ASIC-ot gyártani belőle nem volt idő?

Persze, drága az FPGA, de ők választották ezt a hülye megoldást.

Persze, drága az FPGA, de ők választották ezt a hülye megoldást.Nekik is egyszerűbb lett volna beépíteni a csipbe a DP 1.2a-t, és akkor nem kéne az FPGA. Valamiért mégsem tették. Ebből én csak arra tudok gondolni, hogy vagy technikai, vagy anyagi okokból történhetett ez. Sejthető, hogy inkább az utóbbi.

A skálázócsipek eddig is ott figyeltek a monitorokban, és eddig is kifizetted a fejlesztésük költségét. Most sem lesz másképp, csak a típusuk lesz más.

[ Szerkesztve ]

-

Loha

veterán

Ez a 200$-os licencdíj gondolom onnan jön, hogy ennyibe került az ASUS 248Q monitorához a G-Sync upgrade kit. Nyilván a képen lévő dolgok költsége nulla volt.

Azt is felejtsük el, hogy maga a G-Sync modul nem egy 5$-os ASIC, hanem egy Altera Arria V GX FPGA 768 MB memóriával társítva. A képen lévő egészen konkrétan ez: 5AGXMA3D4F31I3N listaára 810$, de ebből a típusból a legolcsóbb is 190$ körül van.

Ez a lenyúlták a közösből gyorsba, jól hátba szúrva mindenkit meg kész kabaré.

VESA szerint 2009 óta benne van már embedded DisplayPort szabványukban amit nem sikerült 5 év alatt beépíteni az asztali DP-be, tehát nagyon gyorsba kellett lenyúlnia az NV-nak...![;]](//cdn.rios.hu/dl/s/v1.gif)

Adaptive-Sync is a proven and widely adopted technology. The technology has been a standard component of VESA’s embedded DisplayPort (eDP™) specification since its initial rollout in 2009. As a result, Adaptive-Sync technology is already incorporated into many of the building block components for displays that rely on eDP for internal video signaling. Newly introduced to the DisplayPort 1.2a specification for external displays, this technology is now formally known as DisplayPort Adaptive-Sync.

Az meg nyilvánvaló, hogy az MStar, Novatek és Realtek pusztán jótékonysági alapon fejlesztik az új skálázó chipeket az Adaptive-Synchez, és nem fogják a vásárlókra hárítani a költségeket...

![;]](//cdn.rios.hu/dl/s/v1.gif)

Korábban nem úgy volt, hogy csak egy firmware frissítés kell majd FreeSynchez, és minden GCN Radeon támogatni fogja?![;]](//cdn.rios.hu/dl/s/v1.gif)

[ Szerkesztve ]

-

van még olyan topik a pH!-n, ahová nem írtad be legalább 5x, hogy az nVidia lenyúlja a játékosokat 50k-val? szerintem innentől nyugodtan feltételezheted, hogy mindenki tudja, hogy ez a véleményed, kizártnak tartom, hogy lenne olyan user, aki még nem találkozott vele

"We put all our politicians in prison as soon as they're elected." "Why?" "It saves time."

-

HSM

félisten

Volt egy hétig GTX260-am... Egyik játékban az futott szebben, a másikban az utód 4890.

Nem vagyok Ati-fan, de csak a vak nem látja, hogy itt egy szabványosítás alatt álló technológiát sajátítottak ki. Gondolom, sejted, hogy nem véletlen FPGA a megvalósítás ASIC helyett. Egészségükre, de nem volt ez egy korrekt üzleti húzás, se a többi VESA taggal, se a vásárlóbázisukkal. Aki ezt nem látja, vagy nem lát a szemétől, vagy Nv fanboy.

Az pedig végképp lehúzás a köbön, hogy még a friss csipjükbe se rakták bele az A-synchez a DP1.2a-t. Az AMD 290-esében egy éve benne van.

[ Szerkesztve ]

-

parampa

aktív tag

Egyáltalán nem használok V-sync-et és nem is tervezem.

UT99-ben 250FPS a max, nem 30 - 60FPS és nem is

mobil alkalmazásokról van szó. Majd ha kiforrt és elterjedt

lesz az A-sync technológia és stabil marad magasabb FPS

tartományban is akkor visszatérünk erre a kérdésre.Tehát nem nyúltak le semmit, a G-sync a saját megoldásuk.

Köszönjük ezt is megértük egy ATI fan-tól.

Sok ATI kártyám volt és szerettem is öket, nem rosszak.

Én nem fogok átmenni ócsárolni az új AMD kártyákat .

A vidia érzetre stabilabb folyamatos/egyenletesebb, 'smooth'.

Intel & Vidia .

-

HSM

félisten

Nem mondtam, hogy válts Ati-ra. Ott van Nv-n is a G-sync, sőt, azt már ma is meg lehet venni.

Azt az 50 rugót szépen kifizettetik veled a monitor árába beépítve. Nem fogja a monitorgyártó ingyen adni a monitort, miután 200 dollárt perkált az Nv-nek a G-syncért.

Azt az 50 rugót szépen kifizettetik veled a monitor árába beépítve. Nem fogja a monitorgyártó ingyen adni a monitort, miután 200 dollárt perkált az Nv-nek a G-syncért.

Nem a G-syncet nyúlták le a közösből, hanem a VESA szabványtervezetéből gyúrták össze gyorsba a G-syncet, megelőzve az ipari szövetség szabványos megoldását a piacon, a saját szövetségüket hátbaszúrva.

[link][link][link].Ami az Nv pro-kat illeti, teljesen stabil a framerate az Atikon is, nézz nyugodtan netes framrate teszteket, van már pár szerencsére. A legjobb játékok tökéletesen futnak Atin is. A fogyasztás pedig csak a Maxwell-en lett szignifikánsan jobb, a korábbi gennél elhanyagolható volt a különbség.

-

parampa

aktív tag

SwapInterval=0 // 0 means Vsync off, 1 means Vsync on (will cause mouse imput lag) [link]

UT-ben biztosan így van. Meglátjuk élesben mit tud G/A-sync.

Nem hiszm hogy neked kell azt az 50 rugót leperkálni.

Gondolom nem a G-sync -et 'nyúlták' le a közösböl.NEM váltok ATI-ra!

Nv pro: stabilabb framerate, kissebb fogyasztás, a legjobb játékok támogatása! -

Zsmester89

őstag

Nekem most egy régi 4xxx giga van a gépemben, semmi probléma vele, de az új kariból Asus-t gondoltam (980 strix) a halk venti és a minőség miatt.

Bár most, hogy megnéztem ezt a videót, már elgondolkodtató a giga is

A "Hogyan lehetsz milliomos?" c. könyvet egy csomagban árusítják a BTK-val.

-

HSM

félisten

Nem minden játékban... Másfelől, épp ez lenne a lényege ennek az A-syncnek és G-syncnek, hogy ne legyen extra lag, de képtörés sem.

Én pl. utálom a képtörést, sokat ront a képminőségen, a v-syncet meg sokszor nem tudom használni a késleltetése miatt, szóval igencsak várom ezt a dolgot.

Én pl. utálom a képtörést, sokat ront a képminőségen, a v-syncet meg sokszor nem tudom használni a késleltetése miatt, szóval igencsak várom ezt a dolgot.  Viszont eszem ágában sincs az NV-nek a 50 rugót fizetni azért, mert a VESA-közösből lenyúlt technológiát hamarabb piacra dobták, mint a szabványos, licenszdíj-mentres technológiát.

Viszont eszem ágában sincs az NV-nek a 50 rugót fizetni azért, mert a VESA-közösből lenyúlt technológiát hamarabb piacra dobták, mint a szabványos, licenszdíj-mentres technológiát. -

Jack@l

veterán

Ez külső szoftveres addon a játékhoz, én se tudom igazból hogy csinálják, de vsync off mellett sincs csíkozódás, se megugrás.

[ Szerkesztve ]

A hozzászólási jogosultságodat 2 hónap időtartamra korlátoztuk (1 hsz / 10 nap) a következő ok miatt: Az ÁSZF III 10/8. pontjának megsértése - trollkodás - miatt. Többször és többen is kértek már, hogy hozzászólás írásakor használd a linkelés funkciót, mert ennek elmaradása sokak számára zavaró.

-

HSM

félisten

Fogalmam sincs, mit művelhettek az Asetto Corsa-ban, de hogy ezt nem tudják hardveres támogatás nélkül megvalósítani, arra mérget vehetsz. Nem tudsz a monitor blankolási idejével játszani, ha nem ad hozzáférést. Ehhez kell a megfelelő display controller, driver support és 1.2a DP. Ezt pl. a 290-es, 285 meg mégegy kisebb Radeon (asszem 260) már tudja, és a monitorok is érkezőben hozzá.

Nv ezt a saját G-sync moduljával oldotta meg a csip display controllere helyett.

Szóval 290-el nem kell ehhez új kártya, csak kompatibilis monitor. Amiatt meg nem aggódom, eladom a régit, rádobok kicsit és meg van oldva.

-

Jack@l

veterán

Én meg csak ezért nem veszek se új monitort, se új kártyát... Van szoftveres async is, működött rendesen assetto corsában.

A hozzászólási jogosultságodat 2 hónap időtartamra korlátoztuk (1 hsz / 10 nap) a következő ok miatt: Az ÁSZF III 10/8. pontjának megsértése - trollkodás - miatt. Többször és többen is kértek már, hogy hozzászólás írásakor használd a linkelés funkciót, mert ennek elmaradása sokak számára zavaró.

-

HSM

félisten

Pedig minőségi előrelépés lesz.

Persze, én is így vagyok vele, 15 évig elvoltam nélüle, mostmár kibírok pár hónapot, de egyáltalán nem tervezem, hogy ezt az innovációt kihagyjam.

Persze, én is így vagyok vele, 15 évig elvoltam nélüle, mostmár kibírok pár hónapot, de egyáltalán nem tervezem, hogy ezt az innovációt kihagyjam.  Ahogy jönnek elfogadható árú, jóminőségű IPS monitorok A-synccel, én megyek és veszek.

Ahogy jönnek elfogadható árú, jóminőségű IPS monitorok A-synccel, én megyek és veszek.  Márpedig borítékolható, hogy jönni fognak.

Márpedig borítékolható, hogy jönni fognak.A GM204-es nem tud 1.2a-s DisplayPortot, szóval a két hónap múlva kiadott GM204-es kártyák se fogják tudni, ilyesmit friss revízióval se szoktak javítani.

Marad a G-sync és a tejelés Nv fronton.

Marad a G-sync és a tejelés Nv fronton.Ami a kijelzőket illeti, 2015 első negyedévére vannak időzítve: [link].

-

Jack@l

veterán

Az elmúlt 15 évben megvoltam adaptív sync nékül, szimplán nincs rá szükségem 60+ frame-nél (de még 50-nél sem

)

)

Megint egy ph-s riogatás, szánalmasan egyoldalú tájékoztatást nyújt az oldal. Senki se tudja, hogy a pár hónappal ezután kiadott kártyákon milyen display port lesz, de azt hiszem amíg a kijelzőkön sincs 1.3 addig rohadtul nem számít a hiánya...

Ahogy a tiled resource miatt is hogy szörnyülködött mindenki, közben az első játék ami használni fogja, 2015 közepén jön.[ Szerkesztve ]

A hozzászólási jogosultságodat 2 hónap időtartamra korlátoztuk (1 hsz / 10 nap) a következő ok miatt: Az ÁSZF III 10/8. pontjának megsértése - trollkodás - miatt. Többször és többen is kértek már, hogy hozzászólás írásakor használd a linkelés funkciót, mert ennek elmaradása sokak számára zavaró.

-

HSM

félisten

válasz

Televan74

#973

üzenetére

Televan74

#973

üzenetére

Értem én, csak így máris 50K-val drágább a 970, és úgy már igencsak nem versenyképes ár/értékben egy mondjuk 290-el, aminél nem lesz extra licenszköltség a monitorba építve. Persze, le lehet mondani a közeljövő legígéretesebb monitoros fejlesztéséről, de ez azért elég övön aluli.

Az NV-nek persze ez a legjobb, egy fél csúcs VGA-nyi lóvét szednek így ki az emberből a monitoron keresztül.

-

Dtomka

veterán

válasz

balint107

#969

üzenetére

balint107

#969

üzenetére

"Általában nem szoktak lekapcsolni a videokártyák ventijei"

De van amelyiken el sem indul amig nem éri el azt a hőmérsékletet:

MSI GTX 970 Gaming 4G OC Edition -

balint107

aktív tag

Általában nem szoktak lekapcsolni a videokártyák ventijei XD Lehet van egy két speciális eset, aminél már ilyen, de nem sokat oszt szoroz. A GTX 670-emnek alapjáraton, ha nincs terhelve 20-22% ig is lelassul a ventije. ez kb annyi "zajt" okoz, hogy ha egy légy van a szomszéd szobába az zajosabb nála

terhelésen 45% ig megy fel max a legbrutálabb játékok alatt is, a hangja meg úgy 55%-nál indul (kipróbálgattam manuálisan állítva. 60 fölött már kezd kicsit zajosabb lenni 100%-on meg már kifejezetten zavaró hangerőt is tud produkálni, de nekem nyáron 30 Fokos szobámban Crysis 3 alatt 45% körül dolgozott és 65 fok volt a legtöbb, ami lecsekkoltam alatta. Szóval soha nem fog annyira felpörögni a ventije, hogy zavaró legyen, előbb meghallom a tápot és a procihűtőt, mint a kártyát. Játék alatt is picit hangosodik a gép, de a kártyát nem hallani, hanem a táp és a proci hűtő dolgozik jobban. De Chieftec 600W-os táp, nem egy gagyi táp, és Ice Edge mini procihűtő sem rossz, szóval ezzel együtt is csekély zajról beszélhetünk.

terhelésen 45% ig megy fel max a legbrutálabb játékok alatt is, a hangja meg úgy 55%-nál indul (kipróbálgattam manuálisan állítva. 60 fölött már kezd kicsit zajosabb lenni 100%-on meg már kifejezetten zavaró hangerőt is tud produkálni, de nekem nyáron 30 Fokos szobámban Crysis 3 alatt 45% körül dolgozott és 65 fok volt a legtöbb, ami lecsekkoltam alatta. Szóval soha nem fog annyira felpörögni a ventije, hogy zavaró legyen, előbb meghallom a tápot és a procihűtőt, mint a kártyát. Játék alatt is picit hangosodik a gép, de a kártyát nem hallani, hanem a táp és a proci hűtő dolgozik jobban. De Chieftec 600W-os táp, nem egy gagyi táp, és Ice Edge mini procihűtő sem rossz, szóval ezzel együtt is csekély zajról beszélhetünk.[ Szerkesztve ]

-

huskydog17

addikt

válasz

FragMaster

#967

üzenetére

FragMaster

#967

üzenetére

Nocsak, ez a PH teszt megjelenésekor még nem szerepelt a cikkben, de most látom, hogy utólag a PH tesztben is szerepel. Király!

Végre észhez tért az NV DX fronton!Akkor a fejlesztőknél már semmi nem áll a DX 11.x útjában.

Köszi az infót!

Akkor így már az új Maxwell piszok jó termék lett, nekem nagyon tetszik!

[ Szerkesztve ]

Gameplay csatornám: https://www.youtube.com/channel/UCG_2-vD7BIJf56R14CU4iuQ

-

FragMaster

addikt

válasz

huskydog17

#966

üzenetére

huskydog17

#966

üzenetére

TR-t a frissített maxwell is támogat, méghozzá Tier 2 szinten. [link]

"FragMaster felhasználónak 11 pozitív és 0 negativ értékelése van a fórumon!": http://goo.gl/vYc6Ml

-

huskydog17

addikt

A Get Even játékhoz a The Farm51 a DirectX 11.2-t fogja alkalmazni, azon belül is a Tiled Resources-t, tehát hardveres támogatást fognak rakni a megatextúrázáshoz, amit a MachineGames-nek és a Tango Gameworks-nek is alkalmaznia kellene.

A Get Even játékhoz tehát mindenképp GCN Radeon fog kelleni, ha a játékos a lehető legjobb élményt szeretné, mivel a Tiled Resources-t csak a GCN-ek támogatják.Amúgy én is úgy gondolom, hogy a jövő évben ez lehet az egyik nagy gyöngyszem, nagyon várom ezt az alkotást.

Gameplay csatornám: https://www.youtube.com/channel/UCG_2-vD7BIJf56R14CU4iuQ

-

blu79

addikt

sziasztok, mit szóltok a PALIT GTX970-hez , a JetStream-nek az egyik legszebb hűtése van nem? és a boost órajel 1304 nem semmi

![;]](//cdn.rios.hu/dl/s/v1.gif)

¯\_(ツ)_/¯ = G-sync 165Hz ips 1440p « Ahogy a programozók készítik programjaikat, az első jöttment harkály lerombolhatná az egész emberi civilizációt »

-

Crytek

nagyúr

válasz

huskydog17

#961

üzenetére

huskydog17

#961

üzenetére

Arra azért kíváncsi lennék hogy egy "rendes" játékként amiben történik is valami (ebben ugye szinte semmi )harc robbanások ,autozás akár fpsként akár rpg-ként müködne ez a fotosgrafikás felépités ugyanilyen csekély gépigny mellett.

Mert a Dear Esther is nagyon jól néz ki pedig az is csak egy ezer éves engine csak abban sem történik semmi ami számítás igényelne...Abban bizom hogy ettőla csapattól még fogunk látni 1-2 hasnoló jóságot mert ugy néz ki működik a dolog.

A másik ilyen fotos cucc a Get Even lesz bár kétlem hogy ott ilyen 0 gép is elég lesz majd!Next PC Upgrade: 2022

-

Jack@l

veterán

Belenéztem a játék trailerébe, ez az a tipikus nextgen konzol szintű "csoda" grafika. Amúgy nem csúnya, le a kalappal előttük, hogy jól futó játékot kreáltak dx9-en.

http://www.youtube.com/watch?v=9oxbkL3N_fMA hozzászólási jogosultságodat 2 hónap időtartamra korlátoztuk (1 hsz / 10 nap) a következő ok miatt: Az ÁSZF III 10/8. pontjának megsértése - trollkodás - miatt. Többször és többen is kértek már, hogy hozzászólás írásakor használd a linkelés funkciót, mert ennek elmaradása sokak számára zavaró.

-

Cassi

őstag

válasz

balint107

#952

üzenetére

balint107

#952

üzenetére

Az egyik helyen azt írta valaki, hogy a GB G1 970 ventilátora nem kapcsol le alapjáratban, ezért kicsit zavaró a hangja, míg az Asus (Strix) és az MSI például teljesen lekapcsol. Ezt valaki lecsekkolhatná, hogy igaz-e, mert sajnos a hűtés nagyon fontos, ha ez igaz, akkor nem éri meg a 2fps különbségért. Most GB 760 van a gépemben és semmi baj sincs vele, de sajnos egyik márkában sem lehet megbízni, mindnek voltak már problémás szériái.

-

huskydog17

addikt

+1!

Ez a 19 eurós játék az AAA címek túlnyomó többségét nevetség tárgyává teszi.

A The Astronauts most jó alaposan lealázta a legnagyobb stúdiókat és jól bemutatott nekik, hogy hogy is kell egy piszok jó és elképesztően szép játékot létrehozni rendkívül baráti gépigénnyel.

Bizony, itt látszik, hogy a játék PC-exkluzívnak készült és aként is született.Milyen jó is látni, hogy kis 8 fős lengyel stúdió sz*rrá veri a legtöbb nagy stúdiót minőség terén.

Emlékszünk még a Flying Wild Hog-ra? Náluk ugyanez volt: néhány emberke 2011-ben újjáélesztette a hosszú évek óta halottnak hitt klasszikus FPS stílust. Ők akkor megcsinálták azt, amit a nagyoknak nem sikerült.

Ezek után teljesen értetlenül állok az egykori legendás Monolith stúdió húzása előtt, miszerint 6 GB VRAM-ot igényel az új játékuk Ultra szintje. A Tango Gameworks pedig szintén szánalmas gépigényt közölt a The Evil Within-hez. Fogadni mernék, hogy ők sem fogják alkalmazni a Tiled Resources-t az id Tech5-ben.

Gameplay csatornám: https://www.youtube.com/channel/UCG_2-vD7BIJf56R14CU4iuQ

-

balint107

aktív tag

Oké, lehet azt nem próbáltam még, és nem is fogom Nvidia párti lettem miután egy VTX3D 7870 kikészített a teavíz majdnem 90 fokos fortyogásával 10 perc játék után, illetve mindenféle túlzás nélkül szó szerint 5 perc után fejet fájdító zúgásával. A csere kártya R9 270X vapor X hűtéssel sapphire alatt (amire korábban 3870 és 6750 alatt semmi panasz nem volt) most tudott az is zúgni, mint a b*rom, meg GTX 650 szintet hozott a gépembe, ami nem feltétlen a kártya hibája volt, bár nem derült ki.

Szóval én azt mondtam radeont többet nem fogok venni, és harmadszorra a pénzemet "visszakötvetelve" giga GTX 660-al váltottam végül a giga GTX 650-et és láss csodát megint álom volt minden, illetve az nem volt az h erősebb kártyát terveztem volna, de már nem akartam megkockáztatni egy drága melléfogást, így később mikor Full HD monitort vettem, be kellett szereznem egy GTX 670 Giga-t és láss csodát megint tökéletes minden a szintjéhez képest. De közben volt egy fordulóm Asus DCU II GTX 760-al az azért tudott 72 fokig is melegedni, így hát eladtam és jól jöttem ki mert még drágábban is mint hozzájutottam...

Szóval nagyon jó ezek a mások tapasztalatai, de én a sajátjaimat előrébb helyezem, és aztán azt mondom el. Attól, hogy rajtam kívül egy topikban (nem célzok erre a jelenlegire) 10-en szidják és csak én dicsérem, attól még nem fogom másként gondolni, vagy nem lesz másként, hogy az utóbbi időben 8 kártyából 3 ban csalódtam és 5-ben nem, ami 5 egytől egyig gigabyte volt. (GTX 650 2 GTX 660, próba 7850, GTX 670)

Szóval ha engem kérdeztek Nvidia Gigabyte WF (én sem referencia hűtés mert olyan is van) és OC, ha van opció Rev 1 vagy rev 2 akkor lehet inkább a rev 2, de a 670-em az Rev 1 és tökéletes.

[ Szerkesztve ]

-

balint107

aktív tag

Megmondom őszintén én nem ismertem még a Gigabyte-ot abban az időben mikor még a GTX 500-as és a redeon 6000-es széria volt. Gigabyte GTX 650 volt az első Gigabyte kártyám annak már tökéletes hűtése volt. 60 fokig sem melegedett és a ventinek sem volt semmi hangja. Utána volt 2 GTX 660-asom is, azok hasonlóan jók voltak WF 2 (2 ventis hűtéssel) illetve a GTX 670 WF 3-al. Ha jól tudom a WF 3 hűtés a 600-as szériától( 670 680) illetve a radeon 7870-től lépett be, szóval az még teljesen más technológia lehetett. Illetve rossz nyelvek beszélik, hogy radeon oldalon annyira a Gigabyte-t hűtés sem jó, de nem volt még WF3-as R9 280X vagy 290X kártyám így erről nem tudok nyilatkozni. Radeon 7850 WF2-vel próbáltam az is tökéletes volt.

[ Szerkesztve ]

-

Zyrius

aktív tag

válasz

balint107

#956

üzenetére

balint107

#956

üzenetére

Szerintem is a Giga lesz a legjobb, de kicsit félek tőle az alábbiak miatt:

-A mostani HD 6850-es giga kártyám ami 4 éve van nálam elég zajos gyári hűtővel rendelkezett (cseréltem)

-A Coil whine hang elég masszívan hallatszik belőle, tartok tőle, h a giga erre nem fordít megfelelő figyelmet.

-Ha jól tudom nincs magyarországi giga képviselet 1 éve, szóval bármilyen meghibásodás esetén körülményesebb lehet a gariztatás mondjuk egy asushoz képest.Ha bárki tudja pls cáfolja a fenti félelmeimet, hogy nyugodtan vehessek giga 970-est

https://StellarGear.eu - amatőr csillagászat és asztrofotós bugdácsolások

-

balint107

aktív tag

Gigabyte kártyát nagy divat szidni, csak a szidók 70%-a nem tudja, hogy a legjobb hűtésű halk kártyák a piacon, még úgy is, hogy a legnagyobb gyári tuninggal rendelkezik az Oc változat. Csak hallottak ezt azt innen onnan így hibásodott meg úgy hibásodott meg, és a vége az lesz lassan, hogy ne tegyél ilyet a gépedbe mert felrobban tőle XD... 3 év garancia jár a Gigabyte kártyákra, szóval ha elő is fordulna meghibásodás (ami bármely más gyártónál is ugyanúgy megesik), akkor is biztosított a dolog. Mások költenek inkább plusz ventikre és drága gépházakra, mintsem gigat vegyenek inkább vesznek valami rosszul hűtött melegedő zajos kártyát, és büszkék magukra, hogy nekik olyan van, és köpködnek a gigara, egészségükre ő bajuk

[ Szerkesztve ]

-

Jack@l

veterán

Ha nem hullik szét 1 év alatt, akkor semmi.

UI: ahogy látaom, ezeken a kártyákon elég foghíjasok azok a ram kockák, nagyon kínálják a 8 gigás lehetőséget.[ Szerkesztve ]

A hozzászólási jogosultságodat 2 hónap időtartamra korlátoztuk (1 hsz / 10 nap) a következő ok miatt: Az ÁSZF III 10/8. pontjának megsértése - trollkodás - miatt. Többször és többen is kértek már, hogy hozzászólás írásakor használd a linkelés funkciót, mert ennek elmaradása sokak számára zavaró.

-

FragMaster

addikt

válasz

balint107

#947

üzenetére

balint107

#947

üzenetére

Nem én akarok lenni az a balhere aki megmondja, mégis: nincs a Crysisnek valami topicja, ahova ezeket be lehet írogatni ontopicban a fél oldalnyi beállításról szóló képekkel együtt?

"FragMaster felhasználónak 11 pozitív és 0 negativ értékelése van a fórumon!": http://goo.gl/vYc6Ml

-

balint107

aktív tag

kipróbáltam már MSAA-n is a Crysis 3- at sőt 8 MSAA-n is 15 FPS-el XD, de a grafikát nagyon nem turbózza fel, csak eltűnik az éleknél a mosódás, ha volt előtte, vagy mérséklődik. De ha megnézed a maldo HD-t az ő élsimítása is FXAA. Szóval ezzel sincs előnyben. Azt nem mondom, hogy nem kellne el neki MSAA esetleg, mert mondom lehet hiányolni a képi világból, valószínű a nagyon magas textúrák miatt amik nagy látótávolságig élesek, jön elő a dolog. Az alap játék már régen homályos paca volt, mikor ez még tű éles képet ad, ezért is nem hiányzott az alap Crysis 2-ből az élsimitás

[ Szerkesztve ]

-

HSM

félisten

válasz

balint107

#945

üzenetére

balint107

#945

üzenetére

Az FXAA összemossa a képet, az nem élsimítás, hanem kb. egy képernyőmosás. Persze, így az élek is összemosódnak, a bibi, hogy minden más is. Crysis3-at vagy AA nélkül, vagy SMAA-val érdemes tolni. Persze, a 290-es Radeonomat is megizzasztja úgy, de legalább élvezhető a képi világ.

-

balint107

aktív tag

Oké

De arról nem én tehetek, hogy a Crysis 2 Maldo HD olyakor 60 FPS-el vagy még afölött ki akar szaladni a világból maximum beállításon, a Crysis 3 meg FXAA-n is alig éri el a 30 FPS-t GTX 670-el XD A Fraps lassító erejéről meg ne is beszéljünk. XD

Amúgy az FXAA vagy 8msaa nem a textúrákat élesíti, hanem az élek mosódását. De nem rég meg is mondta valaki, hogy Full HD mellett fölösleges a nagy élsimítás, ez nem az én véleményem volt

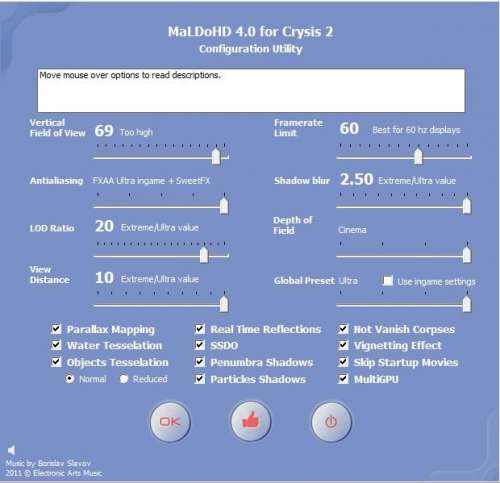

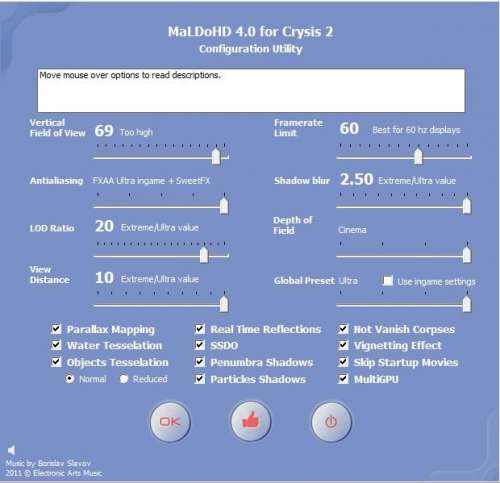

Egyébként itt vannak a Maldo HD beállításai.

Itt sincs egy hűde nagy élsimitás a 8 MSAA hoz képest. Az alapjátéknak meg egyáltalán nincs. De nem tűnik fel a dolog, szóval egy minimális mosódás látszik a maldo HD esetében az éleknél, akkor is ha kiveszem vagy ha maxra teszem. Maxon viszont van SweetFX effekt, ami érezhetően szebbé teszi a színeket és az árnyékokat azért szoktam felnyomni.

Egyébként ezek mellett a beállítások mellett nem szabad bolygani az alap játék Advanced video optionsát, mert amit átálított ott Extreme-ről Ultrára az alap játék ultra beállításai lesznek mérvadóak, az meg gyengébb, mint a maldoHD-é.[ Szerkesztve ]

-

-

balint107

aktív tag

válasz

balint107

#867

üzenetére

balint107

#867

üzenetére

Még egy utolsó prezentáció élesben egymás után a két Crysisról. Döntse el mindenki a saját ízlése szerint melyik az jobb, én a modolt Crysis 2-re szavazok. Arról meg már szót sem akarok ejteni, hogy a Crysis 2 ezzel a grafikával elmegy egy GTX 660-on is a Crysis 3 meg egy GTX 780-on is alig :S

-

Crytek

nagyúr

Ezeknek az elmehibbant elvetemült VRAM gyilkos játékoknak megjelent az ellenkezője.

A világ legjobban optimalizált játékai közé be is írta magát.A kinézet/ gépigény mindent szarráver.The Vanishing of Ethan Carter.

Az én otvar gépemen is jól fut maxon.

Le a kalappal a készitők előtt főleg hogy " csak " DX9-es.[ Szerkesztve ]

Next PC Upgrade: 2022

-

Rathrol

senior tag

Milyen vga hűtőt ajánlanátok nekem EVGA GTX 970-re? Sajnos ACX 1.0 hűtése van, elég hangos és szeretném cserélni, mivel írták hogy a gyári hűtését szabadon lehet cserélni gari vesztés nélkül, így beruháznék egy jobbra és csendesebbre!

-

djgeg

őstag

válasz

Zsmester89

#935

üzenetére

Zsmester89

#935

üzenetére

Aztán reméljük nem olyan kamu marketing mint a kedves COD nál volt

(Persze az sima ram volt... de ma már bármit kinézek ezekből... )

(Persze az sima ram volt... de ma már bármit kinézek ezekből... )[ Szerkesztve ]

"640 kByte memória mindenre elegendő"

-

Televan74

nagyúr

válasz

Zsmester89

#935

üzenetére

Zsmester89

#935

üzenetére

Majd jövőre egy top kártyán alap lesz a 8GB ram.Majd a 980Ti -n lesz annyi.

Mindenbe beleugatok!!!

-

Zsmester89

őstag

válasz

X Factor

#933

üzenetére

X Factor

#933

üzenetére

Az első rostélyon tolja kifelé a meleg levegőt, nem?

Amúgy most olvastam, hogy a Middle-Earth: Shadow of Mordor-nek ultra felbontáshoz kell a 6gb vram

--- én meg azt hittem, ha beruházok egy 980-ra, akkor mindent nyomhatok ultrán full hd-ban 1-2 évig

--- én meg azt hittem, ha beruházok egy 980-ra, akkor mindent nyomhatok ultrán full hd-ban 1-2 évig  naív..naív

naív..naív

A "Hogyan lehetsz milliomos?" c. könyvet egy csomagban árusítják a BTK-val.

-

Reggie0

félisten

válasz

Zsmester89

#932

üzenetére

Zsmester89

#932

üzenetére

A kartyak kozotti resekbol. Csodak nincsenek, igy jelentosen romlik a hutes hatekonysaga, erdemes lehet minden masodik kartyat riserrel kiemelni.

-

X Factor

addikt

-

stratova

veterán

Ha már a 4K felbontás szóbakerült

Ínyenceknek: Nvidia GeForce GTX 980 SLI / 3-way SLI / 4-way SLI review -

fRooStzzZ

senior tag

válasz

westlake

#925

üzenetére

westlake

#925

üzenetére

Kulonosebben engem sem erdekel, de sokan tudjuk, hogy ennel kisebb kartya is eleg egy fhd-ra.

Szerintem azert mar vannak paran, akik nem csak fhd-n jatszanak, hanem magasabb felbontason, illetve tobb monitoron. 7870-el en elvagyok jelenleg is, igaz nem mondom hogy mindenre eleg, de szerintem ez menne tobbet is. (regen i7 3820, r4e lap, 16gb 1866 ram + 6950)

Most amd 760k, G 7870 oc es lassabb minden. Gondolom a proci nem eleg hozza, ezt barmely jatek / teszt amit futattam alatamasztotta, hogy a 6950 erosebb volt a masik konfiggal. (nehol nem is kicsivel)[ Szerkesztve ]

-

Locutus

veterán

-

-

stratova

veterán

válasz

Atom_Anti

#907

üzenetére

Atom_Anti

#907

üzenetére

Szerintem az R9 290X árát 300$ alá nem nagyon viszik. 1080P-ben tényleg parádésak az új GTX-ek, de magasabb felbontáson már nem ennyire egyértelmű az előny, a 980 ott is tartja magát. 1080P-re viszont a 970 most tényleg elég jó vétel lett. SLI-ben mindkettő ütős lehet magasabb felbontáson is, ha az adott játékban jól skálázódik.

(#918) Crytek:

[ Szerkesztve ]

-

fRooStzzZ

senior tag

Ahogy neztem, magasabb felbontason azert nincs annyi elonyuk, sot, ott hatvanyozottan romlik.

fhd-n eleg nagy kulonbsegek vannak a 290x-es a 9x0 kartyak kozott, de egyel magasabb felbontason ez vagy csokken, vagy atveszi az amd a vezetest..

4k-n is lehetett volna kis teszt belole, bar meg ezek a kartyak eppen elegek lennenek szerintem ahhoz a felbontashoz. -

Abu85

HÁZIGAZDA

Az Ubisoft rendelkezik Mantle SDK-val. Itt a probléma annyi, hogy amikor kiadják az új játékokat, akkor még nem lesz DX12, tehát nem lehet szállítani rá a támogatást. Ez független attól, hogy érdekli-e a céget vagy sem. Nyilván nagyon érdekli, de leghamarabb a következő év végén lehet rá játékot építeni.

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Dtomka

veterán

-

Abu85

HÁZIGAZDA

Az AC Unity nem tartalmaz nem szabványos dolgot. Azok mindenen futni fognak. A minőség az más tészta. Nyilván az Ubisoft fő stúdiója az Ubi Montreal, és az Ubi Kiev technikai felkészültsége és a rendelkezésre álló erőforrás elmarad a montreáli csapattól, tehát a PC-s porthoz használt dizájn szempontjából biztos, hogy nem fognak olyan szintű munkát végezni, mint a montreáli csapat a két konzolos portnál. Persze az Ubi álláspontja is érthető. A konzolhoz tervezett tartalom önmagában jobb lehet, míg a PC-nél a DX11 limitációiba is bele kell férnie, tehát trükközni kell a működéssel és a textúrákkal a megfelelő minőségi szint eléréséhez.

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

Atom_Anti

#907

üzenetére

Atom_Anti

#907

üzenetére

Nem fogják. Nincs értelme, mivel mostantól stratégiailag nem reagálnak egymásra. Arra törekednek, hogy xy játékba minél több exkluzív funkciót építsenek. Ezzel lényegében mindkét hardvert meg kell venned, ha mindent maxon és gyorsan szeretnél futtatni.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Crytek

nagyúr

válasz

Atom_Anti

#907

üzenetére

Atom_Anti

#907

üzenetére

Szerintem olyan szintre nem igen csökkentik soha. Amíg veszik drágábban nincs értelme.

Az hogy melyik a jobb mindenki otthon döntse el saját maga mert az ember nem tudja melyik tesztoldalnak higgyen.

Van amelyiken a 970 szinte mindenhol a maga mögé utasítja a 290X-et van ahol a 970 1-2 helyen alig jobb a többinél elvérzik ...stb. Otthon saját gépbe saját környezetbe kell kitapasztalni ahol van minktér vga és ott eldönteni melyik a jobb vétel.Next PC Upgrade: 2022

-

Atom_Anti

senior tag

Vajon Amd mikor fogja a 290x árát olyan 250 dollár szintjére csökkenteni? Jelenleg a 330 dolláros 970 sokkal jobb vétel...

-

balint107

aktív tag

-

Jack@l

veterán

Attól függ mennyi double számítást végez az a renderelő. (ha jóltom jhava részük sima float-ot használ) 980-ra szavaznék, márcsak a több ram miatt is. Addig meg kiderül mitől errorozik a bétás driver renderelés alatt...

A hozzászólási jogosultságodat 2 hónap időtartamra korlátoztuk (1 hsz / 10 nap) a következő ok miatt: Az ÁSZF III 10/8. pontjának megsértése - trollkodás - miatt. Többször és többen is kértek már, hogy hozzászólás írásakor használd a linkelés funkciót, mert ennek elmaradása sokak számára zavaró.

Új hozzászólás Aktív témák

ph Leteszteltük az NVIDIA legújabb, GM204 GPU-jára épülő VGA-ját, amely referencia kivitelben érkezett hozzánk.

Állásajánlatok

Cég: PCMENTOR SZERVIZ KFT.

Város: Budapest

Ennek ellenére vitathatatlan előnyei vannak. Nekem nagyon bejön.

Ennek ellenére vitathatatlan előnyei vannak. Nekem nagyon bejön.

engem nem érdekel, muzsikáljanak még egy év múlva is 40fps fölött a játékok az 55" full hd-s lcd-men és kész

engem nem érdekel, muzsikáljanak még egy év múlva is 40fps fölött a játékok az 55" full hd-s lcd-men és kész

![;]](http://cdn.rios.hu/dl/s/v1.gif)

Persze, én is így vagyok vele, 15 évig elvoltam nélüle, mostmár kibírok pár hónapot, de egyáltalán nem tervezem, hogy ezt az innovációt kihagyjam.

Persze, én is így vagyok vele, 15 évig elvoltam nélüle, mostmár kibírok pár hónapot, de egyáltalán nem tervezem, hogy ezt az innovációt kihagyjam.