Hirdetés

- Philips LCD és LED TV-k

- Lenovo Legion és IdeaPad Y széria

- NVIDIA GeForce RTX 5080 / 5090 (GB203 / 202)

- Az SK Hynix elárulta, hogy meddig nem lesz elég memória

- Nikon Z MILC fényképezőgépcsalád

- Fejhallgató erősítő és DAC topik

- Azonnali VGA-s kérdések órája

- Projektor topic

- NVIDIA GeForce RTX 5070 / 5070 Ti (GB205 / 203)

- Vezeték nélküli fülhallgatók

Új hozzászólás Aktív témák

-

X2N

őstag

Apa kezdődik.

RTX 5090 Saved From Connector Melting With ASRock’s $40 Cable Despite Pulling 1350WShunt-moddolt MSI RTX 5090 Ventus-on ment 20 kör benchmark és már elkezdett leégni a csatlakozó amit itt sikernek állítanak be

-

X2N

őstag

válasz

Kolbi_30

#50544

üzenetére

Kolbi_30

#50544

üzenetére

Steve-ék csináltak egy 2025-ös évértékelőt/összefoglalót, volt itt minden, hiányzó ropok a leégő csatlakozós nvidia kártyákon, MSRP ártól 20-45%-al drágább Radeon 9000-es kártyák launchkor, nem működö nvidia physx az 50-es kártyákon, meg driver bugok tömkelege mert már az AI írja a drivert az nvidiánál, maga Jensen mondta

Asrockba beleégett ryzenek, tarifák, Asus botnet routerek, Intel leépítés...

Ha az a cél h tönkretegyék a DIY pc piacot jó irányba haladunk. -

X2N

őstag

válasz

T.Peter

#50539

üzenetére

T.Peter

#50539

üzenetére

Tippre nem sok újrahasznosított van. 1-1 komolyabb fegyver modell csak magában 10-15GB-is lehet tömörítés nélkül(új COD-ban pl.)

proci985-Komolyabb szimulátorhoz(Assetto,DCS,Arma) jól jön a 16 mag, nálam 5GHz-en megy, az a sweet spot jó fogyasztással(120W) alulfeszelve (1.15V).

Anno elég komolyan megtuningoltam a 96GB ramot is, de inkább visszatettem gyárira, jobb a békesség. -

X2N

őstag

válasz

T.Peter

#50534

üzenetére

T.Peter

#50534

üzenetére

Már h ne lenne, "a legnagyobb reszet a vram-nak mindig a texturak foglaljak el,"

Meg a helyet is a háttértárolón. Már ha tényleg jó minőségű textúrákról van szó.

Megmutassam a 150GB-os mappámat amiben a 3D rendereléshez vannak modelleim meg textúrák? (most néztem, a 150GB az csak a textúra, +70GB a modell

(most néztem, a 150GB az csak a textúra, +70GB a modell  )

)Persze amikor játékban rá van tolva az antialiasing maximális teljesítménnyel, meg megy a felskálázás akkor adsz a képminőségnek egy jó nagy pofont.

-

X2N

őstag

Amikor megjelent leszedtem, meg felnéztem nexus-ra UE5 konfig file-okért amivel kimaxoltam a grafikát a gyárihoz képest is sokkal jobban nézett ki, messzebbre rajzolta ki a vegetációt, árnyékokat, meg részletesebb volt minden, stb, nem ájultam el még így se tőle, szokásos TAA mosoda, 2-3 óra bőven elég volt belőle hogy mindent kiderítsek ami érdekelt, ez nem stalker, ez egy far cry, stalker skinnel. Nem érte meg akkor a teljes árát így nem vettem meg még. Nézted benne a fákat? Azok nem fák, csak kis termetű fák. Nevetségesen néznek ki, túl kicsik, ráadásul az egész világ fel van nagyítva méretbe...

-

X2N

őstag

55 GB, az elég baráti manapság. TPS-játék, nem kellenek bele nagy felbontású textúrák mint egy FSP-nél, a kamera miatt. Megúszós.

A stalker 2-t tudtam h fel fogod hozni

, arról inkább ne is beszéljünk nem használja ki a nanite-ot a vegetációra, majd ha eléri a 2.0 verziót és az újabb verziós UE-n fut meg az AI life 2.0 benne lesz ahogy megigérték majd ránézek.

, arról inkább ne is beszéljünk nem használja ki a nanite-ot a vegetációra, majd ha eléri a 2.0 verziót és az újabb verziós UE-n fut meg az AI life 2.0 benne lesz ahogy megigérték majd ránézek. -

X2N

őstag

Egyébként ha 4k felbontást nézem akkor még mindig van 10% különbség teljesítménybe a 2 kártya között raszterbe.

Ez az állításod az UE5-el addig lesz igaz amíg nem lesz egy igazán komoly open world játék, mert messzemenő következtetéseket én nem vonnék le a jelenlegi cső játák címekből.

Itt is 13.5GB a vram használat, moddolt CP2077-szeret 20GB felett foglalni, és már készül a CP2077-Chicago UE5-re.![;]](//cdn.rios.hu/dl/s/v1.gif)

-

X2N

őstag

Ha a procikat megnézem akkor a 7800X3D-449$ MSRP-vel jött ki 2023-áprilisban. 330$ körül meg lehetett venni 2024-ben, majd felment az ára 450$-ig 1 évvel később, most se sokkal olcsóbb, 400$.

9800X3D már $479-al nyitott, 2025-ben 470$ csak néha esett be az ára 440-usd-re.

Középkategóriás kártyát(9070XT) ne hasonlítsunk már 7900XTX-hez, nem ugyanaz a kategória. 3 évvel később a generációváltáskor olcsóbb a 9070XT?

Erről szól a fejlesztés. Előző gen csúcsa teljesítményét hozza már az új generációs kártya azon az árszinten. -

X2N

őstag

válasz

Yutani

#50523

üzenetére

Yutani

#50523

üzenetére

Meg nem is omlott össze az a piac amit annyira vártunk a bánya után, nem lett semmi se jelentősen olcsóbb. Az új kártyák(meg a 9000-es X3D proci is) meg már emelt áron jöttek ki még kevesebb teljesítménnyel még több haszontalan feature-el(fake AI frame gen).

Ha a következő generáció is ilyen 20-25% teljesítmény növekedést tud majd felmutatni még több fogyasztással és erre majd valaki azt mondja hogy ez jó generáció lett én kiröhögöm. -

X2N

őstag

válasz

Alogonomus

#50521

üzenetére

Alogonomus

#50521

üzenetére

Mert nem ment fel az ára mocskosul a 3D prociknak?

-

X2N

őstag

válasz

S_x96x_S

#50514

üzenetére

S_x96x_S

#50514

üzenetére

Még nem próbáltam csak a sima Arch-t meg az EndeavourOS-t, számomra inkább az a kérdés hogy mennyire lehet stabilan üzemeltetni hosszútávon, mivel ez is Arch alapú, így ha váltok akkor nem biztos hogy rolling disztró lesz a daily driver. Ha nem muszáj nem szívatom feleslegesen magam.

Videó alapján a CachyOS(nem tudtam hogy ennek az előde egy Intel által fejlesztett Clearlinux disztró volt amiben a sebességre mentek rá)-gyorsabb játékok alatt, de a Bazzite stabilabbban hoz jó teljesítményt -

X2N

őstag

válasz

Alogonomus

#50505

üzenetére

Alogonomus

#50505

üzenetére

Jelenlegi hardverpiaci kilátásokkal, ameddig nem lesznek jól működő MCM dizájnok HBM memóriával megfizethető áron(nem 500-600eFt-ért hanem olcsóbban), értelmes fogyasztással(nem 350W+)addig nem aggódok, el leszek ezzel a kártyával, amíg ezek nem lesznek jelentős ugrás teljesítménybe nem lesz. Szoftveres oldala is problémás lesz a chipletes gpu-knak. Azt is ki kell majd várni nem beszélve erről a win10-11-linux váltásról.

Az ami akkor volt a 1080Ti/2080Ti-vel nem fog lejátszódni újra, nem látok rá esélyt, 3 évvel ezelőtt se láttam, most se. Lassan terelnek mindenkit a cloudra ahol majd akkor emelik a havidíjat a duplájára amikor akarják, meg majd azt is megmondják naponta mennyit használhatod.

![;]](//cdn.rios.hu/dl/s/v1.gif) Fiatalabb generáció meg már nem pc-zik, össze se rak pc-t, ilyen árakon???

Fiatalabb generáció meg már nem pc-zik, össze se rak pc-t, ilyen árakon???Erős az 5090-de ha megnézed a 600W fogyasztást mellé már nem az igazi, engem ilyen kártyák már nem érdekelnek. Még undervoltolva is sokat fogyaszt, ~450W

250-350W az ideális egy erős vga-nak, a nagyobb teljesítmény már problémás. A komplett konzol(PS5) fogyaszt 250W-ot csúcsokba. -

X2N

őstag

A lényeg az hogy neked mi az elfogadható.

A gyártó sz@rik rá amíg nem akarják beperelni. Bírja ki a kártya a 3 évet aztán kalap/kabát.

Nekem nem ez az elképzelésem, én azt szeretném hogy addig legyen jó a kártya amíg teljesen el nem avul, ami az én esetemben 7-10 év lesz a 7900XTX-el. Ezért is vettem ezt csúcskarit 3 évvel ezelőtt megjelenéskor, 4K-ra kellett minél több VRAM-al. Ki akarom próbálni hogy a saját gépemben normális tárolási körülmények között meddig megy egy ilyen kártya úgy hogy nincs sag, mert az oldalára támaszkodik a kártya, normális használat mellett, évi 1x takarítással. Leégős NV kártyával nem volt kedvem kísérletezni, pedig egy 3090-4090 se lett volna rossz, de akkor az egy használt kártya lett volna ismeretlen előélettel.

-

X2N

őstag

Itthon nem biztos h népkártya az 5070 és afölötti nv ezért nem látod. A másik hogy ezek az emberek nem is használják ki igazából azokat a kártyákat. Annyi órát még nem tettek bele. Kevés olyan van aki egy 5090-est 16+ órákon keresztül használ 100%-on, vagy aki egész este renderel majd még napközbe is tolja a gépet. Azt viszont garantálni tudom hogy ha nekiállsz tuningolni egy 5090-est és tartósan 100%-ba terheled úgy hogy 600W- vagy felett fogyaszt nagy valószínűséggel már a garancia ideje alatt lesz égett csatlakozód.

Sok leégett csati van, Ha megnézed a külföldi vga javítós youtuber csatornákat doboz számra küldik nekik a leégett csatlakozós nv kártyákat.

Busterftw-Nézd ez így ide kevés lesz, ha minden gyártónál hullanának az RDNA2 kártyák akkor lenne probléma, de így h egy noname kínai gyártónál van csak egy minimál hibaszázalék ez akár az ő saruk is lehet, akár egy elrontott hűtés leszorító/rosszul megtervezett hűtés, gyenge pcb miatt is lehetnek ilyen problémák nem beszélve a rossz tárolásról. Ez kb annyira probléma ebben a mennyiségben h nem éri meg foglalkozni se a hiba feltárásával.

Ahogy az előző Ryzenes problémánál is érdekesnek tartom hogy csak 1 internetes kávézóban hibásodik meg a 150 processzorból a processzorok 10%-a...

Érdemes lenne utánanézni milyen lapokba lettek rakva ezek a processzorok és milyen feszültségekkel üzemelnek. Az a sanda gyanúm hogy a túl magas VSOC feszültség nyírja a procikat, ahogy megjelenéskor is előszeretettel állítgattak be 1.3-1.4V-okat. Majd amikor ment a balhé akkor ezt bios frissítés után 1.3V-ban maximalizálták(elméletben). Manapság 1.2V-al szoktak ezek menni de én nem vagyok róla meggyőződve hogy az X3D-k ennyire bírják ezeket a feszültségeket, a simák lehet jobban bírták, az X3D-lehet háklisabb. -

X2N

őstag

válasz

Yutani

#50493

üzenetére

Yutani

#50493

üzenetére

Úgy hogy a csatlakozóval van a probléma.

A kártyán nincs semmi féle load balancing ugyanis csatlakozónál a pcb-n ha megnézed a vezetősávokat közösítve van a 6-6 érintkező:

A kártyán nincs semmi féle load balancing ugyanis csatlakozónál a pcb-n ha megnézed a vezetősávokat közösítve van a 6-6 érintkező:

Balancing nincsen egyik kártyán se, monitorozás volt a régebbi 3000-es NV kártyákon ahol 2 érpáronként mérő sönt ellenállásokkal monitorozta a teljesítmény felvételt a csatlakozóról a kártya és ha túl lépett egy bizonyos szintet a kártya akkor nem power balanszolás volt(nem balanszol az égvilágon semmit a kártya a vezetéken ez nem áram generátor) hanem power limitálás történt a gpu magon a VRM által, limitálta a kártya a saját teljesítményfelvételét, órajel csökkentéssel együtt, ezért nem melegedett túl a csatlakozó, ezért nem lett rosszabb a hőtágulás miatt az érintkezés és szaladt meg a csatlakozón az áram a rosszabb érintkezés miatt. Az új kártyákon ilyen már nincsen.

Igazából erre az egész monitorozás részre nem is lenne semmi szükség ha egy normális csatlakozó lenne a kártyán. A régi csatlakozónál 8 pines csatlakozónként is van monitorozó rész a kártyákon még úgy is hogy túl van biztosítva 200%-osan a csatlakozó. -

X2N

őstag

"A 3000 széria nem volt ebben érintett ott ez jól működött."

Az hogy ez a széria működött attól még nem lesz jó ez a csatlakozó.

Attól h valami működik még nem biztos hogy jól meg is van tervezve.300-400W-os videokártyákat én nem szeretnék pc-kbe, 300W+ az rengeteg teljesítmény, ott már nem lehet bohóckodni a gyártóknak se.

Évek óta hullanak a Ryzenek, hol ASRockban, hol Asus-ban. Az a szerencséjük hogy nem annyi mint Intelnél a legutóbbi blamánál.

-

X2N

őstag

-

X2N

őstag

válasz

Raymond

#50482

üzenetére

Raymond

#50482

üzenetére

Csak más az amikor részben nyílt a drivered, nem full proprietary. Ha lehet feleslegesen nem nehezítik meg jobb a fejlesztők munkáját. Nem csak a Valve miatt van, GloriousEggroll is fejleszti már egy ideje a Proton-GE, Nobara Project-et, ő se keveset tett hozzá, ahogy a közösség is.

-

X2N

őstag

válasz

Alogonomus

#50480

üzenetére

Alogonomus

#50480

üzenetére

De ha valakinek a szoba dísze a pc akkor mért kell hogy nagy teljesítményű is legyen? Nem lenne jobb egy közepes teljesítményű pici ablakos pc mindenféle csili-vili kijelzővel rgb-s aio-val teljesen hangtalan működéssel? Asztalon is jobban elfér egy ilyen gép.

Én biztos hülyét kapnák ha az asztalon mellettem ott tekerne 12+ ventillátor, meg perifériás látásomba tolná az rgb-t. Nekem egy teljesen zárt rack doboz a pc-m. Semmi fancy nincs benne, nem érdekel a kinézet. Nagy, csak léghűtés van benne a megbízhatóság miatt, most a padlón van feltett oldallappal az asztal mögött. Nincs GPU SAG, meg PCB repedés a PCI csatlakozónál...

Nekem egy teljesen zárt rack doboz a pc-m. Semmi fancy nincs benne, nem érdekel a kinézet. Nagy, csak léghűtés van benne a megbízhatóság miatt, most a padlón van feltett oldallappal az asztal mögött. Nincs GPU SAG, meg PCB repedés a PCI csatlakozónál...Általában a nagy teljesítmény és megbízhatóság az nem jön együtt a csili-vili kinézettel, halk üzemmel, főleg kis-közepes méretbe.

-

X2N

őstag

-

X2N

őstag

válasz

Alogonomus

#50473

üzenetére

Alogonomus

#50473

üzenetére

Hogyne lehetne. 1/3-ad árba van az új csatlakozó a régihez képest.

Fel lehet hozni azt is hogy fizikailag kevesebb helyet foglal a csatlakozó pcb-n de ez már nevetséges kifogás, ahol plusz 2 cm2 pcb sokba kerül(főleg úgy hogy akkora kártyákat gyártanak hogy alig fér be a házba) ott már problémák vannak.

Úgy tudom nem minden kártyájuk ilyen csatlakozós a Sapphire és Asrock-nak így nem volt kötelező ezt a típust választani.

-

X2N

őstag

Gondolom ő is rosszul dugta be.

9 hónapig bírta 600W-ra tervezett csatlakozó a 350W-os kártyával. Csodálatos.

9 hónapig bírta 600W-ra tervezett csatlakozó a 350W-os kártyával. Csodálatos. -

X2N

őstag

-

X2N

őstag

-

X2N

őstag

válasz

proci985

#50446

üzenetére

proci985

#50446

üzenetére

Mindenhol ez van nem csak a programozóknál, játékfejlesztőknél is ugyanez zajlik, a veterán fejlesztők már rég nyugdíjba mentek így nincs aki egy normális játékot letegyen az asztalra évek óta. Az az időszak amiben én felnőttem 1995-2015-ös évek a pc gaming aranykora volt...

-

X2N

őstag

válasz

S_x96x_S

#50441

üzenetére

S_x96x_S

#50441

üzenetére

Mekkora szemétség már hogy 330-360eFt-os kártyát kell venned ha kell 16GB memória, mert a 70-esre nem fért fel 24GB, a 4080-ra meg 32GB. Titan nincs is, pedig az 5090-nek annak kellett volna lennie ECC ramokkal meg a hozzá való driverekkel.

Ezekkel a memória menyiségekkel oké lenne az árazása de így ahogy kiadták nem. De el lett csúsztatva az egész termékpaletta már az előző szériában is, nem érdekli őket már a DIY PC piac, steam statisztika(nem volt soha releváns a valve szerint se) szerint minden rendben van.

Már csak azért is radeont vettem mert ahogy vége lesz a win10-nek a linux support jobb lesz mint a proprietary nvidia driver-el. Persze én meg tudom ezt csinálni mert nem kell se VR meg CUDA

-

X2N

őstag

válasz

Busterftw

#50412

üzenetére

Busterftw

#50412

üzenetére

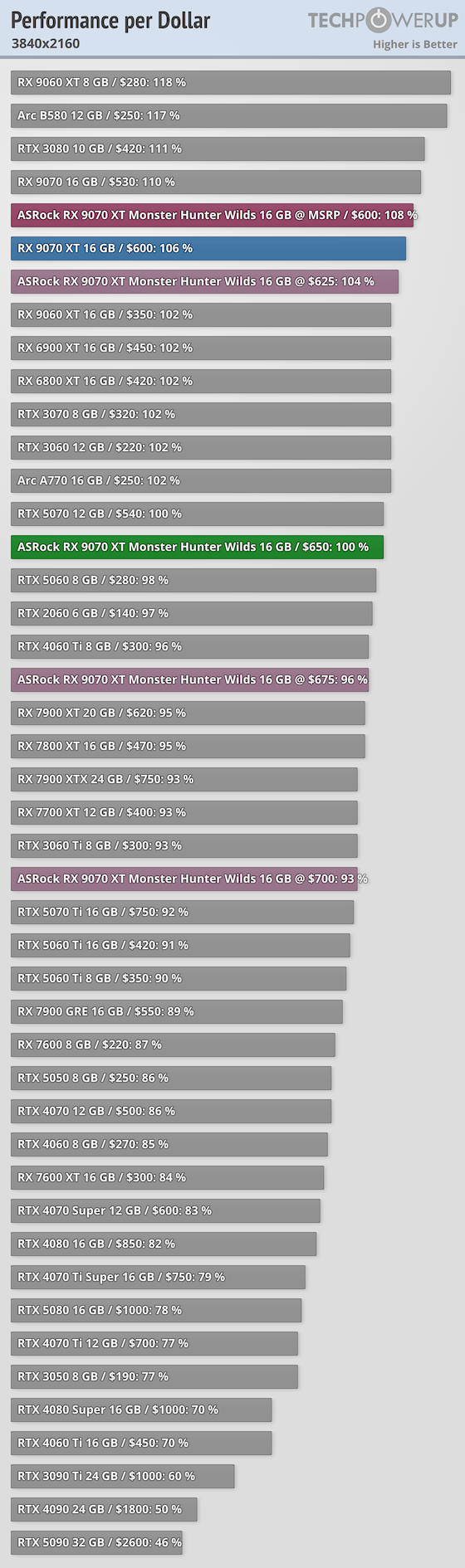

Pedig arról van szó, látszik hogy mi a best buy, 1080p-1440p-re a 9060XT, Arc B580-t érdemes venni, ha meg kell a plusz teljesítmény meg a 16GB VRAM hosszabb távra, vagy 4K felbontásra akkor 9070/9070XT, 50-es szériából egyedül csak az 5070 mondható közepesen jó ár értékűnek, egyébként még a régi 7900XTX-et is jobban megéri megvenni ami sokat elmond az új NV kártyák ár/értékéről....

b.-300k-ért itthon alig használt 5070Ti-t lehet venni azért nem értette Jacek hogy hol veszel ti itthon újonnan ennyiért Prime-ot. Itthon jobb hűtéssel 5070Ti-t ennyiért csak trükközéssel lehet venni.

-

X2N

őstag

válasz

Busterftw

#50394

üzenetére

Busterftw

#50394

üzenetére

Viszont a 9070 elég bestbuy, 16GB ram és erősebb is mint a B850, 9060XT.

1080p grafikont én már nem szoktam nézni(főleg vga választásnál) mert csalóka lehet a proci limit miatt.Plusz 9070-re fel lehet moddolni az XT vbios-t is még több teljesítményért.

Meg nem kell aggódni a leégős csatlakozó miatt se. -

X2N

őstag

válasz

huskydog17

#48680

üzenetére

huskydog17

#48680

üzenetére

Pontosan. Így menne sok játékban csak nincs kihasználva a nyers erő.

-

X2N

őstag

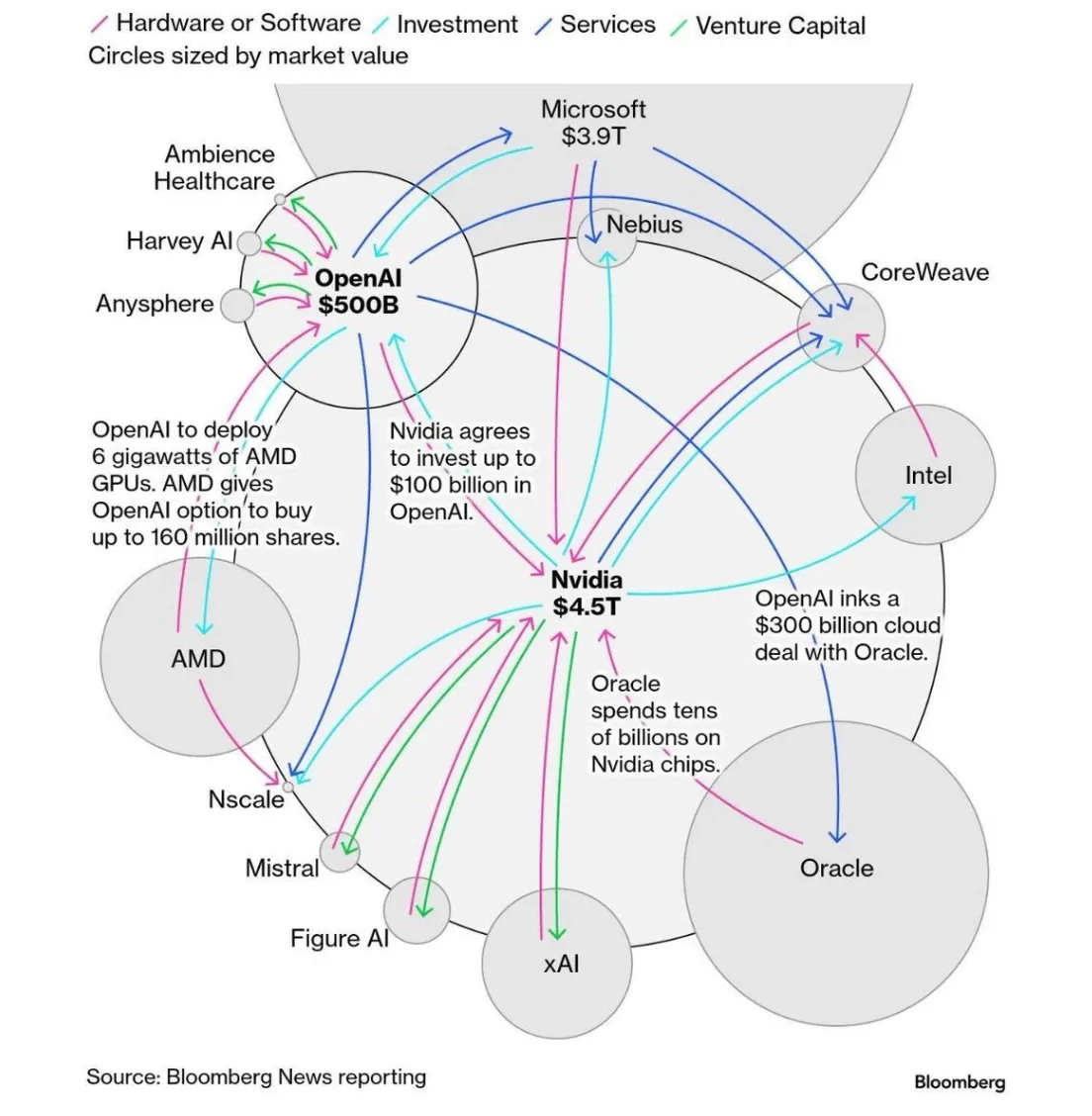

nVidia megvehetné az Intelt.

![;]](//cdn.rios.hu/dl/s/v1.gif)

-

X2N

őstag

válasz

huskydog17

#48342

üzenetére

huskydog17

#48342

üzenetére

Amit te "baromi jó és szépnek" tartasz az sajnos nem az, de ne nekem hidd el ezt hanem ha van lehetőséged nézz meg egy 27" 4K-s monitort a tiéd mellet, ezek gyakoribbak nem az olyan monitorok mint az enyém 24" 4K(nem volt ez se méregdrága monitor, 90eFt-ért vettem anno amikor még lehetett kapni hasonló fotós monitorokat). Ez ugyan csak 150-160PPi de 50%-al jobb így is. Ha erre sincs lehetőséged, akkor is nagyon egyszerűen tudom érzékeltetni a képminőségbeli különbséget, nyiss ki egy könyvet és tedd a monitorod mellé. A windows-ban kapcsold ki a betűkön az élsimítást, hasonlítsd össze mennyivel pixelesebb a monitorodon a betűk mint a könyvnél, utána állíts be 200%-os skálázást a kijelzőre windowsban, így már jóval kevésbé lesznek pixelesek a betűk. Na nálam így kell elképzelni a betűk kinézetét alapon...csak fele akkora méretben mint nálad 200%-on. Emiatt nálam 4x részletesebb a kép és nincs szükség se AA-ra se TAA-ra játékokban mert a szemem kevésbé látja már a pixeleket. De a mobiloddal is összehasonlíthatod a monitorod azok mind retina kijelzősek ha megnyitsz rajta egy natív felbontású képet nem látod a recéket rajta mert bőven 300ppi felett vagy 50-60cm nézési távolságból ügye?

Csak h még egy egyszerű példát mondjak, Assetto Corsa Competizione szimulátor, belső nézetből tolom 55" B9 oleden 4K tv-n, ha ezt kirakom a monitoromra ami 24" 4K az aszfalton látom a repedéseket, az aszfaltra festett csíkokat nem látom recésnek...a tv-n pixeles a kép még ha 3m-ről nézem is...

-

X2N

őstag

válasz

huskydog17

#48338

üzenetére

huskydog17

#48338

üzenetére

Ha kell küldök neked tömörítetlen PNG screenshotokat a játékból hogy néz ki, privátban.

-

X2N

őstag

válasz

huskydog17

#48338

üzenetére

huskydog17

#48338

üzenetére

Ez a "shimmering" egy nem létező dolog nagy PPI-s kijelzőn. Nincs semmi féle vibrálás, ha vibrálást látsz akkor nincs elég nagy pixelsűrűség. Ha elkezded butítani TAA-val a képet felejtsd el azt hogy mi a "natív felbontás", ha te 4K natív képre ráteszed a TAA-t akkor az annyira lerontja a képet mintha 1080p-n natívban játszanál TAA nélkül, a TAA mellé ráadásul masszív szelllemképes utánhúzást is kapsz, rendesen borzalmas nézni, teljesen értelmetlen így 4K+TAA-val játszani. Nagy felbontás kell, nagy PPI-vel kis kijelző mérettel, 300PPI vagy fölötte lenne az ideális(24" monitor 5K felbontás, vagy 32" 8K felbontás lehetőleg 120-144Hz-en oleddel hogy a pixel response tim is jó legyen...vagy újfajta fast ips panel-el). Nekem ~180PPI a monitor, kicsit látom a recéket de ez még vállalható kompromisszum. Az amit ti átlag userek használtok ~92PPI(1080p 24", 27" 1440p) egyszerűen borzalmas, arra tényleg kell minden amivel el tudod mosni a recéket...csak így meg felesleges a játékba low-nál feljebb venni a textúrákat mert nem látod amúgy se a 4k-s textúrák részletességét mert post processingel elmosod...

-

X2N

őstag

válasz

huskydog17

#48335

üzenetére

huskydog17

#48335

üzenetére

Nekem natívon mindenféle AA-nélkül tweakelt Engine.ini beállításokkal baromi jól néz ki a játék, ennél már csak akkor nézne ki ha hardware-es tükröződések árnyékok és GI lenne, esetleg Path Tracing mint a CP2077-ben csak akkor ugye nem menne még a 4090-esen sem...

Az viszont sajnálatos hogy a vegetáció nem Nanite-os, látszik a fákon nagyon sajnos hogy nem olyan jók amennyire lehetne. -

X2N

őstag

válasz

huskydog17

#48329

üzenetére

huskydog17

#48329

üzenetére

Nekem 7900XTX-el nem fogyaszt többet vramból 10GB-nál 4K natívon akkor én csinálok rosszul valamit és mégse rossz a radeonok memória kezelése?

![;]](//cdn.rios.hu/dl/s/v1.gif)

-

X2N

őstag

válasz

huskydog17

#48314

üzenetére

huskydog17

#48314

üzenetére

Egy ilyen kaliberű játék szinte sose lesz kész, mindig lehetne javítani rajta valamit.

-

X2N

őstag

válasz

gainwardgs

#48303

üzenetére

gainwardgs

#48303

üzenetére

Jobb lett volna ha maradnak X-ray engine-en?

![;]](//cdn.rios.hu/dl/s/v1.gif)

-

X2N

őstag

válasz

FollowTheORI

#48206

üzenetére

FollowTheORI

#48206

üzenetére

5-10% -al jobb mint a 7800X3D, én legalább 15%-ot vártam volna, különben meg mi értelme van ennek a processzornak? Mire ment el 2 év? Megfordították a chipletet? Minek? Nem lett sokkal jobb...

-

X2N

őstag

válasz

gainwardgs

#48199

üzenetére

gainwardgs

#48199

üzenetére

Neked mi bajod van?

-

X2N

őstag

válasz

gainwardgs

#48197

üzenetére

gainwardgs

#48197

üzenetére

Ez mi? Többet vártam.

![;]](//cdn.rios.hu/dl/s/v1.gif) Vicc, többet fogyaszt mint a 7800X3D és alig gyorsabb...

Vicc, többet fogyaszt mint a 7800X3D és alig gyorsabb... -

X2N

őstag

Nem kell alátámasztanom semmit. Ez játék függő. Ott van pl a Cities Skylines sorozat abban nagyszerűen lehetne párhuzamosítani a városlakók szimulációját, a világ összes processzor magja kevés hozzá ha elkezdeném valósághűen leszimulálni 15 millió lakos útvonalát...a kérdés csak az hogy a fejlesztők hajlandóak lesznek-e ezzel foglalkozni hogy kihasználja a hardert, ha már megvettem és itt van.

S_x96x_S- 24ms helyett 11ms ez baromi komoly

-

X2N

őstag

Komolyabb szimulációs játékok, Rimworld, Factorio, Arma sorozat több száz npc katonával, Raytracingnél is nagyobb a cpu igény, és a fent említett npc útvonalkeresés olyan játékoknál ahol nagy városok vannak sok-sok npc-vel, bármelyik open world játékban mint az Assassins Creed, Ciberpunk stb. Fizikát is lehetne számoltatni pluszba.

-

X2N

őstag

Nincsen probléma, ennyi van a konzolba, persze hogy nem használnak ki a játékok többet, az még nem jelenti azt hogy npc útvonalkeresésre ne lehet több magot befogni...

Én kérek elnézést hogy fejlődést szeretnék látni a gyártóktól...nem visszafejlődést mint amit az Intel leművelt most az új szériával. Teljesen felesleges hibrid felépítést csinálni tegyék rá mindkét CCX-re a 3D cache-t, ne rajtam akarjanak sprólni aki megvenné közel 300eFt-ért a 16 magos procit..ne nekem kelljen process lassoz-ni mindent alkalmazást...Azt hogy te nem játszol olyan játékokkal ami nem processzor igényes még létezik olyan ahol ki lehetne használni a több magot.

-

X2N

őstag

válasz

gejala

#48078

üzenetére

gejala

#48078

üzenetére

Ideje lenne már hogy meglépjék 16 magot 1 CCX-en és a 3D Vcache is alap kell hogy legyen...meg rendbe kéne rakni már a memória kezelést is, CAMM2 lapok kellenének 10GHz vagy feletti ramokkal, meg olyan memvezérlő ami ezt le is tudja 1:1-ben kezelni...

Ha ez nem megy akkor nem lenne ördögtől való az se hogy csinálnak egy monolitikus 8 magos célprocit játékosoknak 3DVCache-el. -

X2N

őstag

válasz

gejala

#48049

üzenetére

gejala

#48049

üzenetére

Ahelyett hogy ezt a csak chipletes rendszert erőltetnék megcsinálhatták volna akár úgy is hogy lenne benne 8 mag a jól bevált monolitikus felépítéssel Hyper thread nélkül nagy órajelen, alacsony latency-vel gamingre és e mellett egy második processzor rész ami chiplettel van megolva mint az AMD esetében, csak efficienty magokkal, szóval 2 külön processzor a kupak alatt, ezzel az lenne csak a bökkenő hogy a memóriát is duplázni kellene processzoroknál, amit úgy lehetne megoldani hogy vagy meghagyják a mostani 4 ram slotot viszont csak 2-2-slot van bekötve processzoronként(így ezt kötelező lenne telepakolni és végre ki is lenne használva minden slot

), vagy a chipletes processzor rész kaphatna egy 16GB GDDR6/HBM memóriát ahogy a konzolnál is, a másik 8 mag meg használná a DDR5 ramot a szokásos 4 DIMM foglalattal amiből 2 lenne kihasználva szokás szerint...így megmaradna a gamingre az alacsony memória latency-ből fakadó memória előny és lehetne munkára még több alacsonyabb órajelű de jobb hatásfokú processzort tenni a chipletes részbe...

), vagy a chipletes processzor rész kaphatna egy 16GB GDDR6/HBM memóriát ahogy a konzolnál is, a másik 8 mag meg használná a DDR5 ramot a szokásos 4 DIMM foglalattal amiből 2 lenne kihasználva szokás szerint...így megmaradna a gamingre az alacsony memória latency-ből fakadó memória előny és lehetne munkára még több alacsonyabb órajelű de jobb hatásfokú processzort tenni a chipletes részbe... ![;]](//cdn.rios.hu/dl/s/v1.gif)

Wow. őstag lettem... -

X2N

őstag

válasz

gainwardgs

#47959

üzenetére

gainwardgs

#47959

üzenetére

Majd veszel új gépet ha stutterel

-

X2N

őstag

Ott van pl a Sony-s Concord aminek a fejlesztésére összesen több mint 400millió dollár ment el. Mindezt úgy hogy marketingre szerintem semmit nem is költött a Sony. Én arról a játékról konkrétan akkor hallottam először, amikor megjelent, de csak azért mert akkora bukta lett és sok youtuber elkezdett videókat csinálni róla a PS5 árazásával és annak okával kapcsolatban...

A Concord amúgy 8 évig készült, még a covid előtt kezdték a fejlesztést(ez meg is magyarázza miért került ennyibe, gondolom több fejlesztőt is felvettek mint kellett volna, ami nem jelenti azt hogy gyorsabban és jobb minőségbe készül a játék), és akkoriban jó ötletnek tűnt egy Overwatch-oz hasonló AAA kompetitív játék készítése a Sony-nak az új konzolhoz. Ha engem kérdeztek a probléma ezzel csak az hogy senki nem ezt várta a Sony-tól...hanem új single player játékokat a PS5-höz. Szerintem teljesen rossz ez az irány, több fejlesztővel nem lehet jobb játékot készíteni, csak még nagyobb bukták lesznek a jövőben is. -

X2N

őstag

Én a továbbiakban bojkottálni fogom az ilyen játékokat ahol forcolva van a TAA és nem lehet még kikapcsolni se moddal...az összes AAA játékban ki lehetett eddig kapcsolni. Játszanak a konzolosok ilyen képminőséggel...PC-n ez okádék minőség, még egy 2015-ös Witcher 3 is jobban néz ki mint ez az Outlaws, ott legalább látom a textúrákon hogy részletesek. Már a youtube-os videón is megdöbbentően rosszul néz ki az Outlaws....az is egy vicc hogy egy 4090 kevés hozzá miközben rosszabbul néz ki mint az évekkel ezelőtti Fallen Order.

-

X2N

őstag

-

X2N

őstag

válasz

bertapet11

#47908

üzenetére

bertapet11

#47908

üzenetére

Nem látott még az ai elég zöldséget csak pornót, honnan tudja hogy kell felskálázni...

Maradok továbbra is a natív felbontásnál.![;]](//cdn.rios.hu/dl/s/v1.gif)

-

X2N

őstag

Ezt azért készítettem mert érdekelt mekkorák egymáshoz képest a gpu-k:

-

X2N

őstag

válasz

gainwardgs

#47794

üzenetére

gainwardgs

#47794

üzenetére

A wukong egy csőjáték, ez meg egy "open world" 5 bolygóval. Nem fair az összehasonlítás.

-

X2N

őstag

válasz

gainwardgs

#47792

üzenetére

gainwardgs

#47792

üzenetére

Jó lesz ez majd 0.5-1év múlva akciósan. Ha 0 day akarod tolni akkor erősebb kártyát kellett volna venni.

-

X2N

őstag

válasz

GeryFlash

#40514

üzenetére

GeryFlash

#40514

üzenetére

Hát attól hogy 2x annyi TFLOPS még nem lesz 2x annyi fps, kb itt bukik meg az egész elméleted. Ezen kívül a memória konfiguráció is beleszól ebbe, lehet hogy lassabb memóriával még a beharangozott teljesítményt se fogja tudni, persze ezen gyorsíthatnak csak akkor tranzisztort kell pazarolni erre. HBM memóriával meg lehet elszálna még jobban a fogyasztás amit nem akarnak annyira. Jó lesz az új konzol, de ne várjunk már világmegváltást.

RT-re gyenge lesz. Nem csak a hardver miatt. Szoftveresen is fel kéne nőni ehhez.

RT-re gyenge lesz. Nem csak a hardver miatt. Szoftveresen is fel kéne nőni ehhez. -

X2N

őstag

Nincs? Akkor ezmiez?

-

X2N

őstag

válasz

GeryFlash

#40500

üzenetére

GeryFlash

#40500

üzenetére

Már megint a hülyeség megy? Az új konzolok ki sem jöttek még. Nem fog az tudni 4k-ba semmilyen raytracinget

főleg nem 60 fps-el. Kicsit unom már ezt, hogy egy számításteknikai fórumon kell magyarázni hogy mennyire teljesítményigényes a sugárkövetés, és a fórumtagok többsége(tisztelet a kivételnek) azt hiszi hogy a konzol 150-170W teljesítményből 4K Raytracing-et tol majd 60fps-el. Szerinted he ez lehetséges lenne akkor a nagy cégek minek veszik a renderfarmokat, miért kerül 20 millió forintba egy nvidia grid szerver, ha mindezt a teljesítményt megkapod 150ezerért pár hónap múlva?

főleg nem 60 fps-el. Kicsit unom már ezt, hogy egy számításteknikai fórumon kell magyarázni hogy mennyire teljesítményigényes a sugárkövetés, és a fórumtagok többsége(tisztelet a kivételnek) azt hiszi hogy a konzol 150-170W teljesítményből 4K Raytracing-et tol majd 60fps-el. Szerinted he ez lehetséges lenne akkor a nagy cégek minek veszik a renderfarmokat, miért kerül 20 millió forintba egy nvidia grid szerver, ha mindezt a teljesítményt megkapod 150ezerért pár hónap múlva? ![;]](//cdn.rios.hu/dl/s/v1.gif) Biztos majd az új konzol fog olyan minőségű RT-t tolni hogy kukázni kell a célhardvereket, mint az RTX-eket.

Biztos majd az új konzol fog olyan minőségű RT-t tolni hogy kukázni kell a célhardvereket, mint az RTX-eket.  Meg se fogja közelíteni azt a minőségű RT-t a konzol ami már most elérhető pc-n Control, Metro Exodus Quake RTX játékokban. De elmondom még1x utoljára a Rajtracing baromi számításigényes, és nem kell semmilyen módon "optimalizálni" ahogy a Crytek, Wargaming meg egy pár cég megpróbálja, mert annak a minőség látja kárát.

Meg se fogja közelíteni azt a minőségű RT-t a konzol ami már most elérhető pc-n Control, Metro Exodus Quake RTX játékokban. De elmondom még1x utoljára a Rajtracing baromi számításigényes, és nem kell semmilyen módon "optimalizálni" ahogy a Crytek, Wargaming meg egy pár cég megpróbálja, mert annak a minőség látja kárát. -

X2N

őstag

válasz

Firestormhun

#39766

üzenetére

Firestormhun

#39766

üzenetére

2020 nagyszerű év lesz

még PC gamerként is

még PC gamerként is

-

X2N

őstag

Simán elcsúsztathatták volna a megjelenést. Akkor lehet nem 11dollár lett volna a memória. Akár több memória is mehetett volna rá. Lett volna idő megcsinálni a kártyákat normálisan, nem így félkészen kiadni mindent. Most egy techdemot nekem hiába mutatsz, azt a hajamra kenhetem ha Iray rendert használok. Jó ha májusba működni fog az Iray az RTX-ekkel. Akkor meg már inkább kivárom a köv gent. Mert most SPÓROLTAK a rammal...bezzeg a Radeon VII-re jutott. Ráadásul a Radeon Prorendert is frissítették, hétvégén megnézem, aztán ha jónak találom viszlát nvidia...

-

X2N

őstag

Nekem nem vállalható. Majd ha hozza azt a 6x-os sebességnövekedést Iray renderben amit a bőrkabátos megigért a prezentációban akkor elgondolkozok a cserén, addig marad a 980Ti. Miért nem lehetett több vramot tenni az új kártyákra? Már 8GB alá be se kellett volna menni az új kártyákkal, a 2080Ti-n miért nincs 16-32GB vram? Hát hogy rendereljek így? Vicc, és közbe azt mondja Jensen hogy ingyen van... az a szánalmas hogy a rengetegen még így is megveszik ilyen áron. Hát gratulálok. A sok birka.

-

X2N

őstag

válasz

hokuszpk

#38028

üzenetére

hokuszpk

#38028

üzenetére

Eddig ment az ámítás hogy hbm memória, sávszél, memória kihasználás, optimalizálás így meg úgy, aztán az AMD erre kiadja ezt

sírok. De Abu majd megindokolja hogy de hát a PBR Textúráknak sok hely kell, persze, ha 16k-s textúrákat raksz be egy 1x1m-es padlólapra. 10-12-16bit színinformációval tömörítés nélkül....

sírok. De Abu majd megindokolja hogy de hát a PBR Textúráknak sok hely kell, persze, ha 16k-s textúrákat raksz be egy 1x1m-es padlólapra. 10-12-16bit színinformációval tömörítés nélkül....

Új hozzászólás Aktív témák

A topikban az OFF és minden egyéb, nem a témához kapcsolódó hozzászólás gyártása TILOS!

Megbízhatatlan oldalakat ahol nem mérnek (pl gamegpu) ne linkeljetek.

- Philips LCD és LED TV-k

- World of Warships

- Lenovo Legion és IdeaPad Y széria

- Ezek voltak az év játékai 2025-ben szerintetek

- AliExpress tapasztalatok

- NVIDIA GeForce RTX 5080 / 5090 (GB203 / 202)

- Kerékpárosok, bringások ide!

- Poco F6 5G - Turbó Rudi

- Kritikát kapott a Nintendo konzolgyilkos felhasználói szerződése

- Xbox Series X|S

- További aktív témák...

- Garmin USB ANT Stick jeladó eladó

- LG 65C4 - 65" OLED evo - 4K 144Hz - 0.1ms - NVIDIA G-Sync - FreeSync - HDMI 2.1 - 1000 Nits

- BESZÁMÍTÁS! ASUS ROG GL10DH brand számítógép - R7 3700X 32GB DDR4 512GB SSD RTX 2060S 8GB 500W W11

- LG 27UP850K-W - 27" IPS LED - 3840x2160 4K - DisplayHDR 400 - USB Type-C - AMD FreeSync

- ÁRGARANCIA!Épített KomPhone Ryzen 7 7700X 32/64GB RAM RX 9070 16GB GAMER PC termékbeszámítással

Állásajánlatok

Cég: Laptopszaki Kft.

Város: Budapest

Cég: PCMENTOR SZERVIZ KFT.

Város: Budapest

(most néztem, a 150GB az csak a textúra, +70GB a modell

(most néztem, a 150GB az csak a textúra, +70GB a modell

![;]](http://cdn.rios.hu/dl/s/v1.gif)

Nekem egy teljesen zárt rack doboz a pc-m. Semmi fancy nincs benne, nem

Nekem egy teljesen zárt rack doboz a pc-m. Semmi fancy nincs benne, nem

RT-re gyenge lesz. Nem csak a hardver miatt. Szoftveresen is fel kéne nőni ehhez.

RT-re gyenge lesz. Nem csak a hardver miatt. Szoftveresen is fel kéne nőni ehhez.