Új hozzászólás Aktív témák

-

Abu85

HÁZIGAZDA

Mivel az AMD és a Sony kötött egy megállapodást Project Amethyst néven, így most már muszáj úgy összedolgozniuk, hogy az egyes Sony technológiák portolhatók lehessenek PC-re. Tehát most már a hardver tervezése is összefonódott, mert a Project Amethyst garantálja a Sony-nak azt, hogy ha hoznak egy PS6 portot PC-re, akkor PC-n is lesz hardver hozzá, ami futtatja az egyes eljárásaikat. Ez régen a Sony számára nem volt fontos, mert csak mostanában kezdtek el PC-re portolni, de így fontos lett, és meg kell oldani azt a problémát, hogy a Sony saját dizájnokat is tervez, amiket nem biztos, hogy a Microsoft, az NVIDIA, az Intel, stb. lemásol. Tehát kell legalább egy gyártó, ahova a fullos kód portolható, az egyes eljárások kikapcsolása nélkül. Ez a Sony számára egyszerűsíti a portolást, mert elég a PS6-ra dolgozniuk, és bármit amit oda megírnak, azt legalább az AMD-re át tudják hozni. Ha másra nem, az se baj nekik, mert raknak egy "if not AMD, turn off" feltételes elágazást a kódba. Ezzel nagyon olcsón és nagyon gyorsan fognak portolni, miközben élvezik a PC-s eladásokat. Lényegében profitot maximalizálnak.

Az RNDA 4 és az FSR 4 saját technológia. A Sony egyiket sem használja. A Sony egy saját RDNA verziót tervezett, ami nem hasonlít az RDNA 4-re, viszont az FSR 4-et tudják rá úgy portolni, hogy az algoritmus megváltoztatása nélkül fusson. Ettől persze az implementációt nagyon meg kell változtatni, mert a Sony AI hardveres más, mint az AMD AI hardvere. De egyébként az FSR 4 eleve portolható lenne más AI hardverre is, akár úgy, hogy az algoritmust nem éri módosítás, mert mátrixszorzás az egész. Az implementációban kell változtatni.

-

Abu85

HÁZIGAZDA

válasz

Busterftw

#49277

üzenetére

Busterftw

#49277

üzenetére

A Computexen is lehetett hallani, hogy volt a Navi 48-nak egy speciális, 3D V-Cache dizájnja. Úgy, ahogy a mostani CPU-nál megoldották, a lapka alá helyeztek egy 512 MB-os cache-t, ami így 576 MB-ra növelte az infinity cache-t. És azt tesztelgetik a következő generációra. De nem hiszem, hogy már kihozzák ebben a generációban. A next-gennek viszont ez lesz az egyik ütőkártyája, hogy IC-ből a csúcsmodell kb. ~1 GB-os cache-t kap, aminek az elérése nagyon gyors, a computexes pletyik szerint 15 TB/s körüli. Ez teljesen felborítja, ahogy működik majd a rendszer, mert egy rakás, sűrűn használt adat ki sem lép sosem a GPU-ból.

#49278 T.Peter : A Microsoft kicsit más, mert ők más jellegű szerződést kötöttek. A Sony még mindig klasszikusan egy általuk nagyon felügyelt semi-custom lapkát kér, és erre adnak ki egy konzolt, majd talán csinálnak még egy lapkát köztes generációnak. A Microsoft a jelenlegi iparági pletyik szerint legalább egy tucat dizájnt kért első körben, és ebből kettővel van kész az AMD. De a Microsoftnál nincs az architektúra kőbe vésve, mindegyik dizájn célpiacra megy, tehát lehet benne akármilyen CPU és GPU. Valószínűleg lesz olyan, amiben majd UDNA lesz, de a következő körben az Xbox nagyon kevert lesz. És a gépek többségét nem is a Microsoft fogja gyártani, hanem különböző PC gyártók. A Microsoft csak Xbox matricát ad nekik, ha az általuk kiválasztott, Xboxhoz készült AMD dizájnokat veszik majd. Szóval ezt most a Microsoft nagyon másképp képzeli el, mint a Sony.

-

Abu85

HÁZIGAZDA

Nem hiszem, hogy az AMD-nek lenne hova köztes generációt csinálni. Ha kihozzák, akkor leghamarabb a CES-re tudják, az meg hülyeség, mert Computexre már ott a next-gen.

Az NV-nek azért reális a köztes generáció, mert ők 2027-ben hoznak igazi next-gent, tehát a köztes sorozat egy évig piacon lehet.

Az AMD-nek nagyon elvitte a fejlesztéseit a Sony, nekik az UDNA-val már most kész kell lenniük, különben a Sony nem tudja elkezdeni tesztelni a PS6-ot idén. Márpedig a konzolnál az első teszt és a megjelenés között eltelik vagy két év. Emiatt az AMD-nek nincs más választása, mint beáldozni a köztes generációt, és egyből a next-genre lőni. Ezért is szűkíthették le ezt a kört csak két GPU-ra.

-

Abu85

HÁZIGAZDA

válasz

proci985

#49259

üzenetére

proci985

#49259

üzenetére

Nem, az AMD HUB-ot használ. Ez nem sokban különbözik a Crossbartól. Annyi a lényeg, hogy a Crossbar esetében vannak optimális útvonalat, míg a HUB esetében mindegy, mert az útvonal nem direkt, hanem egy menedzsment egység kezeli. Ezért jobb az átlagos késleltetés.

#49262 Busterftw : Az nem tömörítés. Ott az a lényeg, hogy a GPU generálja magát a tartalmat. Azért kerül ~38 GB helyett ~50 kB-ba. Ezt a Work Graphs 1.1 teszi lehetővé, tehát nem igazából hardveres képességről van szó, hanem egy új DirectX 12 funkció van vele kihasználva. Ez leginkább az Unreal Engine 5 számára fontos, mert a Nanite iszonyatosan sokat tud profitálni a Work Graphs API-ból. Az 1.1-es verziónál pedig az Epic meg tudja csinálni a PCG moduljuk, valós időben működő verzióját. Ehhez csinálhatnak saját algoritmust, vagy licencelhetik az AMD kódját, igazából mindegy, mert a lényeg maga a generálás.

-

Abu85

HÁZIGAZDA

válasz

Busterftw

#49241

üzenetére

Busterftw

#49241

üzenetére

Objektív teszt mellé nem kellene magyarázkodni külön írásban.

A személyeskedéssel pedig itt nem mész semmire. Elhiszem, hogy a frusztráció miatt ehhez nyúl az ember, de nem hatékony módszer.

#49245 b. : Nem, nem arról megy a vita, hanem arról, hogy objektívként el lehet-e adni szubjektív véleményt. És igen, le is írod, hogy nem mérhető, és ez itt a gond. Ha valami nem mérhető, akkor hogyan határozod meg, hogy mi a jobb? Objektíven sehogy, tehát fel kell állítani szubjektív szempontokat, amivel nincs gond, de akkor el kell fogadni, hogy a teszt is szubjektív.

-

Abu85

HÁZIGAZDA

válasz

Busterftw

#49232

üzenetére

Busterftw

#49232

üzenetére

Ha valami objektív, akkor nem kell magyarázni, hogy milyen szubjektív szempontokat nézel.

#49234 deathcrow42 : Nem muszáj. Szerintem abszolút helyesek a szubjektív tesztek is, és van szerepük, de fontos kihangsúlyozni, hogy szubjektívek. Ez azért lényeges, mert ha másnak nem ugyanazok a szempontjai, akkor nyilván ne érje csalódás, hogy nem azt látja, amit a szubjektív teszt mutat.

Igen, az alapvetően szubjektív vélemény, hogy ki mit tart jobbnak. Le lehet írni, de ettől még szubjektív marad.

Én például nagyon nem kedvelem a TAA-kat, mert a temporális algoritmus negatív hatásaitól falnak megyek. És ezt nem lehet sosem kiműteni belőlük, mert a működési módjukból ered, vagyis nem klasszikusan javítható hibák, hanem az algoritmus melléktermékei. Ilyen szempontból én a klasszikus SSAA-t jobbnak tartom egy TAA-s tartalomnál, mert a nincs benne ghosting és disocclusion.

Én nagyon megértem, hogy a gyártók látják, hogy mennyire elbaszták az RT API-kat, és csináltak belőlük egy lassú, black box szart. Ezt próbálják most kompenzálni azzal, hogy kevesebb pixelt számolnak, mert a black box jelleg miatt nem alkalmazható egy csomó optimalizáció, amire szükség lenne. De itt ez az ő problémájuk. Ők baszták el. Semmi szükség nem lenne felskálázókra, ha nem black box AABB-t használnának, mert ekkor olyan optimalizálásokra lenne lehetőség, ami Full HD-ben hozná azt a sebességet, amit így a black box módszerrel csak 576p-ben lehet csak hozni. És most a marketing ezt adja el baromi nagy innovációnak, pedig csak nagyon szarul dolgoztak, és gáz lenne kiállni a piac elé, hogy amit lehetett azt elcsesztünk, ezért nagyon alacsony felbontással lehet csak számolni a mérnökeink extrém bénázása miatt.

-

Abu85

HÁZIGAZDA

válasz

Busterftw

#49227

üzenetére

Busterftw

#49227

üzenetére

A szempontok szerint függ. Ha a színhűség a fontos, akkor figyelembe kell venni, hogy a zajszűrt kép torzítja a színeket. Tehát, ha a színeket jelölöd meg szempontként, akkor a nem torzított kép lesz a nyerő, mert abban vannak az eredetihez közel álló színek, míg a szűrt kép a hátrányos, mert a denoise biztosan torzított az eredeti színeken, ami histogram összevetéssel jól láthatóvá is tehető.

Ha viszont a zajszint a szempont, akkor ott a denoise torzítással létrehozott kép a jobb, mert nyilván eltünteti a zajt. SNR vagy PSNR összevetéssel ez is jól láthatóvá tehető.

Ezért fontos kijelölni, hogy mik a képek vizsgálatánál a szubjektív szempontok, és azok alapján lehet szubjektíven dönteni, hogy melyik kép a szempontok szerinti jobb.

-

Abu85

HÁZIGAZDA

Igen. És itt ez a lényeg. Meghatározhatók olyan szubjektív szempontok, ami alapján lehet sorrendet felállítani. De ettől még ennek meghatározása mindig szubjektív marad.

#49213 Busterftw : Nem. Szubjektív szempontokat választottak ki, mert a saját véleményük alapján döntötték el, hogy mi a fontos és mi nem. Amivel továbbra sincs semmi baj, csak ettől ez nem lesz objektív sosem.

Pont az a gond, hogy a usernek a végeredmény a fontos. Ha minden user ugyanazt gondolná, akkor nem lenne a Threat Interactive videóinak 200-500 ezres nézettsége. És a Threat Interactive pont azt hirdeti, hogy az elterjedt, TAA-alapú felskálázók problémái deal-breakerek, és helyettük az analitikai vagy morfológiai AA-kat kellene erőltetni. Rengeteg játékos gondolja így, mert nagyon is lájkolják ezt a nézetet. És ez azt jelenti, hogy a végeredményt nem minden user értelmezi ugyanúgy. De ez megint nem gond, mert ezért vannak tucatjával AA megoldások, mert mások az igények, más a pro/kontra. Szubjektíven lehet azt mondani, hogy xy újságnak ez és az a fontos, de ez például nem fog azoknál a usereknél jól lecsapódni, akik meg gyűlölik a TAA-k hibáit.

-

Abu85

HÁZIGAZDA

válasz

Busterftw

#49210

üzenetére

Busterftw

#49210

üzenetére

Sajnos nem igazán, mert nehéz meghatározni olyan objektív szempontokat, amik mindenkinek megfelelnek. Most az AA-ra fókuszálva, ha lenne ilyen, akkor csak egy AA megoldás lenne. De mivel sokkal-sokkal több van, így vannak szubjektív szempontok, amelyekre épültek különböző alternatívák. És ezzel nincs semmi baj. Valaki a recére érzékeny, valaki a zizegésre, valaki a disocclusionre. Sajnos nincs olyan AA megoldás, ami egyszerre old meg mindent. Viszont, ha kijelölsz egy szubjektív nézőpontot, hogy mik számítanak és mik kevésbé, akkor lehet szubjektív sorrendet felállítani. És azért fontos itt a szubjektív, mert például, ha a disocclusionre vagy érzékeny, és azt jelölöd ki, hogy azt nem szeretnéd látni, akkor eszerint a szubjektív nézőpont szerint az FSR2+, DLSS2+ és XeSS megoldások a legrosszabbak között lesznek, és például az FSR 1 mindet leveri. Ha viszont a zizegés a kritikus nézőpont, akkor pont fordítva lesz.

Ezért fontos az, hogy ez szubjektív, mert te választod ki a szempontokat, amik szerint felállítod a sorrendet az egyes AA alternatívák között.

-

Abu85

HÁZIGAZDA

válasz

Busterftw

#49204

üzenetére

Busterftw

#49204

üzenetére

Ez azért nem ilyen egyszerű, mert vannak olyan stílusk, ahol pont az a lényeg, hogy recés legyen. Tehát nem meghatározható objektíven, hogy mi néz ki szarul, és mi nem, mert függ az alkalmazott grafikai stílustól.

Ezért kínálnak a driverek például integer scalingot, mert nem egyértelmű, hogy mi a jó.

A felskálázások is valójában AA-k, tulajdonképpen élsimítási eljárások kategóriájába esnek. Ha meghatározható lenne, hogy mi a jó, akkor nem létezne kb. két tucat AA alternatíva.

-

Abu85

HÁZIGAZDA

válasz

paprobert

#49193

üzenetére

paprobert

#49193

üzenetére

Kérlek... a hsz-emből légyszi emeld ki azt a részt, ami egyáltalán a felskálázókról szól.

A szem és az agy működése pedig ismert tények. Nem tehet róla az ember, hogy így működik.

#49194 Busterftw : Mutasd meg kérlek azt az objektív fokmérőt, ami alapján a képminőség effektív előnye matematikailag meghatározható. Ilyet még a CB cikk sem említ, mert ugye ilyen nincs. Matematikailag nem tudja levezetni, hogy miért tartja jobbnak. Csak jobbnak tartja, mert ez a szubjektív véleménye. És továbbra is hangsúlyozom, hogy ezzel nincs semmi baj, mert véleménycikkek léteznek a világon.

A tanulmányok az objektív tényt konkrétan levezetik, tehát nem egyéni vélemény dönt arról, hogy valaki jobb vagy sem.

Ne keverjük ide a konteokat. A CB attól nem lesz konteogyáros, hogy szubjektív vélemény szerint értékelnek.

#49195 b. : Hiába tartod gusztustalannak, az emberi látás tudományosan igazolt működése ettől még tény.

-

Abu85

HÁZIGAZDA

A legtöbbet játszott játékok online címek, amelyek terhelése rendkívül alacsony.

A tesztek csak az adott játékokra vonatkoznak. Minden tesztnél igaz az, hogy lehet olyan játék, amelynél teljesen más lesz az eredménye annak, amit a teszt átlagban kihozott. Ezzel mi sem, és senki sem tud mit kezdeni.

Pedig nagyjából a játékok támogatása szempontjából az NV több játékot támogat, mint az AMD, és az AMD többet, mint az Intel. És megnéztem, az 5-3-1 alapvetően az arányokkal megegyező.

#49188 Busterftw : Én egy tudományos eredményben sem olvastam azt, hogy valakinek a véleménye döntött arról, hogy az eredmény mi lett.

-

Abu85

HÁZIGAZDA

válasz

huskydog17

#49184

üzenetére

huskydog17

#49184

üzenetére

Erről nem tehetünk, hogy semmi gondunk nem volt vele. Sajnálom, ha másnak volt. Általában ilyenek a hibák. Csak a konfigurációk egy részét érintik.

A CB szubjektív tesztjeiben minden meghatározható, hiszen maguk írták le, hogy mik a szubjektív szempontjaik. Mint írtam ezzel semmi baj nincs. Azzal van a baj, ha ezt objektívnak nézzük.

A szubjektív teszt nem jelenti azt, hogy valami nem meghatározható. Azt jelenti, hogy nincs objektív összehasonlítási alap, mert nincs közös beállítás. De ha meghatározták a szubjektív véleményüket, hogy mi alapján mérik össze, akkor az rendben van, csak ez a CM szubjektív véleménye lesz.

#49185 Egon : A játékok kiválasztása nálunk is szubjektív szempontok szerint történik. Ezt nehéz objektíven megtenni, mert nincs egy olyan dolog, ami az objektivitást itt biztosítaná. Szóval a játékfelhozatal nálunk is, ahogy mindenhol, teljesen szubjektív. A szempontjainkat pedig megosztottuk anno, mert szerettük volna megmutatni, hogy miért ezeket választottuk. És ez a választás valóban a PH szubjektív véleménye volt. A mostani játékfrissítés is teljesen szubjektív lesz, ezt nem lehet objektív formában biztosítani.

A mostani frissítésnél is hasonlóan járunk el. Igyekszünk egy motort egyszer szerepeltetni, a támogatás szintjén pedig öt NV, három AMD, egy Intel és egy független játék lesz. Ez nagyjából képviseli a piaci arányokat.

-

Abu85

HÁZIGAZDA

válasz

huskydog17

#49180

üzenetére

huskydog17

#49180

üzenetére

Azért kell magyarázniuk, mert nem objektív, amit csinálnak. De ezzel semmi baj, csak el kell magyarázniuk, hogy a szubjektív véleménytesztjeiket hogyan menedzselik.

Nekem semmi problémám nincs azzal, hogy a CB ezt csinálja. Azzal van a problémám, hogy ezt objektív tesztelésnek szeretnék többen eladni, miközben maga a CB sem így adja el. Másképp nem magyarázkodnának, hiszen az objektív teszteket nem kell magyarázni.

Mi elég sokat játszottunk azzal a játékkal és nem tapasztaltunk DX12-ben gondot. Rengeteg, több tíz órát raktunk bele, kb. nulla fagyással. Azért tartottuk meg sokáig, mert hihetetlenül stabil volt mindegyik hardverkonfigurációnkon.

Amiket linkeltél olyat találsz minden Steam játék fórumában. Nem tudunk vele mit tenni, mi nem szoktuk ezeket tapasztalni, azokkal a játékokkal sem, amikre más panaszkodik. A legtöbbször akkor jön elő hasonló, ha a tuning nem működik, de az meg ugye a tuning hibája. És igen tuningnál számít, hogy DX12 vagy DX11. Nagyon sok esetben a DX11-re visszaváltás megoldja ezeket a gondokat, de számos alkalommal felhívta korábban a figyelmet az NVIDIA, hogy ettől a hardver nem lesz stabil tuninggal, csak a DX11 sokkal kevésbé terheli meg, így nem jön elő a tuning instabilitása, ami a DX12-es nagyobb terheléssel előjön. Nem tudnak mit tenni vele, mert a hardver nem stabil DX12-ben, és a tuning visszavétele megoldja. Volt egy hasonló esetünk, és valóban megoldotta a gondot, amikor visszaváltottunk a gyári órajelre.

A szubjektív tesztek az író szubjektív véleményét írják le. Ez nem hazugság, mert mindenkinek lehet véleménye. Viszont ez ettől még nem objektív.

Ha a beállítás nem egyezik, akkor önmagában szubjektív a mérés. És ettől per beállítások tények, csak az eredményt a beállítások termékenként változó eltérése különbsége szubjektívvé teszi. -

Abu85

HÁZIGAZDA

Egyébként csak abba gondolj bele, hogy az efféle felskálázásokat már 2010-ben kifejleszthették volna. Semmi olyan nincs bennük, amire alapvetően a 2010 körül megjelent hardverek nem voltak képesek. Az FSR 2 például tényleg egy szimpla compute shader, az meg már van 15 éve minimum.

A felskálázást tehát nem valami innováció hívta életre, hanem egy szimpla kényszer, amibe belekényszerítették magukat a cégek azzal, hogy szarul csinálták meg iparági szinten az eddigi két RT API-t. És ilyen formában akármilyen hardvert terveznek, hiába vagyunk már a harmadik-negyedik hardveres RT generációnál, maga az API korlátozza a sebességet, amivel hardveresen nem tudnak mit kezdeni. Mi legyen hát, mi legyen hát? Oh igen, számoljon sokkal kevesebb valós pixelt a hardver, és majd a marketing eladja, hogy ez mennyire jó lesz a játékosoknak. Hogy ez egy rakás képi hibát generál? Oda se neki...

Szóval ezt a cégek kényszerből csinálják, nem azért mert olyan nagy ötlet. Ha nagy ötlet lenne, 2010 óta csinálnák, amikor ez technikailag papíron lehetőséggé vált.

-

Abu85

HÁZIGAZDA

Nem kell. Pont ettől szubjektív. A TAA implementációkat például nagyon sokan azért utálják, mert disocclusiont eredményez, ami kiműthetetlen a technikából, hiszen a működési módjának a szerves része. A Threat Interactive pont erre épített fel gigantikus közösséget, ami gyűlöl mindent, ami TAA, mindegy, hogy DLSS, FSR, XeSS, TAAU, stb.

Az FSR1-nek van egy jobb tulajdonsága a TAA módszereknél: sosem eredményez disocclusiont. Ha például megegyezel abban, hogy ez egy kritikus tényező, akkor olyan alapot fektetsz le, amiben a TAA megoldások masszív hibáját felülreprezentálod, és ezáltal a nem temporális technikák fognak nyerni az említett szubjektív összehasonlítási alap mellett.

Az objektivitás szempontjából nem számít, hogy az NV, az AMD vagy az Intel mit gondol, mert a véleményük ebből a szempontból nem objektív így sem. Nem mellesleg ezek a cégek nem azért választanak TAA-s alapot, mert tényleg azt tartják a legjobbnak, hanem azért, mert a felskálázáshoz ennek vannak optimális tulajdonságai, és mellettük megpróbálják a masszív negatívumokat is letolni a torkodon, mintha nem lenne más választásuk. Egyébként lenne.

-

Abu85

HÁZIGAZDA

Beszélhettek. Mindenki beszélhet. Még az újságíró is leírhatja, hogy a saját szubjektív véleménye alapján x VGA-n szebb a piros. És pont ez itt a lényeg. Véleményt írhat, mert csak a saját értelmezésében az, mivel nem tudja objektíven bizonyítani. És a véleménnyel addig nincs gond, amíg azt véleményként közli.

Pontosan, az objektivitás felemlítése ebben az esetben teljesen nonszensz. Mégis vannak, akik megteszik, és ez itt a gond.

A gyártók minden kiadott dokumentum elejébe vagy végébe beleírják ezeket. Pont azért, hogy jogilag ne legyenek felelősségre vonhatók. Ez egy védekezés, mert beperelhetnéd őket, hogy szerinted nem szebb. De így nem tudod beperelni, mert nem azt állították, hogy szebb, hanem a saját szempontjaik szerint tartják szebbnek, és az nem feltétlenül egyezik meg a te szempontjaiddal. Te ettől tarthatod csúnyábbnak, de ez mindegy, mert jogilag így a gyártó nem vonható felelősségre.

-

Abu85

HÁZIGAZDA

A szubjektív véleményeik alapján. És ezzel semmi gond nincs, mert sosem állították azt, hogy ezeket a kijelentéseket objektív tények támasztják alá. Azt mondták, hogy szerintük jobb, és ez így rendben is van. Döntsd el, hogy hiszel-e nekik vagy sem.

Attól egy cég nem hazudik, hogy véleményt közölnek arról, hogy szerintük terveztek egy jobb technikát. Meghatároztak saját szubjektív szempontokat, és aszerint értékelik a munkájukat.

Például az sose mondták ki, hogy xy technika objektíven jobb yx-nél. Mert ez nem meghatározható ilyen egyszerűen, de azt kimondták, hogy xy technikát jobbnak tartják yx-nél. És ez a mondat ugyan nem tényszerű, mert szubjektív tényezőkre épít, de ettől még nem hazugság, mert a saját szubjektív megítélésed adod át, és ehhez cégként neked jogod van. A felhasználónak pedig joga van elhinni vagy nem elhinni.

#49171 PuMbA : Nagyon sok technika azért létezik egymás mellett párhuzamosan, mert nem egyértelmű, hogy melyik a jobb. Ha egyértelmű lenne, hogy az MSAA a király, akkor ma csak MSAA lenne, de mindegyik technikának van valami előnye és hátránya. Emiatt az AA-ra létezik kb. másfél tucat alternatíva, és mindegyiknek megvan a maga pozitívuma és negatívuma. És a munka az nem random, hanem reflektálnak az egyes AA-k negatív jellegzetességeire, majd az az AA, amivel megoldották azt az ominózus gondot rendelkezni fog más negatívumokkal.

-

Abu85

HÁZIGAZDA

válasz

FLATRONW

#49162

üzenetére

FLATRONW

#49162

üzenetére

Az API önmagában nem releváns, mert a képminőségért ingazából a shaderek felelnek. Mivel a shaderek egységesek manapság, bármilyen API-ról is van szó, így lényegében mindegy, hogy milyen API-t futtatsz a háttérben. Ezért van az, hogy a Vulkan és a DirectX 12 is összehasonlítható. Mert ezek csak azt mondják meg, hogy amit számol a hardver az hogyan van menedzselve, de az eredményük megegyező.

#49164 FLATRONW : Ez nem az API-tól függ, hanem a shaderektől. Ha ugyanaz az IR, akkor onnantól kezdve az API mindegy, márpedig ugyanazok voltak a shaderek.

#49166 FLATRONW : A képminőséget továbbra is a shader határozza meg. Akkor tér el a képminőség, ha a shader eltérő, de ez nincs így azokban a címekben, amelyek többféle API-t támogatnak. Már csak azért sem, mert nem lenne túl költséghatékony 400 ezer sornyi kódot újraírni.

#49168 huskydog17 : A szubjektív az, amikor nem meghatározható a vizsgálati szempont, ami objektívvá teheti a mérést. És nem számít, hogy ez le van írva, hogy miért, attól még nincs egyértelmű meghatározás, mert a véleményezés egy ember szubjektív véleménye alapján lesz meghatározva. Ha lenne rá egy meghatározható matematikai tényező, akkor nem kellene magyarázkodni, hogy mit miért csinál valaki így vagy úgy.

Sose mondtam, hogy hazudik, de ettől még szubjektív képet mutat be, és ezzel semmi gond nincs, addig amíg ez nincs objektívként eladva.

Sosem volt probléma a Deus Ex Mankind Divided DX12 módjával, mindig tökéletesen és stabilan lefutott. Azért is tartottuk meg sokáig.

-

Abu85

HÁZIGAZDA

Ezzel nincs is. A szubjektív véleményalkotás még az újságírásban is szabad, ha azt nem próbálod meg objektív tényként eladni. Akkor van gond, ha elkezdik magyarázni, hogy a vélemény, amit írnak az egy objektív tényező.

Amikor már valaki magyarázza, hogy miért csinálja ezt meg azt, az már önmagában szubjektív, mert az objektív tényeket nem kell megmagyarázni. És ez addig rendben is van, amíg valaki úgy magyarázza ezt meg, hogy ezek szubjektív tesztek. Ergo elmondja, hogy amit majd leír az nem tényszerű igazság, hanem egy saját preferenciái szerint értékelt vélemény. Aztán az olvasó eldönti, hogy hisz-e neki vagy sem.

-

Abu85

HÁZIGAZDA

Teljesen mindegy maga a kérdés, hogy melyik milyen, mert ezt megállapítani már önmagában szubjektív tényező. Ezt kell megérteni. Ezért tesztelünk évek óta úgy, hogy ugyanazok a beállítások. És még amúgy így is lehet eltérés a képminőség között, de legalább a hardver oldalán a számítás ugyanaz.

-

Abu85

HÁZIGAZDA

válasz

mozsazsolt0

#49153

üzenetére

mozsazsolt0

#49153

üzenetére

Nincs vita arról a világban, hogy mi a szubjektív és az objektív definíciója. Ettől még gondolhatsz bármit, csak ettől ez a két fogalom már definiálva van.

-

Abu85

HÁZIGAZDA

Aki nézi meg tudja állapítani, de ettől még az a szubjektív véleménye marad, mert nem pont ugyanazt fogja látni, amit más. Emiatt ez nehezen helyezhető objektív álláspontba bele. Kb. olyan az, hogy sokan Blu-ray-re sem váltottak, mert nem érezték hasznát. Ettől függetlenül számtalan véleményteszt volt, hogy a Blu-ray hasznos, de azok is szubjektívek voltak. És egyébként ezzel semmi baj, csak ne próbáljuk meg a szubjektív véleményt objektívnek eladni.

-

Abu85

HÁZIGAZDA

Segítek abban, hogy miért nem jó egy ember látására alapozni. Biológiai értelemben a látás a szem optikai rendszeréig számít objektívnek. Feltételezve azt, hogy mindenkinek a retinájában ugyanúgy érzékelik a fényt a csapok és a pálcikák. Ergo kijelenthetjük, hogy a látott alapok feldolgozása minden embernél egységes. A szemen túl viszont már nem az, mert a kapott adatokat a látóközpont rakja össze. Ez a szubjektív része a látásnak, mert innentől kezdve az agyunk észlelése és értelmezése is nagymértékben befolyásolja, hogy mit látunk. Erre példa az úgynevezett kék-arany ruha jelenség, aminek a lényege az, hogy az emberek egy része egy képen a ruhát kék-feketének, mások pedig arany-fehérnek látják. Hiába ugyanaz a kép, az agyban keletkező észlelési és érzékelési eltérések miatt mást látnak az egyes emberek. Emiatt aki egy tesztben azt mondja, hogy x ilyen és y olyan, akkor azt arra építi, hogy a saját agya úgy érzékeli, de semmilyen objektív alapja nincs arra, hogy azt mondja, hogy mindenkinek az agya azt fogja értelmezni.

A jelenlegi tudományos álláspont alapján a látott kép értelmezése függ attól, hogy a szemünk mesterséges vagy inkább természetes fényhez szokott hozzá, mik a korábbi tapasztalataink az adott kép értelmezésére, illetve mi az agyunk alapvető fénykompenzációs stratégiája. És ez a három tényező minden embernél valamennyire eltérő, ezért bármennyire is furcsa a valóságban mindenki mást lát ugyanazon a képen. Vagyis a szem ugyanazt a képet közvetíti mindenkinek, de az agy más-más módon értelmezi és egészíti ki azt, belehalucinálva bizonyos részleteket. És utóbbi azért nagyon fontos, mert az agy az elvárásaink, az előzetes tudásunk és a kontextus függvényében is értelmezi a látottakat.

Volt az Intelnek nagyon régen egy nagyon érdekes kísérlete, amiben nagyjából 100 ember vet részt. Mindkét gépen pont ugyanaz a kép volt látható, és mindkét gép pont ugyanolyan volt. Amikor nem voltak meg az embereknek az információik az eltérésekről (amik ugye nem voltak) kb. hasonló arányban találták az egyik gép képét szebbnek a másikénál, de nagyobbrészt megegyezőnek mondták a képminőséget. Viszont a második körben az egyik gépre azt írták, hogy azon aktíválták a 4xMSAA-t, a másikon pedig nem. Hirtelen pontosan ugyanabból a tesztből a résztvevők 90+%-a találta a 4xMSAA matricás gép képét szebbnek, miközben továbbra is ugyanazt a képet állították elő, tehát különbség továbbra sem volt a megjelenített tartalom között.

-

Abu85

HÁZIGAZDA

Pontosan. És mivel nem egyenlő, ezért csak szubjektív lehet egy teszt, ami eltérően kapcsolja be őket.

#49125 PuMbA : Beleírják. De ettől még az a mérés nem lesz objektív, ami nem ugyanazt a beállítást alkalmazza az eltérő VGA-kon. Ezt úgy hívják, hogy szubjektív mérés. És ez az FSR4 és DLSS4 összevetésre is vonatkozik.

-

Abu85

HÁZIGAZDA

válasz

huskydog17

#49118

üzenetére

huskydog17

#49118

üzenetére

Az objektív teszt az, amikor ugyanazok a mérési körülmények. Amikor nem ugyanazok, akkor eltérő a beállítás, és az már szubjektív, mert nem tudod garantálni, hogy ugyanaz minden körülmény. Az nem számít, hogy Wolfgang mit gondol erről, mert jó ideje definiálták már a szubjektívet és az objektívet. Akkor van jelentősége, hogy valaki mit gondol, ha valamire nincs definíciónk, akkor lehet rajta vitázni. És nyilván azért látod úgy, hogy sokaknak nem evidens, mert többen vannak azok, akik ismerik a szubjektív és objektív definícióját, mint azok, akik nem.

-

Abu85

HÁZIGAZDA

válasz

huskydog17

#49114

üzenetére

huskydog17

#49114

üzenetére

Ez a különbség az objektív és a szubjektív teszt között. A ComputerBase szubjektív teszteket akar csinálni.

-

Abu85

HÁZIGAZDA

Bár ez furcsának tűnik, de sokszor nem érdemes a nyilvánvalóval kezdeni.

A Nanite és a Lumen is fejlődik, és mindkettő működése függ némileg a CPU-tól. És bár ezek alapvető, mondjuk úgy, hogy elvi működése nem igazán változik, az implementációjuk nagyon is, mert azért az újabb API frissítésekbe jönnek olyan technikák, amelyek kifejezetten hasznosak számukra, lásd Work Graphs.

Valószínűleg az Unreal Engine nagyon is sokat fog profitálni a Work Graphs API-ból, mert tényleg nagyon hasznos lehet a Nanite és a Lumen szempontjából is, viszont ez nem túl rég jelent meg, és bár biztos, hogy látta az Epic, hogy mi készül, igazából a produkciós szempontból hasznos munkát csak a specifikációk lezárásakor lehet megkezdeni. Tehát előbb látniuk kellett, hogy merre fogják fejleszteni a technikáikat a Work Graphs API-val, és erre már hatékonyabban tudnak reagálni azzal, hogy merre fejlesztik a motor optimalizálását.

Szóval az Epic nem azért késleltette ezt eddig, mert eddig tudták húzni, hanem mert most volt optimális az optimalizálásokat beépíteni.

-

Abu85

HÁZIGAZDA

Gondoltatok már userként arra, hogy ne fizessetek olyan játékért, ami UE5-ön akadozik? Mert van egy rakás olyan játék, ami UE5-ön nem akadozik. Vagy az esetleg oda vezetne, hogy a fejlesztők megoldják az akadozást a játék kiadása előtt, mert félnek attól, hogy nem veszik meg a userek?

-

Abu85

HÁZIGAZDA

válasz

Yutani

#48876

üzenetére

Yutani

#48876

üzenetére

Ez nem lehetséges a mostani API-kkal. A hardverek alkalmasak lennének, de az API limitál.

Talán a Sony tudna dolgozni a GNM-en, mert nekik csak egy hardverhez kell igazodni, és tudnának valami nagyot dobni, de nem hiszem, hogy ez fontos számukra a PS5 Pro konzolon. Túl kevesen veszik ezt a gépet, hogy ebbe ennyi energiát fektessenek.

-

Abu85

HÁZIGAZDA

válasz

gainwardgs

#48868

üzenetére

gainwardgs

#48868

üzenetére

Az azért jön külön, mert az egy nagyon-nagyon lassú kód. Direkt úgy van megírva, hogy ne is fusson jól, lásd az Indiana Jonesban. Nem azért, mert ennyire lassúak a hardverek, hanem azért, mert így van megírva. Ezért adják ki azt külön, mert az nem az ID kódja.

Hasonló a helyzet, mint anno a PhysX esetén. Hiába telt el 10+ év, azért nem gyorsult semmit, mert szándékosan volt lassúra megírva, így miután kihúzták a talajt alóla, itt maradt a rosszul megírt CPU-s kód, ami sosem fog futni semmin, mert koncepcióból van lassúra írva.

-

Abu85

HÁZIGAZDA

Driver ezen nem igazán fog segíteni. A játékban át lehet mondjuk írni a shadereket, de az azért majdnem 500 ezer sornyi kód. Nem egy hét alatt fogják átdolgozni, ha átdolgozzák egyáltalán. Nem is hiszem, hogy az ID-t érdekli ez, mert számukra nem az a kritikus, hogy az GF 50 a 40 sorozat előtt legyen, hanem az, hogy minden VGA-n a lehető legjobban fusson a játék.

A jövőben ez lehet, hogy kisebb probléma lesz, mert a legtöbb shadert azért úgy tervezik, hogy az elérhető hardverek tipikus occupancy limitjéhez igazodjon. Ebből a szempontból nem rossz most a helyzet, mert az RDNA 3-4 és az Ada nagyon hasonlóan viselkedik ugyanazzal a shaderrel. Tehát effektíve bármelyikre is optimalizálják, az jó lesz a másikon. A Blackwell occupancy limitje változott. Tehát ha nem arra optimalizálnak, akkor egy RDNA 3-4 és Ada dizájnokra optimalizált shader nem annyira jó a Blackwellen.

Valószínűbb egyébként, hogy itt a shadereket eleve az RDNA "2"-re írják a konzolok miatt, és a PC-s verzióra csak finomhangolnak. Ez nagyon kellemes irány az RDNA 1-2-3-4 és a Pascal-Turing-Ampere-Ada dizájnoknak, mert nagyon keveset kell változtatni a shaderen, ha kell egyáltalán, és minden elég jól szokott futni. Viszont a Blackwell nem annyira bírja az RDNA 2-re optimalizált shadereket, mások a limitek hardverben. A Blackwell inkább a Maxwellhez hasonlít a limitek szempontjából, de Maxwellre már nem optimalizál senki, mert nagyon specifikusan kell vele bánni, és kevés ilyen hardver van már a felhasználóknál.

-

Abu85

HÁZIGAZDA

Más játékban is volt erre példa. Minél inkább számít egy multiprocesszor bájt/FLOPS tempója, annál inkább limitálja ez a mutató a Blackwellt. Ezzel nem lehet mit kezdeni, ez koncepcióból van így tervezve. Az AI volt a dizájn fókusza és nem a grafika. Csak amíg nem nyúlnak a tensorhoz a játékok, addig az AI része a dizájnnak hasztalan, és a grafikai rész limitjeit nincs minek ellensúlyoznia.

Ezért reklámozza az NV nagyon a felskálázást meg a többképkockás generálást, mert tudják jól, hogy a klasszikus feldolgozási módszerek mellett csonkítottak egy nagyot a dizájnon. Cserébe máshol erősebb lett sokkal a dizájn, csak amíg ahhoz nem nyúlnak hozzá, addig ez nem sokat számít.

-

Abu85

HÁZIGAZDA

Nem csak a Doomban tapasztalható ez. Más játékban is van, hogy az Ada úgy átlagos hatékonyságban jobb, mint a Blackwell.

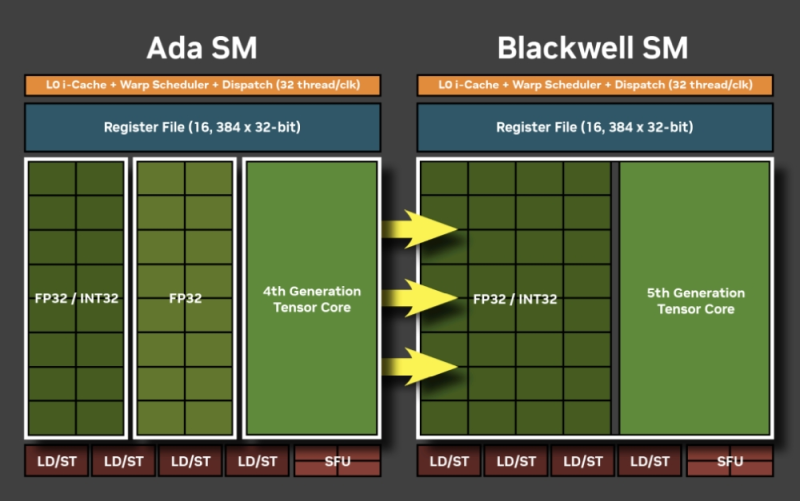

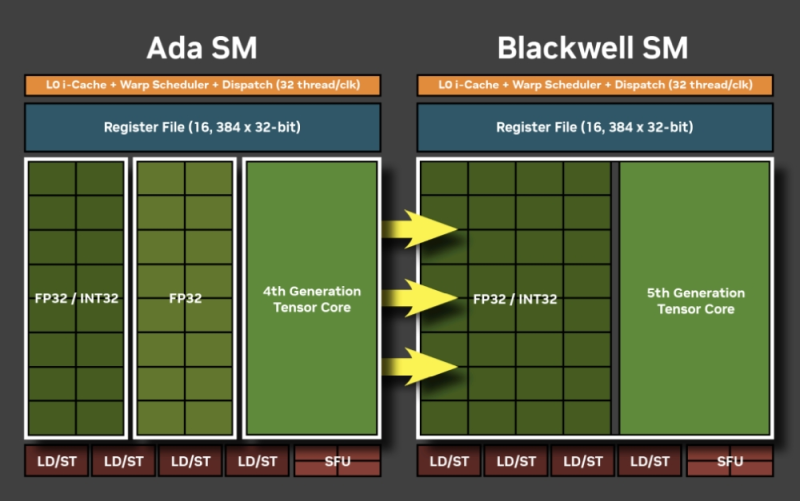

Ez itt a lényeg. Látod, hogy a feldolgozók nem változtak. Szám szerint ugyanannyi van. Viszont az adatút változott. Az a nagyobb FP32 tömb ugyanakkora buszon van bekötve, mint az a kisebbik Ada-féle FP32 tömb. Természetes, hogy nem tudja úgy etetni, mint régen, mert a megmaradt, egységnyi szélességű busz, most kétszer annyi feldolgozót lát el.

Ezzel rohadt nehéz mit kezdeni a szoftver oldaláról, mert a FLOPS ugyan megmaradt, de a bájt/FLOPS feleződött.

-

Abu85

HÁZIGAZDA

Ez nem a szoftveren múlik. Az Ada esetében úgy lehetett etetni a feldolgozókat, hogy volt két szád és két kezed hozzá. Most a Blackwellben egy dupla akkora szájad van, de elvették az egyik kezét. Tehát a Blackwell szájba ugyan befér ugyanannyi kaja, mint két kisebb Ada szájba, viszont a Blackwell már csak egy kézzel lapátolhatja az ételt. Tehát hiába maradt benne ugyanannyi feldolgozó, maga az etetésük sokkal lassabb lett. Ezzel az NV szoftveres csapata nem fog tudni mit kezdeni, mert már nem tudnak rakni még egy kezet a hardverbe, hogy ugyanolyan gyorsan egyen a Blackwell, mint az Ada.

A Blackwell egy más jellegű dizájn, nagyon sok tranzisztort áldoztak olyan dolgokra, amiket a mai játékok nem is tudnak használni. Nem is biztos, hogy a játékok valaha használni fogják, mert nem igazán grafikai fókuszú dolgokról van szó.

Ez a jelenség egyébként nem csak a Doomot érinti, számos játékban látható. Tipikusan azokban a játékokban, amelyek erősebben terhelik a multiprocesszoron belüli adatutak áteresztőképességét, mert ott lett megfelezve a Blackwell az Adához viszonyítva. Ezzel nagyon sok tranzisztort tudott spórolni az NV, csak eltűnt a teljesítmény is vele. Érdekessék, hogy például az RDNA 4-nél pont fordítva dolgozott az AMD. A multiprocesszoron belüli adatutak áteresztőképességét megduplázták, ezért tudja a 7900 XTX-et sokszor megverni a 9070 XT, annak ellenére, hogy számszerűen kevesebb feldolgozó van benne. A szájas példával élve az RDNA 4-nek nem változott a szája, de az RDNA 3-ból örökölt keze mellé kapott még egy extra kezet, hogy lapátolja gyorsabban az ételt.

Ez egy nagyon érdekes és nagyon jelentős döntés volt az AMD és az NV részéről, mert az NV elvett egy kezet a korábbi hardverdizájnból, míg az AMD hozzáadott. Valószínűleg azért döntöttek eltérően, mert az AMD inkább grafikai fókuszú dizájnt akart még mindig, míg az NV inkább AI fókuszút.

-

Abu85

HÁZIGAZDA

válasz

Busterftw

#48778

üzenetére

Busterftw

#48778

üzenetére

Ha 10+ éve mindenki ugyanúgy félreérti az adatokat, attól az még nem lesz érvényes módszertan. Az csak azt jelenti, hogy az emberek következetesen lusták utánanézni, hogyan működik a statisztika, mint tudomány. Olyan ez, mint amikor valaki antibiotikumot szed vírusra. Csak azért, mert mindenki ezt csinálja, még nem lesz okos dolog, csak következetesen tévednek az emberek.

#48790 atok666 : Nem, nem válogat a hardverek között. És ettől torzít, mint a szar.

-

Abu85

HÁZIGAZDA

válasz

TakiNándi

#48770

üzenetére

TakiNándi

#48770

üzenetére

Senki sem tekinti mérvadónak, aki tanult statisztikát.

#48772 Busterftw : A statisztikai módszertan minden statisztika alapja. Anélkül csak haszontalan és értelmezhetetlen adatdömpingről van szó, és nem statisztikáról. És itt fontos, hogy nem az adat mennyisége a fontos, mert ha csinálsz egy olyan statisztikát, ahol egy gépet egymilliószor rögzítesz, akkor rögtön nagyobb lesz az adatmennyiséged a Steamnél. De ugyanott fogsz elbukni, ahol a Steam. A statisztikai módszertan be nem tartásánál, tehát ugyanúgy csak haszontalan adathalmazod lesz.

-

Abu85

HÁZIGAZDA

válasz

Busterftw

#48765

üzenetére

Busterftw

#48765

üzenetére

Azért nem jön ki a matekod, mert a Steam statisztika nem alkalmaz tudományos megközelítést. Van úgy, hogy 100x felkerül egy gép. Hogy lehetne egy olyan statisztika valid, aminél 100x szavazhatsz?

Segítek. Zárt ki a Steam statisztikát, és akkor nem csak nézel, hanem látni is fogsz.

A Steamen pedig azért nem jelennek meg dolgok, mert nem mindig kér adatot a rendszer. És ez nagyon kritikus. Az nem egy automatikus statisztika, engedélyezned kell, sőt, fel kell, hogy dobja, hogy a te adatod ott legyen benne. Tudod, hogy én még mindig a négy évvel korábbi gépemmel vagyok jelen? Rég nincs meg az a gép, de még mindig úgy van a statisztikában, hogy itt van nálam. Hogy lenne bármilyen statisztika hiteles ilyen design flaw mellett...

-

Abu85

HÁZIGAZDA

válasz

TakiNándi

#48752

üzenetére

TakiNándi

#48752

üzenetére

A Steam statisztika azért nem jó, mert nem tudományos, ugyanis nem alkalmaz statisztikai módszertant.

Az AMD-nek jelenleg még mindig 3:1 arányban van előnye az eladásokban az RDNA 4 és Blackwell start óta. Egyszerűen sokkal többet gyártottak az elején. Sőt, még most is többet gyártanak, de már nem sokkal.

#48757 Busterftw : Nem, nem tudja a piaci trendeket mutatni egy tudományos módszertant nélkülöző statisztika. Azért tud olyan hülyeséget kihozni, amilyet kihoz úgy, hogy az AMD lényegesen több Radeont gyártott az elmúlt három hónapban.

A Steam alapvető problémája az, amit már ezerszer felróttak neki, hogy egy gépről bejelentkezhet 100 ember, és akkor 100x lesz az az egy gép regisztrálva. Ezt a Valve próbálja kiszűrni, ezért változott időnként extrém nagyot a statisztika, mert a Valve elkezdte kidobálni azokat a konfigurációkat, amelyeket 100-1000-szer rögzítettek eltérő felhasználónév alatt. Ez mellőzi a teljes tudományos statisztikai módszertant. Elfogadhatod, hogy jó, ha egy gép 100x szerepel a statisztikában, csak ettől még nem lesz jó.

Az NV április végéig összesen 490 ezer Blackwell GeFroce-ot gyártott. Az AMD ~1,2 millió Radeont. Ha 6-8 millió GeForce-ot gyártanának, akkor nem lenne gond, de kell a wafer az AI gyorsítóra.

-

Abu85

HÁZIGAZDA

válasz

Busterftw

#48738

üzenetére

Busterftw

#48738

üzenetére

A Steam statisztika semmire nem jó, mert nem alkalmaz statisztikai módszertant.

Nem a pontossággal van a baj, hanem azzal, hogy a statisztikát mint tudományágat telibeszarja. Konkrétan kibasznának mindenkit az egyetemről, aki ilyen statisztikát csinálna.

#48747 Busterftw : Nem, nem csak az volt a gond. Az a gond, hogy ugyanazt a node-ot használják az AI cuccok, és mivel abban több pénz van, így az NV csak az abszolút minimum mennyiséggel viszi a gaminget, hogy a legkisebb mértékben rontsák a pénzügyi eredményeiket. Emiatt voltak a Radeonok az eladási toplisták élén az üzleteknél. Nem azért, mert az NV nem tud eleget gyártani. Nem is akarnak.

Meg számít az is, hogy a gaming piacon a játékosok eltűrik, hogy mélytorkosra szopatják őket. Szinte tátott szájjal kérik még az alázást. Az AI-piac nem ilyen. Ott egy hosszabb szállítási határidőt azért lemondanak. Nyilván, ha a játékosok eszesek lennének, és nem nyelnék azt, amit kapnak, akkor nagyon gyorsan megváltozna ez, mert rájönne az NV, hogy nem lehet mindent a szátokba tenni.

-

Abu85

HÁZIGAZDA

válasz

Busterftw

#48729

üzenetére

Busterftw

#48729

üzenetére

Ez jelzi nektek, amiről annyiszor írtak már a hozzáértők, hogy mennyire extrém torzító a Steam statisztika statisztikai módszertan nélkül. És amíg a Valve nem kezeli ezt tudományként, és nem alkalmaznak tudományos módszereket, addig a Steam statisztika extrémen torzítani fog a jövőben is. Sajnos nagyon drága lenne alkalmazni egy szakembert erre, hogy összerakja a statisztikájukat, így hát marad a tudománytalanság és az amatőrködés.

-

Abu85

HÁZIGAZDA

Ezzel arra akartam rávilágítani, hogy nem olyan extrém dolog ez, mert minden kormány csinálja.

Szerintem a Foundry-t nem hagyja az USA kinyúlni. Ha mást nem, akkor végső soron kérik a függetlenítést, majd vásárolnak benne 49,9%-os részesedést. Az Intel tervezői része nem fogja érdekelni az USA-t. Úgy lesznek vele, hogy adjanak el mindent, amit lehet a Foudnry-ért.

#48379 b. : Ez a Kína támadja Tajvant dolog még mindig képlékeny. Elszállhat az agya Miximackónak, de logikusan átgondolva, ha belemennek ebbe, akkor azon Kína is veszít, és annyira ingatag lábakon állnak, hogy be is tudnának csődölni egy ilyen támadástól.

Az USA szempontjából fontosak ezek az elvárások az Intel felé. Őket a Foundry érdekli, és az elvárás világos, az Intel adjon el mindent, hogy megmaradjon a Foundry. Még egyébként az sincs kizárva, hogy valakire rákényszeríti az USA az Intel tervezői részlegének felvásárlását. Van pár amcsi cég, amelyeknek van keresztlicencük az Intellel, például AMD, Microsoft, Marvell. Ha minden kötél szakad, akkor kormányzatilag kényszerítik az egyesülést, és cserébe kiírnak egy sok tízmilliárdos tendert, hogy legyen értelme a cégnek megvenni az Intelt. A Microsoft persze necces, mert túl nagy hatalma lenne, az AMD-nek nincs szüksége az Intelre, de a Marvell esélyes, mert nekik még hasznuk is lenne belőle. És itt fontos, hogy például a Marvellnek nem kellene tárgyalnia az AMD-vel a licencről, tehát az AMD sem tudná torpedózni az üzletet. A kisebb licencekről úgyis meg fognak egyezni, mert azok fontosak az AMD-nek is.

-

Abu85

HÁZIGAZDA

A Foudry-nak adnak adófizetői pénzt. Nagy különbség. Az Intel ezt a pénzt nem használhatja fel szabadon, meghatározott dolgokra kell költeni. Ilyet pedig egyébként minden kormány csinál. A TSMC-t is támogatják például Japánban a gyárépítést tekintve. Ebben az USA nem egyedi. És ez sokkal inkább reakció arra, hogy ha Kína is adófizetői pénzzel tömi ki a cégeit, akkor az USA is így játszik, csak átláthatóan és szabályozottan teszik.

-

Abu85

HÁZIGAZDA

Konkrétan követelményei vannak az USA-nak ebből az Intel felé. Tehát elvárják, hogy az építés során mennyi munkaerőt foglalkoztassanak, stb. Tehát ez nem csak szabadon felhasználható pénz, hanem van elvárás is.

A TSMC-nek is adnak így pénzt. Hasonló elvárásokkal. Ilyet csinál Japán is, az EU is, stb. Ez nem egyedi. Nyilván vannak elvárások, amiket a pénzért hozni kell.

-

Abu85

HÁZIGAZDA

válasz

huskydog17

#48319

üzenetére

huskydog17

#48319

üzenetére

Tudom, visszaportoltak képességeket, de nem portolták hozzá vissza az arra szabott RHI-t. És ez így tök jól hangzik, csak nem véletlen, hogy az Epic az egyes képességeket újabb verziókhoz köti.

-

Abu85

HÁZIGAZDA

válasz

huskydog17

#48314

üzenetére

huskydog17

#48314

üzenetére

Maga az UE5 régebbi verzió, ez nagyban akadályozza az egyes lehetőségeket. Azt update-elni pedig nem kis munka, hónapokig tarthat majd. Szóval sok dolgot úgy fognak hagyni, főleg grafikailag.

-

Abu85

HÁZIGAZDA

válasz

huskydog17

#48312

üzenetére

huskydog17

#48312

üzenetére

Inkább az adhatja a TSR előnyét, hogy azt nem kevés extra adattal etetik, és ezeket a többi felskálázó nem kapja meg. Nem tudni, hogy miért, annyira nem érezhették fontosnak a fejlesztők ezeket.

-

Abu85

HÁZIGAZDA

UE5-nek lehet köze hozzá. A traversal stutter jellemzően akkor jelentkezik, ha egy új zóna betöltése történik, és ebből a szempontból valamivel kedvezőbb, ha az eszközlokális memória egyetlen type-ban van benne, ahogy a Radeonon. Az NV-nél egy flag alatt az eszközlokális memória két type-ra van osztva, vagyis a kezelés szempontjából teszem azt egy 8 GB VRAM-os GeForce VGA-n két kisebb menory type-ot használhat az API-ban. Ez nagy különbséget nem okoz nyers teljesítményben, de az olyan motorokban, mint az UE5, ami eleve érzékeny ezekre a traversal stutter dolgokra a zónák betöltésénél, okozhat némileg több akadást, ami a frametime-ot valamelyest ronthatja.

-

Abu85

HÁZIGAZDA

válasz

Yutani

#48292

üzenetére

Yutani

#48292

üzenetére

Driverest. Ez úgy van, hogy az Intel kivette a fast path-okat a kontroll logikából, és ezzel azt is eldöntötték, hogy a DirectX 11-et emulálják, így nem készítenek rá támogatást. Na most ezzel az volt a baj, hogy iszonyatosan lassú volt. Konkrétan olyan címek nem futnak 30 fps-sel, amelyek amúgy mennek több éves IGP-ken. Erre hoztak egy korlátozottabb natív DirectX 11-es meghajtót, majd a fontosabb címeket elkezdték átrakni arra, de ott meg hiányzik a fast path a hardverből, így nem skálázódik jól a rendszer a legtöbb natívan támogatott játékban. Csak azok működnek jól, amelyek deferred contextre vannak írva, ebből meg ugye marha kevés van DirectX 11-en. Ezt viszont már sosem fogják másképp csinálni, mert a DX12 és a Vulkan felé megyünk, de a hardver és a szoftver hiányosságai miatt a retro gamingre nem ajánlott a rendszer, mert sosem tudhatod, hogy melyik emulált játékba futsz bele, és ott tényleg 3-6-9x lassabb lesz a sebesség, mint lehetne. Valahol viszont hasznos volt meglépni, mert rengeteg tranyót spórolnak vele, és mindössze kb. 100 játékra terveztek natív támogatást DirectX 11-hez, tehát sokkal olcsóbb karbantartani a meghajtót, mint például az AMD-nek és az NV-nek, akik minden DirectX 11-es játékot natívan futtatnak. Meg önmagában az emberek erről nem is tudnak, azt hiszik, hogy ha vesznek egy modern hardvert, akkor nem lesz majd baj a 2010-2015 környéki játékokkal. Hát lesz, ha emulálva fut éppen az adott régi cím.

-

Abu85

HÁZIGAZDA

válasz

paprobert

#48290

üzenetére

paprobert

#48290

üzenetére

Az nem az összes cache.

Az Intel már az első Arcból kivette a fast path áramköröket a régi API-kra, ebből sokat spórolnak. Cserébe nagyon-nagyon lassan fut a DirectX 11-es játékok többsége. Ugyanezt az AMD és az NV is meg tudja majd tenni, de ennek ez az ára. Most még nem olyan gyorsak az IGP-k, hogy ez vállalható legyen. Ez egy nagyon paradox választás, mert azt hinnéd, hogy elég erős lesz a hardver a 10 éves játékokra, de azok azért gyorsak a GPU-kon, mert vannak különböző fast path áramkörök a kontroll logikában, plusz van rájuk natív támogatás.

-

Abu85

HÁZIGAZDA

válasz

paprobert

#48288

üzenetére

paprobert

#48288

üzenetére

Nem számolják bele a 8+8 MB cache-t, ami kell a működéshez. Erre van tervezve a GPU, hogy azok a cache-ek ott vannak. Az RDNA 3-hoz nem kell ekkora cache. Elég 2 MB.

Ezen fog változtatni az Xe4, hogy nem kell óriási cache, és nem kell lokalitási elvre optimalizálás, hogy működjön a dizájn. Emiatt közelebb kerül az egész ahhoz, ahogy az AMD és az NV GPU-k működnek.

A másik jelentős különbség az a GPU-k etetése. Az AMD és az NV még ma is beépíti azokat a fast path módszereket a hardverbe, amelyek szükségesek a DirectX 11-es címek gyors futtatásához. Az Intel ezeket már teljesen kihagyja. Emiatt sokkal egyszerűbb az Arc kontroll logikája, mert el lehet távolítani a specifikusan DirectX 11-re szabott adatutakat. Ennek az előnye, hogy kb. 90%-ot spórolnak kontrol logika szintjén a tranzisztorokkal. A hátránya, hogy régebbi API-kkal nem versenyképes a dizájn, és nagyon sok teljesítmény marad benne bizonyos alkalmazásokban. Ez amúgy előnye az Intelnek, hogy nekik nincs összehasonlítási alapjuk az Arc előttről. Nem fogják felróni nekik, hogy egy régebbi DirectX 11-es cím az új IGP-ken 3-6x lassabb, mint a régin. Az AMD-nek és az NV-nek ezt felrónák. Mert kb. ennyi lassulással kell ezen áramkörök nélkül számolni. Nem véletlen, hogy az Arc meghajtónál 200-300%-os gyorsulásokról voltak hírek egy-egy játéknál, amire írtak direkt támogatást. De kb. van több ezer DirectX 11-es cím, és ebből fehérlistás úgy 100-200. Tehát a többség még mindig emulálva fut.

-

Abu85

HÁZIGAZDA

A cache-t a dizájn igényeihez tervezik. Szóval ez nem olyan egzakt dolog, hogy ha az egyikben ennyi van, akkor a másikba is kell. Az Intel azért épít sokkal több cache-t a dizájnba, mert sokkal kevesebb wave-vel dolgoznak, így nekik sokkal ritkább, hogy át tudják lapolni a memóriaelérés késleltetését. Az AMD dizájnja sokkal jobban reagál ezekre a helyzetekre.

Alapvetően ezért van az is, hogy bizonyos játékokban nagyon szar az Xe2, míg bizonyos játékokban nagyon jó. Általában ott jó, ahol a játék shaderei úgy vannak megírva, hogy van alkalmazva némi optimalizálás a lokalitási elvre. (szerencsére a legtöbb AAA cím már ilyen, mert van némi haszna mindegyik dizájnon) Ha nincs, akkor ott nagyon rosszul viselkedik az Xe2, mert hasztalanná válik benne a sok cache.

Az AMD-féle RDNA3 másképp működik, sokkal kevésbé érzékeny arra, hogy milyen optimalizálást alkalmaz egy shader, inkább csak az számít neki, hogy jó legyen a regiszternyomás, és ha az jó, akkor igazából a sebesség is jó. Az Xe2 legalább négy-öt külön tényezőre érzékeny még, és ha az egyik nem jó, akkor a sebesség sem lesz jó.Ez majd az Xe4-ben fog megváltozni, mert az már sokkal inkább hasonlítani fog azokhoz a GPU-dizájnokhoz, ahogyan tervez az AMD és az NVIDIA. Ezáltal nem kell sokkal nagyobb lapkaterületet használni egy adott teljesítményszint eléréséhez, ami az Intelnek egy elég nagy baja jelenleg, mert ki kell tömni a dizájnt cache-sel, hogy működjön, és akkor is csak akkor működik, ha a program erre van optimalizálva.

Pontosan ez volt például a gond a Starfield esetében. Annyira specifikusan csak a regiszternyomásra optimalizáltak, hogy az Arc sebességét máig nem tudták összerakni.

-

Abu85

HÁZIGAZDA

Nem kell. A gaming a teljes kliensnek csak egy picike szelete. Ráadásul folyamatosan egyre kisebb.

Hidd el, Pat Gelsinger nem azért alszik nehezen, mert nem veszik a gémerek az Intel procikat, hanem azért, mert a Foundry égeti a pénzt, és közben a nagyvállalati szférában nem mennek a cuccok. Ha utóbbi menne, minden rendben lenne, még a gémereket is magasról leszarná Pat, mert úgyis kevés pénz van bennük.

-

Abu85

HÁZIGAZDA

válasz

huskydog17

#48141

üzenetére

huskydog17

#48141

üzenetére

Mindhárom gyártó szponzorálta ezt a címet igen sok pézzel. AMD-n csak azért gyorsabb, mert a Call of Duty-n dolgozó stúdiók évek óta kizárólag AMD hardveren fejlesztenek. Ez önmagában nem lenne gond az Intel és az NVIDIA szempontjából, de annyira specifikus optimalizálást kapnak az AMD hardverek, hogy az a pár hétnyi optimalizálási munka az Intel és az NV hardvereken ezt nem tudja behozni.

-

Abu85

HÁZIGAZDA

válasz

huskydog17

#48134

üzenetére

huskydog17

#48134

üzenetére

De 67% nekik is a Quality, csak van valami bug, ami miatt nem skálázódik a sebesség. Nem tudják, hogy hol. Ők már a DirectSR implementációt használják, így gyanítják, hogy ott van valami gabesz. A Microsoft azt javasolta nekik, hogy használjanak újabb Agility verziót, hogy el tudják érni natívan az FSR-t, mert az garantáltan nem ront a sebességen, egyébként meg a driverek a ludasak, és nem tudják program oldalról megoldani. Viszont az Intel és az NV szerint a játék a hibás, és a driverek jók. Az AMD meg azt javasolja, hogy implementálják az új Agility-vel natívan az FSR-t, mert azzal nem is megy ki a program a driverig. Itt állunk most. Kb. mindenki egymásra mutogat, és mivel nincs elérhető profilozó az ilyen jellegű, új API-t használó munkafolyamatra, nem tudják eldönteni, hogy kinél van a hiba.

Valószínű egyébként, hogy valami az Agility betöltőmoduljában van, mert az azért eléggé durva lenne, hogy mindhárom cég drivere ugyanazt a hibát tartalmazza. Csak a Microsoft nem akar ennek a körmére nézni, mert nekik az lenne az érdekük, hogy a DLSS-t és az XeSS-t is natívan tudják implementálni, és ha elkezdenek jönni azok a játékok, amiknél az FSR skálázódik, de a DLSS és az XeSS nem, akkor az NV és az Intel esélyes, hogy ugyanúgy odaadja a kódot natív Agility implementációra. És akkor nem is kell a driver tovább. Szóval elképzelhető, hogy az MS tudja hol a gond, csak addig akarja taknyosra szopatni a renitenseket, amíg nem ugrálnak a kedvük szerint. És alapvetően az MS-nek haszna lenne a natív implementációból, mert akkor azokat tudnák majd szállítani Xboxra is.

-

Abu85

HÁZIGAZDA

Az tényleg létezik. Csak az a kérdés, hogy kell-e a gaming, és jelenleg úgy néz ki, hogy Pat elengedte, mert nem tartja fontos piacnak.

A Lunarral eleve nem mennek semmire, mert csak olcsón veszik meg a gyártók, és nem is készül belőle sok. Így nem hasznos fejlesztés. A Panther nagyobb mennyiségben készül majd, és nagyobb is lesz rajta a haszon.

-

Abu85

HÁZIGAZDA

A Pather Lake-ből eleve nem lesz nagyobb dizájn. A különbség annyi lesz, hogy visszamegy a Lunar Lake-ről a memória az alaplapra. A Lunar legnagyobb gondja, hogy alapvetően túl drágának tartják a gyártók a processzort, annak ellenére is, hogy a memória ott van a tokozáson. Egyszerűen a memóriagyártókkal kötött egyedi megállapodásaik így nem működnek. Az Intel pedig azon az áron nem tartja ezt kifizetődőnek, amennyiért a gyártók megveszik tőlük.

A Nova Lake inkább 2027-es fejlesztés. Addig az S és a HX vonalon Arrow Lake lesz.

Ami jöhet 2025-ben az a Bartlett Lake-S, de az nem biztos, hogy érkezik, mert az csak desktop, és csak LGA1700. De abban lenne 12 P-mag és nem lenne benne kis mag, illetve újra működne a Hyper-Threading is. Viszont ez nem tetszik a menedzsmentnek, mert azt az üzenetet közvetítené, hogy a hibrid téves irány, és már lengetik a kaszát. Jelen pillanatban sokkal hasznosabbnak tartják elengedni a gaminget, mint egyedi dizájnt fejleszteni ide.

-

Abu85

HÁZIGAZDA

válasz

gejala

#48060

üzenetére

gejala

#48060

üzenetére

A Lunar Lake az nagyon kis részben felel majd az eladásokért. Az egy prémium termék, ami kb. ha 5-10%-a lesz a teljes mobil eladásoknak. Ezért nem lesz közvetlenül utódja, mert már nem éri meg a piac törpe szeletéért külön dizájnt tervezni, mert a pénzt viszi, de kevés a direkten realizálható nyereség rajta. Sokkal inkább fog a mobil eladásokért fellelni az érkező Raptor Lake és Arrow Lake felhozatal, ami jön a Core 200 sorozatba.

Ugyanígy az AMD-nél is kisebb részben felel majd az eladásokért a Strix Point. Sokkal inkább a meglévő Hawk Point és az érkező Kraken Point adja majd az eladások zömét. Bár az valószínű, hogy a Strix Pointnak százalékosan nagyobb szerepe lesz az AMD-nél, mint a Lunar Lake-nek az Intelnél, de ez csak azért van, mert jóval nagyobb területet fed le a piacból.

-

Abu85

HÁZIGAZDA

A szoftver is egész jó, de van némi különbség az Intel és az AMD drivere között.

Explicit API-val az AMD egy PAL-on keresztül futtat mindent, tehát gyakorlatilag a teljesítménykritikus részei a drivernek nem különválasztottak, hanem minden PAL-on fut, és ahhoz van egy ICD rendelve, hogy kezeljék az eltérő explicit API-k eltéréseit. Ilyen formában a Vulkan és a DirectX12 ugyanazon a teljesítménykritikus kódbázison fut.

Az Intel nem így csinálja, hanem eleve van két teljesen eltérő implementáció a két explicit API-ra, továbbá még a DirectX 12-höz még vannak eltérő performance kódutak. Tehát effektíve az Intelnek nincs egységes implementációja, hanem DirectX 12-ben két-három performance layerből választják az adott játéknak megfelelőt. Ezért van az, hogy valamelyik játékban nagyon szar a teljesítmény, valamelyikben pedig nagyon jó. De ez nem igazán szoftverhiba, mert koncepcióból csinálják így, úgy van felépítve a driver, hogy több kódút legyen, és majd a készülő játékot elemezve döntik el, hogy mit fognak belőle használni. Ez is működőképes, csak kellene hozzá 3-4x nagyobb humánerőforrás, hogy ezt karban is tudják tartani, mert ugye van egy jó teljesítményű implementáció, és ha azzal egy adott cím nem jó, akkor vannak a fallbackek, amit viszont nem optimalizálnak, mert nincs rá elég emberük. De ettől a szoftver maga jó, csak nagyon kevés programozójuk van ahhoz, hogy egy ekkora kódbázist minden szempontból karbantartsanak.

Ugyanez van egyébként a DirectX 11-es implementációnál is, csak más okból. Ott van egy emulált kódút, és egy natív. A natív teljesítménye nagyon jó, de ha nincs fehérlistán a játék, hogy a natívon fusson, akkor az emulálton fog futni, és ott meg -150-250% teljesítmény vár. De ez nem klasszikusan a szoftver hibája, mert a ráengedett kódúton olyan gyorsan fut, amennyire csak lehet, csak egyszerűen nagyon masszív erőforráshiányban van az Intel, hogy minden kódút gyors legyen.

Lényegében ez egy koncepcionális eltérés. Az AMD-nek az összes támogatott grafikus API-ra van összesen 3 kódútja a driverben a teljesítménykritikus részt tekintve. Az Intelnek ugyanennyi API-ra van legalább 10. És ezzel nem lenne gond, ha háromszor több programozó dolgozna ezeken, de például az Intel driveres csapata kisebb az AMD csapatánál. Tehát a szoftver itt maga jó, csak nincs mögé rakva az a humánerőforrás, amivel minden kódút karbantartható lenne.

-

Abu85

HÁZIGAZDA

A natív render az az, amikor a kijelölt felbontáson számol. Az, hogy mi az élsimítás rajta mindegy.

-

Abu85

HÁZIGAZDA

válasz

gainwardgs

#47896

üzenetére

gainwardgs

#47896

üzenetére

Azok a dolgok hiányoznak, amikre a PS-en ID Buffer van használva, mert ilyen megoldás nincs a PC-s API-kban. Ezek nem lettek átírva, hanem ki lettek vágva.

-

-

Abu85

HÁZIGAZDA

válasz

Busterftw

#43575

üzenetére

Busterftw

#43575

üzenetére

A TSMC-nek csak baja lenne az AMD-ből. A TSMC üzleti modellje épül arra, hogy mindenkinek ugyanannyi esélye van gyártókapacitást szerezni. Aki többet fizet érte, az viszi. Ha megvennék az AMD-t, akkor a TSMC az ügyfelei konkurense lenne. Az egész üzleti modelljük felborulna azzal, hogy maguk versenyeznének a partnereikkel. Ezen sokkal többet veszíthetnek, mint amennyit nyerhetnek. Ráadásul tényleg marha sok pénzbe kerülne az AMD és a Xilinx együtt. Én nem hiszem, hogy 200 milliárd dollár alatti ajánlatot meghallgatnának.

-

Abu85

HÁZIGAZDA

Most veszik meg a Xilinxet, de el akarják adni magukat, világos.

Mellesleg, ha lenne sütnivalójuk a versenyhatóságoknak, akkor nem engednék az AMD-Xilinx üzletet.

Mellesleg, ha lenne sütnivalójuk a versenyhatóságoknak, akkor nem engednék az AMD-Xilinx üzletet.Egyébként megvehetik őket, de jelen pillanatban iszonyatosan komoly kiadás lenne. Az AMD-Xilinx kombinációra 200 milliárd dollár alatt nem hallgatnának meg ajánlatokat. Annyiért meg, hát... azért ez marha nagy költség ám.

-

Abu85

HÁZIGAZDA

Igen, de a GPU scalinget ide belekeveritek (jó nem pont te, hanem más

). Ez nem egy csodafícsőr a driverekben. Tényleg nem való annál többre, minthogy, ha a monitorban nincs saját skálázó, akkor nem lesz kurva szar a natív felbontás alatti kép. Szar lesz, de kurvára. Az, hogy valaki ezt akarja erőltetni driverből egészen szürreális, hiszen egyfajta vészmegoldásnak számít, nem egy általánosan alkalmazandó dolognak.

). Ez nem egy csodafícsőr a driverekben. Tényleg nem való annál többre, minthogy, ha a monitorban nincs saját skálázó, akkor nem lesz kurva szar a natív felbontás alatti kép. Szar lesz, de kurvára. Az, hogy valaki ezt akarja erőltetni driverből egészen szürreális, hiszen egyfajta vészmegoldásnak számít, nem egy általánosan alkalmazandó dolognak.

Ha ez tényleg működne, akkor az AMD és az NV már rég teleplakátolta volna a médiát, hogy ezt használjátok a játékokba épített res. scale helyett.

-

Abu85

HÁZIGAZDA

Szerintem az a baj, hogy kicsit kevered a fogalmakat.

A GPU skálázás az a hardverben egy fixfunkciós blokk. Az Intelnek, az AMD-nek és az NV-nek is van ilyen, és mindegyik Lanczos skálázást alkalmaz. A filter az maga az élesítő. Ez is van az Intelnek, az AMD-nek és az NV-nek is. Persze különböző shaderek, de ezek alapvetően az ALU-n futnak, csak nem szabványos shader nyelvben vannak írva, hanem a driver absztrakciós nyelvén.

A GPU skálázás az a hardverben egy fixfunkciós blokk. Az Intelnek, az AMD-nek és az NV-nek is van ilyen, és mindegyik Lanczos skálázást alkalmaz. A filter az maga az élesítő. Ez is van az Intelnek, az AMD-nek és az NV-nek is. Persze különböző shaderek, de ezek alapvetően az ALU-n futnak, csak nem szabványos shader nyelvben vannak írva, hanem a driver absztrakciós nyelvén.Egyáltalán nem egyedi tehát a gyártóknál a GPU skálázás a hardveres blokkal, illetve az élesítés a driver specifikus shaderével. Mindenki tudja ezt, ami miatt nem reklámozzák, hogy irtó szar minőségű eredményt ad, ahhoz képest, mintha egy játékban kérnél mondjuk 70%-os resolution scale-t, és arra raknál élesítést akár a driverből, de inkább a játékból. Ettől függetlenül lehet használni, akármelyik gyártó driverével, csak tényleg marhára szar lesz a minőség, és kapsz egy rakás ringing képhibát.

Az FSR-nek a Lanczos egy töredéke. Nem emiatt működik, hanem az élrekonstrukció miatt.

A grafikai eljárások egyébként ritkán teljesen újak. Valamire épülnek, és azokat egészítik ki lényeges újításokkal. De ettől a gyártó nyugodtan mondhatja rá, hogy házon belül készült, mert vettek egy alapot, amin elindulnak, és csináltak egy házon belüli új eljárást. -

Abu85

HÁZIGAZDA

Alexander Battaglia írt hülyeséget. A Tom's Hardware csak kontroll nélkül átvette. Nyilván így sem valami jó döntés volt, hiszen megnézhették volna a forráskódot, de az ő részükről a hamis információ inkább lustaság, mintsem tudatos.

Az AMD-nek is van a GPU-jában Lanczos skálázója. Még az Intelnek is. Több évre visszamenőleg igaz az a megjelent GPU-kra. Az, hogy ezt 2021-ben fedezi fel valaki, hát külön vicces.

Az AMD ezt házon belül fejlesztette. A Lanczos az egy kiváló általános skálázó algoritmus, de van egy rakás olyan probléma vele, amiért nem optimális valós idejű számításra, és nem kevés képi hibát is generál. Az AMD vette az alapalgoritmust, és felgyorsították valós idejűre, emellett leszámoltak a képi hibákkal az élrekonstrukció által. Utóbbi a fontos eleme az FSR-nek. A Lanczos csak felskáláz, de a minőséget a élrekonstrukció hozza vissza, és az RCAS teszi teljessé az eredményt. Ezt nem tudod driverből alkalmazni, mert a GPU-k beépített skálázójában nincs semmi élrekonstrukció, az túl bonyolult lenne, illetve a külön aktiválható élesítés nem a tone mapping után történik meg, így olyan post-process effekteket is elkezd élesíteni, aminek ez árt. Arról nem is beszélve, hogy a LOD-bias sincs hozzáigazítva az eredményhez.

Be tudod kapcsolni az AMD és az NV driverekben is az élesítést, dobhatsz be GPU-s skálázást is, nem nagy kunszt az sem, ott van régóta a hardverekben és a driverben, de megközelíteni sem tudod ezekkel az FSR minőségét. Ha meglehetne tenni, akkor az AMD és az NVIDIA is ezt ajánlaná a külön játékokba építhető felskálázó eljárásaik helyett. Sőt, a GPU skálázás miatt egy rakás ringing képhibát is kapsz. Ezért nem hallod sem az AMD-től, sem az NV-től, hogy ilyet csinálj. Tudják ők, hogy rosszabb lesz a minőség, mintha a játékban kérnél skálázást és élesítést.

-

Abu85

HÁZIGAZDA

válasz

Petykemano

#43557

üzenetére

Petykemano

#43557

üzenetére

Nem volt bekészítve. Szeretem amikor valaki hülyeséget állít, és a média átveszi. Ezekre gyorsan meg lehet írni a cikkeket.

-

Abu85

HÁZIGAZDA

Egyáltalán nem használja az NVIDIA szűrőként a Lanczost. Mint írtam a GPU-k nagyon nem szeretik a gyökvonást és a trigonometrikus függvényeket. Ennek az az oka, hogy ezt a fő FP32-es ALU-k nem támogatják. Egy mai tipikus GPU egy gyökvonást 16-64-szer lassabban tud elvégezni, mint egy alapműveletet. Ezért tudta az AMD a Lanczost 20-30-szorosára gyorsítani a saját közelítésre használt egyenletükkel. Egyszerűen már nem a speciális ALU-kat használják, hanem a fő ALU-kat, amikből sokkal több van a GPU-kban. Ez nyilván architektúrafüggő, némelyik hardveren az AMD algoritmusa akár 70x gyorsabb is lehet, mint a tradicionális Lanczos.

Amiről a Lanczos szóba került az a GPU scaling a driverben. Ez sok-sok éve része a Radeon és a GeForce drivereknek is. Ez a beállítás egy fixfunkciós blokkot ér el a GPU-kban, ami Lanczos skálázást kínál, ezért nem lehet minden hardveren aktiválni. De ezzel a Lanczos tipikus képi hibái is megmaradnak, szemben az FSR-rel, ami nem csak Lanczos, így például FSR-nél a ringing errorral nem kell számolni.

Jó lenne, ha az FSR minősége és sebessége hozható lenne driverből, de sajnos ez a jelenlegi képfeldolgozási futószalagok mellett lehetetlen. Ezt muszáj játékba építeni, pont azért, hogy eltüntesd az alapeljárások tipikus képi hibáit.

-

Abu85

HÁZIGAZDA

válasz

Petykemano

#43538

üzenetére

Petykemano

#43538

üzenetére

Semmi. Ugyanonnan veszik a GDDR6-ot. Az a hír kamu, hogy drága a GDDR6.

-

Abu85

HÁZIGAZDA

Na most a leépítés nem valószínű, mert az ARM azért elég sok lábon áll. Nyilván a szervert nem feltétlenül kell annyira erőltetni, mert az sok pénzt visz, és gyakorlatilag semmit sem hoz vissza a 0% közeli részesedéssel. Ezt vagy elkezdik jól csinálni, vagy hagyni kell a fenébe. És a jól csinálás alatt azt értem, hogy elkezdenek alulról építkezni, hogy 10 év múlva legyen esély az első 1-2% megszerzésére az x86/AMD64 ellen. Enélkül ez pénzkemence. Az NVIDIA-nak is az lesz, de az ő pénzük, úgy égetik, ahogy akarják.

A brit székhelyet nem érdemes felszámolni, mert ott van az egyetemi háttér. Ha valamit érdemes bezárni akkor az pont az austini iroda, de csakis pénzszűkében. Ennek az oka, hogy irodát könnyebb máshova rakni, mint működő egyetemet építeni köré. Ez egyébként egy elég fontos tényező lehet a felvásárlás során, mert a SoftBanknak nincs lehetősége bezárni a brit székhelyet, nem tudja ugyanis helyettesíteni a Cambridge-i Egyetemet, míg az NVIDIA számára pont a brit székhely a nyűg, mert ők tudják más egyetemmel helyettesíteni a kutatásokat. Valahol szomorú, hogy annyira felhígult a szakma, hogy ezt már egy IT elemző sem látja, miközben az IT fejlesztések jó része egyetemi kutatásból származik.

-

Abu85

HÁZIGAZDA

válasz

Busterftw

#43533

üzenetére

Busterftw

#43533

üzenetére

Én arra hoztam fel, hogy Boris elkezdte nyomni politikai szinten a kritikus infrastruktúra védelmét. Egyszerűen túl sebezhetővé vált politikailag az ellenfelei által a korábbi üzletek révén, és erre minden politikus reagál valahogy. Ráadásul egyre inkább értékek az IT szabadalmak. Nem egy választónak imponálhat, hogy nem akarja az USA-nak adni az ARM-ot. Persze az okosabban át fognak látni rajta, de ilyen ez a politika.

-

Abu85

HÁZIGAZDA

Pont az a probléma, hogy a britek már túl sokszor engedtek, és már politikai nyomás van velük szemben, hogy többet ne engedjenek. Ezért csinálja most Boris azt a politikát, hogy újabban védik a kritikus infrastruktúrákat.

Azt tudnod kell, hogy Boris egy elképesztően populista politikus. És azt látva, hogy az embereknek számít, hogy ne szórják ki a britek a kritikus cégeiket, elkezdték Newport Wafer Fab üzletének felülvizsgálatát, de Kína nélkül csinálják a Sizewell C nukleáris projektet, és most az ARM-hoz is ragaszkodnának. Ez Borisnak most politikai tőke, ami jól jön abban az időszakban, amikor lassan kiderül, hogy a Brexiten durván rajtavesztettek. Most jobban eladható a híveiknek a kritikus infrastruktúra védelme, mint az, hogy ezeket eladják. Politikai szinten azt nem vizsgálják, hogy anyagilag vagy piaci alapon mi érné meg. Lásd Brexit.

-

Abu85

HÁZIGAZDA

válasz

Petykemano

#43474

üzenetére

Petykemano

#43474

üzenetére

Automotive. HPC.

#43477 gainwardgs : Nem a réjtrészing a probléma, hanem a DirectX 12 mód. Lassabb, mint a DirectX 11-es, ráadásul akadozgat is.

Ez szokásos Unreal Engine betegség, ha nem módosítják az alap leképezőt. Régóta az a probléma, hogy a motor a render targeteket mindenképpen üríti az új képkockák számításánál. Erre van beállítva, de igazából nem lenne szükség rá, ha lenne egy olyan kód a motorban, ami meghatározná, hogy egyáltalán ki kell-e üríteni az egyes render targeteket. Ha nem, akkor felesleges munka van velük, ráadásul értelmetlenül.

Külön vicc, hogy ez csak PC-n probléma még mindig. A konzolokra már olyan leképező van, ami tartalmazza ezeket az optimalizálásokat, és persze, hogy optimalizált kóddal sokkal jobban tudnak működni a gépek.

-

Abu85

HÁZIGAZDA

válasz

Petykemano

#43450

üzenetére

Petykemano

#43450

üzenetére

Nem igazán felvásárolták, hanem megvárták a csődöt, és megvették az IP-ket, illetve az egyes országokban a márkanév használati jogát, de ezek jórészt már lejártak, és nem hosszabbították meg.

#43469 b. : A PC gaming addig értékes az NV-nek, amíg pénzt keresnek rajta. Ha nem tudnak pénzt keresni, akkor értéktelen lesz. Tehát azért áraznak felfelé generációnként, hogy pénzt keressenek. Ennyire egyszerű. Alamizsnáért inkább nem csinálnák.

Új hozzászólás Aktív témák

Hirdetés

A topikban az OFF és minden egyéb, nem a témához kapcsolódó hozzászólás gyártása TILOS!

Megbízhatatlan oldalakat ahol nem mérnek (pl gamegpu) ne linkeljetek.

- CURVE - "All your cards in one." Minden bankkártyád egyben.

- Háztartási gépek

- Gumi és felni topik

- Tőzsde és gazdaság

- Intel Core i5 / i7 / i9 "Alder Lake-Raptor Lake/Refresh" (LGA1700)

- Samsung Galaxy Watch7 - kötelező kör

- AMD Ryzen 9 / 7 / 5 7***(X) "Zen 4" (AM5)

- Nagyrobogósok baráti topikja

- Kerékpárosok, bringások ide!

- Víz- gáz- és fűtésszerelés

- További aktív témák...

- Eredeti Windows 10 / 11 Pro aktiválókulcs AZONNALI SZÁLLÍTÁSSAL!

- Apple iPhone 7 32GB, Kártyafüggetlen, 1 Év Garanciával l

- Azonnali készpénzes nVidia RTX 3000 sorozat videokártya felvásárlás személyesen / csomagküldéssel

- ÁRGARANCIA!Épített KomPhone Ryzen 5 5600X 16/32/64GB RAM RTX 4060 8GB GAMER PC termékbeszámítással

- Bomba ár! Fujitsu LifeBook U7310 - i5-10GEN I 16GB I 256SSD I 13,3" FHD I HDMI I Cam I W11 I Gari!

Állásajánlatok

Cég: PCMENTOR SZERVIZ KFT.

Város: Budapest

Cég: Promenade Publishing House Kft.

Város: Budapest

![;]](http://cdn.rios.hu/dl/s/v1.gif)

Mellesleg, ha lenne sütnivalójuk a versenyhatóságoknak, akkor nem engednék az AMD-Xilinx üzletet.

Mellesleg, ha lenne sütnivalójuk a versenyhatóságoknak, akkor nem engednék az AMD-Xilinx üzletet.