- Pánik a memóriapiacon

- Monitorkalibráló eszközök

- Mennyibe fog kerülni a Steam Machine?

- Azonnali fotós kérdések órája

- OLED monitor topic

- Milyen notebookot vegyek?

- Ne már! Drágább lesz a GPU a memóriapánik miatt?

- NVIDIA GeForce RTX 5070 / 5070 Ti (GB205 / 203)

- Autós kamerák

- Belerohan a hazai piac Kína saját csúcsmemóriáiba

Új hozzászólás Aktív témák

-

Abu85

HÁZIGAZDA

válasz

atok666

#42682

üzenetére

atok666

#42682

üzenetére

Az UL megkérhette őket, hogy ennek a tesztnek a shadereit ne fordítsák a mesh/primitive pipeline-ba. Ez a 3DMark szempontjából fontos. Az AMD-nek ez nem sok munka, mert ki tudnak jelölni a meghajtóban egy programot, aminek az indítását detektálják, és annak egyes shadereit legacy futószalagra fordítják. Akinek ezzel sok dolga lesz az az UL, hiszen az AMD meghajtójára így muszáj engedni az "alkalmazásspecifikus optimalizálást", és ha köcsög az AMD, akkor elkezdik lecserélni a 3DMark többi shadereit is, ezzel nyerve 2-3 ezer pontocskát per kártya. Ezt majd az UL-nek folyamatosan ellenőriznie kell.

#42684 b. : Az AMD-nek jók mesh shaderrel és anélkül is a portok. Úgy van felépítve a hardverük és a fordítójuk, hogy minden esetben az NGG módban fut a program. Ha most egy fejlesztő a vertex/geometry shaderek mellé akar írni mesh shadereket is, akkor csak nyugodtan. A stúdióknak és kiadóknak fog jelentősen nőni a játékra levetített support költség nem az AMD-nek.Egyébként a legnagyobb gond, nem az, hogy nem tudsz mesh shadert írni, hanem, hogy az átállás nagyon drága. Egyrészt minden geometriára vonatkozó shadert kétszer kell megírni. Egy komplex játéknál az simán +50 ezer sor. Másrészt mindkét kódbázist szállítani kell, mert a legacy kártyákat támogatni kell. Az tesztelés szintjén dupla munka, ami végeredményben megduplázza a support költséget. Szóval ez nem egy olyan döntés, amit egyszerű meghozni. Ha nincs meg az anyagi háttér a mesh shaderhez, akkor nincs értelme beépíteni.

-

DudeHUN

senior tag

válasz

atok666

#40775

üzenetére

atok666

#40775

üzenetére

Jelenleg. A jelenlegi még a HDD-ket, mint szűk keresztmetszetet is számításba vevő programok alatt. Viszont Open World játékokban és rá optimalizált tartalomban sok haszna van. A nextgen gépekre fejlesztő szakemberek is ezt emelik ki, mint az egyik hatalmas ugrást. Legalábbis, azok akikkel eddig beszéltem.

-

válasz

atok666

#39108

üzenetére

atok666

#39108

üzenetére

Na varjunk csak, azt azert latni velem, hogy a magszam novelesevel nem nagyon csokken a frekvencia... Amit te mondasz, az alapjan eleg lenne 10-12 mag/sub 4ghz is, es az is lazan verne a 4.8ghz 6 magosokat.

A Ryzenek esetén eddig nem a magszám miatt volt alacsonyabb az 1-2 magra kitolható max turbo frekevencia, hanem mert a gyártás technológia miatt nem tudtak magasabb órajelet kipréselni.

-

Abu85

HÁZIGAZDA

válasz

atok666

#39106

üzenetére

atok666

#39106

üzenetére

A mai rendszereknél a magszám növelésével nem igazán kell hozzányúlni az órajelhez. Maga a hardver elintézi ezt, ha nem tudja tartani az adott fogyasztási kereten belül. Egyszerűen fel van rá készítve, hogy a megfelelő szintre vegye vissza, ha az adott munkafolyamat ezt megkívánja. Például bizonyos AVX módoknál még a közölt alapórajel alá is visszamehetnek a procik. Nem probléma, mert stabilitási gondokat nem okoz, tehát nyugodtan meg lehet adni a specifikációra a magas órajeleket, a hardver majd eldönti, hogy mit állít be magának.

Simán meg tud verni egy 12-magos egy hatmagost egy NUMA-aware motorban, amely nem tartalmaz legacy pathot az öreg API-kra. Ilyen motorok készülnek most. Nyilván a fejlesztők is tudják, hogy az órajelben már nem bízhatnak. Ezt az Intel is folyamatosan kommunikálja nekik. Már csak azért is, mert a 10 nm-es Ice Lake mintája 3 GHz fölött nem stabil. Ezen persze még lehet növelni, de a 10 nm-es node-ot nem a magas órajelre tervezték, hanem egy rendkívül low-power optimalizált megoldás annak érdekében, hogy annyi magot lehessen a lapkába rakni, amennyi van a dinnyében. Ezért sem lesz Ice Lake asztali szinten egy jó darabig, de egyébként készül oda egy 20-magos verzió, csak egyelőre jobb a Comet Lake, viszont 2020-ban már jöhet a sok mag, mert bőven skálázódnak majd az új játékok.

-

Abu85

HÁZIGAZDA

válasz

atok666

#39080

üzenetére

atok666

#39080

üzenetére

Az Intelnek ~70% a GPU-piaci részesedése, és ez nagyrészt abból van, mert az OEM-ek ezt rakják a gépekbe. Szerinted most érdekli őket, hogy ez a felhasználóknak jó-e? Másrészt a felhasználókat érdekli, hogy van jobb? Az a helyzet, hogy a piacnak a jelentős része nem igazán tudja, hogy az Intelt, az NV-t és az AMD-t eszik vagy isszák-e.

-

Abu85

HÁZIGAZDA

válasz

atok666

#38439

üzenetére

atok666

#38439

üzenetére

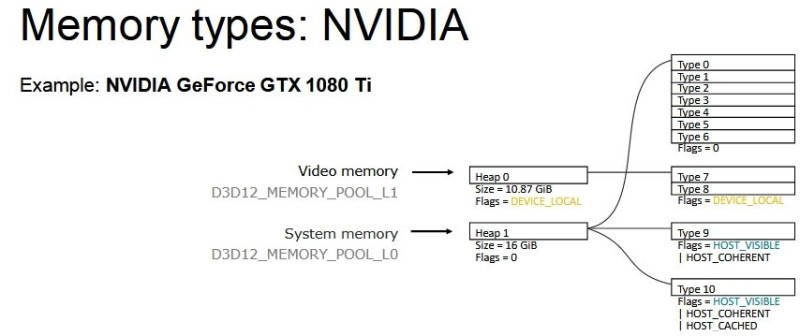

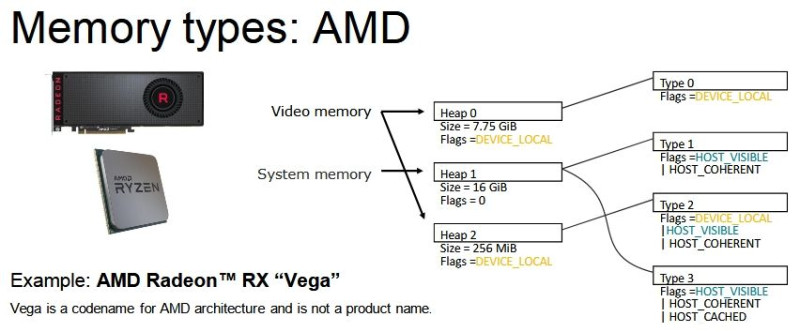

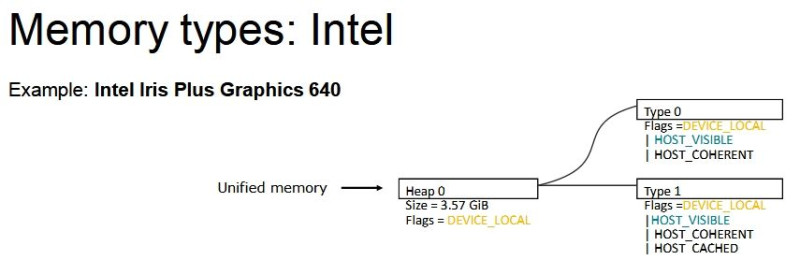

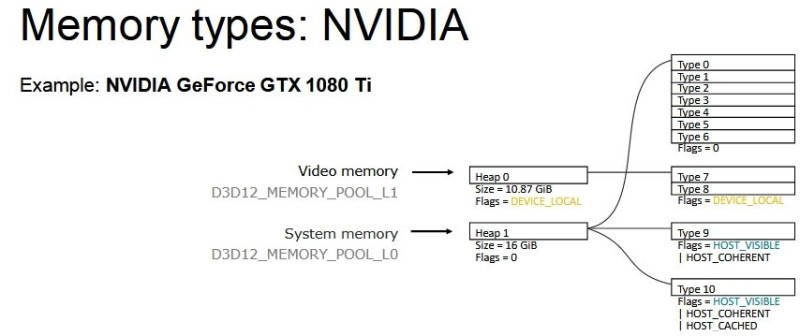

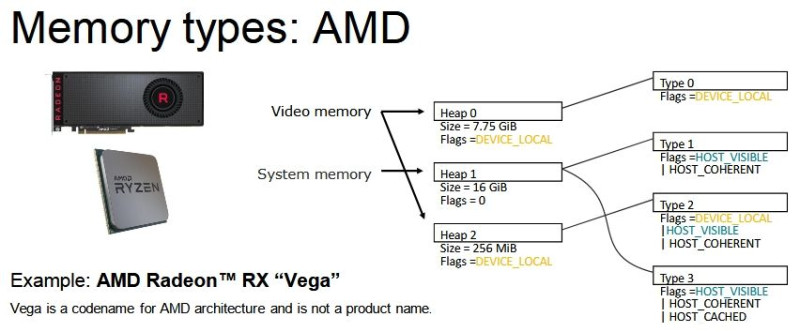

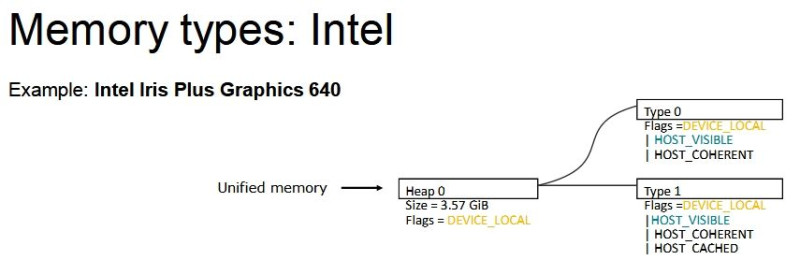

Az allokációk lehetnek eltérő méretűek, de nem célszerű mondjuk nagyon kicsi allokációkat csinálni, mert eléggé eltérő az, ahogy az AMD, az Intel és az NV drivere kezeli a memóriát.

DX12-ben (és Vulkan API-ban is) nem a nyers mennyiség határozza meg igazán a működést, hanem a memória strukturális felbontása:

Na most egy olyan megoldás kell, ami jól működik a fenti három struktúrán belül. Tehát az nem elég jó, hogy működik AMD-vel, mert akkor az Intel és az NV szopni fog. Egy közös többszöröst kell keresni.Ha ez megvan, akkor ott a töredezettség problémája, vagyis vagy ugyanolyan méretű lesz minden allokáció, ami nem túl szerencsés, vagy végül a sok allokáció cseréje miatt fragmentált lesz a VRAM egy idő után. Tehát előfordulhat, hogy van szétszórtan 200 MB szabad hely, de nincs egybefüggően, tehát mindenképpen törölni kell egy allokációt, hogy egy új 200 MB-os beférjen.

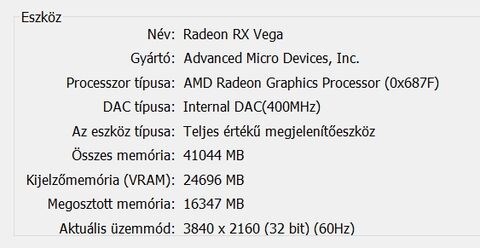

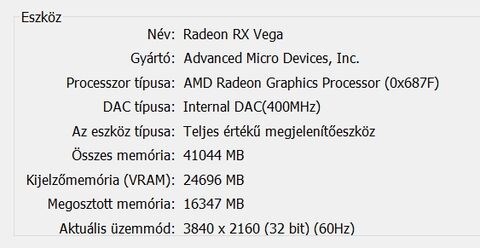

Itt láthatod, hogy ha azt a fekete allokációt a rendszermemóriából be akarod másolni a VRAM-ba, akkor egyszerűen nem tudod megtenni, mert nincs annyi egybefüggő szabad hely. Ki kell törölni mondjuk a pirosat és a zöldet. Ugye itt a HBCC is látható, ami lényegében azt valósítja meg, amit kvázi elgondolsz. Ne is másold az allokációt, hanem csak a szükséges lapjait. Mindegyik lap ugyanakkora, tehát a töredezettség kizárva, illetve mindig az van a memóriában, ami kell. De a jelenlegi API és WDDM kombinációja ezt a megoldást nem támogatja. Nem erre tervezték a rendszert. Meg lehetne oldani, viszont akkor nulláról kell kezdeni az egészet, vagyis új API, új display model, új meghajtók, új hardverek, új OS.(#38440) mormota79: Nem annyit használ, hanem jóval kevesebbet, de mivel a WDDM-et nem tervezték ilyenre, ezért az AMD meghajtója egy trükköt alkalmaz. Amikor bekapcsolod a HBCC-t, akkor keletkezik egy olyan erőforrás, aminek a fedélzeti memóriája megegyezik a beállított HBCC szegmenssel. Legyen az mondjuk 24 GB.

Ilyenkor az OS felé és a programok felé az egész VGA úgy néz ki, mintha egy 24 GB VRAM-mal rendelkező hardver lenne. Ez alapvetően befolyásolja a programok által kiolvasott adatokat, hiszen a meghajtónak el kell rejtenie mindent, ami a háttérben történik ahhoz, hogy az OS felé gyakorlatilag tudjon hazudni a valós hardverről, amin fizikailag nincs 24 GB-nyi memória. Na most ezt még az AMD saját eszközei sem tudják mérni, mert nyilván hazudnia kell az adatokról a meghajtónak, hogy a háttérben a HBCC működhessen, és az AMD profilozói is ezeket a hazugságokat látják csak, ahogy például egy 3rd party program is csak ennyit tud elérni, plusz a Windows is csak ennyit lát. Egyébként létezik egy külön hardver, amit a fejlesztők igényelhetnek. Ez lehetővé teszi, hogy a HBCC mód valós működését kiolvashassák, de ehhez nem lehet hozzájutni átlagemberként. Szóval mi csak azt láthatjuk, amit a driver hazudik. -

Abu85

HÁZIGAZDA

válasz

atok666

#38434

üzenetére

atok666

#38434

üzenetére

Úgy kell elképzelni, hogy a VRAM-ba allokációk kerülnek. Mondjuk van egy adat, ami kell, de az nincs benne a VRAM-ban, akkor az API-n keresztül megkereshető, és az az allokáció, amiben van az adat a rendszermemóriából átmásolható a VRAM-ba. De mindegy, hogy mennyi adatra van belőle szükséged. Ha csak 4 kB-ra, akkor is másolni kell a teljes allokációt, ami lehet akár 100-400 MB is. Tehát 4 kB-ért elpazarolsz akár 400 MB-ot. Ez egy extrém eset, de lényegében erről van szó. Nyilván egyébként az adott allokációkból nem csak 4 kB fog kelleni, de eléggé tipikus, hogy nem kell majd az összes, sokszor még az 50%-a sem, de muszáj másolni, mert másképp nem nem működik a mostani rendszer.

Az AMD pont ennek a gyökerébe nyúlt bele a HBCC-vel. Ez a rendszer lapalapú. Azt mondja, hogy ha csak az a 4 kB kell, akkor másold csak azt, ne rakjál emiatt 400 MB-ot a VRAM-ba, ami aztán úgyse kell. -

HSM

félisten

válasz

atok666

#38335

üzenetére

atok666

#38335

üzenetére

Szerintem az, ha mondjuk egy olcsóbb, egyszerű hatmagoson, pl. i5-8400 is meglenne mondjuk egy erős 100FPS.

Egy közepesen erős négymagos, mondjuk 2-3 éves i5-ön meg menne a jelenlegi felállás szerint kb. szűk 50 FPS-el?

Szóval elfogadhatónak találom az igényt, de azért lehetne kedvezőbb.

A 8700K azért egy bitang erős jószág.

A 8700K azért egy bitang erős jószág. -

#04430080

törölt tag

válasz

atok666

#38307

üzenetére

atok666

#38307

üzenetére

Hogy erős HW -en szarul fut?

Bár a kommenteket olvasva úgy látom van elég gond mindennel![;]](//cdn.rios.hu/dl/s/v1.gif)

-

Abu85

HÁZIGAZDA

válasz

atok666

#33474

üzenetére

atok666

#33474

üzenetére

Pont ez a lényeg. Ha a tömeg nem tudja, hogy mi az, akkor a Win32-es géppark alaposan megcsappan, így pedig a fejlesztőknek az UWP-t kell figyelni, hogy ne csak a Windows 10 felhasználók egy részét tudják célozni. A Microsoft nyilván tudja, hogy miképp lehet ezt ügyesen kivezetni. Észre sem veszed, és már el is tűnt. Küzdeni sem tudsz ellene, mert azokat az embereket kell ennek a dolognak a hasznosságáról meggyőzni, akik azt sem tudják, hogy mi az. Sőt, a legtöbb felhasználó eddig nem fog eljutni. Elfogadják, hogy szimpla frissítéssel nekik lehet Win32-jük, ráadásul ingyen, bele se gondolnak, hogy ha mondjuk 10-ből 7 ember nem kéri a frissítést, akkor a userek maguk ássák a Win32 sírját.

-

Abu85

HÁZIGAZDA

válasz

atok666

#33444

üzenetére

atok666

#33444

üzenetére

Miért lenne ettől más a PC? Csak annyi történik, hogy a dedikált GPU-kat felváltják a tokozott GPU-k. A céljuk ugyanaz lesz, a teljesítményben is sokáig elmehetnek a HBM3/4-gyel, csak nem 10 cm-re lesznek a procitól, hanem magán a processzoron, vagy amellett. Ez mitől apokalipszis? Ugyanúgy lehet majd ezen is játszani.

A Win32 elvesztése sem egy apokalipszis. Az S mód elsődleges célja, hogy csökkentse a Win32-t futtatni képes gépek számát. Az MS már régóta ezt tervezi, de nehéz megtenni olyan módon, hogy ráerőszakolják a userre, amit nem akarnak. Az S mód nem ezt csinálja, hanem azt, hogy az adott gép alapértelmezetten nem lesz képes Win32-es programokat futtatni, de a user opcionálisan telepíthet egy kiegészítést, ami ezt a képességet hozzáadja a rendszerhez. A Home a vásárlás után egy rövid ideig ingyenes lesz, míg a Pro állandóan fizetős. A gyártók többsége marad majd az S módnál, mert az MS felé kisebb a licencköltség még akkor is, ha a Home ingyen van a user oldaláról. Ez így első hallásra nem számít nagy dolognak, de a helyzet az, hogy a Windows 10 S tapasztalata alapján a userek közül 70%-nál több vásárló nem foglalkozott a frissítéssel, annak ellenére sem, hogy ingyenes volt. Ergo az S móddal jelentősen meg lehet kurtítani a Win32-re képes gépek számát, miközben a kritikus tömeget el lehet azzal hallgattatni, hogy ha kell, akkor frissíts ingyen Home verzióra. Az eredménye ennek nem ma fog megmutatkozni, hanem pár év múlva, amikor annyira kritikus lesz a Win32 alkalmazásokat futtatni képtelen Windows 10 konfigurációk száma, hogy a fejlesztők inkább átállnak UWP-re, mert azzal minden Windows 10 usert egyszerre célozhatnak. Ezután a Microsoft már komolyabb következmények nélkül kivághatja a Win32-t, és az aktuális kósza tervek szerint áthelyezhetik felhőbe.

(#33445) Crytek: Explicit API-ról beszéltem mindig, nem csak a DX12-ről. Az Explicit API-t használó játékok száma jelenleg 64.

-

Dtomka

veterán

válasz

atok666

#32983

üzenetére

atok666

#32983

üzenetére

Nem biztos, hogy rossz 5let. Nagyon sok függ az ártól.

Bár szerintem ezt a célhardvert csak az igazi ("akik nagyban üzik") bányászok fogják venni, ha jobban teljesít mint 1 hagyományos vga.

Reméljük, hogy sikeres termék lesz, és ezáltal a játékosoknak szánt vga-k a jó áron a játékosokhoz elér

Én nem kívánom, hogy bedőljön a bánya. Miért tenném? Azért mert valaki sokat veszít attól én nem leszek gazdagabb, csak 1 kárörvendő a sok közül.Tény, hogy a helyzet egyre rosszabb, és valamilyen megoldást kell mielőbb találni!

1x én is leszeretném cserélni a 1070-et

-

Kolbi_30

őstag

válasz

atok666

#28959

üzenetére

atok666

#28959

üzenetére

a steam statisztika nem reprezentativ, mert nem mindenkit kerdez meg, nem mindenki adja meg az adatokat...stb max azt mutatja meg hogy a megkerdezettek és válaszolok kozul kinek mi van..meg nincs benne az se aki nem hasznal steamet..mert lehet nelkule elni.

ha benne lennenek a banyaszok is lehet nem 80/20 lenne hanem 40/60...akkor meg ezen lenne a nyaladzas.. -

válasz

atok666

#28289

üzenetére

atok666

#28289

üzenetére

nem. a konzolok bottleneckei mások. kizárólag a kirajzolás szempontjából (trolloknak: amikor azt írtam, hogy a kizárólag a kirajzolás szempontjából, akkor azt is értettem, hogy kizárólag a kirajzolás szempontjából, ennek megfelelően azt is gondoltam, hogy kizárólag a kirajzolás szempontjából): képes lenne részletesebb modelleket is használni, de kevés shader van benne (az xoneban 768, a ps4ben 1152, a multiplatform címeknél a kevesebbre fejlesztenek, így a ps4nél meg örülnek, hogy gyorsabban fut), ergo felesleges (és végeredményben nagyon kínos) olyan modelleket használni, amelyekre az effektek kiszámítása meghaladja a készülék erejét.

a különbséget a shadinges és shading nélküli képen inkább szemléltetném (általános érvényű, nem ogl specifikus):

a pc, ahol ilyen 2-3-4ezres shaderű vga-k mászkálnak, ráadásul jellemzően magasabb órajeleken, mint a konzolokon, tud mit kezdeni vele. -

válasz

atok666

#28285

üzenetére

atok666

#28285

üzenetére

az artistoknak, akik a modelleket késztik a játékokhoz, nem kell annyira alacsony rajzolási számra optimalizálniuk a modelleket. ez nettóban részletgazdagabb modelleket engedélyez, bruttóban az erre elköltött pénzt (munkaórát) fel lehet használni máshol.

érezni nem fogod a különbséget, mert nincs mihez viszonyítani. sosem tudjuk meg, mi marad ki 1-1 játékból. -

Abu85

HÁZIGAZDA

válasz

atok666

#28285

üzenetére

atok666

#28285

üzenetére

Mert úgy fogod fel az egészet, hogy a grafika sosem fog fejlődni az aktuális szintről. Most már maradunk itt, és nem lesznek többen a jelenetben, nem lesz a látótávolság nagyobb, nem lesz több shadow casting fényforrás, nem lesznek részletesebbek a modellek, stb. De ez téves álláspont. Amint eldobják a motorok a legacy API-kat és azokat a leképezőket, amelyeket igazából a legacy API-k kényszerítenek ki, egy elég nagy ugrásnak lehetünk majd szemtanúi. Ez már nincs messze, hiszen láttunk már next-gen leképezőt lásd object space rendering. De vannak még fejlesztések, például a Frostbite-hoz készülő tiled light tree renderer. Ezek egészen komoly előrelépést kínálnak a mostani tipikus mozaikos vagy jobb esetben klaszteres leképezőkhöz képest. Az egyetlen hátrányuk, hogy kétpofára zabálják a rajzolási parancsot. De ez sem a konzolokon, se a PC-n nem gond, amióta az explicit API létezik. Szóval végre lépkedhetünk tovább. Vannak még egyébként érdekes kutatások, mint például a LABS (az Eidos Montreal R&D részlege) deferred+ koncepciója, tehát nehéz lenne egy domináns irányt kijelölni, de az látszik, hogy az aktuálisan tipikus leképezőkről lépünk tovább.

-

Abu85

HÁZIGAZDA

válasz

atok666

#28281

üzenetére

atok666

#28281

üzenetére

Játékok alatt nem, mert azok messze nem csak rajzolási parancsból állnak, és itt csak a parancs beírása van mérve, miközben azért van más munka is bőven. Viszont a 3DMark API Overhead tesztjében érezhető az ebből eredő gyakorlati gyorsulás. Az direkt erre a problémára lett kialakítva, és mivel nem játék, így olyan mértékű rajzolást is beledobtak, amivel egy mai játék még nem dolgozik. De ez egyébként valós szám, bár az igaz, hogy inkább egy megközelítőleges átlag, mivel nem minden rajzolási parancs egyforma.

A PC-ről most elmondható, hogy túl van a fejlesztési szakaszon. Tehát a megkezdett munkát az év végére befejezik, és igazából szinte minden le lesz másolva a konzolokról. Ez persze nem jelenti azt, hogy nem marad probléma, de azokat már úgy kell megoldani, hogy a konzolos megoldásokat nem lehet áthozni, mert azok nem használnak akkor, ha sok konfigurációval lehet számolni. De ha valami áthozható volt PC-re az aktuális hardverekre, és a konfiguráció sokszínűsége sem akadály, azt lényegében áthoztuk. Ezzel a résszel kész, illetve az év végére kész lesz az ipar/Microsoft. Nem sokkal később a Khronos is. Sok szempontból most sínen van a PC.

-

válasz

atok666

#28281

üzenetére

atok666

#28281

üzenetére

nem érezni, de nem marketing. a korlátokat meg lehet kerülni. pl. erre optimalizálták a modelleket. egy 3d modell akkor volt jó, ha megfelelő idő alatt be lehetett tölteni. ergo a rajzoló addig rajzolta újra és újra, amíg ez nem teljesült. a különbséget nem érzed, mert az eredeti változatot sosem láttad.

-

válasz

atok666

#28148

üzenetére

atok666

#28148

üzenetére

Mondanék NXP-s volumeneket a az adott szektorból, de azért picsán lennék rúgva. Szóval maradjunk annyiban, hogy erősen lead pozícóban vagyunk...

(#28150) Abu85:

Gondolom a háttérben a konkurensek fúrják is az üzletet, hiszen azzal senki se járna jól, ha a Qualcomm-NXP üzlet létrejönne.

Hát a first stepek-en már azért túl vagyunk...

Nem véletlenül van ugye pl a restructured Nexperia....

-

Abu85

HÁZIGAZDA

válasz

atok666

#28148

üzenetére

atok666

#28148

üzenetére

Persze. Ők is figyelik, hogy mi lesz a Qualcomm-NXP felvásárlásból. Alapvetően ezen a piacon messze az NXP a legnagyobb kiszolgáló. Ha a Qualcomm felvásárolja őket, akkor marha nehéz helyzetbe kerül mindenki, mert egyrészt a Qualcommnak marha jó technológiái vannak, és majdnem 40 milliárd dollárért még a piaci részesedést, illetve a kiépített értékesítési csatornákat is felvásárolják.

Egyelőre ugye azt vizsgálják a hatóságok, hogy jogilag aggályos-e a felvásárlás, tehát engedélyt még nem mindenki adott rá. Gondolom a háttérben a konkurensek fúrják is az üzletet, hiszen azzal senki se járna jól, ha a Qualcomm-NXP üzlet létrejönne.

Új hozzászólás Aktív témák

A topikban az OFF és minden egyéb, nem a témához kapcsolódó hozzászólás gyártása TILOS!

Megbízhatatlan oldalakat ahol nem mérnek (pl gamegpu) ne linkeljetek.

- Arc Raiders

- Pánik a memóriapiacon

- Monitorkalibráló eszközök

- A fociról könnyedén, egy baráti társaságban

- Mennyibe fog kerülni a Steam Machine?

- Konteó topic

- Azonnali fotós kérdések órája

- Call of Duty: Black Ops 6

- OLED monitor topic

- Vivo X300 Pro – messzebbre lát, mint ameddig bírja

- További aktív témák...

- MacBook felvásárlás!! Macbook, Macbook Air, Macbook Pro

- Lenovo ThinkCentre M920q/ Dell OptiPlex 3070/ Hp EliteDesk 800 G4-G5 mini, micro PC-Számla/garancia

- Alienware 17r4 olvass

- Bomba ár! Lenovo ThinkPad L460 - Intel 3955U I 8GB I 128GB SSD I 14" FHD I Cam I W10 I Garancia!

- LG OLED & OLED evo Televíziók: BLACK NOVEMBER -30%

Állásajánlatok

Cég: ATW Internet Kft.

Város: Budapest

Cég: Laptopműhely Bt.

Város: Budapest

![;]](http://cdn.rios.hu/dl/s/v1.gif)