- Fával feldobott, kábelrejtő Lancool ház tűnt fel a Lian Li portfóliójában

- Futtasd helyben a Qwen3-at: ingyenes nagy nyelvi modellek az Alibaba konyhájából

- Színes, szemkímélő E Ink monitor jött a BOOX gondozásában

- Pokoli lövölde pörgetné meg a GeForce-ok eladását

- 8 GHz felett ketyeg a G.Skill legfrissebb, 128 GB-os memóriacsomagja

- Milyen processzort vegyek?

- Szünetmentes tápegységek (UPS)

- 3D nyomtatás

- Ez lenne a népkártya? Teszten a GeForce RTX 5060 Ti 16 GB

- Sony MILC fényképezőgépcsalád

- AMD vs. INTEL vs. NVIDIA

- AMD GPU-k jövője - amit tudni vélünk

- AMD Navi Radeon™ RX 9xxx sorozat

- Nem indul és mi a baja a gépemnek topik

- Nikon Z MILC fényképezőgépcsalád

-

PROHARDVER!

"A Proxmox Virtual Environment (röviden: Proxmox VE, PVE vagy proxmox) egy szerver virtualizációra optimalizált nyilt forráskódú Debian alapú Linux disztribúció. Lehetővé teszi a virtuális gépek és konténerek egyszerű telepítését és kezelését web konzol és command line felülettel. A programcsomag két LXC és OpenVZ konténerek, valamint a KVM alapú virtualizáció kezelését támogatja" (Wikipédia)

Hivatalos oldal: https://proxmox.com/en/

Hivatalos fórum: https://forum.proxmox.com/Véreshurka hozzászólásából

Új hozzászólás Aktív témák

-

-

KaqXar19

tag

[The Proxmox VE KVM-based All-in-One with FreeNAS] , kb a kozepenel (freenas install utan egybol)

Since we do not want to mess our storage configuration up by passing disks by their sdX reference, we are instead going to used /dev/disk/by-id as our identifier. This is a very small system to it is fairly easy to find our disks. You will want to issue “ls -l /dev/disk/by-id” on the Proxmox VE host -

KaqXar19

tag

válasz

inspiroyhome

#2745

üzenetére

inspiroyhome

#2745

üzenetére

kivalo otlet.

most epp nem volt 7TB szabad helyem, fontos cucc sem volt rajta, igy nem volt konnyes bucsu, azota meg leszedtem mindent is ujra

-

KaqXar19

tag

addig gugliztam es baxakodtam, mire 0Kb meretu lett a pool, igy ment a destroy

![;]](//cdn.rios.hu/dl/s/v1.gif)

ujra letrehoztam, most tolthetem le megint a zinternetet

koszi mindenkinek a segitseget.

-

KaqXar19

tag

válasz

KaqXar19

#2700

üzenetére

KaqXar19

#2700

üzenetére

Truenas UI-bol egy kis extra info, hatha valaki tudja mivel sirja tele az oldalt:

Error: concurrent.futures.process._RemoteTraceback:"""Traceback (most recent call last):File "/usr/local/lib/python3.9/concurrent/futures/process.py", line 246, in _process_workerr = call_item.fn(*call_item.args, **call_item.kwargs)File "/usr/local/lib/python3.9/site-packages/middlewared/worker.py", line 111, in main_workerres = MIDDLEWARE._run(*call_args)File "/usr/local/lib/python3.9/site-packages/middlewared/worker.py", line 45, in _runreturn self._call(name, serviceobj, methodobj, args, job=job)File "/usr/local/lib/python3.9/site-packages/middlewared/worker.py", line 39, in _callreturn methodobj(*params)File "/usr/local/lib/python3.9/site-packages/middlewared/worker.py", line 39, in _callreturn methodobj(*params)File "/usr/local/lib/python3.9/site-packages/middlewared/schema.py", line 985, in nfreturn f(*args, **kwargs)File "/usr/local/lib/python3.9/site-packages/middlewared/plugins/zfs.py", line 352, in import_poolself.logger.error(File "libzfs.pyx", line 402, in libzfs.ZFS.__exit__File "/usr/local/lib/python3.9/site-packages/middlewared/plugins/zfs.py", line 346, in import_poolzfs.import_pool(found, new_name or found.name, options, any_host=any_host)File "libzfs.pyx", line 1175, in libzfs.ZFS.import_poolFile "libzfs.pyx", line 1203, in libzfs.ZFS.__import_poollibzfs.ZFSException: I/O error"""The above exception was the direct cause of the following exception:Traceback (most recent call last):File "/usr/local/lib/python3.9/site-packages/middlewared/job.py", line 355, in runawait self.futureFile "/usr/local/lib/python3.9/site-packages/middlewared/job.py", line 391, in __run_bodyrv = await self.method(*([self] + args))File "/usr/local/lib/python3.9/site-packages/middlewared/schema.py", line 981, in nfreturn await f(*args, **kwargs)File "/usr/local/lib/python3.9/site-packages/middlewared/plugins/pool.py", line 1462, in import_poolawait self.middleware.call('zfs.pool.import_pool', pool['guid'], {File "/usr/local/lib/python3.9/site-packages/middlewared/main.py", line 1283, in callreturn await self._call(File "/usr/local/lib/python3.9/site-packages/middlewared/main.py", line 1248, in _callreturn await self._call_worker(name, *prepared_call.args)File "/usr/local/lib/python3.9/site-packages/middlewared/main.py", line 1254, in _call_workerreturn await self.run_in_proc(main_worker, name, args, job)File "/usr/local/lib/python3.9/site-packages/middlewared/main.py", line 1173, in run_in_procreturn await self.run_in_executor(self.__procpool, method, *args, **kwargs)File "/usr/local/lib/python3.9/site-packages/middlewared/main.py", line 1156, in run_in_executorreturn await loop.run_in_executor(pool, functools.partial(method, *args, **kwargs))libzfs.ZFSException: ('I/O error',)valamint ezzel floodolja a konzolt

Solaris: WARNING: can't open objset 9, error 5 -

KaqXar19

tag

válasz

KaqXar19

#2696

üzenetére

KaqXar19

#2696

üzenetére

visszaraktam a kartyat, de tovabbra is ott van a pool, de megsem.

root@truenas[~]# zpool import

pool: SSD-8TB

id: 13356854186233550219

state: ONLINE

action: The pool can be imported using its name or numeric identifier.

config:

SSD-8TB ONLINE

gptid/740d77c5-7cf4-11ee-84a2-589cfc10ff8f ONLINE

gptid/740c0fe5-7cf4-11ee-84a2-589cfc10ff8f ONLINE

root@truenas[~]# zpool import SSD-8TB

cannot import 'SSD-8TB': I/O error

Destroy and re-create the pool from

a backup source.

root@truenas[~]# zpool import -f SSD-8TB

cannot import 'SSD-8TB': I/O error

Destroy and re-create the pool from

a backup source.megcsereltem a sata kabeleket, hatha szamit a sorrend, de ugyanaz, I/O error

-

KaqXar19

tag

help.

proxmox alatt truenas core vm, 2 poollal.

aramszunet utan egyik pool (2db Kingston DC600M 3.84TB ssd) elszallt es nem sikerul visszahozni. olvasgattam neten, azt irjak biztos a HBA kartya (SilverStone SST-ECS06). Kiszettem, most anelkul van a 2 ssd bedugva.root@truenas[~]# zpool importpool: SSD-8TBid: 13356854186233550219state: ONLINEaction: The pool can be imported using its name or numeric identifier.config:SSD-8TB ONLINEgptid/740d77c5-7cf4-11ee-84a2-589cfc10ff8f ONLINEgptid/740c0fe5-7cf4-11ee-84a2-589cfc10ff8f ONLINEroot@truenas[~]#itt van, can be imported, oke

root@truenas[~]# zpool import SSD-8TBcannot import 'SSD-8TB': I/O errorDestroy and re-create the pool froma backup source.jo, akkor -f

root@truenas[~]# zpool import -f SSD-8TBcannot import 'SSD-8TB': I/O errorDestroy and re-create the pool froma backup source.es itt el is fogyott a tudomany.

dobtam fel gyorsan egy truenas scale vm-et, ott ugyanigy nem hajlando beimportalni.

termeszetesen nincs backup, es tuti van par cucc rajta, ami kellene.

a host egy Micron 7450 PRO 3.8TB-n van, es azert cumi, mert elvileg ez is, meg a 2 ssd a poolban is PLP-s, tehat aramszunet eseten nem kellene adatvesztesnek lennie.

ha valakinek van otlete hogyan lehetne visszavarazsolni a poolt, azt megkoszonnem.

-

KaqXar19

tag

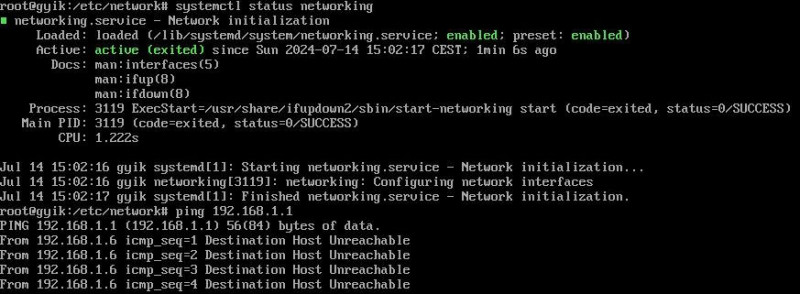

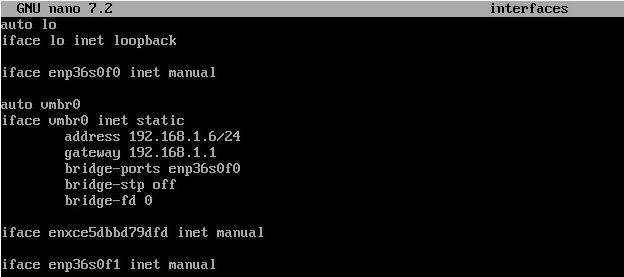

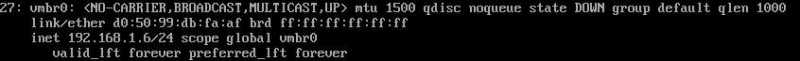

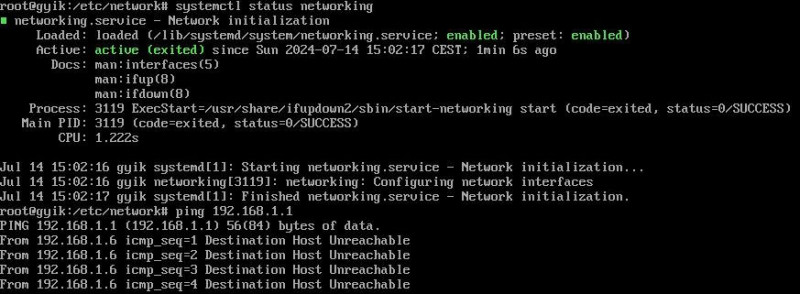

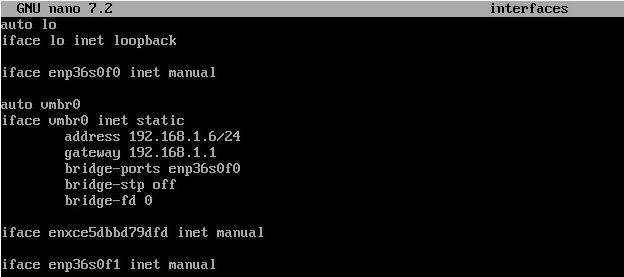

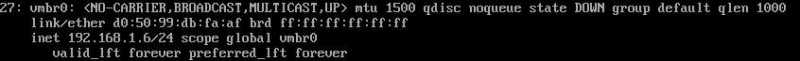

Neha kikapcsolas utan osszefossa magat a host, elszall a halo es csak reinstallal tudom helyrehozni.

Most is ez van, azonban van egy vm, ami nincs lementve es jo lenne megmenteni.Van valami otletetek? A hostot elerem bmc-vel.

ip a, sajnos az eleje nem latszik, csak a vegen, hogy vmbr0 down

-

KaqXar19

tag

válasz

SwissAirplan

#2532

üzenetére

SwissAirplan

#2532

üzenetére

hardwerként adjam hozzá a RAID kártyát

igen, add at a pci-t a truenas vm-nek, onnantol latja a radugott hddket. -

KaqXar19

tag

Asustor nasra dugtam realtek chipes Club3D USB 3.2 Gen1 Type A - RJ45 2.5Gbps Ethernet-et, ment/megy csont nelkul.

-

KaqXar19

tag

válasz

tasiadam

#2380

üzenetére

tasiadam

#2380

üzenetére

ezt nem is lattam, koszi.

kellett neki --calibrate, de utana

Cannot load from file /var/cache/powertop/saved_parameters.powertop

File will be loaded after taking minimum number of measurement(s) with battery only

Leaving PowerTOPallitolag ez majd idovel eltunik es megcsinalja, szoval varok tegnap este ota

-

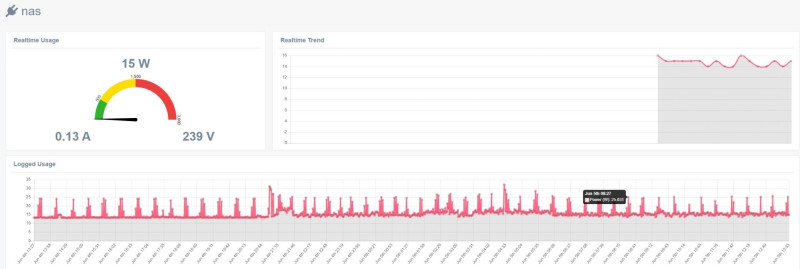

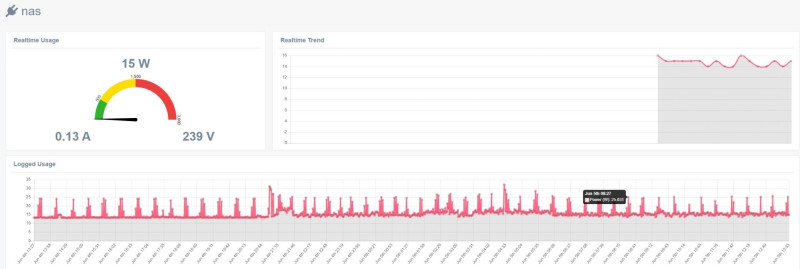

KaqXar19

tag

Asrock DC N100-as (6W tdp) itx lap, Proxmox, alatta Truenas core 2 sata ssdvel, es 2 lxc a rendszer nvme ssd-n (Kingston DC1000B M.2 NVMe 480GB SSD- Enterprise boot drive - onboard power loss protection (PLP)).

Alapbol 14-15W idle, de a tuskek felugranak 24-25W-ra.

Mi a gorcs rangatja mindig felorankent? -

KaqXar19

tag

root@gyik:/boot# ls

config-6.2.16-12-pve initrd.img-6.2.16-12-pve memtest86+x64.bin System.map-6.8.4-3-pve

config-6.2.16-15-pve initrd.img-6.2.16-15-pve memtest86+x64.efi vmlinuz-6.2.16-12-pve

config-6.2.16-18-pve initrd.img-6.2.16-18-pve pve vmlinuz-6.2.16-15-pve

config-6.2.16-19-pve initrd.img-6.2.16-19-pve System.map-6.2.16-12-pve vmlinuz-6.2.16-18-pve

config-6.2.16-20-pve initrd.img-6.2.16-20-pve System.map-6.2.16-15-pve vmlinuz-6.2.16-19-pve

config-6.5.11-4-pve initrd.img-6.5.11-4-pve System.map-6.2.16-18-pve vmlinuz-6.2.16-20-pve

config-6.5.11-6-pve initrd.img-6.5.11-6-pve System.map-6.2.16-19-pve vmlinuz-6.5.11-4-pve

config-6.5.11-7-pve initrd.img-6.5.11-7-pve System.map-6.2.16-20-pve vmlinuz-6.5.11-6-pve

config-6.5.11-8-pve initrd.img-6.5.11-8-pve System.map-6.5.11-4-pve vmlinuz-6.5.11-7-pve

config-6.5.13-1-pve initrd.img-6.5.13-1-pve System.map-6.5.11-6-pve vmlinuz-6.5.11-8-pve

config-6.5.13-5-pve initrd.img-6.5.13-5-pve System.map-6.5.11-7-pve vmlinuz-6.5.13-1-pve

config-6.8.4-2-pve initrd.img-6.8.4-2-pve System.map-6.5.11-8-pve vmlinuz-6.5.13-5-pve

config-6.8.4-3-pve initrd.img-6.8.4-3-pve System.map-6.5.13-1-pve vmlinuz-6.8.4-2-pve

efi memtest86+ia32.bin System.map-6.5.13-5-pve vmlinuz-6.8.4-3-pve

grub memtest86+ia32.efi System.map-6.8.4-2-pveroot@gyik:/boot/efi# ls

root@gyik:/boot/efi#

Új hozzászólás Aktív témák

- iKing.Hu- Apple Macbook 13 M1 Pro Touchbar - 2020 - Használt, karcmentes, 22 töltés

- LG 45GR95QE - 45" Ívelt OLED / 2K WQHD / 240Hz 0.03ms / NVIDIA G-Sync / FreeSync Premium / HDMI 2.1

- AKCIÓ! Microsoft XBOX Series S 512GB játékkonzol garanciával hibátlan működéssel

- iKing.Hu - Apple Watch Ultra 2 Titanium Szíjjal 49 mm Használt, újszerű

- ÁRGARANCIA!Épített KomPhone i5 13400F 16/32/64GB RAM RTX 5070 12GB GAMER PC termékbeszámítással

Állásajánlatok

Cég: PCMENTOR SZERVIZ KFT.

Város: Budapest

![;]](http://cdn.rios.hu/dl/s/v1.gif)