- Melyik tápegységet vegyem?

- ASUS ROG Ally

- NVIDIA GeForce RTX 5080 / 5090 (GB203 / 202)

- Bluetooth hangszórók

- Milyen CPU léghűtést vegyek?

- Milyen billentyűzetet vegyek?

- Amlogic S905, S912 processzoros készülékek

- AMD Navi Radeon™ RX 9xxx sorozat

- AMD Ryzen 9 / 7 / 5 9***(X) "Zen 5" (AM5)

- A héten érkezik az Xbox alkalmazás az LG okostévékre

Új hozzászólás Aktív témák

-

A válasz direkt volt, mert az adott illető kérdőjelezte meg a kevés videókártyát, és random fórumhozzászólásnak nevezte az erről szóló előzetes híreket. Most már vannak konkrétumok is, amik az előzetes híreket erősítik, és nem az ő kötözködő véleményét. Ezért reagáltam direkt neki, és direkt azt, amit. Sőt, most már újabb hírek is vannak hasonlóan villámgyorsan eltűnő készletekről, de már ezt nem akarom feldobni az illetőnek. Szerintem azoknak sem hinne...

-

pengwin

addikt

-

Reggie0

félisten

válasz

Héraklész

#133

üzenetére

Héraklész

#133

üzenetére

Pont hogy a logika erositi meg, hogy eladhattak volna. Az ertelme az, hogy a piacnak semmi sem eleg es mindenert hajlando meg tobbet fizetni. A GPU-kat ugy felszippantja a piac, mintha nem lenne holnap. Raadasul a gyorsabb fejlodes a konkurencianal tovabb erositi a piaci poziciot, tehat celszeru. Harmadreszt az AI lufi is csak azt erositi meg, hogy most kell eladni, mert ki tudja mi lesz holnap amikor kipukkanhat.

Ebbol is latszik, hogy nem egy szimpla skalazasrol van szo, hanem muszaki problemakat kell folyamatosan megoldani, azaz fejleszteni, kulonben mar reg boltban lett volna. Mindossze az az illuzio, hogy a gamereknek fejlesztik es a gaming teljesitmenyben akarnak nagyot guritani. Valojaban az AI-s kepessegekre gyurnak, a gaming pedig egy mellektermek, amivel ossze lehet kapargatni az apropenzt is.

-

Héraklész

tag

A 20 evre elore tervezes nagyjabol olyan mese, mint a mikulas.

Persze, mert te azt mondod. :-D A logika cáfolja meg az utolsó mondatod. Ha a 4090-nel letarolják a piacot, kenterbeverik a konkurenst, nulla értelme van még fölé lőni. A szokásos generációváltáskor kényelmesen előszedik a minimális fejlesztést és kiadják újabb hatalmas pénzt bezsebelve, miközben fejleszthetik már régen a következő lépcsőt. -

Reggie0

félisten

-

pengwin

addikt

1. Csak ez számít. Minden más csak artifactos "humbug" - jó, hogy van, de nagyon rossz irány, hogy lassan megkerülhetetlen lesz alapból a felskálázás. Ennek egy segédtechnológiának kéne lennie, amikor 2-3 év múlva már kezd nagyon izzadni egy kártya az újabb játékok alatt.

2. RT nincs minden játékban, upscaling nincs minden játékban, és mindkettőnek megvannak a maga hátulütői. Szerintem mindkét technológia a cégeknek jó, nem nekünk felhasználóknak - RT mindenből tükröt csinál és nem igazán elérhető a játékosok nagy részének a hardverigény és az MSRP-k miatt, DLSS/FSR meg kis költői túlzással majdnem olyan rossz mint egy motion blur.

3. UV-val az előző 2 NV generáció is a gyárinál sokkal jobb teljesítmény-fogyasztás mutatót hoz, minimális teljesítményvesztés mellett. Csak a gyári beállításokat érdemes összehasonlítani, az UV/OC már nagyon nem azonos körülményeket jelent, még generáción belüli összehasonlításnál is. Pl. van egy RTX 3080-am, arról is lazán le lehetett csípni olyan 60-80W-ot kb. 5% teljesítményért cserébe - rögtön sokkal jobb a perf/W. -

DarkByte

addikt

válasz

Szatyor123

#121

üzenetére

Szatyor123

#121

üzenetére

Sajnos nem, a legközelebbi Németország talán, ismerősön keresztül.

-

aginor

veterán

Igen, van egy olyan réteg is, de látszatra jóval kisebb és kevésbé határozott mint az első.

Engem sosem zavart, ha mondjuk egy 500Hz-es monitor megjelenik. Elfér a piacon, akinek meg nem tetszik, majd jól nem veszi meg.

Kétségtelen tény, hogy az a jobbik felállás, ha a technika jobb mint te, mert akkor te nyugodtan kifuthatod magad. Ellenben károsnak tartom, ha a technikának túl nagy jelentőséget tulajdonítunk, pláne, ha megtesszük bűnbaknak a saját bénaságunkért. -

BiP

nagyúr

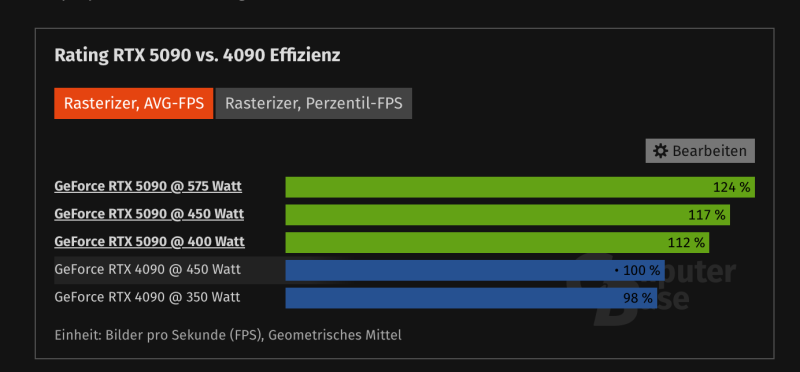

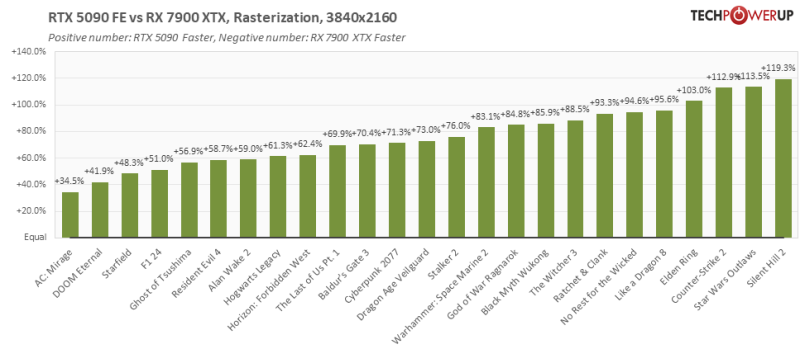

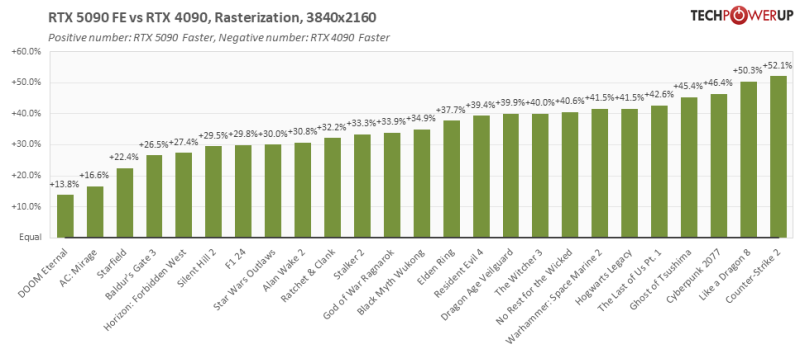

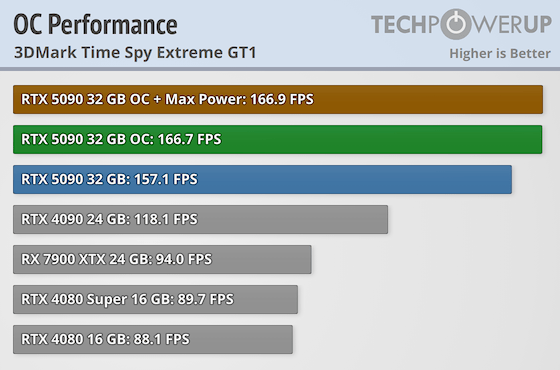

1. Ez csak a raszter teljesítmény ugrás, ami szerintem jó.

2. Minden másban nagyobb ugrás van.

3. Korábban írták, hogy azonos fogyasztás mellett 17%, tehát jóval hatékonyabb.

A gobd akkor van, ha eleresztjük a fogyasztást, mert a maradék +17%-ot nagyon rossz hatékonysággal tudja hozni. -

hapakj

őstag

Tudom-tudom, itt a PH-n mindenki profi CS játékos, emiatt szüksége van minimum 300fps-re

- a másik véglet meg amikor megjelenik egy hír egy 500Hz-es monitorról, akkor jön ez meg minek, teljesen felesleges, az ember úgy sem lát 60Hz-nél többet. Sőt igazából FullHD-n 30Fps az igazi

-

aginor

veterán

válasz

Héraklész

#108

üzenetére

Héraklész

#108

üzenetére

Óriási lagod nem lesz tőle. Nagyjából így néz ki a dolog: a lag megmarad a kiindulási nyers fps környékén, miközben maga az fps megugrik, amivel folyamatosabb játékérzetet kapsz (ahogy gbors is írta).

A fentiek miatt kompetitív versenyjátéknál nem olyan nagy az előnye, de egyjátékos címeknél, vagy bárminél, ami nem reakció alapú elég szépen muzsikál és jól is használható.

Tudom-tudom, itt a PH-n mindenki profi CS játékos, emiatt szüksége van minimum 300fps-re, 0 laggal és egy OLED monitor 0.003ms-es késleltetésére, természetesen 2000Hz-es egér mellett, mert különben nem tud teljesíteni, és emiatt kerül az eredménytábla végére..

-

hapakj

őstag

válasz

DarkByte

#119

üzenetére

DarkByte

#119

üzenetére

"ami képes köztes motion vector infókat adni hogy mi történt két fizikailag render-elt frame között,"

- arra gondolsz hogy egy teljes raszter után, 3 framig csak motion vektorokat ad az engine a DLSS-nek? Nem rossz elképzelés. Nem lennék meglepve ha DLSS4 ne támogatná ezt vagy ne kerülne bele később. -

DarkByte

addikt

Igazából nem is értem a DLSS FG miért nem eleve így lett megálmodva, valami API illesztés a játék motor felé, ami képes köztes motion vector infókat adni hogy mi történt két fizikailag render-elt frame között, hiszen a játék motor futhat nagyobb sampling rate-el, az nem olyan költséges mint maga a render (bár, CPU bottleneck biztos ilyenkor is van) és akkor már az MPEG motion vektorok szintjén vagyunk.

(egyébként érdekes módon a Reflex pont ezt csinálja, a jelen frame render végére ha a játék motor azt mondja a user közben mozdított az egéren, akkor utólagosan warp-olja azt a frame-et mintha időben később készült volna, és generatív AI-val kitölti a légüres részt a szélen; ez amúgy megint nem új cucc, a VR headset-ek a jitter redukálására régóta kihasználják hogy az optika miatt van egy "halott" terület a kijelző szélén amit sose látsz és lehet valamennyit pan-elni a képet a giroszkóp alapján büntetlenül, folyamatosabb mozgás érzetét keltve; ez ugyanaz, csak itt ki kell tölteni a kieső részt)

Innen meg már csak még egy lépés lenne hogy MPEG P/B frame szerűen a kártya pár teljes frame (I) kívül csak részleges képeket render-eljen, ahol tényleg történt valami változás, és a tech összeférceli a frame-eket.

De amúgy elhallgatva az interjút amit a DF csinált a napokban, szerintem pont erre tartunk. Egyre jobban redukálni a brute force raszterizációt, mert nem fogjuk bírni, főleg ha az RT-t sokkal jobban komolyabban vesszük.

Plusz az egyéb szintetikus dolgok, mint a neural metarials is errefelé mutatnak hogy egyre több asset lesz futásidőben előállítva és csak parametrizálást szállítják a játékkal.

Alapvetően szerintem tök jó hogy innoválnak, csak mint minden tranzíciós időszak nehéz, meg akit nem érdekel a tech az nyilván csak az árnyékos oldalát látja.

-

hapakj

őstag

Olyan szempontból értettem dedikált hw-nek hogy a raszterizációs feladatokba nem tud besegíteni.

Egyelőre mondjuk, mert ugye érkezik a "Neural Rendering". Mondjuk nem tudom mennyire lesz elterjedt, ha csak nVidia fogja tudni. Egyébként a Neural Texture Compression elég ígéretesnek tűnik.

-

Nem is azt írtam, hogy ugyanaz a kettő. Nagyon sok a hasonlóság, ezért ha az egyiket hókuszpókusznak nevezzük, akkor a másik is az. Alapvetően az a fő gondom, hogy egy informatikai fórumon vagyunk, ehhez képest úgy kezelik egyesek az innovációt, mintha egy középkori mocsármenti faluban éldegélnének. és az újdonságok képében az ördög kopogna rájuk. Nyilván vannak a framegennek problémái, vannak kompromisszumok, ha használja az ember, de ez az "eleve szar, mer' szar" hozzáállás nem éppen érett gondolkodásra utal...

A többien meg egyetértünk.

#116 hapakj: nem dedikált hardver dolgozik a DLSS-feature-ökön, a tensor core-ok is általános célú egységek, de valóban nem volt szerencsés szoftveresnek nevezni az upscalinget és a framegent. Legyen alternatív képgenerálás, úgy talán egyértelmű.

Anno a Turingnál szórakoztam a die shotokkal, és arra jutottam, hogy az RT és a tensor core-ok kb. 30%-át viszik el a chipnek. Viszont olvastam olyan verziót is, hogy csak 10%, ott megnézték a tensor-RT arányt is, kb. a 2/3-a volt a tensor. Szóval mondjuk 5-20% között lehetne növelni a végrehajtók számát a tensorok nélkül - nem 0, nem is világmegváltó.

-

hapakj

őstag

Mondjuk se az FG-t se az upscalinget nem tekinteném szoftveres extráknak, mert ezek konkrétan dedikált hw egységeket használnak az nvidia GPU-kban.

Igazából az lenne a kérdés, hogy mit tudna a HW ha az erre költött tranzisztorszámot raszterre meg Raytrace-re költenék.Bár pl a Ray Reconstruction is eléggé alapoz ezekre a hw egységekre és nagyon megdobja a Raytrace teljesítőképességét

-

BiP

nagyúr

MPEG más tészta. Ott rekonstruálsz valamit, amit előtte modelleztél az eredeti forrásból.

Itt meg megpróbálja kitalálni a köztes állapotot, ami vagy sikerül vagy nem. Bizonyos körülmények között (pl.magas fps, kevés generált frame, lassú mozgás, stb) jobban, ellenkező esetben kevésbé jól, esetleg már zavaró hatást elérve."Szerintem a FG esetében elsősorban az eredményt kellene nézni - ha jó a játékélmény, akkor miért fáj annyira, hogy nem minden egyes frame-et számol ki nulláról a GPU?"

Egyetértek. Ez is egy lehetőség (mint a DLSS skálázás), aztán mindenki el tudja dönteni az ingerküszöbe alapján, hogy ez neki még belefér-e vagy már nem."hogy a tesztekben el kell különíteni ezeket az eseteket, és akkor lesz egy kép arról, hogy mit tud a HW nyers erőben, és mit tud a szoftveres extrákkal. Ez jelen pillanatban meg is van".

Helyes. -

Csupingo

veterán

válasz

Sidorovich

#111

üzenetére

Sidorovich

#111

üzenetére

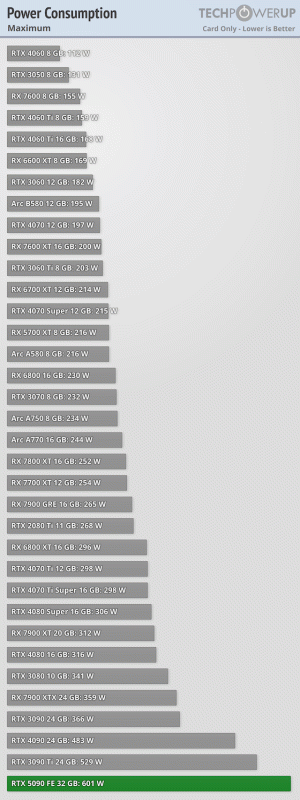

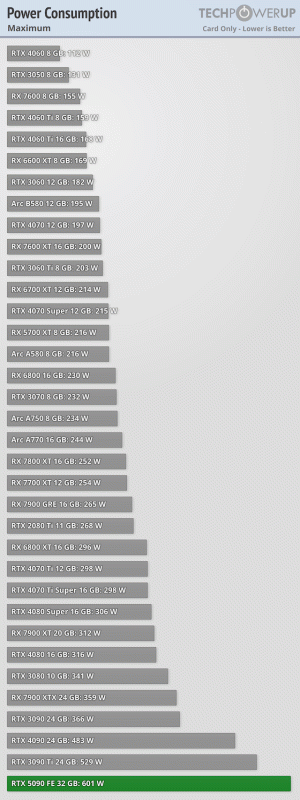

Lehet, már a vga gyártásnál is kezdik elérni a falat. Már nem tudnak olyan mértékben fejleszteni, meg legtöbbször nem is akarnak. Ezek a fogyasztások is már kezdenek izzadságszagúak lenni, de ez mindig is jellemző volt a csúcskártyákra. Ilyen teljesítményt jelenleg nem lehet 100W környékén produkálni.

-

hapakj

őstag

Jah, csak itt az emberek 200% gyorsulást várnak el minden generációnál minden téren

S tényleg annak ellenére, hogy manapság az nVidia fő profilja az AI képesek 3D grafikában is eredményeket / fejlesztéseket elérni

S tényleg annak ellenére, hogy manapság az nVidia fő profilja az AI képesek 3D grafikában is eredményeket / fejlesztéseket elérni  Míg a többi gyártó ami VGA-val elvileg csak a 3D grafikai piacot akarja lefedni eredmények helyett inkább átpozicionálja a termékeit középkategóriába, s előadják hogy mindig is így tervezték

Míg a többi gyártó ami VGA-val elvileg csak a 3D grafikai piacot akarja lefedni eredmények helyett inkább átpozicionálja a termékeit középkategóriába, s előadják hogy mindig is így tervezték

-

Sidorovich

senior tag

"Most akkor javult vagy nem?"

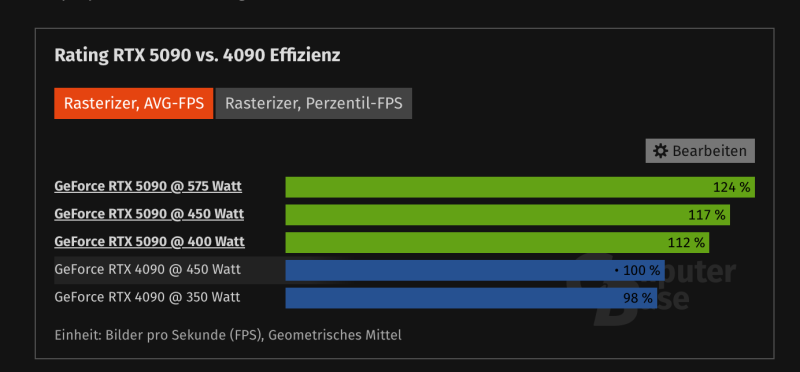

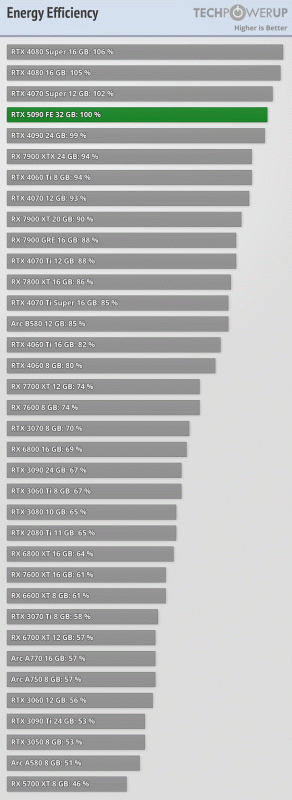

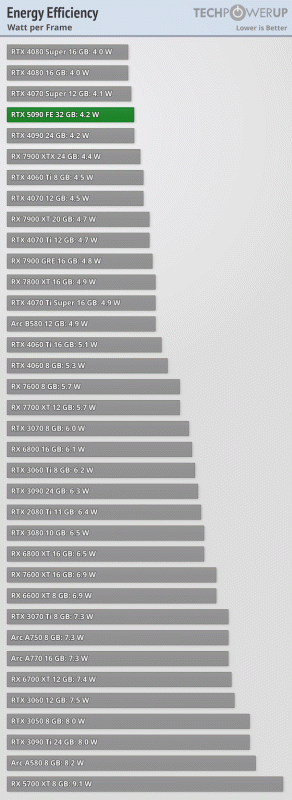

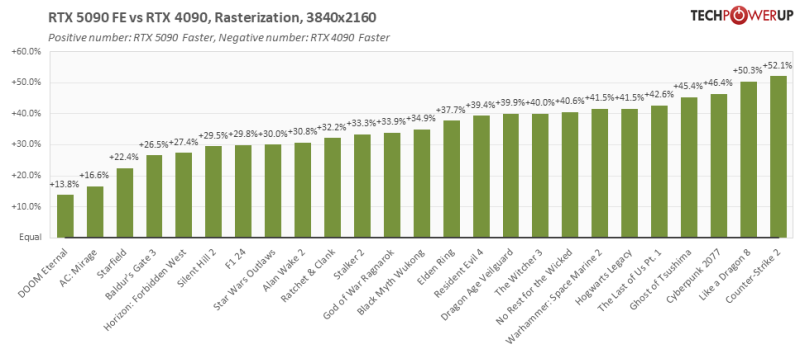

A tesztek szerint javult. A hatékonyság és az elérhető max teljesítmény is javult. Csak a kettő egyszerre nem jön ki belőle. Gyári TDP-n ugyanolyan hatékony, mint a 4090: pont annyival erősebb, mint amennyivel jobban fogyaszt és fűt. Panaszkodnak is a tesztekben az FE hűtés hangjára pl.

Ha viszont visszaveszed a gyári 575W TDP-ről 450-re mondjuk, akkor a tesztek szerint jobban kijön a hatékonyság. Csak minimálisan romlik a teljesítmény, miközben sokat csökken a fogyasztás. Így a 4090-nél érdemben hatékonyabb tud lenni azonos (450W) TDP szinten is: 17%-al erősebb az 5090. -

válasz

Héraklész

#108

üzenetére

Héraklész

#108

üzenetére

Világos. Tehát szar, de ha valaki megmagyarázza, hogy miért nem szar, akkor neked tökmindegy, de akkor is szar, mert "írták"

Mégis mi a kórságtól lenne "óriási" lagod? A CB tesztben pl. a Cyberpunk esetében:

Mégis mi a kórságtól lenne "óriási" lagod? A CB tesztben pl. a Cyberpunk esetében:

4K natív: 29.1 FPS, 65ms lag

4K DLSS: 56.7 FPS, 40ms lag

4K MFGx1: 103.5 FPS, 46ms lag

4K MFGx3: 190.9 FPS, 51ms lagEzek közül melyik lag az óriási? (súgok: egyik sem. még a 65ms sem.)

-

BiP

nagyúr

válasz

Sidorovich

#105

üzenetére

Sidorovich

#105

üzenetére

lényeg ezen is ugyanaz, hatékonyságban az 5090 nem lépett előre semmit,

+ ha a 4090 TDP értékére (450W) korlátozzák az 5090-et, akkor van 17% előnye.

Most akkor javult vagy nem?Ahogy Ti is írtátok közben, azért mégis hatékonyabb lett, még ha nem is fejlesztettek a gyártástechnológián. Ez is egyfajta fejlesztés.

És sajnos szerintem is inkább az AI-ra , DLSS-re gyúrtak inkább, mint a hagyományos raszteren meg az rtx-en.

Most az AI a buzzword, ezt "kell" nyomatni. Marketingebn is meg fejlesztésben is. -

Sidorovich

senior tag

Szerintem sem. Gyártástechnológiai előrelépés nélkül, pusztán az architektúra változtatásaival szerintem teljesen korrekt.

Igazából csak az zavar, hogy a nagy NVIDIA előadáson mutatott ábrák köszönőviszonyban sincsenek ezzel a lényeggel. Megy a bullshit a részvényeseknek. Meg a sima teszteknél is ha valaki csak az FPS ábrákat nézi, abból se derül ki, hogy az extra FPS nagy része az extra fogyasztásból jön. -

hapakj

őstag

válasz

Sidorovich

#105

üzenetére

Sidorovich

#105

üzenetére

Azért őszintén szólva a 17% sebesség előny sem rossz ugyanolyan fogyasztás mellett. Bár ez is leginkább annak tudható be, hogy nagyobb a chip és több végrehajtó egység van benne.

Nekem úgy tűnik, hogy Raster / CUDA oldalról ez még az Ampere architektúra. Valszeg utóbbi időben AI / RT-re koncentráltak. Jókérdés előbbi oldalról mekkorát lehet még javítani.

-

Sidorovich

senior tag

válasz

hokuszla

#100

üzenetére

hokuszla

#100

üzenetére

Lehet velem van a gond, de nem értem, hogy a szöveg nélküli emoji halmaz mit szeretne közölni.

Pont ezt az ábrát pár hozzászólással korábban már bevágtam ide. A lényeg ezen is ugyanaz, hatékonyságban az 5090 nem lépett előre semmit, legalábbis a gyári TDP értékek mellett. Ugyanazt a gyártástechnológiát használják, tranzisztorsűrűség is kb. ugyanaz, csak nagyobb és többet fogyasztó lett a GPU.

A német teszt kimutatta, hogy ha a 4090 TDP értékére (450W) korlátozzák az 5090-et, akkor van 17% előnye. Ez már valami kézzelfogható, de gondolom ez az előrelépés nem lett volna olyan látványos az ábrákon a CEO mögött, így el kellett engedni majdnem 600W-ig, meg bedobni még több generált framet.

Azt külön nem is értem, hogy jutottunk el alig 2 generáció alatt a <300W TDP (Titan RTX) csúcskártyáktól a közel 600W-ig. Ez lenne a fejlődés?

-

válasz

Héraklész

#102

üzenetére

Héraklész

#102

üzenetére

De miért lenne hókuszpókusz? Vagy az MPEG is hókuszpókusz, ahol egy rakás (jóval több, mint 1 vagy 3) képkockát az előző képből és mozgásvektorokból rekonstruálsz? Vagy mondjuk azt, hogy a filmkiadók nem elég tökösek, és miért nem 1TB egy 2 órás 4K film?

Szerintem a FG esetében elsősorban az eredményt kellene nézni - ha jó a játékélmény, akkor miért fáj annyira, hogy nem minden egyes frame-et számol ki nulláról a GPU?A másik oldala a dolognak nyilván az, hogy a tesztekben el kell különíteni ezeket az eseteket, és akkor lesz egy kép arról, hogy mit tud a HW nyers erőben, és mit tud a szoftveres extrákkal. Ez jelen pillanatban meg is van.

-

hokuszla

senior tag

válasz

Sidorovich

#97

üzenetére

Sidorovich

#97

üzenetére

-

DarkByte

addikt

Gondolom ha mondjuk egy 5090 FE-t szeretnék, akkor úgy 2026 tavasza előtt ne is számítsak rá hogy sorra kerülök az Nvidia webshop queue-jában.

-

-

hokuszla

senior tag

válasz

Sidorovich

#92

üzenetére

Sidorovich

#92

üzenetére

ez a max power aminek semmi értelme

-

Sidorovich

senior tag

Nekem igazából még a DLSS is elmegy, ha csak a felskálázást nézzük, mert elég jó végeredményt hoz "Quality" szinten, ahol 4K-ra mondjuk 1440p-ről skáláz fel ha jól tudom. Szoktam is élni vele, mert "szinte ingyen" extra FPS, élsimítást is megoldja.

De a komplett frame generálást már nekem se veszi be a gyomrom.

-

Sidorovich

senior tag

Az előző generációhoz képesti extra teljesítmény jelentős része extra fogyasztásból és hőtermelésből jön. Ez tény, nem csavarás. Konkrétan játékok alatt 24%-al fogyaszt többet a 5090, mint a 4090:

-

ilor14

tag

Jelenleg a 4070-ek mennek legolcsóbban 240 ezer Ft körül, átlagban 270 ezer Ft körül (az alapabb, 2 ventis változatok), ezért hasraütésszerűen mondtam, hogy nagyjából 250 ezer Ft körül lesz.

1 éve nagyjából 360 Ft-os dollár árfolyamnál csökkentették a 4070-ek árát 600 dollárról 550-re, ezután jelentek meg (minimum árban) 230-240 ezres sávban a kártyák, ami nagyából (240 ezres kártyával számolva) 660 dollár, mai 390 Ft-os dollárral az kb 260 ezer forintot jelent és ez a minimumár.

Átlagban inkább 270 ezerért mentek ezek a kártyák, amik akkori árfolyammal 750 dollárnak felelnek meg, jelenlegiben ez 290 ezer lenne.

Szóval azt mondom a legolcsóbb helyeken lesznek majd 250 ezerért is, de csak hónapok múlva és inkább a 300 ezres sávban lesznek, ahogy ti is mondtátok.

mea culpa -

hokuszla

senior tag

lehet csűrni-csavarni, de lemérték a valódi teljesítményt is

-

BiP

nagyúr

Te miről beszélsz?

Szerintem itt a 2000 dolláros 5090-re gondolt, mint 1milliós kiadás. (az 5090 teljesítménye a 4090 duplája témára)550 dollár lesz az 5070, ami nagyjából 250 ezer Ft körül lesz nálunk, eddig is az 5070-ről volt szó.

550dollár az 220e Ft. Ez itthon szerintem inkább lesz 300-hoz közelebb, mint a 250-hez. (itt most nem scalper árra gondolok, hanem valósra) De ne legyen igazam. -

ilor14

tag

Te miről beszélsz? 550 dollár lesz az 5070, ami nagyjából 250 ezer Ft körül lesz nálunk, eddig is az 5070-ről volt szó.

A másik meg, hogy egészen addig faszák lesznek ezek a GPU-k, míg nem a nyers erő kell és támogatva van a frame gen (75 játék támogatja majd release-kor az új frame gent) és a DLSS4 is.

Az RTX 5070 például nyers erőben (valószínűleg) gyengébb lesz, mint a 4070 Super, ami megint csak kész vicc. Extra poén, hogy a frame gen egyébként több memóriát használ, mint a natív felbontás, szóval a 12GB sokkal gyorsabban el fog fogyni, mint ahogy azt sokan gondolják (tippre a multi frame gen még ennél is több memóriát használ).

-

raaay

csendes tag

Engem nem érint, mert amúgy sem vennék ilyen kártyát.

Amikor vásárolok tudatosan döntök nem így szerencsére...

Csak nagyon kellemetlen, hogy ilyen marketinggel próbálják megvezetni az embereket. Attól még undorodom és védhetetlennek tartom, hogy ebben a formában mögötte megjelenhet egy nyilvánvalóan hazug állítás. -

BiP

nagyúr

Ez olyan, mint az autóknál a fogyasztás. Laborban elő lehet állítani olyan körülményeket, ahol (természetesen a reklámozott terméknek lejtős pályán) teljesül a fenti marketingállítás.

Nagyot akartak mondani, Te meg (most már) tudod, hogy milyen feltételekkel lehet csak igaz, ezek alapján lehet dönteni.

Aki meg nem tudja, mit vesz, az hidd el, úgyis pont bekapcsolja (főleg ha a DLSS default), és lehet, hogy észre se fogja venni a trükköt, neki pont jól jön.

Aki meg vizslatja a képkockákat, az meg úgyis tudja, hogy enélkül mennyi a valós teljesítmény.Igen, csúsztatnak, mint minden keynote-on, termékbemutatón, unboxingon, kiállításon, stb. Sajnos ez ilyen. Annyit tehetsz, hogy képbe kerülsz a valós teljesítményt illetően, és aszerint/az igényeid szerint döntesz.

-

hapakj

őstag

vagy 2 év múlva, mikor kezd elfogyni a GPU

- mitől fogyna el a GPU? Max ha túl alacsony lenne a natív képkockák száma a DLSS-hez, de az feltételezné, hogy egy jövőbeni új generációs GPU-ra fejlesztettek a fejlesztők, ami radikálisan gyorsabb. Nem valószínű, hogy ilyen lenne. -

Héraklész

tag

Bezzeg amikor ezt leírtam a PH-n, hogy valószínűleg ez lesz, akkor azt kitörölték, mert fikció...

-

ilor14

tag

Mindenhol ez megy, de szerinted ez laikusoknak mennyit mond? Átlag felhasználónak fingja nincs erről, ő csak annyit lát, hogy jobban kellene mennie a játéknak, mert hát ezt látja, utána meg azt fogja látni, hogy nem is megy jobban, nem is olyan szép a játék, mert tele van artifactokkal, szóval szerintem ez simán megtévesztés.

-

BiP

nagyúr

Hm. Valóban mond ilyet, hogy 5090 twice the performance of the 4090.

Mondjuk az 5070 = 4090-nél elmondja, hogy lehetetlen lenne AI nélkül. (naná, hiszen a képkockák egy jelentős része tensor core által generált, nem valódi raytrace/raszter számítás)És hogy mennyire hihető, amit mond: azt is elmondta, hogy Januártól large scale gyártják és elérhető. Miről is szól ez a mostani hír? Hát, hogy ez mégse valósult meg

#60 flexxx2 : A linkelt résznél maga Jensen mondja, hogy AI és tensor core-ok nélkül ez nem lenne lehetséges.

Úgyhogy nem állította ő sem, hogy nyers erőben ugrottak volna ennyit.

Nem védeni akarom, csak hogy ha annyira hihetetlen dolgot mond, akkor bátran ne higgyük el neki. Kezeljük a helyén a dolgot. Mondott egy jó nagy marketingbullshitet, nagyon jól tudjuk, hogy a valóság, a realitás nem ennyire látványos. -

Duck663

őstag

Ha a 4090 natív 4K-n megy, a 5070 DLSS performance módjában 1080p-ről felskáláz, és ezt megfejeljük a 4* képgenerálással, úgy hogy a 4090 4K natív képgenerálás nélkül, ezek alapján még ez is lehetséges. Az 5070 azért jelentősen később fog CPU limitbe futni.

Igen, el akarják adni a terméküket a különféle vállalatok, de azért nem mindegy, hogy hogyan. Bár az látható, hogy az nvidiának minden el van nézve.

Én most ezen pislogtam egyet. [link]

-

hapakj

őstag

válasz

Sidorovich

#53

üzenetére

Sidorovich

#53

üzenetére

Szerintem jól látod. Ez már nekem a technikai adatokból is így tűnt.

-

Sanya

nagyúr

Ki gondolta volna?

A 600 dolláros snapdragon laptopok is 1300 euro körül mennek.

-

Sidorovich

senior tag

Egyébként jól látom a külföldi tesztek alapján, hogy lényegében a hatékonyság alig nőtt, ha nőtt egyáltalán?

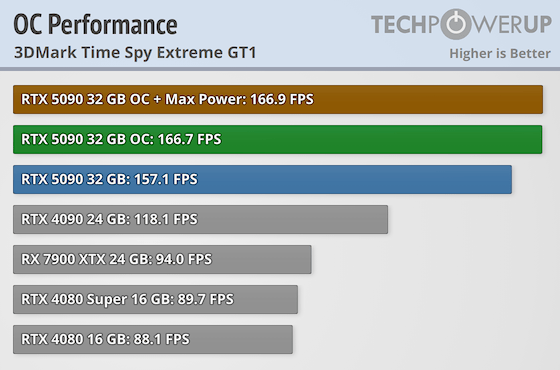

Egy német teszt megnézte úgy, hogy 450W-ra volt limitálva mind az 5090 és a 4090 is. Ilyen körülmények között alig 17%-al volt erősebb a 4090:

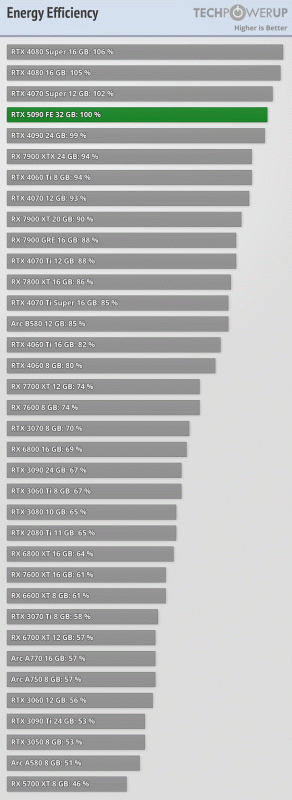

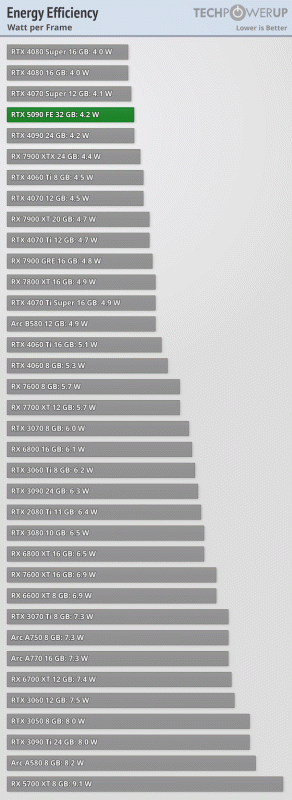

TPU teszt szerint power limit nélkül pedig szintén pont annyival volt erősebb 4K-ban az 5090, mint amennyivel nagyobb a fogyasztása. Ha az energiahatékonyságot nézzük:

-

ilor14

tag

5070-re leszek kíváncsi, nagyjából 17%-kal kevesebb Cuda core van benne, mint az RTX 4070 Superben, szóval nyers előben valószínűleg gyengébb lesz, mint a korábbi széria, cserébe generált képekben valószínűleg viszont megelőzi

-

hapakj

őstag

4*-es képgenerálással az 5070 kétszeres teljesítményt tud felmutatni a 4090-hez képest.

- ez biztos igaz? Szerintem csontra húzott képgenerálással veszi fel csak az 5070 a 4090-el a versenyt, szóval abból 2x több frame szerintem soha nem jön ki

Szerintem csontra húzott képgenerálással veszi fel csak az 5070 a 4090-el a versenyt, szóval abból 2x több frame szerintem soha nem jön ki

S ez továbbra is show, marketing, nem pedig nyers technikai bemutató. Az új generáció legjobb képességeit hasonlítják az előzőhöz, s ha úgy összemérve 2x jobb akkor 2x jobb. Szerintem ne ott keres fair összehasonlítás, ahol a cégnek a tulajdonosa el akarja adni a legújabb terméküket. Azt majd össze lehet ollózni a tecnikai adatokból, meg a megjelenés utáni benchmarkokból.

-

Duck663

őstag

Számomra egyáltalán nem egyértelmű. Ennyi erővel azt is mondhatta volna, hogy 4*-es képgenerálással az 5070 kétszeres teljesítményt tud felmutatni a 4090-hez képest. És még akár ez lehetséges is DLSS performance mellett az 5070-en, ha a 4090 natívan fut, de ez fair összehasonlítás? Nem igazán.

-

hapakj

őstag

Kössz. Hát itt egyértelmű, hogy a teljesítmény növekedésbe beleérti a új framegenerálás által elért eredményeket.(mivel az 5070 csak így van egálban a 4090-el) Az pedig simán hihető, hogy a 5090 kétszer annyi framet tud előállítani framegenerálással, mint a 4090.

Igazából ma már még kevésbé egyértelmű mitől lesz egy VGA gyorsabb mint a másik. Raszter? Raytrace? AI? különböző metrikák, ahol különböző kép teljesíthetnek.

-

S_x96x_S

addikt

válasz

bgombos79

#41

üzenetére

bgombos79

#41

üzenetére

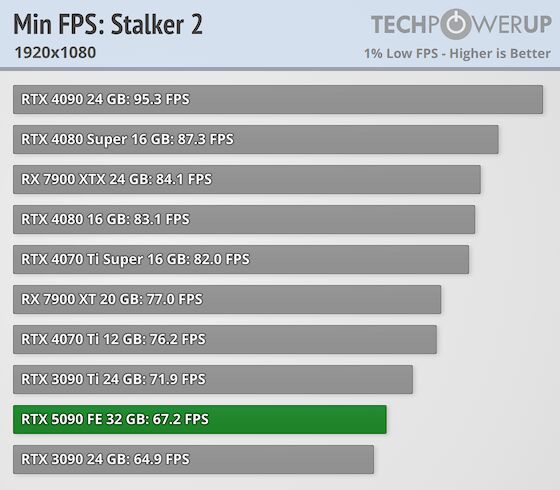

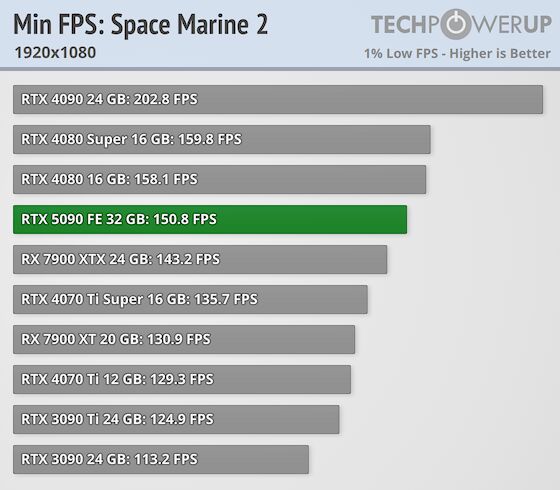

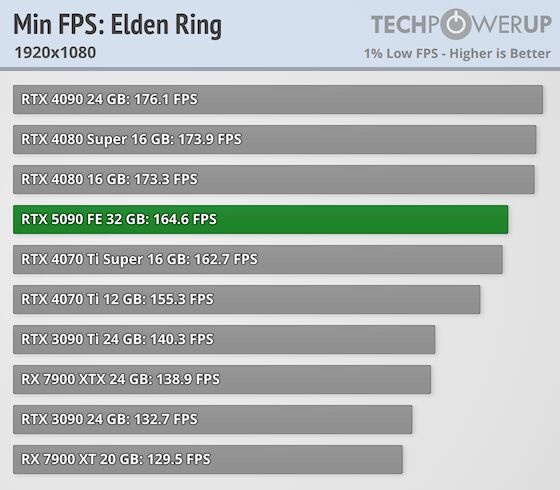

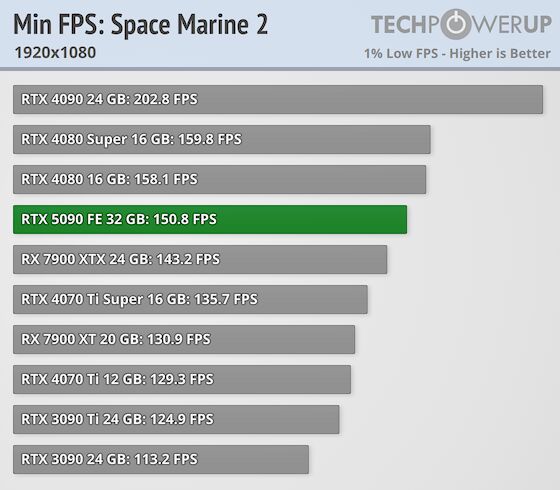

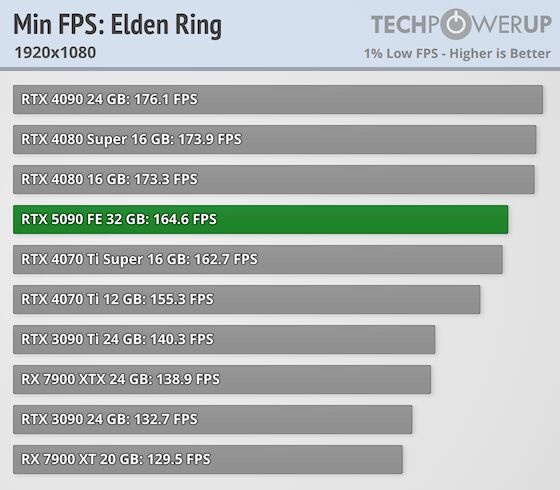

> RTX 5090 -t Full HD -n nézni elég bizar!

> Aki ilyen kártyát vesz szerinted Full HD -n tolja????A probléma az, hogyha az 5080 és az 5070 is ugyanezeket a drivereket kapja,

az nem lesz jó ... mert ott már (jobban) számít a Full HD,

és biztos nem lesz jobb az RTX 5070 eredmény mint a mostani RTX 5090 mérés.De én bízom, hogy a drivereket javítják még.

És van néhány furcsa 2560x1440 - teszt is, ahol a MinFPS furcsa.

( Persze a Flight Simulatort se tartják sokan rendes játéknak ) -

hapakj

őstag

Szerintem onnan jöhet a duplázódott teljesítmény, hogy azt állította, hogy a 5070-nek 4090-es teljesítménye van [link] Persze ez nyilvánvalóan nem igaz, csak abból jön hogy a DLSS 4 már 3 framet generál a 1 helyett.

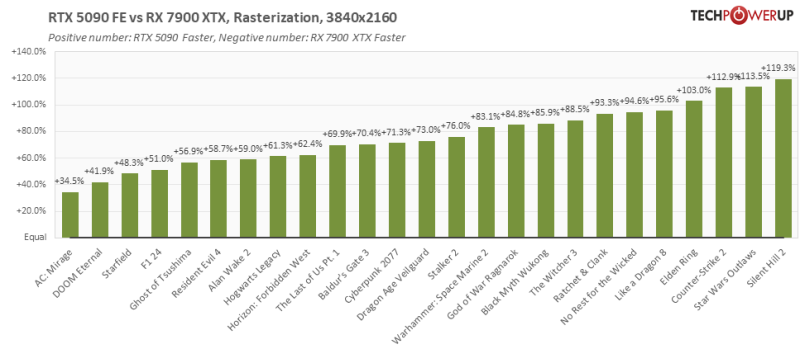

Amúgy ez az 50xx-es széria nyers teljesítményt nézve tényleg nem tűnik nagy eresztésnek. Kb csak az 5090 gyorsult jelentősebben a 4090-hez képest, de az is nem elhanyagolható fogyasztás növekedés mellett.

-

BiP

nagyúr

Igen, erre emlékszem is. (persze az is ordas nagy kamu, de hát ez egy prezi egy marketing vénával megáldott vezérigazgatótól, szóval kezeljük helyén a dolgot)

De Duck 5090 vs. 4090 vonatkozásban beszélt dupláról. Szóval tök más igényeket támasztott, meg mást állított, mint amire mi emlékszünk.

-

A prezentációban az 5070-et reklámozták úgy, hogy 4090 sebességet fog hozni, de nyilván az is csak a framegen bullshit-el értendő majd, csak ezt elfelejtette odaírni Jensen a slide-ra...

-

BiP

nagyúr

Nézd, a cégvezér, nagy lazán odalökte, hogy a 4090-hez képest megduplázódott a teljesítmény.

Nekem nem rémlik ilyen, de ha esetleg be tudnád linkelni, vagy ha leírva le volt, screenshotolni, megköszönnénk.

(ha valami esetleg duplázódik, akkor lehet, hogy itt valami nagyon spéci helyzetben valami feature-ben, pl. frame generált + DLSS4 vs. natúr DLSS2 vagy tököm tudja, vagy AI számolási kapacitás bizonyos feladatban)Tudod Te is, hogy ez nem reális. Jogos a felvetés, hogy akkor miért is várod, várnánk el?

-

-

podtibi

senior tag

Szerintem ezt most igazán kár volt megirni, mert ha még reklám volna(de nem az), akkor érteném. Gyakorlatilag leirtatok egy cikket, amiről mindenki tudott. Még a legnagyobb hülyék is tudják, hogy a büdös életbe nem kapsz videokártyát msrp áron. Azt meg minden épp eszű tudja, hogy tudatosan korlátozzák a videokártyák árait/kiadásait.

-

Hihetetlen.

Így csak négyet fogok venni hat helyett.

-

Vistaboy

veterán

Van egy olyan érzésem, hogy nekem jó lesz még a 4080 egy darabig. Ahogy én laikusként látom, az 50xx széria valóban mérföldkő, felvonultat új technológiákat, amik később biztos el fognak terjedni. Viszont én úgy vagyok vele, hogy ha kijön egy új technológia - még ha forradalmi is -, az első generációja mindig kiforratlan, kell egy kis idő, mire helyreáll. Majd meglátjuk, meddig lesz az 50xx a legújabb széria. Ha esetleg a 60xx csak pár év múlva jön, és az 50xx ára és teljesítménye már idén helyreáll, lehet, hogy beruházok egy 5080-ra, de a jelenlegi állás szerint, akinek egy erősebb 40xx kártya van most a gépében, annak tényleg csak akkor érdemes váltania, ha már nem tudja otthon hová tenni a felesleges pénzét.

Persze ez csak saját vélemény.

-

S_x96x_S

addikt

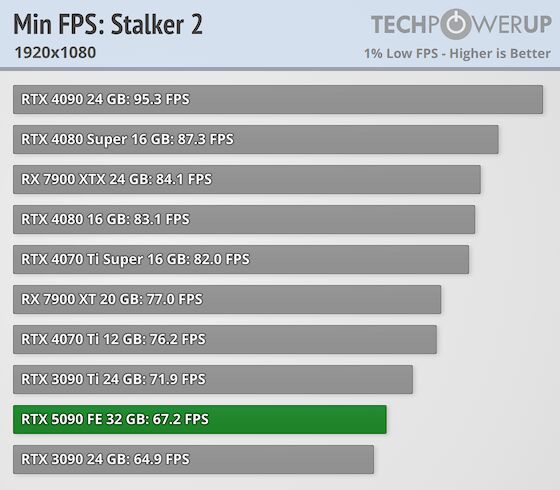

úgyis érdemes még várni a leendő RTX 5090 - tulajoknak.

mert a mért "Min FPS"-ek - néhány esetben elég extrém alacsonyak.Látszik, hogy egy kis optimalizálás ráfér még a rendszerre.

-

Duck663

őstag

Nézd, a cégvezér, nagy lazán odalökte, hogy a 4090-hez képest megduplázódott a teljesítmény. Ezek után joggal várhatom el, hogy GPU limites helyzetben ez megtörténjen. Nem történik, semmilyen esetben sem. A képgenerálást ne vegyük ide, mert ott azt lehet hazudni, amit csak szeretnének, lásd Lossless Scaling. 4K alatt jó lesz az 24%-nak is, mondjuk ahány teszt annyi eredmény.

. -

herion

tag

Mintha nem ez lett volna anno a 4xxx szériákkal is

Emlékszem mikor kiadták a 4070Ti-t egy hét után az Alza meg a többi webshop 400 ezer körül vesztegette az alsó(bb) polcos kártyákat. Az ilyen "felső(bb) polcosok" mint az Asus Strix 70Ti-ok meg 500+ körül mentek.

Mindig van valami indok, amivel mesterségesen feltudják tornázni az árakat az éhes viszoteladók...

-

Ez egy jó teszt lesz. Ha ezt az igen limitált előrelépést felmutató szériát is elkapkodják a népek scalper árakon, akkor igazából tényleg megérdemli a piac, ahogy az NVIDIA áraz...

-

Duck663

őstag

Hát a teszteket látva, azt kell hogy mondja, hogy csalódott vagyok. Hát hol van itt a dupla teljesítmény? A sugárkövetés hatékonysága jobb lett, a többi meg a kiépítés növekedéséből származó természetes teljesítménynövekedés. Nem ezt vártam, a bemutató után.

#11 Armagedown: A nagyobb chiplet dizájnos GPU-t törölték. Elméletileg azért, mert túl bonyolult lett. Az UDMA-s felsőházról olyan információk szivárogtak ki, hogy monolitikus lesz, nem chiplet dizájnos, tehát valós lehet a törlés indoka. Egyébként ha a 9070 oda jön ahova a szivárgások alapján sejtjük, akkor lenne értelme annak, hogy kettőt összerakjanak belőle dual GPU-s rendszerként, ha a szoftver oldaláról is kezelni tudják a dolgot. -

Akkor ezért nincs még fent az alza oldalán az 5090

-

DR01DMAN

aktív tag

Igen. Tiszta véletlen.

-

Armagedown

őstag

Megint lecsaptak a scalperek, ki gondolta volna

-

anulu

félisten

elnézve ezeket az árakat, a teszteket és a use-case-eim, kifejezetten örülök, hogy 2022. novemberében megvettem a 4090-et. nem mellesleg most az is többe kerül, mint a megjelenéskori scalper price...

-

hokuszla

senior tag

nincs vetélytárs

-

No problemo, majd veszek Radeont.

![;]](//cdn.rios.hu/dl/s/v1.gif)

-

-

Kinder

senior tag

Nahát?!

Ki hitte volna...

-

#90868690

törölt tag

Jó tudjuk tudjuk, mindenki várjon tavaszig mert jön a 9070.

Ez mind csak találgatás, az árakról. Majd január 30-án kiderül mennyi az annyi. És hogy milyen gyorsan lesznek pótolva a készletek.

És az is nyilvánvaló márciusban a radeon sem msrp áron fog indulni.

Az is meglepő hogy egy random fórum bejegyzés a cikk alapja. [link]

A random fórum bejegyzésekre nem adsz, vagy mégis?![;]](//cdn.rios.hu/dl/s/v1.gif)

Hiszen ugyan ilyen infók az amd már kiskerben lévő kártyáiról hazugság volt számodra. [link]

Új hozzászólás Aktív témák

Hirdetés

ph Ez azonban csak ideiglenes helyzet, tavasszal normalizálódni fog az árazás.

- ASRock RX 7800 XT 16GB GDDR6 Challenger OC - Új, bontatlan, 3 év garancia - Eladó!

- XFX SPEEDSTER MERC310 AMD Radeon RX 7900 XTX BLACK

- Csere-Beszámítás! Sapphire Pulse RX 7900XTX 24GB Videokártya!

- Országos! KÉSZPÉNZES - UTALÁSOS VIDEOKÁRTYA FELVÁSÁRLÁS! Korrekt áron! AMD!

- Kitűnő állapotban lévő ASUS DUAL RX5500XT EVO OC 8GB 128bit

- Telefon felvásárlás!! Samsung Galaxy A22/Samsung Galaxy A23/Samsung Galaxy A25/Samsung Galaxy A05s

- Bomba ár! Lenovo ThinkPad L390 - i7-8GEN I 8GB I 256SSD I 13,3" HD I HDMI I Cam I W11 I Gari!

- Huawei Nova Y90 128GB, Kártyafüggetlen, 1 Év Garanciával

- HP ProBook 430 G3 laptop Pentium 4405U CPU (hibás)

- Beszámítás! Xiaomi Redmi Note 10 Pro mobiltelefon garanciával hibátlan működéssel

Állásajánlatok

Cég: Laptopszaki Kft.

Város: Budapest

Cég: PCMENTOR SZERVIZ KFT.

Város: Budapest

/cdn.vox-cdn.com/uploads/chorus_asset/file/25822296/2192215278.jpg)

![;]](http://cdn.rios.hu/dl/s/v1.gif)