Új hozzászólás Aktív témák

-

válasz

AeSDé Team

#98

üzenetére

AeSDé Team

#98

üzenetére

Akkor elmagyarázom.

CPU limit akkor jöhet elő, amikor a GPU-nak kevés erőforrást igénylő képkockákat kell kiszámolni (pl. egy régebbi játék kis felbontáson vagy egy játék menüje). A GPU rengeteg fps-t tudna produkálni, de már a CPU nem tudja elegendő mennyiségű adattal ellátni, mert nem elég erős hozzá.

Ez a CPU limit. Hiába raknál a rendszerbe egy 2x olyan erős GPU-t, az sem tudna több fps-t generálni, mert a CPU limitálja az fps-ek számát, az a bottleneck, a szűk keresztmetszet.Amikor játékban vagy pl. egy Far Cry 4-ben, ami rendesen terheli a GPU-t, ott nincs semmilyen CPU limit. Ott a GPU izzad rendesen és a CPU bőven el tudja látni a szükséges adatokkal ahhoz a számú fps-hez, amit a GPU ki tud préselni magából.

-

válasz

AeSDé Team

#96

üzenetére

AeSDé Team

#96

üzenetére

Nem igazán érted, hogy mi az a CPU limit. A menüben sokkal nagyobb az esélye, hogy cpu limites lesz az fps

-

AeSDé Team

őstag

Na végre!

Néhány játékban (pl. FarCry 4) nincs limitálva a framerate a menüben, így amikor megnyomom az Esc gombot hirtelen megszűnik a CPU limit, a videokari pedig több száz FPS-t tol ki magából és azonnal felzúgnak a ventilátorok.

Jó lenne erre megoldást találni. -

FLATRONW

őstag

válasz

Tzoltan21

#94

üzenetére

Tzoltan21

#94

üzenetére

Nem tudják használni a játékfejlesztők DX alatt a tripla buffert, mert az API nem támogatja. Helyette van a render ahead funkció, aminek ugyanaz a feladata, mint a tripla bufernek csak némileg eltér a működése. A DX-es játékokban a fejlesztők tripla bufferként szoknak hivatkozni a funkcióra, tévesen.

-

FLATRONW

őstag

Az általad linkelt oldalon is szépen leírják a lényeget.

Eleinte az őskorban csak egy buffer volt, de ez valami miatt nem volt jó (gondolom sebesség problémák voltak)

Ezért bevezették a dupla buffert, ami már remek sebességet adott, de képtörés lett az eredménye.

Ezért bevezették a v-syncet, ami megszüntette a törést, de adott esetben a képfrissítés felére csökkentette a sebességet.

És utolsó lépésben létrehozták a tripla buffert, hogy a dupla bufferes v-sync okozta sebességvesztést kiküszöböljék.A következő oldal legalján frissítették a cikket és leírják, hogy az MS nem építette be a DX-be a tripla buffert, cserébe beletettek egy ahead prerenderd frames funkciót, ami 0-8 képkockáig buferrelheti a képkockákat. Azt, hogy pontosan mennyi ez a prerendered frames, azt a mai játékokban a készítők döntik el. Ez általában 3 képkocka. A tripla buffer kikapcsolt v-sync mellet semmilyen előnyt nem ad a duplához képest, ezért nincs is értelme használni és nem is használják.

-

válasz

Tzoltan21

#87

üzenetére

Tzoltan21

#87

üzenetére

Akkor jön ki nagyon durván a dolog, amikor mondjuk földrengés vagy hasonló rázkódás van a játékban és emiatt nagy sebességgel remeg a kép. Akkor az ilyen magas fps-eknél teljesen szétszakad. Pl. a Dead Space 1 elején, ahol az űrhajó remgett és volt 200 fps-em, ott az űrhajó ablakén lévő merevítőoszlopok vízszintes osztások mentén teljesen széttöredeztek. Vagy a Painkillerben, amiben ez a konfig hozott vagy 400 fps-t, egy oszlopcsarnokban kapott el egy földrengésszerű valami és az oszlopok teljesen széttöredeztek ugyaní]y a vízszintes osztások mentén. Annyire irreális látványt nyújtott, hogy muszáj volt bekapcsolnom a VSync-et.

-

Tzoltan21

tag

Eléggé érdekesség ez számomra.

Sosem tudtam, hogy a Vsync-nek ekkora jelentősége van. Sosem kapcsoltam be, mert gondoltam a nagyobb fps szám sosem jelenthet hátrányt. Azért van az ha mondjuk 200 fps-el fut egy alkalmazás, hogy aprócska vonalak jelennek meg a monitoron? Nem GPU hibára gondolok itt..

Sosem tudtam, hogy a Vsync-nek ekkora jelentősége van. Sosem kapcsoltam be, mert gondoltam a nagyobb fps szám sosem jelenthet hátrányt. Azért van az ha mondjuk 200 fps-el fut egy alkalmazás, hogy aprócska vonalak jelennek meg a monitoron? Nem GPU hibára gondolok itt.. -

De, pontosan ezt mondtam én is. Így már érthető, csak nem tudtam, hogy ez a frissítés hogy működik.

(#85) FLATRONW

Igen, jól mondod, és ugye ez a triple buffering + vsync lényege, hogy ha minden esetben 16,6 ms és 33,3 ms között van a képkockák kiszámolásának ideje az adott másodpercben, az fps akkor sem esik le 30-a, hanem nyugodtan lehet 55 is. -

FLATRONW

őstag

A tripla buffehez nagyon is kell v-sync és a programnak is OGL-nek kell lenni.

Természetesen dupla buffer mellet is lehet az fps szám bárhol 30 és 60 között.

Elsősorban azt kell megérteni, hogy az fps számláló nem a pillanatnyi sebességet mutatja, hanem az elmúlt 1 másodpercben kiszámolt képkockák számát.

Ami számít a végső képkocka sebességnél dupla bufferes v-sync esetén, hogy mennyi időbe kerül egy képkocka kiszámítása.Mondjuk hogyha a GPU minden egyes képkockát 16,7 - 33,3 ms között számol ki, akkor az fps mutató 30-at fog jelezni. Azonban hogyha az esetek nagyon nagy többségében 16,6 ms alatt kiszámolja és csak néhány képkocka kiszámolásához kell több idő, akkor simán mutathat 55-öt is a mutató.

-

FLATRONW

őstag

Egy kicsit módosítom a második mondatot, mert félreérthető.

Tehát az első kép első negyede az első negyedben, a második kép második negyede a második negyedben, a harmadik kép harmadik negyede a harmadik negyedben és a negyedik kép utolsó negyede pedig a negyedik negyedben lesz megjelenítve.

-

FLATRONW

őstag

Nem teljesen érted jól. 240 fps azt jelenti, hogy 4 darab negyed kép lesz egy frissítési ciklusban, 3 törés lesz a monitoron.

Tehát az első kép az első negyedben, a második a másodikban, a harmadik a harmadikban, a negyedik pedig a negyedik negyedben lesz megjelenítve. Az ötödik kép kirajzolásának kezdetetekor már frissít a monitor is és kezdődik elölről a megjelenítés. És így kerül a 237. képkocka újra az első negyedbe és így tovább. -

Tehát a 16,6 ms-es frissítés azt jelenti, hogy a bal felső képponttól a jobb alsóig ennyi időbe telik a pixelek újraírása? Azt hittem ez CRT-knél volt így. Akkor ha jól értem, 60 Hz és 120 fps esetén a monitor felső fele az első képkocka alapján rakja ki a pixeleket, utána meg ahogy bejön a második képkocka, az alsó fele már az alapján lesz frissítve?

Akkor mondjuk 240 fps-nél a legfrissebb információ csak a kép alsó negyedében található? Ami egy fps esetén a talaj?

-

FLATRONW

őstag

Nem mennek a kukába a kiszámolt képek. Ez az egyik oka a képtörésnek.

Vegyünk egy nagyon egyszerű példát. A monitor 60 Hz-es, tehát 16,6 ms-onként frissít. A grafikus kártya pedig pontosan 120 képkockát képes kiszámolni, tehát 8,3 ms-onként egy képet. Ez azt jelenti, hogy a monitor egyetlen frissítési ciklusa alatt 2 képkocka kerül kiszámításra.

Ebben az esetben az történik, hogy a monitor az első képnek még csak a felét jelenítette meg, de már elkészült a második is és ilyenkor a monitor már a második képből folytatja a megjelenítést. Tehát ebben az esetben pont a kép felénél megjelenik egy törés, mert két félkép van megjelenítve eltérő mozgás fázisban. -

Ez nem igaz. 60-szor kerül friss kép a monitorra, de nem mindegy, hogy 60 vagy pl. 120 az fps. A magasabb fps csökkenti az input lagot. Ha két képfrissítés között 1 képet számol ki a GPU, akkor képfrissítés után egy régebbi állaptot látsz. Ha viszont mondjuk 3-at számol és a legutolsót rakja ki, akkor frissebb információt látsz. Lehet, hogy így az előző 2 kép megy a kukába, de ez már csak ilyen.

-

7time

senior tag

válasz

Tzoltan21

#72

üzenetére

Tzoltan21

#72

üzenetére

Tehát így a sok fps csak kimérhető és nem látható...

Így van, ha többet akarsz akkor 120Hz monitort kell venni, tök felesleges 120Hz vagy több járatni a CPU-VGA ha csak 60 FPS látsz belőle mert csak eszi az áramot, például a Payday 2 játékban 130 FPS majdnem dupláját fogyasztja a gép, persze van sok játék amit ha maxra teszel még a 60 FPS sem bírja elérni a VGA limit miatt.

-

Tzoltan21

tag

Kérdés, hogy régebbi mondjuk HD4000-res vagy az alatti szériánál is működhet ez a fajta limiter? Amúgy szimplán az fps csökkentésnek nem látom sok értelmét, kivéve ha ugye a játék is gyorsul az fps szám alatt.

De egy ilyen teljesítmény/fogyasztás szabályzó jól fog jönni, ha lesz ilyen.

De egy ilyen teljesítmény/fogyasztás szabályzó jól fog jönni, ha lesz ilyen.

-

7time

senior tag

Próbáltam a Riva Tuner több játéknál sem tartja a beállított 60 FPS limitet úgyhogy nem lesz rossz egy ilyen driverbe épített csoda.

-

FLATRONW

őstag

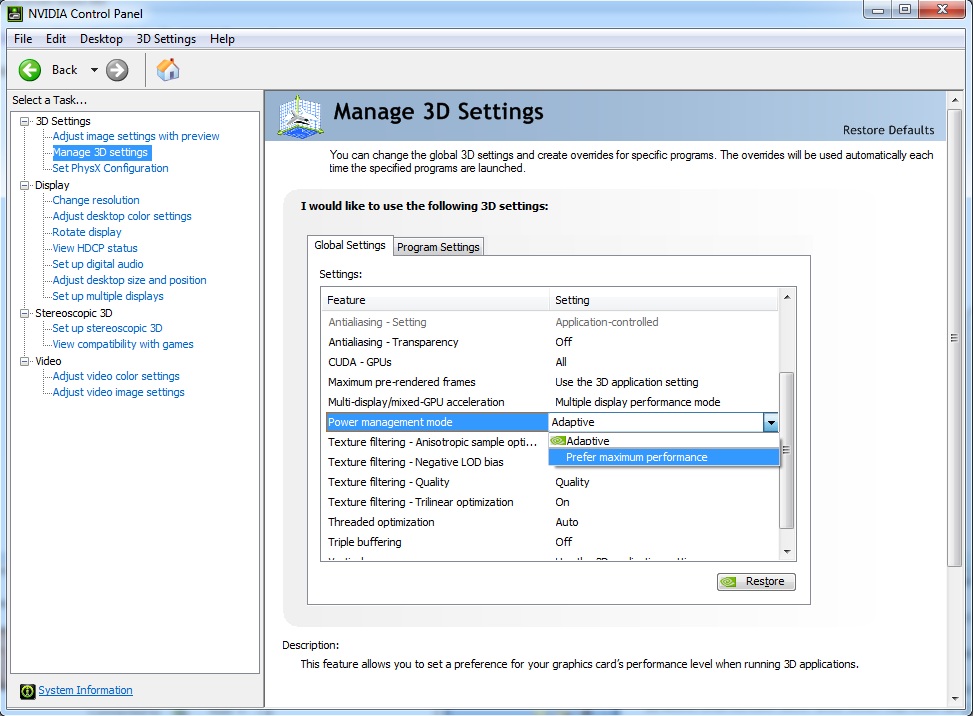

Mivel adaptív v-sync-et használsz, ezért a max teljesítmény csökkenteni fogja a GPU kihasználtságát, mert 60 képkockát kell csak kiszámolnia alacsonyabb minőség mellett. Valószínű, hogy ez megoldaná a fagyásokat is.

Én azt tanácsolom, hogy inkább a játékban vedd vissza a minőséget vagy pedig egy kicsit csökkentsd a GPU alapórajelét.

A Control Panel beállításodhoz lenne néhány észrevételem:- Globális szinten kapcsold ki a környezeti kitakarást, mert ilyenkor minden játékra bekapcsolja azt, még olyan esetekben is, amikor a játékban is van Ambient Occlusion (HDAO, HBAO, SSAO). Ezt a funkciót régi játékoknál érdemes használni, amikben nincs AO. Ilyenkor inkább a programbeállítások fülön külön a játékhoz tartozó profilban érdemes ezt külön beállítani. A driverből bekapcsolt AO jobban is terheli a GPU-t, tehát ezzel sebességet is vesztesz.

- az FXAA is kapcsold ki globális szinten, és csak azoknak a játékoknak a profiljában kapcsold be, ahol használni akarod. Hogyha globálisan be van kapcsolva, akkor minden hardveresen gyorsított programban homályosítani fogja a képet. Például a videolejátszás közben is elmossa a képet, hogyha az hardveresen van lejátszva.

- az élsimítás áttetszősége csak akkor működik (hogyha a játék támogatja is az élsimítást), hogyha az élsimítás módja is át van váltva az alkalmazás beállításának javítása vagy a bármely alkalmazás beállítás felülbírálása lehetőségre. Ezt is inkább érdemes profil szintjén kezelni.

-

Tudom ez off, de nekem most a Metro LL Recux-ban nagyon sokat crashel a játék. GPU driver timeout-tal, tehát szokásosan az a hiba, amikor túl van húzva a kártya. Azzal a különbséggel, hogy nincs. Max boost órajel van rajta. Elképzelhető, hogy ha áttenném max minőségről max teljesítményre, akkor nem lenne ilyen hiba? 1440p-ben futtatom és úgy nincs meg mindig a 60 fps. Mivel az adaptív VSync be van kapcsolva, így érthetően akkor izzad igazán a kártya, amikor beesik 60 alá. A crashek is akkor szoktak jönni sztem (bár nem fraps mellett szoktam futtatni, így nem tudom biztosra mondani). Van, hogy annyit crashel bizonyos pályarészeken, hogy visszateszem 1080p-re a felbontást. Úgy nagyon stabilan megvan a 60 fps, nem is szokott összeomlani. Így néz ki a control panelem:

-

FLATRONW

őstag

Állítólag tényleg vannak olyan esetek, amikor az órajelváltások hibához vezetnek, olyankor érdemes áttenni maximális teljesítményre, hogy ne váltogassa az órajeleket.

Hogyha nincs bekapcsolva v-sync vagy valamilyen külső fps korlátozó, akkor teljesen mindegy hogy adaptívra vagy maximális teljesítményre van állítva, mert ilyenkor úgyis max órajeleken jár a kártya.

-

-

LordX

veterán

Ja jó, olyan opció tényleg nincs, hogy ne vegye vissza az órajelet, ha nincs elegendő terhelés, mert ennek csak akkor lenne értelme, ha szarul lenne implementálva a váltás, és problémákat okozna.. A Battery Boost meg majd jön. Az órajel visszavételt az Ati hozta be 1 generációval az nV előtt (X800 vs 7800 GT), ezt az nV hozta ki egy generációval az AMD előtt. Egyszer egyik, egyszer másik, ilyen ez a popszakma.

Egyébként mi értelme nem adaptívra állítani ezt az opciót, hogy a kártya, ami egyébként 240 FPS-t tolna ki az adott játékban, az idő háromnegyed részében max frekvencia és max ventilátorzaj mellett pörögjön idle-ben VSync mellett?

-

FLATRONW

őstag

válasz

#57638400

#61

üzenetére

#57638400

#61

üzenetére

Valószínűleg keveri a 2 dolgot.

V-sync vagy külső fps korlátozás hatására ha jól tudom (radeon tulajok írták, hogy igen) a Radeonok is vissza veszik az órajeleket hogyha nincs szükség magas teljesítményre. Csak ennek a működése nem annyira agresszív, tehát egy bizonyos szint alatt kell lennie a GPU terhelésének, hogy visszavegye az órajeleket.

Az nvidia notebookokra fejlesztett Batery Boostja pedig a lehető legalacsonyabban próbálja tartani az órajeleket magas GPU terhelés mellett és csak akkor emel rajta, hogyha szükséges.

Ezt próbálja az AMD is megcsinálni, ez áll jelenleg fejlesztés alatt. -

FLATRONW

őstag

válasz

#57638400

#39

üzenetére

#57638400

#39

üzenetére

Csökken az órajel és a hozzátartozó feszültség szint is, így pedig a fogyasztás is nagy mértékben csökken.

Adaptívra kell állítani a power managmentet.

AMD-nél is van valami hasonló beállítás.Azonban ez a megoldás nem annyira hatékony, mert a GPU kihasználtságnak is egy bizonyos szint alá kell esni, hogy vissza vegye az órajeleket és a feszültséget és az órajel csökkentés után is egy bizonyos szint alatt kell lennie a terhelésnek, hogy alacsonyan is maradjon az órajel.

Ahogy utána olvastam az Nvidia féle Battery Boost funkciónak, az jött le nekem, hogy az adott fps limithez a lehető legalacsonyabb órajelet próbálja beállítani magas GPU kihasználtság mellett és ezt elég hatékonyan teszi. Szerintem az AMD is valami hasonlót próbál létrehozni.

Igaz, hogy csak mobil fronton érhető el ez a funkció, de az AMD is erre a piacra szánja elsősorban ezt a technológiát. -

kenyocsaba23

tag

Értem amit írsz és van is benne logika ha jobban át gondolom de szerintem aki jobban el mélyül ebben a témában és zavarja ha pörög a kártya a semmiért egy sima progival pl. evga precisonx-el lehet fixálni az értéket igaz ez nem mindenkinek kényelmes. A programozók pedig sosem fognak éhen halni az AMD-nél mert van bőven munkájuk szerintem.

-

imibogyo

veterán

Ezt tudom. De mivel ez egy új funkció lesz és még nem látta senki miképp lesz megvalósítva, így addig csak találgatunk és nyitva hagytam egy kiskaput a gondolatmenetemben. Én is azt írtam, hogy szinte 100%, hogy erre is lesz profilozás.

kenyocsaba23:

Egyrészről nem értem miért kell mikor legtöbb programban benne van hogy le szabályozza az fps értékeket. Azért mert rengetegben nincs benne. És ne csak játékokban gondolkodjatok már. Nekem például 3DS Max alatt úgy sírt a GTX 680 az előnézeti ablakban, hogy öröm volt hallgatni.Viszont amit már fentebb is írtak így jóval ócskább alkatrészekből meg tudnak oldani dolgokat amik közel bírnák addig mint a mostani jobb alkatrészek. Hagyjuk már ezt a hülyeséget. Honnan tudná a gyártó, hogy te mire használod? Honnan tudná a gyártó, hogy te leszabályzod-e a terméket, vagy sem? Vajon mennyi felhasználó korlátozná le a kártyáját (szerintem kevés a tulajdonosok számához képest) és épp ezért mennyi embernél jelentkeznének a gyengébb komponensek miatti sűrűbb halálozások és így a gyártóknál mennyivel nőne az ebből következő RMA? Vajon ez mennyi plusz költséget jelentene a cégeknek? Hagyjuk már a bullshit generálást....

Azt viszont nem értem miért éri meg nekik meg írni az új motort +firmware-ket minden új kártyához + évente hozzáírni dolgokat és fejleszteni a meglévőt. Ebben nem látok logikát ez szerintem nem egy okos húzás mert pl ennek fejlesztésére elköltenek xxxxmillió dollárt De miért kellene ezt tenniük pont emiatt a feature miatt? Amúgy egyébként is megteszik. Ha ez egy a driverben benne lévő feature lesz, akkor nem kell hetente fejleszteni, pláne nem kell játékonként optimalizálni. Egyszerűen valószínűleg figyelni fogja az FPS értékeket és ehhez igazítja a teljesítményt. Pont. Ha jól csinálják tökéletesen mindegy lesz a kártyának, hogy Super Mario miatt kell leszabályoznia az FPS-t, vagy a 3D-s kecskepornó miatt.

holott hagyhatnák a helyzetet úgy ahogy most van és nem költenének feleslegesen pénzt. Így van minek fejleszteni. Dögöljön éhen a sok programozó és fejlesztő. Gondolom nem hiába döntöttek úgy, ahogy.

-

kenyocsaba23

tag

Üdv mindenkinek! Gondoltam én is hozzászólok mert elég érdekes a dolog számomra.

Egyrészről nem értem miért kell mikor legtöbb programban benne van hogy le szabályozza az fps értékeket. amit valaki vagy be kapcsol vagy nem. Innentől ezt igazán bízhatnák a felhasználókra.

Viszont amit már fentebb is írtak így jóval ócskább alkatrészekből meg tudnak oldani dolgokat amik közel bírnák addig mint a mostani jobb alkatrészek.Azt viszont nem értem miért éri meg nekik meg írni az új motort +firmware-ket minden új kártyához + évente hozzáírni dolgokat és fejleszteni a meglévőt. Ebben nem látok logikát ez szerintem nem egy okos húzás mert pl ennek fejlesztésére elköltenek xxxxmillió dollárt plusz ha azt vesszük a gagyibb alkatrészek holott hagyhatnák a helyzetet úgy ahogy most van és nem költenének feleslegesen pénzt. Lehet az is a le cibált fps-el közelebb akarják hozni a konzolokat és az api-kat ami már nem akkora hülyeség.De kinek kell ez? Mire jó?. Ezt nem értem.

-

imibogyo

veterán

De hát ez a te döntésed, hogy használod-e vagy sem. Nem kényszeríti rád senki sem. Ráadásul már többen jelezték, hogy nV-nél is van ilyen lehetőség driverben. Magyarul mind a két cég driverében megtalálható lesz (és már) ugyanaz. Próbálhatod tovább savazni egyoldalúan a pirosakat, de akkor légyszíves tedd ezt a zöld oldallal is, mert így igazságos. Szóval DE, ezek tényleg butaságok, amiket összehordasz, mert nagyon zöld szemüveget viselsz.

Ráadásul már ott nagyot hibázik a logikád, hogy nem lesz a 290x-ból 270. Mert mondjuk ha beállítasz 150 FPS-es limitet, akkor az összes nagy címnél izzadni fog a 290x-es kártyád, nemhogy 150 FPS-t kicsavarjon magából, hanem hogy mondjuk 60-70-et (csak hasra példa). De ott ahol meg mondjuk 2000 FPS-ed lenne (Supermario 3D

![;]](//cdn.rios.hu/dl/s/v1.gif)

), ott meg ne menjen már a kártya feleslegesen, mert egyrészt ciripelhet (és ismételten mondom, hogy zöld és piros oldalon egyaránt), másrészt meg minek fogyasszon? Mert ugye átkapcsol a játék miatt "teljesítmény módba" a vga, csak épp az nem fogja meg a hardvert, akkor meg minek pörögjön? Hogy Pistike jókat masztizzon a bazi nagy FPS számokra?

), ott meg ne menjen már a kártya feleslegesen, mert egyrészt ciripelhet (és ismételten mondom, hogy zöld és piros oldalon egyaránt), másrészt meg minek fogyasszon? Mert ugye átkapcsol a játék miatt "teljesítmény módba" a vga, csak épp az nem fogja meg a hardvert, akkor meg minek pörögjön? Hogy Pistike jókat masztizzon a bazi nagy FPS számokra?CSAK AKKOR lesz a kártyád visszafogva, amikor majd a felhasználó úgy dönt és CSAK ANNÁL a programnál aminél így dönt. És ez nagy különbség. Persze elképzelhető egy globális beállítás is (ennek én örülnék), de ezt majd meglátjuk. Az szinte 100%, hogy lehet majd paraméterezni/profilozni a dolgot. Ha meg majd nem, akkor majd úgyis jól meghőzöngjük a dolgot. De majd csak akkor...

És erre a V-sync sem megoldás, mert mi van, ha mondjuk 60-nál (60 Hz-s monitor), vagy 144-nél (lásd előbbi) én többet akarok FPS-ben, de mondjuk 200-tól meg kevesebbet (mert mondjuk ott kezd el ciripelni a GTX 970-em)?

Igazad van, csakhogy az nV-nál tudni fogod, hogy szar kártyát vettél, AMD-nél meg nem

Ne haragudj, de ez oltári nagy hülyeség... Te nem ugyanazzal a füleddel hallgatod az egyik kártyát, mint a másikat (bár a hsz.-ediből úgy látom, hogy tényleg nem). Az meg eleve hülyeség, hogy ha az egyik gyártónál hibaként tekintünk valamire, akkor a másiknál miért is nem? Egyébként azt mondják a nagyok, hogy ez működési sajátosság (elsősorban a csúcs kártyáknál), de annál zavaróbb. Csak bizonyos hardver-összeállításnál (táp, alaplap és vga kombinációknál) és ehhez még ráadásként csak bizonyos programokkal jön elő (ráadásul például játékok esetén, csak bizonyos FPS tartományban). Ettől még nem lesz kellemes.Ráadásul az ASUS és MSI nV kártyámat sem gariztatták alapból (ők gagyi gyártók ugye???), mert ez NEM HIBA. Volt amelyiket végül sikerült kicseréltetnem, és kaptam egy még ciripelősebbet, ráadásul pont nV-ből (GTX 680 referencia). Ja, akkor az nV is gagyi gyártó. Értem.

De segítek, hogy fogd a lényeget: az AMD leszabályozza az FPS-számot...

Nem. Neked kellene fognod, hogy nem erről van szó. Arról van szó, hogy ha a user úgy dönt, hogy neki elég mondjuk 80 FPS, akkor aföllött ne teljesítsen a kártya. Ezzel energiát spórolva meg és a kártyát jó esetben halkabban járatva van a céljánál. Talán akár még a vga életét is meghosszabbítva.Szóval SZERINTEM nem arról van szó, hogy innentől a BF4-ben 50 FPS-ról leveszi a teljesítményt mondjuk játszhatatlan 20-ra. Hanem arról van szó, hogy mondjuk 400 FPS helyett beállítasz magadnak mondjuk 144-et maximumnak a 144 MHz-es monitorodra. Ami meg amúgy is alaposan leterheli a gépedet, arra meg jól nem húzol rá limiter profilt. Ennyi.

Mutasd meg, hol csinált ilyet az nV. Ide akartam írni egy hosszabb részt az átcímkézgetésről, de inkább nem teszem, mert úgy látom felesleges.

-

katt777

félisten

Nyilván a smiley jelentéséhez is kell egy kevés ész.

Iróniáról meg még nem is hallottál. De segítek, hogy fogd a lényeget: az AMD leszabályozza az FPS-számot, ami azt jelenti, hogy egy jóval gyengébb kártya teljesítményét kapod a drágább VGA áráért. Mutasd meg, hol csinált ilyet az nV. Vagy inkább ne, mert ez itt nagyon OFF, mások meg mind értik, miről van szó.

Iróniáról meg még nem is hallottál. De segítek, hogy fogd a lényeget: az AMD leszabályozza az FPS-számot, ami azt jelenti, hogy egy jóval gyengébb kártya teljesítményét kapod a drágább VGA áráért. Mutasd meg, hol csinált ilyet az nV. Vagy inkább ne, mert ez itt nagyon OFF, mások meg mind értik, miről van szó.

-

katt777

félisten

Dehogynem. Csak arra AB-t használok. De ÉN akarom állítani. Ha az AMD meghajtója tudja majd mindazt, amit az AB, akkor érdekel, addig viszont lehetőleg igyekezzenek minél kevesebbet újítani és javítani, minden AMD-felhasználó érdekében.

![;]](//cdn.rios.hu/dl/s/v1.gif)

Minden játékban lehet VSync-et állítani, nem kell feltétlenül driverből.

Az viszont 100%, hogy a ma is rengeteg órajelváltogatás okozta hibát az újítás csak soxorozni fogja.

imibogyo: Igazad van, csakhogy az nV-nál tudni fogod, hogy szar kártyát vettél, AMD-nél meg nem. Első esetben reklamálhatsz, másodikban eszedbe sem jut. Gagyi gyártótól nyilván nem szabad semmit megvenni, és igen, aki olyat gyárt, az maga javítsa. Én sosem okoltam az AMD-t olyasmiért, ami nem az ő saruk, de ha hivatalosan támogatják a gagyi cuccokat amire az egész terv egyértelműen mutat), akkor felelősnek tartom őket érte. És persze nem változtat azon, hogy egy 290X kártya adott esetben egy 270 szintjén totyogjon 3x áron. Ilyen nV kártyát nem hiszem, hogy láttál.

Mondjuk, ha eladhatom a 7870XT-met, hogy az új meghajtókkal majd ugyanazt a teljesítményt tudja, mint egy 290X, hiszen ma is mindent visz fullban (-PX), akkor ez kevésbé fog zavarni.

Amilyen hibát te tapasztaltál, az nem csökkentette a VGA-id teljesítményét, ahhoz meg nem kell csúcskártya, hogy egy magas FPS-számú játék cicergést okozzon. -

big-J

őstag

Ez egy nagyon jó ötlet és nagyon-nagyon-nagyon rég óta csodálkozok hogy nincs benne alapból.

-

#57638400

törölt tag

Jó, akkor is csökken valamennyire a fogyasztás, de nem vesznek vissza az órajelből. Ebben az a pláne, hogyha egy játék régi, és nincs benne V-sync opció, akkor azt bekapcsolva akár 200 MHz-en pörgeti 75 FPS-sel, mert régebbi a játék. Mert én most is használok RadeonPro-t a Sims 3-hoz, mert abban nincs V-sync, de ettől biztosan nem veszi vissza az R7 250-em órajelét. Bár, nem tudom, hogy ebben megvan-e az említett PowerTune.

Ha eddig is volt már olyan szoftver, ami visszavett az órajelből, az egy 3rd party alkalmazás volt. Ahogyan Abu is mondta itt - ebben az lesz a poén, hogy nem 3rd party lesz, hanem gyári megoldás, ami az övék, driverből megy, így hatékonyabb lehet. Bár, ennek én asztalon is örülnék, de tényleg az ultramobil fronton van a legtöbb ember számára jelentősége.Szerk.: typo

-

Abu85

HÁZIGAZDA

Nem. A HRAA nagyon komplex. Fél tucat AA megoldás összegyúrása, nem csak egymáshoz kell ezeket igazítani, hanem a játékhoz is, mert analitikai megoldás. Ezt csak a program oldalán lehet implementálni. De jelenleg ezt sem lehet megtenni PC-n, mert a DX nem engedi meg a geometriai adatok kiolvasását az LDS-ből a pixel shadernek. Sok hardver még a dedikált SAD4 utasítást sem támogatja, mert az is egy opcionális fícsőr a DX API-n belül.

-

haxiboy

veterán

Kíváncsian várom az Nvidia megoldását erre a célra.

Az lenne a frankó hogy trükközés nélkül lehetne csökkenteni az input lagot vsync mellett, én pl 60HZ monitoron stabil 60fps-el nem tudok BF4-ezni mert akkora az input lag mint az állat. 59FPS mellett nincs ilyen azóta mindenhol 59-es limitet állítok. Nyilván egy 144HZ monitorral nem lenne gond, vagy nem ekkora. -

Duck663

őstag

Ez szuper, én a Radeon Pro-ban használok ilyet. Azért is nagyon jó, mert amikor a képkocka 60 körül ingadozik, kicsit lejjebb véve, én 45-öt állítottam be, nem lesz tearing, sokkal egyenletesebbnek tűnik a futás, pedig a képkockaszám alacsonyabb! Ezt pedig úgy, hogy driverből, szuper, és reméljük alkalmazásonként profilozható is lesz!

Abu egy kérdés!

Az Ubinál kreálták ezt a HRAA nevű dolgot, amit PS4-en A FarCry4-ben használnak. Na a kérdésem az lenne, hogy ezen az alapon nem lenne lehetséges kreálni egy hasonló minőségű élsimítási eljárást a driverbe? Amit minden (vagy legalább néhány) alkalmazásra rákényszerít a felhasználó. Pl az Alien Isolation AA-ja tök mindegy melyiket nézzük, de egy fos. A BioShock Infinitbe is le tudnék viselni jobbat.

-

shteer

titán

Ezzel lehet majd kordaban tartani az uj 3xx szeria vegtelen etvagyat?

-

szacsee

nagyúr

Indie játékoknál jól jön, hogy majdnem 2D órajelen mehet a kártya.

-

Xelo

addikt

"úgy limitálják a fps-t, hogy a fogyasztás is csökkenjen"

bármilyen megoldással limitálod az fpst a fogyasztás csökken. egyértelmű hogy ha nem kell 150fpst nyomnia a vganak csak 60at mondjuk akkor kevésbé lesz kihasználva -> kevesebb enerdzsi kell neki. tudomásom szerint a vsyncelt 60 kicsit jobban izzasztja a kártyát mint a natúr limitált, tehát ebből a szempontból mindenképp jobb megoldás a korlátozás. az AMD annyit csinál hogy létrehoz egy, a kártyáira jobban optimizált megoldást, ami elérhető lesz bárkinek driverből. -

#16939776

törölt tag

Ez tök jó ha a user tudja beállítani mennyi képkockát szeretne látni, és nem egy háromfokozatú csúszkán lehet majd beállítani hogy mennyire legyen takarékos.

Fix:120FPS elég egy közepes sebességű játékhoz, de egy pörgősebbhez 250-300-nál nem raknám lejjebb.

Ha nagyon gyakran és drasztikusan kell változtatni a GPU órajelén az bőven érezhető lesz a reakcióidő változásában vagy microlagban. -

imibogyo

veterán

Konkrétan a felhasznált alkatrészek minőségére, amelyek nem bírnák a terhelést, esetleg ciripelnének...

Leszabályozott VGA-n persze kisebb eséllyel jönnek ki hardveres (ne adj isten, driveres

Leszabályozott VGA-n persze kisebb eséllyel jönnek ki hardveres (ne adj isten, driveres  ) hibák, ergo lehet szemetet teríteni, nagyobb a haszon, amire meg égető szükségük van.

) hibák, ergo lehet szemetet teríteni, nagyobb a haszon, amire meg égető szükségük van.

Szerintem ezt a "gyenge minőséget" nem szabad leszűkítened még gondolatban sem csak az AMD-re. Csak én legalább 3 darab NV csúcs kártyával és 2 AMD csúcs kártyával szenvedtem a "coli whine"-tól (mivel ez általában csúcs kártyákat érintő probléma). Akkor az mi? A fórumok most is teli vannak a GTX970-es nyavalygásokkal is. Mert én meg mondhatnám a te gondolatmeneteden elindulva, hogy térítse vissza az NV a pénzemet, mert 180.000 Ft-ért "hibás" hardvert ad el..... (ahogy ilyen szempontból az AMD is). Szóval ez a "gyenge minőségű komponensek" problémakör színtől függetlenül megtalálható. Egyébként pedig a legtöbb ilyen kártya NV és AMD oldalon is a gyártópartnerektől jön, nem az anyacégtől nem referencia kártyák, tehát ezért őket okolni eleve balgaság.

És pont emiatt a hírhez kapcsolódva az AMD sem foglalkozna ezzel, ha mondjuk a ciripelő Sapphire kártyákkal lenne a probléma, akkor azt oldja meg a Sapphire. Vagy, hogy NV oldalról is mondjak akkor az ASUS vagy az MSI (az én esetemben pl. GTX 680 volt ilyen és egy MSI 970).

Épp ezért én azt gondolom, hogy ténylegesen a fogyasztás csökkentése a cél. És mondjuk amikor CSS-zek (amit már a mákdarálóm is 180 FPS-el futtat), akkor akár maradhatna passzívban is a dVGA (lásd ASUS Strix).

-

Abu85

HÁZIGAZDA

Ha neked a V-Sync kell, akkor használd azt. De ott nem tudsz a monitorod alá menni tetszőleges frissítéssel. Itt azt állítasz be, amit akarsz. Másrészt a V-Sync egyik hátránya, hogy nem mindig működik. Persze ez programhiba, mondhatjuk azt, hogy csinálják meg jóra a programot.

(#24) lenox: Ugyanezt csinálja a többi gyártó hardvere is, csak a PowerTune alapján kontrollálni az AMD számára hatékonyabb, mert a Radeonok sokkal sűrűbben válthatnak órajelet.

-

Kansas

addikt

Erre a célra pont nem - ha jól értem a ciket meg a screenshot-ot, akkor ennél a technikánál a lényeg az, hogy úgy limitálják a fps-t, hogy a fogyasztás is csökkenjen.

Példa:

X játékot egy 120W TDP-jű VGA negyed gőzzel is elvisz 60fps-en

Ha ezzel a technikával limitálod az fps-t, a fogyasztás is kb. a negyedére esik, vagy még kevesebbre, mert ugyen nem egyenes az arányosság, ha pl. feszültséget és órajelet is csökkent.Ezzel el lehet érni pl hogy a kis teljesítményigényű játékoknál ne egyen annyit a gép, és ezzel párhuzamosan akár halkabb is legyen.

Ha rosszul értettem, remélem Abu kijavít...

-

katt777

félisten

Érdekes megközelítés. Én eddig azt hittem, hogy a VSync, amely programból vagy éppen a driverből is bekapcsolható, pontosan betölti ezt a funkciót az adott monitornak megfelelően.

Mivel a fentiek alapján nyilvánvalóan semmi szükség FPS-limiterre, ennek beépítése a józan logika szerint egészen más okra vezethető vissza. Konkrétan a felhasznált alkatrészek minőségére, amelyek nem bírnák a terhelést, esetleg ciripelnének... Leszabályozott VGA-n persze kisebb eséllyel jönnek ki hardveres (ne adj isten, driveres

Leszabályozott VGA-n persze kisebb eséllyel jönnek ki hardveres (ne adj isten, driveres  ) hibák, ergo lehet szemetet teríteni, nagyobb a haszon, amire meg égető szükségük van.

) hibák, ergo lehet szemetet teríteni, nagyobb a haszon, amire meg égető szükségük van.

Akinek nem kell magas FPS, vegyen olcsó kártyát, ha meg az AMD korlátozza a VGA-m kihasználhatóságát, akkor térítse vissza az árkülönbözetet, amennyivel kevesebbért megkaphattam volna egy ugyanezt a teljesítményt nyújtó karit.

Remélem, nem lesz szükségem más okból frissebb driverre, amíg nem lesz ismét normális támogatással bíró VGA a gépemben. -

-

Laja333

őstag

válasz

FollowTheORI

#17

üzenetére

FollowTheORI

#17

üzenetére

Az csak egy fps limiter. Elolvastad a cikket, vagy csak nem érted mire jó az AMD megoldása?

-

dgabor80

tag

Nagy vagy ABU, köszi szépen a cikket!!!

-

Abu85

HÁZIGAZDA

Jóval egyszerűbb itt a helyzet. Ilyen megoldása még senkinek sincs, mert ha belemész a driverbe, akkor képtelen vagy korlátozni az fps-t. Ez nem csak az átlagfelhasználók számára van így, hanem mindenkinek, mert a driveren belül hiányzik ez a funkció. Ez tény.

Az is tény, hogy alternatív programokban bárkinek elérhető, csak ez nem a driver része. Ennyire egyszerű a dolog. -

Xelo

addikt

felfogtam hogy bonyolultabb valamennyivel, csak túl sok értelmét nem látom. laposok alapból visszavesznek a teljesítményükből ha aksiról mennek ami majdnemhogy garantált FPS csökkenést eredményez. persze eltudom képzelni hogy egyes csillagászati árú termékeknél nem így történik és éppenséggel jól jöhet ez a funckió, de ott is megoldható manuálisan a limit.

@Abu85: az hogy átlagfelhasználónak "nem érhető el" és az hogy a "driverben senkinek nincs ilyen" nem feltétlenül egy és ugyanaz. nyilván erre jöhetne a reakciód hogy node nem "dinamikus" az nvidiáé amivel meg is fognál. hogy kukacoskodjak még egy kicsit: az inspectort telepíteni se kell csak futtatni.

![;]](//cdn.rios.hu/dl/s/v1.gif)

-

Abu85

HÁZIGAZDA

-

imibogyo

veterán

válasz

Bogyó bá'

#10

üzenetére

Bogyó bá'

#10

üzenetére

Na jó, ok. De gondolom az nem is pörgeti a Far Cry-t 230 FPS-el.....

Mondjuk a jelenlegi gépemnek nekem sincs ilyen gondja. Félpasszív Celeron diszkrét VGA nélkül. Bár a Just Cause 2-vel még így is elvagyok.

Mondjuk a jelenlegi gépemnek nekem sincs ilyen gondja. Félpasszív Celeron diszkrét VGA nélkül. Bár a Just Cause 2-vel még így is elvagyok.

Meg aztán ez amúgy sem csak AMD betegség. Nekem a GTX 670-680 is csinálta, meg a GTX 570-em is. Pedig mind a három más-más gyártótól volt. És elég sokan panaszkodnak erre más kártyáknál is, például GTX 970-nél.

-

imibogyo

veterán

Akkor végre véget érhet sok felhasználónál a "coil whine" (már akinél a sok FPS okozza). Nekem is csak akkor jött elő a 7970-nél, amikor 200+ FPS-em volt. Az (lehet csak nekem) nem derült ki a cikkből, hogy ezt globálisan is be lehet álítani? Tehát, hogy sehol sem legyen mondjuk 100 FPS-en felüli érték, vagy CSAK programonként? Mert az én szememben ennek globálisan lenne értelme. Beállítanám, hogy mondjuk maximum 150 FPS legyen globálisan és akkor akár mit is csinálok, akkor is csak 150 FPS lesz.

-

stratova

veterán

Náluk is van ilyesmi csak Battey Boostnak hívják és notinál korlátoz 30 fps-re a hosszabb üzemidőért.

-

szunyika

tag

válasz

FollowTheORI

#1

üzenetére

FollowTheORI

#1

üzenetére

De ha lenne is nekik ilyen, akkor miért ne lehetne követni?

A jó dolgokat miért ne lehetne továbbfejleszteni vagy NeAdjIsten lekoppintani? Erről szól a világ, így haladnak előre a dolgok...

Bár manapság már a szabadalmi háborúról szól az élet...Mellesleg gondolom neked Nvidia-d van

-

Reinkz

senior tag

eddig is volt v-sync, gondolom az lesz az újdonság hogy hozzá igazítja a szükséges teljesítményhez az órajeleket.

-

7time

senior tag

válasz

FollowTheORI

#1

üzenetére

FollowTheORI

#1

üzenetére

Nincs nekik ilyen , mit kellene követni???

-

nonsen5e

veterán

válasz

FollowTheORI

#1

üzenetére

FollowTheORI

#1

üzenetére

Náluk már van nvcp szinten ilyen fps szabályzó? 2 hónapja adtam el a zöld kártyámat, akkor nem volt még azt hiszem.

-

Követni kell az nVidiát ebben is.

![;]](//cdn.rios.hu/dl/s/v1.gif)

Új hozzászólás Aktív témák

Hirdetés

- BESZÁMÍTÁS! ASUS ROG CROSSHAIR X670E GENE alaplap garanciával hibátlan működéssel

- ÁRGARANCIA!Épített KomPhone Ryzen 5 5500 16/32/64GB RAM RTX 4060 8GB GAMER PC termékbeszámítással

- Samsung Galaxy A04 64GB, Kártyafüggetlen, 1 Év Garanciával

- BESZÁMÍTÁS! Apple MacBook Air 15 M3 8GB 256GB SSD garanciával hibátlan működéssel

- Kingmax 1x2GB DDR2 800 RAM eladó

Állásajánlatok

Cég: PCMENTOR SZERVIZ KFT.

Város: Budapest

Cég: Liszt Ferenc Zeneművészeti Egyetem

Város: Budapest

Sosem tudtam, hogy a Vsync-nek ekkora jelentősége van. Sosem kapcsoltam be, mert gondoltam a nagyobb fps szám sosem jelenthet hátrányt. Azért van az ha mondjuk 200 fps-el fut egy alkalmazás, hogy aprócska vonalak jelennek meg a monitoron? Nem GPU hibára gondolok itt..

Sosem tudtam, hogy a Vsync-nek ekkora jelentősége van. Sosem kapcsoltam be, mert gondoltam a nagyobb fps szám sosem jelenthet hátrányt. Azért van az ha mondjuk 200 fps-el fut egy alkalmazás, hogy aprócska vonalak jelennek meg a monitoron? Nem GPU hibára gondolok itt..

nem értem más hogyan tud nélküle játszani.

nem értem más hogyan tud nélküle játszani.

Akkor nem árt ha több az fps. Anno mikor nagy counter strikeos voltam. Mindig belőttük 100-ra az fps-t és gondoltuk, ha valakinek 60 van akkor mi hamarabb észrevehetjük, de ez a különbség elenyésző és monitorfüggő egyben...

Akkor nem árt ha több az fps. Anno mikor nagy counter strikeos voltam. Mindig belőttük 100-ra az fps-t és gondoltuk, ha valakinek 60 van akkor mi hamarabb észrevehetjük, de ez a különbség elenyésző és monitorfüggő egyben...

![;]](http://cdn.rios.hu/dl/s/v1.gif)

), ott meg ne menjen már a kártya feleslegesen, mert egyrészt ciripelhet (és ismételten mondom, hogy zöld és piros oldalon egyaránt), másrészt meg minek fogyasszon? Mert ugye átkapcsol a játék miatt "teljesítmény módba" a vga, csak épp az nem fogja meg a hardvert, akkor meg minek pörögjön? Hogy Pistike jókat masztizzon a bazi nagy FPS számokra?

), ott meg ne menjen már a kártya feleslegesen, mert egyrészt ciripelhet (és ismételten mondom, hogy zöld és piros oldalon egyaránt), másrészt meg minek fogyasszon? Mert ugye átkapcsol a játék miatt "teljesítmény módba" a vga, csak épp az nem fogja meg a hardvert, akkor meg minek pörögjön? Hogy Pistike jókat masztizzon a bazi nagy FPS számokra?

Amik most vannak AA-k azok gyalázatosak!

Amik most vannak AA-k azok gyalázatosak!