- Azonnali informatikai kérdések órája

- Hobby elektronika

- Samsung LCD és LED TV-k

- OLED TV topic

- Intel Core i5 / i7 / i9 "Alder Lake-Raptor Lake/Refresh" (LGA1700)

- Kormányok / autós szimulátorok topikja

- Bambu Lab 3D nyomtatók

- Vezetékes FEJhallgatók

- AMD Ryzen 9 / 7 / 5 9***(X) "Zen 5" (AM5)

- Amlogic S905, S912 processzoros készülékek

Új hozzászólás Aktív témák

-

Kelori

tag

Tripla A játékról beszélgetünk, és az állítható fov-ot meg a fényerő + kontraszt slidert release után patchelik be, nagyon jó, welcome to 2023 testvéreim az úrba

Ezt régen nem full áras gameszkónak hívták hanem nagy jóindualattal open bétának

Ezt régen nem full áras gameszkónak hívták hanem nagy jóindualattal open bétánakNevetek is, meg sírok is, hogy ilyenek sem szúrnak már szemet senkinek.

És amikor megjelenik egy baldur's gate 3, aminek kb a standardnek kéne lennie, akkor jönnek az ilyen cikkek hogy: "A Larian studio túl magasra tette volna a lécet?"Nem baszki, mások tették abisszálisan alacsonyra, és rontották hozzá a végtelen igénytelenségükhöz a gamerek elvárásait.

Egy szónak is száz a vége viszont, (és itt én is befejeztem a starfield ekézését,) minden hibájának ellenére számomra az a legnagyobb baj itt, mint nagyon sok másik modern címnél is, hogy hiányzik belőle a szív, a lélek. És azt nemigen fogják bele patchelni.

-

"This first update is a small hotfix targeted at the few top issues were are seeing. After that, expect a regular interval of updates that have top community requested features including:

- Brightness and Contrast controls

- HDR Calibration Menu

- FOV Slider

- Nvidia DLSS Support (PC)

- 32:9 Ultrawide Monitor Support (PC)

- Eat button for food!We’re also working closely with Nvidia, AMD, and Intel on driver support, and each update will include new stability and performance improvements."

-

#57018880

törölt tag

válasz

paprobert

#49

üzenetére

paprobert

#49

üzenetére

31 óra után: vannak jelenetek amik olyanok mint ha a Quake2-ből importálták volna be, meg néha azért van egy egy ahol mondjuk hozza a Cyberpunk szintet is, tehát elég vegyes. A kissé lehangoló része, hogy pont a ronda részeken tud nagyon szaggatni. Nem értem amikor a kép 80%-a szürkeárnyalatos pixel, az miért tankolja be ennyire a frameratet, minden más játékban ha ilyen jelenet/kamera állás van akkor azonnal kiugrik az fps számláló..

CPU tesztekkel együtt érdemes értelmezni szerintem, illetve most már van arról is infó, hogy a RAM használata sem optimális PC-n, így az SSD agyon terhelése szinte folyamatos.

-

PuMbA

titán

"mert csak az AMD-nek van hozzá meghajtója jelenleg."

Van az NVIDIA-nak is drivere és pont ugyanakkor lett elérhető, mint az AMD-é. Csak az Intelnek nincs: D3D12 Work Graphs Preview

"To obtain the NVIDIA drivers supporting work graphs, please reach out to your developer engagement representative."

-

Abu85

HÁZIGAZDA

válasz

paprobert

#49

üzenetére

paprobert

#49

üzenetére

Ha nem tudja etetni a hardvert elég gyorsan a parancsmotor, akkor ilyen mínuszok vannak.

Egyébként meg lehet nézni, hogy az Xboxban milyen parancsmotor van. Annak a befogadókapacitása a 4090-nál háromszor jobb. Ezek limitet okoznak, mert az AMD erre rengeteg tranzisztort költött, míg az NV inkább tensor magokra költötte a tranyókat.

És nyilván a programozók is látták, de nem tudnak mit tenni, ha nincs elég széles etetése az egyes hardvereknek.

Majd a work graphs segíthet, de azt is AMD-n kell írni, mert csak az AMD-nek van hozzá meghajtója jelenleg.

Nem hiszem, hogy sokan ilyen motort írnának. Ez inkább kivétel lesz, mint szabály, mert az efféle dizájnhoz nagyon jól jönne az, ha a GPU saját magát tudná etetni.

-

paprobert

őstag

Ez egy nagyon hosszú írás arról, hogy Radeon-ra írták az engine-t, és minden máson sz*rul fut emiatt.

Objektíven nézve, mindig vannak engine szintű kilengések azonos kaliberű kártyák teljesítménye között.

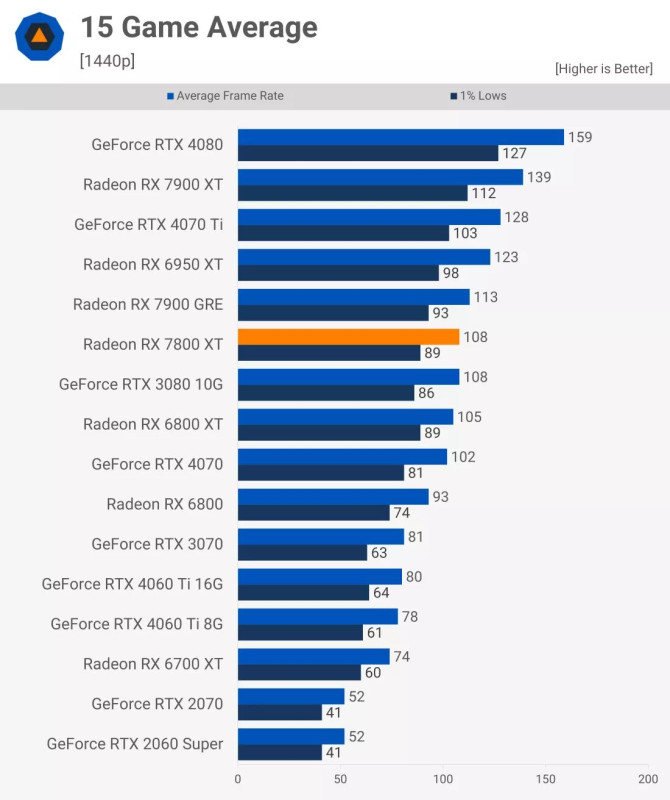

Tipikusan 10% alatti, pár címnél +- 10-20 százalék is lehet. A Starfield viszont soha nem látott, mínusz 40+ százalékot ér el(jelzi, hogy a kód a rossz).

További red flag, hogy a hardverek csökkentett TDP-vel futnak.

Hardveres differencia persze van a gyártók között, de ha erre nem gondoltak a programozók, akkor megint csak a kód a rossz, és a fejlesztő hibázott.Azt látjuk, hogy 3 vendor helyett csak 1-en fut megfelelő sebességgel, miközben a grafika átlagosan csak egy erős közepes.

A megjelenített végeredmény/gépigény hányados alapján a kód nagyon pazarló(igen, még Radeon-on is).Szóval kb. 3-4 apró hint mutat arra, hogy nem a világgal van a gond, hanem a Starfield-del.

Persze ha ezentúl a legtöbb játék ezt a karakterisztikát mutatja majd, akkor el tudom fogadni a trendváltozást, de ez addig csak Bethesda-szerecsenmosdatás marad. -

Abu85

HÁZIGAZDA

Igazából volt példa. [link] - lásd itt. Csak arra nem számított senki, hogy a GeForce driverek hatékonysági limitje egy friss játékban még max grafikán is kijön.

A másik limit, amiből ez származik, ahogy a rendszer a parancsokat kezeli. Egy rakás aszinkron copy parancs van a grafikai és a compute parancsok mellett. A grafikai annyira nem számít, de például ultra beállításon már zömében jönnek a compute pipeline-ok. Ilyenkor a profilozó szerint nagyjából fele-fele a grafikai és compute pipeline terhelés. Tehát a parancsok egy része már nem a nyers grafikai parancslistába kerül, hanem a compute parancslistákba. És ott már egy csomó dolgot tud tenni velük a meghajtó, mert a grafikai parancslistát ugye a Windows kezeli egységesen, oda nem tud beleszólni a driver. És a copy, illetve compute parancsok egy nem OS által kezelt listán mennek be, ami normál esetben nem gond a GeForce-oknak, de akkor igen, ha a copy parancsok száma is sok, mert nem tudják őket csak limitált parancslistákon beküldeni a hardverbe. Hiába tud a hardver xy teljesítményt, ha nem tudod etetni elég gyorsan a parancsokkal. Így tök lényegtelen, hogy mennyi feldolgozó van benne, mert nincs munka, amin dolgozhat. Az AMD azért tudja a hardverét dolgoztatni, mert nem egy szimpla parancsmotort használ, ahogy az NV, hanem van pár compute és copy parancsmotor, amelyek fölé van húzva egy hardveres ütemező. Ilyenkor ugye egy rakás lehetőség nyílik meg előtted, mert a driver látja előre, hogy melyik parancs fontosabb, és ha valamelyiket gyorsan kell bedobni a hardverbe, akkor azt előreveszi. Erre vannak az AMD-nél high priority parancslisták, és ha ott jön valami, akkor az mindennél nagyobb elsőbbséget élvez. Az NV a DirectX 12 API-ban nem képes megváltoztatni a beérkező parancsok sorrendjét, tehát addig nem tudja etetni a hardvert, amíg be nem fut a szükséges parancs. Ez egy hardveres limitáció, ami koncepcióból ilyen, mert az AMD-féle parancsmotor nagyon sok tranzisztort igényel, és azokat a tranziszotorokat az NV tensor magokra költi, amelyeknek meg ennél a játéknál nincs semmi haszna, sose kapcsolnak be. Ez felfogásbeli különbség a hardvert tervezését tekintve, és nyilván az NV nem számolt vele, hogy ilyen hamar jön olyan játék, amely pont ráüt a GeForce-ok limitjeire. Ugyanígy vannak erős limitjei a Radeonoknak is, csak máshol, de például azok a limitek a Portal RTX-ben kijönnek. Tehát ennek az ellentettjére is van példa. Csak a Starfield a GeForce-ok Portal RTX-e lett.

Egyébként a leképező közel sem 12 éves. Nagyon is új, mivel a Bethesda licencelte ezt: [link] - The Forge leképező keretrendszer, ami egyébként pont arról híres, hogy nagyon modern, nagyon gyors alternatíva. Ha 12 éves leképezőt használna a Starfield, akkor a GeForce-oknak sem lenne vele gondja. Pont az a baj, hogy nagyon modern működésű leképezőt használ.

-

Nagynozi

aktív tag

Ez egy BS magyarázat, Digital Foundry Alex Battaglia virágnyelven közölte velünk, hogy itt előnyt élveznek az AMD kártyák és ezt aljas módon érték el. A Starfield-ben 46%-kal teljesít jobban az RX 6800 XT, mint az RTX 3080, erre még nem volt példa a múltban. Lehet itt szépíteni a dolgot, de ezt nem nyelem be. Egy majd 12 éves ráncfelvarrott engine-re épülő játék fusson már jól közepes hardvereken. Nem akarom tovább bántani a Starfield-et, mert, mint játékot szeretem, de itt lehet szakzsargonnal jönni, egyszerűen megakad a falat és nem a szűk keresztmetszet miatt.

-

Abu85

HÁZIGAZDA

Abban a környezetben, amit a Starfield teremt a 6800 XT jobb kártya. Értsétek meg, hogy nem mindegyik játék terheli ugyanúgy a hardvert. Vannak a dizájnoknak erős és gyenge pontjai. Ha egy játék működése nagyon rámegy egy dizájn szűk keresztmetszetére, akkor hiába tud egy másik játékban jól működni, nem fog abban a játékban jól menni, ahol a szűk keresztmetszet korlátozza a sebességet.

Egyébként, ha az NV ezen akar változtatni, akkor át kell írni a meghajtónak az erőforráskezelését. Ki kell dobni a Turing és az Ampere supportot, és el kell kezdeni az Ada pure bindless modelljére szabni a meghajtót, így kiszedhető az emuláció. Ezzel megszűnne egy szűk keresztmetszet. Csak ezt nem fogják megcsinálni, mert a Turing és az Ampere supportra szükség van, nem váltottak még elég sokat Adára. Két D3D12 implementációt pedig nagyon drága lenne fenntartani. Az nagyon megnövelné a hibafaktort, a bugokat, stb.

-

Sundesz

addikt

Ez csak mellébeszélés. Ez a játék szarul fut Nvidian (látványhoz képest mindenen is), ami vagy véletlen, vagy nem lepődnék meg azon, hogy direkt stratégia része (Abu magyarázata az okot említi). Ott a Resi 4, Last of Us, ezek AMD promóban voltak és mégis tudja a 3080 a 6800 XT szintjét. A Starfieldben jelenleg low-n 1440p-ben sem tud stabil 60 fpst mindenhol egy 4070-en, csak FSR-el.

Még azt is kinézem, hogy a Zen 4 nagy előnye a Zen 3-hoz képest is a marketingstratégia része.

-

de nincs olyan, hogy valós teljesítmény

az h az amd részesedése tizenpárszázalék, az hogy a játékok nagyon nagyrészében nvidia "szponzoráció" van, az mennyire torzítja szerinted azokat a "valós" eredményeket?

#35 Kelori

és te minden raklap szar játék cikkei alatt ott vagy a kommentjeiddel?

vaaagy.... netán savanyú a szőlő? TÉNYLEG azt hitted, hogy az intel történelme után ez a gpu majd maga lesz a csoda? (nekem volt anno i740em... és követtem, hogy IGP címen mit műveltek az elmult években... )amugy jah, gamepass címeknél a preorder szokta vinni az eladásokat

köszönjük az elemzést, "hasznos" volt!

köszönjük az elemzést, "hasznos" volt!#33 djbb534

ez a második cikk, ahol a kommentek közt hülyét csinálsz magadból a "másikban" is beírtam az értékeket, ott sem reagáltál

a "másikban" is beírtam az értékeket, ott sem reagáltál  most ezekre itt se fogsz?

most ezekre itt se fogsz?6800xt

Pixel Rate 288.0 GPixel/s

Texture Rate 648.0 GTexel/s

3080

Pixel Rate 164.2 GPixel/s

Texture Rate 465.1 GTexel/s -

Régebbi 740 vga kártya is szenvedett a meghajtó program hibái miatt, látom a helyzet itt is ugyan az.

-

Piszmaty76

aktív tag

válasz

Rabbitf_24

#39

üzenetére

Rabbitf_24

#39

üzenetére

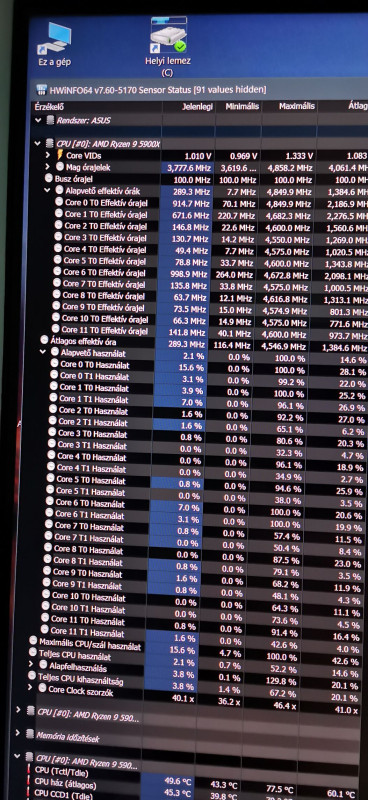

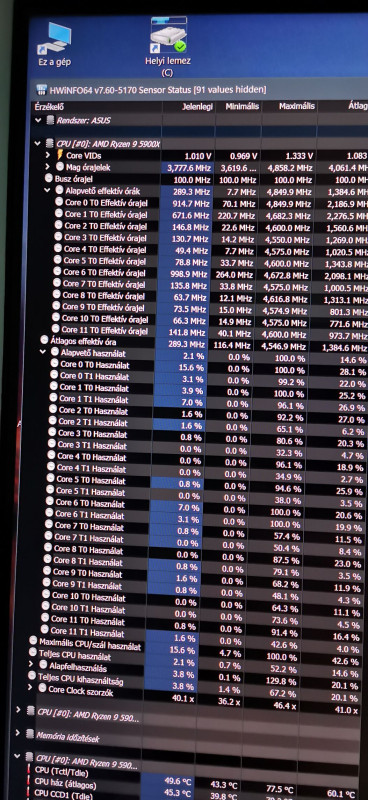

Az 5900X-em a játék alatt.

-

Rabbitf_24

addikt

Hogyan proci igényes a játék?

1 szálon max órajellel kell nyomatni, vagy több magot is használ rendesen? -

Abu85

HÁZIGAZDA

Ez egyébként baromira nem egy elegáns workaround, hibázik is vele az engine random jelleggel. Lényegében egy work graphs-hoz hasonló modellre álltak át. Ezt a Bethesda is meg tudja tenni, amint elérhető lesz a work graphs a DirectX 12 API-ban. De most még nem elérhető, tehát az ExecuteIndirectet kell használniuk. Persze esélyes, hogy a kódot már eleve a work graphs-hoz szabták. Valószínű, hogy tudják is ellenőrizni, mert már vannak azért work graphs driverek a preview specifikációhoz.

Az implementálás miatt meghajtóoldali támogatás kell. A Radeonhoz tervezett RADV ezt azért tudja megcsinálni, mert támogatja az VK_NV_device_generated_commands kiterjesztést. Anélkül a workaround nem működik. Az Intel open-source vulkan drivere ezt nem támogatja. Szóval ez nem olyan egyszerű, hogy jön a proton és megy oszt kész. A meghajtót is ehhez kell írni. Valószínű, hogy az ANV-t meg tudják csinálni ilyenre, de gyárilag biztos nem fog támogatást kapni a VK_NV_device_generated_commands.

A másik probléma a bugok. Ez RADV és ANV esetében kezelhető, mert a közösség írja magát a drivert is, de például gyári driverrel arra vagy kényszerítve, hogy a gyártó megkönyörül-e a nem elegáns workaroundodon. Nem fog, mert nem ajánlott módon használod a meghajtót. Ha a work graphs-hoz hasonló modell ráhackelhető lenne mindenre, akkor szimplán egy driver fícsőr lenne az ExecuteIndirectet használó játékokra, de nem az, ezt implementálni kell a kódba.

-

-

Kelori

tag

Bethesda helyében én olyan kussba vágnám magamat hogy még a jóisten se tudna a létezésemről sem.

Igénytelen, lelketlen, kétbalkezes balfasz brigád. Ha egy ismeretlen stúdióként adták volna ki ezt a raklap szar játékot, a lőtéri kutyát nem érdekelné a végtelen bugjaival, amatőr megoldásaival, és a látványához képest nemlétező optimalizációjával.

De persze megint elkönyvelhetik sikernek, mert a sok pre-order meg day 0 vásárló akik egy csimpánz és egy hintaszék értelmi szintje között mozognak, már az első percben megtermelte nekik a bevételt.

Rendeljük elő gyorsan, nehogy elfogyjon a digitális kulcs xdddd Agyhalott emberek

-

kabortex

újonc

Na ezért nem vennék Intel kártyát. Még egy új AAA játék futtatását se tudják megoldani, nem csak a régiekkel van baj. Már két nagy javítást kiadtak, de még mindig tele van hibával. Meg se közelíti a másik kettőt támogatásban.

-

Sundesz

addikt

Én nem a specifikációkra értettem, hanem a valós teljesítményre, amiben általaban pariban van a 2 kártya. Persze amit Abu írt az magyarázhatja, hogy miért fut ez a motor rosszabbul Nvidian.

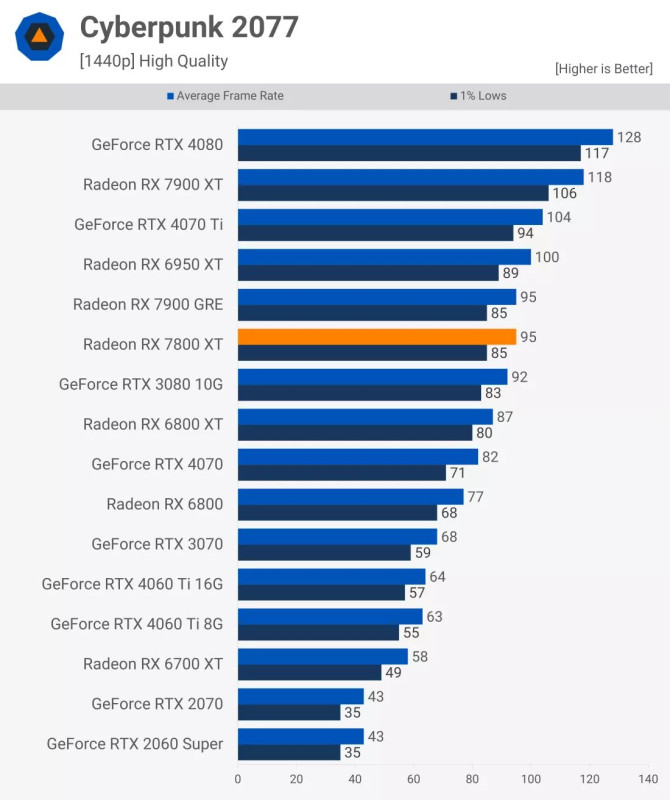

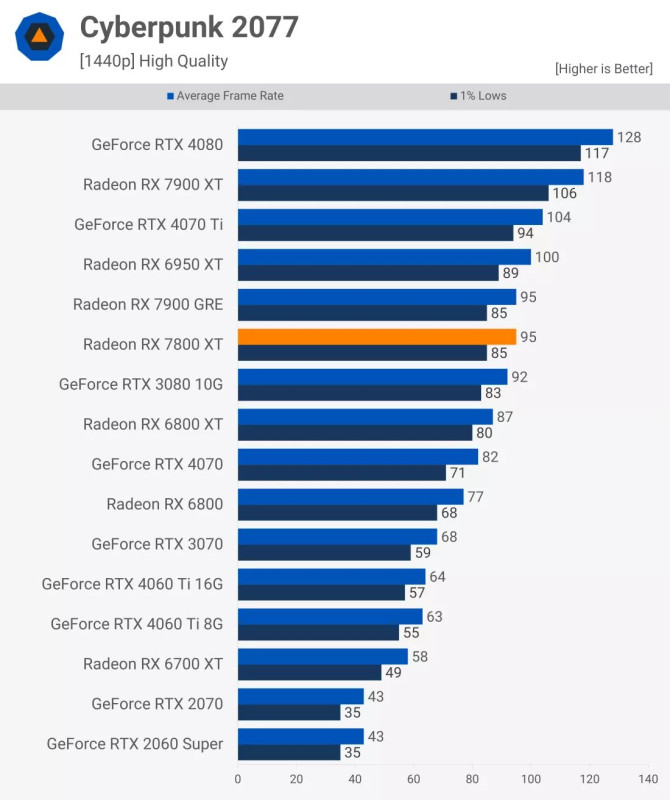

Beltereken nagyon szép tud lenni a játék és ott megvan a kellő fps is, de a New Atlantis rosszul is fut de legalább nem is szép.Az FSR nem tudja a moddolt DLSS minőségét a Starfieldben ez tény. És sajnos legtöbbször ha mindkét megoldás adott akkor jobb a DLSS képminősége.

Cyberpunk 2077. Az RT szempontjából igazad van.

-

-

Köszi a részletes választ! Persze ez most így érhető de az nem hogy miért nem volt bétateszt. Ezért írtam hogy Amd és Nv tesztelhette, inteles meg csak nézett a kiadás pillanatában hogy el sem indul a játék.

Mondjuk azt észrevettem hogy virtuális memóriát növelve (8gb-ról 24-re) stabilabb a játék, nem tudom hogy ez összefügg vele.

És ez a ram fragmentáció magyarázná azt is hogy miért ugrál az fps egy helyben is ugyan azon jelentnél.(gondolom akkor dobál össze vissza mindent) Mert amúgy játszható fps-t produkál de nem stabil, nekem csak a stabilítással van gondom.

Írhatták volna kezdetektől hogy Inteles NE vedd meg mert nem fog menni, prémium mehet a kukába. Jó persze refund lehetne.

Furcsa de pl iris xe dg1 kártyához meg nem kellett rebar. -

pár napja a 4080 miatt szálltak belém, most te ütsz a 3080 csodás rasztererejével... (techpowerup gpu database - persze remélem jó értékeket nézek! tévedés joga fenntartva!

)

)

6800xt

Pixel Rate288.0 GPixel/s

Texture Rate648.0 GTexel/s

3080

Pixel Rate164.2 GPixel/s

Texture Rate465.1 GTexel/sstarlink videok alapján 2 generációt ugrál látványban, attól függően, hogy kint a természetet nézed vagy bent az ürállomást. és ahogy írod, a zsák krumpli szimulációja az sajnos cpu ciklusokat zabál. az fps meg összevissza van: simán adódik helyzet, amikor a kapott látványhoz képest tök jó a sebesség!

persze! cyberpunk2077.

terméeszetesen beleszámolom az RT-t is, hiszen a szponzoráció sarokpontja évek óta... gondolom korábbról a gameworks, azelőttről a fizix a "nem ér a nevem" kategória, de ahol csak dlss van, fsr pedig nincs, az is kellemes élmény! (itt ugye csak fsr van, ami megy nvidián is, nem is lasabb, nem is rondább, stb szóval nagyon nem ugyanaz a "kibaszás" kategória, mint fordítva...)

szóval nagyon nem ugyanaz a "kibaszás" kategória, mint fordítva...)#27 MasterDeeJay

félre ne értsd, a bétás szemétkedés az gyomorforgató dolog, az amd azt gondolta, hogy ha ő csak feleakkora féreg, mint az nV, azt akkor simán lenyeli a közösség... hiszen az nV-nek MINDENT elnéz a gpu vásárlók ... mennyi is? 86 százaléka?

-

Abu85

HÁZIGAZDA

válasz

MasterDeeJay

#24

üzenetére

MasterDeeJay

#24

üzenetére

Nem az Intel-AMD harc miatt van gond. A memóriamenedzsmenttel van baja az Arcnak. Időközben kutakodtam, majd holnapra lesz belőle írás. A lényeg az, hogy a Stafield olyat csinál a memóriamenedzsmentben, amit eddig még senki. Nem csupán allokál erőforrásokat, hanem virtuálisan allokál blokkokat, és ezeket a blokkokat defragmentálja. Így tud egy csomó hasznos adatot belezsúfolni 8 GB-ba. És ez a része nagyon működik a rendszernek, mert alig van olyan helyzet, ahol 8 GB VRAM-nál többet igényelne. A gond a blokkok méreténél kezdődik, mert azok helyezgetése egy csomó kis adatmennyiségű másolást jelent. Ez egy dedikált GPU-nál oké, mert erre van tervezve, de az Arc az inkább működik IGP-ként, annak ellenére, hogy dedikált hardver. Az Intel ezt a jellegű működését a ReBAR-ral próbálja ellensúlyozni, csak amikor a motor kényszeríti a kis blokkok mozgatását, akkor azt le kell tömbösíteni, mert ha nem tennék, akkor egy rakás teljesítményt elveszítenének. Annyit, hogy az A770 semmilyen beállítással nem futna 25 fps-sel sem. Ez a tömbösítés viszont bonyolult, mert a motor nem ezt várja. Lényegében az Arc nem úgy működik, ahogy a szoftver elvárná, és ezt valahogy ellensúlyozni kell a driverből. Nagyon nehéz dolog, de ezt meg kell lépni. Viszont jó hír, hogy a Battlemage generáció már nem olyan lesz, mint az Alchemist, az sokkal inkább dedikált GPU-ként fog működni, és nem IGP-ként.

A másik lehetőség a memóriamenedzsment átírása, egyszerűsítése, de akkor meg 14 GB-nyi VRAM-ot is lezabálna a Starfield. Szóval ez valamit valamiért dolog. Alapvetően hasznosabb, ha spórol a menedzsment, ez jó a Radeonnak és a GeForce-nak is, de az Arc az ilyen jellegű trükköket alkalmazó spórolást nem komálja.

#25 Sundesz : A raszterizálás teljesítménye nem sokat számít a Starfieldben. Sokkal inkább limit a parancsmotorok áteresztőképessége. Valószínű, hogy a sok aszinkron copy feladat, ami betesz a parancsmotoroknak. Azok ugye ugyanazon a pipeline-on keresztül mennek be a GPU-ba, mint a compute feladatok.

-

-

válasz

MasterDeeJay

#24

üzenetére

MasterDeeJay

#24

üzenetére

a konzolt a kontextus miatt írtam, hogy ezeket a játékokat nem az 1.6ghz-es jaguár cpu-ra készítették, ami mellett a célzott gpu is csak egy gtx750/radeon7700as

a játék pedig azért nem indult, mert bétatesztelsz

tudtad, hogy nem véletlen olcsó az az intel, volt elég teszt netszerte, hogy rengeteg játékkal nem működik, beleugrottál, most várod a drivert. nincs ezzel semmi gond, de érdemes helyén kezelni a dolgot.

tudtad, hogy nem véletlen olcsó az az intel, volt elég teszt netszerte, hogy rengeteg játékkal nem működik, beleugrottál, most várod a drivert. nincs ezzel semmi gond, de érdemes helyén kezelni a dolgot.gondolom a 10 éves asscreed unity működésképtelensége is az amd-s harc miatt volt... meg a többi játék totálisan elfogadhatatlan performansza. szóval nem tűnik fel semmiféle pattern, a starlink A KIVÉTEL

-

Sundesz

addikt

Ha nem lenne egyértelmű akkor arra gondoltam, hogy bármilyen tesztoldalt felütve a végén az összesített teljesítménygrafikon megnézve kb egyforma erős kártyákról van szó raszterben. A 6800 XT nem 40%-al gyorsabb egy 3080-nál.

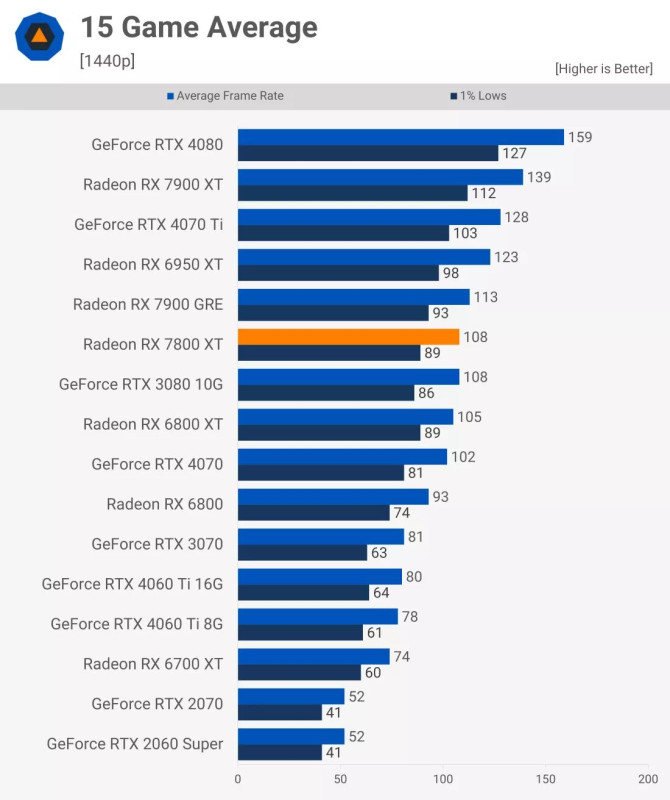

A kapott látvány köszönő viszonyban sincs a gépigénnyel ez tény (a DF optimized settings viszont teljesen élhető). De CPU oldalról is a Zen 3 éppen elég a 60 fps-hez, így nem csoda hogy Xboxon 30 fps lock van Zen 2 CPU-val.

Tudsz mondani olyan NV szponzorált címet ami AMD-n botrányosan fut? Ray tracinget ne számoljuk bele. Tény, hogy több az NV cím, de hogy ennek milyen hatása van a teljesítményre azt nem tudom.

-

-

"azonos kategoriáju"

ez a számozásból kalkulálható? az árból? vagy mégis miből?

ez a számozásból kalkulálható? az árból? vagy mégis miből?ez van amikor tensormagba rakod a tranyót, nem nyers erőbe

+a pénzt pedig inkább bőröndben hordod a vidiásjátékot fejlesztőkhöz nvidiásításért, nem pedig árazol máshogy/raksz a pénzből több kraftot a nyákra

JÓREGGELT!

(és most tessék elképzelni, hogy ezen egy amd kártyás 15 éve 30 játékból 29x átmegy... az nvidiás EGYSZER kap pofont és telesírja a világot.... mert a dlss3 modhoz már nincs kedve

)

) -

válasz

GodGamer5

#16

üzenetére

GodGamer5

#16

üzenetére

szerencsére a többi nextgen only cucc tök jól megy! (tlou, remnant, jedi2)

fel kéne ébredni emberek, ez PÉCÉ. locsold rá a következő 3-4 kilót és mehet tovább a móka. el tetszettek kényelmesedni, mert amíg a jaguar cpura és 10 éves gpura optimalizákltak, elég volt a bányász300k-s gpu, de többé nem elég....

#17 MasterDeeJay

semmiféle botrány nincs, csak a pécések elszoktak attól, hogy a gépük már NEM 10x jobb a konzolnál...#19 K0vasz

ha statikus a világ és nincs fizika azabaj, ha van rajtuk sapka, azabaj.....#20 Gave

sőt! 8k@120-ra! (legalábbis egy végtelen erősségü cpu-n)

(legalábbis egy végtelen erősségü cpu-n)

ugyan nativ 4k-ban a 4090 is küzd az életéért nagyon sok játékban, de az amd bénácskább előző genes cuccának is tudnia kéne! csak nem tudja. -

K0vasz

aktív tag

szvsz ott lehet a kutya elásva, hogy ez egy alapjaiban ezeréves engine, az intel videokártyája meg nativan nem is támogatja a directx11 (vagy 10?) előtti dolgokat

de botrány ez az engine, hogy annyira CPU-igényes, hogy még egy fullHD@60fps-hez is egy R5 3600 a minimum - még ha egy 4090 is van mellette (link). nem csoda, hogy xboxon is csak 30 fps-t tud kitolni magából

-

Nekem szintén a770 crash 5 sec-30min között van hogy az előbbi a gyakori, helyszíntől függ. Fps random ingadozik egy helyben is.

Gtx750ti mobil verzión stabilabb (de ott az egész noti fagy kb fél 1 óra között) ami amúgy nem is igazi dx12 kari....

Motor sem hiszem hogy dx12 lenne.

Maga a játék rohadt jó lett csak a botrány nem amit maguknak köszönhetnek. -

GodGamer5

addikt

A Bethesda olyanokat nyilatkozik mostanság, csoda, hogy nem lincselték meg még őket a fanok... Szerintük minden rendben van a játékukkal, jól is van optimalizálva, ha neked nem megy nem baj, vegyél új gépet... Egyszerűen arcpirító amit megengednek maguknak. Tetves egy stúdió az biztos..

-

#57018880

törölt tag

válasz

A Molyember

#13

üzenetére

A Molyember

#13

üzenetére

Todd szerintem azt mondja amit az AMD és/vagy MS diktál neki, de amúgy meg tök jól van optimalizálva 30fps-re

.

. -

A Molyember

tag

Nem tudom mi bajotok, Todd is megaszonta, nem a Starfield az optimalizalatlan, hanem a gepetek gyenge.

-

Lewzke

őstag

Vagy a Starfield nem elég jó egy középkategóriás videokártyához.

-

majd lesz uj intel driver és akkor menni fog. 20 évet kell behoznia a kékeknek, az elmult egy évben szerintem 200 játék lett stabilabb az ujabb driverektől.

azt nem tudom, hogy valaha lesz-e ELÉG JÓ, ill. én akár milyen olcsó is, egyelőre biztosan nem vennék (eleve nem szeretem a pécét, ez a szintű bétateszt pedig a legalja user experience

)

) -

TeeBee73

veterán

Furcsa. Felraktam a laposomra, és i5 8300H/1050Ti kombóval is elfut 1080p/75% FRS/LOW beállításokkal 30FPS-el.

(Nem szép, inkább csúnya, de játszható. Mondjuk, nem ezen szándékozom végigjátszani. )

) -

#57018880

törölt tag

Buborék, kint olcsóbb a hardver, jobban keresnek, plusz a fizetésükből telik vizes 4090-re is, így a probléma a szemszögükből nem létezik.

vizes 7900 XTX-re már csak kb 15-20% tuning kell, + 13900K + tuning DDR5 és megvan a 60 padló fps is. ezpz

.

.Olyan grafikát mondjuk nem érdemes várni mint a Horizon, mert Starfieldben 4csillióaköbön objektum van és a hozzá tartozó draw call, és fizika reakciók stb.

Cifunak igaza van, a konzolon sem leszel előrébb. Ott is van dropolás még 30-ról is, ugyanúgy lesz ahol akadni fog. Képminőség is rosszabb. PC-n ReShaddel nagyon sokat lehet javítani szerintem pár settinggel.

Nem védeni akarom, mert szerintem sem racionális, hogy nem megy a natív 1440p 60fps egy új/friss középkategóriás gépen. AM5 R5 teteje + 7700/7800 XT AMD marketingje szerint elég kellett volna legyen erre.

-

Gondolom nem mondhatták azt hogy kend a hajadra az intel vga-d, mert nem arra fejlesztettünk és inkább azt mondták hogy sajnáljuk nem felel meg a vga-d a követelménynek. Az egy dolog hogy a 1070ti a minimum nvidia oldalon, de a 1060 ugyan az az architetktúra ugyan azt tudja csak kicsit lassabban. Lehet hogy nincs meg vele (hasamra ütök) a 60 fps minimumon, de mondjuk egy 45 kifér rajt, de attól még a fejlesztő erősebbet ajánl minimumnak.

-

akarnokd

csendes tag

Valami csúnyán el van rontva.

A770LE, 5-30 perc után crash. GTX 1060 6G, 28 óra teljesen stabil és játszható fps, pedig azon sem kellene, hogy fusson. (Mindkettőn ugyanaz a low-low beállítás.)

-

copass

veterán

konzolos szálat nem értem, amikor egy PC vga a téma!

az a szomorú hogy egy 3060-on 1080p-ben 50%-ról kell felskálázni szutyok fsr-el hogy "potato" low-on meglegyen a 60 fp.

ezzel szemben az évtized legszarabbjátékánaktituláltCP2077, megjelenéskor raytrace-el ment medium/high-ban, gtx 1060-on meg ultrán raytrace nélkül természetesen skálázásn élkül...

ez a cpu limit egy szégyen, ott ülsz egy mini atomerőműn érted...

szerencsére van egy valag mod már amivel már értelmezhetően fut, dlss, tweakek,stb. -

Csak a margóra két apróság:

1.: Konzolon egy Series S esetén 900p-ben, egy Series X esetén 1440p-ről skáláz fel, PC-n szabadon állítható ez (tehát ha akarod, akkor lehet 50 és lehet 75%-os a render felbontás a megjelenítetthez képest). A konzolokon gyengébb a háttérben generált objektumok száma, esetenként a textúrája és a fények kezelése is, ami "butább" grafikát eredményez. A konzolon mindezek mellett is 30 FPS limit van, az RTX 4080 úgy csinál 50 FPS-t is, hogy tehát magasabb felbontáson generál egy jobb minőségű, több objektumos megjelenítést.

2.: Az ugye megvan, hogy a Horizon Forbidden West úgy csinál 60 FPS-t PS5-ön Performance módban, hogy 1800p checkerboard rendert skáláz fel? Illetve hogy abban a játékban töredékét tudod megvalósítani annak, amit a Starfield nyújt? Más szóval almát körtével... -

NvidiaRTX

őstag

Ahhoz a játékhoz semmi nem elég jó.

Szánalom hogy 2023-ban egy 4080-al 50FPS (is) van egy játékban FSR-el.

Szerencse, hogy időben váltottam vissza konzolra és többet nem kell a PC minden nyűgével foglalkoznom.

De ha még valami világmegváltó grafot tenne le az asztalra a játék akkor megérteném de ennél a Horizon Forbidden West mérföldekkel szebb és folyamat 60FPS egy 180k-s konzolon.

Na mind1 szenvedjetek csak vele.

Új hozzászólás Aktív témák

- PowerColor Red Devil RX 7900 XTX Csere Kisebbre

- Asus Turbo GTX 1060 6GB értékelésre vár

- MSI GeForce RTX 3070 Ti GAMING X TRIO 8GB GDDR6X

- BESZÁMÍTÁS! XFX MERC 310 RX 7900 XTX 24GB videokártya garanciával hibátlan működéssel

- BESZÁMÍTÁS! ASRock FORMULA OC RX 6900XT 16GB videokártya garanciával hibátlan működéssel

- Creative Sound BlasterX G5 (70SB170000000) (Sound Blaster) (DAC)

- BESZÁMÍTÁS! ASUS B460M i7 10700 16GB DDR4 512GB SSD GTX 1080Ti 11GB KOLINK Observatory TG TT 600W

- 128 - Lenovo Legion 5 (16IRX9) - Intel Core i7-14650HX, RTX 4070 (ELKELT)

- Bomba ár! Dell Latitude 5310 - i5-10GEN I 16GB I 256SSD I HDMI I 13,3" FHD I Cam I W11 I Garancia!

- AKCIÓ! ASUS MAXIMUS VIII HERO Z170 chipset alaplap garanciával hibátlan működéssel

Állásajánlatok

Cég: PCMENTOR SZERVIZ KFT.

Város: Budapest

Cég: Liszt Ferenc Zeneművészeti Egyetem

Város: Budapest

Ezt régen nem full áras gameszkónak hívták hanem nagy jóindualattal open bétának

Ezt régen nem full áras gameszkónak hívták hanem nagy jóindualattal open bétának