Magok harca

Az AMD és az Intel csatája évtizedekre nyúlik vissza, és mindkét céggel előfordult már, hogy elfoglalták a processzorpiac trónját. Persze legtöbbször az AMD fut az Intel után, de az évezred elején, az Athlon 64 időszakában az Intel nem tudott mit kezdeni konkurensével, és most is egy olyan helyzet állt elő, amikor Santa Clara-i óriáscég szorult a második helyre.

Az elkövetkező évek tehát arról fognak szólni a processzorpiacon, hogy az Intel vissza tudja-e venni a teljesítménybeli trónt, és ha igen, akkor mikor. Mivel a múltat ismerjük, a jelenben pedig éppen élünk, érdemesnek tartjuk kielemezni, hogy mivel készül a két érintett a következő évekre, így talán az is körvonalazódhat, hogy az AMD-nek mely fejlesztésektől kell tartania, vagy éppen mi kell nagy versenytársának, hogy újra az élre kerüljön.

Mielőtt belekezdenénk az elemzésbe, egy picit ugorjunk vissza a múltba, méghozzá az Athlon 64 érájába, ahol az AMD totális dominanciát mutatott fel, az Intel a Netbrust architektúrára épülő Pentium 4 és Pentium D sorozattal az akkori Athlonok közelébe sem tudott kerülni. Ezután az Intel dominanciája következett, ami a lényegében az AMD FX processzorok alapját képző Bulldozer architektúrával csúcsosodott ki. Észrevehető, hogy a két cég között akkor alakult ki jelentős különbség, amikor az egyik érintett valami lényeges újítással jött elő, míg a másik alapvetően félrefejlesztett.

Utóbbi megfogalmazást persze speciálisan kezelendő, mert a koncepciót tekintve a Netburst és a Bulldozer sem volt rossz, csak az említett fejlesztések alapját az az ötlet adta, hogy ideje lenne abbahagyni a Pentium Pro CPU-ban bemutatkozó P6 mikroarchitektúra másolását. Erre jó indokuk volt a vállalatoknak, ugyanis a P6 a valóságban nem sok olyan fejlesztési lehetőséggel kecsegtet, amivel az x86/AMD64-es processzorok ideálisan tudnák tartani a lépést az alternatív processzorarchitektúrákkal, például az ARM megoldásaival, de ugyanakkor a sikerhez az is kell, hogy az alkalmazásokat az újszerű dizájnokra optimalizálják, amire nem igazán került sor sem a Netburst, sem a Bulldozer esetében. Tehát hiába látja magát a problémát az Intel és az AMD is, végül mindig visszatértek a P6 elvi alapjaihoz, így mai processzormagjaik is strukturálisan ehhez hasonlítanak leginkább.

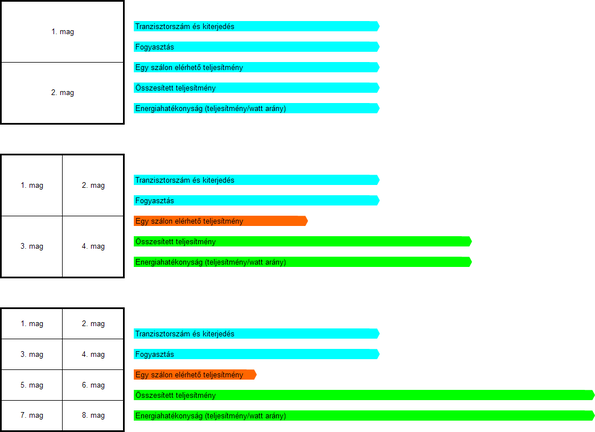

A Pollack-szabály szemléletesen [+]

Látható tehát, hogy mindkét cég megégette már magát saját, innovatívnak szánt dizájnjával, ergo a jövőben valószínűleg kétszer is meggondolják, hogy merre lépjenek tovább. Márpedig, ha a magdizájn tekintetében nem igazán lehet elszakadni a P6 alapvető vonásaitól, akkor valami olyat kell kitalálni, amivel ezzel együtt is növelhető a teljesítmény. Csúnyán fogalmazva jelenleg ez a "többmagosításban" merül ki, ami egész egyértelműen látszik a piacokon: a szerverek szegmensében durván kilőttünk magszám tekintetében, asztali szinten is egészen új magasságokat ostromlunk, és a mobil gépeken belül sem a sok évig stagnáló négy mag már a csúcs. Az irány logikus, már csak a Pollack-szabály miatt is, mivel így garantálható a leghatékonyabb energiafelhasználás, de egyéb tényezőket figyelembe véve is az extra magok beépítése az optimális döntés.

Hirdetés

Sok mag persze, de milyen mag?

A magok számának növeléséről való döntés után van még egy nagy kérdés. Milyen legyen a mag dizájnja? A túl combos nem jó, mert sok tranzisztort igényel, de a túl erőtlen sem az igazi, mert nem lesz elég jó a teljesítménye. Az AMD-nek itt volt egy egészen érdekes húzása. A Zen kódnevű fejlesztést az ideális egyensúlyra gyúrták ki. Ez a mag önmagában nem valami nagy szám, vannak benne érdekes ötletek, de alapvetően semmi forradalmival nem állt elő, egyedül arra koncentrált, hogy mi az az optimális felépítés, aminél a teljesítmény/tranzisztor arány a lehető legmagasabb lesz. Ez tehát önmagában még nem lenne elég az Intel ellen, két további tényező teszi igazán ütőképessé, a dominanciához pedig a konkurens cég aktuális problémái is kellenek.

Nem a Zen ér sokat, hanem az Infinity Fabric

Az AMD-nek egy igazán nagy húzása volt az elmúlt időszakban, ez pedig az Infinity Fabric. Ez az aktuális előny kulcsa, amit ironikus módon az Intel marketingje "ragasztónak" csúfol, de a szerverpiacra szánt, Cascade Lake-AP kódnevű csúcsprocesszoruk egy hasonló "ragasztót" használ, méghozzá UPI néven. Bármennyire is erőltetik tehát a konkurens marketingesek, hogy ez nem jó, gyakorlatilag ez az oka annak, hogy az AMD aktuális szerverplatformja teljesítményben teljesen a Xeonok fölé tudott nőni.

Felmerülhet persze, hogy miért olyan hasznos egy ilyen technológia, illetve az Intel miért nem fejlesztett hasonlót? Utóbbira egyszerűbb válaszolni: a Santa Clara-i óriáscég számos olyan megoldáson dolgozik, amelyek az egyes lapkák tokozáson történő összeköttetéséért felelnek. Ezek közül ma bevethető az UPI (Ultra Path Interconnect), aminek a hátránya, hogy nehezen skálázható, mivel egységnyi adatmozgásra vetítve viszonylag sokat fogyaszt. Maga a rendszer azonban nem rossz, de főleg tokozások közötti összeköttetésre tervezték, tehát nem optimális tokozáson belül használni, noha kétségtelenül lehetséges. A másik opciójuk az EMIB, ami már kifejezetten tokozáson belüli kapcsolatra lett kialakítva, de inkább olyanra, amikor memóriát kell egy lapka mellé helyezni, és emiatt ugyan egységnyi adatmozgásra vetítve keveset fogyaszt, de két végpont között messze nem olyan gyors, mint az UPI. Az AMD Infinity Fabric megoldása ezekkel szemben relatíve gyors, főleg az új verziója, és egységnyi adatmozgásra vetítve, teljesítményét is figyelembe véve, elég keveset fogyaszt. Utóbbi kulcstényező, mert ha ezek a linkek sok energiát igényelnek, akkor egy tokozáson belül keveset lehet alkalmazni belőlük, mivel ezek számának növelésével a processzormagok egyre kevesebb fogyasztási keretből tudnának majd dolgozni. Nem szimpla "ragasztókról" van tehát szó, jóval komplexebb megoldások készültek, illetve készülnek most is, amelyeket célirányosan érdemes tervezni az adott problémára, különben vagy a teljesítményük nem lesz elég jó, vagy a fogyasztásuk.

Az efféle technológiák hasznossága pedig megkérdőjelezhetetlen, ugyanis ilyen módon lehetővé válik a chiplet dizájn. Hogy ez miért lényeges? A gyártás miatt. Amikor egy cég tervez egy új processzormagot, azt be szeretné vetni a lehető legtöbb piacon, ami most a PC-t tekintve a mobil, az asztali és a szerver (a beágyazott piacot azért nem vesszük külön, mert oda különálló lapka sosem készül). Korábban ehhez számos lapkát kellett tervezni, mert mobil szinten az a jó, ha a processzor tokozása nem túl nagy, maga a kész chip sem túl magas, így az adott notebook platformdizájnja kicsi lehet, ettől pedig a gép vékony. Ezzel szemben asztali szinten már nem igazán tényező a tokozás mérete, nem ez fogja meghatározni az adott gép nagyságát, hanem inkább a fogyasztás, a szerverek szegmensében pedig annyira mások az igények, hogy ott aztán ha valamin nem spórolnak, akkor az a méret. El is jutottunk tehát a problémához: egy kifejlesztett mag céloz három olyan piacot, ahol az igények egészen eltérőek, ráadásul gondolni kell a gyártásra is, így jó, ha egy processzornak többféle verziója készül, amelybe fizikailag eltérő számú mag kerül.

Régebben a megoldás az volt, hogy a mobil és a szerverpiac számított a tervezésnél. Előbbi például kapott két lapkát, egy két- és egy négymagost. Ebből az utóbbi jó volt az asztali piac aljára, majd a szerverpiac leglassabb megoldása lefedte a szegmens tetejét is. Végül a szervereknél készült mondjuk három lapka. Viszont ahogy növekedett a magszám, úgy kellett egyre több lapkát tervezni, így ma már nem ritka, hogy az Intel egy generációra kiad hét-nyolc különböző processzort is. Ez az anyagiak tekintetében igen komoly gond, mert hiába van meg maga a dizájn, az adott lapka tömeggyártásának előkészítése a mai modern node-okon a dollárszázmilliókat ostromolja, és a költségek a gyártástechnológia fejlődésével csak nőnek, mert egyre drágább az új eljárások kifejlesztése. Hosszabb távon tehát nem járható út egyetlen magra ennyi eltérő lapkát tervezni.

A chiplet koncepció különböző alkalmazásai [+]

A chiplet koncepció ezen változtat, ugyanis az AMD az Infinity Fabric bevetése óta drasztikusan lecsökkentette a tervezett chipek számát. A Zen megjelenésénél készítettek egyet, amelyből össze tudtak kötni maximum négyet, tehát az asztali és a szerverpiacot egyetlen egy lapkával fedték le, miközben 32 magig tudták skálázni a rendszert.

A Zen 2-vel már ennél is tovább lépett az AMD, és terveztek két I/O hubot, egyet az asztali, egyet pedig a szerverpiacra, majd mellétették a Zen 2 chipleteket, így 8-tól 64 magig skálázódó konstrukcióval álltak elő, miközben összesen három lapkát terveztek. Ezek közül ráadásul csak egy készült 7 nm-en, maga a processzor chiplet, míg a hubok olcsóbb node-okon érkeztek.

Ez időben, költségekben és skálázhatóságban egyértelműen jobb a régi tervezési modellnél, mert a nehézségeket tekintve egy lényeges projekt fut mindig, maga a CPU chiplet. Ez ráadásul kellően kicsi kiterjedésű, vagyis hamar jó lehet a kihozatala is, így gyorsan lehet a modern gyártástechnológiákra ugrani vele. Ez ellen az Intelnek csak akkor lesz esélye, ha ugyanerre a chiplet koncepcióra váltanak át a tervezést tekintve, hiszen gyorsabb fejlesztést és jobb skálázhatóságot garantál, nem mellesleg nem égetik feleslegesen a pénzt.

A gyártástechnológia kérdése

Sajnos az előző oldal végén egy picit lelőttük a poént, hiszen amíg nem ugrik chiplet felépítésre az Intel, addig rendkívül nagy ellenszélben versenyeznek. Egyszerűen túl sok időt és erőforrást emészt fel számos, különböző méretű, de ugyanolyan alapokra épülő, ám a piac különböző szegmenseit célzó lapkára fókuszálni. Eközben az AMD csak arra koncentrál, hogy az adott évben jöjjön egyetlen egy új CPU chiplet, és ezzel le is van tudva a dolog, lehet ugrani a következő generációra, addig az aktuális sorozatot összelegózzák a többiek, mert tulajdonképpen a kisebbik processzorgyártó legót csinált a korábban rendkívül komplex tervezésből.

Mindebből elég nagy előnyt szerez az AMD a szerverpiacon, illetve az asztali szint felsőházában, de a mobil szegmens izgalmas lehet, és ebből eredően normál asztali megoldásoknál sem lefutott a verseny. Itt ugyanis még egyik cég sem alkalmaz chiplet koncepciót, vagyis egyetlen lapkában található minden a processzormagoktól kezdve az integrált grafikus vezérlőn át az egyéb komponensekig. Persze kétségtelen, hogy a chiplet ezen a területen is bevetésre kerül, viszont egyrészt itt nincs akkora előnye, mert elég szűk határok között skálázódnak a mobil piacra szánt fejlesztések, másrészt nem szükségszerű speciális összeköttetés a chipletek közé, tulajdonképpen elég a PCI Express is.

Ami egy nehezebben vizsgálható tényező, az a gyártástechnológia, ahol a TSMC nem csak felnőtt az Intelhez, hanem gyakorlatilag meg is előzték őket. Ez is hozzájárult ahhoz, hogy az AMD erősen térjen vissza, hiszen hozzáférnek a tajvani bérgyártó 7 nm-es eljárásaihoz. Az Intellel való összehasonlítást az nehezíti, hogy a Santa Clara-i óriáscég egy olyan 10 nm-es node-ot vezetett be tömeggyártás szintjén, amelynek paramétereit sosem publikálták, és manapság azt sem árulják el, hogy az ezen gyártott lapkák hány tranzisztorból állnak. Egyedül a 10 nm-es node-on készülő, Spring Hill kódnevű fejlesztés az, amelyről fellelhető pár adat: eszerint 239 mm²-es kiterjedésébe 8,5 milliárd tranzisztor került. Úgy tudjuk, hogy a WikiChip erre az információra egy inteles előadás alkalmával kérdezett rá, és így szerezték meg a paramétereket, de az Intel számunkra nem volt hajlandó megerősíteni a tranzisztorszámot, csupán a 239 mm²-es kiterjedést ismerték el. Ennek az lehet az oka, hogy a nagyobb, Spring Crest kódnevű lapka 680 mm²-be zsúfolt 27 milliárd tranzisztort, miközben a TSMC 16 nm-es eljárását használja, és ebből kiszámolható, hogy tranzisztorsűrűség tekintetében nem valami erős az Intel legjobb gyártási eljárása.

Ennyi adatból persze nem lehet általánosítani, illetve az adott gyártási eljáráson kívül még számos tényező befolyásolja a tranzisztorsűrűséget, de ha az eddig kiadott lapkákat vesszük figyelembe, akkor az Intel 10 nm-es node-ja nem igazán mutatja azt az áttörést, amit elméletben lehetne várni tőle, nem véletlen, hogy a cég a nagyobb teljesítményű lapkákhoz még ma is 14 nm-es eljárást használ. Azt nehéz meghatározni, hogy a problémák rövidtávon javíthatók-e, vagy esetleg megéri elfelejteni ezt az eljárást, és teljes erőbedobással a 7 nm-es gyártástechnológiára fókuszálni. Az eddigi tervek alapján inkább utóbbi körvonalazódik, ami nem feltétlenül rossz, elvégre ami nem működik, azt nem érdemes erőltetni.

Az AMD oldalán viszonylag egyszerű a helyzet a gyártástechnológiát tekintve. A cég csak úszik a TSMC fejlesztéseivel, így az aktuális 7 nm-es eljárást hamarosan leváltják az EUV-s verzióval, majd később jöhet az 5, esetleg 6 nm-es node. A vállalat az utóbbi időben azt hangsúlyozza, hogy mindig a legmodernebb eljárásra ugranának, tehát valószínű, hogy a következő lépcső az 5 nm-es EUV opció lesz.

Szerverpiaci termékek

Ahogy korábban említettük, az AMD és az Intel az asztali piacra direkten nem fejleszt, tehát egy lapka leginkább szerver vagy mobil fókuszú, és az asztali piacot ezekkel töltik fel. Persze speciális helyzetek előfordulhatnak, de ezek sokszor kényszer szülte megoldások.

Az aktuális útitervek alapján a szerverpiac tűnik a legkevésbé izgalmasnak. Az AMD jövőre a Zen 3 CPU chipletet hozza a TSMC 7 nm-es EUV node-ján, és elképzelhető, hogy terveznek mellé új IO hubokat, amelyek extra funkciókon kívül többet nem feltétlenül fognak kínálni. Ilyen formában a Milan kódnevű fejlesztés eléggé hasonlítani fog az idén bemutatott Rome platformra. A foglalat megmarad, ahogy az elérhető interfészek, valamint azok száma sem változik, továbbá már az is tudható, hogy maga a chiplet is marad nyolcmagos. Az L3 gyorsítótár viszont nagyobb lesz, továbbá a magok összeköttetésének kialakítása is módosul.

Ez ellen az Intel a 14 nm-en készülő Cooper Lake-SP-t és a 10 nm-re alapozó Ice Lake-SP-t veti be, melyeket már a nyáron lelepleztek, de csak jövőre érkeznek. Utóbbi végre hozza a PCI Express 4.0-t, amit az Intel szerverplatformjai még ma sem támogatnak, ezzel ledolgoz a cég egy elég nagy technológiai hátrányt, míg a Cooper Lake leginkább a bfloat16 adattípus natív támogatására fókuszál. Utóbbi tényleg hasznos a gépi tanulás tréning szakaszához, és az AMD Milan platformja erre nem figyel. Ez egy lényeges szempont, mert teljesítmény/fogyasztás arányban nem sok esélye lesz az Intel megoldásainak, de egy-két speciális képességgel célozhatnak olyan területeket, amiket az AMD még nem tart különösen fontosnak.

A következő körben még lényeges kérdés lesz, hogy nő-e a szerverprocesszorok fogyasztása. Az Intel 300-400 watt közé tervezi Cooper Lake-SP csúcsmegoldásait, míg az AMD ugyan követhetné őket ebben, de a cégtől korábban megtudtuk, hogy 300 watt az a felső határ, amelyen belül még épphogy eladhatók a mai termékek, így az energiaigény növelésében nem fognak az Intel után menni. Azt nehéz meghatározni, hogy melyik cégnek van igaza, de az Intelnek ma is létezik 350 és 400 wattot fogyasztó szerverprocesszora Cascade Lake-AP kódnéven, és nem kapkodnak érte a gyártók, tehát valószínűleg van egy olyan maximum érték, aminél már nem lehet megfelelően fenntartani a szervert.

Jövőre tehát sok változás nem várható a szerverpiacon, de 2021-ben már lehet erre számítani, ugyanis ekkorra ígéri az AMD a Genoa platformot, amely a Zen 4 processzormag mellett új alapokra építkezik, tehát jön a DDR5 támogatása, illetve valószínűleg egyéb fejlesztések is érkeznek, a gyártástechnológiai hátteret pedig minden bizonnyal a TSMC 5 nm-es eljárás biztosítja majd. Emiatt ez lehet az a generáció, amelynél a tokozásonkénti magszám tovább nőhet.

A 2021-es év azért is hozhat izgalmakat, mert ekkorra ígéri az Intel a Sapphire Rapids kódnevű fejlesztést, amelynek esélye lehet felvenni a versenyt az AMD-vel. Ez előreláthatólag már a cég új, 7 nm-es node-ját használja, szintén új foglalatot vet be, illetve a DDR5 támogatása is megoldott lesz, várhatóan egyéb előrelépések mellett. A 7 nm-es eljárás itt is lehetővé teszi a magok számának tokozásonkénti növelését.

A további tervekről sajnos elég keveset tudni. Mivel a 2021-es év szól mindkét gyártónál a platformbeli alapok leváltásáról, így nem nehéz összerakni azt, hogy a későbbi dizájn a továbbfejlesztésre fog fókuszálni. Ebből a szempontból az Intel a Granite Rapids megoldással készül, míg az AMD boszorkánykonyhájából a Turin kódnev visszhangzik ki, de utóbbi erősen pletykaszintű információ. Mivel ezek még elég messze vannak, így képességeiket is homály fedi.

A mobil szegmens megoldásai

A mobil piacon az AMD útiterve eléggé egyszerűnek tűnik: heteken belül érkezik a Renoir kódnevű SoC APU, amely 7 nm-es node-on készül, a lapkába pedig – az aktuális híresztelések szerint – 8 darab Zen 2 processzormag, valamint 13 darab multiprocesszort használó, Vega architektúrára épülő IGP kerül. A különböző fogyasztási szintre tervezett modellek ezekből eltérő mennyiséget tartalmazhatnak, de ez megszokott dolognak számít.

A Renoir ellen az Intel nem egy, nem is kettő, hanem rögtön három fejlesztéssel készül. Ez ugyan logikátlannak tűnik, mégis van benne ráció, ugyanis az egyes platformok eltérő területen jók igazán. Itt nagyon lényeges, hogy amíg az AMD-nek ott van a 7 nm előnye, addig az Intel ezzel nem rendelkezik, tehát muszáj az egyes területekre célirányosan terveznie a lapkákat, hogy ezt a hátrányt ledolgozzák, vagy legalább csökkentsék.

A jelenleg is elérhető, 14 nm-es, Comet Lake kódnevű mobil megoldások a következő év tavaszán kapnak egy frissítést, és ezek továbbra is a processzorerőre fókuszálnak, vagyis az IGP teljesítményét áldozzák fel a minél magasabb órajel érdekében. A 10 nm-es Tiger Lake az aktuális Ice Lake utódja, vagyis leginkább az IGP-re épít, és inkább a processzor alapórajelét helyezi háttérbe, a fogyasztás viszont elég alacsony lesz, így a nagyon vékony notebookokba kerülhet, a megjelenését pedig a következő évi Computexre időzítik. Valós újdonság lesz még a 14 nm-es Rocket Lake, ami egyszerűen fogalmazva egy kiegyensúlyozott rendszer, tehát se a processzorrész, se az IGP nem kiemelkedő, de mindkettő elég gyors, így a többségnek érdemes ezt választania. Ez a fejlesztés jövő ősszel érkezik. Érdekes pletyka még, hogy a Tiger és a Rocket Lake nem egy lapka, hanem külön van a processzor, illetve a grafikus vezérlő, így elképzelhető, hogy egy éven belül a gyakorlatban is láthatjuk majd az Intel chiplet koncepcióját.

Említést érdemel egyébként az Intel Lakefield kódnevű fejlesztése, amelyhez hasonlót az AMD még nem mutatott be, tehát ezen a szinten egyelőre úgy tűnik, hogy elmarad a verseny. Ugyanakkor utóbbi hiányában is elmondható, hogy a Lakefield messze ígéretesebbnek hangzik az Intel összes többi ismert mobil fejlesztésénél, tehát nagyon is érdemes figyelni rá, hiszen olyan innovatív újításokat vezet be, amelyeket régóta hiányolt erről a területről az iparág.

Tovább haladva az Intel útiterve eléggé ködös, de egy 10 nm-en készülő, Alder Lake kódnevű rendszerről lehet hallani. Persze az AMD sem ontja a gyártók felé a részleteket, utóbbi céggel kapcsolatban annyit tudni, hogy a Renoirt a Van Gogh kódnevű fejlesztés váltja, amelyben a grafikus vezérlő már valamilyen RDNA architektúrára fog épülni.

Asztali fejlesztések

Szándékosan helyeztük a szerver és a mobil szegmenst az asztali elé, ugyanis így egyszerűbben áttekinthető az utóbbi terület. Az AMD szempontjából mindenképpen, hiszen ahogy említettük, a cég nagyrészt legózik. 2020-ban az asztali szint alját a mobilból érkező Renoir tölti majd ki, míg a termékskála tetejét a Milan platformhoz fejlesztett Zen 3 CPU chiplet adja.

Nagyon nagy meglepetésekre ne számítson senki, ugyanis marad a Socket AM4-es foglalat, ebbe beépíthető a Renoir, illetve a meglévő IO hub mellé egy vagy két Zen 3 CPU chiplet, a HEDT piacra pedig szokás szerint jöhet az új EPYC-ből származtatott Ryzen Threadripper. Nagyjából ennyi, és megint azt látjuk, hogy két új lapkával le is fedték az egész piacot, méghozzá 64 magig skálázható módon.

Az Intel esetében máshova kerül a fókusz. A céget sokkal jobban érdeklik a mobilba és a szerverekbe szánt CPU-k, ami nem csoda, innen jön a pénz. Asztali szinten inkább 14 nm-es fejlesztések érkeznek. A HEDT szegmens, vagyis a nagyteljesítményű PC-k esetében az aktuális Cascade Lake-X generáció frissítéseire érdemes számítani, nagyjából jövő ősszel. Ezek sajnos most sem versenyképesek a harmadik generációs Ryzen Threadripperekkel, nem véletlenül vannak alájuk árazva, így jövőre sem lesz jobb a helyzetük a Zen 3-as magokkal dolgozó verziók ellen. Azért megjegyezzük, hogy a Cascade Lake-X az aktuális listaárakon egész jó ajánlat, addig érdemes befizetni rá, amíg megvásárolható, persze azok számára, akik eleve érdekeltek ezen a teljesítményszinten. Ha ennél jobb kell, és csak az Intel jöhet szóba, akkor a 2021-es évet érdemes figyelni, ugyanis az utóbbi hetekben felmerült az a pletyka, hogy az Ice Lake-SP kap majd HEDT verziót, de ennek megjelenése még nagyjából két évnyire van.

A normál asztali platformot tekintve az Intel új foglalatot vezet be jövőre (LGA1200) és ebbe érkezik a 14 nm-es Comet Lake, amely 4, 6, 8 és 10 magot fog kínálni. Sajnos így nem igazán dolgoztatják meg az AMD-t, hiszen a cégnek már most is van 16 magos asztali processzora, és jövőre is tudnak ilyet hozni a Zen 3-ra építve.

A 2021-es esztendő talán hozhat valami felfrissülést. Az Intel ekkorra még mindig 14 nm-es processzorral készül, méghozzá a Rocket Lake kódnevűvel, amelyből már 12 magos lesz a csúcs, de kompatibilis lesz az LGA1200-as alaplapokkal. A nagy kérdés, hogy az AMD mit fog tenni, ugyanis a cég egyik útitervében sincs benne az asztali piac ilyen távlaton belül. Két opció lehetséges: maradhat a Socket AM4, és akkor lesz a Zen 3-nak egy frissítése, de akár jöhet a platformváltás, amivel bemutatkozhat a Zen 4, méghozzá egy új tokozással, a DDR5 támogatásával, várhatóan 5 nm-es node-on. Valószínűleg attól függhet az AMD döntése, hogy a DDR5-ös memóriák árazása mennyire gyorsan tud megfizethető szintre csökkeni. Persze az első DDR5-ös asztali rendszer címe csábító lehet, de ezt úgy is meg tudják szerezni, ha a szerverekbe szánt Genoa platformból készítenek Ryzen Threadripper verziót.

A jelenlegi adatok szerint az asztali piacon a 2022-es esztendő vége lehet izgalmas, ugyanis ekkor érkezik a Meteor Lake, amely az Intel nem szerverekbe szánt, 7 nm-es node-on készülő fejlesztése. Sajnos nagyon keveset lehet tudni róla, de legalább nem egy 14 nm-es frissítésről van szó, ami végre bizakodásra ad okot.

Nagyjából ennyit tudtunk összegyűjteni az Intel és az AMD következő éveiről, kiemelten figyelve arra, hogy a gyártóknak leadott útitervekben valóban szereplő megoldásokról számoljunk be. Ettől persze változhat még a helyzet, hiszen az érintettek viszonylag sokat csúsztatják az egyes fejlesztések tervezett megjelenését, akár törölni is szokták ezeket. Az mindenesetre látszik, hogy a mobil piac érdekes marad jövőre is, a szerver és az asztali szegmens tekintetében viszont viszonylag sokat kell majd várni a nagyobb harcokra, főleg a nagyobb teljesítményszinteken.

Abu85