Hirdetés

-

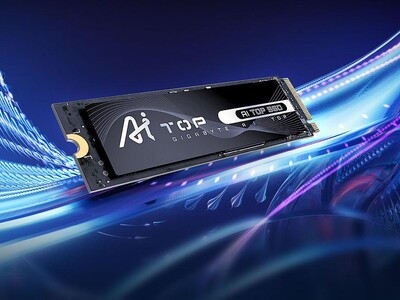

Rekordokat döntöget a Gigabyte új SSD-jének terhelhetősége

ph Az új AI TOP 100E szériás tároló 2 TB-os modellje például 219 000 TBW értékkel rendelkezik.

-

Az USA tisztifőorvosa figyelmeztető címkét ragasztana a közösségi médiára

it Figyelmeztető címkéket szeretne látni az USA tisztifőorvosa a közösségi médiában, ami főleg a serdülők számára lenne emlékeztető a platformok súlyosan káros hatásairól.

-

Európában is kapható az Oppo Reno 12 és Pro testvére

ma A kínai verziókhoz képest változtattak itt-ott, június 25-től 500 eurós áron indul az értékesítés.

-

PROHARDVER!

A legtöbb kérdésre (igen, talán arra is amit éppen feltenni készülsz) már jó eséllyel megtalálható a válasz valahol a topikban. Mielőtt írnál, lapozz vagy tekerj kicsit visszább, és/vagy használd bátran a keresőt a kérdésed kulcsszavaival!

Új hozzászólás Aktív témák

-

Abu85

HÁZIGAZDA

válasz

subpixels

#10557

üzenetére

subpixels

#10557

üzenetére

Egyelőre csak Tesla és Quadro formályában szerepel a roadmapon.

A compute szempontjából egyébként a GK110 sem sokkal különb. Az L1 gyorsítótár szervezése és sebessége változatlan, vagyis az LDS teljesítmény nem módosult. Ami extra az egy 48 kB-os csak olvasható gyorsítótár, amibe a fejlesztők adatokat helyezhetnek, hogy azokat gyorsan el lehessen érni. Ezt azonban direkten kell csinálni, vagyis, ha a programban nem figyel erre a programozó, akkor sok haszna nem lesz. HPC-ben nyilván figyelni fognak rá, hiszen a CUDA így fog fejlődni, de PC-ben ennek sok haszna nem lenne.[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

Löncsi

#10623

üzenetére

Löncsi

#10623

üzenetére

Ja persze a következő 3 évben. Maradjunk annyiban, hogy a ray-tracing majd az évtized vége felé lehet opció a kliensgépeken. A felhőben van hozzá teljesítmény, csak nem hiszem, hogy anyagilag megtérülne egy olyan szerver fenntartása, ami egy userhez ekkora naftát rendel.

Azért a felhő ígérete átalakult már. Régen az unlimited power volt a kulcs ehhez. Ma sem tagadják, hogy ez lehetséges, és elméletben nyilván nem lehetetlen, csak a szerver beépítési és fenntartási költségét ki kell gazdálkodni. Ergo olyan hardvert kell választani, ami arányaiban a leggazdaságosabban képes működni. A játék grafikáját hozzá lehet butítani. A felhő már kinőtt a mézesmázos ígéretekből. A realitás az, hogy semmi sem fut max. grafikán ezeknél a szolgáltatásoknál ... unlimited power ide vagy oda.

Ez olyan, mint a Samaritan demó. Ez lesz a jövő! Persze elméletben lehetséges, hiszen a hardver ereje adott. De ki az aki három évet adnak a művészeknek egy utcarész kidolgozására? Ki az aki így finanszírozni tud egy teljes játékteret anyagilag?

Teljesen világos, hogy a mai PC-s hardverek sokkal többet tudnak, mint amit látsz egy játékban. A gond, hogy senki sem finanszírozza azt a művészi munkát, ami azzal járna, hogy kihozzák a rendszerek valódi erejét. És a realitás az, hogy a jövőben sem fogják finanszírozni. Az erre szánt anyagi befektetések nem fognak növekedni.[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

A VGA-piac senkit sem érdekel. Egy alacsony nyereséghányaddal rendelkező, folyamatosan szűkülő szegmensről van szó. Ide fejleszteni nem éri meg. Sem a GCN, sem pedig a Kepler esetében nem figyelték a mérnökök, hogy a VGA-piacnak mi lenne a jó. Ez mindkét architektúrán látszik, ugyanis a GCN brutál hatékony compute-ban, míg a Kepler hatékonysága a DX11-es architektúrák között az eddigi legrosszabb, vagyis az előző generációhoz képest visszalépés. A VGA-piac számára az ideális szint a kettő között lenne, de mivel egyik cég számára sem érdek egy folyamatosan szűkülő szegmensre fejleszteni, így a növekvő piacok kerültek előtérbe. Az AMD-nél az APU-k, míg az NV-nél a Tegra. Ha ezeket figyelembe veszed, akkor rögtön világossá válik, hogy a GCN architektúra, miért néz ki úgy, mint egy vektortömbökkel felturbózott RISC processzor, és az is világossá válik, hogy miért tervezték úgy az architektúrát, hogy kezelje azokat a pointereket, amiket az AMD64-es processzorok kezelnek. Egy VGA-nál egyiknek sincs haszna, de ha bekerül a proci mellé, akkor máris kész az egész heterogén éra következő nagyobb lépcsőfoka (lásd Kaveri APU). Szintén be lehet hozni a Tegrát a képbe az NV-nél. Ugyan miért lenne értelme akkor harmadolni az LDS teljesítményt, amikor egyre több a Compute a játékokban, és jön a DX 11.1, ami közvetlenül nem, de közvetve számít, ugyanis a Windows 8 az új API-ban pont azért hoz be egy shader-trace interface-t, mert a fejlesztők szerint a DirectX 11-ben nagyon nehézkes a bonyolult DirectCompute programok teljesítményének kielemzése, ezért nem képesek egy bizonyos szintnél bonyolultabb programokat írni, mert túl lassú lesz, és követhetetlen, hogy hol kellene rajta optimalizálni. A shader-trace interface ezen segít, így a fejlesztők sokkal komplexebb DirectCompute programokat írhatnak, amire már egy ideje igény mutatkozik. Ez egyébként DX11 alatt is működik, hiszen shader-trace interface, csak magát a DX 11.1-es API-t követeli, de a DX11.1-es hardvert már nem. És akkor fel lehet tenni a kérdést, hogy vajon miért futott át az NVIDIA agyán, hogy na most aztán letörjük a Kepler képességeit compute-ban, hiszen a fejlesztők most kezdik majd igazán kihasználni a DirectCompute lehetőségeit. Ez egy elég rossz időzítés volt. És, ha valami ezt jelzi, akkor az az, hogy a Kepler megjelenése óta 5 DX11 játékből négy erősen épít a compute kepésségekére. A GeForce GTX 680 teljesítménye erősen függ a játéktól, de egyikben sem képes már megverni a HD 7970-et, sőt inkább a HD 7950 ellen megy, de van két játék, ahol a HD 7870 válik ellenféllé, és egy játékban a HD 7850 is megközelíti. Pont az az egy játék fejti ki az eddigi legnagyobb compute terhelést. Ennek csak akkor van értelme, ha a Tegrát is számításba vesszük. Mivel ez egy ultramobil fejlesztés, így nem kell hozzá nagyon nagy compute hatékonyság. Ezzel jelentős tranyóbudgetet lehet megspórolni. A Kepler tehát azokkal a megszorításokkal, amiket az NV bevezetett, pont ideális az új Tegrákba.

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

KillerKollar

#10632

üzenetére

KillerKollar

#10632

üzenetére

Ne ragadj ki részletet a szövegből! Vagy, ha mégis megteszed, akkor nagyobb részletet rakj hozzá, mert elveszti az értelmét, illetve más lesz a jelentése. "... a Kepler megjelenése óta 5 DX11 játékből négy erősen épít a compute kepésségekére." - Ez a fontos részlet jelen esetben. A Kepler megjelenése óta 5 darab új DX11-es játék jött ki. Ebből négy erősen épít a compute képességekre. Annyira, amennyire eddig semmi. A kiragadott mondat erről a négy játékról ír. Ha csak a mondatot értelmezed, akkor teljesen rossz következtetést vonsz majd le, mert kiragadtad a szövegkörnyezetéből.

Próbáld meg úgy értelmezni az egészet, ahogy a szövegkörnyezetben van. Teljesen más lesz az egész írás értelme. Jelen esetben ugye arról van szó, hogy mivel magyarázható az, hogy az NVIDIA pont most visszalépet a compute hatékonyság területén, amikor kapásból jött négy olyan játék, ami erre gyúr. Ez a nagy kérdés, és szerintem ez a Tegrával magyarázható. Más logikus érvet nem tudok mellette felhozni. De nem pont a négy játék miatt, hanem a shader-trace interface is a DirectCompute erősebb felhasználását segíti elő. Az tisztán látszik, hogy a fejlesztés iránya logikátlan, mivel ellentétes azzal, amerre a szoftverek és az API-k mennek. Viszont biztos van magyarázata.Általánosságban a hsz-em teljesen értelmetlen. Ne is értelmezd úgy.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

KillerKollar

#10634

üzenetére

KillerKollar

#10634

üzenetére

Így már érthető, miért nem nem értetted, amit írtam. Semmi gond amúgy, de komolyabb leosztás helyet kérdezhetsz is.

Tehát a Kepler megjelenése után 5 DX11-es játék jött ki. Most nem sorrendben, de Max Payne 3, Nexuiz, Sniper Elite v2, DiRT Showdown és Ghost Recon Future Soldier. A MAx Payne 3 esetében gondolom az NV időben szólt, hogy ne izmozzák agyon a DirectCompute fícsőröket, mert a Kepler nem lesz benne jó. A többi négy játékban ez elmaradhatott. A Nexuiz, Sniper Elite v2 nagyjából Metro 2033 és AVP eredményeket hoz, vagyis a GTX 680 a HD 7950 körül van. A Ghost Recon Future Soldier esetében a GTX 680 a HD 7870 és a HD 7950 közé szorul. Ezt főleg a valós idejű globális illumináció bekapcsolása okozza. A DiRT Showdown compute terhelése jelenleg a legnagyobb, így a GTX 680 a HD 7850 és HD 7870 között van. Ezt főleg a forward+ lighting modell és az ezzel implementált globális illumináció okozza.Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

Löncsi

#10637

üzenetére

Löncsi

#10637

üzenetére

A BF3 esetében Repi hamarabb megtudhatta, hogy nem lesz erős a Kepler LDS teljesítménye. Éppen ezért a megjelenésre nem teljesen olyan lett a kód, amit a GDC-n előirányzott. A HDAO-t a HBAO váltotta. Ez rosszabb minőséget ad, de nem terheli az LDS-t. Sima FXAA lett SRAA-val irányított, DirectCompute 5.0-ban implementált MLAA helyett is. Ez szintén az LDS terhelés miatt lett kivéve, pedig minőségében ez volt előrébb. Valószínűleg az volt itt a gond, hogy Repi nem tudta pontosan, hogy mekkorát herél az NVIDIA. Mivel a Frostbite 2 tile-based deferred acceleration technikája LDS-re épül, így ennek van egy minimum igénye ebből a szempontból. Na most, úgy túlterhelni az LDS-t, hogy a motor alapját képző technika is erre épít, hát nem célszerű. Most, hogy látják, hogy mi lett a Keplerből, elő lehet venni a kérdést újra, és a gyakorlatban is meg lehet nézni, hogy mennyire lehet megterhelni.

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

Löncsi

#10640

üzenetére

Löncsi

#10640

üzenetére

Ez nem teljesen ilyen egyszerű.

A Frostbite 2 motor úgy használja/használta az LDS-t, ahogy eddig még semmi. Ez roppant kockázatos volt eleve, de ott voltak az eddigi termékek a gyakorlati tesztekhez. Na most nyilván volt erről koncepció, hogy hogyan lehet ezt úgy terhelni, hogy az ne jelentsen problémát a motor működése szempontjából. Az eddigi DX11-es rendszerek LDS teljesítménye nem volt kisebb 0,6 bájt/FLOP-nál. Logikus volt tehát, hogy ha erre rátervezik, akkor az jó lesz mindegyikre. Ha gyorsabb az meg nem baj. Ilyenkor jöhetett az, hogy a Kepler meglepetésre 0,33 bájt/FLOP-ot tud, vagyis az eddigi tervekhez képest nem 0,6-ra, hanem 0,33-ra kell tervezni. Mivel gyakorlatban nem volt tesztlehetőség a BF3 megjelenése előtt, így maradt egy eléggé drasztikus lépés, vagyis kivenni/kicserélni minden olyan extra effektet, ami LDS-t használ. Gyakorlati tesztlehetőség nélkül én is így döntöttem volna. Ma már lehet, hogy másképp döntenének, hiszen ki tudják próbálni, de a játék kiadása előtt ezt nem tudták megtenni.[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

Nem holnap dől ez be, még úgy két év a gyártók szerint lesz benne. Azt senki sem várja, hogy egészséges két év lesz. 2015 után már úgy gondolják az OEM-ek, hogy a high end szint marad csak meg.

A VGA-piac bedőlését egyébként az is jelzi, hogy az AMD az év közepére letett ennek a szegmensnek a jövőjéről. A gyártóktól tudom, hogy ők voltak a legnagyobb támogatói a dedikált VGA-nak eddig, és a HSA-t is ki akarták terjeszteni VGA-kra. Ma már ez a terv nem szerepet a roadmapon. A Compal szerint azért gondolták meg magukat, mert 2014-re úgy saccolják, hogy a VGA-piac 70%-kal lesz kisebb. A fennmaradt rész gyakorlatilag a teljes GPU-piac 9-10%-a lesz, ami annyira pici, hogy nem érdemes a HSA-t ilyen irányba fejleszteni. Nyilván, ha feltételezzük, hogy fennmarad a mostani ~55-45%-hoz körüli NV-AMD részesedés, akkor 5-4% jut egy-egy cégnek. Szóval a piaci részesedés többségét az NV és az AMD az IGP-ből szerzi majd.

Természetesen a GPU fejlesztések számítanak, hiszen a integrált grafikus vezérlők piaca óriási marad. Ezek gyakorlatilag GPU-k, csak nem dedikáltak. Így természetes, hogy rengeteg grafikai irányú fejlesztés van. Ráadásul az IGP-ken a nyereség jóval nagyobb.

Ami pénz van ebben a piacban az nudli már ma is. Nyilván a szűkölés, generációról-generációra folyamatosan eszközölt áremeléssel egyensúlyban tartható, de ez a folyamat öngerjesztő is, vagyis az a szűkülés, amit 2011-ben egy általános visszaesés okoz a Q2 óta, az 2012-ben rányomta a bélyeget az új generáció árazására. Ez újabb szűkülést jelent, mert egyre drágábbak a termékek. Szerencsére még a korábbi generáció hozza az eladásokat, de ezek idővel elfogynak. Akkor már csak új generáció lesz jóval drágábban, mint azt eddig megvehetted.Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

tombar

#10645

üzenetére

tombar

#10645

üzenetére

Nem tehetnek mást, próbálják úgy alakítani az árakat, hogy az számukra megérje. Az olcsó árcédula veszteséget okoz.

Gyakorlatilag, csak a high-end rész fennmaradása 2015-ben már a vég. Nyilván idővel ez is el fog tűnni teljesen, szóval az NV a 2016-2017-es jóslatával reálisan gondolkodik. De azért öt évre nehéz ezt előre megállapítani. Az még talán segíthet, ha a gyártók platformhoz kötnek szolgáltatásokat. Ergo csak akkor kapsz meg minden funkciót egy VGA-tól, ha a vásárolt APU is a dGPU gyártójától származik. Ez abból a szempontból jó, hogy a dGPU-t vásárló réteget megpróbálják a nagy nyereséget termelő APU-kra kényszeríteni, ami összességében kedvező anyagilag.Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

Löncsi

#10647

üzenetére

Löncsi

#10647

üzenetére

Ez teljesen reális gondolkodás mód, egy profitorientált cégtől. Ha akarod az összes funkciót építs platformot.

(#10648) Egon: A másik fórumon nem a WinZipről és a VLC-ről volt szó, hanem arról, hogy az Intelnek támogatnia kellene a szoftverfejlesztéseket, hogy működjenek azok az extrák az OpenCL programoknál, amiket az AMD jelenleg megkap. A trollkodást másra hagytuk, teljesen normális volt a vita.

A grafikus részleg valójában sokkal többet termel az AMD-nek, mert a külön részleg csak a VGA-kat nézi, ami arányaiban kisebb, mint amit az IGP-ből termelnek. Ráadásul benne van a konzolokból szerzett pénz. Az is fontos, hogy a nettó profit az nem teljesen származtatható egy részleg operatív nyereségével.

Nem tudom, hogy észrevetted-e, de a PH-n lassan két éve nincs beszámoló a cégek negyedéves eredményéről. Erre van az IT Cafe.[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

A jövőkép mindig csak lehetséges. Ellenben az már látszik, hogy mindenki egységesen látja, vagyis azt már nyugodtan ki lehet jelenteni, hogy az összes gyártó a GPU integrációban látja a Dennard scaling megszűnésére a megoldást. Ha egy gyártó nem így látná, akkor megkérdőjelezhető lenne az APU sikere, de jövőre már az asztali szintre sem lesz kiadva olyan új processzor, ami nem tartalmaz IGP-t. Ezzel az APU lényegében az egyetlen megoldást, amit vásárolni lehet.

Az NVIDIA elképzelése is megegyezik a többiekével. Koncepcionálisan tehát biztos nem lesz probléma a Maxwell APU-val. A teljesítményt pedig nem érdemes találgatni, mert az sok dologtól függ.

Ma a PC gaming nem úgy virágzik, mint régen. A Casual rétegnek szánt játékok törtek előre a hardcore helyett. Jó példa a Zynga sikere.Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

Löncsi

#10653

üzenetére

Löncsi

#10653

üzenetére

Az csak egy nagyon szimpla extra. Ami nagyobb dolog az a Steady Video, amit tiltanak, ha Intel processzor van a Radeon mellett, de ez is csak egy apró dolog. Ennél sokkal durvább limitációkat lehet szabni.

Az NV-nél például a PhysX-et platformhoz lehet kötni. Ha piacot akarnak szerezni, akkor muszáj agresszív formában fellépni ebből a szempontból.

Az AMD-nek a HSA volt a terv, mivel annak lett volna VGA-ra is kiterjesztése, de nyilván csak platformszinten működött volna. Ma ez lekerült a roadmapról.

Állandó kérdés, hogy mennyire éri meg mesterségesen életben tartani egy piacot, mert a funkciók platformhoz kötése ezt tenné lényegében. Emellett ott van az a gond is, hogy mennyire éri meg az Intel APU-s réteggel kibabrálni. Ők is fizettek a VGA-ért, vagyis elvárhatják, hogy a terméktámogatás legyen annyira korrekt, amennyire csak lehet platform nélkül. Szóval egyelőre a gyártók sem látnak tisztán. Az látszik, hogy keresik a lehetséges megoldásokat.Rövidtávon a casual réteg átáll az APU-ra. Nekik ennél több nem kell. A dGPU fennmarad a hardcore rétegnek. Esetleg a DX11.1-es API képes érdekes dolgokra, így meg lehet osztani feladatokat az IGP-n és a GPU-n. Ez egy kihasználható terület, ha már úgyis ott van az IGP a prociban. Emellett az Eidos PC-s portjait készítő Nixxess már vázolta, hogy miket lehet csinálni APU-val. Amellett, hogy a dGPU elvégzi a szokásos számításokat az IGP-re ki lehet osztani a fizika egyes részeit, az AI számítását, a sortingot és a culling is nagyon fekszik neki. Ezeknek ma tipikusan az a problémája, hogy a DX API késleltetése eléggé nagy, de C++ AMP-vel vagy OpenCL-lel már elég kedvező a helyzet. HSA-t bevetve pedig tovább javítható ez. Legtöbbet a cullingon lehet nyerni, de ott azért még gond, hogy az OpenCL és a C++ AMP sem definiál grafikus futószalagot, szóval ezt meg kell írni.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

Löncsi

#10660

üzenetére

Löncsi

#10660

üzenetére

Egy működő futószalagot nem olyan nagy kunszt megírni. Persze időbe telik, de abszolút nem lehetetlen. A hatékonyság a probléma, ott már nem mindegy, hogy milyet írsz. A Nixxess viszont pozitívnak tartja, hogy ezzel együtt is sokkal gyorsabb lehet a HSA-ra írt culling a tisztán CPU-snál. Ha definiálnak egy hatékony futószalagot, akkor még jobb lehet a sebesség.

Nem kell speciális driver hozzá. Azt az API-t kell támogatni, amiben a futószalagot írta a fejlesztő (C++ AMD, vagy OpenCL). Onnantól kezdve működnie kell.[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

Löncsi

#10666

üzenetére

Löncsi

#10666

üzenetére

Az még logikus. A 2 GB nem logikus 192 bites busszal. Ha ez lesz, akkor az nem jó. Én elhiszem, hogy a vásárlóbázis a gigabájtokra élvez, de sebességben rosszabb, mint a 1,5 GB, hiszen flex a memóriavezérlés. Helyenként úgy fog viselkedni a kártya, mintha 128 bites lenne.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

Löncsi

#10670

üzenetére

Löncsi

#10670

üzenetére

Ez úgy működik, mint a processzorok esetben, ha mondjuk három modult raksz bele. A Dual Channel módban működőt párost dolgoztatja, amíg ki nem fogy a memóriából a rendszer. Ezután hozzányúl a harmadik modulhoz. Ez a Flex vezérlési mód.

Ugyanez megy VGA-nál is. Lesz egy 128 bites módban elérhető memóriapartíció és egy 64 bites. Amíg ki nem fogy a 128 biten elérhető 1 GB, addig nem fog hozzányúlni a 64 biten elérhető 1 GB-hoz.[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

Löncsi

#10673

üzenetére

Löncsi

#10673

üzenetére

Pontosan csak az NV tudja. De logikus a Flex mód, mert más elképzelés erre nincs. A GTX 550-ból ki lehet indulni, és az nem jelent sok jót. De amúgy is csak pletyka. Mindenesetre a 2 GB a lehetséges opciók közül a legrosszabb választás. Ha már nagy a memóriafetis, akkor legyen 3, és nem kell flex vezérlés.

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

matteo_szg

#10675

üzenetére

matteo_szg

#10675

üzenetére

Az ASUS dobjon rá +1 GB-ot és megegyeztünk.

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

Amikor a GTX 550 megjelent, akkor kérdeztem meg a PoW-ot. Ők mondták, hogy Flex vezérlést használ, vagyis először a nagyobb sávszélességgel elért memóriát tölti fel, majd ha az elfogy, akkor a maradékot.

[link] - itt leírtam. Ha ugyanezt alkalmazzák, akkor 128+64 bites lesz a termék, és nem 192 bites. Én inkább 1,5 vagy 3 GB-ot választanék 192 bit mellé. Gondolom a 3 GB az ár miatt került ki, míg a 1,5 GB nem hangzik jól, de kit érdekel, ha gyorsabb. Ha a svéd oldal paraméterei igazak, akkor olyasmi lesz a helyzet, mint a GTX 550-nél. Lesz ahol elég jó lesz a teljesítmény, és lesz ahol bedől. Valószínűleg lesz egy szigorú review guide, ahol az NV kiválasztja azokat a helyzeteket, ahol ez a vezérlés nem dől be. Persze remélhetőleg a svédek félrehallottak valamit.[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

tombar

#10687

üzenetére

tombar

#10687

üzenetére

Igen. Tulajdonképpen jól érted. Feltételezve azt, hogy a svéd oldal paraméterei helytállóak, akkor a 660 így fog működni:

Az egységes mód 1,5 GB memóriát használhat 144 GB/s-os sávszéllel. Ha ez elfogy, akkor a kiterjesztett mód lép érvénybe és a maradék csatornáról is felhasználható 0,5 GB memória. Ezt 48 GB/s-os sávszéllel lehet elérni. Tulajdonképen addig nincs nagy baj, amíg ki nem fut a program a 1,5 GB-ból. Ha megtörténik, akkor a teljesítmény bedől.[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

Technikai előny sosem fog bebizonyosodni vagy cáfolódni. Ez szimplán csak létezik. Az a kérdés, hogy hány játékot fejlesztenek erős compute terhelésre. Olyanra, mint a DiRT Showdown annyira nem számítanék. A Codemasters nyilván beépítette az EGO motorba, így innentől kezdve valszeg mindegyik EGO játékuk forward+ lightingos. A forward+ lighting viszont csak akkor implementálható, ha a motor eleve forward render. Az AMD őszi felhozatalában a Codemasters játékokon kívül az új Hitman és a MOH: Warfighter szerepel. Mindkettő deferred render, szóval olyan durva előny nem lesz ezekben, hogy a HD 7870 is verje a GTX 680-at ahogy a DiRT-ben. Persze AVP, Metro 2033, Sniper Elite V2, Nexuiz és GR: Future Soldier szintű compute terhelés elképzelhető. Szerintem az AMD ezzel is boldog lenne, mert az is elég nekik, ha a HD 7950 van a GTX 680 közelében.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

Löncsi

#10711

üzenetére

Löncsi

#10711

üzenetére

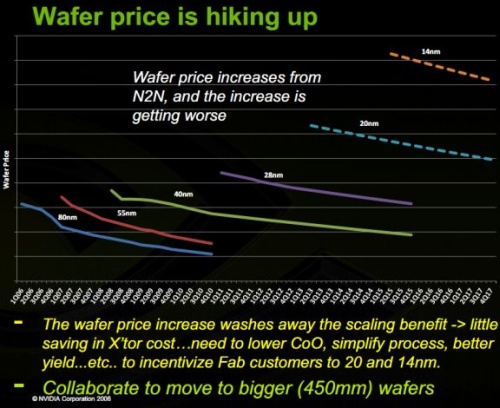

Azért azt senki sem tudja, hogy a TSMC mekkora selejtarányt hoz a GK104-gyel. Emellett a 28 nm-es node jóval drágább, mint amennyi a 40 nm-es valaha is volt.

A 20 nm választóvonal lesz az elemzés szerint. A kisebb lapkáknál át sem érdemes váltani rá.Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

tombar

#10713

üzenetére

tombar

#10713

üzenetére

Célnak semmiképpen sem mondanám a dGPU-k kivégzését. Inkább következmény lehet. Azt azért figyelembe kell venni, hogy ez a piac eleve nem volt egy aranybánya az utóbbi években. Azzal, hogy esik az eladás, nem lett jobb. Vagyis hiába tudják a cégek, hogy az árak emelésével öngerjesztővé válik a szűkülés, egyszerűen nem tehetnek mást.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

TomiLi

#10716

üzenetére

TomiLi

#10716

üzenetére

A HDD-piac teljesen más. A VGA-k nyereséghányada borzalmasan kicsi. Ezt nem szabad elveszteni, különben nincs értelme a piac fenntartásának. A GPU-piacon a nagy pénz az IGP-ben van, nem a dedikált GPU-ban.

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

tombar

#10719

üzenetére

tombar

#10719

üzenetére

Az APU-k nyilván fontos üzleti részt képeznek, de a dGPU-khoz nincs közük. Elméletben megvannak egymás mellett. A gyakorlatban az emberek nézete problémás, mert a vásárlóbázis 80%-ának elég, amit egy APU kínál. Ez jelenti az alapproblémát, amire nincs gyógyír.

Az, hogy mi lesz a next-gen konzolokban annyira nem fontos a PC-s szempontok szerint. A konzolra a játékok nem úgy készülnek, ahogyan PC-re, más a fejlesztőkörnyezet, az API, és még sok minden más. Az AMD-nek az, hogy bezsebelnek három design wint a konzoloknál elsősorban pénzt jelent, mintsem valós előnyt a PC-s fejlesztéseknél. Ha nem lenne AMD egyik next gen konzolban sem, akkor sem változna semmi, mert ugyanarra megy mindegyik cég, szóval a konzolok elvi felépítése nem módosulna. Az AMD-nek sokkal nagyobb előny az, hogy ott áll az ARM és az ImgTec a HSA mögött, mint az, hogy ott vannak a konzolokban.(#10720) KillerKollar: Úgy, hogy a teszt kerülte a max. grafikát. Értem, hogy más az oldalaknál a tesztszisztéma, de egy 160k-s kártyát azért vesz a user, hogy felrakja maxra, amit csak lehet. Főleg AA-t és AF-et.

(#10721) Löncsi: Nem kamu szerintem. Azt korábbról is tudtuk, hogy ha kerüli az adott teszt az AA-t és így a max. grafikát, akkor a GeForce-ok jobbak lehetnek.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

TomiLi

#10724

üzenetére

TomiLi

#10724

üzenetére

A VGA-kat könnyebb ellenőrizni. Csak megnézed, hogy az AMD most ~30 millió dollárnyi operatív profitot keresett ezen a szegmensen. Az NVIDIA legutóbb nettó ~60 millát keresett összesen, de ebből ~70-80 milla az Intel bánatpénze, hiszen 3 évig évi 300 majd szintén 3 évig 200 millát fizetnek az NV-nek, negyedéves lebontásban.

A HDD-k esetében látod a hatalmas nyereséget. Itt egyáltalán nem.(#10723) Löncsi: Nyilván az ártól sok függ majd. 70k-ért szerintem is jó.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

A textúrák minősége jól skálázható. Ez sosem volt probléma, ha valaki tényleg komolyan vette a PC-s portot. Aki meg nem, az ezután sem veszi majd komolyan.

A modellek skálázása egyszerűbb lesz, ha bevezetik a fejlesztők a PTEX-et. Tekintve, hogy mennyire nagy művészek felé a követelmény, ez a leglogikusabb irány a next gen gépeken. Ezzel jóval egyszerűbben skálázható a tesszellálás is. Vektor displacement map mellett akár csúszkával is, amit már korábban hiányoltál. A PTEX implementálása sem nehéz. Az AMD már megmutatta, hogy PRT-vel meg lehet csinálni elég jól. De nem hiszem, hogy ne lehetne rá írni szoftveres megatextúrázást. A Keplernél binned textúrázással akár.Agyonrombolós fizika még jó ideig nem lesz. A játékmenet nagyon nehézkessé válik, mert szétrombolt fizikai objektumokba beakadhat az AI és a játékos. Ha pedig ezeket kivesszük az ütközésvizsgálatból, akkor átmehet rajta minden. Szóval sok a gond. A fizika rombolhatósága olyan szinten lesz jelen, ahogy mondjuk a BF3-ba és a Red Faction két új részében. Ezek már nem eye candy-k, hanem valóban hatnak a játékmenetre, főleg a Red Faction. De ott kínosan ügyelnek arra a fejlesztők, hogy a potenciális akadályt képző részek eltűnjenek.

A GPU-k, illetve pontosabban az IGP-k felhasználásán más szempontok szerint gondolkodnak a fejlesztők. A GPU-kat egyelőre nem bántanák ezekkel, mert nem hatékony a procinak oda-vissza küldözgetni az adatot.(#10729) KillerKollar: Ez a baj, hogy sehol. A beállítások részletezésének mellőzése eleve nagy hiba. [link] - így kell ezeket jelölni. Ebből kiolvashatod a részleteket. Minden max., kivéve a DOF. A high/very high nem mindenhol informatív. Például a Metronál felmerül a kérdés, hogy a DOF aktív volt-e. Emellett Metronál van Very High opció is. Dirt 3-nál van Ultra opció. Nem mondom, hogy nem ezt értette ez alatt, de nem egyértelmű. És ez hiba, mert nem nekem kell találgatni a beállításokról, hanem neki kell leírni.

Az AA/AF világos, hogy inaktív volt. Az utolsó előtti oldal mér bekapcsolt AA-val vagy AF-fel. A kettővel együtt csak a Just Cause 2 esetén, pedig a Metro, az AVP és a Far Cry 2 támogatja mindkettőt. A Mafia 2-ben valóban nincs AA-re lehetőség.[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

KillerKollar

#10731

üzenetére

KillerKollar

#10731

üzenetére

Ha nem írják, honnan tudnám? Az a biztos, hogy az AA és a AF mindig ki volt kapcsolva, mert azt csak az utolsó előtti oldal elemezte, és nem mindegyik játéknál. Ez persze már önmagában kizárja a max fogalmát.

A logika semmit sem ér. Az előző generációban is rengeteg teszt ment le nem max beállítással a GTX 590 és HD 6990 összemérésénél. Múltkor is hoztál fel pár oldalt, és ott is kiderült, hogy nem mindenhol volt maxon az adott program. Pedig felsőkategóriás kártyákról volt szó. Itt a logika nem segít. Le kell írni a beállításokat jóval egyértelműbben, mint a high / very high jelzés. Főleg a Metro és a Dirt 3 esetében, ahol ezek nem jelentenek maxot a beállítások menüben.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

Konzolon jellemzően az a baj, hogy kevés a memória és a memória-sávszélesség. Ebből a két szempontból most sem fogja hozni a PC-s szintet a hardver. A next gen esetében 1-2-4 GB memóriáról hallani, és ez meg van osztva a CPU és a GPU/IGP között.

A PTEX más. Alapvetően megatextúrázással lehet implementálni, tehát technikailag csak az a hátráltató tényező, hogy van-e elég tárhely az adathordozón. Ha van, akkor lehet csinálni 30 GB-nyi textúrát, és mindig a megfelelőt kell betölteni LOD-dal. A Rage ezért használja ugyanazt a textúraadatot mindegyik platformon, mert a megatextúrázás lehetővé teszi.

A másik opció, amit a Codemasters felvetett az AFDS előadásán, hogy számolhatná a textúrát a GPU. Egyszerű matematikai képletekből állna az egész. Ráadásul ezzel a rendszer procedurális is lenne, hiszen a képlet módosításával módosul a textúra. A tesszellációra is valós időben generált displacement mapot lehetne használni.Annyit már ma is tudhatnának, mint a Red Faction. Nem kell ahhoz GPU, csak egy megfelelő motor a fizika kezelésére.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

Löncsi

#10737

üzenetére

Löncsi

#10737

üzenetére

Azért az említett két játék erősen igényli a subpixel információt, amit csak az MSAA ad meg, különben sok lesz a temporális zavar a képkockák között. Nem véletlen, hogy mindkettőbe be van építve az MSAA, vagy annak egy speciális formája.

Önmagában egy post-process AA sosem lesz jó minőségű. Extra információk kellenek hozzá. Jelenleg a Shogun 2 és a Deus Ex: HR tartalmaz olyan post-process AA-t, ami subpixel információkkal irányított. A legtöbb játékba jellemzően csak be van hányva a post-process AA algoritmusa, és kivételbe van rakva a HUD, illetve a szövegek. Ennél tovább a fejlesztők általában nem dolgoznak, inkább csinálnak shaderes MSAA-t, ha lehetséges.

Nincs senkinek ellenére a post-process AA. Jó lehet, de csak úgy, ahogy a Shogun 2 és a Deus Ex: HR használja. Extra adatok nélkül, csak a végső képről dolgozva félkaró óriás bármelyik eljárás. Az MLAA 2.0 és az SMAA sem az igazi. Tény, hogy sokat javul a képminőség azzal, hogy megpróbálja a subpixel pozíciót keresni, de ettől nem lesz konkrét adatja, vagyis még mindig nem az igazi. Ezeknek is ugyanúgy kell az extra információ a számoláshoz.

Alapvetően jó minőségű post-process AA nincs. Megfelelő minőségű lehet, hiszen az AMD MLAA 2.0-ja és a Jimenez-féle SMAA tényleg szuperül dolgozik, ahhoz képest, hogy csak egy képkockányi információja van, de ez még mindig messze van a jó minőségtől. Elhiszem, hogy bármilyen post-process AA jobb a semminél, de ettől nem lesz megfelelő egy eljárás.[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

Én is olvastam azt a 8 magos Atom + 8 GB előrejelzést. Az Atom miatt erős a kétely bennem.

CPU-powa megvan. A Red Faction 4 maggal simán elvan. Boxon is szépen teker.

Borderlandset sose néztem meg. Nem jön be ez a rajzfilmes stílus. De lehet, hogy ott jól működik.

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

Firestormhun

#10770

üzenetére

Firestormhun

#10770

üzenetére

Egyáltalán nem így van. A VGA-piac és a VGA-kat gyártó cégek üzleti érdeke másodlagos egy grafikus motor fejlesztésénél. A legfontosabb, hogy az megfeleljen az előre kitűzött igényeknek. Ha a hardverek még nem készek rá, akkor sem baj, mert a grafikában az a jó, hogy skálázható.

Az előre kitűzött célok természetesen függnek attól, hogy a grafikus processzorok általánosan milyen irányba fejlődnek. Csak pár példa. Régen minden motor forward render volt. Ez megfelelt a 2004-2006 előtti igényeknek, de felfigyeltek arra a fejlesztők, hogy a memória-sávszélesség arányaiban gyorsabban nő, mint a számítási teljesítmény. Éppen ezért a ahelyett, hogy dolgoztak volna olyan forward render eljárásokon, mely jóval több pontfényforrást kezel hatékonyan, elkezdték a deferred render felé fordítani a figyelmet. A 2000-es évek közepén ez sem volt új dolog, alapvetően régóta létező technika, csak régen a forward render jobb volt. A deferred render algoritmusok mellett megnőtt a memóriahasználat, de ez nem volt gond, mert a memória kapacitása és sávszélessége ekkor egy boomot élt meg. Marha gyorsan jött a GDDR3-GDDR4-GDDR5 egymás után, és a lapkák is relatíve olcsók voltak. Persze a deferred render algoritmusok hozták a limitációkat is, mint az MSAA normális támogatásának hiánya, illetve megnehezítette a munkát a limitált lehetőségek a felületi variációkra. Ugyanakkor a forward renderhez képest előny volt a rengeteg pontfényforrás hatékonyabb számítása és a hatékonyabb árnyalás. Mára elértünk oda, hogy szinte minden motor valamilyen deferred render eljárással dolgozik (van sok: defered shading, full és partial deferred lighting, Tile-based deferred acceleration) ... illetve elenyésző számban azért még vannak forward render motorok. Manapság megint egy változás történik. A memória-sávszélesség arányaiban lassabban növekszik, mint a számítási teljesítmény, és ezzel a mutatóval újra a forward render kerül előtérbe (ez amúgy is célszerű, mert az offline renderek forward eljárást használnak, hiszen így a művészek keze nincs annyira megkötve). Az új forward+ lighting eljárás már hatékonyabban kezel ugyanannyi pontfényforrást, mint bármely deferred render, illetve működik rajta az MSAA, nem limitálja a felületi variációkat, és az átlátszóság is egyszerűbben képezhető le. Az árnyalás fázisa ugyan lassabb forward elvvel, mint defereddel, de a lighting fázisnál bőven gyorsabb a forward, így összességében jobb.

Nyilván aki forward render motort használ opciós lehetőségként tekint a forward+ lighting eljárásra. A deferred render motorok esetében is lesz egy kis segítség itt. Ide is be lehet ágyazni a forward+ eljárás egy részét, amivel növelhető a grafika minősége. Ez persze csak egy gyors reakció a növekvő művészi igényekre, de valójában brutál compute és sávszélesség igényes, szóval amellett, hogy grafikai minőség szempontjából előny, a sebességben nagyon meg lesz az ára. Csak akkor érdemes bevetni, ha a művészek tényleg igénylik a jobb grafika kialakításához.

Ebből azért lejöhet, hogy a fejlesztések fő mozgatórugója a művészi munka szabadabbá tétele, illetve a reakció a hardverek egyes képességeinek hosszútávú változására. Pl. mi nő gyorsabban, a számítási teljesítmény, vagy a memória-sávszélesség.Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

Firestormhun

#10772

üzenetére

Firestormhun

#10772

üzenetére

Ebben félig van csak ráció. A másik fele a dolognak az, hogy a játékok fejlesztésére költött anyagi befektetés nem nőhet egyenes arányban a grafika fejlődésével. Ez fogja inkább vissza a fejlődést és nem pont a konzol. Ma már rengeteg olyan DX11-es játék jön, ami olyan eljárásokat használ, amit konzolba be sem lehet építeni. Nyilván elvben megoldható, csak nincs meg hozzá a teljesítmény. A GPU-k pedig lehetnek 30x gyorsabbak is (már bőven azok), addig ez nem ér semmit, amíg a művészi munkába fektetett anyagi- és humánerőforrás nem lesz 30x nagyobb. Erre tök jó példa a Samaritan demó. Ha lenne három év egy útcasarkot pofozgatni, akkor ma minden játék úgy nézne ki PC-n. Három év azonban egy teljes játéktérre sincs, szóval keresni kell olyan megoldásokat, amivel gyorsabban kreálható a tartalom. Carmack ezért megy a megatextúrázás és a megageometria felé, mert ez egy ilyen megoldás. Rögös az út persze, nagyon nem fekszik a dolog a CPU.nak + a lassú külső buszon bekötött GPU-nak (ezzel a textúra tile-ok folyamatos másolgatásának a rendszermemória és a VRAM között), de elméletben ott az előny, és az integráció fejlődésével a gyakorlatban is ott lesz. Aztán kiegészíthető ez a Ptexszel, ami ténylegesen pár kattintásra csökkent a mai textúraformátumok mellett sokszor órákig tartó munkát. Csak így lehet jelentősen előrelépni, mert a költségek és a befektetett humánerőforrás drasztikus növelése szerintem nem jó út, már csak anyagilag sem.

Mindig van különbség, csak az effektet ismerni kell, hogy azt hol keresd. A technika implementációja pedig jellemzően a fejlesztőktől függ. Sok olyan opció van egyébként, ami régóta létezik, de csak most kezdik alkalmazni, hogy megérkezett az ALU Power. Ilyen például az SSDO. Ez teljes felbontás mellett a Nexuizban van először. A Crysis 2 is támogatta, de negyedelt felbontással, nyilván van egy combosabb compute igénye, szóval nem árt finoman bánni vele. A különbség viszont nagyon szembeötlő:

On [link] - Off [link]Az OpenGL támogatásának csökkenése nem a konzolok hagyatéka. Egyik konzol sem használ PC-s API-t, szóval teljesen irreleváns a PC-s API kiválasztásnál a port. Amiért az OpenGL hanyatlott az a DX10-es reformok. Pont azt hozta amire a fejlesztők vágytak, ezzel viszont teljesen megölték a visszafelé kompatibilítást. Az OpenGL nem tud elszakadni a kompatibilitástól, így sajnos görgeti maga előtt azokat a problémákat, amitől az MS megszabadította a DX-et. Ettől persze nem lesz rossz API, sőt, nagyon jó, de a DX most jobb.

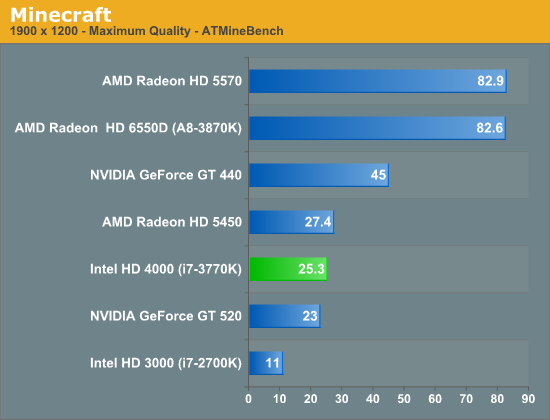

Az AMD az OpenGL visszaszorulásának egyáltalán nem örül. Az OpenGL driver náluk nagy változáson ment át az elmúlt 7 évben. Az egészet az Orca (OpenGL) driver indította el, ami a Catalyst 7.1-ben mutatkozott be. A régi driver felújításaként a sebesség marha jó volt, de a stabilitás már nem. Ezután döntött úgy az AMD (ekkor ugye már megvették őket), hogy ezt a sebességet kell hozni stabilan. Kétfelé ágazott tehát a projekt. Az Orca funkcionális fejlesztése tovább zajlott, de a nagyobb project az OpenGL driver újraírása a nulláról. Ez a projekt 2010 októberében készült el, amikor megérkezett a FirePro kártyákhoz a 8.773-as driver. Ezzel a korábbi driverhez képest 446%-os teljesítménynövekedést sikerült elérni egy v7800-on, ami az akkori csúcs volt. És ami a legfontosabb, hogy a stabilitás is elképesztően fejlődött. Ezután kezdték a FirePro termékek megkapni a programcertifikációkat, mert funkcionálisan szuper volt a működés. A konzumer termékeknél a mainline kódba 11.3-as driverben került bele ez az OpenGL driver. Ennek az eredménye, hogy a Radeonok így teljesítenek a MineCraftban:

A GeForce GT 440-nél nem gyorsabb a HD 5570 majdnem kétszer (DX-ben kb. egy szinten teljesítenek, kicsit gyorsabb a GeForce), és az A10-3870K sem gyorsabb 3,5x az i7-3770K-nál (úgy átlag 20-40%-kal gyorsabb "csak" az Intelnél). Ami ezeket az eredményeket hozza az AMD-nél az a nulláról újraírt OpenGL driver előnye.

Az AMD pechére ennek játékokban már nem nagyon lesz hozománya, mert a DX elhúzott. Persze a professzionális piacon jól jön majd a driver, szóval nem kidobott pénz és idő ... de azt mondani, hogy az AMD szerencséjére nincs sok OpenGL játék ... hát, ennek ők ennyi befektetett munka után egyáltalán nem örülnek.Az természetes, hogy a GE és a TWIMTBP programoknál más lesz a grafika fejlesztési szempontja, de mi van a Ghost Recon Future Soldierrel? Az is olyasmi eredményeket ad, mint a DiRT Showdown és semelyik partnerprogramnak sem volt része. A helyzet az, hogy a fejlesztőknek is a compute irány volt a lényeges, hiszen a Fermi erre ment. A GCN látták, hogy erre megy. Általánosan kimutatható volt, hogy az architektúrák compute hatékonysága nő. Az Intel a Gen7 architektúrát ebbe az irányba vitte. Az MS hozza a shader-trace interfészt, hogy egyre bonyolultabb compute shadereket lehessen írni, hiszen egyrészt kapják a fejlesztőktől az igénylést, és látják, hogy a GPU-k merre mennek. Ezek alapján ki gondolta volna azt, hogy az NV nem erre megy a Keplerrel ... valójában senki. Alapvetően a Kepler és a GCN különbsége nem nekünk okoz nagy fejtörést. Persze a kasszánál is gond, hiszen nehéz dönteni. De képzeld el a fejlesztőket, akik követték a napnál is világosabb trendet, és jön egy architektúra, ami hirtelen felrúgja azt. Na az ő helyzetük nem könnyű ... a Ghost Recon Future Soldier esetében azt választották, hogy hagyják a GI effektet úgy ahogy van. Ha lassú lenne, akkor majd a felhasználó kikapcsolja. Valószínű, hogy nem csak ők követik ezt az utat. Persze ott van ellenpéldának a BF3, amiből kivették a compute shaderes extra effekteket, de ez csak elővigyázatosság volt, mert maga a motor működése nagyon épít az LDS terhelésére. A Kepler kipróbálása nélkül lehetetlen volt megállapítani, hogy mennyire rázná meg a terméket, ha a Tile-based deferred acceleration mellett még mondjuk egy HDAO is ostromolná az LDS-t. Mivel a Tile-based deferred acceleration nagyon a működés része, és DX11 alatt ki sem kapcsolható, így nem ártott ügyelni erre. Gondolom az NV korábban megmondta nekik, hogy úgy csinálják a rendszert, hogy a Kepler a Fermi shared memory tempójának a harmadára képes. Ma már lehet, hogy másképp alakul a dolog, hiszen van mivel tesztelni. 2011 őszén nem volt.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

Firestormhun

#10785

üzenetére

Firestormhun

#10785

üzenetére

A F.E.A.R. példák rosszak. Az első rész után a kettőben megváltozott a render. Amit az első részben használt azt kukázták, de helyette áttértek a Valve-féle Ambient Cube rendszerére, vagyis az új játékba épített megvilágítási modell jóval modernebb volt. Tehát összességében előrelépés volt. Az első részben használt SH (spherical harmonics) modell sok memóriát evett, és nem mutatott jól specular mapok mellett. Ezt lecserélni az Ambient Cube megoldásra nem volt rossz ötlet.

Az Assasin's Creed 1 esetében valóban tartalmazott egy hibát a DX10/10.1-es kód. Ezt persze lehetett volna javítani is, de inkább a DX10/10.1 törlését választották a fejlesztők. Tervben volt a javítás utáni visszarakás, de nem történt meg. Akkor a Gaming Evolved program még nem létezett, szóval nem volt támogatás az AMD-től, hogy visszakerüljön. Az NV meg hülye lett volna támogatni a visszarakást, hiszen nagyon jó példa volt arra, hogy a DX10.1 milyen értékes.

Az Assasin's Creed 2 esetében már eleve nem döntöttek a DX10/10.1 implementálása mellett. Igazából ezzel nincs gond. A fejlesztőnek joga van ezt eldönteni.A Chrome 4 esetében a DX10 eleve nem volt tervben. A 3-ban azért volt DX10, mert sok dolgot azzal lehetett hatékonyan megoldani. A 4-es motorban már alapvető változások voltak, így elég volt a DX9 is. A legújabb Chrome 5 már támogat DX11 kódot is. Aki licenceli ezt a motort nyugodtan építhet rá, ugyanakkor ez a kódbázis csak gyorsít, de a DX9 is elég gyors, szóval a Techland nem vetette be az eddigi játékokban.

A CryEngine 3-ból sosem hiányzott semmi, amit a 2 tudott. Egyszerűen a Crysis 2-höz nem használták fel. Nem ritka, hogy egy motor sokkal többet tud annál, mint amennyit kihasznál a rá épülő játék. Ez nem a motor problémája, hanem a fejlesztő hanyagsága. A Crysis 2 iskolapéldája, hogy mit nem szabad csinálni, de ettől a CryEngine 3 nem lett rossz motor, vagy visszalépés, csak a Crysis 2-nél meghozott értelmetlen és technikailag megalapozatlan fejlesztői döntések miatt tűnik annak.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

Löncsi

#10795

üzenetére

Löncsi

#10795

üzenetére

De az API nagyon korlátozó. Igazából csak azért van értelme, mert sok hardvert lehet vele támogatni. De ezért nagy árat kell fizetni.

A másik korlátozás a művészi munkához szükséges erőforrás. Ez is nagyon véges.[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

Löncsi

#10797

üzenetére

Löncsi

#10797

üzenetére

Technikailag megoldható a HSA az már elég low-level felület, de nem a grafika az elsődleges célja, ezért sincs grafikus futószalagja, persze ilyet bármikor lehet írni, de az elsődleges cél sosem lesz ez.

A HSA az egy független felület. Bármin fut, csak írni kell rá finalizert és kernel drivert az adott hardverhez.

Miért kellene megszüntetni a legacy DX támogatást? Az OpenGL is el van mellette.

Egyébként a legjobb megoldás az a DX API hardverhez közelibbé válása. Ez már a DX11.1-gyel elkezdődött. A gyártók egyéni kiterjesztéseket írhatnak az alap specifikációk mellé.Richard Huddy csak szerette volna megtudni, hogy a fejlesztők mit gondolnak az API eldobásáról. Nyilván sok fejlesztőt megkérdezett, de az összeset nem, és ennek a legjobb formája, ha teszel a sajtóban egy kijelentést, aztán figyeled a dev. fórumokat. A leírt problémát ténymegállapítások voltak. Ettől az AMD nem akarja az API-t eldobni, csak kíváncsi volt a reakciókra. Ennek tényleg az egyik legjobb módja a sajtó kihasználása.

És ki lesz a befektető? Az rendben, hogy ha kap a csapat három évet, hogy csináljon egy olyan utcasarkot, ami a Samaritan demóban van, akkor ilyen grafikát ma is lehet csinálni, de ki ad nekik három évet, amikor egy teljes játéktérre max. 2 évet szoktak adni? Ez persze nem az API problémája, hanem a felhasznált eljárásoké, amelyek idejétmúltak lettek a művészi oldalon. Carmack ezért erőlteti megatextúrázást, mert látja, hogy lassan nem a hardver teljesítménye a grafika fejlesztésének legfőbb mozgatórugója. Nagyon sokat tudnak a hardvere, és nagyon gyorsak, de nincs pénz/idő ahhoz, hogy ezt a művészi oldalon grafikába öntsék.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

Löncsi

#10799

üzenetére

Löncsi

#10799

üzenetére

A korlátozás elviekben keletkezik. Azt kell nézni, hogy 60 fps mellett mennyivel több rajzolási parancsot kezelnek a konzolok.

Az Unreal Engine 4-nek pedig van még pár problémája. Ha a konzolok nem kapnak 8-16 GB rendszermemóriát, akkor mindenképpen kell egy más megoldást találni a GI implementációra. Ezért is készült el az UE3 továbbfejlesztése, mert egyelőre az Epic sem biztos abban, hogy imáik meghallgattatnak.Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

Nem fog senki sem lemenni hardverszintű támogatásra. Jobb alternatíva a virtuális architektúra. Arra bárki írhat szoftveres futószalagot. Ha ezt a vISA-t sokan támogatják, akkor a gyártók felelhetnek a vISA->hardver ISA fordításért, ez lenne a finalizer. Így működik a HSA, sőt, még a CUDA is, hiszen az is PTX-en keresztül támogatja a hardvereket. Utóbbi a vISA. A HSA esetében a vISA a HSAIL. Persze ezek között van különbség, de a koncepció ugyanaz.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

tombar

#10858

üzenetére

tombar

#10858

üzenetére

A Max Payne 3 kimarad. Iszonyat szar vele mérni, mert folyamatosan átvezető animációk ugranak be real time, és fellövik 1000-re az fps-t.

Egy egész hétvégén azzal pöcsöltem, hogy találjak valami helyet, ahol nincsenek véletlenszerű részek, de csak 10 másodperces apró események vannak így. Írtam a Rockstarnak, hogy csináljanak hozzá egy benchmarkot, mert jó lenne a cucc, csak így nagyon körülményes. Helyette hirtelen felindulásból lett Nexuiz, ami CryEngine 3, és jóval egyszerűbb, mert ott van benne a benchmark opció.

Egy egész hétvégén azzal pöcsöltem, hogy találjak valami helyet, ahol nincsenek véletlenszerű részek, de csak 10 másodperces apró események vannak így. Írtam a Rockstarnak, hogy csináljanak hozzá egy benchmarkot, mert jó lenne a cucc, csak így nagyon körülményes. Helyette hirtelen felindulásból lett Nexuiz, ami CryEngine 3, és jóval egyszerűbb, mert ott van benne a benchmark opció.[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

tombar

#10862

üzenetére

tombar

#10862

üzenetére

Általában ez van, ha új tesztplatformot állítunk fel. Meg kell nézni, hogy mi hogyan működik, mert ha teszt közben derül ki valami para, akkor az szívás időben. A Nexuizt is a 2,5 eurós steam akció szülte. Az ingyenes próba miatt ránéztem, és "jé há ebbe van bencsmák".

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

tombar

#10864

üzenetére

tombar

#10864

üzenetére

Azért azt megnézem, hogy a bench mennyire tükrözi a játékbeli teljesítményt. Általában nincs lényegi eltérés.

(#10865) gbors: Ezt nem vettük észre. Full HD-ben elég szépen ment. 2560-ban van pár VGA, amit megevett, de az erősebbek bírták. Szóval a gépigény nem mondható keménynek. Lehet, hogy a patchek miatt. A fórumukon írták, hogy a javítások sokat lőttek a sebességen.

Nem ronda. Budget játékhoz mérten én is rácsodálkoztam. Van SSR, Bokeh DoF, HDR motion Blur, szimulált volumetrikus fények. Ja és SSDO, ráadásul ez az első játék, ami teljes felbontáson csinálja, vagyis a Cryss 2-vel ellentétben nem skálázva. Erre az SSDO-ra már senki sem mondja majd, hogy nem látja a különbséget: On - Off[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

tombar

#10866

üzenetére

tombar

#10866

üzenetére

Hát, kb. De amúgy nem rossz gama, szokásos Arena shooter. Csak túl gyors a játékmenet. Azt sem tudod, hogy mi történik.

De bele lehet tanulni.

De bele lehet tanulni.

Amúgy valszeg a következő frissítésből kikerül, de most volt pár óra berakni valamit az MP3 helyére. Kár, hogy nem jött hamarabb a Sleeping Dogs. A sajtó el van ájulva tőle, és a PC-s port is elég jól össze van rakva. Mondjuk a Nixxes erre specializálódott, szóval náluk ez alap. Ebből egyébként azon lehet elmélkedni, hogy nem is akkora hülyeség, amit az EIDOS/SQUARE ENIX csinál, hogy egy csapatot csak a PC-s portokra tart. Szkeptikus voltam, de a Deus Ex: HR és most a Sleeping Dogs igazolja, hogy egy külön csapat jobban tud figyelni a PC-s port optimalizálására, ráadásul megpakolják extrákkal is, mint DX11, sztereo 3D, többmonitoros buli.[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

sakal83

#10874

üzenetére

sakal83

#10874

üzenetére

Anno 2070 (DirectX 11) - motor: InitEngine / műfaj: stratégia

Batman: Arkham City (DirectX 11) - motor: Unreal Engine 3 / műfaj: TPS

Battlefield 3 (DirectX 11) - motor: Frostbite 2.0 / műfaj: FPS

Crysis Warhead (DirectX 10) - motor: CryEngine 2 / műfaj: FPS

Deus Ex: Human Revolution (DirectX 11) - motor: Crystal Engine / műfaj: FPS/RPG

DiRT Showdown (DirectX 11) - motor: EGO Engine / műfaj: autóverseny

Metro 2033 (DirectX 11) - motor: 4A Engine / műfaj: FPS

Nexuiz (DirectX 11) - motor: CryEngine 3 / műfaj: FPS

Sniper Elite V2 (DirectX 11) - motor: Asura Engine / műfaj: TPSEzek a játékok lesznek a mi tesztünkben. Az idén megjelent DX11-es játékokból három is benn van. Ez a fő változás. A Shogun 2 ment még, mert annak most valahogy nincs rendben a sebessége az új patchekkel. Ahogy az NV javította a tempóvesztést a Kepleren, megint jött egy új patch, ami újra gondot csinál. Szóval ezt váltotta az Anno 2070, mert így a Shogun 2-t nem lehet normálisan mérni. A Sniper Elite V2 pedig az új Metro.

Mondjuk ebbe azért én is benne vagyok, mert 2560-ra 4xSSAA-at írtam. Hát azt nem szeretik a kártyák. Full HD-ben a 2,25x SSAA-val még elvannak, de a 4x úgy néz ki, hogy sok. Mindegy mostmár.

Mondjuk ebbe azért én is benne vagyok, mert 2560-ra 4xSSAA-at írtam. Hát azt nem szeretik a kártyák. Full HD-ben a 2,25x SSAA-val még elvannak, de a 4x úgy néz ki, hogy sok. Mindegy mostmár.

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

tombar

#10883

üzenetére

tombar

#10883

üzenetére

Az 1.0-s verzióból hiányzik az advanced lgihting egy része, ami ugye VPL-alapú valós idejű GI-t adja be. Ezt az 1.1-es patch adta hozzá a játékhoz. De azt az NV amúgy is kéri, hogy kapcsolják ki, sőt arra kérnek mindenkit, hogy hagyja ki a DiRT Showdownt. Tisztában vannak a Kepler határaival. Persze ilyen alapon ki lehetne hagyni a Ghost Recon Future Soldiert és a Sniper Elite V2-t is (ez a két játék valszeg azért nem releváns, mert nem kap olyan figyelmet, mint a sokat reklámozott DiRT Showdown, azaz kicsi az esélye, hogy valaki ezekhez nyúl ... a Ghost Recon Future Soldier esetében ez igaz, mert ma is elég bugoska).

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

Én 40-50 között voltam 1680x1050-ben maxon. Simán aprítottam.

A CryEngine 3 egy partial deferred lighting motor. Oda a jó AA-hoz elég komplex megoldás kell. A Nexuiz szimplán MSAA-t próbál erőszakolni, apró trükkökkel. Valójában tehát nem bugos csak nem felel meg a motor sajátosságainak. Jobban jártak volna egy post-process AA-val (én ezt lövöm be hozzá driverből, SSAA-val is próbálkoztam, de az fájt neki

).

).[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

tombar

#10886

üzenetére

tombar

#10886

üzenetére

Nem tudom, hogy melyik a legújabb patch. Letöltöttük a steamról a legújabb verziót és azzal mértünk. Valszeg 1.1, de nem követem annyira.

Minden gyártónak joga van ajánlani egy útmutatást, hogy ő hogyan tesztelne. Az NV most nem ajánlja az új játékokat (főleg a négy legújabb DX11-est, mert azok compute irányba mennek), és jellemzően a 8xMSAA-t, illetve terméktől függően a Full HD-nél nagyobb felbontást. Összességében ezeket a játékokat ajánlják tesztre: DirectX 11 Games: Battlefield 3, Batman Arkham City, Crysis 2, DiRT 3 - DirectX 10: Far Cry 2 - DirectX 9: Elder Scrolls V: Skyrim.

Az AMD útmutatói jellemzően mások. Ők tesztelnek 20-25 játékkal, bedobják az eredményeket, hogy nekik mi jött ki a különböző saját és konkurens kártyákkal, és csak arra hívják fel a figyelmet, hogy ha valami nagyon eltér, akkor azt érdemes újramérni, vagy ránézni, hogy esetleg mi lehet az oka. Nem igazán ajánlanak semmit.Itt majd alapvetően az lesz a helyzet, hogy a következő hónapokban a fejlesztőnek döntenie kell, mert most már van Kepler, tudják mire képes, és el lehet dönteni, hogy benne hagyja-e az adott játékban a compute shader effektek többségét, vagy csökkentenek a terhelésen. Igazából azt kell mérlegelni, hogy a GCN-nek a csökkenő terhelés nem gond, de a Keplernek a magas terhelés az. Valószínű, hogy próbálnak arany középutakat keresni. A Dirt Showdown, a Sniper Elite V2 és a Ghost Recon Future Soldier szerintem egyedi esetek. Valószínű, hogy nem volt már idő, vagy esetleg kedv/akarat a Kepler miatt kivenni egy-egy effektet. Ez főleg a Ghost Recon Future Soldierre értendő, mert az egy független fejlesztés, és ők is DiRT-hez hasonló (bár nem pont ugyanolyan) VPL-GI-t csináltak. Itt főleg a GI lesz a kulcs, mert azt ugye hallottuk a SIGGRAPH-on, hogy fake megoldásokat el kell felejteni és jöjjön a dinamikus GI. Na most ez is rendkívül tág fogalom, mert mára már van legalább egy tucat jó implementáció erre. A legjobb eredményt a compute shaderes megoldások adják, de lehet, hogy a konzolok és a Kepler miatt érdemes régebbi megoldások után kutatni, mert vannak. Persze tudom, hogy a BPS előadáson a compute erősítése volt a fő téma, ami logikus ösvény, de gondot jelent, ha a két uralkodó architektúra között 4,5x-es a shared memory tempókülönbsége, és a cache szervezés hatékonysága is ég és föld kategóriába tartozik.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

fatallerror

#10891

üzenetére

fatallerror

#10891

üzenetére

Ilyen poénért nem bannolunk.

De azért tud meg, hogy fájt.

De azért tud meg, hogy fájt. ![;]](//cdn.rios.hu/dl/s/v1.gif)

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

Löncsi

#10903

üzenetére

Löncsi

#10903

üzenetére

Addig nincs baja a flex vezérlésnek, amíg nem megy a játék memóriaigénye 1,5 GB fölé. Mivel H olyan játékokkal tesztelt, amelyek ezt nem lövik túl, így a kártyának sincs igazán gondja.

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

Löncsi

#10905

üzenetére

Löncsi

#10905

üzenetére

Ez nem ilyen egyszerű, ahogy egy program leírja. A mai játékok jellemzően annyi VRAM-ot használnak, amennyi rendelkezésre áll. Egyszerűen töltik, amíg befér, majd ha már nem, akkor a régen használt dolgot helyére írnak. Ezért is hülyeség a Rockstarnak ez a memórialimitje. Semmi alapja nincs, csak megpróbálják limitálni a felhasználók elől a beállításokat, mert sokan nem értenek hozzá. Ami fixen zabbant VRAM-ot azok a bufferek és a render targetek. A textúrákra és az objektumokra viszont felesleges bármit is fixen számolni, azok úgyis streamelve lesznek.

Ez szerintem egy nagy hibája a R.A.G.E. motornak. Teljesen felesleges bármilyen limitet felállítani a VRAM-ra. Nem véletlen, hogy a Rockstaron kívül senki más nem teszi ezt meg. Ezzel nem segítik a felhasználókat, de a tesztelőket szopatják, mert olyan beállítást kell találni, ami mindegyik kártyára ráaggatható. Ezt utáltuk a Shogun 2-ben is. Rádobtuk maxra, majd az 1 GB-os kártyákra kiírta, hogy nem akarja. Ezt még eltűrtük neki, de az új patchekkel a GeForce kártyák teljesítménye nagyon ingadozik (mintha nem lenne QA, teljesen érthetelen ... az NV megoldja a problémát, majd jön egy patch, ami újra elbassza a sebességet), így köszöntük neki a "szép napokat" és jött az Anno 2070. Most a Max Payne 3-ra is találtam egy egész jól mérhető részt, de rájöttem, hogy a 2 GB alatti kártyákon nem lehet maxra állítani a grafikát. Szóval megint szopás lenne, mint a Shogun 2-nél.[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

Új hozzászólás Aktív témák

A topikban az OFF és minden egyéb, nem a témához kapcsolódó hozzászólás gyártása TILOS!

MIELŐTT LINKELNÉL VAGY KÉRDEZNÉL, MINDIG OLVASS KICSIT VISSZA!!

A topik témája:

Az NVIDIA éppen érkező, vagy jövőbeni új grafikus processzorainak kivesézése, lehetőleg minél inkább szakmai keretek között maradva. Architektúra, esélylatolgatás, érdekességek, spekulációk, stb.

- Kínai, és egyéb olcsó órák topikja

- Milyen TV-t vegyek?

- Kodi és kiegészítői magyar nyelvű online tartalmakhoz (Linux, Windows)

- Befutottak az első Xperia 1 VII pletykák

- Honor Magic5 Pro - kamerák bűvöletében

- Yettel topik

- Magga: PLEX: multimédia az egész lakásban

- Apple notebookok

- MIUI / HyperOS topik

- AMD Ryzen 9 / 7 / 5 / 3 5***(X) "Zen 3" (AM4)

- További aktív témák...

- Geforce 1660 super (hibás)

- Garanciális 2026-ig! - Sapphire NITRO+ AMD Radeon RX 7900 Xtx Vapor-X

- ASUS DUAL Radeon RX 6500 XT O4G 4Gb DDR6 2025.09-ig garanciával

- Eladó/nagyobbra cserélhető Gigabyte Radeon RX 6800 XT GAMING OC 16G

- MSI GeForce GTX 1660 SUPER GAMING X 6GB GDDR6 192bit LED Nvidia Videokártya

Egy egész hétvégén azzal pöcsöltem, hogy találjak valami helyet, ahol nincsenek véletlenszerű részek, de csak 10 másodperces apró események vannak így. Írtam a Rockstarnak, hogy csináljanak hozzá egy benchmarkot, mert jó lenne a cucc, csak így nagyon körülményes. Helyette hirtelen felindulásból lett Nexuiz, ami CryEngine 3, és jóval egyszerűbb, mert ott van benne a benchmark opció.

Egy egész hétvégén azzal pöcsöltem, hogy találjak valami helyet, ahol nincsenek véletlenszerű részek, de csak 10 másodperces apró események vannak így. Írtam a Rockstarnak, hogy csináljanak hozzá egy benchmarkot, mert jó lenne a cucc, csak így nagyon körülményes. Helyette hirtelen felindulásból lett Nexuiz, ami CryEngine 3, és jóval egyszerűbb, mert ott van benne a benchmark opció.

![;]](http://cdn.rios.hu/dl/s/v1.gif)