- Karácsonyfaként világíthat a Thermaltake új CPU-hűtője

- Az USA vizsgálja a RISC-V kínai terjedésének kockázatát

- Kicsit extrémre sikerült a Hyte belépője a készre szerelt vízhűtések világába

- Egészen nagy teljesítményspektrumon fedné le a mobil piacot az AMD

- Kihívás a középkategóriában: teszten a Radeon RX 7600 XT

- OLED TV topic

- Gaming notebook topik

- Milyen TV-t vegyek?

- Kicsit extrémre sikerült a Hyte belépője a készre szerelt vízhűtések világába

- Micro Four Thirds

- Milyen cserélhető objektíves gépet?

- Azonnali informatikai kérdések órája

- AMD Ryzen 9 / 7 / 5 7***(X) "Zen 4" (AM5)

- HiFi műszaki szemmel - sztereó hangrendszerek

- SSD kibeszélő

Hirdetés

-

Már tudjuk, hogy mikor jön az idei Xbox Games Showcase

gp A showt egy külön Direct előadás követi, ami szinte biztosan az idei Call of Duty lelepelzése lesz.

-

Spyra: akkus, nagynyomású, automata vízipuska

lo Type-C port, egy töltéssel 2200 lövés, több, mint 2 kg-os súly, automata víz felszívás... Start the epic! :)

-

Saját Redmi Note 13 Pro+ a világbajnok focicsapatnak (és indiai rajongóiknak)

ma Argentína nemzeti válogatottjának mezével díszítik az új Redmi különkiadást.

-

PROHARDVER!

A legtöbb kérdésre (igen, talán arra is amit éppen feltenni készülsz) már jó eséllyel megtalálható a válasz valahol a topikban. Mielőtt írnál, lapozz vagy tekerj kicsit visszább, és/vagy használd bátran a keresőt a kérdésed kulcsszavaival!

Új hozzászólás Aktív témák

-

Abu85

HÁZIGAZDA

válasz

TomLion

#8241

üzenetére

TomLion

#8241

üzenetére

Azért nem adtak el belőle tonnákat, mert sokkal drágább volt gyártani, mint a 6800 Ultrát.

(#8242) DemonDani: Szerinted, aki Eyefinityt rak össze, az annyira igénytelen, hogy 30k-s, semmit nem tudó tucatmonitorokat választ.

Aki ilyen konfigban gondolkodik, az kapásból az IPS paneleket veszi célba.

Aki ilyen konfigban gondolkodik, az kapásból az IPS paneleket veszi célba.[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

TomLion

#8244

üzenetére

TomLion

#8244

üzenetére

Az EVGA megcsinálja szerintem a Geminit. Nekik ez üzlet. Az NV-nek csak akkor lenne üzlet, ha ütnék a HD 6990-et.

Nem teljesen. Az NV számára HD 6990 elleni vereség egy dupla-GPU-s kártyával azt az üzenetet továbbítaná a felhasználóknak, hogy technológiailag lemaradtak az AMD-vel szemben. Ez minden szempontból rossz. Sokkal jobb, ha azt hiszitek, hogy az NV meg tudja verni a HD 6990-et, csak nem akarja. Ugyanez volt a HD 5970 ellen. Majd a mi két GPU-s kártyánk megalázza ... aztán nem lett belőle semmi.

Mindenki ezt gondolja, de ha túlléped a 300 wattot, akkor buktázod az OEM eladásokat. Tekintve, hogy a HD 5970 itt ért el sikereket, ez nem jó dolog. Azért nem hozznak ki a gyártók 300 wattnál többet fogyasztó VGA-t.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

DemonDani

#8246

üzenetére

DemonDani

#8246

üzenetére

Eleve az, hogy a felhasználók 90% azt sem tudja, hogy mi az Eyefinity kizárja azokat a vásárlókat, akik kevésbé értenek hozzá. Akik viszont értenek hozzá, azok igényesek. Tudják mi a különbség a TN és az IPS panel között, vagyis értik, miért érdemes az utóbbiba ruházni.

Egyébként nem professzionális monitorokról beszélünk. 80-100k-ért kapsz IPS-es monitort.

Egyébként nem professzionális monitorokról beszélünk. 80-100k-ért kapsz IPS-es monitort.[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

TomLion

#8248

üzenetére

TomLion

#8248

üzenetére

Ha ez érdekli őket, akkor nem tervezték volna meg a GeForce GTX 295-öt, amit három hónapon át 50 dolláros kártyánkénti veszteséggel értékesítettek. Tavasszal le is állították a szállítást mert elérték a mélypontot, aminél több veszteséget már nem tudtak volna benyelni. Augusztussal indult újra a termék forgalmazása, ami már nullszaldós volt az áttervezés miatt, de később emeltek az áron, mert az AMD a HD 4870 X2 gyártását leállította előkészülve a HD 5970-re.

A status quo addig marad fent, amíg van olyan ember, akit meg lehet vezetni. A látszaton viszont egy olyan két GPU-s kártya, ami a HD 6990 ellen elbukik nagyon nagyot ront. Ez nem biztos, hogy megengedhető.

Persze a dolog tök lényegtelen. Az NV-nek sokkal komolyabb dolgok miatt fáj a feje, minthogy egy zsugorodó, és kvázi értéktelen VGA-piac elsőségéért küzdjenek. A konkurensek már platformot kínálnak. Ez ellen kell tenni valamit, mert ez hozza a nagy zsét. Az NV leghamarabb 2013-ban fog Win8-as platformot kínálni. Kell valami komoly előny, amivel betörhetnek.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

DemonDani

#8250

üzenetére

DemonDani

#8250

üzenetére

Tudjuk milyen az a jóféle TN panel. Ott van 50-60k környékén egy monitor, és az olcsóbb IPS képminőségéhez köze sincs. Valószínűleg, aki 100k-s kártyákban és az ehhez szükséges izmos gépen gondolkodik, mindezt három monitorral, az nem aprót kötegel, hogy meg tudja venni.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

DemonDani

#8252

üzenetére

DemonDani

#8252

üzenetére

Miért kell lemondani a 3D-ről? Nem a 120 Hz miatt lesz 3D-s. Ezt csak azért vezették így be, mert a monitor oldaláról olcsóbb, mint a passzív szemüvegekhez megfelelő kiépítés. Persze az eredmény is rosszabb.

Nem vagy tisztában az IPS működésével, ha a válaszidőt rosszabbnak tekinted, a dinamikus kontraszt és a LED pedig elérhető IPS-nél is, már akinek szüksége van erre. Nekem volt egy Samsung monitorom. Azért cseréltettem LG-re mert nem tudtam kikapcsolni a dinamikus kontrasztot. Nagyon zavaró volt, amikor böngészés közben villogott. Szerencsére ismertem a szervizest, és gyorsba elintéztük a cserét. Ráfizettem ugyan 5 rongyot, de megérte a dinamikus kontraszt kikapcsolásának lehetősége.

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

Itt az a lényeg, hogy az SSAO sokkal kevesebb erőforrást követel, mint az AO. Ugyanez igaz máshol is. A post process zabálja az ALU powert és effekttől függően a VRAM-ot, de összességében jobban jársz, ha így oldod meg. Ebbe valamennyire belejátszik az is, hogy a mai GPU-knak az ALU kapacitása általánosan kihasználatlan.

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

A fejlesztők többsége nem ír SSAO algoritmust. A Crytek meg a nagyok talán megcsinálják, de a többiek elkérik az AMD HDAO vagy az NV HBAO algoritmusát, attól függően, hogy melyik felel meg jobban nekik.

A HDAO képminőségben nagyon erős. A HBAO már nem, de nem is eszik annyit. Persze a HDAO előnye, hogy Compute Shaderben írta az AMD, így a DX11-es kártyákon a sebesség 7-szer jobb, mint DX10-ben lenne. A HBAO egy shader modell 4-es megvalósítás.Csak a textúrázó és a ROP kapacitás nem nőtt teljesen arányosan. Nem beszélve a geometriai kapacitásról, ami gyakorlatilag tesszellálás nélkül minden kártyán egy háromszög/órajel. Egyedül a Cayman dolgozik két háromszöggel, míg a fermis GeForce-ot az NV mesterségesen korlátozza, ha nincs tesszellálás, nehogy a Quadro piacát veszélyeztesse a rendszer.

Ilyen körülmények között és a DirectCompute 5.0 lehetőségeivel egyértelmű, hogy a post process a nyerő. Ha nem erre mennénk akkor lehet, hogy mást látnánk, de a hardverek erre fejlődnek, és ezt le kell követni.(#8257) DemonDani: Eleve onnan indultunk ki, hogy ha veszel egy ilyen kártyát, akkor Full HD alá nem adod.

Ez egyszerűen tény. A felbontás nagyságával javul a minőség. Ha kisebb felbontású monitort választasz, akkor azonos mérteben gyengébb lesz a megjelenítés minősége. Gondolod ezek után, hogy ez alternatíva lehet azoknak a felhasználóknak, akik minimum félmillás hárommonitoros konfogikon gondolkodnak?

Ez egyszerűen tény. A felbontás nagyságával javul a minőség. Ha kisebb felbontású monitort választasz, akkor azonos mérteben gyengébb lesz a megjelenítés minősége. Gondolod ezek után, hogy ez alternatíva lehet azoknak a felhasználóknak, akik minimum félmillás hárommonitoros konfogikon gondolkodnak?

Volt már nálam IPS panel. Ég és föld a különbség a TN panelhez képest. Ha lenne anyagi keretem rá, rég nem TN panelt nyúznák.

Az IPS technológiája teljesen más, és ezért másak a késleltetési értékek. A technológia alapja, hogy minden váltás megközelítően egyenlő ideig tart. Ha 6-8 ms-ot látsz az IPS-en, akkor az nem egyenlő a TN és a VA 6-8 ms-ával. Sokkal jobb azoknál.Az gáz. Remélem ez a dinamikus kontraszt nem lesz állandóra alkalmazva. Felőlem fejleszthetnek erre, de legyen kikapcsolható.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

Mert forward renderingnél több vertex és pixel opciód lesz. A geometriát nem csak egyszer kell leszámolni, hanem többször is, ha a lightning fázis is ekkor kerül fel. A Deferred Renderrel ezektől a többszöri számításoktól mented meg magad. Lesz más probléma (AA és átlátszó felületek), de a DX11-gyel gyakorlatilag minden gond kezelhető.

(#8260) DemonDani: Azért tervezték ilyenre a Caymant, hogy vigye a játékok többségét 3x Full HD-ben is. Masszívan erre az igénybevételre van az egész rendszer kialakítva.

Ne feled, hogy a Deferred fázisok miatt, a játékok egy részében az MSAA hibás, vagy egyáltalán nincs benne a motorban. Az MSAA már nem megoldás. A fejlesztőknek kell az AA-t megoldani, és a motor igényeihez szabni. A Crysis 2 is erre épül. Az MSAA masszív probléma Deferred Shading mellett. A motor három algoritmust használ az AA-ra. Az egyik a közeli felületeken végez edge detect szűrést, majd egy post process shader az adatok alapján dolgozik. A távoli részek temporális szupermintákkal dolgozik, ami képminőségben kielégítő és gyors. Az maradék felületet egy MLAA fogja kezelni. Persze utóbbi nem biztos, hogy benne marad, ha igaz, hogy az NV befizetett.[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

Sokban függ ez az algoritmustól. Jelenleg eléggé jó minőségre fókuszálunk. Ha azt forward szinten csinálod meg, akkor az több teljesítménybe kerül, mint ha Deferred Rendert alkalmaznál. Carmack volt oda nagyon a Forward Renderingnél, és lényegében úgy vallotta, hogy elég az árnyékokhoz G-Buffert használni, ahogy az UE3 teszi. Azóta a hardverek fejlődtek, és átértelmeződtek az elméletek. Most már a Lightning fázist is Deferred algoritmussal érdemes megoldani, mert a megkívánt komplexitás és a geometriai váz részletességének növelése a forward algoritmusok teljesítményét jelentősen rontja. Deferred Renderingból is vannak eltérő elképzelések. Három megvalósítást különböztetünk jelenleg meg. Defered Shading, amikor a G-Buffer kimenetek között akár 6 fázis is lehet. Ez nagyon sávszélesség-igényes, de lehetővé teszi az virtuális anyag indexelését, ami sok információ tárolását teszi lehetővé pixelenként. A Partial és a Full Defered Lightning kevesebb információt tárol, vagyis kevesebb a sávszélességigény, de a kevesebb információ miatt limitáltak a felületi variációk. Ha jól tudom, akkor a full, legjobb esetben 96 bit/pixel, míg a partial 64 bit/pixel. Nyilván a Deferred Rendering terepén, olyan 130-140 bit/pixel elég lenne sokmindenre, de nincs meg a sávszélesség.

Ugye ebben még nincs benne a Deep G-Buffer, amire az AA-hoz és az átlátszó felületekhez szükség van. Gyakorlatilag a sávszélességproblémákra jelent majd megoldást a Frostbite 2 motorban alkalmazott Tile-based deferred acceleration, amit DirectCompute 5.0-ban írtak. Kihasználják a Local Data Share előnyeit, ami nagymértékben csökkenti a sávszélességigényt. Ezzel lényegében megszerzed a szükséges pixelenkénti információt anélkül, hogy kicsinálnád a kártya memóriaalrendszerét. Persze az AA-val itt is trükközni kell, mert szintén sok lesz az információ. Valami hibrid megvalósítás ajánlott. Tulajdonképpen annyira sok lehetőséget kínál a DX11, hogy bármilyen megoldást lehet találni. Az MLAA adja magát, és innentől pedig csak subpixel információkra van szükség, amire a legjobb a Super-Sampling, de elég lesz csak a közeli objektumokra alkalmazni, így megfogható a teljesítményigény.

Ugye ebben még nincs benne a Deep G-Buffer, amire az AA-hoz és az átlátszó felületekhez szükség van. Gyakorlatilag a sávszélességproblémákra jelent majd megoldást a Frostbite 2 motorban alkalmazott Tile-based deferred acceleration, amit DirectCompute 5.0-ban írtak. Kihasználják a Local Data Share előnyeit, ami nagymértékben csökkenti a sávszélességigényt. Ezzel lényegében megszerzed a szükséges pixelenkénti információt anélkül, hogy kicsinálnád a kártya memóriaalrendszerét. Persze az AA-val itt is trükközni kell, mert szintén sok lesz az információ. Valami hibrid megvalósítás ajánlott. Tulajdonképpen annyira sok lehetőséget kínál a DX11, hogy bármilyen megoldást lehet találni. Az MLAA adja magát, és innentől pedig csak subpixel információkra van szükség, amire a legjobb a Super-Sampling, de elég lesz csak a közeli objektumokra alkalmazni, így megfogható a teljesítményigény.

A Deferred Shading térnyerése egyre nagyobb, mert több érv szól mellette, mint ellene. Az, hogy ki milyen megvalósítást választ, az igényektől függ. A STALKER új verziós X-Ray motorja a hagyományos Defered Shading mellett dolgozik, a CryEngine 3 Partial Defered Lightningos. Ez tűnik egyébként jelenleg az arany középútnak a két véglet között, de a Tile-based deferred acceleration nagyon ígéretes, így könnyen befutó lehet hosszabb távon.[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

Statikus jelenet mellett egy GF110 7-8 fps-re képes az NVIDIA ray-tracing motorjával. Dinamikus jelenetnél ugyanez a minőség, még mindig másodpercekben mérhető képkockasebességet jelent. Egyelőre nagyon messze vagyunk a valós idejű ray-tracingtől, ha a raszterizálással elérhető minőséget meg akarjuk közelíteni. Nem számítanék rá, hogy ez 3 éven belül megváltozik.

Az AA piszok nagy para lesz akkor is. A hibrid megoldások jelentik csak a lehetőséget. Az MLAA és a hasonló ötletek önmagukban csak a tűzoltásra jók. Driverben nagy ötlet, de egy motor esetében sokkal több lehetőséged van.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

Egyelőre azt kellene megtudni, hogy melyik driverből származik az adat, mert az ominózus kiszivárgott driverben ez a két sor nem szerepel.

Itt az inf-ben található lista:

; NVIDIA Windows Vista / Windows 7 (64 bit) Display INF file

; Copyright (c) NVIDIA Corporation. All rights reserved.

[Version]

Signature = "$Windows NT$"

Provider = %NVIDIA%

ClassGUID = {4D36E968-E325-11CE-BFC1-08002BE10318}

Class = Display

DriverVer = 01/20/2011, 8.17.12.6677

CatalogFile = NV_DISP.CAT

.

.

[Strings]

DiskID1 = "NVIDIA Windows Vista / Windows 7 (64 bit) Driver Library Installation Disk 1"

NVIDIA = "NVIDIA"

NVIDIA_A = "NVIDIA"

NVIDIA_B = "NVIDIA "

NVIDIA_DEV.0040.01 = "NVIDIA GeForce 6800 Ultra"

NVIDIA_DEV.0041.01 = "NVIDIA GeForce 6800"

NVIDIA_DEV.0042.01 = "NVIDIA GeForce 6800 LE"

NVIDIA_DEV.0043.01 = "NVIDIA GeForce 6800 XE"

NVIDIA_DEV.0044.01 = "NVIDIA GeForce 6800 XT"

NVIDIA_DEV.0045.01 = "NVIDIA GeForce 6800 GT"

NVIDIA_DEV.0046.01 = "NVIDIA GeForce 6800 GT "

NVIDIA_DEV.0047.01 = "NVIDIA GeForce 6800 GS"

NVIDIA_DEV.0048.01 = "NVIDIA GeForce 6800 XT "

NVIDIA_DEV.004E.01 = "NVIDIA Quadro FX 4000"

NVIDIA_DEV.0090.01 = "NVIDIA GeForce 7800 GTX"

NVIDIA_DEV.0091.01 = "NVIDIA GeForce 7800 GTX "

NVIDIA_DEV.0092.01 = "NVIDIA GeForce 7800 GT"

NVIDIA_DEV.0093.01 = "NVIDIA GeForce 7800 GS"

NVIDIA_DEV.0095.01 = "NVIDIA GeForce 7800 SLI"

NVIDIA_DEV.009D.01 = "NVIDIA Quadro FX 4500"

NVIDIA_DEV.00C0.01 = "NVIDIA GeForce 6800 GS "

NVIDIA_DEV.00C1.01 = "NVIDIA GeForce 6800 "

NVIDIA_DEV.00C2.01 = "NVIDIA GeForce 6800 LE "

NVIDIA_DEV.00C3.01 = "NVIDIA GeForce 6800 XT "

NVIDIA_DEV.00CD.01 = "NVIDIA Quadro FX 3450/4000 SDI"

NVIDIA_DEV.00CE.01 = "NVIDIA Quadro FX 1400"

NVIDIA_DEV.00F1.01 = "NVIDIA GeForce 6600 GT"

NVIDIA_DEV.00F2.01 = "NVIDIA GeForce 6600"

NVIDIA_DEV.00F3.01 = "NVIDIA GeForce 6200"

NVIDIA_DEV.00F4.01 = "NVIDIA GeForce 6600 LE"

NVIDIA_DEV.00F5.01 = "NVIDIA GeForce 7800 GS "

NVIDIA_DEV.00F6.01 = "NVIDIA GeForce 6800 GS/XT"

NVIDIA_DEV.00F8.01 = "NVIDIA Quadro FX 3400/4400"

NVIDIA_DEV.00F9.01 = "NVIDIA GeForce 6800 Series GPU"

NVIDIA_DEV.0140.01 = "NVIDIA GeForce 6600 GT "

NVIDIA_DEV.0141.01 = "NVIDIA GeForce 6600 "

NVIDIA_DEV.0142.01 = "NVIDIA GeForce 6600 LE "

NVIDIA_DEV.0143.01 = "NVIDIA GeForce 6600 VE"

NVIDIA_DEV.0145.01 = "NVIDIA GeForce 6610 XL"

NVIDIA_DEV.0147.01 = "NVIDIA GeForce 6700 XL"

NVIDIA_DEV.014A.01 = "NVIDIA Quadro NVS 440"

NVIDIA_DEV.014C.01 = "NVIDIA Quadro FX 540M"

NVIDIA_DEV.014D.01 = "NVIDIA Quadro FX 550"

NVIDIA_DEV.014E.01 = "NVIDIA Quadro FX 540"

NVIDIA_DEV.014F.01 = "NVIDIA GeForce 6200 "

NVIDIA_DEV.0160.01 = "NVIDIA GeForce 6500"

NVIDIA_DEV.0161.01 = "NVIDIA GeForce 6200 TurboCache(TM)"

NVIDIA_DEV.0162.01 = "NVIDIA GeForce 6200SE TurboCache(TM)"

NVIDIA_DEV.0163.01 = "NVIDIA GeForce 6200 LE"

NVIDIA_DEV.0165.01 = "NVIDIA Quadro NVS 285"

NVIDIA_DEV.0169.01 = "NVIDIA GeForce 6250"

NVIDIA_DEV.016A.01 = "NVIDIA GeForce 7100 GS"

NVIDIA_DEV.0191.01 = "NVIDIA GeForce 8800 GTX"

NVIDIA_DEV.0193.01 = "NVIDIA GeForce 8800 GTS"

NVIDIA_DEV.0194.01 = "NVIDIA GeForce 8800 Ultra"

NVIDIA_DEV.0197.01 = "NVIDIA Tesla C870"

NVIDIA_DEV.019D.01 = "NVIDIA Quadro FX 5600"

NVIDIA_DEV.019E.01 = "NVIDIA Quadro FX 4600"

NVIDIA_DEV.01D0.01 = "NVIDIA GeForce 7350 LE"

NVIDIA_DEV.01D1.01 = "NVIDIA GeForce 7300 LE"

NVIDIA_DEV.01D3.01 = "NVIDIA GeForce 7300 SE/7200 GS"

NVIDIA_DEV.01DB.01 = "NVIDIA Quadro NVS 120M"

NVIDIA_DEV.01DD.01 = "NVIDIA GeForce 7500 LE"

NVIDIA_DEV.01DE.01 = "NVIDIA Quadro FX 350"

NVIDIA_DEV.01DF.01 = "NVIDIA GeForce 7300 GS"

NVIDIA_DEV.0211.01 = "NVIDIA GeForce 6800 "

NVIDIA_DEV.0212.01 = "NVIDIA GeForce 6800 LE "

NVIDIA_DEV.0215.01 = "NVIDIA GeForce 6800 GT "

NVIDIA_DEV.0218.01 = "NVIDIA GeForce 6800 XT "

NVIDIA_DEV.0221.01 = "NVIDIA GeForce 6200 "

NVIDIA_DEV.0222.01 = "NVIDIA GeForce 6200 A-LE"

NVIDIA_DEV.0240.01 = "NVIDIA GeForce 6150"

NVIDIA_DEV.0241.01 = "NVIDIA GeForce 6150 LE"

NVIDIA_DEV.0242.01 = "NVIDIA GeForce 6100"

NVIDIA_DEV.0245.01 = "NVIDIA Quadro NVS 210S / NVIDIA GeForce 6150LE"

NVIDIA_DEV.0290.01 = "NVIDIA GeForce 7900 GTX"

NVIDIA_DEV.0291.01 = "NVIDIA GeForce 7900 GT/GTO"

NVIDIA_DEV.0292.01 = "NVIDIA GeForce 7900 GS"

NVIDIA_DEV.0293.01 = "NVIDIA GeForce 7950 GX2"

NVIDIA_DEV.0294.01 = "NVIDIA GeForce 7950 GX2 "

NVIDIA_DEV.0295.01 = "NVIDIA GeForce 7950 GT"

NVIDIA_DEV.029C.01 = "NVIDIA Quadro FX 5500"

NVIDIA_DEV.029D.01 = "NVIDIA Quadro FX 3500"

NVIDIA_DEV.029E.01 = "NVIDIA Quadro FX 1500"

NVIDIA_DEV.029F.01 = "NVIDIA Quadro FX 4500 X2"

NVIDIA_DEV.02E0.01 = "NVIDIA GeForce 7600 GT"

NVIDIA_DEV.02E1.01 = "NVIDIA GeForce 7600 GS"

NVIDIA_DEV.02E2.01 = "NVIDIA GeForce 7300 GT"

NVIDIA_DEV.02E3.01 = "NVIDIA GeForce 7900 GS "

NVIDIA_DEV.02E4.01 = "NVIDIA GeForce 7950 GT "

NVIDIA_DEV.0390.01 = "NVIDIA GeForce 7650 GS"

NVIDIA_DEV.0391.01 = "NVIDIA GeForce 7600 GT "

NVIDIA_DEV.0392.01 = "NVIDIA GeForce 7600 GS "

NVIDIA_DEV.0393.01 = "NVIDIA GeForce 7300 GT "

NVIDIA_DEV.0394.01 = "NVIDIA GeForce 7600 LE"

NVIDIA_DEV.0395.01 = "NVIDIA GeForce 7300 GT "

NVIDIA_DEV.039E.01 = "NVIDIA Quadro FX 560"

NVIDIA_DEV.03D0.01 = "NVIDIA GeForce 6150SE nForce 430"

NVIDIA_DEV.03D1.01 = "NVIDIA GeForce 6100 nForce 405"

NVIDIA_DEV.03D2.01 = "NVIDIA GeForce 6100 nForce 400"

NVIDIA_DEV.03D5.01 = "NVIDIA GeForce 6100 nForce 420"

NVIDIA_DEV.03D6.01 = "NVIDIA GeForce 7025 / NVIDIA nForce 630a"

NVIDIA_DEV.0400.01 = "NVIDIA GeForce 8600 GTS"

NVIDIA_DEV.0401.01 = "NVIDIA GeForce 8600 GT"

NVIDIA_DEV.0402.01 = "NVIDIA GeForce 8600 GT "

NVIDIA_DEV.0403.01 = "NVIDIA GeForce 8600 GS"

NVIDIA_DEV.0404.01 = "NVIDIA GeForce 8400 GS"

NVIDIA_DEV.0406.01 = "NVIDIA GeForce 8300 GS"

NVIDIA_DEV.040A.01 = "NVIDIA Quadro FX 370"

NVIDIA_DEV.040E.01 = "NVIDIA Quadro FX 570"

NVIDIA_DEV.040F.01 = "NVIDIA Quadro FX 1700"

NVIDIA_DEV.0410.01 = "NVIDIA GeForce GT 330"

NVIDIA_DEV.0420.01 = "NVIDIA GeForce 8400 SE"

NVIDIA_DEV.0421.01 = "NVIDIA GeForce 8500 GT"

NVIDIA_DEV.0422.01 = "NVIDIA GeForce 8400 GS "

NVIDIA_DEV.0423.01 = "NVIDIA GeForce 8300 GS "

NVIDIA_DEV.0424.01 = "NVIDIA GeForce 8400 GS "

NVIDIA_DEV.042C.01 = "NVIDIA GeForce 9400 GT"

NVIDIA_DEV.042F.01 = "NVIDIA Quadro NVS 290"

NVIDIA_DEV.053A.01 = "NVIDIA GeForce 7050 PV / NVIDIA nForce 630a"

NVIDIA_DEV.053B.01 = "NVIDIA GeForce 7050 PV / NVIDIA nForce 630a "

NVIDIA_DEV.053E.01 = "NVIDIA GeForce 7025 / NVIDIA nForce 630a "

NVIDIA_DEV.05E0.01 = "NVIDIA GeForce GTX 295"

NVIDIA_DEV.05E1.01 = "NVIDIA GeForce GTX 280"

NVIDIA_DEV.05E2.01 = "NVIDIA GeForce GTX 260"

NVIDIA_DEV.05E3.01 = "NVIDIA GeForce GTX 285"

NVIDIA_DEV.05E6.01 = "NVIDIA GeForce GTX 275"

NVIDIA_DEV.05E7.01 = "NVIDIA Tesla C1060"

NVIDIA_DEV.05E7.02 = "NVIDIA Tesla T10 Processor"

NVIDIA_DEV.05E7.03 = "NVIDIA Tesla C1060 "

NVIDIA_DEV.05E7.04 = "NVIDIA Tesla T10 Processor "

NVIDIA_DEV.05E7.05 = "NVIDIA Tesla M1060"

NVIDIA_DEV.05E7.06 = "NVIDIA Tesla M1060 "

NVIDIA_DEV.05E7.07 = "NVIDIA Tesla M1060 "

NVIDIA_DEV.05EA.01 = "NVIDIA GeForce GTX 260 "

NVIDIA_DEV.05EB.01 = "NVIDIA GeForce GTX 295 "

NVIDIA_DEV.05F9.01 = "NVIDIA Quadro CX"

NVIDIA_DEV.05FD.01 = "NVIDIA Quadro FX 5800"

NVIDIA_DEV.05FE.01 = "NVIDIA Quadro FX 4800"

NVIDIA_DEV.05FF.01 = "NVIDIA Quadro FX 3800"

NVIDIA_DEV.0600.01 = "NVIDIA GeForce 8800 GTS 512"

NVIDIA_DEV.0601.01 = "NVIDIA GeForce 9800 GT"

NVIDIA_DEV.0602.01 = "NVIDIA GeForce 8800 GT"

NVIDIA_DEV.0603.01 = "NVIDIA GeForce GT 230"

NVIDIA_DEV.0604.01 = "NVIDIA GeForce 9800 GX2"

NVIDIA_DEV.0605.01 = "NVIDIA GeForce 9800 GT "

NVIDIA_DEV.0606.01 = "NVIDIA GeForce 8800 GS"

NVIDIA_DEV.0607.01 = "NVIDIA GeForce GTS 240"

NVIDIA_DEV.0610.01 = "NVIDIA GeForce 9600 GSO"

NVIDIA_DEV.0611.01 = "NVIDIA GeForce 8800 GT "

NVIDIA_DEV.0612.01 = "NVIDIA GeForce 9800 GTX/9800 GTX+"

NVIDIA_DEV.0613.01 = "NVIDIA GeForce 9800 GTX+"

NVIDIA_DEV.0614.01 = "NVIDIA GeForce 9800 GT "

NVIDIA_DEV.0615.01 = "NVIDIA GeForce GTS 250"

NVIDIA_DEV.0619.01 = "NVIDIA Quadro FX 4700 X2"

NVIDIA_DEV.061A.01 = "NVIDIA Quadro FX 3700"

NVIDIA_DEV.061B.01 = "NVIDIA Quadro VX 200"

NVIDIA_DEV.0622.01 = "NVIDIA GeForce 9600 GT"

NVIDIA_DEV.0623.01 = "NVIDIA GeForce 9600 GS"

NVIDIA_DEV.0625.01 = "NVIDIA GeForce 9600 GSO 512"

NVIDIA_DEV.0626.01 = "NVIDIA GeForce GT 130"

NVIDIA_DEV.0627.01 = "NVIDIA GeForce GT 140"

NVIDIA_DEV.062E.01 = "NVIDIA GeForce 9600 GT "

NVIDIA_DEV.062F.01 = "NVIDIA GeForce 9800 S"

NVIDIA_DEV.0635.01 = "NVIDIA GeForce 9600 GSO "

NVIDIA_DEV.0637.01 = "NVIDIA GeForce 9600 GT "

NVIDIA_DEV.0638.01 = "NVIDIA Quadro FX 1800"

NVIDIA_DEV.0640.01 = "NVIDIA GeForce 9500 GT"

NVIDIA_DEV.0641.01 = "NVIDIA GeForce 9400 GT "

NVIDIA_DEV.0643.01 = "NVIDIA GeForce 9500 GT "

NVIDIA_DEV.0644.01 = "NVIDIA GeForce 9500 GS"

NVIDIA_DEV.0645.01 = "NVIDIA GeForce 9500 GS "

NVIDIA_DEV.0646.01 = "NVIDIA GeForce GT 120"

NVIDIA_DEV.0658.01 = "NVIDIA Quadro FX 380"

NVIDIA_DEV.0659.01 = "NVIDIA Quadro FX 580"

NVIDIA_DEV.065B.01 = "NVIDIA GeForce 9400 GT "

NVIDIA_DEV.065F.01 = "NVIDIA GeForce G210"

NVIDIA_DEV.06C0.01 = "NVIDIA GeForce GTX 480"

NVIDIA_DEV.06C4.01 = "NVIDIA GeForce GTX 465"

NVIDIA_DEV.06CD.01 = "NVIDIA GeForce GTX 470"

NVIDIA_DEV.06E0.01 = "NVIDIA GeForce 9300 GE"

NVIDIA_DEV.06E1.01 = "NVIDIA GeForce 9300 GS"

NVIDIA_DEV.06E2.01 = "NVIDIA GeForce 8400"

NVIDIA_DEV.06E3.01 = "NVIDIA GeForce 8400 SE "

NVIDIA_DEV.06E4.01 = "NVIDIA GeForce 8400 GS "

NVIDIA_DEV.06E6.01 = "NVIDIA GeForce G100"

NVIDIA_DEV.06E7.01 = "NVIDIA GeForce 9300 SE"

NVIDIA_DEV.06E9.01 = "NVIDIA GeForce 9300M GS"

NVIDIA_DEV.06F8.01 = "NVIDIA Quadro NVS 420"

NVIDIA_DEV.06F9.01 = "NVIDIA Quadro FX 370 LP"

NVIDIA_DEV.06FA.01 = "NVIDIA Quadro NVS 450"

NVIDIA_DEV.06FD.01 = "NVIDIA Quadro NVS 295"

NVIDIA_DEV.06FF.01 = "NVIDIA HICx16 + Graphics"

NVIDIA_DEV.06FF.02 = "NVIDIA HICx8 + Graphics"

NVIDIA_DEV.07E0.01 = "NVIDIA GeForce 7150 / NVIDIA nForce 630i"

NVIDIA_DEV.07E1.01 = "NVIDIA GeForce 7100 / NVIDIA nForce 630i"

NVIDIA_DEV.07E2.01 = "NVIDIA GeForce 7050 / NVIDIA nForce 630i"

NVIDIA_DEV.07E3.01 = "NVIDIA GeForce 7050 / NVIDIA nForce 610i"

NVIDIA_DEV.07E5.01 = "NVIDIA GeForce 7050 / NVIDIA nForce 620i"

NVIDIA_DEV.0846.01 = "NVIDIA GeForce 9200"

NVIDIA_DEV.0847.01 = "NVIDIA GeForce 9100"

NVIDIA_DEV.0848.01 = "NVIDIA GeForce 8300"

NVIDIA_DEV.0849.01 = "NVIDIA GeForce 8200"

NVIDIA_DEV.084A.01 = "NVIDIA nForce 730a"

NVIDIA_DEV.084B.01 = "NVIDIA GeForce 9200 "

NVIDIA_DEV.084C.01 = "NVIDIA nForce 980a/780a SLI"

NVIDIA_DEV.084D.01 = "NVIDIA nForce 750a SLI"

NVIDIA_DEV.084F.01 = "NVIDIA GeForce 8100 / nForce 720a"

NVIDIA_DEV.0860.01 = "NVIDIA GeForce 9400"

NVIDIA_DEV.0861.01 = "NVIDIA GeForce 9400 "

NVIDIA_DEV.0864.01 = "NVIDIA GeForce 9300"

NVIDIA_DEV.0865.01 = "NVIDIA ION"

NVIDIA_DEV.0868.01 = "NVIDIA nForce 760i SLI"

NVIDIA_DEV.086A.01 = "NVIDIA GeForce 9400 "

NVIDIA_DEV.086C.01 = "NVIDIA GeForce 9300 / nForce 730i"

NVIDIA_DEV.086D.01 = "NVIDIA GeForce 9200 "

NVIDIA_DEV.0871.01 = "NVIDIA GeForce 9200 "

NVIDIA_DEV.0874.01 = "NVIDIA ION "

NVIDIA_DEV.0876.01 = "NVIDIA ION "

NVIDIA_DEV.087A.01 = "NVIDIA GeForce 9400 "

NVIDIA_DEV.087D.01 = "NVIDIA ION "

NVIDIA_DEV.087E.01 = "NVIDIA ION LE"

NVIDIA_DEV.087F.01 = "NVIDIA ION LE "

NVIDIA_DEV.0A20.01 = "NVIDIA GeForce GT 220"

NVIDIA_DEV.0A23.01 = "NVIDIA GeForce 210"

NVIDIA_DEV.0A60.01 = "NVIDIA GeForce G210 "

NVIDIA_DEV.0A62.01 = "NVIDIA GeForce 205"

NVIDIA_DEV.0A64.01 = "NVIDIA ION "

NVIDIA_DEV.0A65.01 = "NVIDIA GeForce 210 "

NVIDIA_DEV.0A78.01 = "NVIDIA Quadro FX 380 LP"

NVIDIA_DEV.0CA0.01 = "NVIDIA GeForce GT 330 "

NVIDIA_DEV.0CA2.01 = "NVIDIA GeForce GT 320"

NVIDIA_DEV.0CA3.01 = "NVIDIA GeForce GT 240"

NVIDIA_DEV.0CA4.01 = "NVIDIA GeForce GT 340"

NVIDIA_DEV.0CA5.01 = "NVIDIA GeForce GT 220 "

NVIDIA_DEV.0CA7.01 = "NVIDIA GeForce GT 330 "

NVIDIA_DEV.0CAC.01 = "NVIDIA GeForce GT 220 "

NVIDIA_DEV.0DC4.01 = "NVIDIA GeForce GTS 450"

NVIDIA_DEV.0DE0.01 = "NVIDIA GeForce GT 440"

NVIDIA_DEV.0DE1.01 = "NVIDIA GeForce GT 430"

NVIDIA_DEV.0E22.01 = "NVIDIA GeForce GTX 460"

NVIDIA_DEV.0E23.01 = "NVIDIA GeForce GTX 460 SE"

NVIDIA_DEV.1080.01 = "NVIDIA GeForce GTX 580"

NVIDIA_DEV.1081.01 = "NVIDIA GeForce GTX 570"

NVIDIA_DEV.1086.01 = "NVIDIA GeForce GTX 570 "

NVIDIA_DEV.10C0.01 = "NVIDIA GeForce 9300 GS "

NVIDIA_DEV.10C3.01 = "NVIDIA GeForce 8400GS"

NVIDIA_DEV.1200.01 = "NVIDIA GeForce GTX 560 Ti"[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

-

Abu85

HÁZIGAZDA

válasz

gainwardgs

#8317

üzenetére

gainwardgs

#8317

üzenetére

Meg kell várni az idei GTC-t, akkor beszélnek róla először. Addig csak elcsípet információfoszlányom vannak. Az biztos, hogy érdemes sietni, mert az Intel is hozza a Knights Cornert.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

-

Abu85

HÁZIGAZDA

Arra. Annyira nem számít amúgy a dolog. Ezen a piacon már lehet bakizni, ez a jövő szempontjából mindegy, csak a bevétel nem az.

Az AMD sem a legnagyobbal kezd. A HD 6000 óta változtattak. Szerintem most is így lesz.

Véleményem szerint mindkét gyártónál előnybe kerül a mobil termékskála, így most először az MXM modulok jönnek és utána az asztali VGA-k.[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

A PCI Express 3.0 egyik tényleges előnye, hogy a CPU beleírhat a VRAM-ba. Más nincs. A sávszélesség nő, de a késleltetés a fizikai távolság miatt marad. Igazából a késleltetéssel van a probléma.

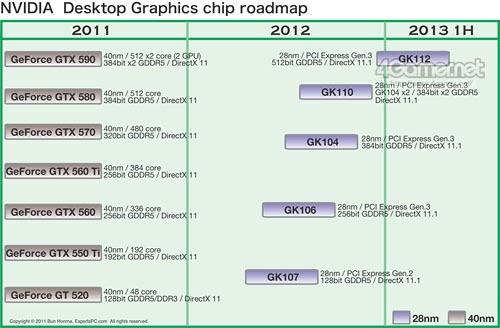

Elárulom neked a felületes NV útitervet, úgyis téma ez a topikban. A 2013-as üzleti évre vonatkozó adatok alapján: Q1 - első 28 nm-es GeForce (Kepler, GK107 valszeg), Q2 - új Quadro (Kepler), Q3 - új Tesla (Kepler), Q4 - Tegra 4. Tekintve, hogy üzleti évről van szó, így a 2012 februártól 2013 februárjáig értendő az egész.

A 2013-as üzleti évre vonatkozó adatok alapján: Q1 - első 28 nm-es GeForce (Kepler, GK107 valszeg), Q2 - új Quadro (Kepler), Q3 - új Tesla (Kepler), Q4 - Tegra 4. Tekintve, hogy üzleti évről van szó, így a 2012 februártól 2013 februárjáig értendő az egész.[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

Elég sok, ha heterogén módon fut a program. Ezt majd ki lehet használni. Nyilván program oldaláról kell a támogatás, így az elején semmi előny nem lesz a PCI Express 3.0.

Az alaplapgyártóknál a PCI Express 3.0 csak egy újabb fícsőr, vagy nagyobb szám, amit a dobozta írhatnak. Ez a marketing. Néha gusztustalan, de ez a piac része.

Persze. A PCI Express 3.0-s VGA nem árt a fícsőrök kihasználásához.

Engem nem kevésbé, de hát csak ennyi van. Ha több lenne elmondanám.

Nem tudom, hogy a Maxwell minek a része lesz. Valszeg külön termékskálát kap, de 2014 előtt nem hiszem, hogy itt lesz. A Tegra inkább megmarad mobil terméknek. A Maxwell nagy fogyasztással rendelkező szerverbe szánt lapka, amiből lesz asztali modell is.Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

A heterogén módon működő progiknál lesz ennek előnye ... OpenCL és C++ AMP-ben. Szimplán gyorsító funkció. Feladattól függően általános előny lehet. Annyira sokat persze nem kell várni tőle. Nem csodafícsőr ez, csak segít.

Szerintem a Tegra 4-ből már lesz asztalra is. Amilyen gyorsan esik össze a VGA-piac kell valami, ami a részesedésben 15% fölött tartja az NV-t. Erre az asztali Tegra 4 nettopba és All-In-One gépbe nagyon jó lehet. Akár még 20% fölé is vissza lehet térni, az nagy eredmény lenne. Többet valszeg a Maxwellig nem remélnek. Persze az is kérdés, hogy a piac hogyan rendeződik át a kutatások szempontjából, mert ha az elemzők elkezdik beszámolni a táblákat a negyedéves eredményekbe, akkor simán hozható a 20%-os részesedés. Ez még nagy talány.

Igen a Maxwell az egy ARM processzormagokra épülő APU lesz. 2014-ben lehet belőle valami. A Project Denver magokat használja, vagyis az NV saját fejlesztésű megoldását. A VGA rész kérdéses. A nextgen konzoloktól sok függ, de 2014 után valószínűleg ez a piac egy elhanyagolható rész lesz, mint most a hangkártyák. Le lehet fedni, de nem biztos, hogy érdemes. Ez még később kiderül. Az biztos, hogy a prioritás az APU, mert az új konzolokra írt játékokat ezzel lehet normálisan kiszolgálni.

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

schwartz

#8340

üzenetére

schwartz

#8340

üzenetére

Ajánlott, de nem kötelező. Itt az is kérdés, hogy ki használják-e a Kepler virtuális memóriára vonatkozó támogatását. Egyelőre erre csak a Rage-nek lenne szüksége, mondjuk annak nagyon.

Szerintem még ne válts. Nincs még teljes kép arról, hogy a programok miképp támogatják ezt a fícsört. Ugye itt az elméleten túl gyakorlatban is kell támogatás, vagyis a programba kell építeni, különben nem lesz használva. Aztán a program fejlesztőjénél is kérdés, hogy mit választ. Egyelőre két elméleti opció van erre, de gyakorlatban még nincs semmi. Ezért sincs előírva kötelezően a virtuális memóriára vonatkozó támogatás. Az is kérdés, hogy mennyit segít ez egy VGA-n. Az APU-kon nagy eséllyel dob, de egy VGA-n már kérdéses. Sok még az ismeretlen faktor sajnos.

Szerintem az egésznek akkor lesz nagyobb jelentősége, ha az integráció komolyabb szintre fejlődik. 2013-2014 körül.(#8341) coonee: A Sandy-E procikra nem érdemes várni. Az első verziók nem lesznek jók. A második verziók jövőre jönnek. Inkább vegyél egy sima i5-ös Sandy Bridge-et. A K nélküli verziók azokból is támogatják a VT-d-t.

Az, hogy mennyiben lesznek a Kepleresek megrövidítve attól függ, hogy hány program készül majd, ami kihasználja az új GPU-k esetében a virtuális memória elérését. Ha nem lesz ilyen program (mert ez is előfordulhat), akkor semmiben. A PCI Express 3.0 a sebesség szempontjából nem olyan lényeges. A funkciókból viszont hasznos, ha a proci írhatja és olvashatja a VRAM-ot. De ehhez is program oldali támogatás kell. Vagyis, ha nem lesz rá program, akkor csak értékes funkció lesz, amit nem használnak ki.[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

A 4Gamer korábban már mellélőtt. Pl.: [link] - nem minden termékkel, de párral igen (ezt a GF110 shadereinek számából is látni lehet).

Lehet, hogy bemákolják ezt a kört, de szvsz nem. Most csak abból indulok ki, hogy egy gyártópartner nem tudja, hogy mi lesz 2012 második felében, szóval honnan tudhatná a 4Gamer. Az meg a másik dolog, hogy kétkártyás VGA-nak sosem volt kódneve. Persze ez lehet, hogy változik, mert teljesen világos, hogy a 9800GX2-őt, a GTX 295-öt és a GTX 590-et is a kényszer szülte. Azt el tudom képzelni, hogy az NV most terv szerint készül az AMD stratégiájára egy termékkel.

Most csak abból indulok ki, hogy egy gyártópartner nem tudja, hogy mi lesz 2012 második felében, szóval honnan tudhatná a 4Gamer. Az meg a másik dolog, hogy kétkártyás VGA-nak sosem volt kódneve. Persze ez lehet, hogy változik, mert teljesen világos, hogy a 9800GX2-őt, a GTX 295-öt és a GTX 590-et is a kényszer szülte. Azt el tudom képzelni, hogy az NV most terv szerint készül az AMD stratégiájára egy termékkel.Nekem egészséges fenntartásaim vannak azzal a képpel. A GK107-et (kb-s időpont szintjén) meg tudom erősíteni, mert én is hallottam, és eléggé jó forrásból (konkrétan gyártótól), de a többit csak kétségekkel nézzétek. GK106-ról még nem hallottam. GK112-ről meg pláne nem. Mondjuk ettől még lehet, hogy készülnek, de ha a GK106 ennyire hamar jön, akkor valszeg már tudnék róla, mivel a GK104-ről és a GK110-ről tudok. (utóbbi kettőről tényleg csak annyit, hogy jönnek.)

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

gainwardgs

#8374

üzenetére

gainwardgs

#8374

üzenetére

Olyanból már több is van.

A Keplerről csak pletyik vannak, és addig ennyi lesz, amíg az NV nem küld hivatalos adatokat a partnereknek. Ezek szoktak szivárogni.

A pletyik napi szinten változnak. Ma például az a hír járja, hogy dobják az IMR-t, és TBDR-re váltanak.Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

gainwardgs

#8376

üzenetére

gainwardgs

#8376

üzenetére

A feldolgozás menetéhez van köze. Az IMR egy számítások szempontjából pazarló architektúra, de ha van elég memória, akkor lehet, hogy jobb opció többet számolni, és utána eldobni a dolgokat, mint előre kiszámolni, hogy melyik számítás hasznos. A TBR és TBDR ilyen, vagyis nincs felesleges számítás, így spórol a memóriával. A mobil szinten ez hasznos, mert ott korlátozott ez a terület. Persze ez közel sem jelenti, hogy kevesebbet számol, csak a számítások nagyon nagy része hasznos.

Tulképp az IMR a pazarló megközelítés, míg a TBR/TBDR a spórolós. Arról sok vita van, hogy melyik a jobb. Mindegyiknek vannak erős és gyenge pontjai.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

peterm711

#8385

üzenetére

peterm711

#8385

üzenetére

Tőlük azért ne várt el, hogy idő előtt szivárogtassanak.

Van egy útitervük, amihez tartják magukat. Azt vagy teljesítik, vagy nem. Ettől függetlenül a megjelenés előtt nem fognak konkrétumot mondani.

Van egy útitervük, amihez tartják magukat. Azt vagy teljesítik, vagy nem. Ettől függetlenül a megjelenés előtt nem fognak konkrétumot mondani.

Egyébként már mondtam, hogy ezen a generáción már nem múlik semmi. Sokkal fontosabb felkészülni a platformharcra. Ahogy látom a GCN architektúrát, és hallom a Kepler előzeteseket, mindkét cég így gondolkodott. Ez a csata beáldozható, ha ez a háborúban előnyösebb pozíciót eredményez.

Ez most olyan langyos bemelegítés. Ha nyer valaki akkor is kit érdekel. Nyert egy éves szinten 30%-os visszaesést produkáló piacon. Már nem lényeg. A pénz nem itt van.[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

Angel1981

#8387

üzenetére

Angel1981

#8387

üzenetére

A gyártók remélik, hogy nem, de most áremelés kell ahhoz, hogy a piac gazdaságossan működjön tovább. Az, hogy a kategóriák árazása inkább nő nem a piac eladásait fogja erősíteni. Szerintem, ha most alá lehetne írni 2012-re a stagnálást, akkor megtennék.

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

schwartz

#8389

üzenetére

schwartz

#8389

üzenetére

A fejlesztés lényegi értelme már nem a GPU volt, hanem az integráció. Ugyanígy gondolkodik a Keplerrel az NV is. [link] A GTC Asia-n ez volt a téma, hogy a Kepler és a Maxwell esetében az integráció volt a fontos. Valójában már nem számít a VGA-piac. Ha jó lesz, akkor jó lesz, de a legfontosabb, hogy az integráció jó legyen, mert az egy zsíros piac. A GCN ebből a szempontból új. Alapvetően nem is GPU, hanem kinézetre inkább egy RISC-alapú processzor. [link] például ilyen brutális cacheszervezés nem kell egy tradicionális GPU-ba, de nyilván itt már az a cél, hogy a GPU átvegye az általános számításokban a szerepet. Ezt a modellt példázza, hogy a GCN már ugyanazokat a 64 bites pointereket támogatja, mint egy AMD64-es processzor, és képes címfordításra az AMD64-es címtéren belül, emellett támogatja az x86 virtuális memóriát. Ez egy GPU-ba alapvetően nem kell, de a fúzióban nagyon is fontos szempontok. Az NVIDIA is erre megy, mivel a Maxwell már kap ARM Denver magokat. Az ARMv8-ra építenek, és támogatják ugyanazt, amit az AMD megoldása, csak ARM alapokon.

Az, hogy a Keplert megveri, vagy esetleg nem veri meg az aktuális Radeont már mindegy. Ez a piac éves szinten komoly visszaesést produkál. Az IGP növekszik, és ott kell erősíteni. Természetesen az AMD és az NV akarja a dGPU-kat, mert hátha megmenthető a piac. Éppen ezért lesznek olyan változtatások, hogy a dGPU-k értékesek maradjanak. Ez persze olyan dolgokat von maga után, hogy a rendszer platformban tud majd minden funkciót. Vagyis, ha AMD mellé veszel Radeont, akkor jóval több funkciót kapsz, mint ha Intel mellé vennéd meg. Ugyanígy az NV-nél is. Ha a saját ARM-os rendszerek mellé veszed a GeForce-ot, akkor jár az összes szolgáltatás, szemben az x86/AMD64-es processzorokkal. Ez egy értékes reform lehet. A dGPU a platform kiegészítőjévé válik, nem pedig a PC elemévé. Az Intelnek is van erre reakciója a Larrabee-vel, de ők úgy gondolják, hogy ezt nem kell kihozni, mert a VGA-piac összezsugorodik, és a hangkártyák jelentőségi szintjére süllyed. Azt nyilván nem mondom, hogy évi 30%-os visszaesés mellett nem ennek van nagyobb esélye, azaz az Intel alapvetően jól látja, hogy a VGA-k felvirágzásának kevés esélye van. Persze, ha tévednek, akkor pár hónapon belül le lehet hozni PC-s VGA-nak a HPC-be szánt aktuális Knights terméket. Ez nyilván majd az Intel procikkal fog minden szolgáltatást támogatni. Valószínű, hogy a Knights Ferry elhasalásával a driverek fejlesztésével nem álltak le, mert a Knights termékek jók lehetne professzionális szintre. A HPC jelent prioritást, de ha már kész a hardver, akkor minimum egy esélyt érdemel a profi piac. Igazából ez ilyen mit veszíthetnek kategória. Persze az Intel a Larrabee-s gubanccal csúszott az útiterv szintjén. A Haswellben már Larrabee-nek kellene lenni, de helyette az Ivy Bridge IGP-jét kell kozmetikázni, valszeg nem merik megkockáztatni a Larrabee-t. Ezzel az architekturális integrációjuk 2015-re csúszott. Esetleg, ha elég tökösek, akkor a 14 nm bevezetésénél bevágják a Larrabeet, de kockázatosnak tűnik egy új terepen ekkorát változtatni. Persze nyilván meg lehet lépni.Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

gainwardgs

#8393

üzenetére

gainwardgs

#8393

üzenetére

OBR, Fuad, esetleg Theo?

Lehet, hogy egy GPU-t talán átültetnek a Fermiből, ez logikusnak is tűnik, de a teljes szériát biztos nem.

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

schwartz

#8396

üzenetére

schwartz

#8396

üzenetére

Egy CPU-n nagyságrendekkel nagyobb haszon van, mint egy VGA-n. Már csak a termékek méretéből látszik, hogy melyikhez kell jóval több anyag.

Egyébként a VIA egy speciális területéből él a piacnak, vagyis amit aprópénzért legyártanak, azt baromira drágán adják tovább. A konzumer réteg nem fog azért zsebbe nyúlni, mert esetleg egy gép tökéletesen üzemképes -30°C-on is.

Egyébként a VIA egy speciális területéből él a piacnak, vagyis amit aprópénzért legyártanak, azt baromira drágán adják tovább. A konzumer réteg nem fog azért zsebbe nyúlni, mert esetleg egy gép tökéletesen üzemképes -30°C-on is.

De amúgy írtam, hogy azon dolgoznak a gyártók, hogy a dGPU értékes maradjon, de ehhez olyan szolgáltatások kellenek, melyek főleg platformszinten használhatók ki. Azt kötve hiszem, hogy az NV és az AMD megakadályozza majd, hogy az Intel APU-khoz, vagy ha lesznek még, akkor CPU-khoz társítsd VGA-t, de ha nem platformot építesz korlátozásokat kapsz. Ezek nem mesterségesen kreáltak lesznek, hanem a hardver eltérő képességeiből adódnak majd. Például az NV x86 és AMD64 licenc nélkül képtelen ugyanazokat a pointereket használni, amiket az Intel és AMD processzorok. De ugyanígy lesz fordítva is. Ezért kap kiemelt szerepet a platform, mert az összes funkciót olyan hardverek kombinálásával lehet biztosítani, amelyeket egymáshoz terveztek.[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

schwartz

#8398

üzenetére

schwartz

#8398

üzenetére

Azon a gyártástechnológiákon, amin ők dolgoznak egy processzor tokozással együtt nem több pár dollárnál. Ezek nagyon pici lapkák, kevés pinnel, és BGA-féle tokozással A többit meg az ASRock rakja hozzá. A VIA-t az nem érdekli.

De mint mondtam a VIA alapvetően a beágyazott rendszerekből szerzi a pénzt. Ott is az extrém körülményekre tervezettből ... vízálló, fagyálló stb. Ezek komoly felárat jelentenek.Egy VGA esetében számolj sokkal nagyobb chippel, sokkal költségesebb tokozással, többszáz wattra felkészített VRM-mel, bonyolult NYÁK-kal, relatíve drága GDDR5 memóriával. Nem viccből akarnak itt a gyártók reformot.

A legtöbb haszon a belépőszintből jön, de arra ráhúzhatják a vizes lepedőt az erős IGP-kkel szemben. Nem is fejlesztik ezeket a megoldásokat, mert úgy sem tudják megverni az IGP-ket.

A legtöbb haszon a belépőszintből jön, de arra ráhúzhatják a vizes lepedőt az erős IGP-kkel szemben. Nem is fejlesztik ezeket a megoldásokat, mert úgy sem tudják megverni az IGP-ket.Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

OBR szopatja a népet. Ő rakta ki, hogy februárban lesz. Ez mára már nála is április. Sajna a régi poszt elveszett a /dev/null-ban.

Az új kiírásában már GTX 550-re lehet számítani februárban.

Az új kiírásában már GTX 550-re lehet számítani februárban.[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

huskydog17

#8402

üzenetére

huskydog17

#8402

üzenetére

Reggel már utánakérdeztem a Keplernek. Kb. mindenki mást mond. Ami megegyezik, hogy áprilisban lesz valami.

A GK104-ről neliz már írt. [link] - neki többnyire igaza szokott lenni.

Aztán van egy olyan pletyka, hogy TBR-re vált az NV, amit kétlek, de ki tudja. Szóval aki most leírja az igazat, annak gratulálok. Én is nekifogtam délelőtt egy hírnek, de nem tudtam eldönteni, hogy melyik variációt írjam bele. Úgy döntöttem inkább várok. Ha áprilisban tényleg lesz valami, akkor heteken belül megkapja egy csomó OEM a kártyákat. Az már azért elég jó esély a szivárgásra.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

huskydog17

#8404

üzenetére

huskydog17

#8404

üzenetére

Egyelőre igen. Én főleg neliz postja miatt ódzkodok tőle. Ő sokszor ír tényleg jót. De az biztos, hogy áprilisban lesz valami, mert az mindenkinél megegyezett.

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

huskydog17

#8406

üzenetére

huskydog17

#8406

üzenetére

Azt nem tudom. Én a Kepler iránt érdeklődtem. Arra mindenki áprilist mond. Az elképzelhető, hogy a Fermiből lesz egy-két új termék. Tekintve, hogy kínai újév lesz, így valószínű, hogy ha valami megjelenik, akkor az a jövőhéten fog. Utána legközelebb február végén.

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

Hakuoro

#8436

üzenetére

Hakuoro

#8436

üzenetére

Ez erős spekuláció szvsz, még többszöri olvasásra is nagyon kockázatos. Nem kérdés, hogy az Ageia hardvere anno jobb volt a fizika számítására. Sőt még ma is az, csak nem élvez terméktámogatást. A gond itt az, hogy megéri-e tranzisztorok százmillióit egy olyan egységre költeni, amit pár játék tud kihasználni. 2011-ben két olyan játék jelent meg, mely GPU-s PhysX-et támogat. A többi megjelenéshez viszonyítva, ez durván kevés. Ráadásul vedd hozzá, hogy az apple-to-apple összehasonlítás érdekében a PhysX-et szinte minden tesztben inaktiválják.

Az kétségtelenül tény, hogy manapság nagyon nehéz olyan GPU-t tervezni, ami minden egyes felmerült szempont szerint maximálisan megfelel a potenciális igényeknek. Ezek tipikusan a cGPU-k, amik hát olyanok, mint a GCN Radeon, vagyis a tranzisztor/teljesítmény aránya, sehol sem a legjobb, de szinte minden feladatban jó eredményt fog produkálni. Tipikusan grafikus számításra fejlesztett GPU-k a VLIW4/5 Radeonok. A Fermi valahol a kettő között van úgy félúton.

Nyilván a fejlesztések kihívása jelentős, mivel a mostani generációval olyan igényeket is le kell fedni, ami csak 2012-ben, vagy 2013-ban merül fel, és mindezt tedd meg úgy, hogy jó legyél grafikában, compute számításban, legyen a rendszer úgy ahogy gazdaságos, illetve készítsd elő az integrálásra. Na most ilyen elvi követelmények mellett én nem tartom jó ötletnek, hogy egy dedikált, kifejezetten egy adott körülményhez illesztet egység foglalja az értékes tranzisztorokat. Ha pedig ez csak a PhysX-et fogja gyorsítani, akkor egyértelműen pazarlás. Legalábbis a gamer szinten, mivel évente egy kézen meg lehet számolni az ezt támogató játékokat. A profi szinten a PhysX eléggé elterjedt, ott ennek nagy jelentősége lehet.

Azt tudom még elképzelni, hogy az NVIDIA már nem csak a PhysX-et veszi számításba, hanem a Bullettet is, amire egyre jobban építenek a konzolgyártók. Ez gyorsítható OpenCL-lel és DirectCompute-tal is (illetve a korábbi verziók mentek CUDA-n, talán ennek a beépítése nem megoldhatatlan feladat az új verziók esetében sem). Ennek viszont szerintem akkor lesz csak értelme, ha a CPU-magok mellé kerül be a GPU. Persze simán elképzelhető, hogy az NVIDIA a Keplerrel már erre készül, hiszen a VGA-k már nem számítanak nagy üzletnek. Sokkal fontosabb, hogy az integráció nagyon erős legyen. Ez opció lehet, csak nem biztos, hogy megéri most bevállalni, mert 2012-ben azért még elég nagy bevétele lesz az NV-nek a VGA-kból. Ok ... itt lehet azzal jönni, hogy a felsőkategória következmény nélkül feladható piac a maga 1-2%-os eladási rátájával, és ez igaz. Az is igaz, hogy főleg a notebookok piaca hozza majd a pénzt, de ott meg az IGP-k erősödése jelenti a kockázatot. Azt persze nem tudni, hogy az NVIDIA hogyan számolt a Tegrával, amikor a Keplert elkezdték fejleszteni. Lehet, hogy úgy kalkuláltak, hogy mára a Tegrának kellene eltartania a céget, de ez egyelőre nem történt meg. Tény, hogy növekszik a bevétel mobil vonalból, de nyereséget itt még nem láttak. A GPU-piac mondjuk abból a szempontból jól áll, hogy a nyereség zöme a 3D Visionből és az Intel negyedévenkénti komoly licencpénzéből van. Előbbi nehéz helyzetben van, mert az LG és a Samsung már nem támogatja, és kérdés, hogy a fejlesztők meddig fognak fizetni az SDK használatáért, látva, hogy egyre kevesebb olyan 3D-s monitor jelenik meg, ami kezeli a 3D Visiont, vagy esetleg felhozva a Windows 8-ban található Sztereó 3D SDK-t, mely egy szabványos megoldás. Itt érdemes feltenni a kérdést, hogy a 3D Vision meddig maradhat fizetős. Az Intel pénze persze megmarad.Egy szó, mint száz ... én ezt az Ageia integrálós dolgot nem tartom logikusnak. Megtörténhet, de nagyon sokat kellett inni a tervezés előtt, hogy a kockázatokról megfeledkezzenek a mérnökök.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

Hakuoro

#8442

üzenetére

Hakuoro

#8442

üzenetére

Röviden az a lényege, hogy ahol gyorsabb lesz ott gyorsabb lesz, ahol pedig nem ott nem.

Nem vagyok szenyó, így megmondom, hogy miről lehet tudni, vagy miről tudok. A Compalnak vannak kepleres MXM moduljai, amiket éppen tesztelnek. Semmi kép, vagy más infó. Illetve még az, hogy a tervek szerint GeForce GTX 660M és 675M lesz a termékek neve. Ennyi.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

schwartz

#8450

üzenetére

schwartz

#8450

üzenetére

Szerintem itt a THQ-val van baj. Már régóta téma, hogy financiális nehézségekkel küszködnek. Valószínű, hogy pár projektet átütemeznek, illetve leállítanak. Attól függ, hogy mennyire van kész a program a debütálásra. Gondolom a Metro: Last Light nincs kész, és félbehagyva, bugosan nem akarják kiadni (ami véleményem szerint jó döntés). Ezért a csúszás. Felelőst keresni ezért szerintem felesleges. De ha akarsz, akkor én a THQ vezetőségét jelölném meg szigorúan szvsz.

Valószínűsítem, hogy úgy spórolnak, hogy a futó projektektől is elveszik az erőforrást. Ez akár a munkaerő csökkentésével is jár. Attól függően, hogy mi a legjobb megoldás a cég és a készülő projektek számára. Ezek komplex kérdések, belsőleg az anyagi tartalékokkal tisztában van a vezetőség, így ők jobban látnak.[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

Nyilván nem mondhatják azt, hogy a konzolpiac virágzik, a PC-n már csak a mainstream réteg értékes, akiket kiszolgálnak az IGP-k, illetve azt sem, hogy 30%-ot estek a VGA-k eladásai egy év alatt.

Az a jó ezekben a kimutatásokban és eredményekben, hogy mindent meg lehet magyarázni. Figyeld meg, hogy ha most valaki az előrejelzettnél gyengébb negyedévet csinál a várt bevételek szempontjából, akkor ráfogja majd a HDD-piacra, és a thaiföldi áradásokra. Még akkor is, ha köze sincs hozzá, de ez egy jó kifogás. Hülyébb befektetők még be is szívják, hogy biztos azért történt.

Magyarázhat az NV és az AMD a PC-s piac előnyeiről, és a hardcore játékokra való igényről, mert csak úgy kell formálni a statisztikát, hogy ezt kimutassák, de azt nem tudják megmagyarázni, hogy például a CoD: MW3 összeladásainak miért csak 2-3%-a PC-s.[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

schwartz

#8464

üzenetére

schwartz

#8464

üzenetére

Minden olyan adat, ami külön shader clockkal számol erősen kétséges. Ezt a modellt az NVIDIA elveti. Az Echelonban sincs benne. Túl sok tranzisztorba kerül a magas órajel, és még nehezen gyárthatóvá is teszi a lapkát, ráadásul borzalmas fogyasztást eredményezhet. Jobb opciót jelentenek a multiprecíziós vektortömbök kisebb órajellel.

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

schwartz

#8495

üzenetére

schwartz

#8495

üzenetére

Én speciel nem tudok erről semmit, de szerintem logikus, hogy lesz ilyen fícsőr a Kepler generációban. Annyira nem nehéz ezt megoldani. Nem is tudom, hogy a GF11x termékekbe miért nem került be. De mindegy a következő frissítésre ez már alap lesz.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

Pletykánál többet úgy sem kapsz. Meg kell várni, amíg a gyártóktól jön szivárgás.

[link] - itt van esetleg egy érdekes hozzászólás. NVGreg ... fogalmam sincs ki ő, de azt írja, hogy az összes adat fake, és várjunk türelmesen. A szövegkörnyezetből úgy tűnik, mintha NV-s lenne, bár ide bárki írhat bármit.[link] - Itt van egy Aida szivárgás pl. ... Ez azt mondja, hogy a GTX 670M és 675M GF114M GPU lesz. Az kérdéses, hogy marad-e a 40 nm, vagy csinálnak egy 28 nm-es shrink-et a GF114-es Fermiből.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

schwartz

#8501

üzenetére

schwartz

#8501

üzenetére

Pedig ebben igaza van bárki is ő. Most, ha azt várják az emberek, hogy lesz egy 50-60%-kal gyorsabb termék, de ebből 10-20% lesz meg, akkor azt sokan csalódásnak fogják értékelni. Ezért nem írok meg semmit, ami nem biztos. Egyszerűen hiába írom bele a hírbe, hogy pletyka, azt sokat nem értelmezik.

Feltolni az elvárásokat a lehető legrosszabb dolog, ami egy céggel történhet. Magas igények mellett úgy is el lehet bukni, ha maga a termék esetleg jó.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

KillerKollar

#8504

üzenetére

KillerKollar

#8504

üzenetére

Én megmondom nektek, hogy speckókat még nem láttam. Ha láttam volna, akkor már lenne hír.

Arról az oldalról azt tudom mondani, hogy alaposan mellé lőtt a Cape Verde speckókkal. Így már nem vennék mérget rá, hogy ezzel betalálnak.Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

KillerKollar

#8506

üzenetére

KillerKollar

#8506

üzenetére

Dehogy. Semmit sem fognak belőle a játékok alatt érezni.

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

Ezek csak pletykák, mivel a gyártók még nem kaptak terméket. Következésképpen senki sem tud mérni, mert nincs olyan helyen kártya, ahonnan szivárogna valami.

Sok vérfan azt hiszi, hogy ezzel nagyon jót csinál az NV-nek, de közben szépen tolják fel az igényeket. Most az a helyzet, hogy az NV 300 dollárért kínál majd olyat, ami 30%-kal gyorsabb mindennél. Olyan szintre tolják az igényeket, hogy ebből akkor is oltári bukás lesz, ha a termék amúgy tökéletesen megállná a helyét.Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

válasz

schwartz

#8510

üzenetére

schwartz

#8510

üzenetére

Ez nem úgy működik, hogy csak a ROP. A shaderek zabálják le a sávszélt. Azokat kell etetni. A BF3 persze tipikusan a számítási teljesítményre helyezi a hangsúlyt, mert olyan rendszert használ, ami kíméli a sávszélt. Egy dolgot nem kímél, mégpedig a VRAM használatot. A 32 Color ROP-ot mindig érdemes a raszterizáló teljesítményéhez igazítani. Ettől függ főleg a ROP etetése.

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

Új hozzászólás Aktív témák

A topikban az OFF és minden egyéb, nem a témához kapcsolódó hozzászólás gyártása TILOS!

MIELŐTT LINKELNÉL VAGY KÉRDEZNÉL, MINDIG OLVASS KICSIT VISSZA!!

A topik témája:

Az NVIDIA éppen érkező, vagy jövőbeni új grafikus processzorainak kivesézése, lehetőleg minél inkább szakmai keretek között maradva. Architektúra, esélylatolgatás, érdekességek, spekulációk, stb.

- LEGO klub

- Politika

- Na, még egyszer, csak ezúttal OnePlus Open néven

- Honor Magic5 Pro - kamerák bűvöletében

- Itt az első kép a 2024-es Nokia 3210-ről

- Mibe tegyem a megtakarításaimat?

- eBay-es kütyük kis pénzért

- Xbox Series X|S

- NFL és amerikai futball topik - Spoiler veszély!

- OLED TV topic

- További aktív témák...

Egyébként nem professzionális monitorokról beszélünk. 80-100k-ért kapsz IPS-es monitort.

Egyébként nem professzionális monitorokról beszélünk. 80-100k-ért kapsz IPS-es monitort.

Most csak abból indulok ki, hogy egy gyártópartner nem tudja, hogy mi lesz 2012 második felében, szóval honnan tudhatná a 4Gamer. Az meg a másik dolog, hogy kétkártyás VGA-nak sosem volt kódneve. Persze ez lehet, hogy változik, mert teljesen világos, hogy a 9800GX2-őt, a GTX 295-öt és a GTX 590-et is a kényszer szülte. Azt el tudom képzelni, hogy az NV most terv szerint készül az AMD stratégiájára egy termékkel.

Most csak abból indulok ki, hogy egy gyártópartner nem tudja, hogy mi lesz 2012 második felében, szóval honnan tudhatná a 4Gamer. Az meg a másik dolog, hogy kétkártyás VGA-nak sosem volt kódneve. Persze ez lehet, hogy változik, mert teljesen világos, hogy a 9800GX2-őt, a GTX 295-öt és a GTX 590-et is a kényszer szülte. Azt el tudom képzelni, hogy az NV most terv szerint készül az AMD stratégiájára egy termékkel.