Hirdetés

Az NVIDIA az idei Computexen nagyrészt a szerverpiacra fókuszált, és a fő bejelentés a GH200 Grace Hopper nevű fejlesztés volt. Valójában erről már két részletben beszélt a cég korábban, ugyanis az idei GTC-n a Grace hivatalosan is bemutatkozott, míg a Hopper lényegében a H100 jelzésű gyorsítót rejti.

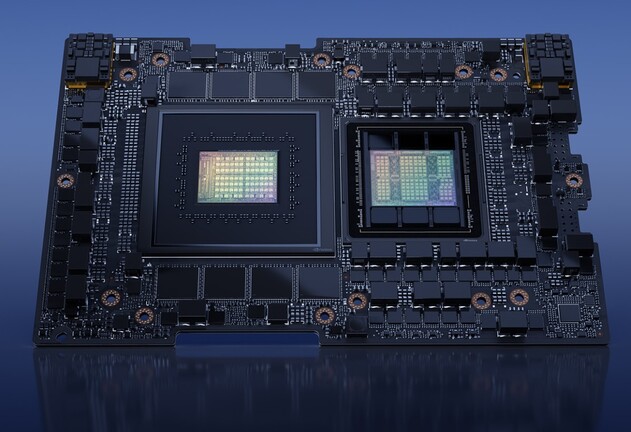

A vállalat már korábban is ecsetelte, hogy a két fejlesztés egymás mellett is alkalmazható, de csak most vált ténylegesen rendelhetővé a partnerek számára. A nyers specifikációkat tekintve a GH200 Grace Hopper CPU-ja 72 darab ARM Neoverse V2 magot rejt 480 GB-nyi, ECC-t is támogató, hozzávetőleg 512 GB/s-os tempóra képes LPDDR5X memória társaságában, a 900 GB/s-os adatátvitelt biztosító, memória-koherens NVLINK interfészen kapcsolódó GPU pedig 132 darab multiprocesszort használ, 96 GB-nyi, nagyjából 4 TB/s-os sebességű HBM3 memória mellett. A teljes konstrukció fogyasztása 450 és 1000 watt között van, ez valószínűleg egy konfigurálható paraméter, amit a megrendelő tud kiválasztani. Természetesen minél nagyobb energiafelvétel történik, annál jobb lehet a teljesítmény.

NVIDIA DGX GH200 AI Supercomputer [+]

A rendszerre alapozva érkezik a DGX GH200 AI Supercomputer, ami 256 node-nyi GH200 node-ot tartalmaz, és ezekből 24 rack köthető össze. Ennek a rendszernek a teljesítménye 8 bites lebegőpontos feldolgozás mellett 1 EFLOPS lesz, de ez az adat structural sparsity mellett értendő.

Az NVIDIA szerint a GH200 Grace Hopper konstrukcióra épülő rendszerek az év későbbi részében lesznek hozzáférhetők, a DGX GH200 AI Supercomputer várhatóan az év vége felé.

Lazán kapcsolódik egy újdonság, amit a zöldek a Computexen lepleztek le. Ez az NVIDIA ACE (Avatar Cloud Engine), amely ehetővé tenné az egyedi neuronhálók biztosítását a játékokhoz, ami új lehetőségeket adnak nem játszható karakterek felhasználására, hiszen ezáltal ezek természetes nyelvi interakciókra is képesek lehetnének.

Az alapötlet kifejezetten előnyös, hiszen újszerű játékélmény lenne általa kiépíthető, viszont a rendszer működtetéséhez komplex szerverpark is szükséges, amit a fejlesztőknek fenn kellene tartani, és ennek az anyagi vonzatai még nehezen határozhatók meg. Szerencsére hasonló alapelvű, generatív AI-ra épülő szolgáltatások már ma is léteznek, igaz nem videojátékokhoz, és egy meghatározott havidíj mellett valóban fel lehet építeni rá egy előfizetéses üzleti modellt, vagyis van ráció a koncepcióban. A kérdés az lesz, hogy mekkora havidíjat lennének hajlandók fizetni a játékosok egy ilyen szolgáltatásért, hiszen ki kell termelni ezekből a szolgáltatás működtetési költségeit. Ráadásul ennél a típusú generatív AI konstrukciónál fontos az azonnali rendelkezésre állás, vagyis nem lehet ám percekig várakoztatni a befutó kérelmeket, mert az nagyon lerontaná a játékélményt.

Érdekesség még, hogy a MediaTek és az NVIDIA partnerségéről szóló pletyka is részben igaznak bizonyult, mivel az érintettek bejelentették, hogy a MediaTek autoipari felhasználásra szánt rendszerchipet tervez, amelyhez NVIDIA GPU chipletet fognak használni. Ez persze klasszikus értelemben nem tekinthető IP licencelésének, de a lényegen nem változtat, így a Dimensity Auto platform NVIDIA GPU dizájnnal lesz kiegészítve.