- NVIDIA GeForce RTX 3060 Ti / 3070 / 3070 Ti (GA104)

- Az Apple megszerezné a klubvilágbajnokság közvetítési jogait

- Amlogic S905, S912 processzoros készülékek

- Sony MILC fényképezőgépcsalád

- Fujifilm X

- AMD Ryzen 9 / 7 / 5 / 3 3***(X) "Zen 2" (AM4)

- Milyen billentyűzetet vegyek?

- Vezetékes FÜLhallgatók

- Léghűtés topik

- Érkezik Magyarországa az LG szuper dizájnos hordozható projektora

Hirdetés

-

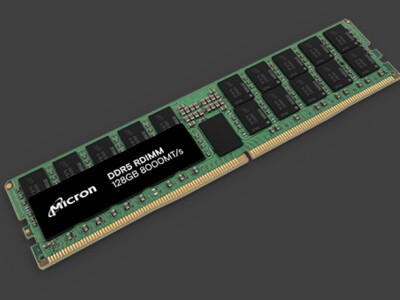

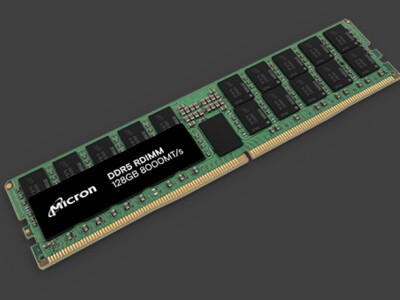

Alacsony fogyasztású, 128 GB-os szervermemóriát kínál a Micron

ph Az új RDIMM TSV technológia alkalmazása nélkül éri el a címben említett tárkapacitást.

-

Toyota Corolla Touring Sport 2.0 teszt és az autóipar

lo Némi autóipari kitekintés után egy középkategóriás autót mutatok be, ami az észszerűség műhelyében készül.

-

iPaden is vége az App Store monopóliumának

ma Ősztől lehet alternatív alkalmazásboltból telepíteni az EU tagállamaiban.

Új hozzászólás Aktív témák

-

HSM

félisten

És még egy gondolat, hogy persze borítékolható, hogy majd jönnek a "cherry picked" mérési eredmények azon néhány szoftverből, amik gond nélkül skálázódnak akárhány, akármilyen magokra is, mint pl. a Cinebench... Aztán meg lehet vakarózni, hogy bizonyos alkalmazásokban meg miért nem köszön vissza a várt eredmény... Ahogy az első három generációs Ryzenek is meglepően erős Cinebench versenyzők voltak, miközben azért néhol nem teljesítettek ilyen szépen a konkurenseikhez képest.

#5390 Busterftw : "meglevo OS-ra jott a mas felepites."

Éppen ezaz, nem jött másféle felépítés. Ilyen rendszerek a win10 megjelenése előtt már legalább 5-6 évvel is léteztek, lásd Core2 Quad és kétprocesszoros munkaállomások."Intel biztos odatette magat a Microsoftnal, hogy alljanak ra a temara."

A probléma, hogy nem lehet minden erőből megoldani. Biztos lesz pár szoftver, ami bemutatóra majd jól leoptimalizálnak, de egyébként ez nem fog jól működni automatikusan csak úgy magától, erőből. Ehhez a szoftvereket is finomhangolni kellene. Ráadásul az optimum változhat, hogy mennyire az energiatakarékos és mennyire a gyors működés a preferencia."Sok licensz az."

Nekik mindegy. Így is úgy is elkel a licensz a gépen.

[ Szerkesztve ]

-

HSM

félisten

válasz

S_x96x_S

#5393

üzenetére

S_x96x_S

#5393

üzenetére

"Valamint a legtöbb párhuzamosítást - át lehet lökni a GPU-ra ..

Vagyis a heterogén ( CPU + GPU ( + FPGA ))

programozásé a jövő"

Ezt nyomták a Caveri APU-nál is ezer éve... [link] Aztán a forradalom valamiért mégis elmaradt, pedig a hardver azóta is adott (lenne) hozzá.#5394 Busterftw : "a CCX desgin ellegge eltero volt mindentol ami addig megjelent es mainstream volt"

Az OS és a szoftverek szintjén teljes mértékben ugyanaz a megoldandó probléma, mint a Core2 Quadnál. Vannak magok, amik egymással gyorsan tudnak adatot cserélni (közös L2 a Quadnál, közös L3 a CCX-nél) és vannak, amik lassan, és ezt a feladatok kiosztásánál/ütemezésénél érdemes figyelembe venni.Fun fact, annak idején épp az AMD demózta bőszen, mikor megjelentek a világ első natív négymagosával, hogy ez bizony mennyivel jobb, mint a konkurencia kétszer kétmagos felépítése...

"Currently Intel’s quad core implementation relies on it having two Core 2 dies on a single package. It can easily pull this off because it doesn’t integrate the memory controller into the CPU. This allows more cores to be added as needed.

However, this creates an inherent performance problem, since both die are only connected only through the CPU front side bus (FSB). Sending data from core one to three means that it has to be sent out of the CPU to the northbridge and then back again creating a massive additional latency and reducing the bandwidth available for memory access.

Discussion between cores one and two or three and four is okay, because they are on the same piece of silicon, but still 50% of the time there’s a latency problem.

" [link]

Pontosan ez történik a CCX-ek esetén is, ha a szomszéd CCX-el kell adatot cserélni, arra csak a memóriavezérlőn keresztül van mód, hiába fizikailag egy csip. Ez a probléma "szűnt meg" az 5600X és 5800X modelleken, mivel azokon egy csip egy CCX, minden mag egyforma gyorsan fér az adatokhoz.Azzal viszont teljes mértékben egyetértek, hogy a fő probléma, hogy hogyan ütemezd a feladatokat a magok között, adott esetben power plan függően, a különböző elérhető kis/nagy magszámok mellett.

Bár tegyük hozzá, 16 magot megfelelően skálázódó módon ellátni szálakkal egyébként sem feltétlenül egyszerű, hát még ilyen "egzotikus" felépítésű CPU-k esetén.

Bár tegyük hozzá, 16 magot megfelelően skálázódó módon ellátni szálakkal egyébként sem feltétlenül egyszerű, hát még ilyen "egzotikus" felépítésű CPU-k esetén. [ Szerkesztve ]

-

HSM

félisten

válasz

S_x96x_S

#5397

üzenetére

S_x96x_S

#5397

üzenetére

Mit mondhatnék erre... Annyira csendben zajlik, hogy cirka 10 év leforgása alatt is csak néhány szoftver használja.

Ami eszembe jut, azok az RT gyorsított render szoftverek és talán egy tömörítő van/volt, ami OpenCL támogatott.Egyébként az egyértelmű, hogy hasznos lehetőségek rejlenek ebben a modellben, de úgy tűnik a PC eddig túl ingatag/fragmentált terep volt (nem volt pl. minden CPU mellett IGP) ahhoz, hogy ott is elterjedjen, mint pl. a konzoloknál, inkább megoldották amit kellett erőből a CPU-n.

#5399 Petykemano : A DDR5 és az új AM5 IOD kérdés, mennyit javít a memória alrendszer tempóján, ha sokat, akkor az óriás L3 jelentősége azért jelentősen csökkenhet, mivel a maximális magszámot (16) nem tervezik emelni és a jelenlegi alap 8mag/32MB sem éppen kevés.

#5402 Petykemano : Érdekes írás, köszi!

-

HSM

félisten

válasz

S_x96x_S

#5410

üzenetére

S_x96x_S

#5410

üzenetére

"mert ez az új "normális"

az Intel Alder-Lake-S akár 150W-os TDP-vel nyomulhat ..

de az is lehet, hogy ez csak az átlag - mert:

Intel: "TDP values are maintained at 125W (PL1) and 228W (PL2).""Intelnél máshogy van definiálva a TDP, mint AMD-nél, ezt itt nagyon fontos lenne figyelembe venni. Az Intel féle 125W PL1 és 228W PL2 a gyakorlatban azt jelenti, hogy a beállított időablakban (8-60 másodperc között modellfüggően) átlagosan nem mehet a PL1 azaz 125W fölé, és sehogyse mehet a PL2, azaz 228W fölé. Illetve ami fontos, itt a TDP = fogyasztás. Persze, imádják a lapgyártók a saját szájízük szerint megemelni a PL1, PL2-t, de ez egy egész más történet.

AMD-nél a TDP valami számolás eredménye, ők valahogyan a hűtő felől nézik, ott a 105W-os TDP-vel ellátot processzor vidáman fogyaszthat átlagosan 140W-ot hosszú távon is. Tehát, ha úgy tetszik, épp az AMD lépett kicsit feljebb az AM4-el a korábban szokásos max 65/95W fogyasztási keretből.

A lapgyártók persze itt is igyekeznek a konkurencia fölé kerülni, de mivel itt a gyári limiteket nem módosíthatják, így a processzor telemetriáját próbálják félrevezetni, tehát még szvsz rosszabb a helyzet, mint a konkurens processzorokon, ahol legalább két beállítás után visszakaphatod bármilyen alaplapon a gyárilag specifikált működést.#5419 Petykemano : "És azt mondom, hogy az csupán "véletlen", hogy ezt az Apple pont megengedheti magának és még így is brutálisan nyereséges."

Szerintem a véletlennek ehhez semmi köze. Azt gondolom, óriásit kaszálnak azzal, hogy a saját chipjükre zárták be a rendszerüket, és nem kell másoknak fizetniük a CPU-ért.

Így ebben a piaci helyzetben nem csoda, hogy minden pénzt megér nekik, hogy egy ideig előnyben legyen gyártástechnológiailag is, ezzel is erősítve a képet, hogy megéri váltani az új rendszerre a régiekről.[ Szerkesztve ]

-

HSM

félisten

válasz

Petykemano

#5423

üzenetére

Petykemano

#5423

üzenetére

Igen, az Intel biztosan nem engedheti meg magának a hasonló mértékű finanszírozást, hiszen az esetleges veszteséget a CPU-n nem fogja tudni máshol visszahozni, mint az Apple. Ott ugye nem tudsz csak CPU-t venni, hanem egyben veszed az OS-el és mindennel együtt. És nyilván mivel azt az OS-t kell használnod rajta, mivel jelenleg nem nagyon van alternatíva, így vélhetőleg az alkalmazásboltból is utána még csorog a bevétel.... Az Apple-nek ez is az üzlet része, nekik jobb, ha nem az általános x86 a rendszer alapja, amire bármikor rádobhattál kétféle más OS-t is. A saját CPU-val viszont bármikor bezárhatják az ajtókat, ha akarják.

[ Szerkesztve ]

-

HSM

félisten

válasz

Petykemano

#5436

üzenetére

Petykemano

#5436

üzenetére

Itt a fogyasztás lesz szvsz nagyon érdekes. Az a single pontszám nagyon-nagyon erős, de kérdés, hány terhelt mag mellett tudja ezt a tempót tartani és milyen fogyasztás mellett. Illetve arról a 11600 pontról is jó lenne tudni, hogy készült, mert a 140W limit feloldása után, beállítva az 5850X 12 000 felett is hoz.

V-cache-el és picit emelt órajelekkel azért bőven versenyképesek maradhatnak ezzel már a mostani Zen3-al is. Főleg, ha esetleg hoznak mellé egy továbbfejlesztett IOD-t is.

-

HSM

félisten

válasz

Petykemano

#5449

üzenetére

Petykemano

#5449

üzenetére

A V-cache egy teljes új generációnak nekem kevésnek tűnik, főleg, hogy nem is minden gyorsulna tőle, hiszen a meglévő 32MB is igencsak méretes.

Én azt tudnám elképzelni, hogy kijönnek valami prémium kiadással, kicsit emelt órajelek + V-cache, pl. XT végződéssel a mostani modellek mellé, úgy tökéletesen beleillene a palettába. 6000-es szériának akkor tudnám elképzelni, ha kapna egy nagygenerált az IOD és az hozna valami újítást, de annak azért kevés esélyét látom az AM4 életciklusának vélhetőleg erősen a vége felé.

-

HSM

félisten

Egyébként egyetértek ezzel az oldallal.

Viszont ehhez szerintem komolyabb fejlesztés fog kelleni, mint a V-cache és esetleg minimális órajel emelés. Főleg, hogy a V-cache nekem nem tűnik ésszerűnek az olcsóbb termékekre (4 - 6 mag), és azokból a mostani 5000-es széria is foghíjas. Tehát ebben az esetben szükség lenne egy hézagkitöltő Zen3+ magra némi fejlesztéssel, amivel a teljes palettát fel lehetne frissíteni.[ Szerkesztve ]

-

HSM

félisten

"Ha pl. az x-es verziókon lenne v-cache, a simákon meg nem, akkor akár ennyi is elég lehet egy új generációhoz"

Szerintem azért nem, mert azt szerintem igen nehéz lenne eladni, hogy néhány alkalmazás gyorsul, néhány meg semmit. Illetve vélhetőleg inkább a nagyobb magszámú modelleken tud segíteni (12-16), ahol szűkebb keresztmetszet az elérhető memória sávszélesség.Ezzel szemben egy kis CCD felvarrás az mindenhol hozhatna pár százalékot, az inkább tűnik nekem eladhatónak, a drágább modelleket pedig megfűszerezhetik a V-cache-el is, pl. a sima és X-es modellek magukban, drágább XT modellek a V-cache-el.

#5457 Petykemano : "$300-ba azért már csak bele kéne férjen +10$ költség"

Nem vagyok benne biztos, hogy ilyen olcsón megúsznák. A magot azért ehhez rendesen meg kell utómunkálni, elvékonyítás, plusz hézagkitöltő lapkák illetve a plusz L3 lapka az egész tetejére. Vélhetőleg a selejt-hajlamot is növelné ez az extra igénybevétel és munkafolyamatok. Illetve nyilván tudjuk, hogy ami a polcon 300 dollár, abból ennél jóval kevesebb a gyártó profitja, amiből lejönne az a tegyük fel, 10 dollár. Én ennek jelenleg is inkább a prémium kiadásokon látom értelmét, nem az olcsóbb "tömeg" modelleken.

Én ennek jelenleg is inkább a prémium kiadásokon látom értelmét, nem az olcsóbb "tömeg" modelleken.[ Szerkesztve ]

-

HSM

félisten

válasz

Petykemano

#5459

üzenetére

Petykemano

#5459

üzenetére

"hogy reszelnek picit az órajelen, akkor 650-660-ra felmehet, de azért ez még kevéske"

Hát ezaz... És ezen szvsz nem fog javítani a V-cache egy cseppet sem. Lásd pl. a 3100 és 3300X-et, single core-ban gyakorlatilag egy az egyben az órajelkülönbség jön vissza [link] , ~12% előny, ebből ~10% az órajel. És ez még csak nem is a 32MB magassága, hanem szerény 8MB szemben a 16-al.

De nézhetjük architektúrán belül is, 5600X vs 5700G, kerek 20 pont azonos órajelen, azaz 3,5% az előny 16MB helyett 32MB-al.... [link]

Szóval szvsz éppen ez lesz a gond, hogy a V-cache nem sokat fog lendíteni a hat-nyolcmagoson sok appban, míg az előállítás költségét emeli. Ide sajnos mindenképpen kelleni fog egy kicsit komolyabb beavatkozás, ha nem akarják elveszteni a koronát.

Feltéve, hogy a kiszivárgott AL számok valósak.

#5460 poci76 : Az a 100Mhz BOOST emelés kb semmit nem fog dobni a számokon, már a mostani verziók is igen magas órajelen járnak.

Azt nem hinném, hogy miután ennyit szívtak az új gyártástechnológiáikkal, árversenybe kezdenének, főleg, ha igen erős lesz az ajánlatuk anélkül is.

[ Szerkesztve ]

-

HSM

félisten

válasz

Petykemano

#5462

üzenetére

Petykemano

#5462

üzenetére

Szerintem épp arra lesz jó, amire demózták... Leginkább játék + 6900X(V) és 6950X(V).

Jobban átgondolva ott azért emiatt jobban az AL nyakán lehet majd, mint CB alatt, ami azért jelentős tényező a prémium gamer piacon.

Szerintem a CCD-s előny maradna, hiszen fizikailag ugyanaz a CCD van a V verzión, csak máshogy megmunkálva. A CCD probléma akkor jönne, ha Zen3+ kellene, hiszen a szerverekbe még csak most kezdik a sima Zen3-at teríteni, nem biztos, hogy kihozatal szempontjából szerencsés lenne most kihozni egy új dizájnt. Bár ki tudja.

Illetve árban is bőven lehetne versenyezni, igen jó processzorok ezek a mostani Zen3-ak, biztos vagyok benne, hogy megfelelő árazás mellett ugyanúgy vinnék az emberek, mint a cukrot, és szerintem van még tér akár kicsit olcsóbban adni őket, maximalistáknak meg mehet a V-modell kis prémiumért.

[ Szerkesztve ]

-

HSM

félisten

válasz

Petykemano

#5484

üzenetére

Petykemano

#5484

üzenetére

"Logikus lenne inkább még két zen3-as lapkát gyártani"

Igen, terület alapon. De gyanítom, azért nem költségmentes az átállás a gyártósor és gyártott lapka tekintetében (arra gondolok, nem biztos, hogy hirtelen tudnának Cezanne helyett Vermeer-t gyártani adott 7nm kapacitás mellett a pillanatnyi kereslet függvényében), a Cezanne-t pedig amúgy is gyártják a notebookok miatt. Illetve a gyártást korlátozhatja/drágíthatja a máshol gyártott IOD beépítése, ami szintén nem gond a Cezanne-nél, ahogy írod is.Egyébként jó meglátás az is, hogy lehet bőven a notebookos fogyasztás keretből kilógó Cezanne, amit így szépen lehet értékesíteni olyan piacra, ahol nem gond pár W plusz fogyasztás.

Illetve a mostani GPU árak/ellátás mellett a beépített IGP is szerintem hasznos extra, ami ráadásul a konkurenciánál is a legtöbb modellnél adott. -

HSM

félisten

válasz

Petykemano

#5523

üzenetére

Petykemano

#5523

üzenetére

Amit a késleltetésről írsz, az elérhető órajelekre lehet hatása az L1-L2 cache kiterjedésének a magon belül.

"3d cache épp azért lesz forradalmi"

Én sokkal inkább abban látom a forradalmiságát, hogy nem növeli a lapka méretét (kihozatal!), illetve "modulárisan" építhető, ha akarják rárakják, ha nem akarják nem, így többféle termékből építhető portfólió anélkül, hogy külön gyártósor és lapka tervezése válna szükségessé.[ Szerkesztve ]

-

HSM

félisten

válasz

Petykemano

#5529

üzenetére

Petykemano

#5529

üzenetére

Épp tegnap olvastam én is. [link]

A kommentek között említették, hogy annyiból nem meglepő, hogy új termék, aki 5600X-et/5800X-et akart már rég vehetett, aki meg pl. az IGP miatt erre várt most lerohanta a boltot.

Illetve írta valaki, hogy szép és jó az IGP, de ha veszel valami ezer éves rom VGA-t míg normalizálódnak az árak az sem feltétlen rossz opció, és akkor nem kell végig felezett L3-as processzort használj.

Én inkább HTPC-be tartom atomjó opciónak, ha nem cél a komolyabb játék és később se megy majd bele GPU.

-

HSM

félisten

válasz

Petykemano

#5538

üzenetére

Petykemano

#5538

üzenetére

"A kettő szerintem nem feltétlenül esik egybe, vagyis nem biztos, hogy alapjáraton az a lapka fogyaszt keveset, ami egyébként 1-2 maggal magas frekvencia elérésére képes."

Jó meglátás. De valamit kezdeni kell azokkal is, amik se különösebben magas órajelet, se különösebben jó fogyasztást nem hoznak.

De valamit kezdeni kell azokkal is, amik se különösebben magas órajelet, se különösebben jó fogyasztást nem hoznak.  Én ezeket gondolnám ideálisnak pl. az 5900X-ek második CCD-jének elszórni. TDP tartalék van bőven, két mag kikapcsolható, és kb. csak a base clock van, mint kötelező specifikáció, amit a nem túl szoros TDP-n belül hozni kell.

Én ezeket gondolnám ideálisnak pl. az 5900X-ek második CCD-jének elszórni. TDP tartalék van bőven, két mag kikapcsolható, és kb. csak a base clock van, mint kötelező specifikáció, amit a nem túl szoros TDP-n belül hozni kell. -

HSM

félisten

válasz

Petykemano

#5542

üzenetére

Petykemano

#5542

üzenetére

Az 5950X-en azért szigorúbb már a specifikáció és a TDP is szűkösebb.

"A 6 magos lapkák többsége szerintem nem azért 6 magos, mert hibás, hanem mert 8 magosként túl sokat fogyasztana."

Könnyen lehet.

Én egyébként azt gondolom, szinte biztos, hogy desktop "flagship" CPU-kra azért igen jó lapkák (is) kerülnek a reklámérték miatt, gondolok pl. 5800X, 5950X. Persze, az 5800X lehet "forrófejű", csak tudjon magas órajelet, hiszen 140W-ig mehet a fogyasztása ami igen bőkezű, az 5950X-ért meg azért már kellően borsos összeget kell a kasszánál hagyni, hogy ne fájjon nekik túlzottan rárakni legalább egy igen jó CCD-t is.

-

HSM

félisten

válasz

S_x96x_S

#5558

üzenetére

S_x96x_S

#5558

üzenetére

"... és 2-3-5 év múlva képesek az M1/2/3/4 -et is lekörözni - innovációban;"

Ez még mindig nem biztos, hogy elég ellensúlyozni a hátrányt, hogy nem saját kezükben a platform. Az M1 jó teljesítménye szvsz inkább eladni volt szükséges, a gyártó számára szvsz a legnagyobb előny a teljes kontroll a hardveres rész felett.#5561 Petykemano : Azt ne felejtsük el, hogy ezek erősen optimalizált blokkok. Hiába "férne el" mondjuk +2 CU, ha mondjuk a kevésbé optimális vezetékelés miatt buknának csomót az órajelen. Nem bolondok tervezik a chipet, ha reális alternatíva lett volna jobban kihasználni a drága és korlátozottan elérhető wafert, megtették volna.

-

HSM

félisten

válasz

Petykemano

#5592

üzenetére

Petykemano

#5592

üzenetére

Azért itt nekem van két észrevételem. Az egyik, hogy relatív lassú ramokat használtak: "Also used DDR4-3200 CL14 dual-rank, dual-channel memory".

Ez korábbi tesztekből már sejthető volt, hogy így hagynak teljesítményt a CPU-ban, ez nyilván növelte a gyorsítótár-méret jelentőségét.A másik észrevétel, hogy a cache egy furcsa dolog, amíg "hasznos" a növekmény, addig remekül lehet profitálni belőle, de utána alig. Pl. a Radeon 6800-nál volt egy ilyen ábra prezentálva: [link] . Mindenesetre nagyon kíváncsi lennék a mérésekre, hogyan alakulna a 32MB vs. 96MB L3 verseny a különböző szoftverekben.

Én általánosan továbbra is jobban preferálnék +2 magot, mint nagyobb L3-at, ha hasonló áron lennének a polcon.

#5587 S_x96x_S : A WRX80 az árához képest szerintem nem durrant akkorát. Én komolyabb előnyre számítottam a duplázott memória csatornák láttán, mint amit mértek [link] .

[ Szerkesztve ]

-

HSM

félisten

válasz

Petykemano

#5595

üzenetére

Petykemano

#5595

üzenetére

Ami számomra kicsit furcsa, hogy az Alder is csak 16 sáv erejéig 5.0, a maradék 4 ott is 4.0.

Egyébként alaplap oldalról is érdekes lehet a kérdés, az 5.0 mennyivel növelné az alaplap költségét. A Zen lapkáknál épp könnyű kéne legyen az ilyesmik beépítése, hiszen csak az IOD-t kellene frissíteni és meg is lenne oldva a dolog. Illetve esetleg termékpozicionálás? Valamivel el kell majd adni a második hullám AM5 lapot is.

![;]](//cdn.rios.hu/dl/s/v1.gif)

-

HSM

félisten

válasz

Petykemano

#5624

üzenetére

Petykemano

#5624

üzenetére

Pedig ez tűnik a legjobb megoldásnak. A kis mag utasítás szinten kompatibilis az AVX512-vel is, csak csiga lassú, ha tempó is kell, majd átrakja az ütemező a nagyobb magokra.

#5627 Petykemano :"reszelgetés (+10%) helyett elég komoly (+50+%) méretnövekedésen esnek át bizonyos alegységek"

Szerintem itt lényeges szempont, hogy mi lehetett a cél a fejlesztésnél. Az első Core architektúrák után a cél kb. a Skylake-ig az volt, hogy a mobil chipek terén legyen jelentős az előrelépés, ez volt a tervezési filozófia, hogy csak akkor építettek be valamit, ha hatékonyságban is jó volt. Nekem úgy tűnik, hogy ezt most már máshogy gondolják, a nagy magba menjen minden, amit elbír a gyártástechnológia, a hatékonyság meg majd jön a sok kis magból.#5629 S_x96x_S : "( mert az Inteltől láttunk nem annyira pöpec implementációkat, amikor pl. visszavett az órajelből avx-512 utasításoknál )"

Így volt ez az AVX2-nél is. A gyakorlatban viszont ebből nem igazán láttam problémát, nem dupla olyan gyors lett az AVX2 kód, csak mondjuk 80%-ot gyorsult.

Ami gondot okozhatott, hogy a maradék magokon is így csökkent a nem-AVX-es kódoknak elérhető órajel, de ezek már nagyon apróságok.

#5630 S_x96x_S :"Personally, I think Zen 4 might have a single 512-bit FMA unit that can be addressed as 1×512 or 2×256, in a setup similar to Sunny Cove’s."

Nekem tetszene, ha ez lenne a megvalósítás. Nem gondolom, hogy jót tenne a csipnek más aspektusokból, ha túlizmosítanák a vektorfeldolgozókat, a jelenlegi Zen-nek is tetszik a kiegyensúlyozottan jó teljesítménye. -

HSM

félisten

válasz

Petykemano

#5635

üzenetére

Petykemano

#5635

üzenetére

"Az E magokat az intel throughputra akarja használni."

Szvsz nincs ellentmondás. A kulcs itt szerintem, hogy adott lapkaméreten belül a legjobb throughput. Tehát lehet, csak negyed tempóval aprítaná az AVX512-t, de ha ebből 4 elfér egy nagy mag helyén már lehet nyertél...

A kulcs itt szerintem, hogy adott lapkaméreten belül a legjobb throughput. Tehát lehet, csak negyed tempóval aprítaná az AVX512-t, de ha ebből 4 elfér egy nagy mag helyén már lehet nyertél...

Aldernél szerintem nagy öngól, hogy a kis mag semmilyen formában nem eszi meg az AVX512-t, így a nagy mag ilyen tudása teljesen kihasználhatatlan marad. -

HSM

félisten

válasz

hokuszpk

#5637

üzenetére

hokuszpk

#5637

üzenetére

Akár az is opció lehet szvsz.

#5638 wwenigma : Ez a "hány magos" kérdés régóta nem egyértelmű sajnos. A Bulldozer is nézőpont kérdése, 4 vagy 8 magosnak tekinted, de a Zen-eknél is bizonyos kódokak igencsak árt, ha át kell nyúlkálni a szomszédos CCX-ekbe, tehát ott is bejött a "nézőpont kérdése", hány magot tudsz hatékonyan használni a különféle alkalmazásokban. Aztán persze most már a kékek is beálltak a sorba az Alder Lake-el.

Valószínűleg itt is más, mélyebb metrikák után kell majd nézni, ahogy a gyártástechnológiai elnevezéseknél is volt. A user meg csak vakargathatja majd a fejét.

Valószínűleg itt is más, mélyebb metrikák után kell majd nézni, ahogy a gyártástechnológiai elnevezéseknél is volt. A user meg csak vakargathatja majd a fejét.

-

HSM

félisten

válasz

S_x96x_S

#5646

üzenetére

S_x96x_S

#5646

üzenetére

"vagy az új 6950X - nél csak az egyik chiplet lesz 3DVcache tunningolt."

Ennek mutatták be először a prototípusát. [link]![;]](//cdn.rios.hu/dl/s/v1.gif)

Érdekes gondolat egyébként, a big-little első megközelítésének is megfelelne.

Az ütemező miatt túlzottan nem aggódnék, a CPPC-ből konfigurálható mag-preferencia eddig is adott volt, és a Ryzeneknél eddig is voltak erősebb és gyengébb magok, hiszen nem egyforma volt a magok maximális BOOST órajele, tehát simán SMU-ból is kezelhetőnek tűnik a dolog ahogy jelenleg is.

Az ütemező miatt túlzottan nem aggódnék, a CPPC-ből konfigurálható mag-preferencia eddig is adott volt, és a Ryzeneknél eddig is voltak erősebb és gyengébb magok, hiszen nem egyforma volt a magok maximális BOOST órajele, tehát simán SMU-ból is kezelhetőnek tűnik a dolog ahogy jelenleg is.[ Szerkesztve ]

-

HSM

félisten

válasz

S_x96x_S

#5672

üzenetére

S_x96x_S

#5672

üzenetére

Én a CXL-ben és PCIe5-ben rövid távon nem nagyon látok fantáziát.

Az összes játék ma úgy van megírva, hogy még véletlen se legyen érzékeny a latency-re, hiszen időtlen idők óta magas. Mielőtt az alacsony latency-re épülő bármi megjelenhet, azelőtt kellene alá felhasználói bázis valamint rengeteg fejlesztés. Ez minimum évek. Mire ezeknek jelentőségük lesz, szvsz már rég kidobtuk az összes AL vagy Zen4 CPU-t. -

HSM

félisten

válasz

S_x96x_S

#5677

üzenetére

S_x96x_S

#5677

üzenetére

"virtuális valóság kütyüknek ( headset) és játékoknak azért nem árt a latency."

Így igaz. Ugyanakor nem vagyok meggyőződve róla, hogy a PCIe latency okozna ott gondot, és nem egyéb szűk keresztmetszetek, pl. CPU/GPU. Ilyen szempontból én nem vagyok optimista az Alder Lake-el, több ponton is előjöhetnek problémák. Pl. a 4 kis mag csak egy "ring állomás", valamint az átütemezés késleltetése a kis nagy magok között. A késleltetés minimalizálására éppen az architektúra kiszámíthatósága lenne a legfontosabb és specifikus optimalizálás."Az egységes memóriát használó újgenerációs konzolokról áthozott játékoknak - is jót tehet a Gen5-ös latency csökkentés."

Tehetne, de nem fog. Mert nem fogják áthozni, mert a játékmenetet érintő dolgoknak skálázódnia kell, hiszen nem rakhatják túl magasra a minimum gépigényt, mert az eladásokból élnek. Ezeket a dolgokat eddig is emiatt átírták/kukázták PC portnál."amikor már van Nvme SSD-ből és GPU -ból

is CXL/Gen5-ös választék."

Itt azért a NAND-ok késleltetése is okozhat még némi fejfájást, elvileg a mostani PCIe-nél is az a szűk keresztmetszet. -

HSM

félisten

válasz

S_x96x_S

#5685

üzenetére

S_x96x_S

#5685

üzenetére

"A mostani PCIe -nél már maga a PCIe a szük keresztmetszet."

A PCIe késleltetése rendszerenként eltérő lehet, de amiket találtam méréseket, alapvetően szűk 1µs nagyságrendű értékekről beszélünk, lásd pl [link] .

Ehhez képest egy átlag NAND olvasási késleltetése nagyságrendekkel magasabb, lásd pl. [link] (~50µs) , de még a kifejezetten latency-re kigyúrt Z-NAND is többszörös késleltetésű (a cikkben 3µs).

Meg lehet nézni a teszteket is, a Z-NAND-os SSD elég szépen lesöpörte a hagyományos NAND-os konkurenciát, hiába ugyanúgy PCIe-es."És a Gen4-nek ugyanolyan sz*r a latency-je mint a Gen3-nak"

Ezzel sem értek egyet. Kellőképpen meg vagyok róla győződve, hogy pl. egy 1GB-os állomány lényegesen hamarabb (azaz alacsonyabb késleltetéssel) fog azonos szélességű 4.0-s PCIe-en átcsorogni, mint 3.0-on.![;]](//cdn.rios.hu/dl/s/v1.gif)

Itt azért azt hozzátenném, hogy a késleltetés megítélése (alacsony, magas, stb) erősen függ attól, milyen felhasználáshoz. Hagyományos NAND alapú tárolók mellé úgy tűnik bőven elég gyors, de mondjuk egy dedikált VGA memóriájának rendszerbe bekötéséhez fájóan lassúnak tűnik."A NAND mellé sokszor tesznek be DRAM cache-t ; Én amúgy nem vennék "DRAM-less SSD" ."

Én sem vennék (és nem is vettem soha). De a cache az SSD esetén úgy tudom nagyrészt az írási műveletek és a "cellatérkép" gyorsítótárazására használatos, tehát ugyanúgy ott tartunk, hogy a NAND késleltetése a szűk keresztmetszet így is. -

HSM

félisten

válasz

S_x96x_S

#5690

üzenetére

S_x96x_S

#5690

üzenetére

Az ábra alapján a szoftver késleltetése a leginkább számottevő, így szemre kb a fele a 10µs késleltetésnek, ami nagyon sok. Ennek semmi köze a PCIe-hez. A PCIe ~1µs-je persze egy számottevő faktor, de szvsz nem ezen fog elúszni még a nextgen megoldások tempója sem.

Hogy a maradék 4µs hardware latency mire megy el az ábrán, az nekem nem világos.Azon meg nincs mit csodálkozni, hogy ha gyakorlatilag DDR memóriaként, a tárolási rendszer "szoftveres" oldalát teljesen kihagyva/megkerülve gyorsabb, főleg hogy ott már csak 64B-ot néztek, míg a többinél 4kB-ot. Viszont így nyilván a szoftveres tárolórendszer szolgáltatásainak is búcsút lehet inteni.

Az sajnos nem derült ki a cikk utáni kisbetűs részekből sem, hogy az "Idle" itt pontosan mit is jelent, pl. egy mélyalvásból ébresztett PCIe nyilván lényegesen magasabb latency-t fog produkálni, mint egy épp használatban lévő, vagy kevésbé energiatakarékos módban lévő PCIe.

[ Szerkesztve ]

-

HSM

félisten

válasz

S_x96x_S

#5692

üzenetére

S_x96x_S

#5692

üzenetére

"- és az NVMe protocol overheadje ( a PCIe felett ) lehet."

Ez egy érdekes kérdés, ezt most akkor hardware vagy software kategóriába soroljuk.

"ettől függetlenül az ábra arra jó, hogy jelezze, hogy mennyi optimalizálandó van még a rendszerben"

Az én véleményem szerint az ábra félrevezető lehet, ugyanis nagyvonalúan eltekint attól, hogy az a vastag "software latency" bizony hasznos és szükséges szolgáltatásokat nyújt a rendszernek.Valamint attól is eltekint, hogy a "hagyományos" NAND alapú tárolók sem véletlen lettek ilyenek, évek óta a tárterületre eső költségek durva optimalizálása folyt, főleg consumer oldalon. Én már a (2bit

) MLC-nél fogtam a fejem, TLC-nél (3bit MLC) már nagyon, erre már jönnek a hírek a PLC (5bit MLC) NAND-okról is.... [link]

) MLC-nél fogtam a fejem, TLC-nél (3bit MLC) már nagyon, erre már jönnek a hírek a PLC (5bit MLC) NAND-okról is.... [link]

Pedig már a Z-NAND is jól mutatta, milyen brutális gyorsulás lehetséges már a meglévő infrastuktúrán is csupán azzal, hogy nem a tárterületre és olcsóságra van az egész optimalizálva.A DDR "halálát" én annyiból nem tartom realitásnak, hogy nem véletlen használunk olyanokat, a bővíthetőség fontos opció a legtöbb szegmensben. Persze, egy CPU mellé integrált HBM, mint nagyméretű gyorsítótár nagyon hasznos újítás lehet, de emellett komoly korlátja is lenne a fejleszthetőségnek, ha nem lenne mellé még valami.

Persze, idővel igen hasznosak lehetnek ezek a CXL kütyük, ugyanakkor technikailag szerintem nem reális, hogy az alacsony késleltetés a DDR busz késleltetésének szintjére csökkenjen, pont az univerzalitás/kompatibilitás miatti "vastagabb" hardware/software stack miatt.#5694 Petykemano : Önmagában szerintem kevés lesz a sávszélességben utolérni.

[ Szerkesztve ]

-

HSM

félisten

válasz

Petykemano

#5735

üzenetére

Petykemano

#5735

üzenetére

Nem lennék meglepődve, ha érkezne Zen3-ból egy olcsóbban gyártható 6nm verzió a 3D-s mellé. Elvileg azt magyarázták, hogy relatív olcsó 6nm-re áttérni, jó hozzá a 7nm gyártósor és így több csip férhet el ugyanakkora waferre, tehát ~azonos költséggel több termék lenne gyártható, ami nem kis fegyvertény ilyen hiány mellett.

Itt a buktató a 6nm és a V-cache összeférhetősége lehet, erről nem olvastam eddig semmit.A Zen4 / 5nm nem csodálkoznék, ha csak a legdrágább termékekre mennének kezdetben, igazából a Zen3-ból is alig volt készlet fél évig, pedig abból alapból ("asztali szegmens" szemmel nézve) csak prémium opciók jöttek.

[ Szerkesztve ]

-

HSM

félisten

"A 12600K 6+4 kis maggal erősebb lesz Multi Threadban mint egy 5800X, ami 300 dollár alatt nem kis teljesítmény."

De milyen "teljesítmény"-felvétel mellett konnektor felől?![;]](//cdn.rios.hu/dl/s/v1.gif) A Zen3 egyik nagy erőssége, hogy igen jó perf/watt mutatójú magokat használ. Kazán üzemmódban pedig eddig is volt konkurens, igaz, valamivel drágábban. 11700K (~400$) és 10900K-ra gondolok főleg.

A Zen3 egyik nagy erőssége, hogy igen jó perf/watt mutatójú magokat használ. Kazán üzemmódban pedig eddig is volt konkurens, igaz, valamivel drágábban. 11700K (~400$) és 10900K-ra gondolok főleg.

Ezen kívül az is "probléma" lehet, hogy az 5800X heterogén megoldás, míg az 12600K nagyon nem. Ezeket mind figyelembe érdemes venni majd az árazás mellett.

-

HSM

félisten

válasz

S_x96x_S

#5756

üzenetére

S_x96x_S

#5756

üzenetére

Volt róla szó, hogy ez lesz a "standard" mobilos lapka (BGA Type3 [link] ).

Ami nekem újdonság, hogy ezt már 12W-tól be lehet vetni.

Én amúgy erre a szegmensre vagyok a leginkább kíváncsi, mit tudnak ebből a konstrukcióból kihozni, akkus üzemidő kontra sebesség az ultrahordozható kategóriában (~12-25W). Ebben egyébként az AMD jelenlegi nyolcmagosa erős terhelés mellett igen jó, de folyamatos alacsony terhelésen szvsz nem a leghatékonyabb.

[ Szerkesztve ]

-

HSM

félisten

válasz

S_x96x_S

#5758

üzenetére

S_x96x_S

#5758

üzenetére

Ezt a marketinget már eljátszották a négymagos "Pentium" atomokkal, amiket egy picit drágább nem-atom alapú kétmagos Celeron is körberöhögött.

Ilyen szempontból a 2 > 4 néha mégis igaz.

Ilyen szempontból a 2 > 4 néha mégis igaz.De szerintem ilyen árkategóriájú gépet, mint egy ilyen Alder/Zen már többségében nem olyanok vesznek, akik nem néznek utána. Ott pedig igen hamar ki fog derülni, kinek milyen kártyái vannak.

Az energiatakarékossághoz szerintem hozzátehet majd az új GPU, és a modernebb gyártástechnológia is, mégha ez csak egy half-node is.

No, és persze a pontos konfigurációt, vezérlő szoftvert is lehet mindig kicsit csiszolgatni.

No, és persze a pontos konfigurációt, vezérlő szoftvert is lehet mindig kicsit csiszolgatni. -

HSM

félisten

válasz

S_x96x_S

#5760

üzenetére

S_x96x_S

#5760

üzenetére

Az impulzus vásárlónak szvsz édesmindegy az is, hány magos. Neki megtetszett az a szép zöld pici gép a kirakatban, megveszi, kész.

Szvsz nagyobb baj, hogy a technikai hátterűeknek is egyre nehezebb eligazodni, mert egyre kevesebb a pontos, technikai specifikáció.

Én pl. elég durván meglepődtem, mikor kiderült, hogy a 4650U-s Renoir CPU-m nem támogatja a CPPC-t és a magonkéti feszültség szabályozást, csak az asztali és "Lucienne" átmatricázott kiadásai.

Ettől persze nem lett kevésbé jó CPU, de a felfedezés eléggé váratlanul ért "CPU-érdeklődőként" is.

Ettől persze nem lett kevésbé jó CPU, de a felfedezés eléggé váratlanul ért "CPU-érdeklődőként" is. -

HSM

félisten

válasz

Petykemano

#5762

üzenetére

Petykemano

#5762

üzenetére

Mármint, azzal próbálhatják majd eladni, egyetértek.

Hiszen alapvetően itt lehet óriási előny, hogy kifejezetten energiahatékonyságra optimalizált magok találhatóak a processzorban.

Hiszen alapvetően itt lehet óriási előny, hogy kifejezetten energiahatékonyságra optimalizált magok találhatóak a processzorban.Egyébként a nagy kérdés, szükség van-e ilyesmire, és ezzel kapcsolatban kicsit szkeptikus vagyok. Az i5-8250U-mon, ami egy 2017-es termék, vidáman be tudtam állítani, hogy akkuról max 2,6Ghz, illetve XTU-ból, hogy max 12W fogyasztás és olyan szépen beszabályozta magát a win10 "balanced" sémájával hogy öröm volt nézni. Tehát ha valaki vette a fáradtságot kicsit szoftveresen okosan használni, már azzal is igen sokáig el lehetett lenni egy átlagos 50Wh körüli ultrabook akku kapacitással.

Meg lehet nézni, pl. egy ekkori Thinkpad X1 Carbon még különösebb hozzányúlás nélkül is 1,13KG-ból 10+ órás akku időket tudott hozni netezés és videó nézés közben értelmes fényerőn... [link]

Egyébként az is érdekes kérdés, hogy a modern böngészők sokszálas motorjai mennyire lesznek jóban a pici magokkal. Ugyanis gyors net mellett igencsak érezni a különbséget pár komplexebb weblap betöltési sebességén, milyen CPU ül alatta. Nekem eszembe sem jutna általánosan a gyengébb magokra tenni emiatt a böngészőmet.

Persze, itt is érdekes kérdés, mennyivel lassabb, és mennyivel takarékosabb, és ez összességében mire lesz elég az amúgy szintén igen erős perf/watt-ú Zen-ek ellen.

Persze, itt is érdekes kérdés, mennyivel lassabb, és mennyivel takarékosabb, és ez összességében mire lesz elég az amúgy szintén igen erős perf/watt-ú Zen-ek ellen. -

HSM

félisten

"mert mi ertelme lenne valamit lassabban elvegezni?"

Erre mondjuk azért vannak elképzeléseim, pl. hasznos lehet a háttérben futó pl. weblap fülek kódjait a takarékosabb magokra ütemezni. A felhasználói élmény nem csökken, de a fogyasztás igen. Amivel inkább szkeptikus vagyok, mennyit hoz ez a konyhára a gyakorlatban? Szvsz túlzottan nem sokat. Erre bőven elég, ha ilyenkor az OS nem turbózza ki a világból a CPU-t.A drivereket én épp nem tenném a takarékos magokra, mivel azok kritikusak lehetnek sok szempontból.

-

HSM

félisten

-

HSM

félisten

válasz

S_x96x_S

#5788

üzenetére

S_x96x_S

#5788

üzenetére

A legérdekesebb: "If rumors surrounding the late-October/early-November launch dates of 12th Gen Intel Core "Alder Lake" processors are true, then the situation with these patches will have a direct impact on AMD. Processor reviewers will be compelled to use Windows 11 for their Core "Alder Lake" testing, as the new operating system supposedly has greater awareness of the heterogeneous core design."

Majd lehet nézni a review-ok kisbetűs részeit, fenn voltak-e AMD-n a megfelelő patchek (ha addig valóban a helyükre kerülnek egyáltalán a dolgok)....

-

HSM

félisten

válasz

Petykemano

#5819

üzenetére

Petykemano

#5819

üzenetére

"A 10nm miatt vált némileg ketté a mobil portfólió ami által lettek olyan 10nm-es termékek, amik nem jelentek meg a desktop kínálatban."

Igazából nem vált az külön, csak mivel a 10nm-en se nem tudták hozni az előző desktop generáció egyszálas teljesítményét (gyenge órajel) se nem tudtak kellően nagy csipet építeni (gyenge kihozatal) így inkább valahogy leizzadták 14nm+++++-ra ahogy sikerült az alapvetően 10nm-es dizájnjukat, ami egyfajta egyszeri tűzoltásnak fogható fel inkább szvsz."A nagy bravúr az lenne"

Ilyen bravúr szvsz nem reális. Mobilban elsődleges a fogyasztás és tokozásméret, így fontos a lehető legszorosabban integrálni, amit csak lehet. A desktop, workstation és szerver portfólió, ahol hatékonyan tudja ellensúlyozni a csiplet felépítés hátrányait (mint pl. az összekötő interfészek plusz fogyasztása, késleltetése) a sok mag és a jó kihozatal révén elérhető gazdaságos árazás. Szerintem okosan csinálják, hogy mobilon kívül megy a chiplet, mobilba (és IGP-igényes felhasználásra, pl. SFF kliens gépek, HTPC-k) pedig gyártanak egy azonos alapokra építő, de szorosabban integrált verziót.

Mobilban elsődleges a fogyasztás és tokozásméret, így fontos a lehető legszorosabban integrálni, amit csak lehet. A desktop, workstation és szerver portfólió, ahol hatékonyan tudja ellensúlyozni a csiplet felépítés hátrányait (mint pl. az összekötő interfészek plusz fogyasztása, késleltetése) a sok mag és a jó kihozatal révén elérhető gazdaságos árazás. Szerintem okosan csinálják, hogy mobilon kívül megy a chiplet, mobilba (és IGP-igényes felhasználásra, pl. SFF kliens gépek, HTPC-k) pedig gyártanak egy azonos alapokra építő, de szorosabban integrált verziót."a kis magok jók lehetnek arra is, hogy javítsák a standby vagy idle üzemidőt"

Nem értem egyébként, mire erőltetik ennyire ezt a "modern standby"-nevű dolgot, hogy kb. bekapcsolva aludjon a gép, ez nem egy tablet/okostelefon!? Még szerencse, hogy ki tudtam kapcsolni a laptopomon ("Linux-standby", lol), így tud kultúráltan is aludni, és nem akar pl. a táskámban fel-felébredni.

Még szerencse, hogy ki tudtam kapcsolni a laptopomon ("Linux-standby", lol), így tud kultúráltan is aludni, és nem akar pl. a táskámban fel-felébredni.

"Másrészt viszont elég biztosnak látszik, hogy a throughput teljesítményt kis magokkal fogja megoldani."

Ez az, amire a gyakorlatban nagyon kíváncsi leszek, hogyan és mennyire fog működni, mondjuk egy szokásos 15W és 30W keretből a konkurencia homogén megoldásához képest, vagy akár a saját Tiger Lake processzoraikhoz képest. -

HSM

félisten

válasz

Petykemano

#5821

üzenetére

Petykemano

#5821

üzenetére

"marketing szempontból nem átütő erejű"

Nehéz is lett volna átütő marketinget tenni egy olyan termék mellé, ami:

- már megjelenésekor gyengébb volt, mint a kokurencia

- nem is tudtak belőle eleget gyártani"azzal lehetne csökkenteni, ha valami TSV-s megoldást használnának"

Tulajdonképpen igen, a TSV realitás, azzal megcsinálhatnák a mostani APU felhozatalt kétrétegben, alul a standard nyolcmagos chiplet, felül a GPU és IOD. De ez az én szótáramban maradna a "monolitikus" felépítés, csak 1 helyett 2 "emeleten" megvalósítva. De azt gyanítom, ezt ésszerűbb/gazdaságosabb a mostani értelemben integrált APU-s megoldással megoldani, amibe így egyéb optimalizálások is kerülhetnek, mint pl. felezett L3."Nem kapcsolják ki, hanem csak úgy otthagyják, és az az elvárás, hogy olyan gyorsan térjen magához, mint egy telefon."

Ez nálam is felhasználás, ilyenkor szoktam a hagyományos (Linux / "S3") módon altatni, ami azt jelenti, hogy a gép kikapcsolódik, és csak a memória marad áram alatt. Így is gyakorlatilag azonnal használható, amint felébresztem, az áramfogyasztása a lehető legalacsonyabb, és biztosan nem kezd el a tudtom nélkül dolgokat csinálni, hiszen a memórián kívül kikapcsol minden. Ez a "modern standby" elvileg arra lenne jó, hogy az "alvó" gép rendszeresen felkel és pl. letölti az e-maileket, meg ilyen hülyeségek, hogy amikor leülsz elé, ott legyen már az értesítés. Amellett, hogy a koncepció gyakorlatban több sebből vérzik, egyébként nem lenne butaság, de ez szvsz nem alvás, én ha erre vágyom egyszerűen nem kapcsolom ki, és úgy is alig fogyaszt energiatakarékosra tekerve a megfelelő profilt és kikapcsolt kijelzővel. Tehát ehhez sem kell Alder Lake, mert már a Skylake is alig kért valamit így, bekapcsolva.

"mint arra a kérdésre, hogy tavaly kinek kellhetett egy 8/16 magos 15-35W-os Renoir."

Haha, jelenleg 23W 6/12 Renoir felhasználó vagyok. Jó dolog, ha kicsi és könnyű lehet az ember relatív erős munkaállomása, és nem merül le csak attól, ha ránézek.

Jó dolog, ha kicsi és könnyű lehet az ember relatív erős munkaállomása, és nem merül le csak attól, ha ránézek.  A Pollack szabály helyénvaló, azt is értem, hogy próbálják valahogy kimaxolni az áteresztőképességet és egyszálas tempót is, ugyanakkor nekem ezekkel ugyanaz a bajom, mint a CCX-ekkel a Ryzenekben, miszerint ha nem homogén a processzor, arra speciálisan optimalizálni kell, és optimalizálás nélkül könnyen sokkal többet bukhatunk az egészen, mint amennyit nyerhettünk volna ideális esetben. És itt az Aldernél lényegesen kritikusabbnak tűnik a megfelelő ütemezés, mint pl. egy 5950X-es Ryzenen, ahol azért sokkal kevésbé mehetnek vakvágányra a dolgok.

A Pollack szabály helyénvaló, azt is értem, hogy próbálják valahogy kimaxolni az áteresztőképességet és egyszálas tempót is, ugyanakkor nekem ezekkel ugyanaz a bajom, mint a CCX-ekkel a Ryzenekben, miszerint ha nem homogén a processzor, arra speciálisan optimalizálni kell, és optimalizálás nélkül könnyen sokkal többet bukhatunk az egészen, mint amennyit nyerhettünk volna ideális esetben. És itt az Aldernél lényegesen kritikusabbnak tűnik a megfelelő ütemezés, mint pl. egy 5950X-es Ryzenen, ahol azért sokkal kevésbé mehetnek vakvágányra a dolgok.

Ha én ezzel így célszemélynek számítok, jelenleg sokkal esélyesebbnek látom majd fejlesztésre valamely U-kategóriás 8/16-os Cezanne-t a későbbiekben, mint egy Aldert. Pedig jól jön nekem mind a single, mint a multi tempó, de nem vágyom szoftveres/szálkezelési anomáliákra, annyival nem várom gyorsabbnak az Alder nagy magjait sem, hogy ezt bevállaljam. Meglátjuk.

[ Szerkesztve ]

-

HSM

félisten

válasz

S_x96x_S

#5825

üzenetére

S_x96x_S

#5825

üzenetére

"Az 5nm sokat számít."

Igen.

Illetve arra akartam célozni, hogy tényleg durva nagy szám, amiből az is következik, hogy így "könnyű" 70%-al megverni a konkurenciát perf/watt, ráadásul +2 maggal, jelentsen bármit is a különösebb konkrétumokat nélkülöző ábra.

És még csak nem is egy takarékosra hangolt aktuális Ryzent, hanem egy 45W-os Core i7-11800H-t szerepeltettek ellene, amiről nekem nem épp az ideális perf/watt jut eszembe...

-

HSM

félisten

válasz

Petykemano

#5829

üzenetére

Petykemano

#5829

üzenetére

"Az eredeti kérdés az volt..."

Lehetetlennek tűnik a feladvány, úgy általánosságban.

"Jó hát azért a 6/12 még látótávolságon belül van az azt megelőzően standard 4/8-tól."

Nálam egy i5-8250U-t váltott, Cinebench R20 szemüvegen keresztül nézve kb. 1200 multi pontból lett 2200 azonosan 15W-ból, ez már inkább a porban sem látszik a hátunk mögött kategória....

A négymagos Tiger Lake, ha adunk neki 10W fogyasztás előnyt, na, akkor már látótávolságban van a ~2000 pontjával, ami szintén eltűnik a porban azonos fogyasztási keret esetén. (Nálam a 4650U 23W-ból 2600 pont....)"mert akkor pillanatok alatt lemerül"

Full terhelésen a 15W-os CPU-val mondjuk 20W az egész gép, egy átlag ultrabook 40-50Wh körüli akkuval így is bőven 2+ órát elmegy."Én most nem tudnék neked olyan programot vagy eszközt mondani, amit így már lehetővé tett"

Nem feltétlenül ez a lényeg. Egy kétmagoson is meg lehet mindent csinálni, csak nagy kérdés, mennyi idő alatt. Aki pedig dolgozik a gépén ez egyáltalán nem mindegy.

Aki pedig dolgozik a gépén ez egyáltalán nem mindegy."nem lesz még átütő erejű"

Én továbbra is jobb kompromisszumnak tartom a Ryzeneket. Legalábbis amíg nem megoldott, hogy direkt szoftveres optimalizáció nélkül is jól működjön a hybrid dizájn. Lásd pl. [link] . Aztán meglátjuk mi lesz.

#5831 Petykemano : "ennek a procinak nem szabadna 45W (TDP) felett üzemelnie"

Én inkább ilyen 60-100W-os limiteket látok nála a konfigoknál [link] ...

Azt a "nagyjából pariban"-t nem nézted meg szerintem elég alaposan. Lásd: [link]

Lásd: [link]

Ennyi tranzisztorból az AMD is bele tudna még rakni pár magot, és elég durva multis perf/watt lenne. Elég, ha megnézed mit művel ma egy 5800U 15W-on: [link] . Képzelj el ebből kettőt egymás mellett, még mindig csak 30W, és ebbe két IOD került így...[ Szerkesztve ]

-

HSM

félisten

válasz

S_x96x_S

#5845

üzenetére

S_x96x_S

#5845

üzenetére

"és az AMD eddig is egy picit rugalmasabb volt"

Önállósodásra ez a fajta "semi-custom" szvsz egyáltalán nem megfelelő, amit az AMD kínál. Ez más, mint mikor kapsz egy licenszt és tervezhetsz sajátot.Megnéztem mit mond erről a wikipedia: "Partly. For some advanced features, x86 may require license from Intel; x86-64 may require an additional license from AMD. The 80486 processor has been on the market for more than 30 years[1] and so cannot be subject to patent claims. The pre-586 subset of the x86 architecture is therefore fully open." [link]

Én erről a témáról azt gondolom, nem feltétlen az utasításkészlet, amin állni vagy bukni fog a dolog. Persze, egy jól megtervezett ISA azért előny lehet. Illetve kritikus fontosságú a szoftveres oldal, az x86 jelenlegi legerősebb oldala szvsz ez, az elérhető szoftveres infrastruktúra és kompatibilitás.

[ Szerkesztve ]

Új hozzászólás Aktív témák

- Samsung Galaxy Note20 Ultra - a tollnak nincs ellenfele

- btz: Internet fejlesztés országosan!

- Formula-1

- Képeken az egyik kameráját elvesztő Sony Xperia 10 VI

- Újabb Samsungok telepíthetik a Galaxy AI-t

- Kerékpárosok, bringások ide!

- Letartóztatták a bitcoin-Jézust

- Lakáshitel, lakásvásárlás

- Samsung Galaxy S24 - nos, Exynos

- Vodafone-ra áttért Digi Mobilosok

- További aktív témák...

Állásajánlatok

Cég: Promenade Publishing House Kft.

Város: Budapest

Cég: Ozeki Kft.

Város: Debrecen

Bár tegyük hozzá, 16 magot megfelelően skálázódó módon ellátni szálakkal egyébként sem feltétlenül egyszerű, hát még ilyen "egzotikus" felépítésű CPU-k esetén.

Bár tegyük hozzá, 16 magot megfelelően skálázódó módon ellátni szálakkal egyébként sem feltétlenül egyszerű, hát még ilyen "egzotikus" felépítésű CPU-k esetén.

Én ennek jelenleg is inkább a prémium kiadásokon látom értelmét, nem az olcsóbb "tömeg" modelleken.

Én ennek jelenleg is inkább a prémium kiadásokon látom értelmét, nem az olcsóbb "tömeg" modelleken.

![;]](http://cdn.rios.hu/dl/s/v1.gif)