- AMD K6-III, és minden ami RETRO - Oldschool tuning

- Hobby elektronika

- Épített vízhűtés (nem kompakt) topic

- HiFi műszaki szemmel - sztereó hangrendszerek

- Vezetékes FEJhallgatók

- VR topik (Oculus Rift, stb.)

- NVIDIA GeForce RTX 4080 /4080S / 4090 (AD103 / 102)

- Az Apple megszerezné a klubvilágbajnokság közvetítési jogait

- Bambu Lab X1/X1C, P1P-P1S és A1 mini tulajok

- Bluetooth hangszórók

Hirdetés

-

Spyra: akkus, nagynyomású, automata vízipuska

lo Type-C port, egy töltéssel 2200 lövés, több, mint 2 kg-os súly, automata víz felszívás... Start the epic! :)

-

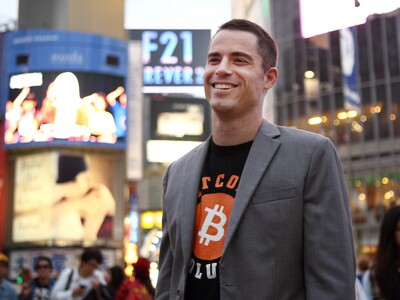

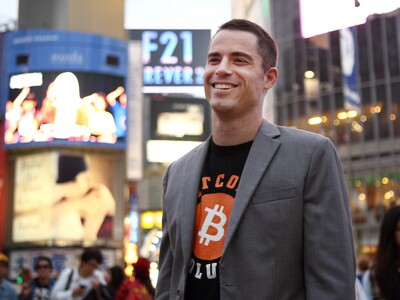

Letartóztatták a bitcoin-Jézust

it Amerikai adókerülés vádjával, Spanyolországban tartóztatták le a bitcoin-Jézusként ismert Roger Vert.

-

Lunar Lander Beyond teszt

gp Nagyon sok évtizeddel az eredeti Lunar Lander megjelenése óta ismét ezen a címen jelent meg Atari logóval egy játék. Vajon mennyit javult a játékdesign a hetvenes évek óta?

Új hozzászólás Aktív témák

-

Yany

addikt

válasz

#09256960

#3625

üzenetére

#09256960

#3625

üzenetére

azaz kisebb felbontáson lerenderelt képből próbál előállítani valamely képjavító eljárással jobb képet.

Nagyon nem jó fiókba raktad el magadban ezt. És fölösleges színezett szemüveggel gyanusítani azokat, akik a DLSS-be többet látnak, mert ennél jóval többről van szó. A szerverfarm(ok)on megtanult információk tömkelegét veti be a kép megalkotásakor, nem pedig egy képjavító eljárásról van szó a hagyományos értelemben. Ez nem egy post process és nem is supersampling, valahol a kettő között, ugyanis míg a förmedvény MLAA, vagy image sharpening egy (vagy) több aktuálisan kirenderelt képkockából dolgozó algoritmus, addig a SuperSampling egy a képernyőnél magasabb felbontásban történő renderelés eredményét skálázza lefelé kisebb felbontásra. Előbbinél nincs plusz input, kizárólag egy előre megírt algoritmus teszi hozzá a saját módosítását egy kész képhez. A SuperSampling rengeteg plusz információval bír, ráadásul nem közelített, vagy sejtett értékeket tesz a tényszerűen odavaló pixelek helyére/mellé. Sőt, még odavalóbb pixeleket tesz oda, hiszen 1 pixel színét több alkotja egyben, és mivel a valóság analóg ugye, tehát nincs felbontása, a kvázi végtelen felbontással érnénk el a tényekig (persze sokkal inkább csak olyan skáláig kell lemenni, ahol a molekulák sűrűsége már színt definiál egy emberi szemben megtalálható receptor számára, de ez már túlzás).

De a DLSS...! Fogja az alacsony felbontáson kirenderelt képet (pl. 1440p) és a sok-sok számítással kialakított neuronháló segítségével döntéseken keresztül kiegészíti a látottakat "emlékből". Az emlék picit megtévesztő, mert az emberben az emlék sokkal inkább érzés jellegű, semmint tényleges képi információ explicit részletekkel, de valami ilyesmiről van szó, mert "néha" téved és e tévedések egymásutánja változó glitch-ek formájában manifesztálódik a végleges képkockákon.

Amit kihangsúlyoznék: a DLSS nem pusztán azzal az információval rendelkezik bemenetként, amit a gpu kirenderelt, hanem egy iszonyat tömény adathalmazzal is, amit extrém magas felbontáson látottak alapján gyártott le neki egy (vagy több) bivalyerős vas. Ez a neuronháló a tréning mértékétől függően nem feltétlen csak "sejt" dolgokat, de kvázi jobban is tudhatja, mint egy natív felbontású végeredmény, hiszen jóval magasabb felbontású emlékekkel rendelkezik. Ne feledjük, hogy a natív render rengeteg kényszerű optimalizációval rendelkezik, amik közt az egyik legtipikusabb pl. a mipmapping, ami pl. a kerítés jellegű objektumoknál akár el is tüntetheti a hálós tartalmat. Egy SSAA esetén azt látnád ugye... ahogy egy DLSS is jellemzően itt brillírozni tud.

Mielőtt bárkiben felmerülne: a DLSS-t nem kell fetisizálni, de a távlatokat, amiket nyit az ML alapú render, azt jobban teszi mindenki, ha nyitott elmével fogadja, mert abban extrém meglepő tartalék lappang. (5~6 év múlva ha valaki még emlékszik erre a gondolatomra, akkor nyugodtan linkelje be, én szóltam, egy gyors hint: lásd tanult vs. számított fizika, ahol pont ugyanez történik).

szerk: ja igen, a lényeg: De, egy ML algoritmus közreműködésével készült 4K kép, ha nem is minden pillanatban és minden részletében, de tud helyesebb képet eredményezni, mint a natív 4K és ezt a véleményemet vállalom minden ezen nevető ember előtt.

[ Szerkesztve ]

Építs kötélhidat - https://u3d.as/3078

Új hozzászólás Aktív témák

Relatív gyári teljesítmények:

● RX 6400-hoz képest

● RX 6500 XT-hez képest

● RX 6650 XT-hez képest

● RX 6750 XT-hez képest

● RX 6950 XT-hez képest

Fogyasztási keret állításához:

● MorePowerTool

/link a weblap közepe fele/

● MorePowerTool leírás/guide, mit hogyan, miért !!!

Aktuális AMD driver:

● AMD.com

EXCEL-tábla topiklakók méréseivel:

● [LINK]

- AMD K6-III, és minden ami RETRO - Oldschool tuning

- Sorozatok

- Politika

- Xiaomi Mi 9 Lite - kilencre érdemes lapot húzni

- Hobby elektronika

- Épített vízhűtés (nem kompakt) topic

- MotoGP 24 - Íme a launch trailer

- Luck Dragon: Asszociációs játék. :)

- Az iPadOS-re írt appokra is díjat vet ki az Apple

- Kerékpárosok, bringások ide!

- További aktív témák...

- EVGA GeForce GTX 1080 Ti FTW3 GAMING 11GB GDDR5X 352bit (11G-P4-6696-KR) Videokártya

- Geforce GT 730 -4 gb videokártya

- PowerColor Red Dragon Radeon RX 5700 XT 8GB

- Hibátlan - GIGABYTE GTX 1660Ti Windforce OC 6G 6GB GDDR6 VGA videókártya dobozos

- ELADÓ 32 DB Nvidia RTX 3060 Ti és 8 DB Zotac Gaming Geforce RTX 3080 Trinity / KOMPLETT BÁNYAGÉP

Állásajánlatok

Cég: Promenade Publishing House Kft.

Város: Budapest

Cég: Ozeki Kft.

Város: Debrecen