Hirdetés

Hirdetés

-

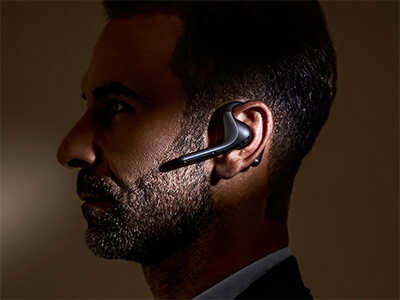

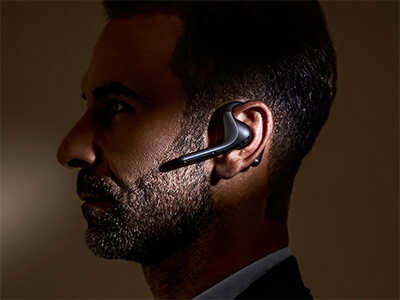

IFA 2024: A Timekettle új fordítógépe már közel van ahhoz, amire várunk

ma Ezek a hordozható fordítógépek évről-évre sokat fejlődnek, most a Timekettle mutatta meg, hogy hol tart az iparág.

-

Spyra: nagynyomású, akkus, automata vízipuska

lo Type-C port, egy töltéssel 2200 lövés, több, mint 2 kg-os súly, automata víz felszívás... Start the epic! :)

-

A cégek zöme már AI-t használ

it 200 millió heti szinten aktív felhasználója van már a ChatGPT-nek, miközben a 100 milliárd dollárosra értékelt OpenAI-ba az Apple és az NVIDIA is befektetne. Az OpenAI és az Anthropic aláírt az amerikai kormánnyal az AI-kutatás kapcsán, míg a Meta modelljeit bankok és tech cégek vezették be.

Új hozzászólás Aktív témák

-

S_x96x_S

őstag

> Ha te is alaposan megnézed a cb2024 már akkor elavult volt mikor kiadták.

sajnos igen,

"AVX-512 is used in Cinebench 2024, but in such low amounts that it’s irrelevant."

remélem jön majd egy zen5-re optimalizált változat is.

(Cinebench 2024: Reviewing the Benchmark )> Ha linuxolsz és villogni szeretnél manapság inkább tegyél be egy LLAMA tesztet.

rá kell nézni, hogy jól van-e lefordítva,

mert amúgy:

"Llamafile 0.7 Brings AVX-512 Support: 10x Faster Prompt Eval Times For AMD Zen 4"

https://www.phoronix.com/news/Llamafile-0.7de úgy általában az Inference-nél

a memória sebessége a szűk keresztmetszet, és abban az Intel egyenlőre jobb,

és nem véletlen, hogy a Threadripperek hasítanak, a több memória csatorna miatt.De amúgy linux tesztekből jó vagyok.

pl. itt egy másik: 173 CPU teszt. Ebből 60 esetben a 14900K volt az első.

És ez picivel több mint a tesztek 1/3 -a. És el kell ismerni, ez nem is annyira rossz a 14900K -tól. Viszont az idő az avx-512 -nek dolgozik. Egyre több és több alkalmazás támogatja."Across 173 different CPU/system benchmarks carried out, the Intel Core i9 14900K was in first place 60 times while the AMD Ryzen 9 7950X racked up 72 first place finishes and the 3D V-Cache enabled Ryzen 9 7950X3D racked up another 24 wins."

> Csak a gond hogy lehervadt a ryzen csúnyán benne.

szerencsére nem állt meg az optimalizáció.

https://x.com/JustineTunney/status/1790571803984966020

"I just wrote brand new exponent functions for llamafile and llama.cpp that make SiLU and SoftMax 2x faster, at full accuracy, for ARM NEON, AVX512, AVX2, AND SSE2."persze ezekből főleg majd a zen5 profitál, de már a zen4-nél is kimérhető.

https://github.com/ggerganov/llama.cpp/pull/7154#issuecomment-2102956053[ Szerkesztve ]

Mottó: "A verseny jó!"

Új hozzászólás Aktív témák

ph Az új fejlesztésű dizájn teljesen a TSMC-re épít, és a mobilgépeket célozza meg.

- Samsung Galaxy S24 Ultra - ha működik, ne változtass!

- Steam topic

- Vigneau interaktív lokálblogja

- Retroid Pocket 4 Pro teszt

- A piac legerősebb strapamobilját mutatja be az Ulefone

- Sony MILC fényképezőgépcsalád

- Audi, Cupra, Seat, Skoda, Volkswagen topik

- LG LCD és LED TV-k

- Taroltak a Pixel 9-ek a DxOMarknál

- Azonnali alaplapos kérdések órája

- További aktív témák...

Állásajánlatok

Cég: Ozeki Kft

Város: Debrecen

Cég: Ozeki Kft

Város: Debrecen