Hirdetés

-

Megérkezett Magyarországra a Samsung új OLED gaming monitora

ph Az Odyssey OLED G8 32 hüvelyes, sík OLED panellel dolgozik.

-

Retro Kocka Kuckó 2024

lo Megint eltelt egy esztendő, ezért mögyünk retrokockulni Vásárhelyre! Gyere velünk gyereknapon!

-

Elden Ring: Shadow of The Erdtree - Íme a végső gépigény

gp A kiegészítő érkezése már nincs messze, alig egy hetet kell már csak várnunk a DLC-re.

-

PROHARDVER!

A legtöbb kérdésre (igen, talán arra is amit éppen feltenni készülsz) már jó eséllyel megtalálható a válasz valahol a topikban. Mielőtt írnál, lapozz vagy tekerj kicsit visszább, és/vagy használd bátran a keresőt a kérdésed kulcsszavaival!

Új hozzászólás Aktív témák

-

TESCO-Zsömle

félisten

Kizárt. Alaplapba megy, szóval a 125-150W TDP köti őket, ha kijjebb nem tolják a keretet... Itt a GPU fogja a rövidebbet húzni, mert a prociba kell majd a 4 modul, de szvsz még így is jócskán felülmúlhatja a Trinity-t, elvégre a CPU szükséges része is fog addig töpörödni.

Számomra az nem világos, hogy lesz-e olyan APU, ami az AM3+-os Piledriver CPU-t váltja. Olyan amiben el van tolva a balansz a CPU felé, és van benne mondjuk 8 modul. Ami a dVGA-s üzemre van kihegyezve, pl munkára, vagy ez a vonal az AM3+-al együtt sírba száll és nyomjuk a Heterogén programokat helyette.

ViiiiktorOC: Azt sem számoltad bele, hogy a feldolgozókon kívül lesz még benne egy halom cucc, ami a Caymen-be nem volt, mert az nem kifejezetten cGPU.

Sub-Dungeoneer lvl -57

-

Abu85

HÁZIGAZDA

Azt nehéz összehasonlítani (főleg úgy, hogy a GCN rendkívül moduláris ... ki lehet hagyni a ACE-t is belőle, persze nem ajánlott, de az Intel és az NV is el fog menni a nagyon moduláris felépítés felé). Az AMD már 2013-ra összerakhatja a Bulldozert a GCN-nel. Az NV hasonlóval 2014-ben, míg az Intel 2015-ben állhat elő. Természetesen az AMD sem a 2013-as verziót hagyja meg 2014-re és 2015-re.

Egyébként minden generációban a 300 mm^2 lesz megcélozva.[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

Az NVIDIA messze van attól a modularitástól, amilyen a GCN. Pont ez az oka annak, hogy a Fermi csak a GF104/114-es GPU szintjén jó. Fölötte túl nagy, bár igaz, hogy más a célja is, de alatta egyszerűen a rendszer nem jól skálázódik. Túl nagy lesz a kisebb lapka. A GF106-Brats elég jó összehasonlítás. A feldolgozók valóban modulárisak, de a fő probléma a komplex vezérlés, ami eddig nem volt megoldva sehol. A GCN-ben az ACE motor látja el ennek a feladatát. Ez teljesen moduláris, sőt akár ki is hagyható a rendszerből, bár nyilván ez a hatékonyság rovására megy. A Kepler még nem lesz ilyen az NV-nél, de a Maxwell esetében már dolgozni kell egy hasonló rendszeren, mert csak így lehet normálisan skálázni.

A Bulldozer modul a hozzátartozó L2-vel 30,4 mm^2, míg a Sandy Bridge mag 29,5 mm^2 a hozzátartozó L3 szeletével. Abszolút nem nagy különbség. Egy szálon a Sandy Bridge mag a jobb, míg erős throughput terhelésen a Bulldozer modul. Ez nyilván tervezési eltérés. A különbség itt az L3-nál van. Az Intel azt a felépítést erőlteti, ami a korábban törölt Larrabee-kben volt. Az AMD nem akarta felvállalni ennek a kockázatát, mert kétszer nem működött, így kérdés, hogy harmadjára jó lesz-e. Inkább maradtak az L3 esetében a MOESI-nél. Arra az integrációra amire az AMD készül jobb döntés is, mert a GCN is rendelkezik normális belső cacheszervezéssel, és a Bulldozer is. Innentől kezdve az L3 egy kommunikációs elem lenne, vagyis 1-2 MB elég is. Az Intel az integrációt az L3-ra építi fel, és a Larrabee magok beépítésével is élni fog az x86 memóriaarchitektúrájának alapszabálya, vagyis egy mag L3-ba kiírt eredményét egy másik mag a következő ciklusban olvashatja. Erről megoszlanak a vélemények, hogy ez mennyire jó. A két elkaszált Larrabee mutatja, hogy vannak buktatók. Az Intelnek még egy dobása van a MIC fejlesztéssel és dönteni kell a Skylake integrálásáról. Nyilván a kérdés jelentős, mert ha a MIC bukik az még nem tragédia, de a Skylake esetében már biztosra kell menni. Ha továbbra sem működik a Larrabee, akkor szerintem nem fogják integrálni.

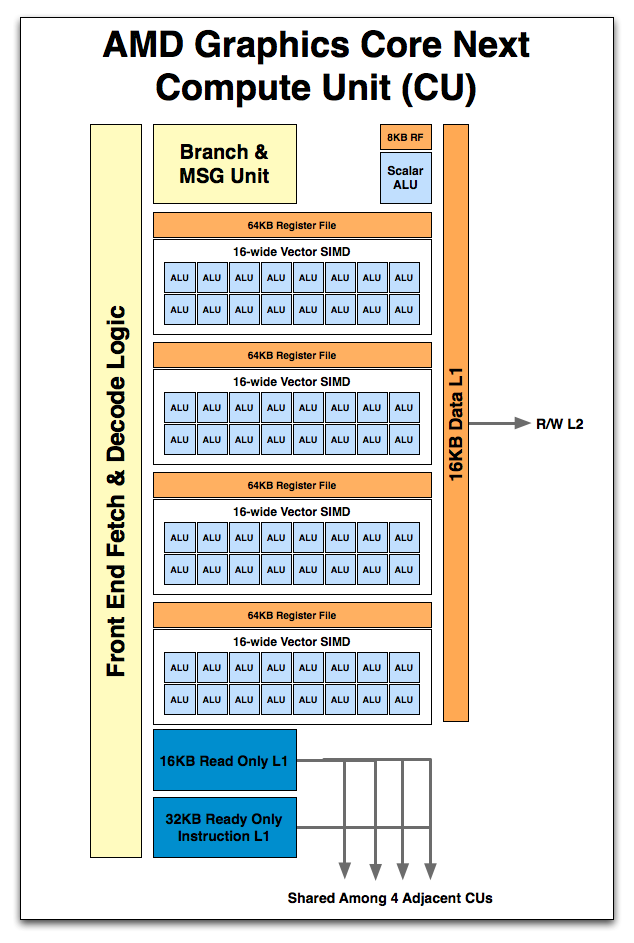

Az NV CPU-magja az eddigi ARM-magokhoz képest viszonylag nagy lesz. Az ARMv8-at még sok utasítással kiegészítik, hogy illeszkedjen az igényeikhez. Persze valószínű, hogy nem lesz akkora, mint a mai x86-os csúcsmagok. Ezt majd extra magokkal próbálják ellensúlyozni. A heterogén érában ennek nincs nagy jelentősége. Ha egy mag nem hozza azt, amit a másik cég egy magja, vagy modulja, akkor dobsz be még egyet, és a probléma letudva. Az NV-nek még az SM-ben kell dolgoznia. A CUDA magokban az FP skalárt vektorfeldolgozóra kell cserélni. Ez is a hatékonyságot növeli.A Fusionbe nem kell 32 CU. Elég 8 például, ehhez kell egy vagy két ACE, de inkább egy. Egy 1 MB-os L3 és két CPU-modul. Az Intel sem fog a Skylake-be 50 Larrabee magot építeni. Itt azon van a hangsúly, hogy az általános számításoknál a GPU egyszerűen sokkal hatékonyabb lehet a párhuzamos feldolgozás mellett. Egyetlen GCN CU például annyi flops/ciklust tud, mint egy Interlagos processzor. Persze nyilván az órajel nem egyezik, így a valóságban négyszer több GCN CU kell, de még így is nagyságrendekkel hatékonyabb az egész. Ugyanez igaz az Intelnél és az NV-nél is, csak más arányokkal, a GPU-s feldolgozás a throughput terhelés mellett elképesztően hatékony.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

Elég sok infó van a Bulldozermodulról, és az Intel magjának működéséről. Láthatod, hogy teljesen más cacheszervezést használnak. Ezért van a Bulldzoer moduljában 2 MB-os L2 cache, míg az Intelnél ez 256 kB. Az AMD a Bulldozernél nem úgy épít az L3-ra, hogy a rendszer elengedhetetlen része legyen, mert a Larrabee-t az Intel kétszer is elkaszálta, és félnek attól, hogy egy nagy L3 MESIF protokollal borzalmas terhelésnek lesz kitéve, ha abba nem 4-8 szál dolgozik, hanem több száz. A gyűrűs busz is addig tűnik jó ötletnek, amíg a pár mag és egység van, de ha beköltöznek a Larrabee magok, akkor 20 is lehet a rendszerben. Megállónként egy órajellel számolva hosszú az út a CPU-magokig. Ezért döntöttek úgy, hogy az L3 csak a rendszer kiegészítése lesz, MOESI koherenciaprotokollal. Itt az elmélet az Intel megoldása mellett van, de a tény, hogy két Larrabee hullott el ezen a ponton, már kérdésessé teszi a gyakorlati alkalmazhatóságot. Éppen ezért az AMD a biztonságosabb utat választja, így az L3 nem a rendszer alapköve, hanem csak egy része. Ez valamivel lassabb, illetve több helyet igényel a lapkán, de biztos, hogy működni fog a gyakorlatban, mivel a CPU-magoknak ott lesz az L2, így a GPU által teleszemetelhető L3-hoz aránylag ritkán kell nyúlni. Az L3 egyébként elhagyható a Trinity APU-ban például nem is lesz benne. Ettől a modulok teljesítménye alig változik, mert ott a nagy L2.

Meg SSEx kódoknál is gyorsabb, mivel egy Sandy Bridge mag a 256 bites feldolgozó felét használhatja, míg a Bulldozer modul az egészet. Az AVX kódoknál valóban lassabb.[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

PC-n nem gyengén pop-uppol a Rage. Ez egyértelműen annak a problémája, hogy a textúra betöltése lassú. Xbox 360-on a legjobb a játék ebből a szempontból. Nem véletlenül akar Carmack szabadulni a VGA-któl. Olyan PC-ket akar, mint amilyen az Xbox 360 felépítése. Az ID Tech 5-höz ez illik, ebben semmi kétség.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

Kb. igen. Elszámolta magát.

---

Más: Végre kaptam egy részletes doksit a DX11.1-ről. Mégsem tűnik olyan rossznak a VSC bitek visszatérése. Az MS kitalált egy olyan módszert, amivel nem kell rajzolási parancsonként ellenőrizni. Nice. Akkor így mégsem történt komoly visszalépés. Persze a szegmentálás megmarad, mert a specifikus kiterjesztések gyártóhoz vannak kötve.

Egyébként nem tűnik olyan lehetetlennek a DX11.1 a mai DX11-es hardverekkel sem. Elképzelhető a támogatás, még ha részlegesen is. A rendszer nagy része DX11-es kiegészítés, így ebből a mostani hardverek is profitálhatnak. Két rész van, ami probléma lehet a DX11-es hardvereknek. Az egyik a logikai operáció a render targeteken, míg a másik a kényszerített mintaszámítás lehetősége a reszterizáló státusz készítésénél. A többi újítás lényegében nem feltétlen követel új hardvert. Na most kérdés, hogy a mai hardverek közül ki fejlesztett többet, mint kellett volna.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

Az OEM-ek olyan BIOS-t kapnak, ami -20%-os PowerTune-t alkalmaz alapból, és megváltoztathatatlanul. Ezzel benne vannak a 300 wattban.

Nyilván a kiskereskedelmi kártyák esetében nem a BIOS-ban van megszabva a PowerTune. Ezt a driverből lehet állítani, vagy hagyni alapon, ami 375 wattos limitet jelent.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

FireKeeper

nagyúr

jah, arra emlékszem, az egyik oldalon volt az 5770 a(z akkor) kb használhatatlan DX11 supporttal és szűkös memsávszéllel, a másik oldalon a régi, kazán, de nagyon erős DX10.1-es 4870.

steam, GOG, uPlay: @petermadach || HotS: PeterMadach#2675 || Xperia 10 V || Ultrawide & SFF masterrace || Unofficial and unpaid VXE R1 shill

-

Z10N

veterán

Hanem mi? GFLOPS-ot meg nyilvan nem tudunk, mivel az orajelek nem ismertek. Szoval volnal kedves tajekoztatni, mivel hazon belul vagyunk az arch. azonos. A CU 4 SIMD-bol epul fel, SIMD-enkent 16 vektor ALU-val igy jon ki a 64 blokkonkent, ezenkivul ott van a skalar ALU.

# sshnuke 10.2.2.2 -rootpw="Z10N0101"

-

Z10N

veterán

Jah, hogy igy erted. Azt hittem a GCN ALU szamokra/strukturara ertetted. Igy egyetertek. A regebbi lapkaknal volt bottleneck a backenden rendesen a kotott ROP-ok miatt, meg a hatekonysag is mas volt (UTDP/GE/GU). Viszont a GCN-nel a ROP-ok mar le lettek csatolva a memoria vezerlorol. Persze a Pitcairn eseteben a 24 ROP meg erdekes lehet, de ha a Cape Verde-t vesszuk a 16 ROP is szepen elboldogul, bar ahogy te is mondtad a mem savszel elegge visszafogja. Azert gondolom, hogy egy kozepktegorias versenyzotol elvarhato a dupla GE. A fuggetlenedett ROP miatt viszont a 24 kerdeses. Az utolso felvetesed viszont jo meglatas. Lehet megis ALU csokkentes lesz lasd 7770.

# sshnuke 10.2.2.2 -rootpw="Z10N0101"

-

Abu85

HÁZIGAZDA

Az AMD-nek van saját rendezvénye június közepén, szóval nem feltétlen akarnak mindent ellőni a Computexen.

Amúgy annyi van, hogy júliusban jönnek az egyedi dupla Tahiti cGPU-s termékek. A PowerColorét már megírtam, és jön még a HIS is egy megoldással. Szerintem a HD 7990 megjelenése attól függ, hogy a piaca mekkora lenne a kártyának. Most, ha megnézed, akkor a GTX 690 már 1000 dolláros. Szóval ezeket az igényeket 1000-1000 példányban legyártott csúcskártya gyártónként bőven lefedné. Ha három gyártó csinál, akkor még gond is lesz az eladással.Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

1200-1500 dollár. Persze nem csak HD 7970 CF, hanem 1,1+ GHz GPU órajel, megy ugye 6-6 GB memória. Kifejezetten 5+ monitoros Eyefinity-hez, vagy három 4K displayhez.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

FireKeeper

nagyúr

nem hinném, hogy a high-end játékos szegmens olyan fontos lenne, hogy még egy chipet küldjenek ide. talán a professzionális piacra esetleg.

steam, GOG, uPlay: @petermadach || HotS: PeterMadach#2675 || Xperia 10 V || Ultrawide & SFF masterrace || Unofficial and unpaid VXE R1 shill

-

FireKeeper

nagyúr

ide már van egy komplett, kész, potens chipjük, aminek a konkurencia kénytelen volt aláárazni hogy versenyben maradjon. emellett nem hinném hogy lenne belőle annyi extra profit, ami megérné a fejlesztést, elvégre is aki 600-as felsőkategóriás geforce-ot akart venni, az már szerintem megtette.

steam, GOG, uPlay: @petermadach || HotS: PeterMadach#2675 || Xperia 10 V || Ultrawide & SFF masterrace || Unofficial and unpaid VXE R1 shill

-

KillerKollar

senior tag

Olvasgattam már régebben a vitáidat Abuval és ő is megmondta hogy hihetetlenül drágán és nagyon butítva lehetne csak kiadni a GK 100-at asztali változatban részben a fogyasztás miatt,nem érné meg semmiképpen sem,mindenképp jobban járnak ha a GK 104-en módosítanak.

[ Szerkesztve ]

-

FireKeeper

nagyúr

én úgy tudtam, hogy a GK104 lesz a játékos igények kielégítésére, míg a GK110 megy a prof piacra. ennek megfelelően a GK110-ben lesznek játékos szemszögből "használhatatlan" extrák (mint ahogy a Tahitiben is vannak), így lehet hogy a fogyasztással nem arányosan nő a teljesítmény.

a húzott Tahiti ellen érdemes szimplán meghúzni a GK104-et.steam, GOG, uPlay: @petermadach || HotS: PeterMadach#2675 || Xperia 10 V || Ultrawide & SFF masterrace || Unofficial and unpaid VXE R1 shill

-

fatallerror

addikt

és #6035) hoolla

lehet h tényleg nem lesz, a kártya csak elméletben létezik tudtommal tehát még prototípusa sincs és lehet tényleg úgy kalkulálták h nem éri meg kiadni

de lehet kiadják szeptemberben és akkor még mindig kb 4 hónapnyira lesznek a 8970estől és az nem lesz lényegesen gyorsabb a 7970nél, szerintem nagyon max 20%-al lesz gyorsabb amivel még szerintem kb 20-30%-al lassabb lenne a 7990nél tehát vásárló erő (az a pici) meglenne még az ősszel is[ Szerkesztve ]

don't tell me what i can't do!

-

fatallerror

addikt

-

Abu85

HÁZIGAZDA

Tegnap kérdezősködtem a TUL-nál. Ők azt mondták, hogy létezik, és már a nagyközönség is láthatta. (az AFDS-en ezt mutatták meg FirePro matricákkal - kis sunyik

)

)

Több vita is van viszont. A partnerek 1000 dolláros árcédulát akarnak, de az AMD szerint 800 dollár elég. Van pro/kontra érv. Az 1000 dollárt azért mondják a partnerek, mert kiszámolták, hogy ez olyan ~5000 eladást jelent világszinten, amit csak magas árral lehet értékelhetőnek tekinteni. Az AMD viszont legalább ~30000-et akar (ami szerintem még 800 dollárral sem fog összejönni), mert az alatt szerintük ennek az egésznek semmi értelme. Valószínű, hogy idén a partnerek akarata dönt, és lesz egy 1000 dolláros csúcs-Radeon, de az is valószínű, hogy ez lesz az utolsó, mert ~5000 eladásért nem éri meg fejleszteni. Azt nyilván látják, hogy a GTX 690 is alig jár párezer eladásnál, szóval az 1000 dollár az egy problémás ár, mivel nagyon a luxusszintre lövi a terméket (ráadásul itt nincs limitált széria meg hasonló, ami növelné a luxusértéket). Az SLI és a CF is gond. Ugye opciós lehetőség 1000 dollár helyett 1500-at vagy 2000-et kérni, de a user összerakja két VGA-ból és kész, szóval nem lehet nagyon fölé lőni az árban.

Amúgy a fogyasztás résszel nincs gond. Annyi lesz amennyi a HD 6990. Gyakorlatilag azt a koncepciót másolják le, amit az előd adott. Lesz OEM BIOS 300 wattos PowerTune limittel, míg a retail kártya 375 watt limitet kap, amit a második BIOS felold, és feltolja az órajeleket. Emellett lesz némi játék a PowerTune Boosttal, lényegében a koncepció újdonsága ebben ki is merül.

Szóval a rendszer létezik és a TUL szerint ősszel ki is hozzák az egyik nagy AMD-s játékhoz. Ez amúgy a másik vita, hogy Medal of Honor: Warfighter legyen vagy Hitman: Absolution. A célközönség inkább a Medal of Honor: Warfighter lehet (meg időben is kedvezőbb), de a Hitman: Absolution mögött jobban áll az AMD, így több DX11-es/compute effektre is lehet számítani, ami nyilván nagyobb reklámérték. A SQUARE ENIX is teljesen partner mindenben, míg az EA-nek TWIMTBP szerződése van, szóval ők azért a brutál compute effektekre kikényszerítik a nemleges választ a fejlesztőktől, vagy valami kompromisszumot. Az látszik, hogy az NV-t alapvetően nem zavarja, ha a GTX 680 hoz egy HD 7950 szintet, nagyjából ők is tudják, hogy az architektúra computeban gyenge, így számítanak rá, hogy lesznek játékok, amelyekben nem verhető a Tahiti (ez elfogadható a fejlesztők oldaláról is), olyat viszont nem szeretnének látni, hogy a GTX 680 a HD 7850-nel küzd. Tudják, hogy ez is reális nagy compute terhelés mellett, de akkor sem jó számukra.

Én úgy gondolom, hogy a Medal of Honor: Warfighter lesz a kiválasztott, mert az időben kedvezőbb, és a célközönség szempontjából is az. A Hitman meg majd kap külön reklámkampányt.[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

Nekik inkább azzal van gondjuk, hogy 1000 dollár az luxusszint. Túl lényegtelen az eladás mennyisége miatt. Szerintem ezt a HD 7990-et kiadják és vége a dupla-GPU-s vonalnak. Jövőre szerintem csak egy GPU-s Radeonok lesznek, de készülhet egy a 2.5D stacked DRAM-mal ellátott verzió a csúcslapkából. Ezt a technikát amúgy sem árt kipróbálni élesben egy APU-ba építés előtt. Nyilván azt tudjuk, hogy az AMD 5 éve dolgozik egy ilyen projekten a Hynix és pár más partnerrel, és már van prototípus. Szerintem a HD 8000-ben lesz termék is. A fejlesztők post-process erőltetései mellett hasznos lehet. Valószínűnek tartom, hogy a dupla-GPU-s vonalat egy ilyen váltja le.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

ricshard444

veterán

Legtöbb tesztben a 660Ti meg a 7950-t veri,hol reális ez max részletesség mellett ? Sehol szvsz,és akkor a fanok jönnek,hogy hú de kajak a kártya, a 680nak nincs párja,mert a 670 idézem "sz@rrá alázza a 7970-t is" .Ezzel még nem is lenne bajom,mert mégiscsak fanok,de hogy ez terjed el(még véletlenül sem a valóság) és elkezdenek lehülyézni az emberek,hogy "miért gányos AMD-t vettél és közelében sincs az nVidia-nak" Nemrég esett meg velem - True Story

+ egy régi kedves oldalamon is ez terjed,hogy 7950-t ne vegyél,a 660Ti olcsóbb és gyorsabb

+ egy régi kedves oldalamon is ez terjed,hogy 7950-t ne vegyél,a 660Ti olcsóbb és gyorsabb  Annyira nem izgat,csak fárasztó

Annyira nem izgat,csak fárasztó[ Szerkesztve ]

Vannak dolgok...

-

fatallerror

addikt

azt full leszarja az ember h gyorsabb pár %al (ha igaz) ha a gtx 680 141 ezer ft a 7970es meg 115 ezer.... vegye meg a márkabuzi annyiért a 680ast de h 26 ezer ft-al nem jobb az biztos, aki az ár/teljesítmény mutatót nézi most tuti 7950est választ....

én is nv-t szeretnék köv kártyának de így kétlem h megériakkor érné meg a 141 ezres gtx 680 ha 20-30%-al gyorsabb lenne a 7970nél, vagy annyival gyorsabb? linkeld bátran :]

#6079) ricshard444 : nem kell teszt, egyértelműen jobb ár/teljesítmény mutatója van a 7970nek a 680hoz képest de mint mondtam ez csak a márkabuziknak fáj, akit hidegen hagy h mi vana gépében az azt választja amelyik jobban megéri, most az amd éri meg na bumm

[ Szerkesztve ]

don't tell me what i can't do!

-

ricshard444

veterán

Sajnos ez tényleg ígyvan

1-2 hónapja méregettem a GTX480 VS 6950 teljesítménybeli különbségét,mindenki úgygondolja,hogy a GTX480 klassz,és veri a 6970-t is mert ez lett bemagyarázva nekik.Az általam tesztelt 5-6 programban 80-20%-s aránnyal nyert a 6950.Nem friss kártyás példa és nem is egy generációból vannak,de legalább igaz...

1-2 hónapja méregettem a GTX480 VS 6950 teljesítménybeli különbségét,mindenki úgygondolja,hogy a GTX480 klassz,és veri a 6970-t is mert ez lett bemagyarázva nekik.Az általam tesztelt 5-6 programban 80-20%-s aránnyal nyert a 6950.Nem friss kártyás példa és nem is egy generációból vannak,de legalább igaz...[ Szerkesztve ]

Vannak dolgok...

-

Tudom, hogy ezek a post-process AA-k mennek még DX9-el is. Annyiban kötődött csak bennem DX11-hez, hogy azzal miért nem lehet már valami jobb megoldást összehozni, ha DX10.1 óta már nem gond a deferrend renderig + MSAA -> De akkor mégis gond még mindig.

[ Szerkesztve ]

TV/monitor kalibrálást vállalok. ||| "All right , Thom. But understand this: I do care for you. I care for all the lost souls than end up up here."

-

Abu85

HÁZIGAZDA

Azok jó poénok.

Az Xbitlabs is csak ~26%-kal hozta ki átlag gyorsabbnak, de a konklúzió az lett, hogy nem mondható, hogy igazán erősebbnek a GTX 680-nál.

Az Xbitlabs is csak ~26%-kal hozta ki átlag gyorsabbnak, de a konklúzió az lett, hogy nem mondható, hogy igazán erősebbnek a GTX 680-nál.

Igazából a fő problémát az okozza, hogy a tesztelők többet tudnak arról, hogy mi megy a háttérben, és nem tetszik nekik az AMD új vezetőségének az iránya. Elvették a gyártóktól és a marketingtől a pénzt csak azért, hogy belefordítsák a Gaming Evolved és a Fusion Fund partnerprogramokba. Ezeknek olyan eredménye lesz, mint a WinZip 16.5, vagy a VLC vagyis bizonyos programfunkciók csak AMD hardverrel mennek. Ezt azonban hangsúlyozza az AMD, hogy félreértik. Nem azért nem mennek a funkciók NVIDIA és Intel termékeken, mert az AMD fizetett, hogy ne menjen, hanem azért, mert az AMD két évvel a többiek előtt jár az OpenCL eszközök fejlesztésében. Nyilván az Intel zárkózik fel, de sok idő kell még nekik, míg az NVIDIA számára az OpenCL nem fókusz. Na most ezt nem hiszik el sem az AMD-nek, sem pedig a fejlesztőknek. A Corel is mondta, hogy a WinZip 17-ben lesz OpenCL támogatás az Intel és az NV hardverekre is, de ott vannak a kétségek. Pedig a Corel által felvázolt indok elég egyszerű. Az AMD OpenCL támogatására tudják rámondani, hogy működik, és mivel a fájltömörítés egy kényes folyamat, értsd nem árt ha az adatok tömörítve is épek maradnak, így nyilván egy cég nem vállalja fel annak a lehetőségét, hogy CRC erroros lesz az állomány. Szerintem ez tök érthető. Hiába a sebesség, ha rossz lesz a tömörített adat. Ha nem tudják garantálni a hibátlan működést Intel és NV hardvereken, akkor inkább ne legyen gyorsítás.

Szóval most az AMD az új sátán a média szemében, mert az új vezetőség a szoftverfejlesztésekbe öli a pénzt, ami szegmentálhatja a PC-t.

Egyébként ez a stratégia tényleg érdekes. Gondolom Rory rájött, hogy évek óta próbálják verni az Intelt a kereskedelmi láncokban, de soha semmit nem nyertek vele. Egyszerűen az Intelt előnyben részesítik a partnerek, még ha az AMD sok kedvezményt és támogatást is ad nekik. Az új stratégia tehát az anyagiak átszervezése. Elvonni a marketing- és partnerpénzeket, és belerakni a szoftverfejlesztésekbe. A Gaming Evolveden ez nagyon látszik. Nyilván ez egy kiépített partnerprogram, tehát már ott van a fejlesztőknél. Az egyetlen amit módosítani kell, hogy agresszívabbá kell válni az effektek beépítésénél. Amíg Richard Huddy vezette, addig az volt a szempont, hogy a piac érdekeit nézzék, és jól optimalizált játékok jöjjenek. Ez látható is volt. A DiRT 3, a Deus Ex: Human Revolution, a Civilization V, és az Aliens vs. Predator mind baromira jól optimalizált program, ami általában alap, de fontosabb, hogy semmilyen olyan effekt nem volt bennük, amit az NV-t negatívan érintette. Amióta elment Richard Huddy az Intelhez, megváltozott a szellemisége is az egésznek. Rory kiadta a parancsot, hogy nem a piac érdeke az elsődleges, hanem az ügyfeleké (vásárlók) és az AMD-é. Ezzel a szemlélettel született a Sniper Elite V2, a Nexuiz, a DiRT Showdown és a Sleeping Dogs. Mindegyiken látszik a változás. Erős compute shader használat, és komoly anyagi büdzsé rengeteg kulcs megvásárlására, így a nagyobb webáruházak ingyen adhatnak a Radeonokhoz játékokat. Egyes termékekhez akár hármat. Persze nyilván az AMD nem tudta előre, hogy a Kepler ilyen gyík lesz compute-ban, de ha már így alakult, akkor Rory szerint jöjjön a vérszem is ki kell használni. Emellett igen erős váltásokon ment át a R&D részleg. Mivel a DX11.1 még nincs itt, így a compute shader használatot korlátozza a mostani DX SDK-ban található fejlesztőeszközök gyengesége. Egy fejlesztőcégnek nincs ideje és erőforrása komoly compute shader effekteket csinálni, mert a debug és profilozó eszközöket egyszerű shaderekre szabták. A bonyolult effekteket nehéz optimalizálni, így rengeteg hand tune-ra van szükség. Az AMD-nek erre ideje és pénze is van, és a kész eljárásokat odaadják a fejlesztőknek. Nyilván a DX11.1 sokat segít az új tracer API-val, de amíg az nincs itt, addig a fejlesztők többsége nem tud bonyolult shader kódot írni. Nem azért, mert hülyék, hanem túl sok lenne a beleölt pénz és idő, és ott van az a tényező, hogy ha nem sikerül jól a kód, akkor az egész kidobott pénz. Nyilván ezzel az AMD is találkozik, csak, ha az effekt mondjuk nem gyors, akkor idő mint a tenger kutatni kell tovább, vagy elmenni más irányba. Nekik nem lebeg a fejük felett egy játék kiadási dátuma. Ezt ugyan el lehet tolni, de egy grafikai effektért ritkán hoznak ilyen áldozatot.

Ugyanez a helyzet a Fusion Fundnál. Ez csak az anyagi támogatásról szólt régebben, de Rory érkezése óta egy Gaming Evolvedhez hasonló infrastruktúra kiépítése zajlik. "OpenCL-t akarsz a programba, de túl nehéz? Semmi gond. Az AMD programozói angyalszárnyon érkeznek és megcsinálják helyetted." Nagyjából ez a fejlesztőknek az üzenet. Ez a része persze bonyolultabb, mint a játék, mert itt azért általános programokról van szó, ahol jóval specifikusabbak az igények, de nyilván a multimédiás programok esetében lehet találni közös pontokat, szóval ez a rész egyszerűen fejleszthető általánosan. Sok videós program van például, de egyik sem transzkódolja a videókat annyira eltérően. És hasonló példákat lehet felhozni a felskálázásnál, a képmanipulációknál vagy képszerkesztésnél, illetve a mondjuk az arcfelismerésnél. A fejlesztőeszközök is egész érdekes irányba fejlődnek. Amíg az Intel az OpenCL toolt teszi nagyjából használhatóvá, addig az AMD a CodeXL-t befejezésén dolgozik, mely az első olyan fejlesztőkörnyezet, ami kifejezetten a heterogén érához készült. Azt ugye az AFDS-en kihangsúlyozta az AMD, hogy az általuk kínált fejlesztőkörnyezetek nem tartalmaznak kizárást a gyártókra, vagyis működnek Intel termékeken is, ellentétben az Intel OpenCL tooljaival, de azt nyilván senki sem gondolja, hogy az AMD nem a saját termékeihez fejleszti őket. Persze még így is gyorsabb kódot csinálsz Intelre az AMD SDK-ival, de ez betudható annak, hogy az AMD az OpenCL projektet három évvel az Intel előtt kezdte meg.

Ezek miatt az AMD most az iparág új sátánja, mert Rory más stratégiát dolgozott ki, mint a korábbi vezérek, és az AMD jelenleg a saját igényeire formálja a szoftverfejlesztéseket. Itt tehát két álláspont ütközik. Az egyik az, hogy a szoftverfejlesztés a független fejlesztők dolga, és egy hardvereket kínáló cégnek ebbe nem szabad beleszólni, mert az semmi jóhoz nem vezet. A fejlesztőeszközöket fel kell kínálni, és a fejlesztők majd megoldják. Alapvetően ez az Intel álláspontja is. Az NVIDIA álláspontját korábbról ismerjük. Ők támogatják a fejlesztéseket, az eszközökön kívül is, mindenféle más erőforrással (legyen az anyagi, humán, meg még mit tudom én mi). Az AMD új vezetősége is ebbe az irányba fordult. Erős fejlesztői támogatás és pénzelés a Gaming Evolveden keresztül, illetve GE-szerű partnerprogram kreálása az általános szoftverek fejlesztőinek. Ez sok médiának nem tetszik.Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

Ez az egyik hozománya a marketingpénz elvonásának az AMD-nél. Ugyanakkor az NV számára veszélyesebb a Gaming Evolved ilyen mértékű erősödése. Nem tart sokáig, amíg feltűnik, hogy az AMD került vezető szerepbe a játékfejlesztések támogatásában. [link] - a HardwareCanucksnak már feltűnt. A Sniper Elite V2, a DiRT Showdown és a Sleeping Dogs mint erősen támogatott AAA címek csak a kezdetet jelentik. Jön a Medal of Honor: Warfighter, a Hitman: Absolution, a BioShock Infinite és az új Tomb Raider. Két meg nem említett AAA játékról is tudok (Total War: Rome II és Company of Heroes 2). Azért ilyen AAA felhozatalt a zsebben még a sokat megélt TWIMTBP programtól sem láttunk. És egyszer mindenki lecseréli a régi játékokat a tesztekben, akkor pedig az kellemetlen lesz a Keplernek.

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

Csak szóban hozták ki kedvezőbbnek a 680-at, mert az eredmények világosak voltak. A GHz Edition gyorsabb. Az Xbitlabs azért merült fel, mert az ő eredményeit néztem. Ott 26%-os átlagos sebességelőnyre mondták, hogy nem lehet rámondani, hogy a leggyorsabb. Meg lehet nézni a tesztet. [link] - itt az összegzés. Ha számolsz, akkor átlag 26%-ot kapsz. Ez pedig a levont konklúzió: "It wouldn’t be correct to claim that the AMD Radeon HD 7970 GHz Edition is the fastest single-GPU graphics card available today because our tests do not show it to be overwhelmingly better than the reference GeForce GTX 680." Átlag 26% az ma már nem elég az AMD-nek, hogy gyorsabbnak mondják.

Az NVIDIA-nak már elfogadják. Az AMD-nek még nem. De ha ők is ezt csinálják, akkor az a piac szegmentációjához vezet, ami sokak szemében nem kedvező. Ez egyébként valóban gond. Gyakorlatilag ma már jobb aszerint dönteni, hogy mivel szeretnél játszani a PC-n is. Tiszta konzol beütés.

Ami nagyobb gond, hogy pár tesztelő kicsit a mellére szívja, hogy a Keplert agyondicsérte, amikor most kiderül, hogy jönnek a compute heavy játékok, és láthatóan nem acélos az architektúra ezekben a környezetekben. Sokan cikinek érzik, hogy nem látták előre, vagy legalábbis nem említették meg, minimum azt, hogy a Keplernek esetleg gondja lehet a compute hatékonysággal. Ezt médiában dolgozó ismerősöknél is látom. Pár tesztelő pipa azért, mert az AMD csak szintetikus benchmarkokon mutatta meg a GCN compute erejét, de nem hívta fel rá a figyelmet, hogy ezt idén még ki is használja nem is egy játék. Azért általában nem szokás a saját magad ajánlásának ellent mondani később. Persze szerintem közel sem ilyen drámai a helyzet. Az olvasók nem várják el, hogy előre lásd a jövőt, szóval kicsit tragikusan fogják fel ezt páran, mint ha a hitelük romlana tőle, pedig valójában nem tett senki sem rosszat, amikor a Keplert ajánlották. Mi is ezt tettük, még sem parázunk, hogy az új játékokban legyorsulja a GCN. Basszus ez van, eltelt 4 hónap megváltozott a helyzet. Nem először történik ez. Fless is változtatott az álláspontján a GTX 200 és HD 4800 időkben egy új teszt után. Még sem akasztotta fel senki, mert nem látta előre, hogy 4 hónap múlva más eredmények jönnek majd ki.A drivertámogatás módosítása jó döntés volt. Nem bírták volna a Win 8-ra való felkészülést havi frissítések mellett. Amint megvágták ezt és összevonták a fejlesztést rögtön beindultak, és elsőként kínáltak WHQL drivert a végleges Win 8 OS-hez. Ennek az OEM-ek nagyon örülnek, mert az AMD-s gépeket már elkezdhették végleges tesztfázist a Win 8 startjára.

Hát az alvó kutyák az valami fantasztikus. Szerintem mindenkit megleptek. És ha belegondolok, hogy ezt a játékot le akarták lőni.

Ez PowerColor magánakció. Más gyártó is csinál majd. De amúgy igazából ilyenek mellett szerintem az AMD átgondolhatja ezt a startot (én legalábbis ezt tenném). Igazából 800-1000 dollár környékén ennek nincs értelme. Ezen a szinten már a nagyobb OEM-ek sem gondolkodnak.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

Én nézegettem, és jellemzően számokban gyorsabb volt. Amúgy a cherry picked az jellemzően 3-5%-ot számít. A GCN nem itt szedi össze az előnyt, hanem a compute-on. Még az AMD-t is meglepte, hogy mit csinált az NV a Keplerrel. Abszolút nem erre számítottak a Fermi után.

Semmi gond nincs a driverrel, hibátlanul működnek a tesztekben is, és én is a 12.8-at használom. A használat módjával van gond. Sokan nem tudják megérteni, hogy az AMD nem adja oda senkinek a PowerTune specifikációját, enélkül pedig lehetetlen rá normális támogatást írni hozzá. Maga a Rivatuner fejlesztője mondta a Guru3D-n, hogy az AMD elzárta magát a 3rd party programoktól. Bárki telepíthet Afterburnert, az ATT-t, vagy más 3rd party cuccot, de elvágja magát a driver PowerTune rutinjától. Ez azt jelenti, hogy egy külön rutint kell az adott programnak betölteni, ami alapján a hardver működni fog, de mivel az AMD-n kívül senki sem tudja hogyan működik a PowerTune, így könnyen kitalálható, hogy ez egy elég nehéz feladat. A drivert megpróbálják visszafejteni, de ez nem könnyű, mivel a PowerTune-ra csak beállítások vannak, ami kódoltak, vagyis ha ez nincs meg, akkor a működés hibás lesz. A GeForce sokkal egyszerűbb, mert ott az energiamenedzsment és az órajel vezérlése még mindig a driveren keresztül megy, vagyis specifikáció nélkül is nagyon könnyen monitorozható, hogy mi történik, vagyis aránylag jó rutinok írhatók hozzá. Az AMD-nél a driver a Win indításakor elindít egy PowerTune profilt. A hardver ezt megérti, majd az alapján egészen az OS leállításáig dolgozni fog. A gondot az jelenti, hogy ez a profil a zárt Overdrive modulhoz kötött, vagyis ha 3rd party program órajelet akar állítani, akkor az első dolog, hogy ki kell ütni az Overdrive modult a driverből. De enélkül nincs PowerTune, vagyis nincs energiagazdálkodás, órajelváltozás, semmi. Tehát a 3rd party programokhoz vakon kell írni egy PowerTune profilt, a rendszer működésének ismerete nélkül. A GeForce-nál használt monitorozás sem segít, mert a PowerTune nem kér a drivertől engedélyt semmihez. A hardver dönt mindenről, és a változásokról ad a drivernek egy visszaigazolást, hogy x-y PowerTune szint bekapcsolt/kikapcsolt. Ez jó dolog, de a 3rd party fejlesztések a hogyanra kíváncsiak, és nem a visszaigazolásokra. Ezt azonban a szoftverből nem kapják meg, mert nem a driver dönt az aktiválásról. Az AMD arra egyébként már lehetőséget ad, hogy a 3rd party programok betöltsék a Overdrive modulját, vagyis ez a része már megoldott, csak ez magával vonja az Overdrive órajellimitjeit is a tuningnál. Ezért egyetlen 3rd party program sem használja a driver Overdrive modulját, ha a felhasználó tuningolni akar (szerencsére tuning nélkül már ezt töltik be). Ezt egyébként én is kipróbáltam, az ASUS progijával. Amíg nem nyúlok az órajelekhez hibátlan, de amint egy MHz-et is emelek jöhetnek a problémák. Ha ugyanezt az Overdrive modulban teszem meg nem történik semmi gond. A hibák egyébként képi villanásokban, és érdekes lagokban jönnek. Nem mindig persze, mert valamennyire már kiismerték a 3rd party fejlesztők, de nyilván a PowerTune egy eléggé komplex technika, szóval speckók nélkül nem sokra mennek.

A speckókat egyébként valszeg nem adják ki az elkövetkező hónapokban, vagy talán években, mert jelenleg mindenki PowerTunet próbálja másolni. Nyilván az AMD nagyon védi, hiszen öt évük ment rá. Szerintem alapvetően nem bonyolult a működés, csak trükkös, és gondolom, hogy ha publikusan specifikálva lenne, akkor könnyen le lehetne másolni. Az NV és az Intel addig, amíg nem alkotnak valami hasonló hardveres megoldást, addig az órajeljátékot és az energiamenedzsmentet többé kevésbé driverből oldják meg. Ennek egyébként igazi értéke a webböngészésnél van. A PowerTune előnye, hogy baromi gyorsan értékeli ki a hardver a szituációkat, vagyis bizonyos helyzeteket 10 ns-on belül lereagál órajelváltozással. Az energiamenedzsment pedig fél másodpercenkénti órajelváltásra ad lehetőséget, és 1 másodpercenként 1 MHz-es lépcsőkben is változhat az órajel. Ezért bírják az AMD IGP-s/GPU-s notebookok 1-2 órával tovább a gyorsított tartalmakon a webes terhelést, mint a konkurensek. Az NV-nél az energiamenedzsment 5-10-20 másodperces limitekhez kötött vagyis, ha beállt egy 3D órajel egy canvas kódra, akkor az minimum 5-10 másodpercig nem lehet újra köztes, vagy 10-20 másodpercig nem lehet újra idle (függően a hardvertől). És ha a leváltás megtörtént, akkor az idlet minimum 10 másodpercig tartani kell (Keplernél csak 5 sec). Mindebbe pedig be kell számolni a szoftver kiértékelését, ami 500 ms-os késleltetés. Az Intelnél az energiatakarékosság 2-4 másodperces limittel megy, vagyis aránylag elég jó, plusz a driver 500 ms-os késleltetése. A turbó az nehezebb ügy, mert az félig hardveres. De az engedélyt a rendszer a drivertől kéri, ami vagy engedélyt ad, vagy nem (általában igen, de vannak a driverben programokra profilok, ha az egy turbó tiltott exe fut, akkor a driver megtagadhatja a turbót). Mindenesetre a váltás az alap és a turbó között 2 másodpercen belül megtörténik, de a turbót addig kell tartani, amíg a driver nem mondja, hogy elég. Ezután még 10 másodperc az ütemezett leváltás, ami öt lépcsőben zajlik. Ezek a profilok egyébként azért vannak, mert a hardver túlbuzgó, és a flashekre, illetve a canvas tartalmakra nyomja a turbót rendesen. A canvassal nem lehet mit kezdeni, hacsak a böngészőre nem adod be a tiltást, de a flash az könnyebb ügy. A stage 3D-s flashprogramok, is jól profilozhatók. A canvas úgy van megoldva, hogy ha nincs aksin a noti, akkor a canvasra soha sincs turbó. A webgl az picit szopósabb. Oda sajnos néha nem ártana, de nehéz monitorozni, vagy mindenen megy, vagy semmin. Jelenleg a canvashoz hasonló a megoldás.

Ezek alapján érthető, hogy az AMD miért védi ennyire a PowerTune-t. Simán lemásolná mindenki, és akkor oda a webes üzemidő előnye.[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

Nem próbálkozni kell, hanem olvasni. Nem lehet mindenkinek fogni a kezét. Ami tényszerű, hogy elég sok teszt született ezekről a kártyákról. Driverhibáról soha semmi beszámoló nem volt. A ZeroCore pedig egyszerűen szintén utánaolvasás hiánya. Az AMD világosan beleírta a 12.4-es Catal note-jába, hogy akinek ezután sem megy, annak alaplapi BIOS-t kell frissíteni. A legtöbb alaplapgyártó hozott ki frissítést. Nem véletlen, hogy nekünk sosem volt problémánk a ZeroCore funkcióval. Minden tesztben ott a mért eredmény, a kikapcsolt monitor melletti idle fogyasztásról. El kell olvasni a release note-okat.

Ismerem, de megértheted az Intelt és az NV-t is, hogy 1-2 órával több üzemidőt kínál a Radeonos rendszer webböngészés mellett. Ez nagy előny. A Trinity APU 6 óráig bírta a webes terhelést, míg az Ivy 4-ig egy webes TechReport tesztben. Ez a különbség sok, így nem kérdés, hogy a teljesen hardveres energiagazdálkodás kedvezőbb a szoftveresnél. A jövőben tehát az Intel és az NV is ebbe az irányba fog menni. Nem PowerTune-nak fogják hívni, de úgy fog működni, mivel teljesen hardveres lesz.

[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

-

Abu85

HÁZIGAZDA

Mi a baj a játékoknál vele? Az órajel dobálása? A PowerTune 0%-os alapbeállításokkal mindig tartja az alapórajelet, kivéve a Furmarknál. Ha tuningolsz, akkor +20%-ra kell húzni, és a tuningórajel is stabil lesz. Ha pedig kevesebb fogyasztást akarsz, akkor -20%. Ekkor tényleg valós időben változik az órajel a legtöbb játéknál. Tehát ha nem mész negatívba, akkor sosem lesz egy játékban kisebb az órajel az alapnál.

Ami alapbeállításon is dobálja az órajelet az a GeForce-on a GPU Boost, akár 100 MHz-eket is pakol oda vissza. A PowerTune Boost is ilyen csak finomabb határokkal.

Van két kép, hogy mi az amit a GPU Boost és a PowerTune Boost beállíthat, mint érték. Az AMD esetében a váltás az alapon kívül csak egy órajelállapot. Az NV-nél az alapon kívül 8 külön órajelállapot van, de termékenként változó ugye, mivel ebből csak az alsó 4 garantált. Ezek között a rendszer valós időben válthat a terhelés függvényében.

A képeken egyébként a pontok erőssége azt jelenti, hogy az adott teszt során a rendszer milyen gyakorisággal lőtte be az órajel-feszültség párosát. Ha erősebb a szín, akkor sokszor, ha gyengébb, akkor kevésszer. A GPU Boost esetében ugye vannak üres helyek. Azok is léteznek, mint állapot, csak nem voltak a teszt közben aktívak.[ Szerkesztve ]

Senki sem dől be a hivatalos szóvivőnek, de mindenki hisz egy meg nem nevezett forrásnak.

Új hozzászólás Aktív témák

A topikban az OFF és minden egyéb, nem a témához kapcsolódó hozzászólás gyártása TILOS!

MIELŐTT LINKELNÉL VAGY KÉRDEZNÉL, MINDIG OLVASS KICSIT VISSZA!!

A topik témája:

Az AMD éppen érkező, vagy jövőbeni új grafikus processzorainak kivesézése, lehetőleg minél inkább szakmai keretek között maradva. Architektúra, esélylatolgatás, érdekességek, spekulációk, stb.

![;]](http://cdn.rios.hu/dl/s/v1.gif)