- AMD GPU-k jövője - amit tudni vélünk

- Google Chromecast topic

- VR topik (Oculus Rift, stb.)

- Gaming notebook topik

- Milyen TV-t vegyek?

- AMD Ryzen 9 / 7 / 5 / 3 5***(X) "Zen 3" (AM4)

- Milyen cserélhető objektíves gépet?

- ThinkPad (NEM IdeaPad)

- NVIDIA GeForce RTX 4080 /4080S / 4090 (AD103 / 102)

- Az NVIDIA szerint a partnereik prémium AI PC-ket kínálnak

Hirdetés

-

Spyra: akkus, nagynyomású, automata vízipuska

lo Type-C port, egy töltéssel 2200 lövés, több, mint 2 kg-os súly, automata víz felszívás... Start the epic! :)

-

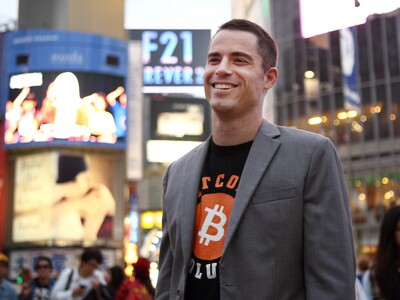

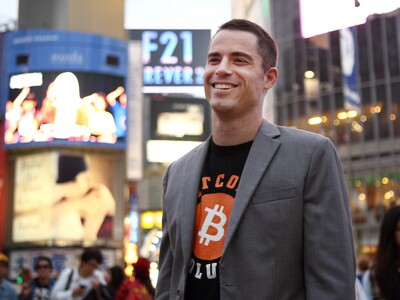

Letartóztatták a bitcoin-Jézust

it Amerikai adókerülés vádjával, Spanyolországban tartóztatták le a bitcoin-Jézusként ismert Roger Vert.

-

Ilyen lesz a SteamWorld Heist II

gp A folytatás a tervek szerint a nyár folyamán, pontosabban augusztus elején érkezik.

Új hozzászólás Aktív témák

-

sb

veterán

Itt most szerintem két dolog keveredik.

Decode és encode két külön dolog.

1. Dekódolás

- Itt nemigen van más kimenet adott forrásból. Különben sz*rra sem lenne jó az egész szabvány, ha mindenki más eredményt kapna.

- Utána már lehet utómunkával javítani a képen, de ez már utófeldolgozás ahogy írták. Van egy része amit mindenki tud: a scaling minden dekóderbe kell, itt már lehetnek gpu-függő eltérések is és a képminőségre kihat. mondjuk mint minden itt is eléggé függ a forrástól. Ha eleve nem lenne szükség skálázásra akkor ez a lépés is kiesne.

- És erre jöhet az extra hókuszpókusz - amit viszont általában ki szoktak kapcsolni az összes vga-n: élkiemelés, kontrasztosítás, denoise, sharpen, stb...2. Kódolás

Itt viszont lehet és van is minőségkülönbség a paraméterezhetőségből, a számítási pontosságból adódóan, de még akár többkörös kódolás is lehet ami miatt eltér a minőség. Mindez tök azonos bitráta mellett.

A hw encode eddig ezt nem tudta jó minőséggel, ha jól rémlik, akkor a kvantálás meg 1-2 hasonló lépés az ami kevésbé pontos mint a cpu-n futó algoritmusok. De erre már nem emlékszem pontosan.A lényeg, hogy jóval gyengébb videó jön ki a gpu-val kódolva ugyanolyan bitrátán mint cpu-val. Utóbbi viszont nyilván sokkal lassabb... főleg ha több pass van (ami ugye online streamnél amúgy sem járható út).

Dekódolásnál viszont nincs különbség. A scaling után már lehet, olyan amit 10-ből 9 ember észre sem vesz még szar forrásnál sem. Az utómunka meg feltűnő... mert jó eséllyel inkább ront az egészen.

Új hozzászólás Aktív témák

ph A vállalat gyorsított memóriaszkennelést javasol a kibertámadások észleléséhez.

- MSI VENTUS 2X RTX 3070 - eladó!

- Hibátlan - PALIT GTX 1650 StormX 4GB GDDR5 VGA videókártya - tápcsatlakozó nélküli !!!

- Újszerű PowerColor Fighter AMD Radeon RX 6600XT 8GB GDDR6 ÁR/ÉRTÉK BAJNOK! Bolti Garanciával!

- ELADÓ 32 DB Nvidia RTX 3060 Ti és 8 DB Zotac Gaming Geforce RTX 3080 Trinity / KOMPLETT BÁNYAGÉP

- PCX Garancia! MSI RTX 3080 Ti 12GB GDDR6X Gaming X TRIO Videokártya! BeszámítOK

Állásajánlatok

Cég: Ozeki Kft.

Város: Debrecen

Cég: Promenade Publishing House Kft.

Város: Budapest