A GK110-es GPU extrái

Ahogy azt korábban már említettük, az NVIDIA a Kepler esetében kettészelte a VGA-piac és a professzionális termékekre vágyó vásárlóbázis igényeit. A GK104 lényegében az előbbi területen alkalmazható jól, míg a GK110 lesz az igazi Kepler, amibe a HPC-piac számára értékelhető képességek kerülnek. A GK110 újításai tehát elsősorban a szerverekbe, illetve a professzionális termékekbe szólnak, ahol az új Hyper-Q és a Dynamic Parallelism szolgáltatás nagyon hasznos tud lenni.

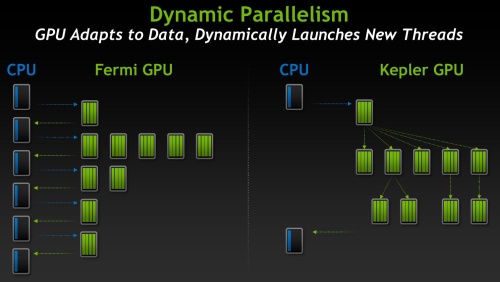

A Dynamic Parallelism a GPU kihasználtságát képes növelni azzal, hogy eliminálja a központi és grafikus processzor közötti kommunikációt. Korábban a processzor több szituációban is korlátozta a GPU-t, mivel minden kernelt a processzor indított a grafikus vezérlőn. A GK110 esetében ez nem feltétlenül szükséges, ugyanis a beágyazott kernelekkel a rendszer képes tovább dolgozni anélkül, hogy a processzor segítségét venné igénybe. Tulajdonképpen bármelyik kernel képes egy új kernelt indítani anélkül, hogy processzor beavatkozására lenne szükség.

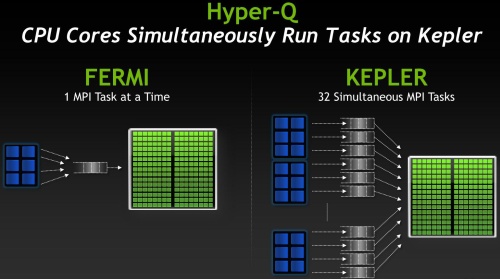

A Hyper-Q funkció is hasonlóan hasznos, mivel segít maximálisan kihasználni a GPU rendelkezésre álló erőforrást. A szolgáltatás lehetővé teszi, hogy a rendszer bármelyik processzormagja képes legyen munkafolyamatot indítani egyetlen GPU-n. Az MPI-alapú párhuzamos rendszerek ebből nagyon sokat profitálhatnak, mivel a Fermi architektúra esetében csak egy MPI munkafolyamat lehetett aktív egyidőben. Ez könnyen vezetett a rendszer rossz kihasználtságához, ám a Kepler a Hyper-Q segítségével 32 darab szimultán MPI munkafolyamatot kezel, ami jóval jobb hatékonyságot tesz lehetővé, az előző generációhoz viszonyítva.

Látható, hogy a GK110-es Kepler architektúra értékes fejlesztéseket tartalmaz, így már csak a megjelenést kell megvárni, és számos HPC-szerver építhet rá.

Virtualizált GPU

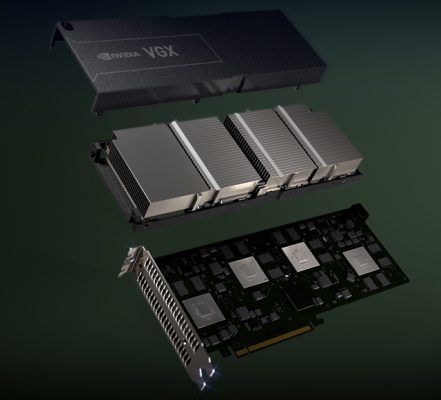

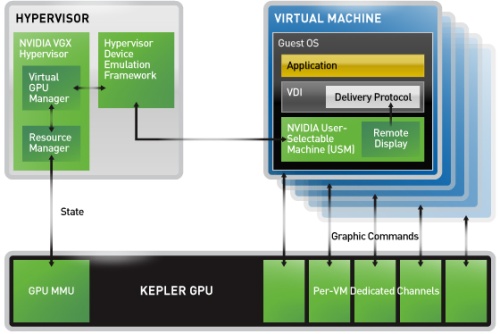

A másik érdekesség, amiről az NVIDIA beszélt, az a virtualizált GPU. A Kepler generációba tartozó termékek ebbe a csoportba tartoznak, így alkalmazható rajtuk a vállalat új VGX technológiája. Ez gyakorlatilag a grafikus processzor szétosztására szolgál, ami a VGX Hypervisor feladata. A rendszer egy GPU-t akár 256 darab virtuális erőforrássá is szétoszthat anélkül, hogy a teljesítmény drasztikusan csökkenne.

VGX Hypervisor

A VGX technológiához az NVIDIA még csak egy kártyát készített. Ezen a terméken négy darab Kepler architektúrára épülő GPU található, ám a lapkák kódnevéről nincs információ. Annyi biztos, hogy egy-egy GPU 192 darab CUDA magot tartalmaz, és 4 GB-nyi DDR3 szabványú memóriával dolgozik. A VGX Board összesítve 768 CUDA magot kínál, mellyel a számítási teljesítmény eléri az 1,3 TFLOPS-ot, és teszi mindezt 150 wattos fogyasztás mellett. Egy kártya maximum 100 darab virtuális gépet tud kiszolgálni, de nyilván egy szerveren belül több VGX Board is helyet kaphat.

A VGX technológia a virtualizált asztali környezetek piacát célozza meg, ahol igény is van a nagy teljesítményű virtuális grafikus erőforrásra. Az NVIDIA a technológia lényegét egy iPaden mutatta be, mely hálózaton keresztül kapcsolódott egy Windows operációs rendszert futtató PC-hez. A VGX segítségével a tablet Autodesk 3D-s szimulációt futtatott, mely virtuálisan jelent meg az iPad kijelzőjén, de valójában a háttérben megbúvó PC-n futott az egész.

Természetesen fontos eleme a technológiának a kliens számára biztosított képi jel, melyről a Kepler GPU-kban található dedikált transzkódoló gondoskodik. Ez az egység H.264-es videofolyamot kreál a futtatott feladatból, és lényegében az adott kliens csak a végső képkockát kapja meg. A felhasználó természetesen ezek alapján dolgozhat, és a kliens által fogadott beviteli parancsok a kiszolgálón kötnek ki, ahol ezek alapján új képkockák kerülnek számításra. Természetesen a H.264-es formátum tömörítést is jelent, amit a kliensgépnek ki kell kódolni, emellett a tömörítés veszteséggel is jár, vagyis a távoli kiszolgáló által biztosított kép nem lesz olyan jó minőségű, mintha ugyanazt a folyamatot a kliensgép csinálná. Ettől függetlenül számos piaci szegmensen megvan ennek az elgondolásnak az előnye, amelyek sokszor jobban számítanak, mint a hátrányok.

A cikk még nem ért véget, kérlek, lapozz!