Az NVIDIA izgalmas bejelentésre szánta el magát az idei GTC alkalmával. A cég a szerverpiacon főleg a gyorsítókra koncentrál, de manapság látható, hogy a skálázhatóság tekintetében komoly limitációkba ütköznek a PCI Express interfész által. A vállalat a gondra eredetileg az NVLINK-et dolgozta ki, amelyet pár Power9-es dizájn támogatott is az OpenPower kezdeményezés keretében, de a Power10-es dizájnoknál már egyáltalán nem nagy az érdeklődés. Az NVIDIA tehát ott találta magát, hogy van egy memóriakoherens megoldásuk a skálázhatósági problémákra, de senki sem akarja támogatni. Márpedig ez kulcskérdés, hiszen az épülő exascale szuperszámítógépek esetében a processzort és a gyorsítót mindig ugyanaz a gyártó szállítja, vagyis a zöldeknek nincs más választása, saját lábra kell állniuk.

A vállalat a fentiekre reflektálva bejelentette a Grace kódnevű szerverprocesszort. Erről elég keveset tudni, nem ismert, hogy milyen gyártástechnológián készül, a magok száma is kérdéses, viszont az biztos, hogy ARM architektúrát használ, továbbá valamelyik Neoverse dizájnt veti be. Itt nem volt sok választás az NVIDIA előtt. Az x86/AMD64-hez nincs hozzáférésük, míg az OpenPower a maga területén jó, de áttörést aligha lehet tőle várni. Maradt tehát az ARM, amely cég egyelőre nem tudott betörni a szerverpiacra, a legnagyobb partnerüknek tekinthető Marvell is inkább a specializálódás felé menetel, de ha összeszedjük az x86/AMD64 lehetséges alternatíváit, akkor igazából az ARM-nak van a legnagyobb esélye valamit elérni, még akkor is, ha egy komolyabb áttörésre éveket, akár egy évtizedet kell várni. Persze az NVIDIA kiemelte, hogy továbbra is támogatják majd az x86/AMD64-es szerverprocesszorokat, de ezekben sosem lesz natívan támogatva az NVLINK, mindig is egy limitációt jelentő szabványos interfészen keresztül lehet majd bekötni a cég gyorsítóit. Ez ugyanakkor egy állandó versenyhátrány lesz, mivel az Intel és az AMD abban érdekelt, hogy a saját processzoraik mellé a saját gyorsítóik kerüljenek, így nincs érdekükben a konkurens technológiák beépítése. Ez részben egy stratégia, ami jól látszik a leggyorsabb szuperszámítógépekre kiírt tendereken. Ezeket az NVIDIA korábban sorra nyerte, míg most az Aurora, a Frontier és az El Capitan nevű nagyvasakról is lemaradtak, ennek az oka pedig az, hogy nincs NVLINK az x86/AMD64-es szerverprocesszorokban.

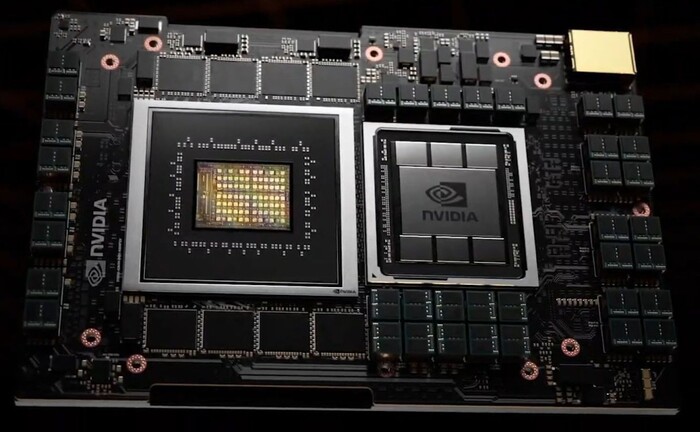

Maga a Grace kódnevű processzor LPDDR5X szabványú, ECC-t is támogató rendszermemóriát használ majd, amelyet 500 GB/s-nál is nagyobb memória-sávszélességgel ér majd el. A fő részelem természetesen az NVLINK, ennek is a negyedik generációs változata, amely a CPU-k közötti memóriakoherens összeköttetést 600, míg a CPU és GPU közöttit 900 GB/s-nál nagyobb tempóval oldja meg. A szóban forgó CPU leghamarabb 2023-ban érkezhet. Valószínűleg akkor is elkészül a fejlesztés, ha az ARM felvásárlását valamilyen okból nem sikerülne végrehajtani.

Az NVIDIA bejelentette, hogy a Swiss National Supercomputing Centre (CSCS) az első megrendelője a Grace kódnevű processzornak, ahol az Alps nevű szuperszámítógépet építik. Sajnos a zöldek továbbra is erősen marketingszámokat villogtatnak a nyers számítási teljesítményre vonatkozóan, hiszen 20 EFLOPS-os AI tempót mondanak. Ez korábban már egyszer előkerült a Leonardo nevű rendszernél, amely 10 EFLOPS-ot tudott AI teljesítményben papíron, de ez FP16-os operációk mellett jött ki számításba véve az úgynevezett structural sparsity-t is. Ez nem egyenlő a szuperszámítógépek besorolására tipikusan használt lebegőpontos formátummal, mivel erősen többszörözni tudja az EFLOPS paraméter elé írható számot. Ugyanakkor, amíg a Leonardo esetében megfejthető volt a többi rendszerrel összevethető teljesítmény, addig itt túl keveset tudni a hardverről, hogy erről bármit is közölni lehessen, de ahogy a korábbi 10 EFLOPS-osnak mondott gépnél, úgy most is elképzelhető, hogy az Alps nem tekinthető a szó legszorosabb értelemben exascale rendszernek.

A Los Alamos National Laboratory is épít majd nagyvasat a Grace processzorra, amiről igazából semmit sem tudni, leszámítva azt, hogy a Swiss National Supercomputing Centre rendszeréhez hasonlóan a HPE tervezi.

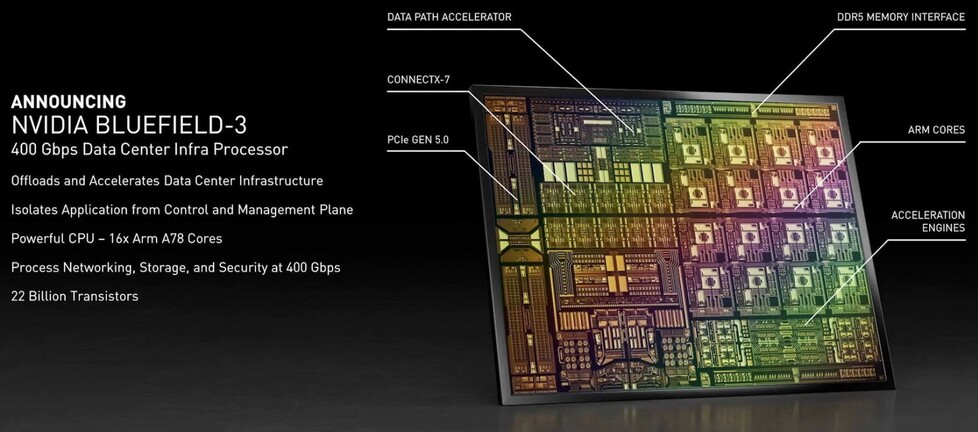

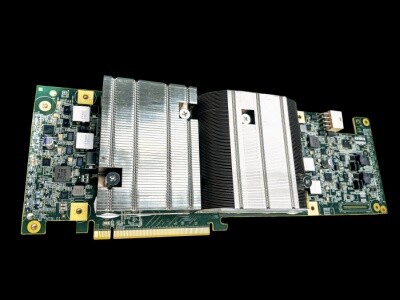

Az NVIDIA a fentieken túlmenően bejelentette még a Bluefield-3-at is, amely termékcsalád a korábban felvásárolt Mellanox technológiáját viszi tovább. Az új, 400 Gbps-os DPU (Data Processing Unit) 22 milliárd tranzisztort használ, a belsejében pedig számos specializált blokk mellett 16 darab ARM Cortex-A78 várja, hogy a hálózati funkciók nagy részét feldolgozhassa, ezzel tehermentesítve a host processzort. Itt érdemes megemlíteni az Aerial A100 nevű, PCI Express csatolóba helyezhető gyorsítót is, amely az A100-at ötvözi egy Bluefield-2-vel. Ezt az 5G-s bázisállomásokba szánja az NVIDIA.

A vállalat bemutatta még a DGX Station 320G-t is. Ez a múlt év novemberében még DGX Station A100 néven futott, amikor a vállalat először megszellőztette, de végül a gyorsítók teljes fedélzeti memóriájára utaló szám került a nevébe. A rendszer lényege ettől nem változott, vagyis négy darab A100 80 GB-os modellt kínál benne a cég. Erre az NVIDIA apró adatközpontként tekint, ami egyszerűen elhelyezhető egy irodában. Utóbbi miatt a relatíve halk hűtésre kiemelten figyeltek.

Végül szót érdemel az Orin kódnevű rendszerchip utódja, amely Atlan kódnéven készül, és az NVIDIA ebbe már integrálja a Bluefield technológiát, vagyis kap DPU-t is. A vállalat szerint ez lesz az iparág első rendszerchipje, amely 1000 TOPS-os AI számítási teljesítményt képes majd kipréselni magából, de erre 2025-ig várni kell.