Hagyományos futószalag – GeForce 7

A történet, melyben most a katarzishoz érkeztünk, valamikor négy évvel ezelőtt, a GeForce FX-fiaskó idejében kezdődött. Az NVIDIA már 2002-ben beindította annak a processzornak a fejlesztését, amit végül ma, G80 kódnév alatt mutattak be. Minden tekintetben radikális újdonságról van szó, mert a chipet már nem lehet egyszerűen csak GPU-nak nevezni. A grafikus feldolgozóegységet takaró rövidítés ugyanúgy nem illik rá, ahogyan a vizuális feldolgozó – VPU – név sem.

Egy ennyire új jelenséget bemutathatunk úgy is, hogy felsoroljuk a technikai adatait, a radikális változásokat, és közölhetjük a mérési eredményeket, de ez sohasem volt a PROHARDVER! stílusa. Most egy hosszú, részletekbe menő elméleti leírás következik, mely egyeseket elriaszthat, de aki veszi a fáradságot, az cikkünket végigolvasva képbe kerülhet a VGA-k jelenlegi helyzetével és közeli jövőjével kapcsolatban. Akit nem érdekelnek a részletek, az ugorjon rögvest a 6. oldalra, ahol egy rövidebb összefoglalót talál.

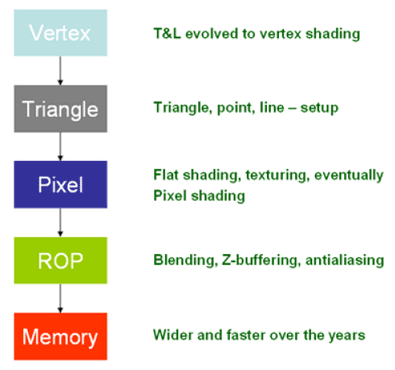

A G80 megértéséhez először a klasszikus grafikus futószalagot kell megismerni. A folyamat a geometriai csomópontok – a vertexek – felépítésével kezdődik, melyeket a térben eltolni – transzformálni – és világítani kell. Ezután következik a csomópontok háromszögekbe rendezése. Az utóbbi időben a harmadik lépés, a pixelszintű számolás kapta a legnagyobb hangsúlyt. Az egyes képpontok színének meghatározása folyik itt bonyolult matematikai számítások – árnyalási egyenletek – és textúrázási eljárások segítségével. A negyedik lépést az NVIDIA ROP (raster operation) vagyis raszteres műveleti résznek, a Microsoft pedig Input Mergernek nevezi. Itt összegződnek a pixel shaderek eredményei és itt kerül a képre az anti-aliasing (élsimítás). A ötödik elem a memória, melyben a végleges kép fölépül, és a textúrákat és egyéb adatokat tárolja.

Az évek során ez az elvi felépítés semmit sem változott, csak az egyes lépcsők fejlődtek. A DirectX 7-ben a vertexes rész kikerült a CPU-ból, és a grafikus processzor T&L (Transform & Lighting) egysége foglalkozott vele. A DirectX 8-ban a pixel egységek programozhatósága debütált, ami a DirectX 9 folyamán fokozatosan finomodott. A ROP részen fejlődtek a Z-buffer technikák és az élsimítás, a memória pedig egyre gyorsabb és gyorsabb lett.

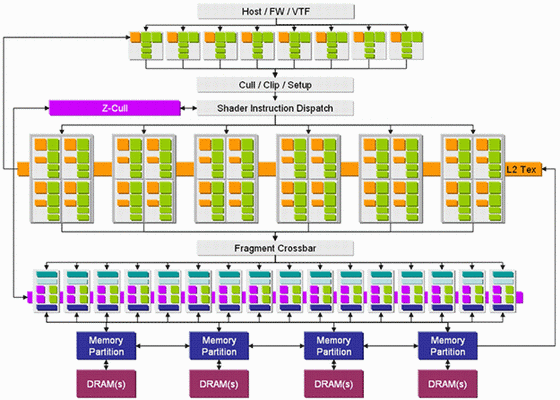

Az eddigi GPU-k közös jellemzője volt, hogy az egyes részfeladatokat specializált egységek hajtották végre; kialakult a jól ismert vertex shader, pixel shader, ROP felépítés, aminek legnagyszerűbb példája a GeForce 7 sorozat, melyet nyugodtan nevezhetünk tupírozott GeForce 6-nak is, hiszen technikailag szinte egyforma a két széria.

A klasszikus GPU felépítése – GeForce 7

A fenti ábrán jól látható a vertex shaderek, a pixel shaderek és a ROP egységek rétege, valamint a sok irányban csatolt memória. Az is látszik, hogy a pixel shaderek négyesekbe, úgy nevezett quadokba rendeződnek. Ez a felállás azért praktikus, mert a pixelek általában 2x2 pixel-negyedből – szubpixelből – épülnek fel.

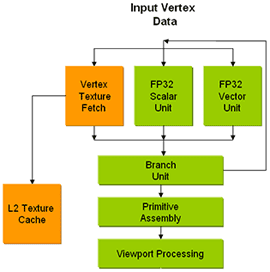

A vertex és pixel shaderek önmagukban sem egyszerű számolók. A GeForce 6-7 sorozat vertex árnyalóiban négykomponenses vektor és egy skalár számoló van, amiket ciklusvezérlő egészít ki, ráadásul nem csak aritmetikai, hanem logikai műveletekre is képesek. A vezérlőre azért van szükség, mert egyes műveletek vagy shaderkódok annyi számítást igényelhetnek, amit a számolóegység egy körben nem tud végrehajtani. Az eddigi GeForce-ok vertex egységei már textúrát is tudtak olvasni; erre a Radeonok csak közvetve képesek.

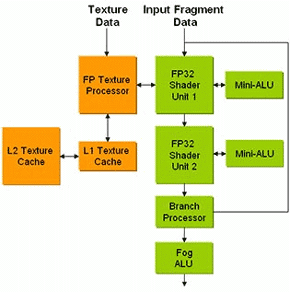

A pixel shaderek még összetettebbek. Nem egy, hanem két aritmetikai-logikai egységük (ALU-juk) van, amit egy textúrázó egészít ki. A GeForce 7 széria esetében ehhez jön még két mini-ALU és természetesen a ciklusvezérlő. Ami fontos, hogy a pixelszámolás négyes vektorokban zajlik, ami úgynevezett co-issue és dual-issue rendszerben is történhet. Az előbbinél egy háromkomponenses vektor és egy skalár számolható egyszerre, az utóbbiban két kétkomponenses vektor.

Hagyományos vertex shader és pixel shader – GeForce 7

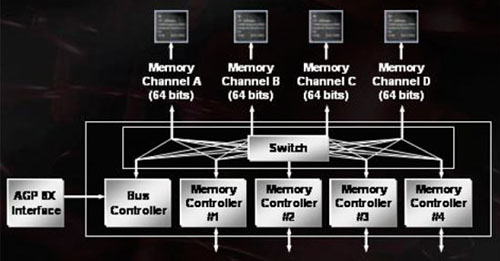

A memóriavezérlő is évek óta változatlan. Még valamikor a Radeon 8000-es széria és a GeForce 3 idejében megszületett a crossbar felépítés. Ez egy több részre osztott vezérlőt és sok memóriacsatornát jelent, amit egy kapcsoló köt össze. Crossbar nemcsak a memóriás részen lehet, hanem bárhol, ahol mindkét oldalon sok egységet kell szorosan kapcsolni. Ilyen van például a GeForce 7 pixel és ROP egységei között is.

4 x 64 bites crossbar memóriavezérlő

Első forradalom – Radeon X1000

Amikor hosszas csúszások után megjelent a Radeon X1000-es széria, az addig látott tervezési elvek többsége felborult. Az R5xx chipekben egy merőben új architektúrát ismertünk meg. Az új ATI felépítés bemutatásakor az aktuális VGA-királyt, az X1950 XTX-et, vagyis az R580-as GPU-t érdemes megnézni közelebbről. A vertex shaderek maradtak a régiek, de a pixelekkel foglalkozó rész jelentősen átalakult.

48 pixelszámoló elkülönített textúrázókkal – R580

Ahogy a fenti képen is látható, egy új, központi egység köré rengeteg pixel shader összpontosul, melyek hatalmas, közös regisztertömbön keresztül kommunikálnak. A regiszter egy, a memóriánál és a cache-eknél is gyorsabb adattároló terület, amit számoláshoz közvetlenül el lehet érni. A textúrázó egységek kikerültek az ALU-kból. Erre azért volt szükség, mert egy textúraművelet (írás vagy olvasás) nagyságrendekkel több időt vesz igénybe, mint egy aritmetikai vagy logikai művelet. Ha egy hagyományos shader textúraműveletbe kezdett, akkor a számoló addig üresen várakozott, míg a kívánt adat meg nem érkezett. A különálló textúrázók ezt a késleltetést eltüntetik.

Közelebbről megvizsgálva az új Radeon chipet látszik, hogy a pixel shaderek továbbra is négyelemű vektorokkal dolgoznak, és négyes csoportokba – quadokba – rendeződnek. Mind a 48 egységben megmaradt két ALU – vektor és skalár résszel –, valamint a cikluskezelő. A Radeon csak 3-1 elosztású co-issue-t tud, dual-issue-t nem.

Az X1000-es Radeonok másik nagy újítása a crossbarnál sokkal elegánsabb Ring Bus memóriavezérlő volt, mely sokkal kevesebb vezetékezést igényel, ráadásul az adott alkalmazásokhoz igazítható. A vezérlő felépítését korábban már részleteztük.

Ring Bus

Az újfajta elrendezés miatt nem lehet pusztán a számok alapján összehasonlítani a GeForce-okat és a Radeonokat. Az egyik oldalon 24 pixelfutószalag, a másikon 48 pixel shader sorakozik fel. Az egyik oldalon 24 textúrázó és 16 ROP egység, a másikon 16 textúrázó és ugyanennyi ROP van. Azért általánosságban elmondható, hogy a shaderintenzívebb, modern játékokban – mint amilyen az Oblivion – egyértelmű a Radeon X1950 előnye a GeForce 7900-zal szemben, tehát az NVIDIA lassan, de biztosan hátrányba került. Legutóbbi felsőkategóriás tesztünkben már látszott, hogy a legerősebb Radeonokkal csak a két GPU-t harcba küldő GeForce 7950 GX2 tudta felvenni a versenyt. Az egychipes 7900 GTX rendre alulmaradt a vörösökkel szemben, eljött a váltás ideje.

Második forradalom – GeForce 8

Az előddel és a konkurenciával kapcsolatos tudásunk felfrissítése után elérkeztünk az új, G80 kódnevű chiphez. A vektoros felépítésű shadereket, a négyes blokkokat, de még a különálló pixel és vertex shadereket is el lehet felejteni; van helyettük megannyi stream processzor. Az új feldolgozókat úgy kell felfogni, mint apró skalár ALU-kat, melyek ugyanazt az egyszerű műveletet hajtják végre egy bemenő adatfolyamon – streamen – és kimenetük is egy adatfolyam. Az eredménystreamet ezután gyorsan újabb processzorra lehet irányítani. A felépítés előnye a hagyományos, vektor+skalárossal szemben, hogy nullára csökkenthető a kihasználatlan komponensek száma.

128 stream processzor – G80

A másik, talán még fontosabb újdonság, hogy nincsenek különálló vertex és pixel shaderek, csak univerzálisak – ez az úgynevezett unified shader architektúra. Egy 3D jelenet felépítésekor egyenetlen a vertex és pixel műveletek aránya, ráadásul viszonyuk időben is változhat. Ha például mereven 4 vertex egységünk és 8 pixel egységünk van, akkor egy komolyabb geometriát tartalmazó kép megjelenítésekor a négy vertex egység vért izzad, míg a pixelesek többsége lógatja a lábát. Fordított esetben, erősen pixelszámolásra támaszkodó helyzetben a vertex egységek unatkoznak. Az unified shader felépítés mindkét esetet kiküszöböli.

Összegezve, a G80 a korábbi megoldások két leggyengébb pontját eliminálja. Nincs veszteség az egyenetlen pixel és vertex eloszlás miatt, és a vektoros felépítés miatti üresjáratok is eltűnnek.

Memória-sávszélességből soha nem lehet elég. Amikor az ATI előrukkolt az új Ring Busszal, arra hivatkozott, hogy a 256 bitnél szélesebb crossbar megvalósítása komoly technikai gondokat jelent. Nos, az NVIDIA-nál megoldották ezeket a gondokat. A G80 továbbra is crossbar vezérlőt használ, ráadásul a korábbi 4 x 64 bites felállásából 6 x 64, vagyis 384 bit lett!

Azért a nagy általánosítás mellett is maradt alap építőköve a G80-nak. Nyolc stream processzor alkot egy szorosabb egységet. Két ilyen egység – vagyis 16 stream processzor – egy blokkot jelent. A blokkot még négy textúracímező és nyolc textúraszűrő egészíti ki. A részek közti és a blokkok közti kommunikációt kétszintes cache segíti. A stream processzorok és a textúrázók halmazát egy szálkezelő irányítja. Az NVIDIA az egész rendszert GigaThread névvel illeti.

Egy stream processzor egyszerre egy MAD (a=b*c+d) és MUL (a = b*c) műveletet tud végrehajtani, 32 bites, lebegőpontos számokon. Az első hallásra szinte hihetetlen, 1350 MHz-es órajel mellett ez megközelítőleg 520 gigaflops-os nyers számítási teljesítményt jelent! A processzornak csak a stream processzorai futnak ilyen óriási ütemen, a GeForce 8800 GTX többi komponense 575 MHz-en jár. A G80 681 millió tranzisztorból épül fel, a TSMC gyárában készül 90 nm-es technológiával. A 384 bites memóriavezérlő a sima DDR-től a GDDR4-ig mindenféle memóriát támogat. A 8800 GTX-nek 900 MHz-es (effektíve 1800 MHz) GDDR3 memóriája van, abból is rögtön 768 MB. A kisebb GeForce 8800 GTS-nek csak 96 stream processzora – vagyis 6 nagy blokkja – van. A számolók 1200 MHz-en, a processzor többi része 500 MHz-en jár. A memória vezérlője 64 bittel, 320 bitesre, mérete 128 MB-tal, 640 MB-ra, órajele pedig 800 MHz-re csökkent.

További finomságok

A GigaThread mellett a Lumenex Engine nevet kell még alaposan az emlékezetünkbe vésni. A megnevezés alatt azok a grafikai megoldások rejtőznek, melyekkel eddig adósunk volt az NVIDIA. A négyszeres felett is versenyképes élsimításról (anti-aliasing, AA), a szögfüggetlen anizotropikus szűrésről, valamint a HDR és AA közös használatáról van szó.

Az NVIDIA eddig a négyszeres anti-aliasingra összpontosított, ahol RG-MSAA-t, vagyis elforgatott rácsos multisamplinget használt. Az eljárás lényege, hogy az amúgy függőleges oszlopokban és vízszintes sorokban elrendeződő mintavételezési rácsot elforgatják, amivel bizonyos mértékű rendezetlenség jön létre, így a csipkés élek hangsúlya eltűnik. Ez az eljárás négyszeres szinten még úgy-ahogy megállta a helyét az ATI teljesen rendezetlen mintavételezési pontjaival szemben, de magasabb szinten az NVIDIA a négyszeres módjának elcsúsztatását használta, ami az ATI tovább növelt mesterséges káoszával már nem tudta felvenni a versenyt, ráadásul lassú is volt.

Az új GeForce-os élsimítás a Coverage Sampling Anti-aliasing nevet, illetve a CSAA rövidítést kapta. Az elérhető módok a 8x, 8xQ, 16x és 16xQ. Egy meglehetősen semmitmondó ábra mellékletében azt az információt kaptuk, hogy a 16x CSAA sebességben nagyjából egyenrangú lesz az eddigi 4x MSAA-val, képminősége pedig messze túlszárnyalja azt. A két kijelentés így együtt kicsit meredeknek tűnhet, de tesztjeink során alaposan kivizsgáltuk, mi a valós helyzet.

Az ATI korábban büszkén hirdette, hogy csak az ő termékei képesek egyszerre HDR-t és AA-t használni. Mostantól nem érvényes ez, ugyanis a G80-ban végre van egyidejű HDR és AA. A nagy dinamikatartományú renderelés extrája, hogy nem csak 64 bites, hanem 128 bites precizitással is végrehajtható.

HDR + AA már GeForce-on is

Anizotropikus szűrésben is le volt maradva az NVIDIA – mostanáig. A GeForce 8 sorozatban végre olyan szögfüggetlen szűrés van, ami felveszi a versenyt a Radeonokkal, és klasszisokkal jobb a korábbi GeForce-oknál. Természetesen ezt az újdonságot is alaposan megvizsgáltuk sebesség és minőség szempontjából.

Anizotropikus szűrés – GeForce 7 és GeForce 8

A ROP egységeket is átvariálták az új chipben. A G80-nak hat raszter egysége van, melyek fejenként 4 pixelt (vagyis 16 szubpixelt) készítenek el ütemenként, ami összesen 24 pixelt jelent. Árnyékkezeléskor, amikor csak Z-értéket kell számolni, az új NVIDIA chip egyszerre 192 pixelt tud elővarázsolni. A G71 egyszerre 16 színes vagy 32 árnyékos pixelt tudott kiszámolni, tehát ezen a téren is komolyan erősített a G80.

Az új, stream processzoros felépítésnek köszönhetően sokat javult a GeForce-ok cikluskezelése. A GeForce 7 sorozat egyszerre 880 pixeles tömbökön tudott dolgozni. Ha történetesen a tömbben csak néhány pixelen kellett végrehajtani az adott műveletet, akkor is végig kellett próbálgatni az összeset, hiszen csak úgy derült ki, melyek a kiválasztottak. A Radeon X1900-as széria már jelentősen kisebb, 48 pixeles egységekkel dolgozik, de a G80 még ezen is túltesz. Egyes esetekben 32 pixeles, de van, amikor 16 pixeles csoportokkal operál, így jelentősen csökkenthető a fölösleges feltételvizsgálatok száma, ami komplex shaderprogramoknál nagyon jó lehet.

Azok is nagyon örüli fognak az új GeForce-nak, akik nem feltétlenül játékra vagy grafikára igényelnek nagy számítási teljesítményét. Az 520 gigaflops-os nyers erő standard C programozási nyelven is elérhető. A Compute Unified Device Architecture-nek (CUDA) köszönhetően a masszívan párhuzamosítható, többszálas számítási műveletekben a G80 128 darab, 1350 MHz-es stream processzora nagyságrendekkel gyorsabb a hagyományos CPU-knál, ráadásul SLI-ben több grafikus kártya is összekapcsolható

DirectX 10

Biztosan sokaknak feltűnt, hogy a G80 kapcsán eddig meg sem említettük a DirectX 10-et, holott mindenki az új grafikus rendszerről papol már hónapok óta. Véleményünk szerint ami nincs, arról nem nagyon érdemes beszélni. Az igazat megvallva, mi is vártuk, hogy az NVIDIA ad majd valamiféle DirectX 10-es demót, amit legalább be tudunk mutatni egy megjelenés előtti Vistával, de csak a nagy reklámszövegeket kaptuk, hogy DirectX 10 így, DirectX 10 úgy. Mindenesetre röviden bemutatjuk az új módi főbb jellemzőit.

Egyelőre a DirectX 10 csak Windows Vista alatt lesz elérhető, és valószínűleg ez így is marad. A Microsoft szerint túl bonyolult lenne az új rendszer XP-re való átültetése. A Vistához nem kell majd feltétlenül DirectX 10-es videokártya. Elsősorban az operációs rendszernek köszönhető, hogy a DirectX 10 alatt az eddiginél sokkal stabilabb meghajtórendszer lesz, amit WDDM (Windows Display Driver Model) néven ismerhetünk meg. Az újdonság lényege, hogy a meghajtónak van egy alkalmazás módú és egy kernel módú része. A szoftverek – játékok – grafikai (Direct3D) hívásai alkalmazási módban vannak, így ha valami folytán elszáll egy program, nem rántja magával az egész operációs rendszert.

WDDM – a Vista meghajtórendszere – Direct3D felhasználói módban

A DirectX 10-et teljesen az alapjaitól építették fel újra, így nem kompatibilis a korábbi DirectX 9-cel. A DirectX 9-es hardver nem tudja majd futtatni a DirectX 10-es kódot, de a DirectX 10-es vas kezeli a DirectX 9-et is. Az újjáépítésnek és a régi irányelvek elhagyásának nagy előnye, hogy rengeteg korábbi korláttól meg lehetett szabadulni. Az új DirectX első nagy előnye, hogy jelentősen csökken a CPU és GPU közötti adatátvitelből adódó késleltetés (overhead). A korábbi modellnél minden objektumot külön adott át a CPU, ugyanis többnyire a központi egység módosította az egyes elemeket. Most közös az átadás, így kevesebb a veszteség. DirectX 9-ben a vezérléssel kapcsolatos és a hasznos műveletekre fordított idő aránya nagyjából 40/60 százalék volt; ez DirectX 10 alatt 20/80 százalékra módosul.

Az új DirectX kifejlesztésekor felhasználták a korábbi, programozható shaderes tapasztalatokat. A kódolók szempontjából nagyon fontos korlátot oldottak fel. Eltörölték az úgy nevezett cap biteket, ami annyit jelent, hogy mostantól nincs feles megfelelés – mint például a DirectX 9 esetében a Shader Model 2.0 és 3.0. Egy hardver akkor lehet DirectX 10-kompatibilis, ha minden feltételnek megfelel. Ezzel rövidül az egyes alkalmazások fejlesztési ideje, hiszen nem kell ez eltérő hardverek miatt különböző kódrészeket írni. Persze, a DirectX 10 kizálólagos elterjedése még távol van, legalább 3–4 évet várni kell majd rá.

A harmadik nagy újítás, hogy az eddigi vertex shader (VS) és pixel shader (PS) közé beékelődött a geometriai shader (GS), így a VS-PS útvonal VS-GS-PS-re módosul. Az új számoló vertexcsoportokkal, geometriai primitívekkel dolgozik, de új csomópontokat is létrehozhat, vagy régieket törölhet. Az ilyen jellegű műveletekre animálásnál vagy fizika számolásánál van szükség, amit eddig a CPU végzett. Hogy még összetettebb hatásokat lehessen elérni, az útvonalba a GS mögé egy Stream Out lépést építettek be, amivel az addig létrehozott adatok ismét a VS-ekbe vagy a GS-ekbe tölthetőek. Mondhatni, a geometriával foglalkozó VS és GS alkot egy szorosabb tömböt, amihez lazábban kapcsolódik a PS.

Az új modell egyes shaderei felépítésben azonosak, így szinte egyértelmű volt, hogy a G80-éhoz hasonló, egységesített shaderes architektúrával érdemes próbálkozni, hiszen a merev VS-ek, GS-ek, PS-ek arányát még nehezebb lehet megfelelően belőni, mint korábban a VS-ek és PS-ek arányát. Így az egyes shaderek, ha úgy hozza a szükség, vertexeket számolnak, ha kell, geometriai primitíveket tologatnak vagy pixeleket számolnak. Persze DirectX 10-es hardver elkülönített VS, GS és PS blokkokkal is megoldható, de valószínű, hogy ilyet nem fogunk látni. A kötetlen, egységesített shaderek új modellt is kaptak. A Shader Model 4 az eddigiekhez képest több utasítást, több konstanst, nagyobb textúrákat, új utasításokat, egyszóval nagyobb szabadságot biztosít.

Programozható shader modellek

Sokszor felmerült a kérdés, hogy mennyivel lesz szebb és jobb a DirectX 10. Ennek taglalásába egyelőre teljesen fölösleges belekezdeni. A legtöbb, DirectX 10-zel kapcsolatban álló vállalat az eddiginél sokkal élethűbb megjelenítést ígér. Rengeteg DX9 és DX10 összehasonlító képet láttunk már, melyek közül néhányról kiderült, hogy nem is DX10-zel, hanem valamilyen fotóretusáló szoftverrel készültek. Tim Sweeny, az Unreal Engine vezető fejlesztője nemrégiben azt nyilatkozta a FiringSquadnak, hogy elsősorban gyorsulásra számíthatunk. A DirectX 10 tehermentesíti a CPU-t, és az egyre erősödő grafikus processzoroknak, meg a nagyobb mozgástérnek köszönhetően tovább finomíthatóak az egyes vizuális hatások. Egyelőre semmilyen eszközzel nem tudjuk bemutatni a DirectX 10 képességeit, de amint megérkezik a szükséges szoftver, napirendre tűzzük a témát.

Elméleti összefoglalás

Foglaljuk össze, milyen újdonságokat hozott a G80. A TSMC gyárában 90 nm-es csíkszélességgel készülő, közel 700 millió tranzisztorból álló chip az első PC-be szánt egységesített – unified – shaderes felépítésű GPU, mely messze túlmutat a hagyományos GPU-kon. Nincsenek pixelfutószalagjai, de még hagyományos értelemben vett shaderei sem. A munkát 128 darab stream processzor végzi, melyek a GeForce 8800 GTX zászlóshajónál 1350 MHz-en dolgoznak. A GPU többi része 575 MHz-es ütemen jár. A szupergyors számolókhoz hat termetes ROP (raszterműveleti) egység tartozik, melyek normál pixeleket másfélszer olyan sebességgel gyártanak, mint a GeForce 7900 GTX, árnyékot pedig hatszoros sebességgel számolnak. A GPU-hoz 384 bites vezérlőn keresztül 768 MB GDDR3 memória kapcsolódik, ami 900 MHz-en (effektíve 1800 MHz-en) jár.

A brutális hardver tud újfajta élsimítást és anizotropikus szűrést, melyek már a Radeonokkal is felveszik a versenyt. A G80 végre egyszerre képes HDR-t és AA-t használni, így az NVIDIA ebben is utolérte az ATI-t.

Az új GPU nem csupán az első unified shaderes architektúra PC-re, hanem az első DirectX 10-es megoldás is. Az új DirectX szorosan kapcsolódik a Vistához. Legnagyobb újdonsága, hogy a vertexek és pixelek mellett már geometriát is kezel, így nagymértékben tehermentesíti a CPU-t; átveheti az animálást és a fizika számolását. A DirectX 10 részleteivel a Windows Vista megjelenésekor behatóan foglalkozunk majd.

| VGA megnevezése | NVIDIA GeForce 8800 GTX | NVIDIA GeForce 8800 GTS | NVIDIA GeForce 7950 GX2 | NVIDIA GeForce 7900 GTX | ATI Radeon X1950 XTX |

| GPU kódneve | G80 | G80 | 2xG71 | G71 | R580 |

| Gyártástechnológia | 90 nm (TSMC) | 90 nm (TSMC) | 90 nm (TSMC) | 90 nm (TSMC) | 90 nm (TSMC) |

| Tranzisztorok száma | 681 millió | 681 millió | 2 x 278 millió | 278 millió | 380 millió |

| GPU órajele | 575 / 1350 MHz | 500 / 1200 MHz | 500 MHz | 650 MHz | 650 MHz |

| Vertex shader egységek száma | 128 darab skalár stream processzor | 96 darab skalár stream processzor | 2 x 8 | 8 | 8 |

| Pixelfutószalagok száma | 2 x 24 | 24 | 48 pixel shader | ||

| Pixel shaderek száma | 2 x 24 | 24 | |||

| Textúrázók száma | 32 textúracímező, 64 textúraszűrő |

24 textúracímező, 48 textúraszűrő |

2 x 24 | 24 | 16 |

| ROP egységek száma | 6 blokk | 5 blokk | 2 x 16 | 16 | 16 |

| Támogatott PS- és VS-verzió | 4.0 / 4.0 | 4.0 / 4.0 | 3.0+ / 3.0+ | 3.0+ / 3.0+ | 3.0+ / 3.0+ |

| Memóriavezérlő | 384 bites crossbar | 320 bites crossbar | 256 bites crossbar | 256 bites crossbar | 256 bites Ring Bus |

| Memória órajele | 900 MHz | 800 MHz | 600 MHz | 800 MHz | 1000 MHz |

| Memória-sávszélesség | 86400 MB/s | 64000 MB/s | 76800 MB/s | 51200 MB/s | 64000 MB/s |

| Memória mérete | 768 MB | 640 MB | 2 x 512 MB | 512 MB | 512 MB |

Ma, a bemutatás napján azonnal elérhetővé válik a GeForce 8800 GTX zászlóshajó és a valamivel kisebb GeForce 8800 GTS. A nagyobb kártya ajánlott ára 599 dollár, a kisebbé 449 dollár. A VR-Zone szerint máris visszahívták a 8800 GTX-ek egy részét, vélhetőleg feszültségszabályozási probléma miatt; ebbe tesztkártyánk is belefutott. A hiba nem érinti a 8800 GTS-eket.

GeForce 8800 GTX testközelből

Tesztlaborunkban a nagyobbik GeForce 8-as, a 8800 GTX landolt. Első pillantásra látszott, hogy itt valami hatalmassal van dolgunk. A méretes hűtő alatt hihetetlenül hosszú nyomtatott áramkör nyújtózott.

A kártya teljes hozza megközelítőleg 27 centiméter, így lelógott az alaplapról. Ez kisebb házak esetében gondot jelenthet, de aki egy ekkora óriást vásárol, annak biztosan a háza is méretes.

Az új csúcs-GeForce-ot közelebbről szemlélve először a hatalmas hűtőn akadt meg a szemünk. A szomszédos kártyahelyet is felemésztő megoldás nagyobb minden eddig látottnál. A lapátkerékszerű ventilátor a házból kifelé fújná a levegőt, ha nem lenne a hűtő borításán néhány rés. Nagy meglepetésünkre a közel 700 millió tranzisztoros chip hűtése egyáltalán nem volt hangos, zaja a GeForce 7900 GTX szintjén mozgott, tehát zárt házból alig hallatszott ki.

A kártya hátulján nincs semmi érdekes, a nagy csoda a hűtő alatt bújt meg. A GPU-t hatalmas fémsapka borítja, mely alá nem mertünk benézni. A kártya végén, a két DVI csatlakozó előtt látható még egy kisebb chip, amely a RAMDAC-okat rejti – ezek korábban a GPU-ban laktak. Érdekes a memóriamodulok kiosztása is. Eddig a crossbaros kártyáknál kettő valamely egész számú hatványához voltunk szokva, most viszont 12 chipet találtunk. A válasz egyszerű. Két-két chip alkotja a hatcsatornás vezérlő egy-egy 64 bites ágát, így jön össze a 384 bit (6 x 64 bit).

Említést érdemel még a 8800 GTX hátulján látható két PCI Express tápcsatlakozó. A kártya az alaplaptól, a PCI Express buszon keresztül legfeljebb 75 wattot kaphat. A szabvány szerint az extra csatlakozóról is legfeljebb 75 wattnyi energia irányítható a grafikus kártya felé. A két konnektorból arra lehet következtetni, hogy a 8800 GTX valahol 150 és 225 watt között fogyaszt. A tesztelési útmutató a 8800 GTX-hez legalább 450 wattos tápot jelöl meg, melynek 12 voltos ága legalább 30 A leadására képes. A 8800 GTS igénye kisebb; 400 watt és 26 A a 12 voltos ágon.

A hűtést megbontva látszik, hogy a nagy ventilátor még nagyobb bordára fújja a levegőt. A hőleadóban egy heat-pipe húzódik végig, de a korábbi kémfotókon látott vízhűtéscsonkoknak nyomát sem találtuk. A GPU-val rézbetét érintkezik, a többi chipet pedig olyan hővezető párnácskák borítják, amilyeneket a GeForce 7900 GTX-nél láthattunk.

A GPU fémsapkáján a 0638A2 felirat volt a legérdekesebb, ami arra utal, hogy a lapka 2006 38. hetében, vagyis szeptember végén készült. A Samsung memóriamodulok 1,1 ns késleltetésűek, ami 900 MHz-es elvi sebességet jelent.

A GeForce 8800 GTX mérete igazán a konkurensek mellé állítva tűnik fel. Az eddigi nagyoknál, a Radeon X1950 XTX-nél, GeForce 7900 GTX-nél és a kétchipes 7950 GX2-nél is hosszabb egy hüvelykkel.

A képeken több helyen is látszik, hogy a 8800 GTX-nek két SLI csatlakozója van. A mellékelt dokumentáció az SLI kapcsán általában több és nem kettő 8800 GTX összekapcsolásáról beszél, így elképzelhető, hogy akár három, négy (vagy talán több?) csúcskategóriás GeForce is összeköthető. Ennek valószínűleg nem a játékosok, hanem a kis költségvetésű szuperszámítógép-projektek fognak örülni.

Tesztkonfiguráció és fogyasztás

| Videokártya / driver | GeForce 8800 GTX (575/1350/900 MHz) / Forceware 96.89 MSI GeForce 7950 GX2 1024 MB (500/600 MHz) / Forceware 91.47 MSI GeForce 7900 GTX 512 MB (650/800 MHz) / Forceware 91.47 BBA Radeon X1950 XTX 512 MB (650/1000 MHz) / Catalyst 6.8 |

| Processzor | Core 2 Duo E6300 @ 2,66 GHz (2 MB L2 cache) |

| Alaplap | ASUS P5WDH Deluxe i975X chipset (Intel Chipset Update 8.1.1.1001) |

| Memória | Corsair TwinX1024-8000UL – 2 x 512 MB (5-4-4-9) |

| Merevlemez | Maxtor DiamondMax 10 250 GB (PATA, 7200 rpm, 16 MB cache) |

| DVD-meghajtó | NEC-3550 |

| Tápegység | Cooler Master RS-550-ACLY |

| Op. rendszer | Windows XP Professional SP2 + DirectX 9.0c |

A mérésekhez korábbi, csúcskategóriás videokártya tesztünk konfigurációját és játékait használtuk. A GeForce 8800 GTX esetleges CPU-limitjeit az amúgy is tuninggal elért 2,66 GHz mellett – egyes játékokban – 3,5 GHz-en is mértünk.

Játékok

- Activision – Quake 4 (1.3)

- 3D Realms Entertainment – Prey (1.1)

- Valve – Half Life 2 Episode One

- UBI Soft – Far Cry (1.33) és (1.4)

- EA Games – Battlefield 2 (1.4)

- Vivendi Universal Games – F.E.A.R. (1.07)

- Activision – Call of Duty 2 (1.3)

- UBISoft – Splinter Cell Chaos Theory (1.05)

- EA Games – Need for Speed: Most Wanted (1.3)

- Ensemble Studios – Age of Empires 3 (1.09)

- EIDOS – Tomb Raider: Legend (1.2)

- Bethesda – The Elder Scrolls: Oblivion (1.1 final)

- UBISoft – Call of Juarez

A meghajtóprogramokban a képminőségi beállításokat az NVIDIA kártyák esetében „legjobb minőség”-re, az ATI kártyák esetében pedig a legszebbre kapcsoltuk, az anizotropikus szűrés végig be volt kapcsolva (az ATI kártyák esetében a szögfüggetlenség is), így később csak az élsimítás mértékét állítgattuk. A „Catalyst AI”-t alapállapotban hagytuk. A játékok többségén maximális grafikai beállításokat használtunk, ahol nem, ott ezt külön megemlítjük. A Quake 4, Prey, HL2, Far Cry, BF2, COD2, SCCT, AOE3 játékokban saját magunk által felvett demókat/replayeket használtunk a kártyák teljesítményének leméréséhez. További öt játékban (F.E.A.R., NFS:MW, TRL, Oblivion, Call of Juarez) egy begyakorolt útvonalat jártunk be háromszor egymás után, miközben FRAPS-szel mértük az fps-eket. A három lefutott kör után az átlagot jegyeztük fel. F.E.A.R.-ben ezen kívül a játékba beépített teljesítménytesztet is lefuttattuk.

Szokás szerint a fogyasztás vizsgálatával indítottunk. Nyugalmi állapotban a GeForce 8800 GTX kevesebb mint 5%-kal fogyasztott többet a GeForce 7950 GX2-nél, és átlagosan 20%-kal evett többet, mint az egychipes 7900 GTX és a Radeon X1950 XTX. Abból kiindulva, hogy a G80 is 90 nm-es csíkszélességgel készül, és a konkurenseknél majdnem kétszer több tranzisztorból épül fel, az eredmény nagyon jónak mondható.

Terhelve sem voltak olyan oltáriak az eltérések. A teljes GeForce 8800 GTX-es konfiguráció, a tuningolt Core 2 Duóval együtt csupán 271 watt mozgósítására kényszerítette a tápot, ami az áramforrás 80%-os hatásfokát figyelembe véve kevesebb mint 220 wattos tényleges fogyasztást jelent. Az X1950 XTX-es rendszer megközelítőleg 16%-kal, a kétchipes 7950 GX 20%-kal, a 7900 GTX pedig 40%-kal fogyasztott kevesebbet. Kétségtelen, hogy az új GeForce mostantól a legnagyobb áramzabáló a VGA-k között, de a rémhírekben terjesztett 200 watt fölötti fogyasztás kacsának bizonyult. Az NVIDIA szerint a csúcs valahol 145 W környékén van, ez szerintünk is reális.

Frissítés: tettünk egy próbát, aminek során arra voltunk kíváncsiak, hogy egy minőségi 350 wattos táp megbírkózik-e egy igazán high-end rendszerrel, amiben természetesen GeForce 8800 GTX dolgozik. Ehhez egy FSP ATX-350GTF tápot vettünk, ami a 12 V-os ágon mindössze 15 A-t tud leadni (az NVIDIA olyat ajánl a 8800 GTX-hez, ami legalább 30 A leadására képes). A konfiguráció alapjául egy Gigabyte 965P-DS4 alaplap szolgált, benne egy Core 2 Duo E6300-as processzorral 3,3 GHz-re tuningolva, 1 GB memória, GeForce 8800 GTX VGA, 3 darab HDD, 1 darab DVD-író, a CPU-ventilátor és további két 12 cm-es házventilátor maximális fordulatszámon, mondhatni egy jól megpakolt rendszerrel volt dolgunk. És jöjjön a lényeg: a táp terhelve a konnektorból 347 wattot vett fel, azaz 80 %-os hatásfokot számolva a konfiguráció kb. 280 wattot fogyasztott, miközben a Far Cry 1600x1200-as felbontásban 16xQ AA/16xAF beállítások mellett futott. Mindez azt jelenti, hogy a gyártók (ezesetben az NVIDIA) szándékosan felülspecifikálják a legújabb hardveralkatrészek fogyasztását, egyrészt azért, hogy ebből kifolyólag ne merüljön fel semmilyen probléma, másrészt pedig mi más is mozgathatná a hardverpiacot, ha nem ez...? Azt természetesen nem felejthetjük el, hogy jó minőségű táppal próbálkoztunk, és hogy mely márkák számítanak jónak? Érdemes körülnézni a cikkarchívumban illetve utánakérdezni a fórumban.

Fill-rate és shaderek

A GeForce 8800 GTX izomereje már az első fill-rate tesztben megmutatkozott. Közel 100 MHz-es hátránya ellenére is több mint 35%-kal gyorsabb volt a második helyezett X1950 XTX-nél. A második helyre valójában a kétchipes GeForce 7950 GX2-t vártuk, de tesztünkben – ahogyan több játékban sem – nem aktiválódott a második mag.

| GeForce 8800 GTX | GeForce 7900 GTX | GeForce 7950 GX2 | Radeon X1950 XTX | |

| Órajel (GPU / memória) | 575/1350/900 MHz | 650/800 MHz | 625/750 MHz | 650/1000 MHz |

| Pure fill-rate (Mpixel/s) | 13173 | 9476 | 7383 | 9713 |

| Z pixel rate (Mpixel/s) | 67796 | 17823 | 14350 | 9979 |

| Single texture (Mpixel/s) | 12019 | 9098 | 7188 | 7557 |

| Dual texture (Mpixel/s) | 8046 | 6444 | 5134 | 4958 |

| Triple texture (Mpixel/s) | 5443 | 4472 | 3524 | 3300 |

| Quad texture (Mpixel/s) | 4104 | 3248 | 2626 | 2429 |

Árnyékban eddig is a GeForce-ok voltak a jobbak, de a 8800 GTX produkciója egyszerűen megsemmisítő volt! Majdnem négyszer akkora sebességet produkált, mint a második helyezett GeForce 7900 GTX, a konkurens Radeonra pedig közel hétszeresen vert rá! Egy textúrával 30% körüli volt a 8800 GTX előnye a 7900 GTX ellen, és 60%-kal hagyta le a Radeont. Dupla textúrával már csak 25% volt az új nagy GeForce előnye a régivel szemben, tehát textúrázásban az új architektúra kevésbé lett hatékony. Mindenesetre a Radeon ebben a tesztben is nagyjából 60%-kal kapott ki. A három- és négytextúrás esetekben is megmaradt a 7900 GTX 20% körüli és a Radeon 60% körüli lemaradása.

Gonosz dolog lenne komolyabban boncolgatni a GeForce 8800 GTX és a többi videokártya vertex shadereinek teljesítményviszonyát. A G80 összes számolójával a többiek 8 és 2x8 egysége nem tudja felvenni a versenyt. Nem is csoda, hogy az újdonság minden tesztben közel 300 fps-t produkált. Azért azt érdemes megfigyelni, hogy a DX10-es architektúrának nem nagyon fekszik a DX9-es, statikus folyamatirányítás; abban a tesztben még a képe is szétesett.

Pixelkezelésben is némileg előnyben van a G80, hiszen nincsenek lustálkodó vertex shaderei, hanem minden számolója a képpontokra veti magát.

Textúragenerálásban elementáris volt a GeForce 8800 GTX produkciója. Az intenzíven számolós tesztekben több mint két és félszer gyorsabb volt a nagy Radeonnál, melyet a 7950 GX2 két GPU-ja is megelőzött. Ahogyan csökkent a kalkulálási igény, és nőtt a textúrázás aránya, úgy kúsztak előre a 7-es GeForce-ok. A 8800 GTX előnye már „csak” 35–55% közötti volt a 7950 GX2-vel szemben, a másik két versenyzőre viszont jócskán ráduplázott. Hasonló volt a helyzet a PS 2.a és PS 3.0 tesztben is, bár az utóbbiban a Radeon egy kicsit feltámadt, majdnem feleannyit tudott, mint az új GeForce.

Árnyékszámolásban már nem volt olyan szuper a G80, sőt egy gyenge pontját is felfedeztük: nem kedveli a textúrás normalizálást. Ezekben az esetekben a 7950 GX2 meg tudta előzni, és a másik két vetélytársra sem tudott már ráduplázni. Normalizálós elméletünk a PS 2.a tesztben megbukott, ott villogott a 8800 GTX, de a számolásban jó Radeon is jeleskedett. Valószínűbb, hogy a modern GPU-knak a kettes shader modell cikluskezelése nem fekszik. A PS 3.0 tesztben a Radeon X1950 XTX csak 17%-kal maradt le az új GeForce mögött, tehát a G80 is verhető lehet egy kis erősítéssel.

Tesztek – I.

Lássuk hát a játékokat, egyelőre csak DirectX 9-ben és OpenGL-ben!

Quake 4-ben a GeForce 7950 GX2 két GPU-ja 17%-kal bizonyult gyengébbnek a 128 stream processzornál. Először azt hittük, hogy a 7950 GX2 viszonylagos közelsége CPU-limit miatt van, de közel egy gigahertzet dobva a Core 2 Duóra is maradt az 120 fps körüli sebesség. A Radeon hiába verte meg a GeForce 7900 GTX-et, a 8800 GTX másfélszer jobb volt nála.

A szintén Doom 3-motoros, de komplexebb grafikájú Prey-ben már jobban elhúzott a 8800 GTX. A második helyezett kétchipesre 35%-ot, a Radeonra 72%-ot, egychipes elődjére pedig 94%-ot vert.

A Half-Life 2 legújabb epizódjában két tesztet futtattunk le. Az elsőben Bloom szűrőt használtunk. Itt az új nagyágyú ráduplázott a 7900 GTX-re, a másik két résztvevőnél pedig 50%-kal volt jobb.

A G80 HDR-rel mutatta meg igazi erejét. A nagyobb precizitású számolásnál a második helyre előrelépő Radeon is 75%-kal maradt az éllovas mögött, amely ismét ráduplázott a 7900 GTX-re.

Far Cry-ban szintén két kört mentünk. A hagyományosban nem volt olyan nagy a 8800 GTX előnye; csupán 35–38%-ot adott követőinek, de a 7900 GTX ismét közel volt a dupla veréshez.

HDR-rel már a Radeon is majdnem duplát kapott, a 7950 GX2 pedig 50%-kal maradt le. A történethez hozzátartozik, hogy a HDR+AA nem úgy ment a GeForce-on, ahogyan az elvárható. Talán egy patchre vagy frissebb meghajtóra lesz szükség.

Tesztek – II.

Battlefield 2-ben is hasonló volt a helyzet, mint korábban. A Radeonnál és a kétchipes GeForce-nál nagyjából 50%-kal volt jobb az új trónkövetelő, a 7900 GTX pedig feleannyit tudott, mint a 8800 GTX.

F.E.A.R.-ben is két kört mentünk. Először a beépített benchmarkot futtattuk le. Ebben, természetesen, ismét az új GeForce győzött, de előnye nem volt olyan nagy, mint korábban. A 7950 GX2-t csupán 10%-kal, a Radeont 44%-kal, a 7900 GTX-et pedig 68%-kal előzte meg.

Saját demónkban a GeForce-ok kicsit gyorsultak, a Radeon viszont 33%-kal lassabb lett. Talán az NVIDIA-nak jobban fekvő shaderes részt találtunk, de az is lehet, hogy az ATI kártyáit a beépített benchmarkhoz igazították.

Call of Duty 2-ben a GeForce 8800 GTX 40-57%-kal volt a mezőny előtt.

Nagy meglepetésünkre Splinter Cellben a kétchipes GeForce 7950 GX2, ha csak egy hajszálnyival is, de megelőzte a 8800 GTX-et. Ebben a tesztben a nagy Radeon is meglehetősen közel került kihívójához, és a 7900 GTX-re sem duplázott rá az utódja.

Autózásban sem az új GeForce vitte a prímet. A Radeon X1950 XTX egy orrhossznyival halászta el az első helyet. A másik két GeForce lemaradása nem volt akkora, mint a korábbi játékokban.

Tesztek – III.

A meglehetősen shaderintenzív Age of Empires 3-ban ismét nagyot alakított a G80 köré épített GeForce. A második helyezett Radeonnál majdnem 50%-kal volt jobb, a GeForce 7900 GTX produkcióját pedig közel két és félszeresen túlteljesítette.

Tomb Raider Legendsben, a next gen hatásokat bekapcsolva, természetesen a GeForce 8800 GTX vitte a prímet. Itt sem beszélhetünk egyértelmű CPU-limitről, mert a Core 2 Duo 32%-os gyorsítása alig 9%-kal emelte az FPS értéket. A többi kártya 60–70%-kal maradt le.

Az extrákat kikapcsolva a GeForce 7950 GX2 hátránya egy picit csökkent, de a Radeonnál és az egymagos GeForce 7-esnél több mint 80%-kal volt jobb az újonc.

Az Oblivion városi jelenetében talán már a CPU is beleszólt az eredmény alakulásába, ugyanis a Core 2 Duót tovább húzva még 18%-os gyorsulást értünk el. A Radeonnál és a 7950 GX2-nél 21%-kal, a 7900 GTX-nél 64%-kal volt jobb a GeForce 8800 GTX.

A shaderizzasztó erdőben ismét villantott az új GeForce. A második helyezett 7950 GX2-t majdnem 70%-kal, a Radeont közel 80%-kal múlta felül. A 7900 GTX még a felét sem tudta hozni a 8800 GTX teljesítményének. Oblivion rengetegét járva megtapasztaltuk azt a hibát, amiről a VR-Zone is írt; a kártya alapórajelen hibázni kezdett, pedig a GPU nem volt melegebb 80 foknál. A jelenség akkor jött elő, amikor egymás után többször váltottunk 2D és 3D üzemmód között – amúgy a kártya rendben volt.

Frissítés: A 96.97-es driverrel sikerült működésre bírnunk Oblivion alatt az élsimítást és a HDR-t egyszerre. A GeForce 8800 GTX előnye 65%-nál is magasabb. CoJ-ban is sikerült bekapcsolni az FSAA-t és a HDR-t, de a játékban több helyen is villódzó árnyékokkal találkoztunk, ezért ennek letesztelésétől most eltekintettünk.

Első Call of Juarez tesztünkben, ahol meglehetősen sok víz van, nagyon együtt volt a mezőny. A 7950 GX2 kiegyenlítette a 8800 GTX-et, a 7900 GTX pedig a Radeont. Először processzorlimitre gyanakodtunk, de a tuningolt processzorral sem gyorsult a 8800 GTX, így ezt az eshetőséget kizártuk. Végül tettünk egy próbát 1600x1200-as felbontásban, ahol a 8800 GTX 26 fps-t futott, tehát egyértelművé vált, hogy ez a játék ennyire megfogja a kártyákat.

Utolsó tesztünkben ismét a GeForce 8800 GTX győzedelmeskedett, bár előnye nem volt olyan mértékű, mint a tesztek többségében. A kétchipes GeForce-ot 7%-kal, a Radeont 30%-kal, a 7900 GTX-et 40%-kal múlta felül. A Call of Juarez-es eredmények valószínűleg a játék motorjának csiszolatlansága miatt lettek ilyenek.

AA és AF sebesség

A szintetikus és játékos tesztek után megvizsgáltuk az élsimítást és anizotropikus szűrést is. Először a látványjavítók teljesítményre gyakorolt hatását ellenőriztük néhány játékban.

Az OpenGL-es Prey-ben a 4x AA kevésbé terhelte a GeForce 8800 GTX-et, mint a kétszeres. A GeForce 7900 GTX-hez képest a 8800 GTX sokkal jobban bírta a 8x AA-t. A Radeon hatszorosban kevesebbet lassult, mint a 8800 GTX nyolcszorosban, de az összehasonlítás nem túl szerencsés. Az új, 8xQ AA-ban jobb volt a 8800-as, mint a sima 8x AA-ban, sőt a 16x mód is nagyon jól ment neki. A legkomolyabb 16xQ AA teljesítmény már csak a harmada volt a kiindulási, élsimítás nélkülinek, bár itt is 45 fps-t mértünk, nagyjából annyit, mint a Radeonnál 6x AA-val.

Far Cry-ban a Radeon és a GeForce 7900 GTX hasonló jelleget mutatott, mint az előző játékban. A 8800 GTX most a Q nélküli módokban volt jobb. Egy kis túlzással már érvényes lett a dokumentációnak az a része, hogy a 16x CSAA olyan teljesítményigényű mint a régi, 4x MSAA.

Az elsősorban shadereket terhelő Oblivionban nem volt olyan mértékű az AA miatti lassulás, mint az előző két játéknál. A GeForce 8800 GTX csak a legkeményebb 16xQ AA módban lassult 10%-nál többet, és a másik két kártya visszaesése is kisebb mértékű volt, mint korábban.

HDR-t és AA-t együtt a 3DMark06 tesztjeiben vizsgáltuk. Mindkét részletben közel azonos volt a GeForce 8800 GTX és a Radeon X1950 XTX lassulásának mértéke, de a GeForce általában 50%-kal nagyobb fps értékeket produkált.

Három játéktesztünk megmutatta, hogy az anizotropikus szűrés már nem teszi komolyan próbára a legújabb, csúcskategóriás grafikus kártyákat. A GeForce 7900 GTX a magasabb szinteken még 80% alá lassult, de a pillanatnyilag legerősebb Radeon és GeForce általában kevesebb mint 10%-ot veszített. Azért egy hajszálnyival jobb volt a GeForce, ami nem az fps értékekre, hanem a csökkenés mértékére értendő.

AA és AF minőség

Mit sem ér a sebesség minőség nélkül. Az élsimítás és az anizotropikus szűrés milyenségét is megvizsgáltuk.

| NVIDIA G80 | NVIDIA G71 | ATI R580 Quality | ATI R580 | |

| Trilinear filtering |  |  |  |  |

| 2x-es aniso |  |  |  |  |

| 4x-es aniso |  |  |  |  |

| 8x-os aniso |  |  |  |  |

| 16x-os aniso |  |  |  |  |

Bizony, a G80 anizója nemcsak gyorsabb, hanem szebb is lett minden eddigi megoldásnál. A helytelenül kicsillagosodó GeForce 7 (G71 GPU) és a Radeon X1000 (R580 GPU) normál módját jobb elfelejteni. Az ATI minőségi AF-je is szemmel láthatóan gyengébb lett, mint az új GeForce-é.

| NVIDIA G80 | ATI R580 | NVIDIA G71 | |

| Nincs FSAA |  |  |  |

| 2x-es FSAA |  |  |  |

| 4x-es FSAA |  |  |  |

| 6x/8x-os FSAA |  |  |  |

A G80 nyolcszoros élsimítása nagyszerű lett. A mintavételezési pontok legalább annyira rendezetlenek, mint az ATI hatszoros módjában, ráadásul kettővel többen is vannak. A GeForce 7 szemmel láthatóan szabályos nyolcszoros mintája szolgáltatja a rossz példát.

Azoknak, akik szeretik pixelenként összehasonlítani egyes grafikus kártyák képét, készítettünk még több mintát. Mi a Radeon hatszoros, a GeForce 7 és GeForce 8 nyolcszoros AA-ja között még láttunk némi különbséget, de afölött már olyan picik az eltérések, hogy állóképeken is hosszas megfigyelést igényelnek.

| NVIDIA G80 | ATI R580 | NVIDIA G71 | |

| Nincs FSAA |  |  |  |

| 2x-es FSAA |  |  |  |

| 4x-es FSAA |  |  |  |

| 6x/8x-os FSAA |  |  |  |

| NVIDIA G80 | |||

| 8xQ FSAA |  |  |  |

| 8xQ FSAA | 16x-os FSAA | 16xQ FSAA | |

| Vízszintes | Függőleges | Átlós | |

| Nincs FSAA |  |  |  |

| 2x-es FSAA |  |  |  |

| 4x-es FSAA |  |  |  |

| 8x-os FSAA |  |  |  |

| 16x-os FSAA |  |  |  |

| 16xQ FSAA |  |  |  |

Konklúzió

Az új G80-ról és a GeForce 8800 GTX teljesítményéről csak szuperlatívuszokban lehet beszélni. Az új processzor a pletykák közül a legvadabbakat is kielégítette, hiszen néhány hónappal ezelőtt ki gondolta volna, hogy közel 700 millió tranzisztoros chip megvalósítható, és ráadásul lesznek olyan részei, melyek több mint 1 GHz-en járnak. Sokáig azt sem hittük el, hogy unified shaderes lesz, de a 256 bitnél szélesebb memóriavezérlő is irreálisnak látszott. Szerencsére két jóslat nem teljesült be, mégpedig a 200 watt fölötti fogyasztásra és a vízhűtésre vonatkozó. Ugyan a G80 még 90 nm-es gyártási technológiával készült – le mernénk fogadni, hogy legkésőbb tavasszal már 80 nm-es lesz –, fogyasztása nem irreálisan magas a konkurens Radeonhoz vagy elődeihez képest, és melegedéssel sem volt gondunk.

Az új GeForce zászlóshajó, a 8800 GTX beváltotta a GPU-hoz fűzött reményeket. Többnyire kétszer olyan gyorsnak bizonyult, mint elődje, a GeForce 7900 GTX, ami már kezdett kevés lenni a legnagyobb Radeonok ellenében. A Radeon X1950 XTX és a GeForce 7950 GX2 eddig közösen osztozott a VGA-s trónon, ugyanis a 7950 GX2 két processzorának nyers ereje nem minden esetben érvényesült a számolásban – eddig – verhetetlen Radeonnal szemben. Nos, a GeForce 8800 GTX mindkét kártyára átlagosan 50%-ot, komolyabb shaderes játékokban még többet vert, így toronymagasan új bajnokot avathatunk. Kétségtelen és egyértelmű, hogy a GeForce 8800 GTX az új király!

Persze, nem minden esetben a király a nyerő. A csúcsmodellek általában nagyok, drágák, arra valók, hogy megmutassák: mi vagyunk a legjobbak. Nincs ez másképp a GeForce 8800 GTX esetében sem. A nyomtatott áramköre lelóg az alaplapról, ajánlott ára pedig 599 dollár. Hogy ez magyar pénzben pontosan mit jelent, arról is fogalmat alkothatunk: a drága márkának számító EVGA GeForce 8800 GTX kiskereskedelmi ára kb. 175 ezer forint, a GeForce 8800 GTS pedig 140 ezer forint. Más, olcsóbb márkák kínálatát tekintve nagyjából 160, illetve 120 ezer forinttal számolhatunk.

Egyáltalán nem lepődtünk meg, amikor láttuk, hogy a kisebb GeForce 8800 GTS ajánlott ára 449 dollár, vagyis fillérre ugyanannyi, mint a Radeon X1950 XTX-é. A G80 architektúrájából és a két 8800-as GeForce órajelviszonyaiból arra következtetünk, hogy a 8800 GTS nagyjából 40%-kal lesz lassabb a csúcsmodellnél, hiszen 25%-kal kevesebb stream processzora és 15%-kal alacsonyabb GPU-órajele van. Ez annyit jelent, hogy a kisebbik 8800-as is jobb választás lehet, mint az ATI hozzávetőleg 125 ezer forintos zászlóshajója. A G80 blokkdiagramjára pillantva látszik, hogy a fele sem lesz tréfa. Egy 64 stream processzoros, középkategóriás GeForce 8 is olyan gyors lehet, mint a GeForce 7900 GTX. Ami pedig a kétchipes, 150–160 ezer forintos GeForce 7950 GX2-t illeti, valószínűleg a kihalás lesz a sorsa...

A G80 bemutatásával ismét lépéselőnybe került az NVIDIA. A Radeon 9700 debütálása óta nem láttunk ilyen meggyőző őrségváltást, és a nagy fölény akkor is inkább az NVIDIA FX-es gyengélkedésének volt köszönhető. Nagyjából egy éve jelent meg a Radeon X1000-es széria, ami ugyan forradalmi változásokat vonultatott fel, de nem lett sokkal gyorsabb, mint az NVIDIA hagyományos GeForce 7-esei. A G80-ra alapozó GeForce 8-cal az NVIDIA is megtartotta saját revolúcióját, amely elsöprő erejűnek tűnik. Hajrá ATI, van mit behozni!

|

| NVIDIA GeForce 8800 GTX |

fLeSs és rudi

A GeForce 8800 GTX-et és a 7950 GX2-t az NVIDIA, az MSI GeForce 7900 GTX-et az Expert Computer Kft., az ATI Radeon X1950 XTX-et az ATI bocsátotta rendelkezésünkre.