Régi tervek új APU-ja

A tavaly július elején debütált, Llano kódnevű megoldást hosszú várakozás előzte meg. Ezt mi sem bizonyítja jobban, minthogy a 2007-es tervek szerint az AMD az első CPU-t és GPU-t egyaránt tartalmazó processzort még valamikor 2009-ben szerette volna piacra dobni. A napvilágot látott információk alapján azonban a Swift több próbálkozás után sem akart összeállni, és ennek állítólag a gyártástechnológia volt az oka.

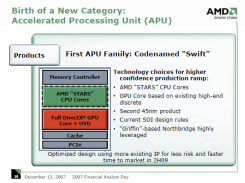

Az AMD ugyanis az első, 130 nanométeres Athlon 64 óta úgynevezett SOI (Silicon-On-Insulator – szilícium a szigetelőn) technológiát alkalmaz szinte az összes processzorának gyártásánál, ezzel ellentétben a GPU-k készítésénél azelőtt sosem alkalmazták még ezt a módszert. Ráadásul a grafikus lapkák gyártását korábban a területen jóval nagyobb tapasztalattal rendelkező TSMC végezte, akik egy egyszerűbb, úgynevezett bulk CMOS eljárással termelték és termelik őket mind a mai napig. A szóban forgó, kereskedelmi forgalomba sosem került, Swift fantázianévre hallgató termék annyiban bizonyosan hasonlított volna a Llanóhoz, hogy úgynevezett "Stars", azaz K10 alapú x86-os magokat tartalmazott volna. Végül nagyjából 2 év csúszással – a Swift helyett – 2011-ben végre megérkezett a Llano, melynek születése szintén nem volt zökkenőmentes; ennek fő oka pedig állítólag újfent a gyártástechnológiában rejlett.

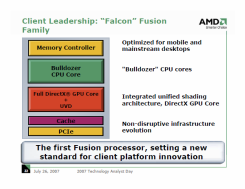

A Swifttel párhuzamosan az AMD már az azt követő, Falcon elnevezésű terméket is betervezte, mely végül szintén valahol a süllyesztőben ért földet. A koncepcióról nagyjából annyit lehetett tudni, hogy Bulldozer magokat tartalmazott volna a GPU és az integrált PCIe vezérlő mellett. A Swifthez és a Falconhoz hasonlóan az első, még 2009-re tervezett első verziós, pusztán x86-os magokat tartalmazó Bulldozer sem látott soha napvilágot. Akik nyomon követik a processzorok világát, azok nyilván jól tudják, hogy végül az első Bulldozer-alapú processzor a Llanóhoz hasonlóan csak tavaly jelent meg, ami szintén bő 2 éves csúszást jelent. Nagyjából egy évvel ezen termékek piacra kerülése után megállapíthatjuk, hogy a kettő közül a Llano sikerült jobban, így nagyobb sikert is aratott.

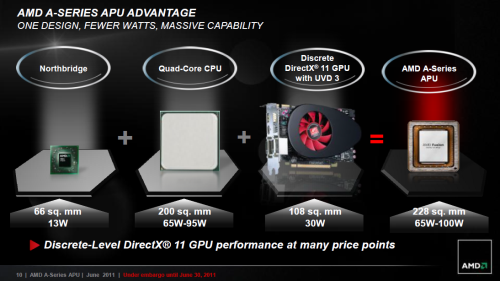

Tavalyi megatesztünkből kiderült, hogy az ezen lapkára épülő asztali A8-as és A6-os megoldások x86-os számítási teljesítménye – az Intel i3-as modelljeihez hasonlóan – megfelel a legtöbb átlagfelhasználónak, míg az integrált GPU-teljesítmény közepes részletesség mellett 1440x900-hoz vagy kisebb felbontáshoz is elegendő lehet; tisztességesen optimalizált vagy néhány éves játékok esetén még akár az 1680x1050-hez is. Ez Llanót megelőző integrált grafikai megoldásoknál még szinte teljesen utópisztikusan hangzott. Ezen processzorokkal egy viszonylag költséghatékony, alacsony fogyasztású, valamint csendes konfigurációt lehetett kiépíteni. Utóbbi jó tulajdonságok okán HTPC-hez is sokan választották a Llanót, mivel a talán legszigorúbb HTPC-s elvárásoknak is megfelelt az APU.

Mielőtt továbbmennénk, elevenítsük fel az APU fogalmát! Az AMD néhány éve úgy döntött, hogy a korábbi Fusion elnevezés égisze alatt megjelenő processzoroknak egy új kategóriát hoz létre, melyet az eddig jól megszokott CPU (Central Processing Unit, azaz központi végrehajtóegység) helyett APU-nak hív. Az APU az Accelerated Processing Unit rövidítése, mely nyers fordítás szerint annyit jelent, hogy gyorsított végrehajtóegység. Az alapötlet olyan processzorok megalkotása volt, amelyek heterogén módon programozhatóak, biztosítva egy belépőt a rendszerszintű integrációba, avagy más néven lassan megkezdődhet a heterogén éra térhódítása.

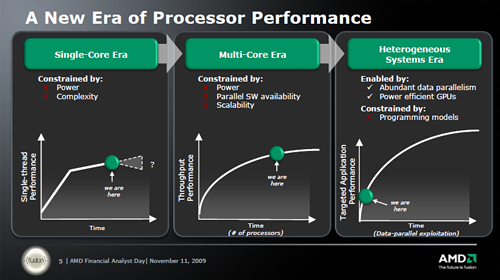

A többség egyfajta divathullámnak értékeli a grafikus mag processzorhoz való társítását, de ennél többről van szó, ugyanis a GPU-ban szunnyadó számítási kapacitást általános számításokra is fel lehet használni, ráadásul bizonyos esetekben lényegesen kedvezőbb teljesítmény/fogyasztás mutatót képes ezzel felmutatni a rendszer. Az előző évtized első felében még kemény órajelháború folyt. A processzorok egyetlen x86-os magot tartalmaztak, és a mérnökök ebből próbálták kipréselni a lehető legnagyobb számítási teljesítményt.

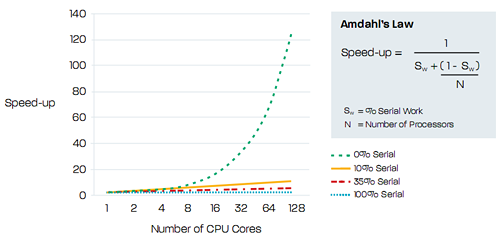

A tervezők idővel belátták, hogy ez az út sokáig nem járható tovább, így inkább az adott processzoron vagy szilíciumlapkán belüli magok számának növelése felé indultak el. Ez egy meglehetősen tranzisztorigényes megoldás, ráadásul probléma, hogy a többmagos processzorok programozása sem egyszerű, mely helyzet a magok számának növelésével csak még tovább romlik. Mindez oda vezet, hogy az extra magok beépítése a teljesítményt alig növeli tovább a megfelelő szoftverek hiányában, vagyis a többmagos elgondolás skálázhatósága jó néhány esetben egyáltalán nem optimális.

A heterogén rendszerek ezekre a problémákra próbálnak gyógyírt nyújtani. Természetesen a helyzet itt sem olyan egyszerű, hiszen hiába a sok esetben mérföldekkel jobb teljesítmény/fogyasztás mutató, ha mindezt nem lehet kihasználni, ugyanis mindezen erőforrások kiaknázásához szükséges egy újfajta programozási modell, egy megfelelő felület. Ilyen például az OpenCL, mely már jó ideje elérhető, így már "csak" az ezen felületet kihasználni képes alkalmazások tömkelegének érkezésére kell várnunk.

A cikk még nem ért véget, kérlek, lapozz!