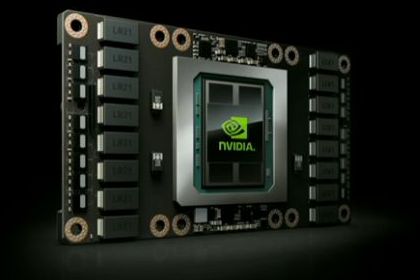

Az NVIDIA az idei GTC-n, hosszú felvezetés után leleplezte a Tesla P100 jelzésű gyorsítót, amely már a vállalat új, Pascal architektúrára épülő lapkáját kapta meg.

A paraméterek tekintetében Jen-Hsun Huang, a vállalat elnök-vezérigazgatója 150 milliárd tranzisztorról beszélt a Tesla P100 esetében, de itt ez összesítve értendő, vagyis benne van maga a GPU, az interposer, illetve a négy darab, összesen tizenhat lapkát adó HBM memória is. A GPU maga 15,3 milliárd tranzisztorból áll, de ennek különösebb jelentősége nincs. Az viszont fontos adat, hogy a Tesla P100 GPU-ját a TSMC gyártja, méghozzá a 16 nm-es FF+ node-on. Ez egy többé-kevésbé elismert titok volt, de az már nem, hogy az interposert ki gyártja. Nos az NVIDIA a második generációs HBM memóriákra CoWoS formában utalt, és ismert tény, hogy utóbbi a TSMC Chip-On-Wafer-On-Substrate szolgáltatása, vagyis ezt a komponenst is a tajvani bérgyártó készíti.

A négy darab második generációs HBM memória összesített kapacitása 16 GB lesz, vagyis HBM2 memóriánként 4 GB-tal lehet számolni. Ismerve ezeknek a lapkáknak a sajátosságait a memóriabusz szélessége 4096 bit.

NVIDIA Tesla P100

Az NVIDIA magáról a lapkáról elárulta, hogy 4 MB-nyi L2 gyorsítótár található benne, illetve az is kiderült, hogy a beépített multiprocesszorok összesen 14 MB-nyi regiszterterületet kínálnak. Ezt Jen-Hsun Huang nagyon kiemelte, mint valami nagy számot, de valójában az igazság az, hogy egyáltalán nem számít kiemelkedőnek, mivel például az AMD Fiji lapkájában összesen 16 MB-nyi regiszter van. Ettől függetlenül tényleg egy nagyon fontos adatról van szó, mivel az NVIDIA a Fermi után igencsak regiszterszegény architektúrákat tervezett, ami természetesen jót tett a fogyasztásnak, de nem kedvezett a gyakorlatban kinyerhető általános számítási teljesítménynek. A Pascal egy regiszterben gazdagabb architektúra lesz, ami a megcélzott piacokon lényeges tényező.

Ami viszont érdekes volt, hogy az NVIDIA konkrétan elárulta, hogy mekkora a Tesla P100 számítási teljesítménye. Ebből a szempontból az újdonság tempója 64 bites, 32 bites és 16 bites lebegőpontos számítások mellett rendre 5,3 TFLOPS, 10,6 TFLOPS és 21,2 TFLOPS lesz. Az, hogy ez konkrétan milyen felépítéssel jön ki, arról később írunk egy részletesebb elemzést.

Az Tesla P100 egyik sarkalatos pontja, hogy a korábban leleplezett NVLINK interfészre épít, vagyis hagyományos x16-os PCI Express 3.0-s verzió nem is lesz belőle. Ezt a processzorokhoz egyrészt direkten is hozzá lehet kötni, de ebben az esetben szükséges egy NVLINK vezérlő a processzorokba is. Mivel ez több platform esetében nem teljesülhet, így az NVIDIA tervezett egy úgynevezett NVLINK Hybrid Cube Mesht. Ez lesz az alapja az NVIDIA DGX-1 szerverének, amelybe például nyolc darab Tesla P100 szerelhető. Ilyenkor az egész nyolc GPU-s tömb négy darab PCI Express átkapcsolóhoz lesz kötve, és ezekkel az átkapcsolókkal lesz összekötve a két Intel Xeon processzor. Ez azt jelenti, hogy egy processzor felől egy x16-os PCI Express 3.0-s csatorna lesz kivezetve egy PCI Express átkapcsoló felé, amely ebből két darab x16-os PCI Express 3.0-s csatornát formál, és ide be lesz kötve egy-egy darab Tesla P100. Az NVLINK már a GPU-kat köti össze egymással, és ezt a felépítést az alábbi ábra nagyon jól szemlélteti.

Az NVIDIA azt is bejelentette, hogy már zajlik az amúgy 300 wattos TDP fogyasztással rendelkező Tesla P100 tömeggyártása, így magát a modult, illetve az erre épülő NVIDIA DGX-1 szervert már elő lehet rendelni. Előbbinek nincs hivatalos ára, de utóbbi 129 000 dollárba kerül.

A vállalat a szállítást az év második felében oldja meg a kiemelt partnereknek, de 2017-ben, egészen pontosan az első negyedévben az OEM-ek számára is elérhető lesz az új Tesla. Ennek értelmében a megcélzott, gépi tanulásban utazó piac nagyobb részének nagyjából háromnegyed év múlva lesz elérhető az újdonság.